الإنجليزية / 简体中文 / 日本語

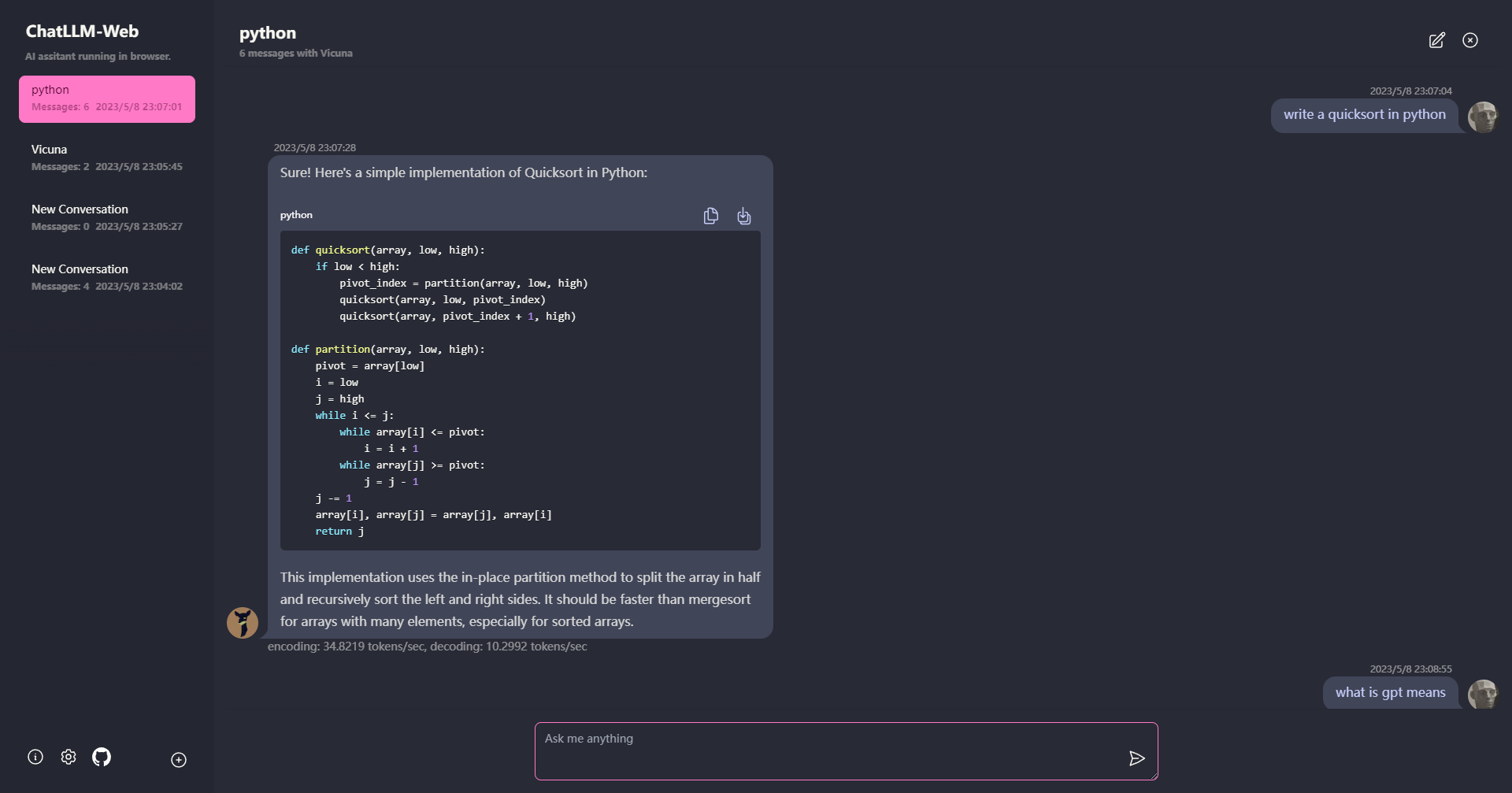

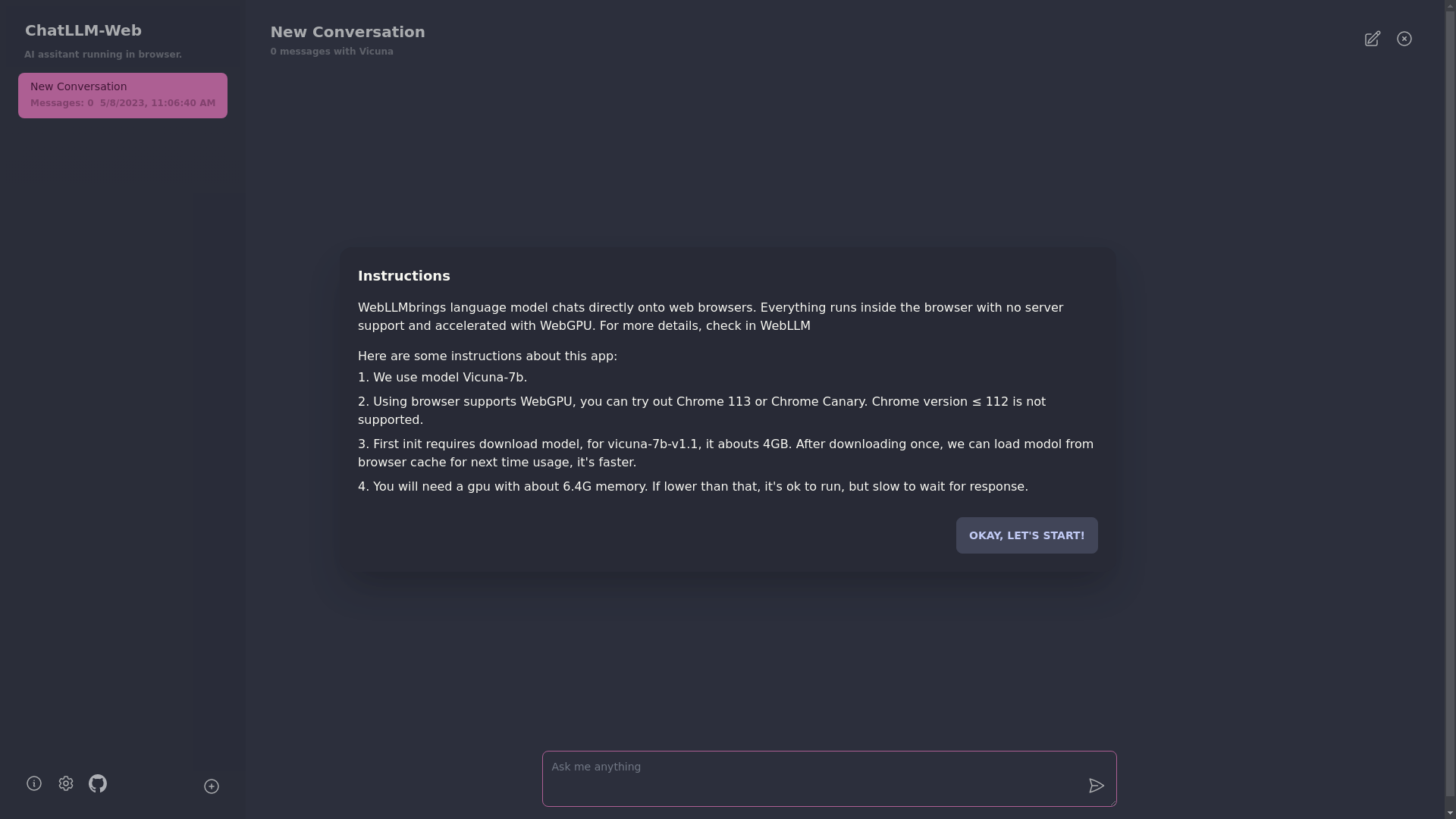

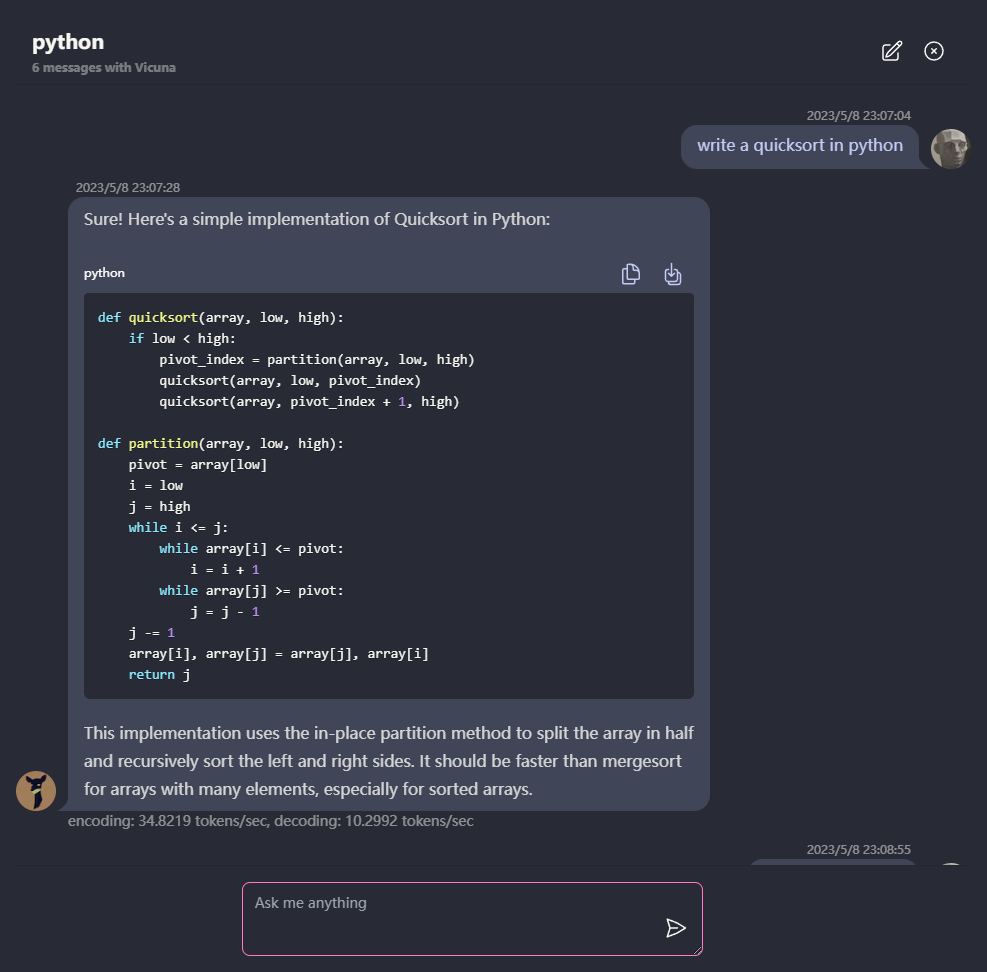

الدردشة مع LLM مثل Vicuna بالكامل في متصفحك مع WebGPU ، بأمان ، خاصة ، وبدون خادم. مدعوم من الويب.

جربه الآن

؟ يتم تشغيل كل شيء داخل المتصفح بدون دعم الخادم ويتم تسريعه باستخدام WebGPU .

يعمل النموذج في عامل ويب ، مما يضمن عدم حظر واجهة المستخدم وتوفير تجربة سلسة.

من السهل النشر مجانًا بنقرة واحدة على Vercel في أقل من دقيقة واحدة ، ثم تحصل على شبكة Chatllm الخاصة بك.

؟ يتم دعم التخزين المؤقت للنموذج ، لذلك تحتاج فقط إلى تنزيل النموذج مرة واحدة.

دردشة متعددة المحركات ، مع تخزين جميع البيانات محليًا في المتصفح للخصوصية.

دعم الاستجابة للتدفق والبث: الرياضيات ، تمييز الكود ، إلخ.

؟ واجهة المستخدم المستجيبة والمصممة جيدًا ، بما في ذلك الوضع المظلم.

دعم PWA وتنزيله وتشغيله في وضع عدم الاتصال تمامًا.

لاستخدام هذا التطبيق ، تحتاج إلى متصفح يدعم WebGPU ، مثل Chrome 113 أو Chrome Canary. إصدارات Chrome ≤ 112 غير مدعومة.

ستحتاج إلى وحدة معالجة الرسومات مع حوالي 6.4 جيجابايت من الذاكرة. إذا كان لدى وحدة معالجة الرسومات الخاصة بك ذاكرة أقل ، فسيظل التطبيق يعمل ، لكن وقت الاستجابة سيكون أبطأ.

؟ في المرة الأولى التي تستخدم فيها التطبيق ، ستحتاج إلى تنزيل النموذج. بالنسبة لنموذج Vicuna-7B الذي نستخدمه حاليًا ، يبلغ حجم التنزيل حوالي 4 جيجابايت. بعد التنزيل الأولي ، سيتم تحميل النموذج من ذاكرة التخزين المؤقت للمتصفح للاستخدام بشكل أسرع.

لمزيد من التفاصيل ، يرجى زيارة mlc.ai/web-llm

[✅] LLM: استخدام عامل الويب لإنشاء مثيل LLM وإنشاء إجابات.

[✅] المحادثات: يتوفر دعم التحويل المتعدد.

[✅] PWA

[] إعدادات:

git clone https://github.com/Ryan-yang125/ChatLLM-Web.git

cd ChatLLM-Web

npm i

npm run dev

معهد ماساتشوستس للتكنولوجيا