2-2000x更快的算法,減少50%的內存使用情況,可用於所有硬件 - 新的和舊的。

如果您想使用快速算法合作 - msg me!加入我們的Discord服務器以更快地製作AI,或者您只是想談論AI! https://discord.gg/unsloth

Unsploth網站

文件

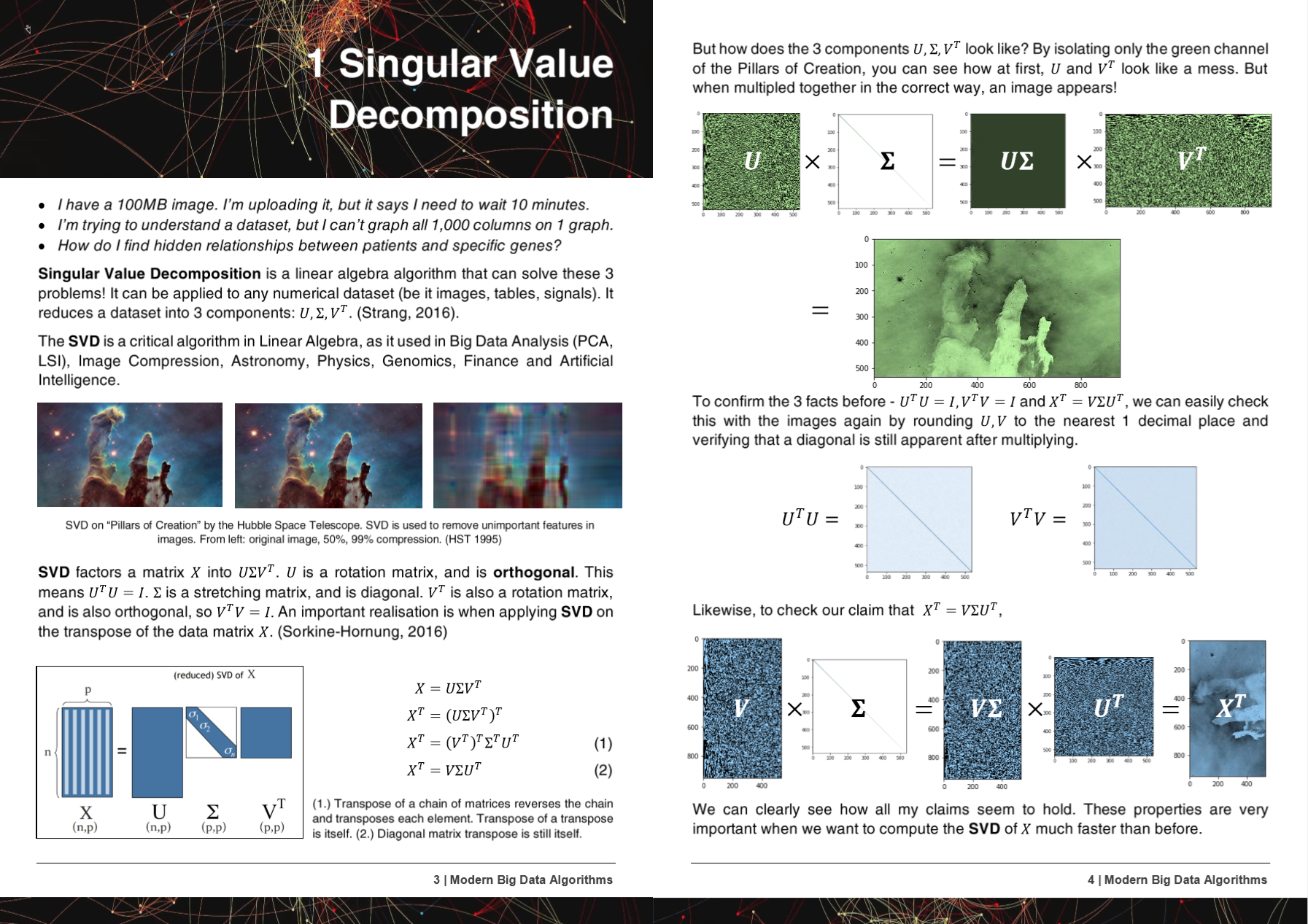

50頁現代大數據算法PDF

HyperLearn的算法,方法和回購已在5篇研究論文中得到或提及!

+ Microsoft, UW, UC Berkeley, Greece, NVIDIA

- 微軟:Yu等。使古典機器學習管道可區分http://learningsys.org/nips18/assets/papers/45camerareadysubmissionfinetune.pdf

- 華盛頓大學:Ariel Rokem,Kendrick Kay。分數山脊回歸:山脊回歸的快速,可解釋的重新聚集化https://arxiv.org/abs/2005.03220

- 國家科學研究中心“ Demokritos”,希臘:克里斯托斯·柏拉圖,喬治奧斯·佩塔西斯。數據插補的機器學習方法的比較https://dl.acm.org/doi/10.1145/3411408.3411465

- 加州大學伯克利分校大衛·陳。 GPU加速t-Distrib的隨機鄰居嵌入https://digitalassets.lib.berkeley.edu/techreports/ucb/ucb/incoming/eecs-2020-89.pdf (在NVIDIA RAPIDS TSNE中融合到Nvidia rappeds)

- Nvidia :Raschka等。急流:Python中的機器學習:數據科學,機器學習和人工智能的主要發展和技術趨勢

Hyperlearn的方法和算法已納入了6個以上的組織和存儲庫中!

+ NASA + Facebook's Pytorch, Scipy, Cupy, NVIDIA, UNSW

- Facebook的Pytorch :SVD非常慢,凝膠給Nans,-inf#11174 pytorch/pytorch#11174

- Scipy :Eigh非常非常慢 - >建議一個簡單的修復#9212 Scipy/Scipy#9212

- CUPY :製作SVD覆蓋臨時陣列x cupy/cupy#2277

- NVIDIA :加速與GPU一起加速TSNE:從小時到秒https://medium.com/rapids-ai/tsne-with-gpus-hours-hours-to-seconds-seconds-9d9c941db

- UNSW Abdussalam等。社交媒體圖像和銷售性能中的大型SKU級產品檢測https://www.abstractsonline.com/pp8/# ! /9305/presentation/465

在HyperLearn的開發過程中,通知GCC的錯誤和問題!

- GCC 10忽略函數屬性優化所有X86以來,自R11-1019 https://gcc.gnu.org/bugzilla/show_bug.cgi?id=96535

- 矢量擴展對齊(1)不生成不規則的負載/商店https://gcc.gnu.org/bugzilla/show_bug.cgi?id=98317

- gcc> = 6不能在sse目標上直列_mm_cmp_ps https://gcc.gnu.org/bugzilla/show_bug.cgi?id=98387

- GCC 10.2 AVX512蒙版回歸來自GCC 9 https://gcc.gnu.org/bugzilla/show_bug.cgi?id=98348

HyperLearn完全寫在Pytorch,Nogil Numba,Numpy,Pandas,Scipy&Lapack,C ++,C,Python,Cython,Cython和Assembly以及鏡子(主要是)Scikit學習。 HyperLearn還具有嵌入的統計推斷指標,並且可以像Scikit Learn的語法一樣稱為。

Hyperlearn的一些關鍵當前成就:

- 比Sklearn + 50%的記憶使用量減少70%的時間最小二乘 /線性回歸的時間

- 由於新的並行算法,與Sklearn相比,適合非矩陣分解的時間少50%

- 40%更快的全歐盟 /餘弦距離算法

- 減少50%的時間LSMR迭代最小二乘

- 新的重建SVD-使用SVD將缺失的數據歸為丟失!具有.fit和.transform。比平均插補大約30%

- 50%加快稀疏基質操作 - 並行

- 隨機SVD現在快20-30%

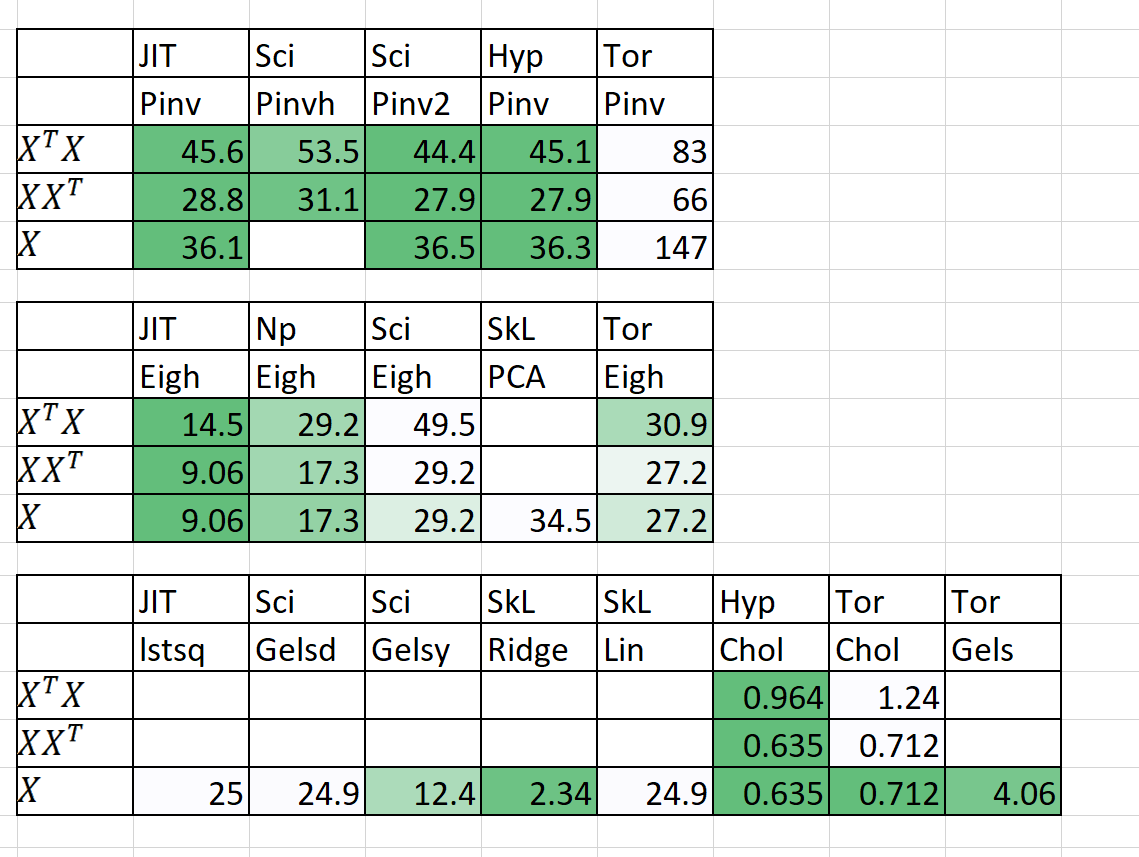

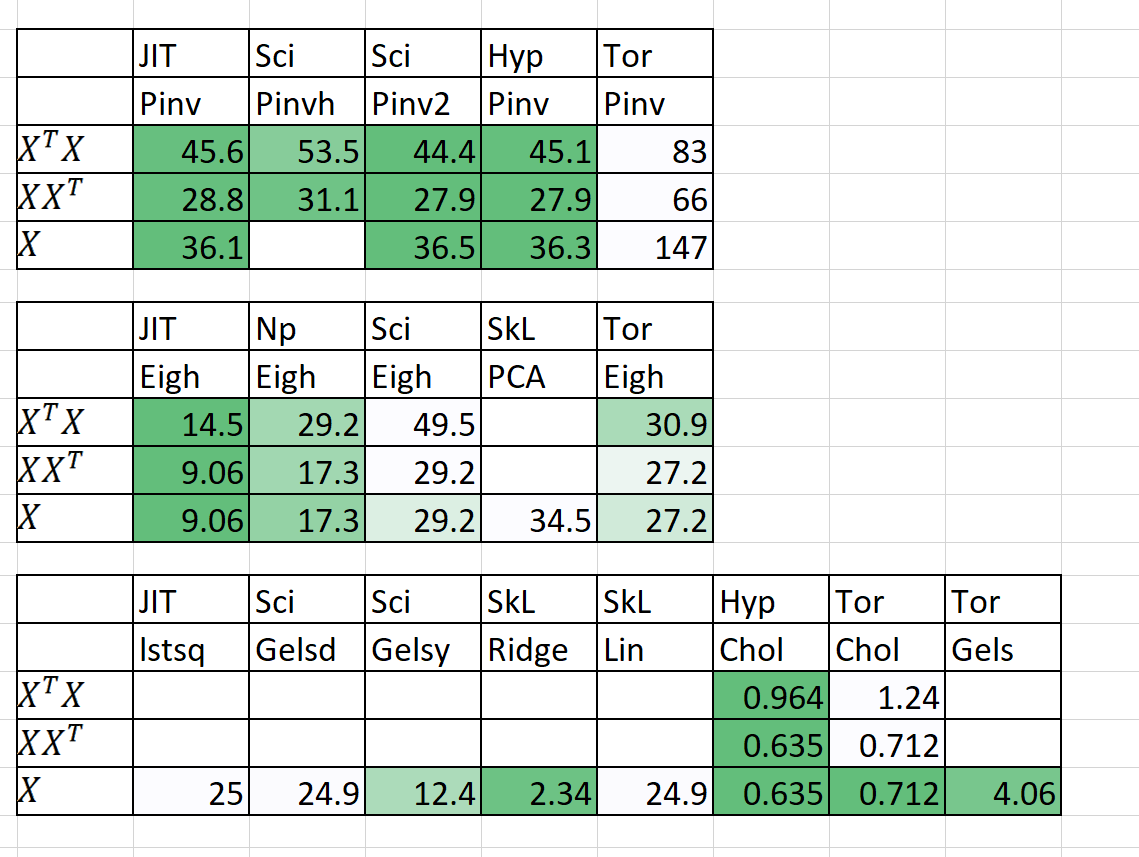

速度 /內存的比較

| 演算法 | n | p | 時間 | | RAM(MB) | | 筆記 |

|---|

| | | Sklearn | 超清除 | Sklearn | 超清除 | |

| QDA(Quad dis a) | 1000000 | 100 | 54.2 | 22.25 | 2,700 | 1200 | 現在並行 |

| 線性回歸 | 1000000 | 100 | 5.81 | 0.381 | 700 | 10 | 保證穩定和快速 |

時間 +預測時間。 RAM(MB)= Max(RAM(fit),RAM(預測))

我還為n = 5000,p = 6000添加了一些初步結果

確實需要幫助!給我發消息!

關鍵方法和目的

1。尷尬地平行於循環

2。50%+更快,50%+瘦

3。為什麼StatsModels有時會難以忍受?

4。使用Pytorch模塊的深度學習下降

5。20%+更少的代碼,更清潔的清除代碼

6。訪問舊且令人興奮的新算法

1。尷尬地平行於循環

- 包括內存共享,內存管理

- 通過pytorch&numba的cuda並行性

2。50%+更快,50%+瘦

- 矩陣乘法排序:https://en.wikipedia.org/wiki/matrix_chain_multiplication

- 元素明智的矩陣乘法將復雜性從O(n^3)降低至O(n^2):https://en.wikipedia.org/wiki/hadamard_product_(matrices)

- 將矩陣操作簡化為愛因斯坦符號:https://en.wikipedia.org/wiki/einstein_notation

- 連續評估一次性矩陣操作,以減少RAM開銷。

- 如果p >> n,則可能分解XT比X好。

- 在某些情況下,應用QR分解然後SVD可能會更快。

- 利用矩陣的結構來更快地計算逆逆(例如三角矩陣,Hermitian矩陣)。

- 計算SVD(x)然後獲得PINV(x)有時比純PINV(x)快得多

3。為什麼StatsModels有時會難以忍受?

- 優化了置信度,預測間隔,假設檢驗和線性模型的擬合測試優點。

- 在可能的情況下,使用愛因斯坦符號和哈達馬產品。

- 僅計算計算的必要條件(矩陣的對角線,而不是整個矩陣)。

- 在符號,速度,內存問題和變量存儲上固定統計模型的缺陷。

4。使用Pytorch模塊的深度學習下降

- 使用pytorch創建Scikit-Learn,例如替換中的滴滴。

5。20%+更少的代碼,更清潔的清除代碼

- 盡可能使用裝飾師和功能。

- 直觀的中級函數名稱,例如(ISTENSOR,同級)。

- 輕鬆通過超核能處理並行性。

6。訪問舊且令人興奮的新算法

- 矩陣完成算法 - 非負最小二乘,NNMF

- 批量相似性潛在dirichelt分配(BS-LDA)

- 相關回歸

- 可行的概括最小二乘FGL

- 離群耐受回歸

- 多維樣條回歸

- 廣義小鼠(替換中的任何模型下降)

- 使用Uber的Pyro進行貝葉斯深度學習

額外的許可條款

- 採用Apache 2.0許可證。