2-2000X 더 빠른 조류, 메모리 사용량이 50% 줄어든 모든 하드웨어에서 작동합니다.

빠른 알고리즘에서 협업하려면 MSG ME !! AI를 더 빨리 만들거나 AI에 대해 채팅하고 싶다면 불화 서버에 가입하십시오! https://discord.gg/unsloth

Unsloth 웹 사이트

선적 서류 비치

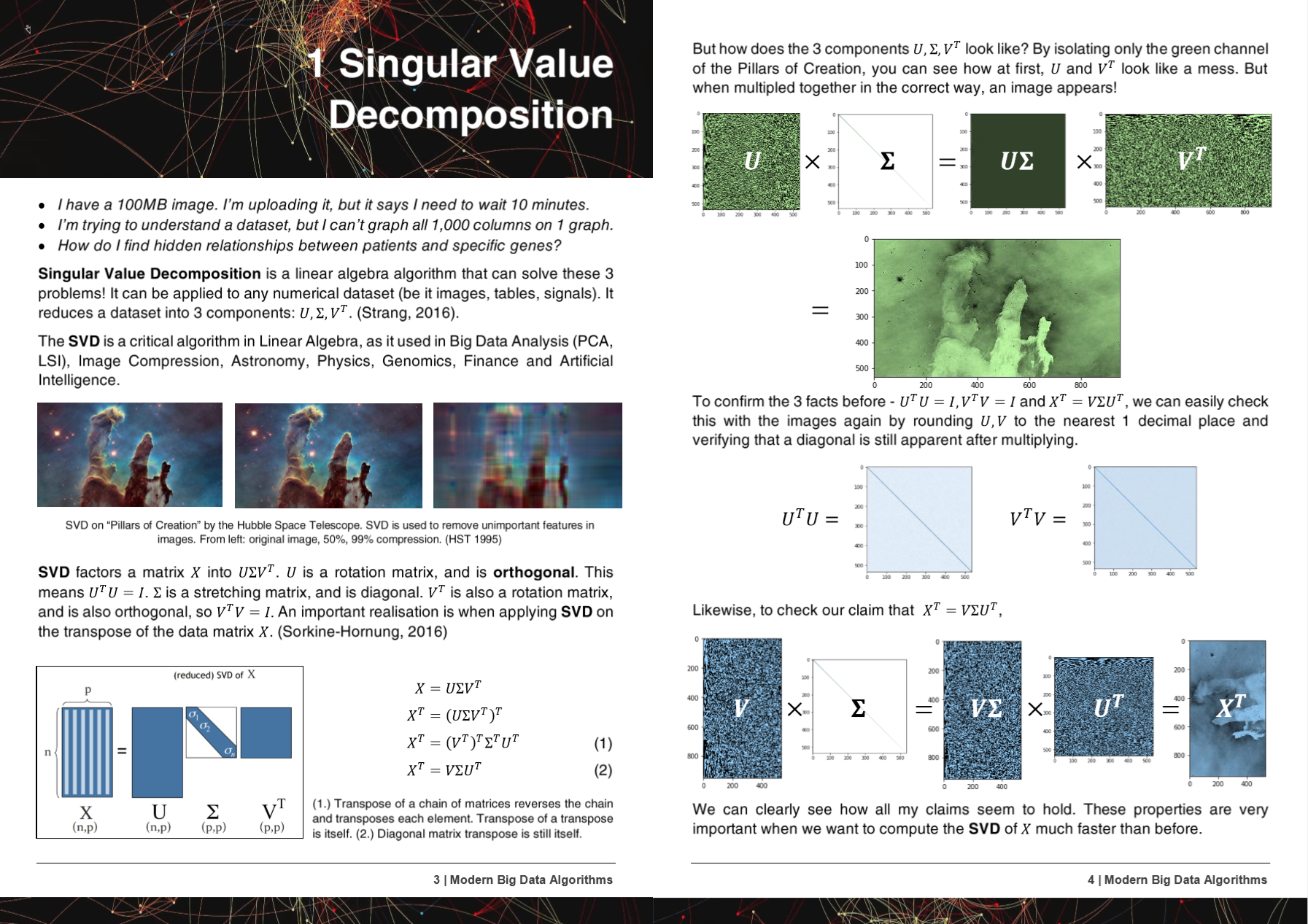

50 페이지 현대 빅 데이터 알고리즘 PDF

HyperLearn의 알고리즘, 메소드 및 리포는 5 개의 연구 논문에서 특징 지어 지거나 언급되었습니다!

+ Microsoft, UW, UC Berkeley, Greece, NVIDIA

- 마이크로 소프트 : Yu et al. 클래식 머신 러닝 파이프 라인 차별화 가능한 http://learningsys.org/nips18/assets/papers/45camerareadysubmissionfinetune.pdf 만들기

- 워싱턴 대학교 : Ariel Rokem, Kendrick Kay. 분수 릿지 회귀 : 릿지 회귀의 빠르고 해석 가능한 리 파라미터 화 https://arxiv.org/abs/2005.03220

- 국립 과학 연구 센터 'Demokritos', 그리스 : Christos Platias, Georgios Petasis. 데이터 대치에 대한 머신 러닝 방법 비교 https://dl.acm.org/doi/10.1145/3411408.3411465

- UC 버클리 데이비드 찬. GPU 가속화 된 T- 분산 된 확률 론적 인 이웃이 포함 된 https://digitalassets.lib.berkeley.edu/techreports/ucb/incoming/eecs-2020-89.pdf (Nvidia Rapids TSNE에 통합 된 HyperLearn 방법)

- Nvidia : Raschka et al. Rapids : Python의 머신 러닝 : 데이터 과학, 기계 학습 및 인공 지능의 주요 개발 및 기술 동향 https://arxiv.org/abs/2002.04803 (Nvidia Rapids TSNE에 HyperLiagn Methods를 통합)

HyperLearn의 방법 및 알고리즘은 6 개 이상의 조직 및 리포지토리에 통합되었습니다!

+ NASA + Facebook's Pytorch, Scipy, Cupy, NVIDIA, UNSW

- Facebook의 Pytorch : SVD는 매우 느리고 젤을 제공합니다. -Inf #11174 Pytorch/Pytorch #11174

- Scipy : Eigh 매우 느리게 -> 쉬운 수정 제안 #9212 Scipy/Scipy #9212

- CUPY : SVD를 임시 배열 X Cupy/Cupy#2277로 작성하십시오

- NVIDIA : GPUS로 TSNE 가속화 : 몇 시간에서 몇 초에서 https://medium.com/rapids-ai/tsne-with-gpus-hours-to-seconds-9d9c17c941db

- Unsw Abdussalam et al. 소셜 미디어 이미지 및 영업 성과의 대규모 SKU 수준 제품 감지 https://www.abstractsonline.com/pp8/#!/9305/presentation/465

HyperLearn의 개발 중에 버그와 문제가 GCC에 통보되었습니다!

- GCC 10 함수 속성 무시 함수 속성 무시 R11-1019 https://gcc.gnu.org/bugzilla/show_bug.cgi?id=96535 이후 모든 x86에 대해 최적화

- 벡터 확장 정렬 (1) 정렬되지 않은 부하/저장을 생성하지 않음 https://gcc.gnu.org/bugzilla/show_bug.cgi?id=98317

- gcc> = 6은 sse 대상에서 _mm_cmp_ps를 인라인 할 수 없습니다 https://gcc.gnu.org/bugzilla/show_bug.cgi?id=98387

- GCC 10.2 AVX512 GCC의 마스크 회귀 9 https://gcc.gnu.org/bugzilla/show_bug.cgi?id=98348

HyperLearn은 Pytorch, Nogil Numba, Numpy, Pandas, Scipy & Lapack, C ++, C, Python, Cython and Assembly, Mirrors (대부분) Scikit에서 완전히 작성됩니다. HyperLearn에는 또한 통계적 추론 측정이 포함되어 있으며 Scikit Learn의 구문처럼 호출 될 수 있습니다.

HyperLoyn의 현재의 주요 성과 :

- 70% 최소 제곱 / 선형 회귀에 맞는 시간 덜 적은 시간 + 50% 메모리 사용량 감소

- 새로운 병렬 아고로 인한 스카이보다 비 음성 매트릭스 인수에 맞는 시간 50% 적음

- 40% 더 빠른 전체 유클리드 / 코사인 거리 알고리즘

- 50% 더 적은 시간 LSMR 반복 최소 제곱

- 새로운 재구성 SVD- SVD를 사용하여 누락 된 데이터를 부과하십시오! .fit 및 .Transform이 있습니다. 평균 대치보다 약 30% 더 우수합니다

- 50% 더 빠른 희소 행렬 작업 - 병렬화

- RandomizedSVD는 이제 20-30% 빠릅니다

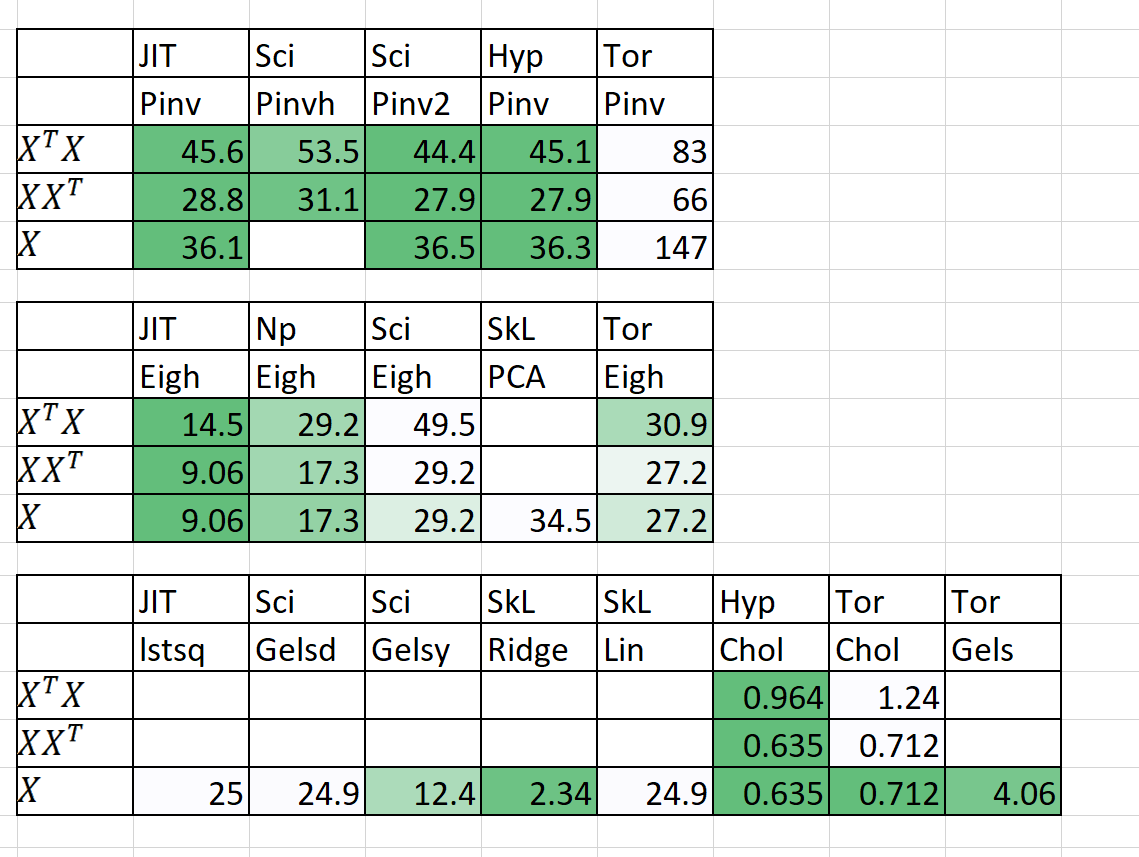

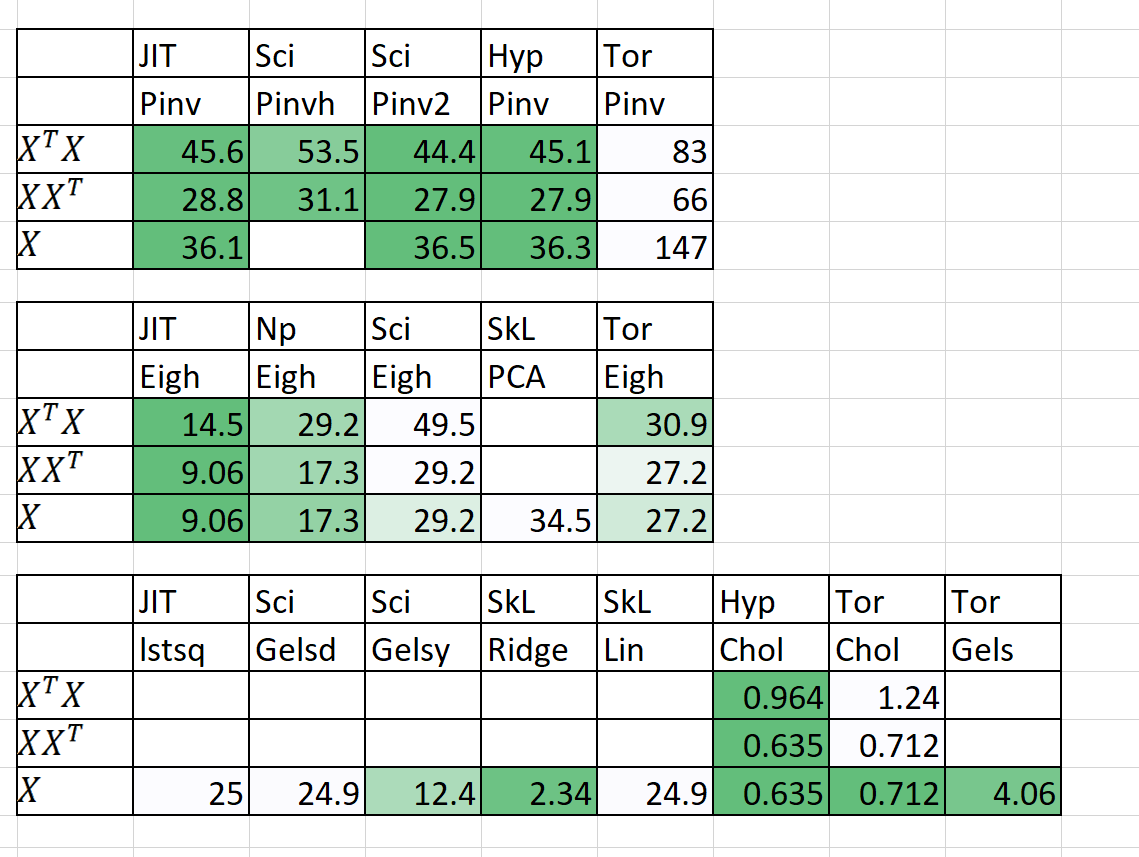

속도 / 메모리 비교

| 연산 | N | 피 | 타임스) | | 램 (MB) | | 메모 |

|---|

| | | 스카리 | 과도 | 스카리 | 과도 | |

| QDA (쿼드 디스 A) | 10000000 | 100 | 54.2 | 22.25 | 2,700 | 1,200 | 이제 병렬화되었습니다 |

| 선형 회귀 | 10000000 | 100 | 5.81 | 0.381 | 700 | 10 | 안정 및 빠른 보장 |

시간이 적합 + 예측입니다. RAM (MB) = MAX (RAM (FIT), RAM (예측))

또한 n = 5000, p = 6000에 대한 예비 결과를 추가했습니다.

도움이 필요합니다! 메시지를 보내주세요!

주요 방법론과 목표

1. 루프에 대해 부끄럽게 평행합니다

2. 50%+ 더 빠르고 50%+ 린

3. 왜 스테이드 모델이 견딜 수 없을 정도로 느리게 느리게됩니까?

4. Pytorch를 사용한 모듈의 딥 러닝 드롭

5. 20%+ 코드가 적고 더 깨끗한 명확한 코드

6. 오래되고 흥미 진진한 새로운 알고리즘에 액세스

1. 루프에 대해 부끄럽게 평행합니다

- 메모리 공유, 메모리 관리 포함

- Pytorch & Numba를 통한 CUDA 병렬 처리

2. 50%+ 더 빠르고 50%+ 린

- 매트릭스 곱셈 순서 : https://en.wikipedia.org/wiki/matrix_chain_multiplication

- 요소 현명한 매트릭스 곱하기 곱하기 O (n^2)에서 복잡성을 줄이기 (n^3) : https://en.wikipedia.org/wiki/hadamard_product_(matrices)

- 아인슈타인 표기법으로 매트릭스 작업을 줄이기 : https://en.wikipedia.org/wiki/einstein_notation

- RAM 오버 헤드를 줄이기 위해 일회성 매트릭스 작업을 연속적으로 평가합니다.

- p >> n이라면 아마도 XT가 X보다 낫다는 것일 수 있습니다.

- QR 분해를 적용하면 경우에 따라 SVD가 더 빠를 수 있습니다.

- 매트릭스의 구조를 활용하여 더 빠른 역전 (예 : 삼각형 행렬, Hermitian Matrices)을 계산합니다.

- SVD (x)를 계산 한 다음 PINV (x)를 얻는 것은 때때로 순수한 pinv (x)보다 빠릅니다.

3. 왜 스테이드 모델이 견딜 수 없을 정도로 느리게 느리게됩니까?

- 선형 모델에 대한 신뢰, 예측 간격, 가설 테스트 및 적합성 테스트의 좋은 테스트가 최적화됩니다.

- 가능한 경우 아인슈타인 표기법 및 Hadamard 제품을 사용합니다.

- 계산하기에 필요한 것만 계산합니다 (매트릭스가 아닌 행렬의 대각선).

- 표기법, 속도, 메모리 문제 및 변수 저장에 대한 통계 모드의 결함을 고정합니다.

4. Pytorch를 사용한 모듈의 딥 러닝 드롭

- Pytorch를 사용하여 교체 낙하와 같은 Scikit-Learn을 만듭니다.

5. 20%+ 코드가 적고 더 깨끗한 명확한 코드

- 가능한 경우 데코레이터 및 기능을 사용합니다.

- 직관적 인 중간 수준의 기능 이름 (istensor, isiterable).

- HyperLiprocessing을 통해 쉽게 병렬 처리를 처리합니다

6. 오래되고 흥미 진진한 새로운 알고리즘에 액세스

- 매트릭스 완료 알고리즘 - 비 음성 최소 제곱, NNMF

- 배치 유사성 잠재 Dirichelt 할당 (BS-LDA)

- 상관 관계 회귀

- 실행 가능한 일반화 최소 제곱 FGL

- 이상적인 관용 회귀

- 다차원 스플라인 회귀

- 일반 마우스 (모든 모델 대체량)

- 베이지안 딥 러닝을 위해 Uber 's Pyro 사용

추가 라이센스 용어

- Apache 2.0 라이센스가 채택되었습니다.