| | | | 中文文檔

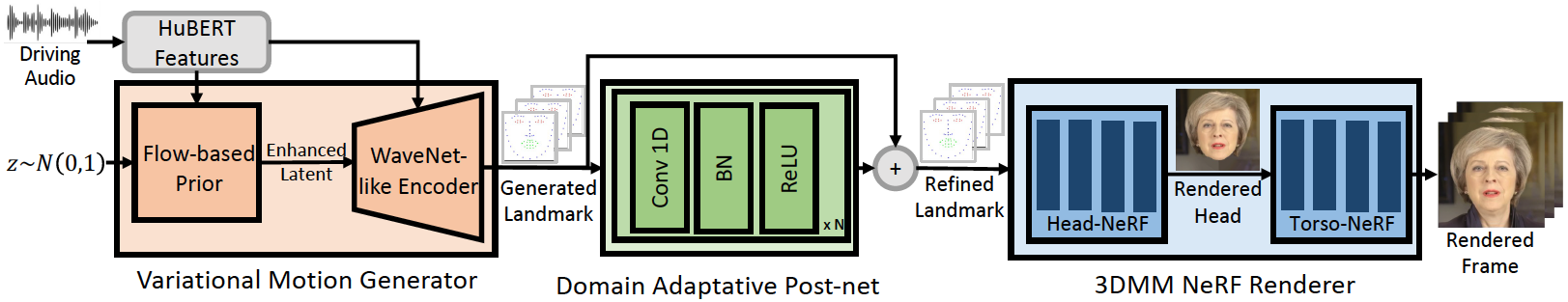

該存儲庫是我們ICLR-2023論文的官方Pytorch實施,在其中我們提出了用於廣義和高保真音頻驅動的會說話的面部發電的基因表面。推理管道如下:

我們的Geneface可以更好地達到唇部的同步和對域外音頻的表現力。觀看此視頻,以與以前的基於NERF的方法進行清晰的唇部同步比較。您還可以訪問我們的項目頁面以獲取更多詳細信息。

我們已經發布了Mimictalk(https://github.com/yerfor/mimictalk/)的守則,這是一種基於SOTA NERF的人 - 特殊說話的面部方法,並實現了更好的視覺質量,並啟用了講話樣式控制。

我們已經發布了Geneface ++的代碼(https://github.com/yerfor/genefaceplusplus/),該代碼是Geneface的升級版本,並實現了更好的唇部,視頻Qaulity和系統效率。

2023.3.16我們在此版本中發布了一個重大更新,視頻演示在這裡。包括:1)基於RAD-NERF的渲染器,可以實時推斷並在10小時內進行培訓。 2)基於Pytorch的DEEP3D_RECODSTRUCTION模塊,該模塊的安裝易於安裝,比以前的基於TF的版本快8倍。 3)俯仰感知音頻2MOTION模塊,該模塊可能會產生更多的唇部同步地標。 4)修復一些導致大量內存使用的錯誤。 5)我們將很快上傳有關此更新的論文。2023.2.22我們發行了一個長1分鐘的演示視頻,其中Geneface是由Diffsinger產生的中文歌曲驅動的。2023.2.20我們在inference/nerfs/lm3d_nerf_infer.py中發布了穩定的3D地標後處理策略,該策略提高了最終結果的穩定性和質量。 我們在此版本中提供了預先訓練的模型和Geneface的處理數據集,以快速啟動。在下文中,我們將展示如何以4個步驟推斷預訓練的模型。如果您想在自己的目標人視頻上訓練基因表,請訪問以下各節( Prepare Environments , Prepare Datasets和Train Models )。

步驟1。根據docs/prepare_env/install_guide.md中的指南創建一個名為geneface的新的Python Env。

步驟2。在版本中下載lrs3.zip和May.zip ,然後將其解壓縮到checkpoints目錄中。

步驟3。處理docs/process_data/process_target_person_video.md中的指南中的May.mp4的數據集。然後,您可以看到一個名為data/binary/videos/May/trainval_dataset.npy的輸出文件。

在上述步驟之後,您的checkpoints和data目錄的結構應如下所示:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

您可以找到一個名為infer_out/May/pred_video/zozo.mp4的輸出視頻。

請按照docs/prepare_env中的步驟操作。

請按照docs/process_data中的步驟操作。

請按照docs/train_models中的步驟操作。

除了本倉庫中提供的May.mp4外,我們還提供了8個實驗中使用的目標人視頻。您可以在此鏈接上下載它們。要在名為<video_id>.mp4的新視頻上訓練,您應該將其放入data/raw/videos/ DERICTORY中,然後根據提供的示例文件夾egs/datasets/videos/<video_id> egs/datasets/videos/May <VIDEO_ID>上創建一個新文件夾並編輯配置文件。

您還可以錄製自己的視頻並為自己培訓獨特的基因表模型!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

我們的代碼基於以下存儲庫: