| | | | 中文文档

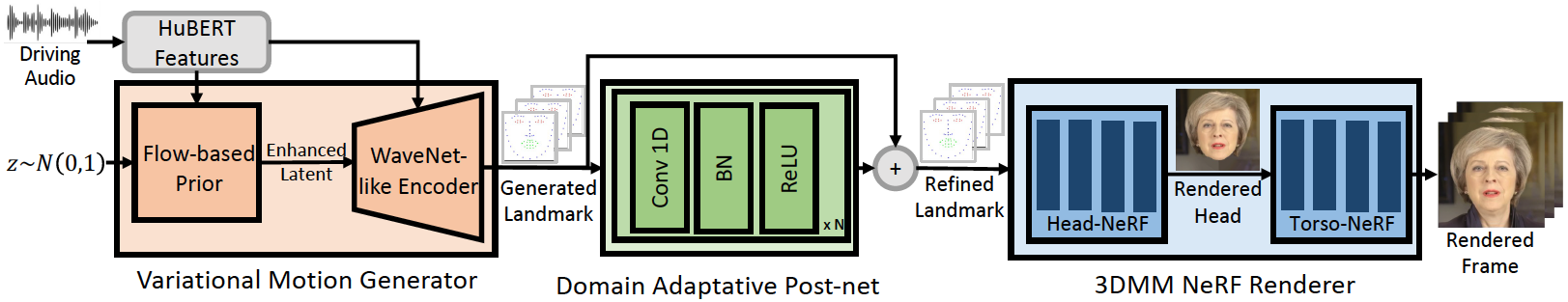

Dieses Repository ist die offizielle Pytorch-Implementierung unseres ICLR-2023-Papiers, in dem wir Geneface für verallgemeinerte und hochwertige audioorientierte sprechende Gesichtsgenerierung vorschlagen. Die Inferenzpipeline lautet wie folgt:

Unser Geneface erreicht eine bessere Lip-Synchronisation und Ausdruckskraft für Audios außerhalb der Domäne. Sehen Sie sich dieses Video für einen klaren Lippensynchronisierungsvergleich mit früheren NERF-basierten Methoden an. Sie können auch unsere Projektseite für weitere Details besuchen.

Wir haben den Code von Mimictalk (https://github.com/yerfor/mimictalk/) veröffentlicht.

Wir haben den Code von Geneface ++ (https://github.com/yerfor/genefaceplusplus/) veröffentlicht, eine verbesserte Version von Geneface und erreicht eine bessere Lip-Sync, Video-Qaulity und Systemeffizienz.

2023.3.16 Wir veröffentlichen ein großes Update in dieser Version, eine Video -Demo ist hier. einschließlich: 1) Renner-basierter Renderer, das in Echtzeit schließen und in 10 Stunden trainiert werden kann. 2) Pytorch-basiertes Deep3D_Reconstruction-Modul, das einfacher zu installieren ist und 8x schneller ist als die vorherige TF-basierte Version. 3) Pitch-Affe-Audio2Motion-Modul, das mehr Lip-Sync-Wahrzeichen erzeugen könnte. 4) Beheben Sie einige Fehler, die einen großen Speicherverbrauch verursachen. 5) Wir werden das Papier bald über dieses Update hochladen.2023.2.22 Wir veröffentlichen ein 1-minütiges Demo-Video, in dem Geneface von einem chinesischen Lied angetrieben wird, das von Diffsinger erzeugt wird.2023.2.20 Wir veröffentlichen eine stabile 3D-Nachbearbeitungstrategie in inference/nerfs/lm3d_nerf_infer.py , die die Stabilität und Qualität der Endergebnisse mit großem Rand verbessert. In dieser Veröffentlichung stellen wir vorgebildete Modelle und verarbeitete Datensätze von Geneface bereit, um einen schnellen Start zu ermöglichen. Im Folgenden zeigen wir in 4 Schritten, wie die vorgebrachten Modelle in 4 Schritten schließen können. Wenn Sie Geneface in Ihrem eigenen Video -Video -Video trainieren möchten, wenden Sie sich bitte an die folgenden Abschnitte ( Prepare Environments , Prepare Datasets und Train Models ).

STEP1. Erstellen Sie eine neue Python Env mit dem Namen geneface , folgt der Anleitung in docs/prepare_env/install_guide.md .

STEP2. Laden Sie den lrs3.zip und May.zip in der Version herunter und entpacken Sie sie in das checkpoints .

Schritt 3. Verarbeiten Sie den Datensatz von May.mp4 nach der Anleitung in docs/process_data/process_target_person_video.md . Anschließend sehen Sie eine Ausgabedatei mit dem Namen data/binary/videos/May/trainval_dataset.npy .

Nach den obigen Schritten sollte die Struktur Ihrer checkpoints und data wie folgt aussehen:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

Sie finden ein Ausgabevideo mit dem Namen infer_out/May/pred_video/zozo.mp4 .

Bitte befolgen Sie die Schritte in docs/prepare_env .

Bitte befolgen Sie die Schritte in docs/process_data .

Bitte befolgen Sie die Schritte in docs/train_models .

Abgesehen von den in diesem Repo bereitgestellten May.mp4 bieten wir auch 8 Zielvideos, die in unseren Experimenten verwendet wurden. Sie können sie unter diesem Link herunterladen. Um auf einem neuen Video mit dem Namen <video_id>.mp4 zu trainieren, sollten Sie es in die data/raw/videos/ Verzeichnisse einfügen und dann einen neuen Ordner unter egs/datasets/videos/<video_id> erstellen und Konfigurationsdateien bearbeiten, je nach dem angegebenen Beispiel Ordner egs/datasets/videos/May .

Sie können auch Ihr eigenes Video aufnehmen und ein einzigartiges Geneface -Modell für sich selbst trainieren!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

Unsere Codes basieren auf den folgenden Repos: