| | | | 中文文档

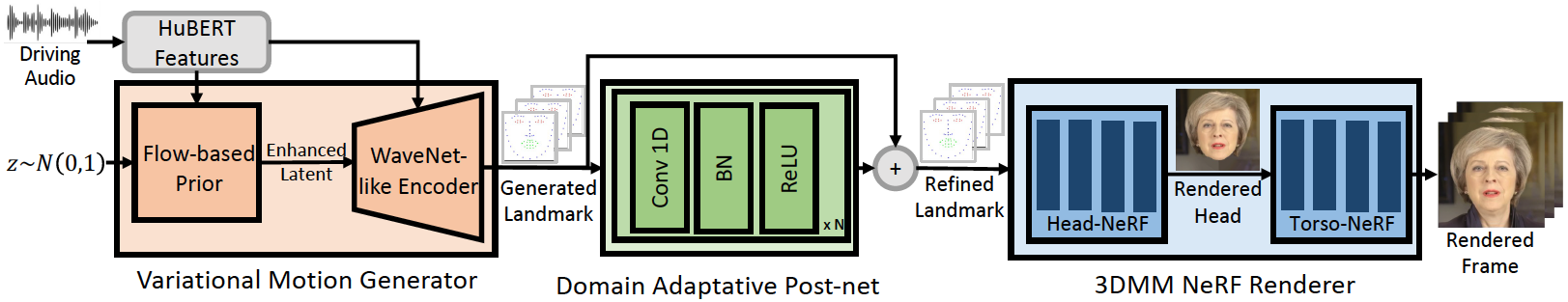

Este repositorio es la implementación oficial de Pytorch de nuestro artículo ICLR-2023, en el que proponemos Geneface para la generación de cara parlante generalizada y de alta fidelidad basada en audio. La tubería de inferencia es la siguiente:

Nuestro Geneface logra una mejor sincronización de labios y expresividad a audios fuera de dominio. Mire este video para obtener una comparación clara de sincronización de labios con métodos anteriores basados en NERF. También puede visitar nuestra página del proyecto para obtener más detalles.

Hemos lanzado el Código de Mimickalk (https://github.com/yerfor/mimictick/), que es un método parlante específico de persona con sede en Sota Nerf y logra una mejor calidad visual y permite un control de estilo de conversación.

Hemos lanzado el Código de Geneface ++ (https://github.com/yerfor/genefaceplusplus/), que es una versión actualizada de Geneface y logra una mejor sincronización de labios, qaulidad de video y eficiencia del sistema.

2023.3.16 Lanzamos una gran actualización en este lanzamiento, hay una demostración de video aquí. Incluyendo: 1) Renderizador basado en Rad-Nerf, que podría inferir en tiempo real y ser entrenado en 10 horas. 2) El módulo profundo 3D_REConstruction basado en Pytorch, que es más fácil de instalar y es 8 veces más rápido que la versión basada en TF anterior. 3) Módulo de Audio2Motion de pitch que podría generar más hito de sincronización de labios. 4) Solucione algunos errores que causan un gran uso de memoria. 5) Subiremos el documento sobre esta actualización pronto.2023.2.22 Lanzamos un video de demostración de 1 minuto de largo, en el que Geneface está impulsado por una canción china generada por Diffsinger.2023.2.20 Lanzamos una estrategia estable de postprocesamiento de referencia en 3D en inference/nerfs/lm3d_nerf_infer.py , que mejoran la estabilidad y la calidad de los resultados finales por un margen grande. Proporcionamos modelos previamente capacitados y conjuntos de datos procesados de Geneface en esta versión para habilitar un inicio rápido. A continuación, mostramos cómo inferir los modelos previamente capacitados en 4 pasos. Si desea capacitar a Geneface en su propio video de la persona objetivo, llegue a las siguientes secciones ( Prepare Environments , Prepare Datasets y Train Models ).

Paso 1. Cree un nuevo env con llamado geneface de Python siguiendo la guía en docs/prepare_env/install_guide.md .

Paso 2. Descargue el lrs3.zip y May.zip en el lanzamiento y descúplalo en el directorio checkpoints .

Paso 3. Procese el conjunto de datos de May.mp4 siguiendo la guía en docs/process_data/process_target_person_video.md . Luego puede ver un archivo de salida llamado data/binary/videos/May/trainval_dataset.npy .

Después de los pasos anteriores, la estructura de sus checkpoints y directorio data debe verse así:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

Puede encontrar un video de salida llamado infer_out/May/pred_video/zozo.mp4 .

Siga los pasos en docs/prepare_env .

Siga los pasos en docs/process_data .

Siga los pasos en docs/train_models .

Además del May.mp4 proporcionado en este repositorio, también proporcionamos 8 videos de personas objetivo que se usaron en nuestros experimentos. Puede descargarlos en este enlace. Para entrenar en un nuevo video llamado <video_id>.mp4 , debe colocarlo en los data/raw/videos/ Directory, luego crear una nueva carpeta en egs/datasets/videos/<video_id> y editar archivos de configuración, de acuerdo con la carpeta de ejemplo proporcionada egs/datasets/videos/May .

¡También puede grabar su propio video y entrenar un modelo de geneface único para usted!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

Nuestros códigos se basan en los siguientes Repos: