| | | | 中文文档

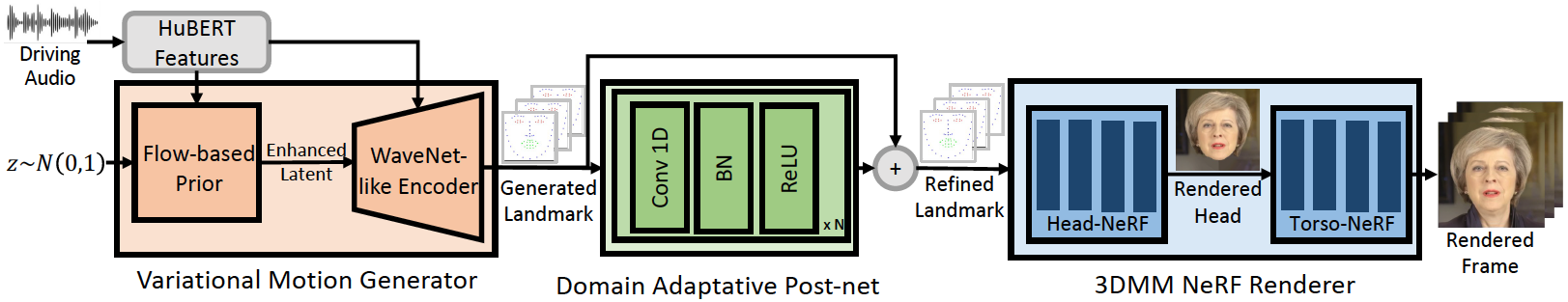

Repositori ini adalah implementasi Pytorch resmi dari makalah ICLR-2023 kami, di mana kami mengusulkan Geneface untuk pembuatan wajah yang digeneralisasikan dan digeneralisasikan audio. Pipa inferensi adalah sebagai berikut:

Geneface kami mencapai sinkronisasi bibir yang lebih baik dan ekspresif untuk audio di luar domain. Tonton video ini untuk perbandingan sinkronisasi bibir yang jelas terhadap metode berbasis NERF sebelumnya. Anda juga dapat mengunjungi halaman proyek kami untuk lebih jelasnya.

Kami telah merilis Kode Mimictalk (https://github.com/yerfor/mimictalk/), yang merupakan metode pembicaraan khusus yang berbasis di Sota Nerf dan mencapai kualitas visual yang lebih baik dan memungkinkan kontrol gaya bicara.

Kami telah merilis Code of Geneface ++ (https://github.com/yerfor/genefaceplusplus/), yang merupakan versi Geneface yang ditingkatkan dan mencapai lip-sync yang lebih baik, qaulity video, dan efisiensi sistem.

2023.3.16 Kami merilis pembaruan besar dalam rilis ini, demo video ada di sini. termasuk: 1) renderer berbasis rad-nerf, yang dapat menyimpulkan secara real-time dan dilatih dalam 10 jam. 2) Modul Deep3D_Reconstruction berbasis Pytorch, yang lebih mudah diinstal dan 8x lebih cepat dari versi berbasis TF sebelumnya. 3) Modul Audio2Motion pitch-Aware yang dapat menghasilkan lebih banyak landmark lip-sinc. 4) Perbaiki beberapa bug yang menyebabkan penggunaan memori besar. 5) Kami akan segera mengunggah kertas tentang pembaruan ini.2023.2.22 Kami merilis video demo selama 1 menit, di mana Geneface didorong oleh lagu Cina yang dihasilkan oleh Diffsinger.2023.2.20 Kami merilis strategi pasca pemrosesan tengara 3D yang stabil dalam inference/nerfs/lm3d_nerf_infer.py , yang meningkatkan stabilitas dan kualitas hasil akhir dengan margin besar. Kami menyediakan model pra-terlatih dan kumpulan data Geneface yang diproses dalam rilis ini untuk memungkinkan awal yang cepat. Berikut ini, kami menunjukkan cara menyimpulkan model pra-terlatih dalam 4 langkah. Jika Anda ingin melatih Geneface pada video target orang Anda sendiri, silakan jangkau bagian berikut ( Prepare Environments , Prepare Datasets , dan Train Models ).

Langkah1. Buat python env baru bernama geneface mengikuti panduan di docs/prepare_env/install_guide.md .

Langkah2. Unduh lrs3.zip dan May.zip dalam rilis dan unzip ke direktori checkpoints .

Langkah3. Proses Dataset May.mp4 Mengikuti Panduan di docs/process_data/process_target_person_video.md . Kemudian Anda dapat melihat file output bernama data/binary/videos/May/trainval_dataset.npy .

Setelah langkah -langkah di atas, struktur checkpoints dan direktori data Anda akan terlihat seperti ini:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

Anda dapat menemukan video output bernama infer_out/May/pred_video/zozo.mp4 .

Harap ikuti langkah -langkah di docs/prepare_env .

Harap ikuti langkah -langkah di docs/process_data .

Harap ikuti langkah -langkah di docs/train_models .

Terlepas dari May.mp4 yang disediakan dalam repo ini, kami juga menyediakan 8 video target orang yang digunakan dalam percobaan kami. Anda dapat mengunduhnya di tautan ini. Untuk melatih pada video baru bernama <video_id>.mp4 , Anda harus menempatkannya ke dalam data/raw/videos/ direktori, kemudian membuat folder baru di egs/datasets/videos/<video_id> dan mengedit file konfigurasi, sesuai dengan folder contoh yang disediakan egs/datasets/videos/May .

Anda juga dapat merekam video Anda sendiri dan melatih model Geneface yang unik untuk diri Anda sendiri!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

Kode kami didasarkan pada repo berikut: