| | | | 中文文档

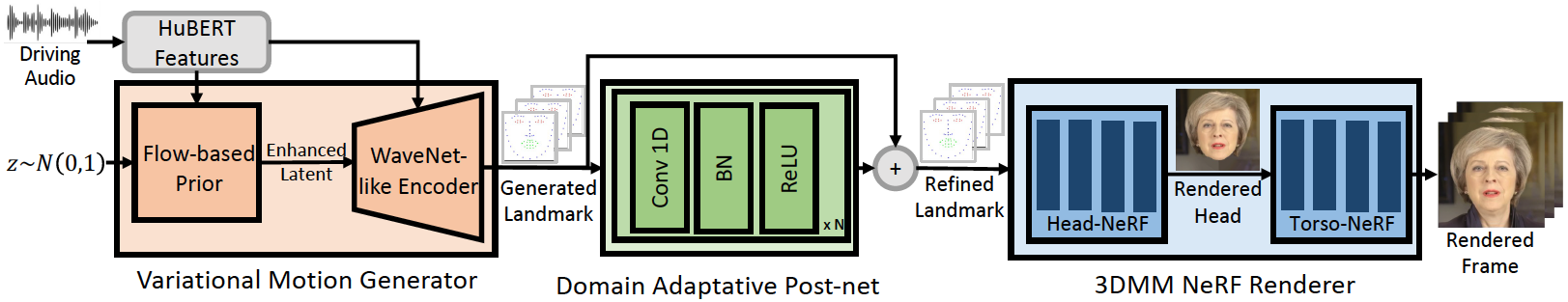

Ce référentiel est la mise en œuvre officielle Pytorch de notre article ICLR-2023, dans lequel nous proposons GenEFACE pour la génération de visage parlante audio généralisée et haute fidélité. Le pipeline d'inférence est le suivant:

Notre GenEFACE réalise une meilleure synchronisation des lèvres et expressivité aux audios hors du domaine. Regardez cette vidéo pour une comparaison claire de synchronisation labiale avec les méthodes basées sur le NERF précédentes. Vous pouvez également visiter notre page de projet pour plus de détails.

Nous avons publié le code de Mimictalk (https://github.com/yerfor/mimictalk/), qui est une méthode de parole spécifique à la personne basée à Sota Nerf et atteint une meilleure qualité visuelle et permet un contrôle du style de discussion.

Nous avons publié le code de Geneface ++ (https://github.com/yerfor/GenefacePluSplus/), qui est une version améliorée de GenEFACE et réalise une meilleure synchronisation labiale, la qualité vidéo et l'efficacité du système.

2023.3.16 Nous publions une grande mise à jour dans cette version, une démo vidéo est ici. y compris: 1) un rendu basé sur RAD-nerf, qui pourrait déduire en temps réel et être formé en 10 heures. 2) Module Deep3D_Reconstruction basé sur Pytorch, qui est plus facile à installer et est 8x plus rapidement que la version basée sur TF précédente. 3) Module AudioMotion audio 2 qui pourrait générer plus de monument synchronisé sur les lèvres. 4) Correction de certains bogues qui provoquent une grande utilisation de la mémoire. 5) Nous téléchargerons le document sur cette mise à jour bientôt.2023.2.22 Nous publions une vidéo de démonstration d'une minute, dans laquelle GenEface est motivée par une chanson chinoise générée par Diffsinger.2023.2.20 Nous publions une stratégie de post-traitement historique 3D stable dans inference/nerfs/lm3d_nerf_infer.py , qui améliore la stabilité et la qualité des résultats finaux par une grande marge. Nous fournissons des modèles prélevés et des ensembles de données traités de GeneFace dans cette version pour permettre un démarrage rapide. Dans ce qui suit, nous montrons comment déduire les modèles pré-formés en 4 étapes. Si vous souhaitez former Geneface sur votre propre vidéo de personne cible, veuillez atteindre les sections suivantes ( Prepare Environments , Prepare Datasets et Train Models ).

Étape 1. Créez un nouveau Python Env nommé geneface suivant le guide dans docs/prepare_env/install_guide.md .

Étape2. Téléchargez le lrs3.zip et May.zip dans la version et dézip dans le répertoire checkpoints .

Étape 3. Traitez l'ensemble de données de May.mp4 suivant le guide dans docs/process_data/process_target_person_video.md . Ensuite, vous pouvez voir un fichier de sortie nommé data/binary/videos/May/trainval_dataset.npy .

Après les étapes ci-dessus, la structure de vos checkpoints et de vos répertoires data devrait ressembler à ceci:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

Vous pouvez trouver une vidéo de sortie nommée infer_out/May/pred_video/zozo.mp4 .

Veuillez suivre les étapes de docs/prepare_env .

Veuillez suivre les étapes de docs/process_data .

Veuillez suivre les étapes de docs/train_models .

Outre le May.mp4 fourni dans ce dépôt, nous fournissons également 8 vidéos de personnes cibles qui ont été utilisées dans nos expériences. Vous pouvez les télécharger sur ce lien. Pour s'entraîner sur une nouvelle vidéo nommée <video_id>.mp4 , vous devez les placer dans le répertoire data/raw/videos/ , puis créer un nouveau dossier chez egs/datasets/videos/<video_id> et modifier les fichiers de configuration, selon l'exemple fourni egs/datasets/videos/May .

Vous pouvez également enregistrer votre propre vidéo et former un modèle GENEFACE unique pour vous-même!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

Nos codes sont basés sur les références suivantes: