| | | | 中文文档

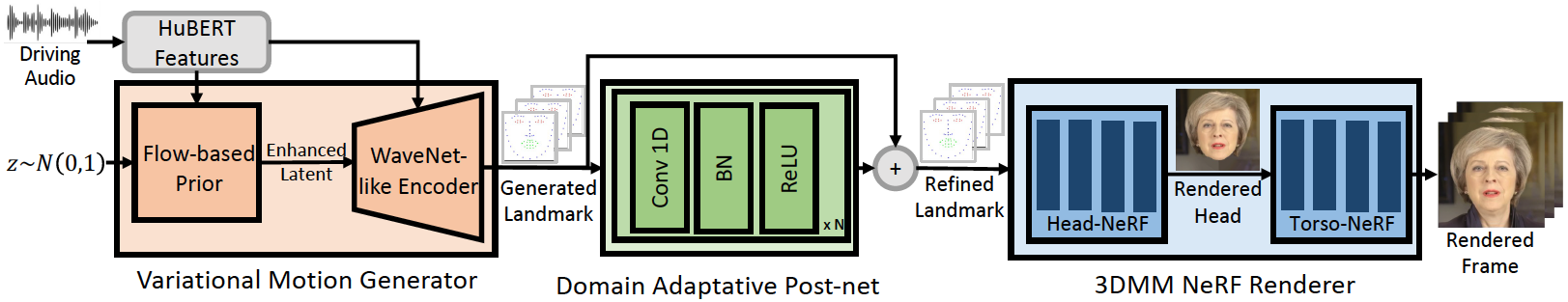

このリポジトリは、ICLR-2023ペーパーの公式のPytorch実装であり、一般化された高忠実度のオーディオ駆動型のトーキングフェイスジェネレーションのためにGenefaceを提案しています。推論パイプラインは次のとおりです。

私たちのGenefaceは、ドメイン外のオーディオに対してより良い唇の同期と表現力を実現します。以前のNERFベースの方法との明確なリップシンクの比較については、このビデオをご覧ください。詳細については、プロジェクトページをご覧ください。

Sota nerfベースの人固有のトーキングフェイスメソッドであるMimictalk(https://github.com/yerfor/mimictalk/)のコードをリリースしました。

Geneface ++(https://github.com/yerfor/genefaceplusplus/)のコードをリリースしました。

2023.3.16このリリースで大きなアップデートをリリースします。ビデオデモがこちらです。含む:1)RAD-NERFベースのレンダラー。リアルタイムで推測し、10時間で訓練される可能性があります。 2)PytorchベースのDeep3D_Reconstructionモジュールは、インストールが簡単で、以前のTFベースのバージョンよりも8倍高速です。 3)より多くのリップシンクランドマークを生成できるピッチアウェアAudio2Motionモジュール。 4)メモリの使用量が大きいバグを修正します。 5)このアップデートに関する論文をまもなくアップロードします。2023.2.22 1分間のデモビデオをリリースします。このビデオでは、GenefaceはDiffsingerによって生成された中国語の歌によって駆動されます。2023.2.20 inference/nerfs/lm3d_nerf_infer.pyで安定した3Dランドマーク後処理戦略をリリースし、最終結果の安定性と品質を大きなマージンで改善します。 このリリースで、事前に訓練されたモデルとジーンフェイスの処理されたデータセットを提供して、クイックスタートを可能にします。以下では、事前に訓練されたモデルを4つのステップで推測する方法を示します。自分のターゲットパーソンビデオでGenefaceをトレーニングしたい場合は、次のセクションにアクセスしてください( Prepare Environments 、 Prepare Datasets 、 Train Models )。

ステップ1。 docs/prepare_env/install_guide.mdのガイドに続いて、 genefaceという名前の新しいpython envを作成します。

ステップ2。リリースでlrs3.zipとMay.zipをダウンロードし、 checkpointsディレクトリに解凍します。

ステップ3。 docs/process_data/process_target_person_video.mdのガイドに続くMay.mp4のデータセットを処理します。次に、 data/binary/videos/May/trainval_dataset.npyという名前の出力ファイルを表示できます。

上記の手順の後、 checkpointsとdataディレクトリの構造は次のようになります。

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

infer_out/May/pred_video/zozo.mp4という名前の出力ビデオを見つけることができます。

docs/prepare_envの手順に従ってください。

docs/process_dataの手順に従ってください。

docs/train_modelsの手順に従ってください。

このリポジトリで提供されているMay.mp4とは別に、実験で使用された8つのターゲットパーソンビデオも提供しています。このリンクでダウンロードできます。 <video_id>.mp4という名前の新しいビデオでトレーニングするには、 data/raw/videos/ directoryに配置し、 egs/datasets/videos/<video_id>で新しいフォルダーを作成し、 egs/datasets/videos/Mayに従って構成ファイルを編集する必要があります。

また、独自のビデオを録画して、ユニークなGenefaceモデルを自分で訓練することもできます。

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

私たちのコードは、次のレポに基づいています。