| | | | 中文文档

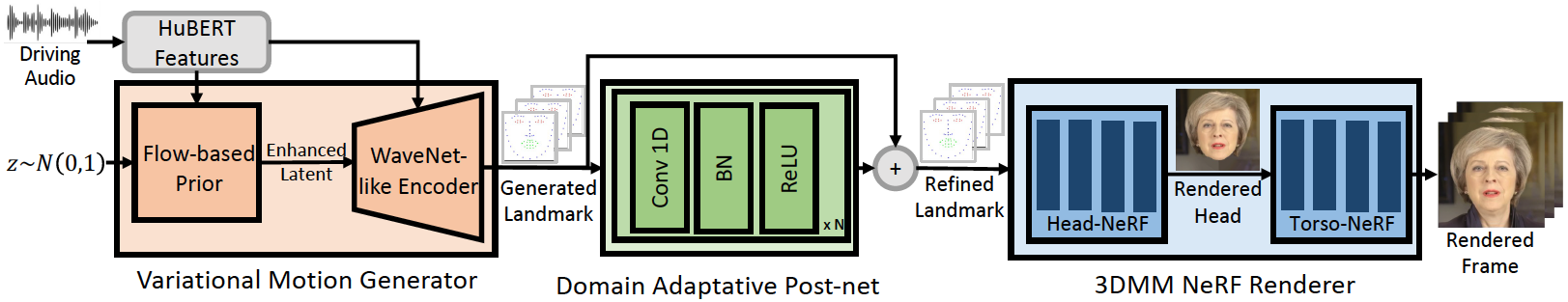

Этот репозиторий является официальной внедрением Pytorch нашей статьи ICLR-2013, в которой мы предлагаем GeneFace для генерализованного и высокого уровня, управляемого звуком, ориентированным на разговорные лица. Трубопровод вывода заключается в следующем:

Наш GeneFace достигает лучшей синхронизации губ и выразительности с вне домена звуков. Посмотрите это видео для прозрачного сравнения с синхронизацией губ с предыдущими методами на основе NERF. Вы также можете посетить нашу страницу проекта для более подробной информации.

Мы выпустили Кодекс Mimictalk (https://github.com/yerfor/mimictalk/), который представляет собой метод говорящего лица на основе человека на основе SOTA Nerf и достигает лучшего визуального качества и позволяет управлять стилем разговора.

Мы выпустили код GeneFace ++ (https://github.com/yerfor/genefaceplusplus/), которая представляет собой обновленную версию Geneface и достигает лучшей Sync, видео и эффективности системы.

2023.3.16 Мы выпускаем большое обновление в этом выпуске, видео демонстрация видео. в том числе: 1) рендерер на основе RAD-Snerf, который может вывести в режиме реального времени и обучаться через 10 часов. 2) модуль Deep3d_reconstruction на основе Pytorch, который проще установить и в 8 раз быстрее, чем предыдущая версия на основе TF. 3) модуль Audio2motion с планом Audio2motion, который может генерировать больше Lip-Sync Landmark. 4) Исправьте некоторые ошибки, которые вызывают большую память. 5) Мы загрузим статью об этом обновлении в ближайшее время.2023.2.22 Мы выпускаем демо-видео длиной 1 минуты, в котором GeneFace управляется китайской песней, сгенерированной Diffsinger.2023.2.20 Мы выпускаем стабильную трехмерную стратегию постобработки в inference/nerfs/lm3d_nerf_infer.py , которая улучшает стабильность и качество окончательных результатов с большим запасом. Мы предоставляем предварительно обученные модели и обработанные наборы данных GeneFace в этом выпуске, чтобы обеспечить быстрый запуск. Далее мы показываем, как вывести предварительно обученные модели в 4 шагах. Если вы хотите тренировать GeneFace на своем собственном видео целевого лица, перейдите к следующим разделам ( Prepare Environments , Prepare Datasets и Train Models ).

Шаг 1. Создайте новый Python Env с именем geneface после руководства в docs/prepare_env/install_guide.md .

Шаг 2. Загрузите lrs3.zip и May.zip в релизе и разкачивайте его в каталог checkpoints .

Шаг 3. Обработайте набор данных May.mp4 Следуя руководству в docs/process_data/process_target_person_video.md . Затем вы можете увидеть выходной файл с именем data/binary/videos/May/trainval_dataset.npy .

После вышеуказанных этапов структура ваших checkpoints и каталога data должна выглядеть так:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

Вы можете найти выходное видео с именем infer_out/May/pred_video/zozo.mp4 .

Пожалуйста, следуйте шагам в docs/prepare_env .

Пожалуйста, выполните шаги в docs/process_data .

Пожалуйста, следуйте шагам в docs/train_models .

Помимо May.mp4 , предоставленного в этом репо, мы также предоставляем 8 видео с целевым человеком, которые использовались в наших экспериментах. Вы можете скачать их по этой ссылке. Чтобы тренироваться на новом видео с именем <video_id>.mp4 , вы должны поместить его в data/raw/videos/ Directory, затем создать новую папку в egs/datasets/videos/<video_id> и редактировать файлы конфигурации, согласно предоставленной папке egs/datasets/videos/May .

Вы также можете записать свое собственное видео и тренировать уникальную модель Geneface для себя!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

Наши коды основаны на следующих репо: