| | | | 中文文档

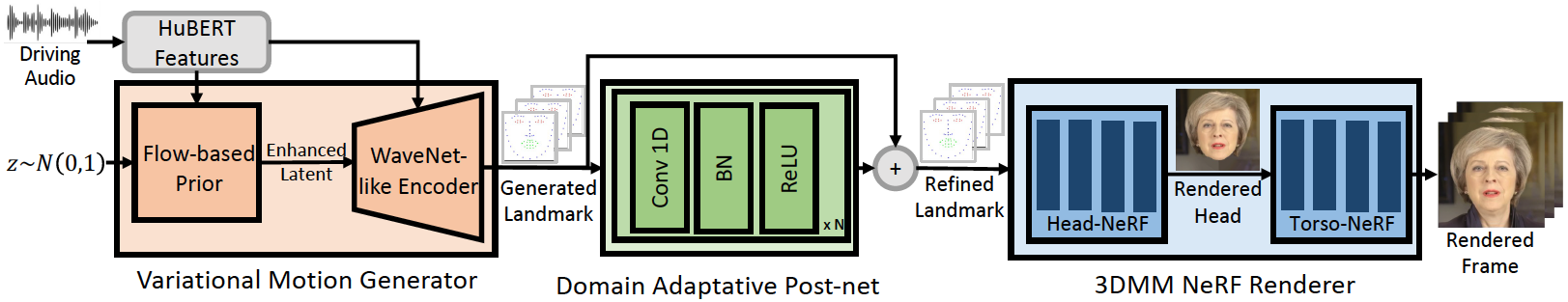

هذا المستودع هو تنفيذ Pytorch الرسمي لورقة ICLR-2023 الخاصة بنا ، والتي نقترح فيها Geneface لتوليد وجه معمور وتوليد وجهات محفوظة على الصوت. خط أنابيب الاستدلال كما يلي:

يحقق Geneface الخاص بنا مزامنة الشفاه بشكل أفضل والتعبير إلى صوتيات خارج المجال. شاهد هذا الفيديو لإجراء مقارنة واضحة للمزامنة مع الأساليب السابقة القائمة على NERF. يمكنك أيضًا زيارة صفحة المشروع لدينا لمزيد من التفاصيل.

لقد أصدرنا مدونة Mimictalk (https://github.com/yerfor/mimictalk/) ، وهي طريقة وجه محددة من الشخص القائم على Sota Nerf وتحقق جودة بصرية أفضل وتتيح التحكم في نمط الحديث.

لقد أصدرنا رمز Geneface ++ (https://github.com/yerfor/genefaceplus/) ، وهو نسخة تمت ترقيتها من GeneFace وتحقق أفضل شحنة ، و qaulity ، وكفاءة النظام.

2023.3.16 نقوم بإصدار تحديث كبير في هذا الإصدار ، عرض فيديو هنا. بما في ذلك: 1) العارض القائم على Rad-Nerf ، والذي يمكن أن يستنتج في الوقت الفعلي ويتم تدريبه في 10 ساعات. 2) وحدة DEEP3D_RECRETRUCTION التي تستند إلى PYTORCH ، والتي يسهل تثبيتها وهي أسرع 8x من الإصدار السابق المستند إلى TF. 3) وحدة Audio2Motion المدركة التي يمكن أن تولد المزيد من معلم تزامن الشفاه. 4) إصلاح بعض الأخطاء التي تسبب استخدام الذاكرة الكبير. 5) سنقوم بتحميل الورقة حول هذا التحديث قريبًا.2023.2.22 نطلق مقطع فيديو تجريبي لمدة دقيقة واحدة ، حيث يكون Geneface مدفوعًا بأغنية صينية تم إنشاؤها بواسطة Diffsinger.2023.2.20 نطلق استراتيجية ثلاثية الأبعاد مستقرة لما بعد المعالجة في inference/nerfs/lm3d_nerf_infer.py ، والتي تعمل على تحسين ثبات وجودة النتائج النهائية بهامش كبير. نحن نقدم نماذج مدربة مسبقًا ومجموعات بيانات معالجة من Geneface في هذا الإصدار لتمكين بداية سريعة. في ما يلي ، نظهر كيفية استنتاج النماذج التي تم تدريبها مسبقًا في 4 خطوات. إذا كنت ترغب في تدريب GeneFace على فيديو الشخص المستهدف الخاص بك ، فيرجى الوصول إلى الأقسام التالية ( Prepare Environments ، Prepare Datasets ، Train Models ).

Step1. قم بإنشاء Python Env جديد يدعى geneface باتباع الدليل في docs/prepare_env/install_guide.md .

Step2. قم بتنزيل lrs3.zip و May.zip في الإصدار وفك ضغطه في دليل checkpoints .

Step3. معالجة مجموعة البيانات في May.mp4 باتباع الدليل في docs/process_data/process_target_person_video.md . ثم يمكنك رؤية ملف إخراج يسمى data/binary/videos/May/trainval_dataset.npy .

بعد الخطوات المذكورة أعلاه ، يجب أن يبدو هيكل checkpoints ودليل data هكذا:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

يمكنك العثور على مقطع فيديو مخرج اسمه infer_out/May/pred_video/zozo.mp4 .

يرجى اتباع الخطوات الموجودة في docs/prepare_env .

يرجى اتباع الخطوات في docs/process_data .

يرجى اتباع الخطوات في docs/train_models .

بصرف النظر عن May.mp4 المقدمة في هذا الريبو ، فإننا نقدم أيضًا 8 مقاطع فيديو مستهدفة تم استخدامها في تجاربنا. يمكنك تنزيلها على هذا الرابط. للتدريب على مقطع فيديو جديد يسمى <video_id>.mp4 ، يجب عليك وضعه في data/raw/videos/ Directory ، ثم إنشاء مجلد جديد على egs/datasets/videos/<video_id> وتحرير ملفات التكوين ، وفقًا لمجموعات المجلد egs/datasets/videos/May .

يمكنك أيضًا تسجيل الفيديو الخاص بك وتدريب نموذج Geneface فريد لنفسك!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

تعتمد رموزنا على إعادة الشراء التالية: