- - - - 中文文档

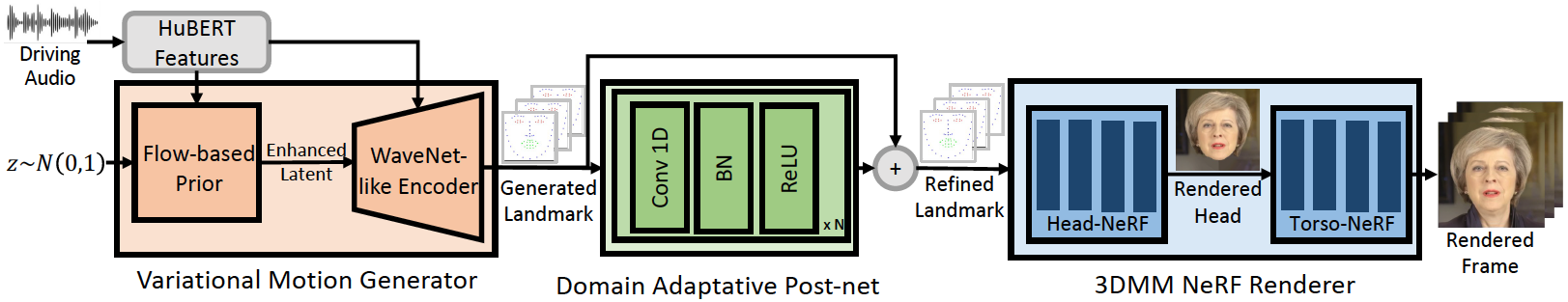

พื้นที่เก็บข้อมูลนี้คือการใช้งาน Pytorch อย่างเป็นทางการของกระดาษ ICLR-20123 ของเราซึ่งเราเสนอ Geneface สำหรับการสร้างใบหน้าที่ขับเคลื่อนด้วยเสียงที่ขับเคลื่อนด้วยเสียงทั่วไปและมีความเที่ยงตรงสูง การอนุมานไปป์ไลน์มีดังนี้:

Geneface ของเราประสบความสำเร็จในการซิงโครไนซ์และการแสดงออกของริมฝีปากที่ดีขึ้นกับเสียงที่ไม่อยู่ในโดเมน ดูวิดีโอนี้สำหรับการเปรียบเทียบ Lip-Sync ที่ชัดเจนกับวิธีการที่ใช้ NERF ก่อนหน้า คุณสามารถเยี่ยมชมหน้าโครงการของเราสำหรับรายละเอียดเพิ่มเติม

เราได้เปิดตัวรหัสของ Mimictalk (https://github.com/yerfor/mimictalk/) ซึ่งเป็นวิธีการพูดคุยที่เฉพาะเจาะจงของบุคคลที่ใช้ Sota Nerf และบรรลุคุณภาพการมองเห็นที่ดีขึ้น

เราได้เปิดตัวรหัสของ Geneface ++ (https://github.com/yerfor/genefaceplusplus/) ซึ่งเป็นเวอร์ชันที่อัพเกรดของ Geneface และบรรลุลิปซิงก์วิดีโอ qaulity และประสิทธิภาพของระบบ

2023.3.16 เราเปิดตัวการอัปเดตครั้งใหญ่ในรุ่นนี้วิดีโอสาธิตอยู่ที่นี่ รวมถึง: 1) เรนเดอร์ที่ใช้ RAD-NENF ซึ่งสามารถอนุมานได้ตามเวลาจริงและได้รับการฝึกฝนใน 10 ชั่วโมง 2) โมดูล Deep3D_Reconstruction ที่ใช้ Pytorch ซึ่งติดตั้งได้ง่ายกว่าและเร็วกว่ารุ่น TF ก่อนหน้านี้ 8x 3) โมดูล Audio2Motion ที่รับรู้ระดับเสียงซึ่งสามารถสร้างสถานที่สำคัญของลิปซิงค์ได้มากขึ้น 4) แก้ไขข้อบกพร่องบางอย่างที่ทำให้เกิดการใช้หน่วยความจำขนาดใหญ่ 5) เราจะอัปโหลดกระดาษเกี่ยวกับการอัปเดตนี้เร็ว ๆ นี้2023.2.22 เราเปิดตัววิดีโอตัวอย่างยาว 1 นาทีซึ่ง Geneface ได้รับแรงหนุนจากเพลงจีนที่สร้างโดย Diffsinger2023.2.20 เราเปิดตัวกลยุทธ์หลังการประมวลผล 3D ที่มีเสถียรภาพใน inference/nerfs/lm3d_nerf_infer.py ซึ่งปรับปรุงความมั่นคงและคุณภาพของผลลัพธ์สุดท้ายด้วยอัตรากำไรขั้นต้นขนาดใหญ่ เรามีโมเดลที่ผ่านการฝึกอบรมมาล่วงหน้าและชุดข้อมูลที่ประมวลผลของ Geneface ในรุ่นนี้เพื่อเปิดใช้งานการเริ่มต้นอย่างรวดเร็ว ในต่อไปนี้เราจะแสดงวิธีการอนุมานรุ่นที่ผ่านการฝึกอบรมมาก่อนใน 4 ขั้นตอน หากคุณต้องการฝึกอบรม Geneface ในวิดีโอบุคคลเป้าหมายของคุณเองโปรดไปยังส่วนต่อไปนี้ ( Prepare Environments Prepare Datasets และ Train Models )

ขั้นตอนที่ 1. สร้าง Env Python ใหม่ชื่อ geneface ตามคำแนะนำใน docs/prepare_env/install_guide.md

ขั้นตอนที่ 2. ดาวน์โหลด lrs3.zip และ May.zip ในการเปิดตัวและคลายซิปลงในไดเรกทอรี checkpoints

ขั้นตอนที่ 3. ประมวลผลชุดข้อมูลของ May.mp4 ตามคำแนะนำใน docs/process_data/process_target_person_video.md จากนั้นคุณสามารถดูไฟล์เอาต์พุตชื่อ data/binary/videos/May/trainval_dataset.npy

หลังจากขั้นตอนข้างต้นโครงสร้างของ checkpoints และไดเรกทอรี data ของคุณควรมีลักษณะเช่นนี้:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

คุณสามารถค้นหาวิดีโอเอาต์พุตชื่อ infer_out/May/pred_video/zozo.mp4

โปรดทำตามขั้นตอนใน docs/prepare_env

โปรดทำตามขั้นตอนใน docs/process_data

โปรดทำตามขั้นตอนใน docs/train_models

นอกเหนือจาก May.mp4 ที่ให้ไว้ใน repo นี้เรายังมีวิดีโอบุคคลเป้าหมาย 8 รายการที่ใช้ในการทดลองของเรา คุณสามารถดาวน์โหลดได้ที่ลิงค์นี้ ในการฝึกอบรมวิดีโอใหม่ชื่อ <video_id>.mp4 คุณควรวางลงใน data/raw/videos/ ไดเรกทอรีจากนั้นสร้างโฟลเดอร์ใหม่ที่ egs/datasets/videos/<video_id> และแก้ไขไฟล์ config ตามตัวอย่างของโฟลเดอร์ egs/datasets/videos/May

นอกจากนี้คุณยังสามารถบันทึกวิดีโอของคุณเองและฝึกอบรม Geneface ที่ไม่เหมือนใครด้วยตัวคุณเอง!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

รหัสของเราขึ้นอยู่กับ repos ต่อไปนี้: