| | | | 中文文档

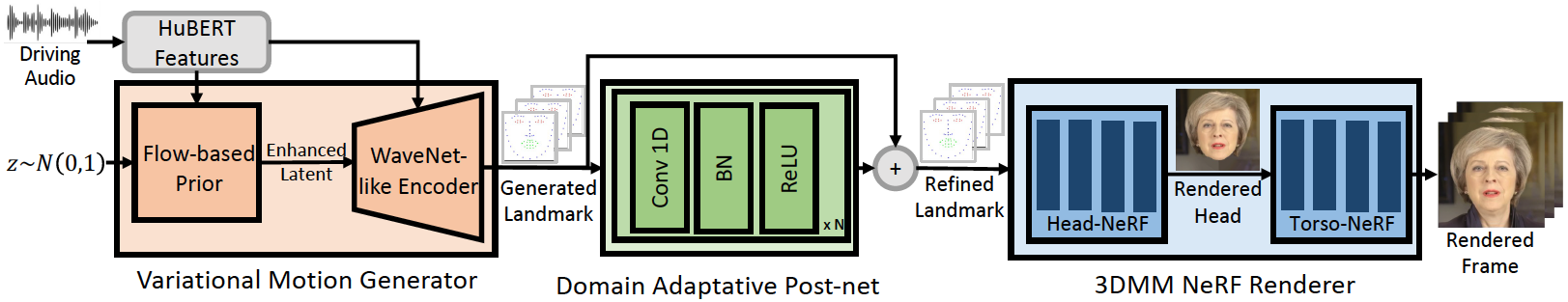

该存储库是我们ICLR-2023论文的官方Pytorch实施,在其中我们提出了用于广义和高保真音频驱动的会说话的面部发电的基因表面。推理管道如下:

我们的Geneface可以更好地达到唇部的同步和对域外音频的表现力。观看此视频,以与以前的基于NERF的方法进行清晰的唇部同步比较。您还可以访问我们的项目页面以获取更多详细信息。

我们已经发布了Mimictalk(https://github.com/yerfor/mimictalk/)的守则,这是一种基于SOTA NERF的人 - 特殊说话的面部方法,并实现了更好的视觉质量,并启用了讲话样式控制。

我们已经发布了Geneface ++的代码(https://github.com/yerfor/genefaceplusplus/),该代码是Geneface的升级版本,并实现了更好的唇部,视频Qaulity和系统效率。

2023.3.16我们在此版本中发布了一个重大更新,视频演示在这里。包括:1)基于RAD-NERF的渲染器,可以实时推断并在10小时内进行培训。 2)基于Pytorch的DEEP3D_RECODSTRUCTION模块,该模块的安装易于安装,比以前的基于TF的版本快8倍。 3)俯仰感知音频2MOTION模块,该模块可能会产生更多的唇部同步地标。 4)修复一些导致大量内存使用的错误。 5)我们将很快上传有关此更新的论文。2023.2.22我们发行了一个长1分钟的演示视频,其中Geneface是由Diffsinger产生的中文歌曲驱动的。2023.2.20我们在inference/nerfs/lm3d_nerf_infer.py中发布了稳定的3D地标后处理策略,该策略提高了最终结果的稳定性和质量。 我们在此版本中提供了预先训练的模型和Geneface的处理数据集,以快速启动。在下文中,我们将展示如何以4个步骤推断预训练的模型。如果您想在自己的目标人视频上训练基因表,请访问以下各节( Prepare Environments , Prepare Datasets和Train Models )。

步骤1。根据docs/prepare_env/install_guide.md中的指南创建一个名为geneface的新的Python Env。

步骤2。在版本中下载lrs3.zip和May.zip ,然后将其解压缩到checkpoints目录中。

步骤3。处理docs/process_data/process_target_person_video.md中的指南中的May.mp4的数据集。然后,您可以看到一个名为data/binary/videos/May/trainval_dataset.npy的输出文件。

在上述步骤之后,您的checkpoints和data目录的结构应如下所示:

> checkpoints

> lrs3

> lm3d_vae_sync

> syncnet

> May

> lm3d_postnet_sync

> lm3d_radnerf

> lm3d_radnerf_torso

> data

> binary

> videos

> May

trainval_dataset.npy

bash scripts/infer_postnet.sh

bash scripts/infer_lm3d_radnerf.sh

# bash scripts/infer_radnerf_gui.sh # you can also use GUI provided by RADNeRF

您可以找到一个名为infer_out/May/pred_video/zozo.mp4的输出视频。

请按照docs/prepare_env中的步骤操作。

请按照docs/process_data中的步骤操作。

请按照docs/train_models中的步骤操作。

除了本仓库中提供的May.mp4外,我们还提供了8个实验中使用的目标人视频。您可以在此链接上下载它们。要在名为<video_id>.mp4的新视频上训练,您应该将其放入data/raw/videos/ DERICTORY中,然后根据提供的示例文件夹egs/datasets/videos/<video_id> egs/datasets/videos/May <VIDEO_ID>上创建一个新文件夹并编辑配置文件。

您还可以录制自己的视频并为自己培训独特的基因表模型!

@article{ye2023geneface,

title={GeneFace: Generalized and High-Fidelity Audio-Driven 3D Talking Face Synthesis},

author={Ye, Zhenhui and Jiang, Ziyue and Ren, Yi and Liu, Jinglin and He, Jinzheng and Zhao, Zhou},

journal={arXiv preprint arXiv:2301.13430},

year={2023}

}

我们的代码基于以下存储库: