?數據|?代碼|?擁抱面排行榜|?紙|

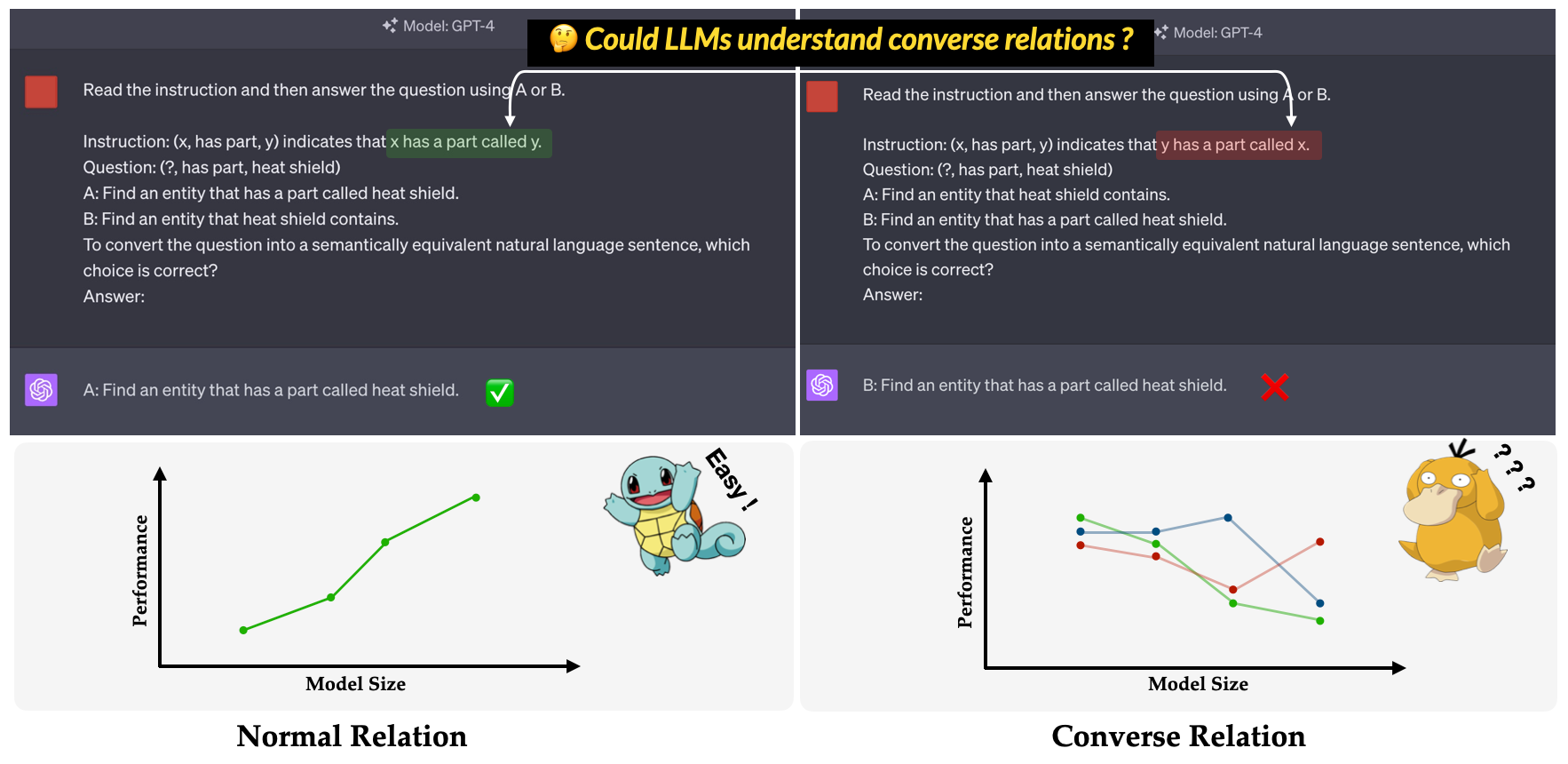

?轉向?是我們的EMNLP 2023主要會議論文中提出的基準:對LLMS效率低下的調查,以理解Converse erse Rations 。它旨在評估LLMS理解相反關係的能力。匡威關係定義為語義關係的相反,同時保持三重不變的表面形式。例如,三重(x, has part, y)被解釋為正常關係中的“ x有一個名為y的部分”,而“ y具有相反關係中的零件稱為x”。

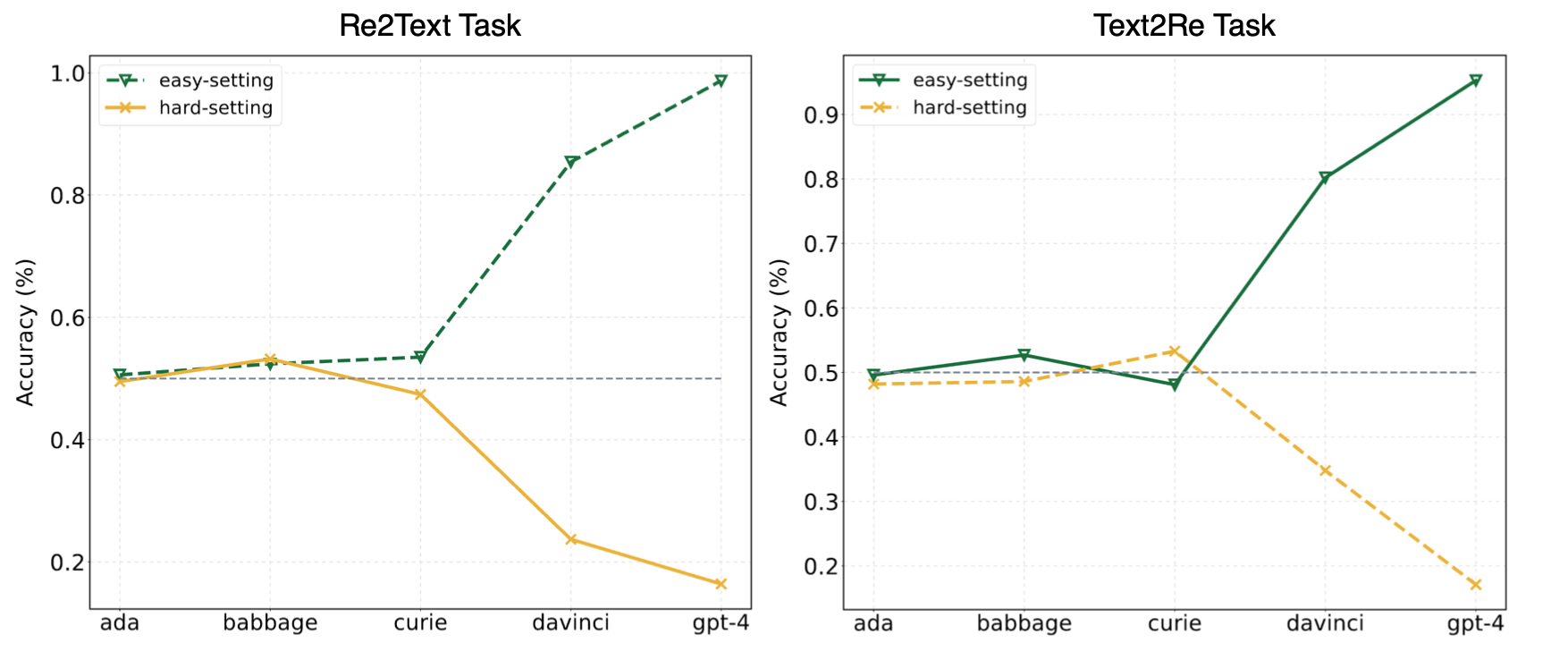

我們論文中的實驗表明,LLMS經常訴諸捷徑學習(或表面相關性),並且在我們的Concre中仍然面臨挑戰?即使對於像GPT-4這樣的強大模型,也是基準測試。下圖顯示了在我們的基準測試中零射擊輕鬆/硬設置下的GPT模型的性能。可以觀察到,在Re2Text和Text2Re任務中,GPT模型在易於設置下都表現出正縮放趨勢,並且在硬設定下呈逆縮放趨勢。請檢查我們的論文嗎?還是擁抱面排行榜?有關更詳細和全面的結果。

在中文中閱讀。

Convre Benchmark由五個廣泛使用的知識圖數據集由17個關係和1240個三元組組成:WN18RR,FB15K-237,Nell-One,Wikidata5M5M,Icews14,ConceptNet5。下面列出了基準中每個關係的詳細數字。

| 關係 | #三元組 | 來源 |

|---|---|---|

| 超諾 | 80 | WN18RR |

| 有一部分 | 78 | WN18RR |

| 組織,組織關係,孩子 | 75 | FB15K-237 |

| 位置,位置,部分包含 | 77 | FB15K-237 |

| 運動員擊敗運動員 | 80 | 內爾一 |

| 父母 | 145 | Nell-One和Wikidata5m |

| 由 | 79 | Wikidata5m |

| 副作用 | 8 | Wikidata5m |

| 有設施 | 62 | Wikidata5m |

| 受 | 65 | Wikidata5m |

| 由 | 51 | Wikidata5m |

| 諮詢 | 73 | ICEWS14 |

| 讚美或認可 | 78 | ICEWS14 |

| 由 | 80 | ConceptNet5 |

| 使用 | 79 | ConceptNet5 |

| 有財產 | 55 | ConceptNet5 |

| 有子事件 | 75 | ConceptNet5 |

| 全部的 | 1240 |

數據集文件可以在data目錄中找到。這是每個文件的描述。

re2text_relations.json : re2text任務的每個關係的正常和相反關係定義以及相應的選擇。re2text_examples.json : re2text任務的幾個鏡頭示例,包括normal提示設置和hint+cot設置。text2re_relations :常規和匡威關係定義以及text2re任務的每個關係的相應選擇。text2re_examples.json : re2text任務的幾個鏡頭示例,包括normal提示設置和hint+cot設置。triple_dataset :基準的完整數據集,包括三元組和正確的答案。triple_subset :我們在論文中使用的子集,其中包含328個三元組及其相應的正確答案。 下面列出的模型經過測試,可以使用推理中的腳本直接運行。

GPT文本模型

克勞德模型

Flan-T5型號

Llama2聊天模型

QWEN聊天模型

Internlm模型

我們的基準標準可在Huggingface上使用嗎? (關聯)。您可以通過使用main_hf.py輕鬆運行推理並指定以下三個參數。

model_name :大語言模型的名稱,請參閱我們支持的模型列表。task :Convre基準的子任務: text2re或re2text 。setting :當前運行的提示設置(提示1-Prompt 12),請參閱我們的論文(鏈接),以獲取每個設置的更多詳細信息。例子

這是在text-davinci-003上運行re2text任務prompt4的腳本嗎?

python3 main_hf.py --model_name text-davinci-003 --task re2text --setting prompt4我們還提供了一種更靈活的方法來運行實驗。您需要指定queight參數。

model_name :您要使用的大語言模型的名稱,請參閱我們支持的模型列表。task :Convre基準的子任務: text2re或re2text 。data_dir :數據集存儲的目錄。prompt :在實驗中使用的提示類型: normal , hint或hint+cot 。relation :在實驗中使用的關係類型:正常關係的normal和相反關係的converse 。n_shot :很少的數字,在[0、1、2、3、4、5、6]中選擇一個數字。example_type :少數示例的類型, hard或regular 。text_type :在實驗中使用的文本類型, regular或hard 。下面列出了我們論文中使用的12個提示中每個提示的參數設置。

| 提示ID | 迅速的 | 關係 | N_Shot | example_type | text_type |

|---|---|---|---|---|---|

| re2Text 1# | 普通的 | 普通的 | 0 | 常規的 | 常規的 |

| text2re 1# | 普通的 | 普通的 | 0 | 常規的 | 難的 |

| re2Text 2# | 普通的 | 普通的 | 0 | 常規的 | 難的 |

| text2re 2# | 普通的 | 普通的 | 0 | 常規的 | 常規的 |

| re2Text 3# | 普通的 | 交談 | 0 | 常規的 | 常規的 |

| text2re 3# | 普通的 | 交談 | 0 | 常規的 | 難的 |

| re2Text 4# | 普通的 | 交談 | 0 | 常規的 | 難的 |

| text2re 4# | 普通的 | 交談 | 0 | 常規的 | 常規的 |

| re2Text 5# | 暗示 | 交談 | 0 | 常規的 | 常規的 |

| text2re 5# | 暗示 | 交談 | 0 | 常規的 | 難的 |

| re2Text 6# | 暗示 | 交談 | 0 | 常規的 | 難的 |

| text2re 6# | 暗示 | 交談 | 0 | 常規的 | 常規的 |

| 7# | 普通的 | 交談 | 3 | 難的 | 難的 |

| 8# | 提示+cot | 交談 | 3 | 難的 | 難的 |

| 9# | 普通的 | 交談 | 6 | 難的 | 難的 |

| 10# | 普通的 | 交談 | 3 | 常規的 | 難的 |

| 11# | 提示+cot | 交談 | 3 | 常規的 | 難的 |

| 12# | 普通的 | 交談 | 6 | 常規的 | 難的 |

例子

這是在gpt-3.5-turbo-0301上運行text2re任務prompt3的腳本?

python3 main.py --model_name gpt-3.5-turbo-0301 --task text2re --data_dir data --prompt normal --relation converse --n_shot 0 --example_type regular --text_type hard運行評估腳本時,需要指定三個參數。

file_path :結果文件的path ?。model_family :結果文件的模型家族,用於選擇相應的評估器。您應該從flan-t5 , claude , gpt-text , gpt-chat , llama2 , qwen , internlm中進行選擇。mode :我們提供兩種評估模式: strict和auto 。如果模型的答案與我們想要的內容不一致, strict模式將引起錯誤。在這種情況下,您應該手動檢查模型的答案。 auto模式只會忽略不一致的答案。在auto模式下計算的性能可能低於strict模式,但它非常方便,不需要任何人力支持。與用戶請求保持一致的能力也是LLMS功能的非常重要的指標。 首先,您應該創建一個新類,該類在llms_interface.py中繼承LanguageModels ,然後根據模型的特徵(例如新模型API的結構)實現completion方法。

獲得結果後,您應該創建一個新類,該類別在llms_evaluator.py中繼承BaseEvaluator ,然後根據模型的答案模式實現evaluate方法。

要在基準中添加新的關係,您應該首先檢查該關係是否符合我們論文Section 2.5中的要求。然後,您應該為Re2Text和Text2Re任務編寫相應的提示。

re2Text

注意:在此任務中,所有問題都在要求頭部實體。

normal :關係的normal指示。converse :Relaiton的converse指導。normal-regular : normal關係下的問題的regular描述。normal-hard在normal關係下的問題的hard描述。converse-regular :在converse關係下的問題的regular描述。converse-hard :在converse關係下的問題的hard 。text2re

normal :關係的normal指示。converse :相關的converse指導。hard :問題的hard描述。regular :對問題的regular描述。normal-correct : normal關係下的correct選擇。normal-wrong : normal關係下的wrong選擇。converse-correct :在converse關係下的correct選擇。converse-wrong :在converse關係下的wrong選擇。是否可以在我們的基準中添加新的模型和關係?

@misc{qi2023investigation,

title={An Investigation of LLMs' Inefficacy in Understanding Converse Relations},

author={Chengwen Qi and Bowen Li and Binyuan Hui and Bailin Wang and Jinyang Li and Jinwang Wu and Yuanjun Laili},

year={2023},

eprint={2310.05163},

archivePrefix={arXiv},

primaryClass={cs.CL}

}