؟ البيانات |؟ الكود |؟ Leadingface Leadorboard |؟ ورقة |

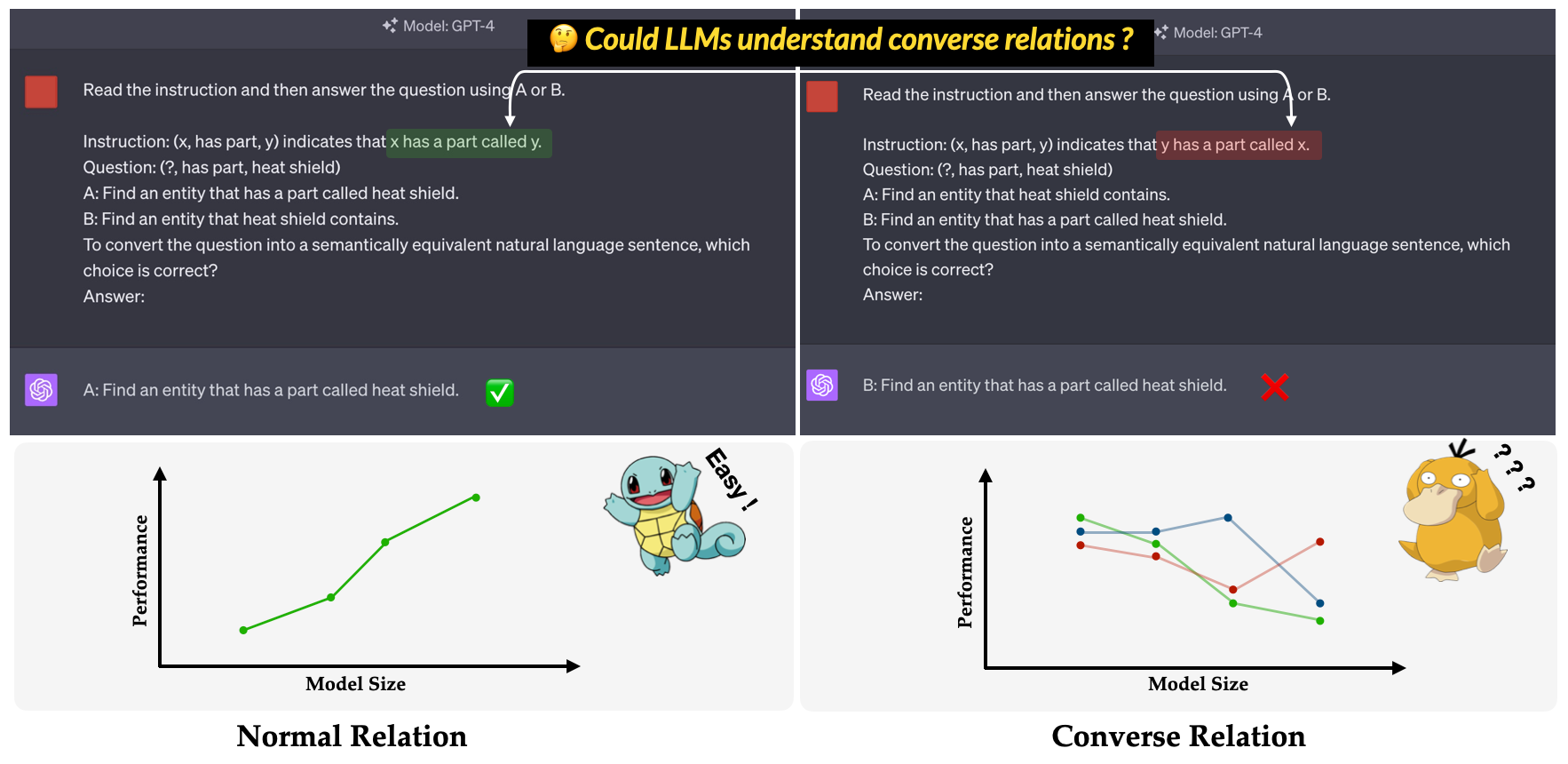

؟ القافلة ؟ هو المعيار المقترح في ورقة المؤتمر الرئيسية EMNLP 2023: التحقيق في عدم فعالية LLMS في فهم الإقناع . ويهدف إلى تقييم قدرة LLMS على فهم العلاقات العكس. يتم تعريف العلاقة العكسية على أنها عكس العلاقة الدلالية مع الحفاظ على الشكل السطحي من الثلاثي دون تغيير. على سبيل المثال ، يتم تفسير Triple (x, has part, y) على أنه "x له جزء يسمى y" في العلاقة العادية ، في حين أن "y لديه جزء يسمى x" في علاقة العكس؟.

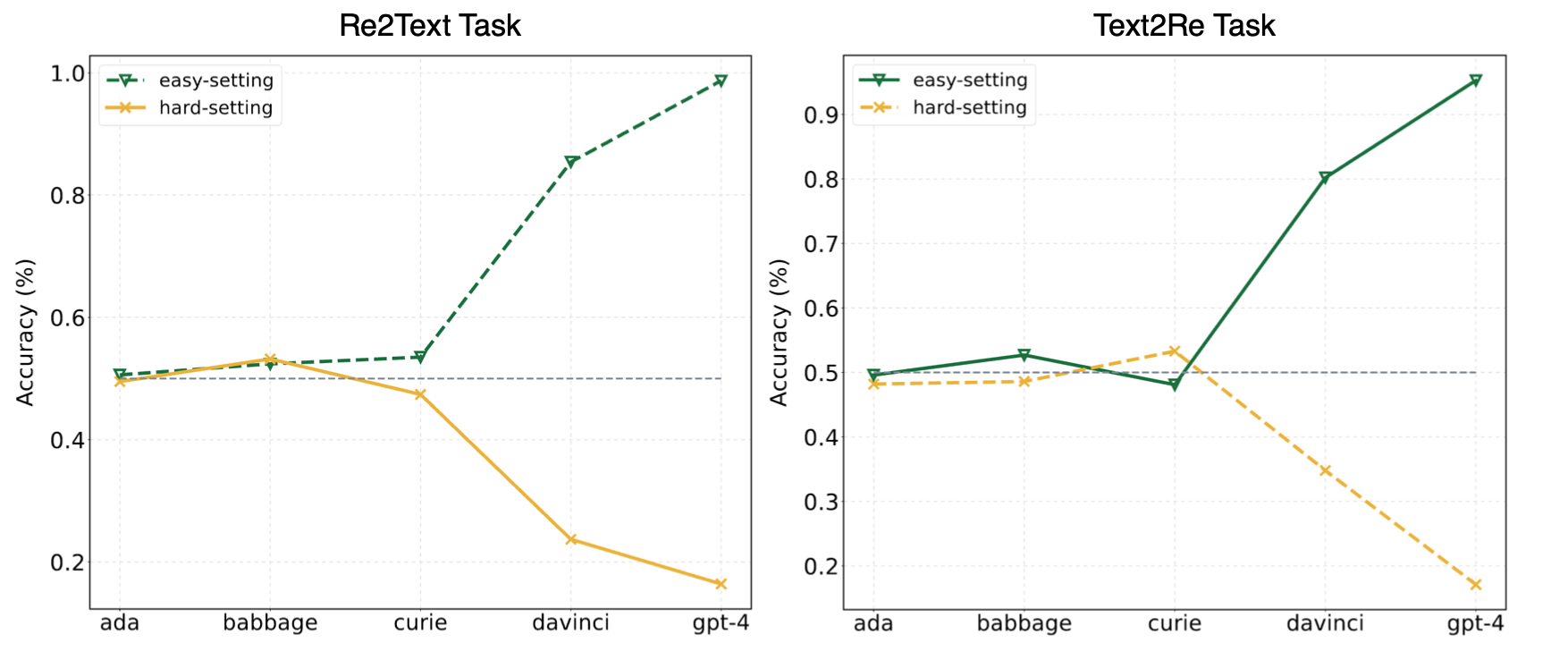

أشارت التجارب في ورقتنا إلى أن LLMs غالبًا ما تلجأ إلى التعلم المختصر (أو الارتباطات السطحية) وما زالت تواجه تحديات على القرد؟ المعيار حتى بالنسبة للنماذج القوية مثل GPT-4. تعرض الصورة التالية عروض نماذج GPT تحت إعدادات صفر سهلة/صعبة على معيارنا. يمكن ملاحظة أنه في كل من مهام Re2Text و Text2Re ، تظهر نماذج GPT اتجاهًا إيجابيًا للتوسع تحت تحديد اتجاه التحجيم السهل ، واتجاه التحجيم العكسي تحت تحديد الثابت. يرجى التحقق من ورقتنا؟ أو lextringboard Huggingface؟ لمزيد من النتائج التفصيلية والشاملة.

اقرأ هذا في 中文.

يتألف المعيار القائم من 17 علاقة و 1240 ثلاثية من خمس مجموعات بيانات الرسم البياني المعرفة على نطاق واسع: WN18RR ، FB15K-237 ، NELL-ONE ، WIKIDATA5M ، ICEWS14 ، ConceptNet5. يتم سرد العدد التفصيلي من الثلاثي لكل علاقة في المعيار أدناه.

| العلاقة | # الثلاثي | مصدر |

|---|---|---|

| Hypernym | 80 | wn18rr |

| لديه جزء | 78 | wn18rr |

| منظمة ، علاقة تنظيم ، طفل | 75 | FB15K-237 |

| الموقع ، الموقع ، يحتوي جزئيا | 77 | FB15K-237 |

| رياضي ضرب رياضي | 80 | نيل واحد |

| والد | 145 | Nell-One & Wikidata5m |

| يمثلها | 79 | ويكيداتا 5 م |

| أثر جانبي | 8 | ويكيداتا 5 م |

| لديه منشأة | 62 | ويكيداتا 5 م |

| تأثرت | 65 | ويكيداتا 5 م |

| مملوكة | 51 | ويكيداتا 5 م |

| استشارة | 73 | ICEWS14 |

| الحمد أو تأييد | 78 | ICEWS14 |

| صنع من | 80 | ConceptNet5 |

| تستخدم | 79 | ConceptNet5 |

| له الممتلكات | 55 | ConceptNet5 |

| لديه | 75 | ConceptNet5 |

| المجموع | 1240 |

يمكن العثور على ملفات مجموعة البيانات في دليل data . هنا وصف كل ملف.

re2text_relations.json : تعريف العلاقة العادية والعلاج والخيارات المقابلة لكل علاقة لمهمة re2text .re2text_examples.json : أمثلة قليلة لطلاقة المهمة re2text ، بما في ذلك إعداد المطالبة normal وإعداد hint+cot .text2re_relations : تعريف العلاقة العادية والعلاج والخيارات المقابلة لكل علاقة لمهمة text2re .text2re_examples.json : أمثلة لقطة قليلة لمهمة re2text ، بما في ذلك إعداد المطالبة normal وإعداد hint+cot .triple_dataset : مجموعة بيانات كاملة من المعيار ، بما في ذلك ثلاثية والإجابات الصحيحة.triple_subset : المجموعة الفرعية التي استخدمناها في ورقتنا ، تحتوي على 328 ثلاث مرات وإجاباتها الصحيحة المقابلة. يتم اختبار النماذج المدرجة أدناه ويمكن تشغيلها مباشرة باستخدام البرنامج النصي في الاستدلال.

نماذج نص GPT

نماذج كلود

نماذج Flan-T5

نماذج الدردشة Llama2

طرز دردشة Qwen

نماذج Internlm

معيارنا متاح على Luggingface؟ (وصلة). يمكنك بسهولة تشغيل الاستدلال باستخدام main_hf.py وتحديد الوسائط الثلاث التالية.

model_name : اسم نموذج اللغة الكبير ، راجع قائمة النماذج المدعومة لدينا.task : المهام الفرعية للمعيار القياسي: text2re أو re2text .setting : إعداد موجه للتشغيل الحالي (Promper1-Prompt 12) ، يرجى الرجوع إلى الورقة (الرابط) لمزيد من التفاصيل عن كل إعداد.مثال

هنا هو البرنامج النصي لتشغيل prompt4 لمهمة re2text على text-davinci-003 ؟

python3 main_hf.py --model_name text-davinci-003 --task re2text --setting prompt4نحن نقدم أيضًا طريقة أكثر مرونة لتشغيل التجارب. هناك حجج eight التي تحتاج إلى تحديدها.

model_name : اسم نموذج اللغة الكبير الذي تريد استخدامه ، راجع قائمة النماذج المدعومة لدينا.task : المهام الفرعية للمعيار القياسي: text2re أو re2text .data_dir : الدليل حيث مجموعة البيانات المخزنة.prompt : نوع المطالبة للاستخدام في التجربة: normal أو hint أو hint+cot .relation : نوع العلاقة لاستخدامه في التجربة: normal للعلاقة الطبيعية converse عن علاقة العكس.n_shot : أرقام قليلة ، اختر رقمًا في [0 ، 1 ، 2 ، 3 ، 4 ، 5 ، 6].example_type : نوع أمثلة قليلة ، hard أو regular .text_type : نوع النص المراد استخدامه في التجربة ، regular أو hard .يتم سرد إعدادات الوسيطة لكل موجه 12 المستخدمة في ورقتنا أدناه.

| معرف موجه | اِسْتَدْعَى | العلاقة | n_shot | example_type | text_type |

|---|---|---|---|---|---|

| re2text 1# | طبيعي | طبيعي | 0 | عادي | عادي |

| text2re 1# | طبيعي | طبيعي | 0 | عادي | صعب |

| re2text 2# | طبيعي | طبيعي | 0 | عادي | صعب |

| text2re 2# | طبيعي | طبيعي | 0 | عادي | عادي |

| re2text 3# | طبيعي | عكس | 0 | عادي | عادي |

| text2re 3# | طبيعي | عكس | 0 | عادي | صعب |

| re2text 4# | طبيعي | عكس | 0 | عادي | صعب |

| text2re 4# | طبيعي | عكس | 0 | عادي | عادي |

| re2text 5# | تَلمِيح | عكس | 0 | عادي | عادي |

| text2re 5# | تَلمِيح | عكس | 0 | عادي | صعب |

| re2text 6# | تَلمِيح | عكس | 0 | عادي | صعب |

| text2re 6# | تَلمِيح | عكس | 0 | عادي | عادي |

| 7# | طبيعي | عكس | 3 | صعب | صعب |

| 8# | تلميح+سرير | عكس | 3 | صعب | صعب |

| 9# | طبيعي | عكس | 6 | صعب | صعب |

| 10# | طبيعي | عكس | 3 | عادي | صعب |

| 11# | تلميح+سرير | عكس | 3 | عادي | صعب |

| 12# | طبيعي | عكس | 6 | عادي | صعب |

مثال

هنا هو البرنامج النصي لتشغيل prompt3 لمهمة text2re على gpt-3.5-turbo-0301 ؟

python3 main.py --model_name gpt-3.5-turbo-0301 --task text2re --data_dir data --prompt normal --relation converse --n_shot 0 --example_type regular --text_type hardهناك ثلاث وسيطات يجب تحديدها عند تشغيل البرنامج النصي للتقييم.

file_path : path ملف النتيجة؟.model_family : عائلة النموذج لملف النتيجة ، المستخدمة لاختيار المقيِّم المقابل. يجب عليك الاختيار من بين flan-t5 ، claude ، gpt-text ، gpt-chat ، llama2 ، qwen ، internlm .mode : نقدم وضعين للتقييم: strict وذات auto . سوف يرفع الوضع strict أخطاء إذا كانت إجابة النموذج متسقة مع ما نريد. في هذه الحالة ، يجب عليك التحقق من إجابة النموذج يدويًا. سوف يتجاهل الوضع auto الإجابات غير المتسقة. قد يكون الأداء المحسوب تحت الوضع auto أقل من الوضع strict ، لكنه مناسب للغاية ولا يحتاج إلى أي دعم بشري. تعد القدرة على التوافق مع طلب المستخدم أيضًا مؤشرًا مهمًا للغاية على قدرة LLMS. أولاً ، يجب عليك إنشاء فئة جديدة ترث LanguageModels في llms_interface.py ، ثم تنفيذ طريقة completion وفقًا لخصائص (مثل بنية واجهة برمجة تطبيقات النموذج الجديد) للنموذج الخاص بك.

بعد الحصول على النتيجة ، يجب عليك إنشاء فئة جديدة ترث BaseEvaluator في llms_evaluator.py ، ثم تنفيذ طريقة evaluate وفقًا لنمط إجابة النموذج الخاص بك.

لإضافة علاقة جديدة في المؤشر ، يجب عليك أولاً التحقق مما إذا كانت العلاقة تفي بالمتطلبات الواردة في Section 2.5 من ورقتنا. ثم يجب عليك كتابة المطالبات المقابلة لكل من مهام Re2Text و Text2Re .

re2text

ملاحظة: في هذه المهمة ، كل السؤال هو طرح كيان الرأس.

normal : التعليمات normal للعلاقة.converse : تعليمات converse من Relaiton.normal-regular : الوصف regular للسؤال تحت العلاقة normal .normal-hard : الوصف hard للسؤال تحت العلاقة normal .converse-regular : الوصف regular للسؤال تحت علاقة converse .converse-hard : الوصف hard للسؤال قيد العلاقة converse .text2re

normal : التعليمات normal للعلاقة.converse : تعليمات converse من Relaton.hard : الوصف hard للسؤال.regular : الوصف regular للسؤال.normal-correct : الاختيار correct تحت العلاقة normal .normal-wrong : الاختيار wrong تحت العلاقة normal .converse-correct : الاختيار correct تحت علاقة converse .converse-wrong : الاختيار wrong تحت علاقة converse .لا تتردد في إضافة نماذج وعلاقات جديدة إلى مؤشرنا؟

@misc{qi2023investigation,

title={An Investigation of LLMs' Inefficacy in Understanding Converse Relations},

author={Chengwen Qi and Bowen Li and Binyuan Hui and Bailin Wang and Jinyang Li and Jinwang Wu and Yuanjun Laili},

year={2023},

eprint={2310.05163},

archivePrefix={arXiv},

primaryClass={cs.CL}

}