? Данные |? Код |? Таблица лидеров объятия |? Бумага |

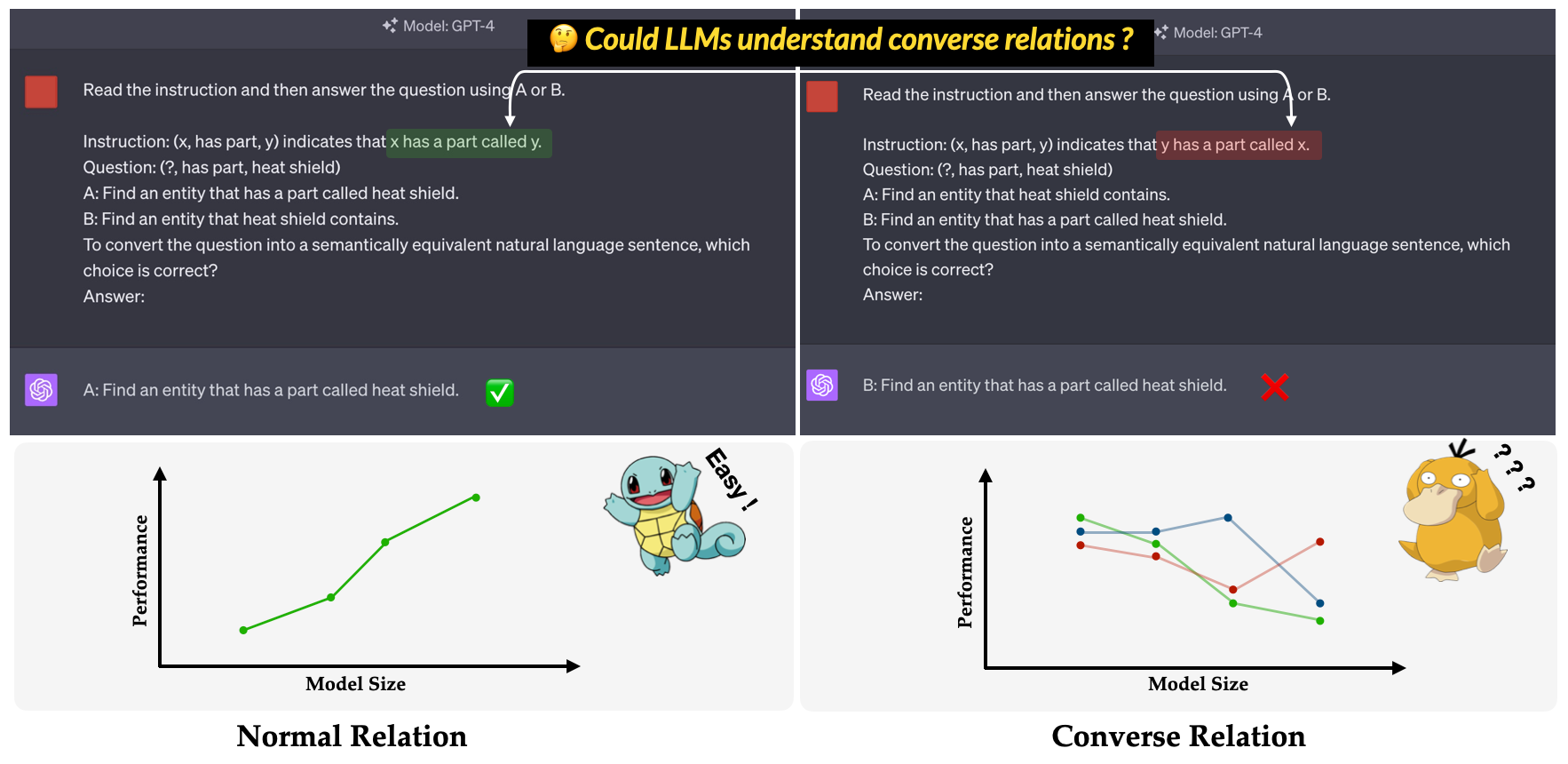

? Convre ? Является ли эталон , предложенный в нашем основном документе EMNLP 2023: расследование неэффективности LLMS в понимании убеждений . Он стремится оценить способность LLMS в понимании конверсических отношений. Отношение обратной связи определяется как противоположность семантическому соотношению при сохранении поверхностной формы тройной неизменной. Например, тройной (x, has part, y) интерпретируется как «x имеет часть, называемую Y» в нормальной связи, в то время как «y имеет часть, называемую x», в обращении?

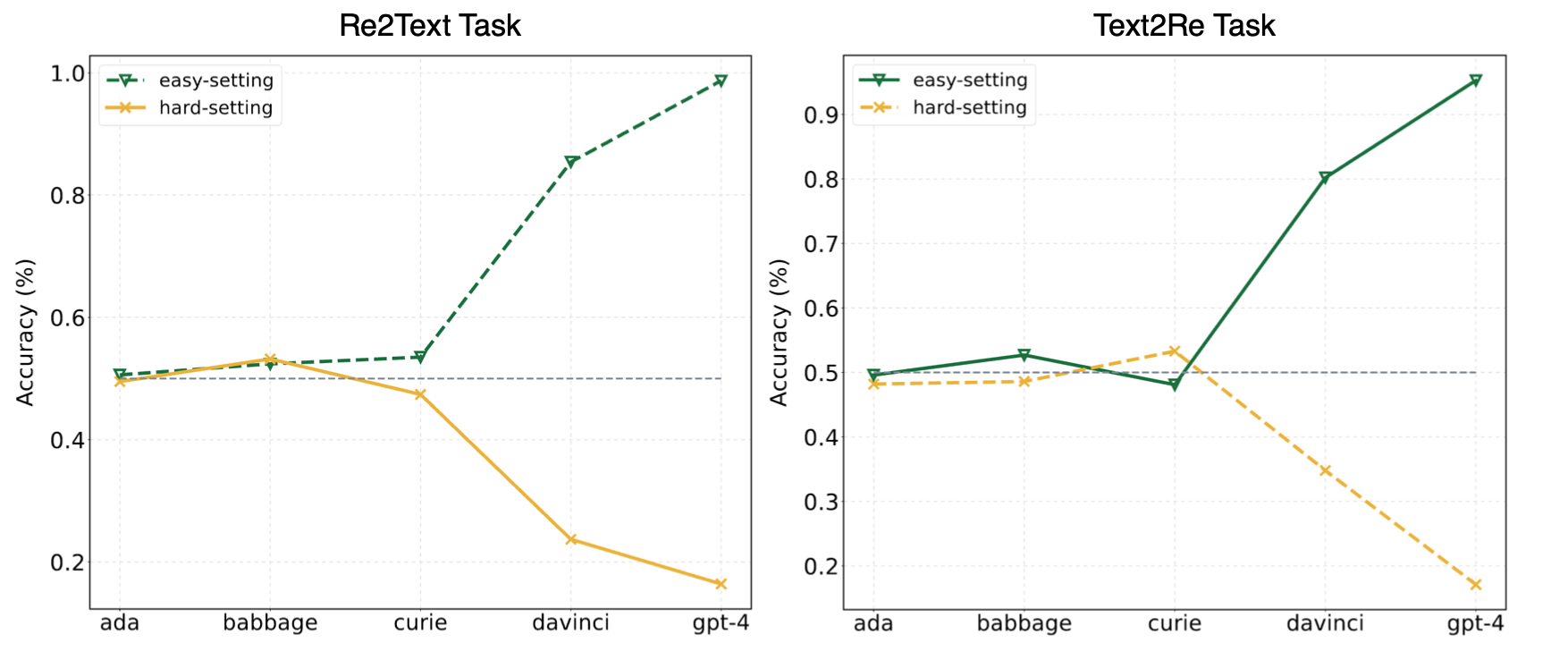

Эксперименты в нашей статье предполагали, что LLM часто прибегают к краткому обучению (или поверхностным корреляциям) и все еще сталкиваются с проблемами в нашем «Convre»? Clarkmark Даже для мощных моделей, таких как GPT-4. На следующей картине показаны характеристики моделей GPT под нулевым выстрелом, простыми/жесткими настройками на нашем эталонном этапе. Можно наблюдать, что как в задачах Re2Text , так и в Text2Re модели GPT демонстрируют положительную тенденцию масштабирования при легком установлении и тренде обратного масштабирования при твердых. Пожалуйста, проверьте нашу газету? Или таблица лидеров объятия? Для более подробных и всесторонних результатов.

Прочитайте это в 中文.

Convre Benchmark состоит из 17 отношений и 1240 тройков из пяти широко используемых наборов графиков знаний: WN18RR, FB15K-237, Nell-One, Wikidata5m, ICEWS14, ConceptNet5. Подробное количество тройков для каждого соотношения в эталоне перечислено ниже.

| Связь | # Тройки | Источник |

|---|---|---|

| гипернам | 80 | Wn18rr |

| имеет часть | 78 | Wn18rr |

| организация, организационные отношения, ребенок | 75 | FB15K-237 |

| местоположение, местоположение, частично содержит | 77 | FB15K-237 |

| Спортсмен победил спортсмена | 80 | Нелл-один |

| родитель | 145 | Nell-One & Wikidata5m |

| представлено | 79 | Wikidata5m |

| побочный эффект | 8 | Wikidata5m |

| имеет объект | 62 | Wikidata5m |

| под влиянием | 65 | Wikidata5m |

| принадлежащий | 51 | Wikidata5m |

| консультироваться | 73 | ICEWS14 |

| хвала или одобрить | 78 | ICEWS14 |

| сделанный из | 80 | ConceptNet5 |

| используется из | 79 | ConceptNet5 |

| имеет собственность | 55 | ConceptNet5 |

| имеет подвласть | 75 | ConceptNet5 |

| Общий | 1240 |

Файлы набора данных можно найти в каталоге data . Вот описание каждого файла.

re2text_relations.json : нормальное и обратное определение отношения и соответствующие варианты каждого отношения для задачи re2text .re2text_examples.json : несколько примеров выстрела задачи re2text , включая normal настройку подсказки и настройку hint+cot .text2re_relations : Определение нормального и обратного соотношения и соответствующие варианты каждого отношения для задачи text2re .text2re_examples.json : несколько примеров выстрела задачи re2text , включая normal настройку подсказки и настройку hint+cot .triple_dataset : полный набор данных контрольного знака, включая тройки и правильные ответы.triple_subset : подмножество, которое мы использовали в нашей статье, он содержит 328 тройки и их соответствующие правильные ответы. Модели, перечисленные ниже, протестированы и могут быть запущены непосредственно, используя сценарий по выводу.

Text Models GPT

Клод модели

Модели FLAN-T5

Llama2 чата модели

Qwen Chat Models

Internlm модели

Наш тест доступен на Huggingface? (связь). Вы можете легко запустить вывод, используя main_hf.py и указав следующие три аргумента.

model_name : имя модели большой языка, см. Наш поддерживаемый список моделей.task : подзадача Convre Benchmark: text2re или re2text .setting : Настройка приглашения для текущего запуска (reffice1-prompt 12), пожалуйста, обратитесь к нашей статье (ссылке) для получения более подробной информации о каждом настройке.Пример

Вот скрипт для запуска prompt4 задачи re2text на text-davinci-003 ?

python3 main_hf.py --model_name text-davinci-003 --task re2text --setting prompt4Мы также предоставляем более гибкий способ управления экспериментами. There are ️eight arguments you need to specify.

model_name : имя модели большой языка, которую вы хотите использовать, см. Наш поддерживаемый список моделей.task : подзадача Convre Benchmark: text2re или re2text .data_dir : каталог, где хранится набор данных.prompt : тип подсказки для использования в эксперименте: normal , hint или hint+cot .relation : тип отношения к использованию в эксперименте: normal для нормальной связи и converse для обратного отношения.n_shot : несколько выстрелов, выберите число в [0, 1, 2, 3, 4, 5, 6].example_type : тип нескольких примеров, hard или regular .text_type : тип текста, который можно использовать в эксперименте, regular или hard .Настройки аргумента для каждой из 12 предложений, используемых в нашей статье, указаны ниже.

| Приглашение идентификатора | быстрый | связь | n_shot | example_type | text_type |

|---|---|---|---|---|---|

| Re2text 1# | нормальный | нормальный | 0 | обычный | обычный |

| Text2re 1# | нормальный | нормальный | 0 | обычный | жесткий |

| Re2text 2# | нормальный | нормальный | 0 | обычный | жесткий |

| Text2re 2# | нормальный | нормальный | 0 | обычный | обычный |

| Re2text 3# | нормальный | обратный | 0 | обычный | обычный |

| Text2re 3# | нормальный | обратный | 0 | обычный | жесткий |

| Re2text 4# | нормальный | обратный | 0 | обычный | жесткий |

| Text2re 4# | нормальный | обратный | 0 | обычный | обычный |

| Re2text 5# | намекать | обратный | 0 | обычный | обычный |

| Text2re 5# | намекать | обратный | 0 | обычный | жесткий |

| Re2text 6# | намекать | обратный | 0 | обычный | жесткий |

| Text2re 6# | намекать | обратный | 0 | обычный | обычный |

| 7# | нормальный | обратный | 3 | жесткий | жесткий |

| 8# | Подсказка+COT | обратный | 3 | жесткий | жесткий |

| 9# | нормальный | обратный | 6 | жесткий | жесткий |

| 10# | нормальный | обратный | 3 | обычный | жесткий |

| 11# | Подсказка+COT | обратный | 3 | обычный | жесткий |

| 12# | нормальный | обратный | 6 | обычный | жесткий |

Пример

Вот скрипт для запуска prompt3 задачи text2re на gpt-3.5-turbo-0301 ?

python3 main.py --model_name gpt-3.5-turbo-0301 --task text2re --data_dir data --prompt normal --relation converse --n_shot 0 --example_type regular --text_type hardПри запуске сценария оценки необходимо указать три аргумента.

file_path : path файла результата?model_family : семейство моделей файла результата, используемое для выбора соответствующего оценщика. Вы должны выбрать из flan-t5 , claude , gpt-text , gpt-chat , llama2 , qwen , internlm .mode : мы предоставляем два режима оценки: strict и auto . strict режим поднимет ошибки, если ответ модели не соответствует тому, что мы хотим. В этом случае вы должны проверить ответ модели вручную. auto режим просто игнорирует противоречивые ответы. Производительность, рассчитанная в auto режиме, может быть ниже, чем strict режим, но он очень удобен и не нуждается в поддержке человека. Возможность соответствовать запросу пользователя также является очень важным показателем возможности LLMS. Во -первых, вы должны создать новый класс, который наследует LanguageModels в llms_interface.py , а затем реализовать метод completion в соответствии с характеристиками (такими как структура API новой модели) вашей модели.

После получения результата вы должны создать новый класс, который наследует BaseEvaluator в llms_evaluator.py , а затем реализовать метод evaluate в соответствии с шаблоном ответа вашей модели.

Чтобы добавить новое соотношение в эталон, вы должны сначала проверить, соответствует ли отношение требования в Section 2.5 нашей статьи. Затем вам следует написать соответствующие подсказки как для задач Re2Text , так и Text2Re .

Re2text

Примечание. В этой задаче весь вопрос задает главную организацию.

normal : normal обучение отношения.converse : converse обучение Relaiton.normal-regular : regular описание вопроса под normal отношением.normal-hard : hard описание вопроса под normal отношением.converse-regular : regular описание вопроса в соответствии converse .converse-hard : hard описание вопроса в отношении converse Community.Text2re

normal : normal обучение отношения.converse : converse обучение относительно режима.hard : hard описание вопроса.regular : regular описание вопроса.normal-correct : correct выбор под normal отношением.normal-wrong : wrong выбор под normal отношением.converse-correct : correct выбор под converse отношением.converse-wrong : wrong выбор под converse отношением.Не стесняйтесь добавлять новые модели и отношения к нашему эталону?

@misc{qi2023investigation,

title={An Investigation of LLMs' Inefficacy in Understanding Converse Relations},

author={Chengwen Qi and Bowen Li and Binyuan Hui and Bailin Wang and Jinyang Li and Jinwang Wu and Yuanjun Laili},

year={2023},

eprint={2310.05163},

archivePrefix={arXiv},

primaryClass={cs.CL}

}