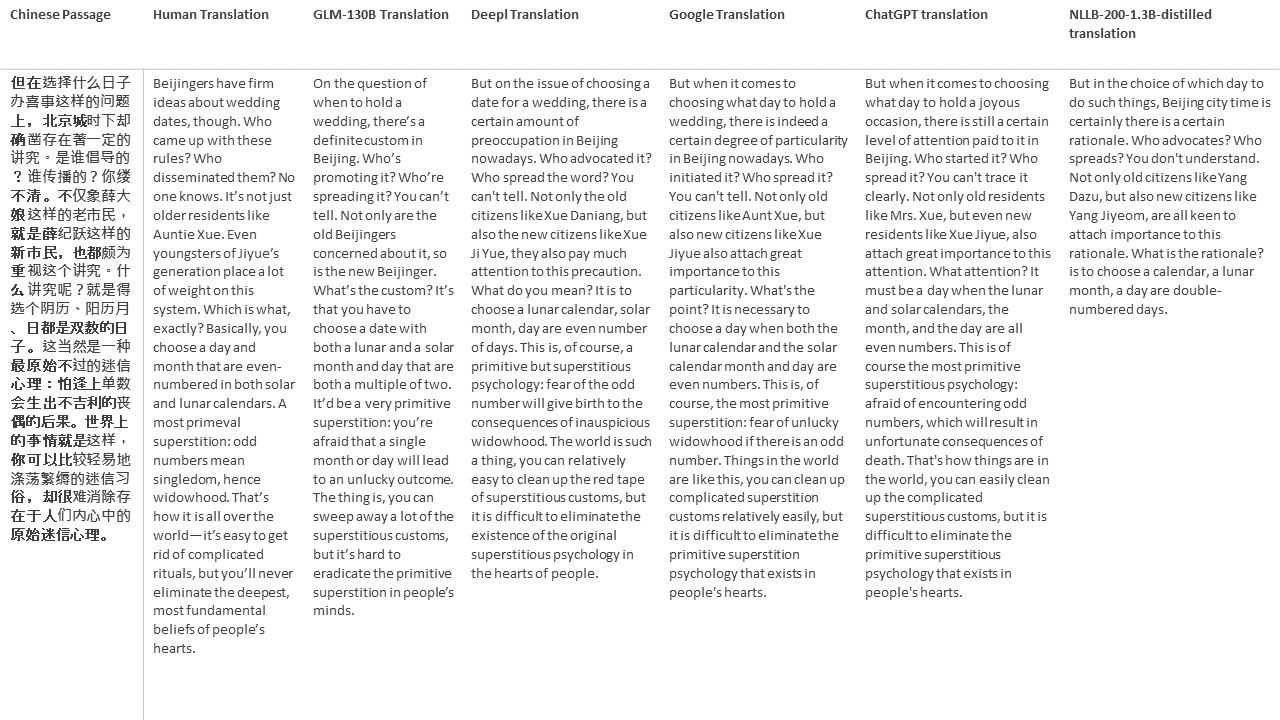

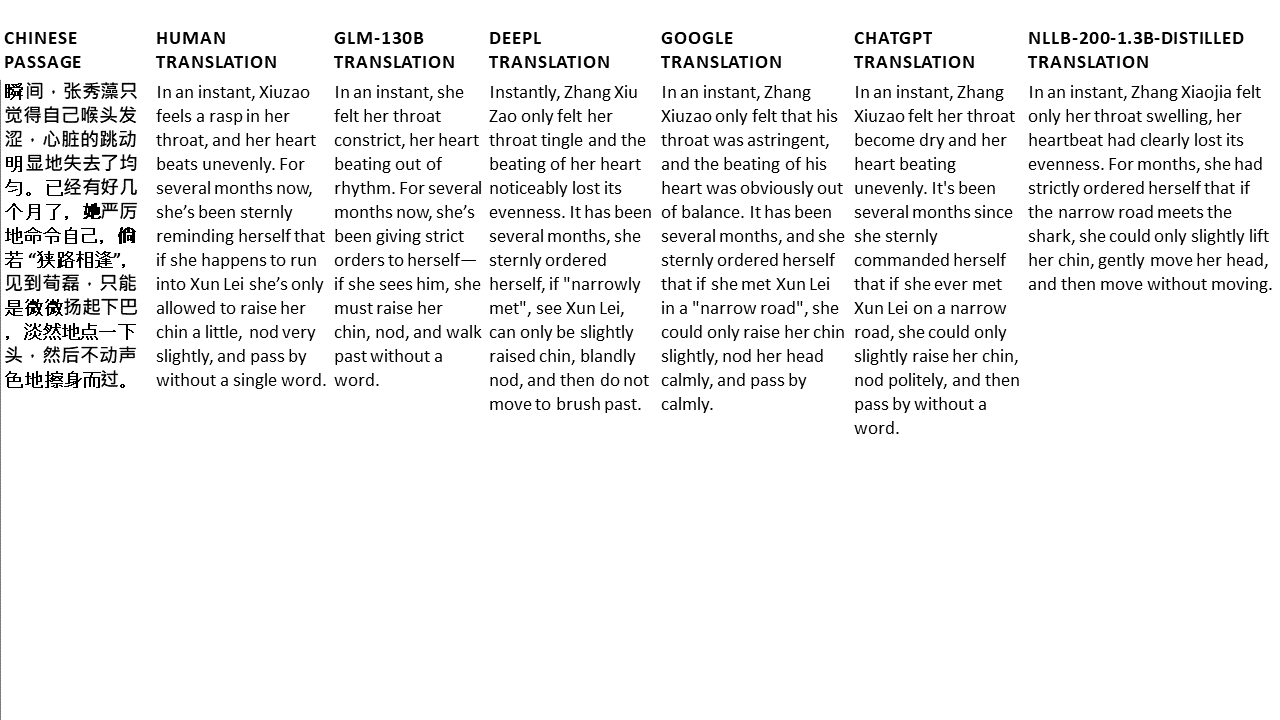

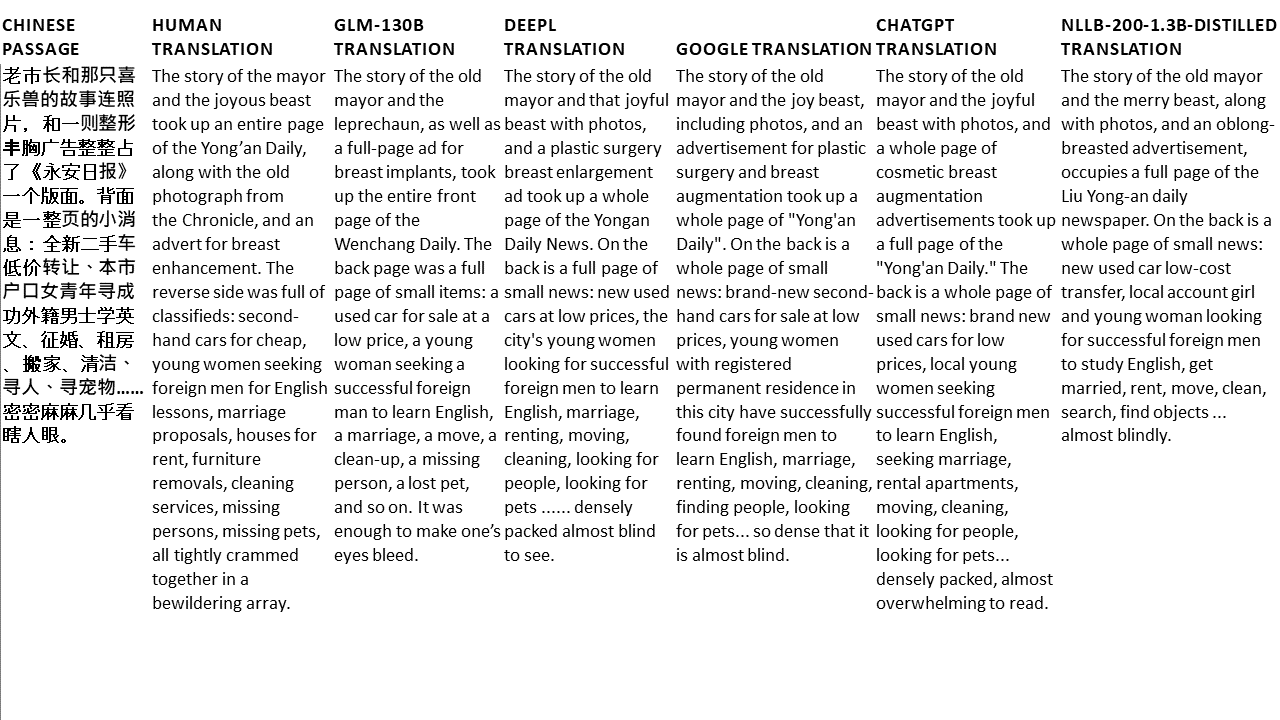

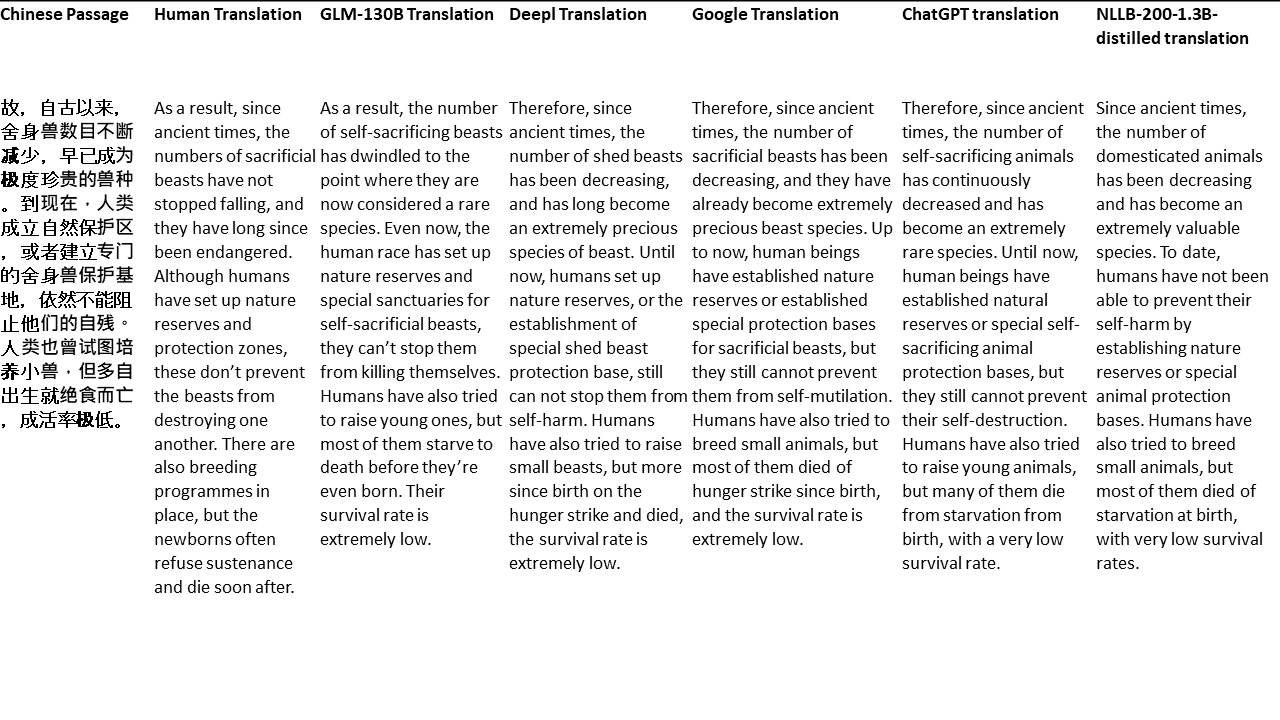

在过去的几年中,用于应对翻译的传统机器学习技术已经看到了很大的技术改进。但是,他们仍然在语言家族树上相距甚远的语言。例如,英语和中文/韩语/日语。

由于这些模型为何处理这些任务的本质(无法推断上下文,疯狂的语法等),我想知道在多语言语料库中训练的足够规模的鉴定的大语言模型(LLM)将如何执行。双语LLM可以在翻译任务上近似双语人吗?

当然,第一步是选择一个测试模型。很少有双语或多语言模型都经过足够的规模训练,并且对所讨论的两种语言具有相同或接近平等的培训数据表示。我感谢Thudm的团队培训和发布GLM-130B,这是一家双语LLM,对英语和中文的2000亿个代币进行了培训(总计400B)。 (https://github.com/thudm/glm-130b)。

这是用于测试的主要模型。此处可用的演示-https://huggingface.co/spaces/thudm/glm-130b,因为GLM-130B未经指导,需要进行几声或单次弹药提示策略进行翻译策略。在初步测试中,我注意到翻译的复杂性和质量与少数拍摄示例的复杂性和质量的相关性。结果,我的一次性提示包括简短的段落和一本用英语翻译和出版的中文书中的相应翻译。

我对GLM-130b的一击提示

Chinese: 同北京许许多多同龄的老市民一样,薛大娘现在绝不是一个真正迷信的人,她知道迷信归根结蒂都是瞎掰,遇上听人讲述哪里有个老太太信神信鬼闹出乱子,她还会真诚地拍著大腿笑著说几句嘲讽的话;但她又同许许多多同龄的老市民一样,内心还揣著个求吉利的想法。

English: Like many Beijingers her age, she isn’t really superstitious—when you come right down to it, it’s just a bunch of random nonsense. Stories of old ladies fussing about visits from gods or ghosts have her slapping her thigh and making some cutting remark. Yet, also like many Beijingers her age, she has her own ideas about summoning good luck.

Chinese: Chinese text to translate

English: [gMASK]参数默认除外

打开AI的GPT模型具有多种语言,具有极端的英语偏见(〜92.6%的英语,单词计数)(https://github.com/openai/gpt-3/blob/master/master/master/dataset_statistics/languages/languages_by_by_by_by_word_count.csv)。但是,由于一种语言的能力似乎使其他语言的能力以足够规模的LLM流血(在非常大的英语语言模型的多语言能力上,https://arxiv.org/abs/2108.13349),我还包括比较中的chatgpt translions。由于Chatgpt是按照指令对准的,因此一个简单的翻译命令就足够且使用了。特定的说明或示例以优先考虑流利性和流动性,可能会产生更好的结果。

没有留下的语言,Meta的NLLB-200在机器翻译基准上实现了最先进的结果,并且也进行了比较。

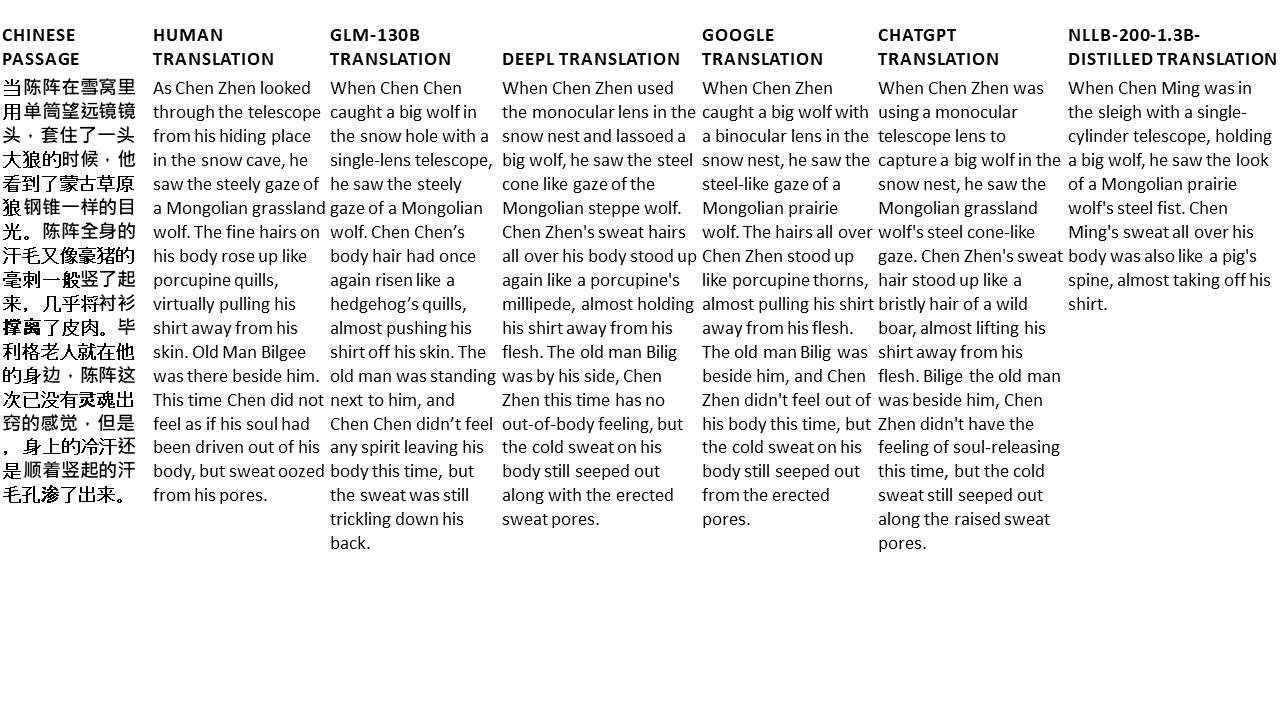

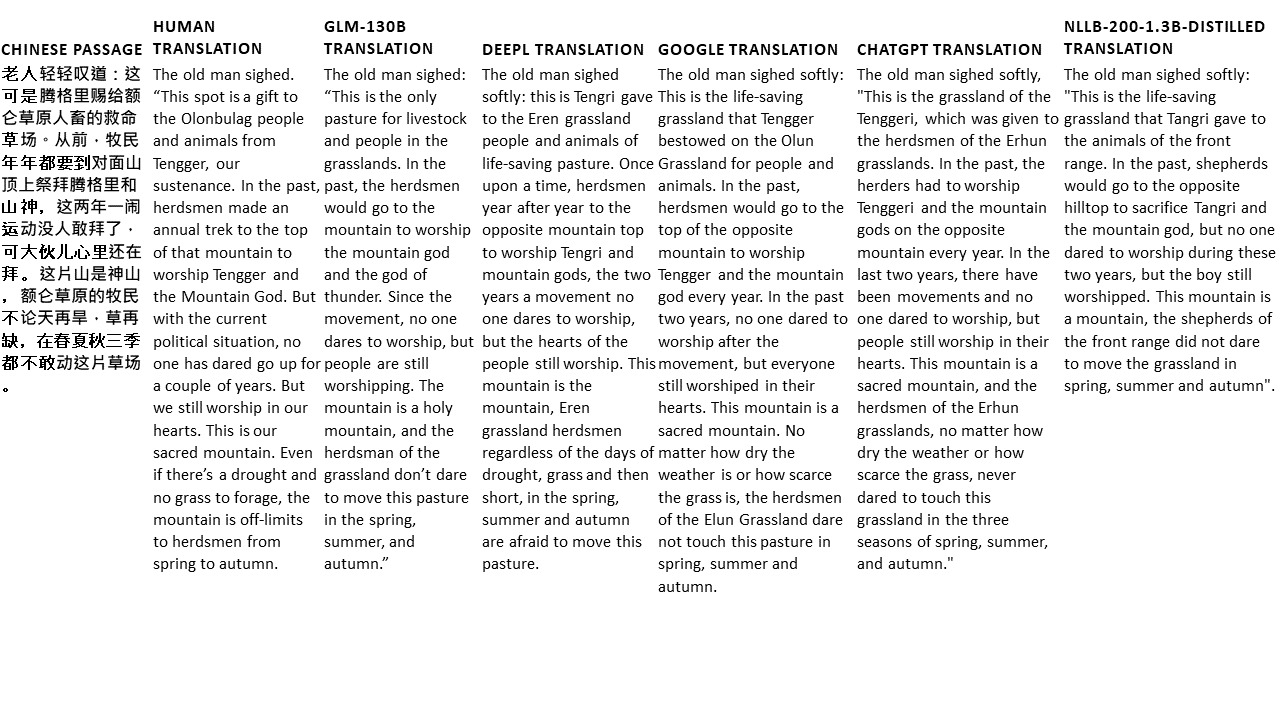

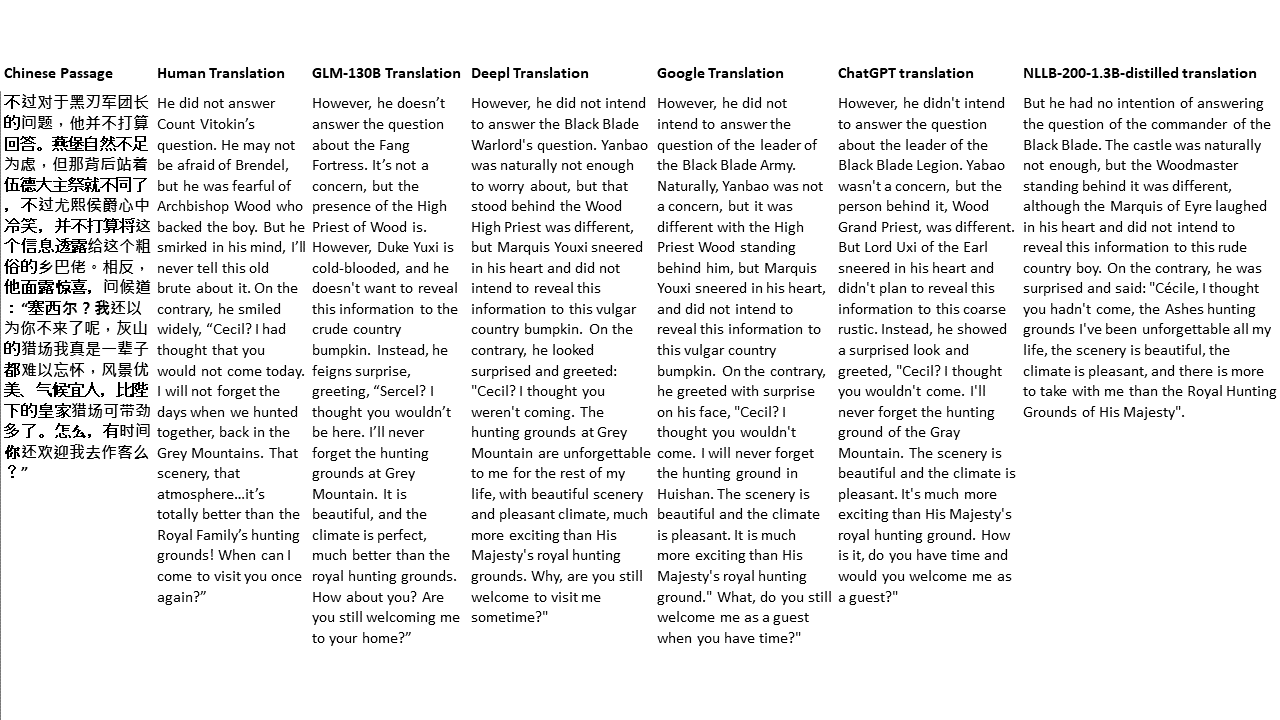

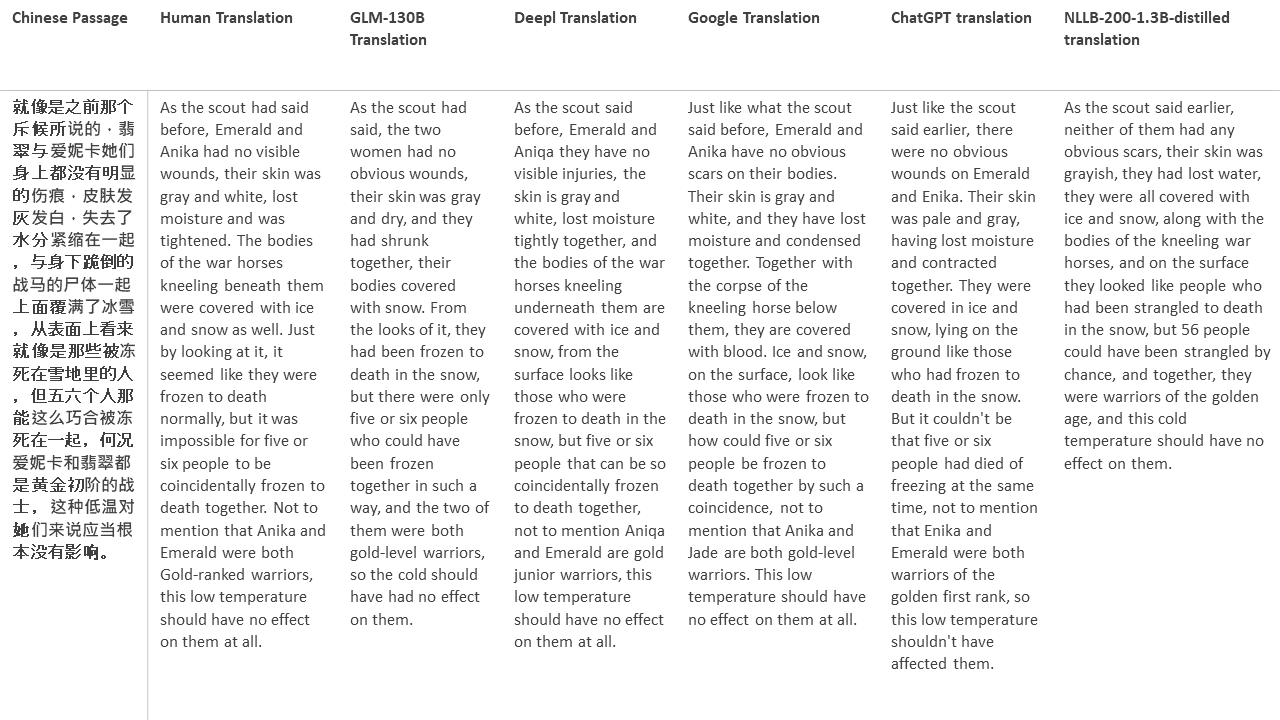

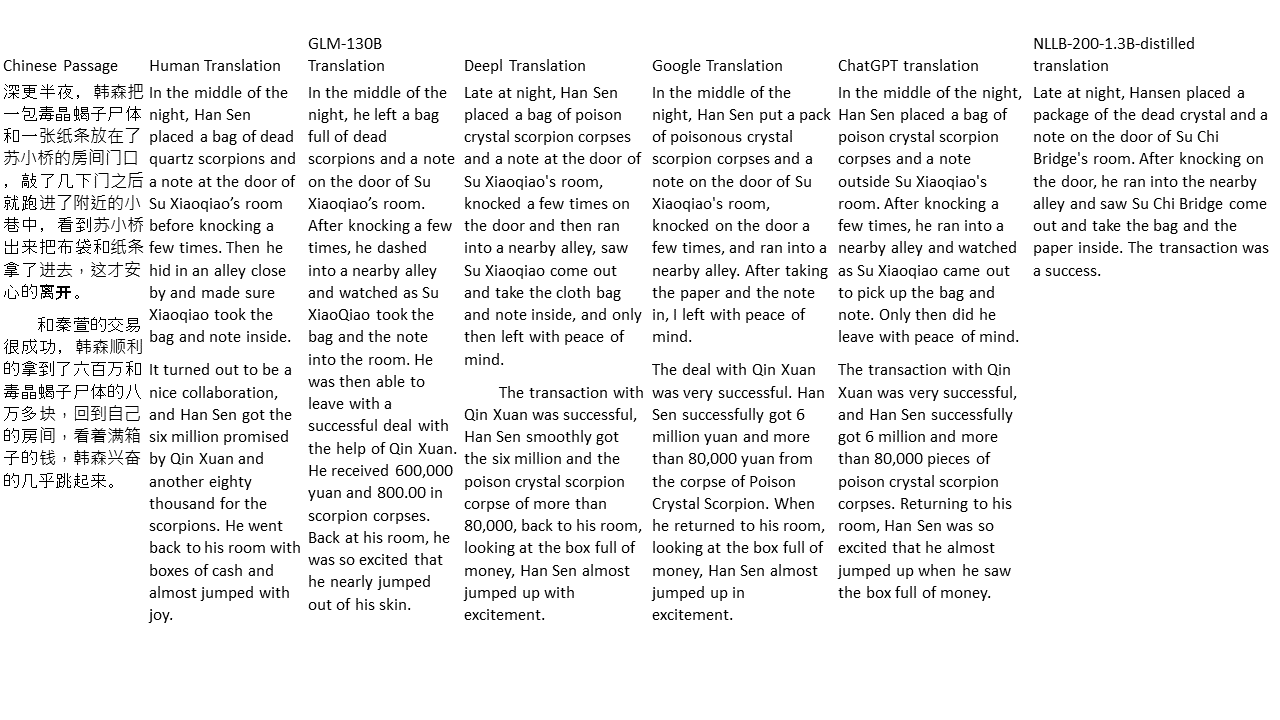

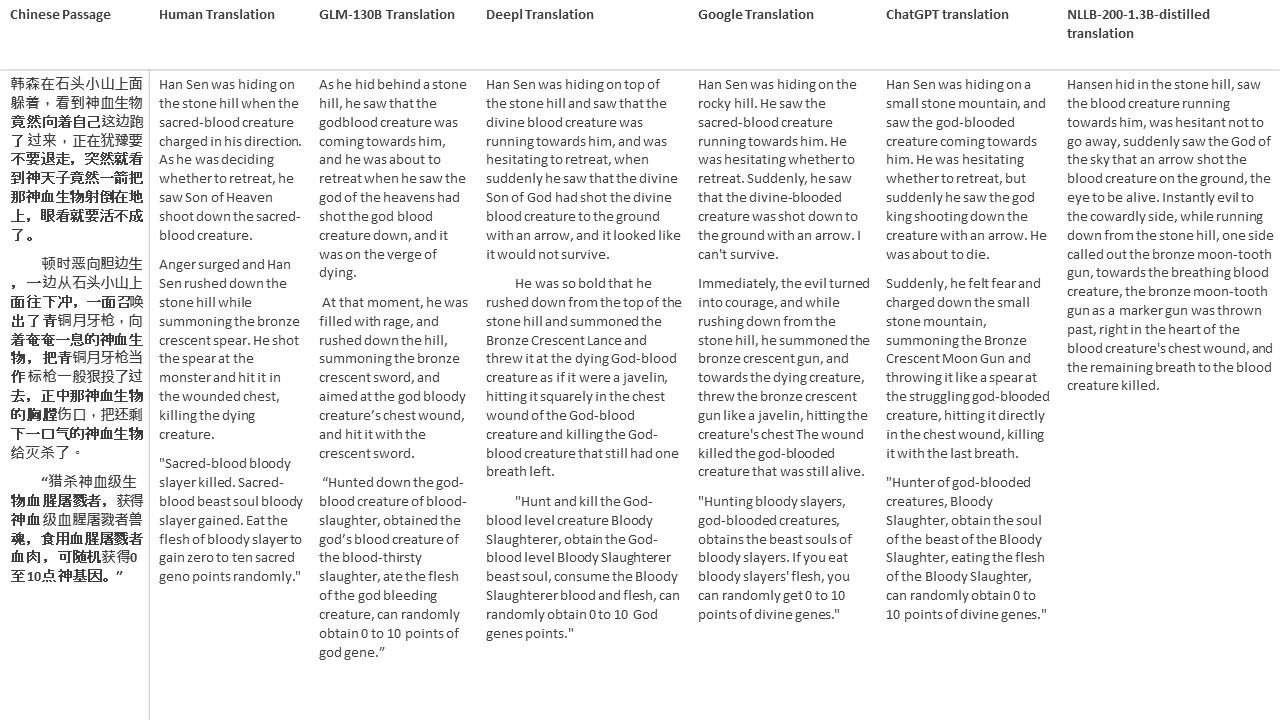

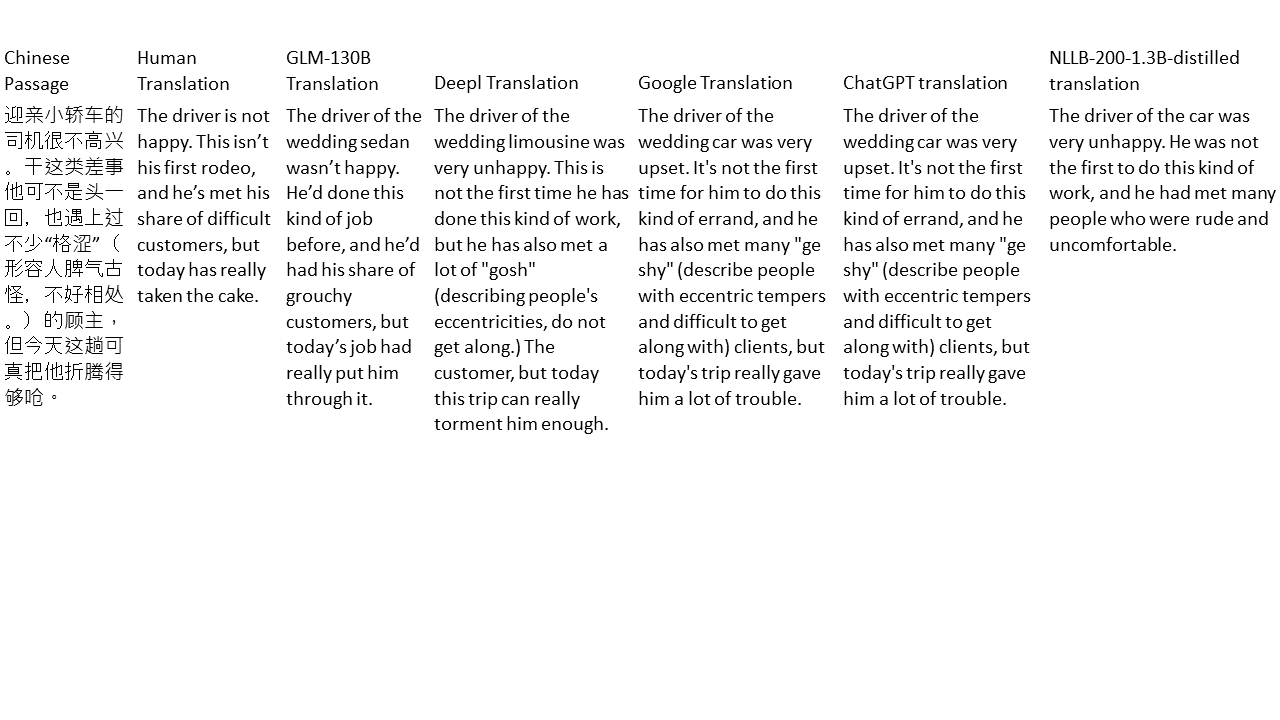

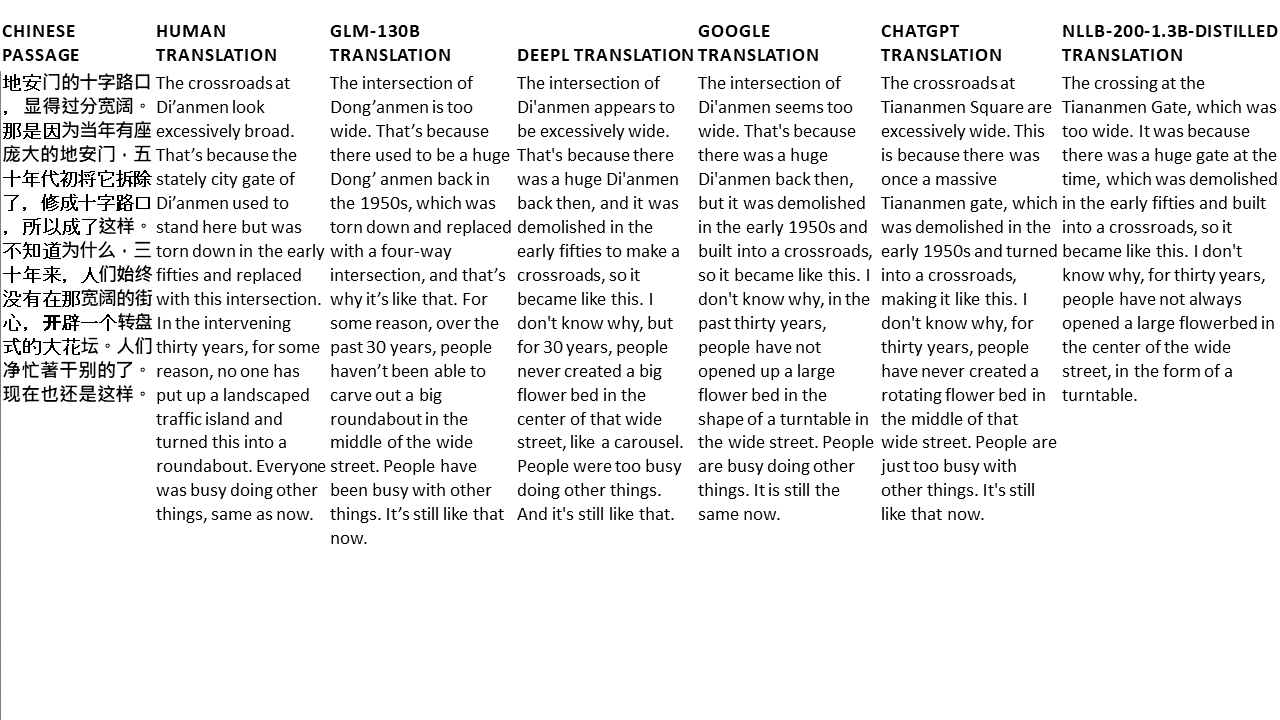

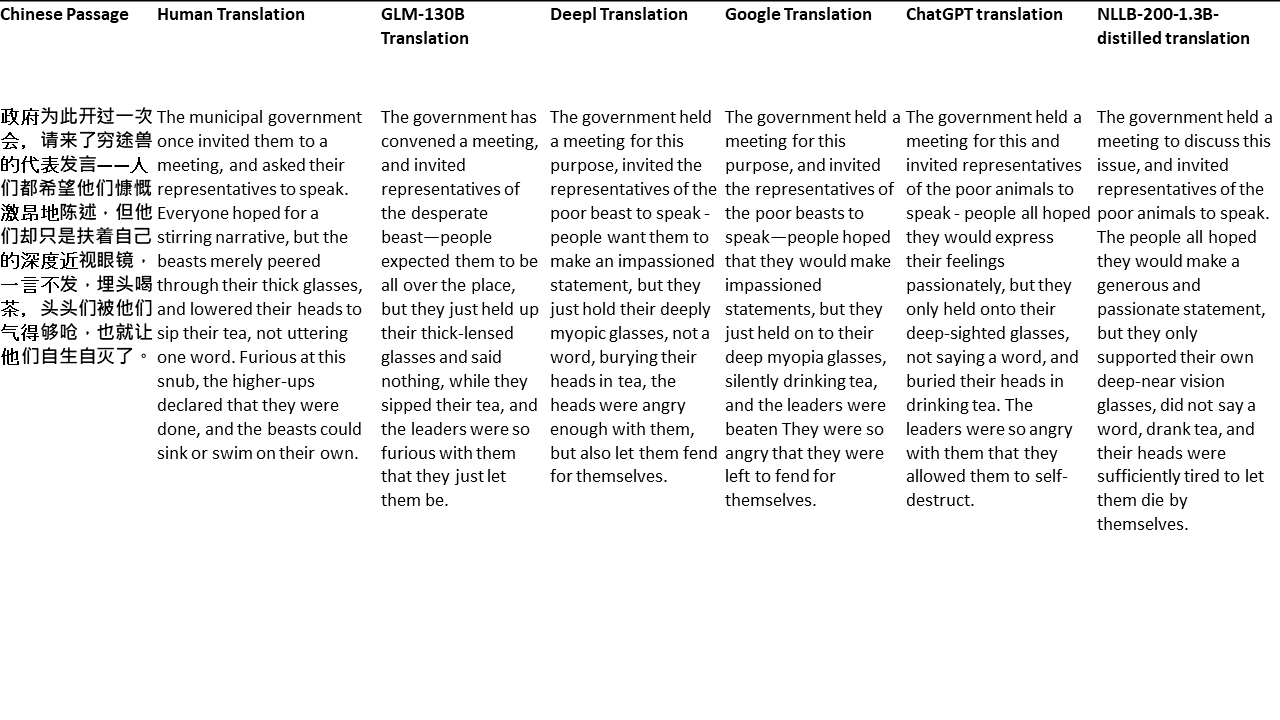

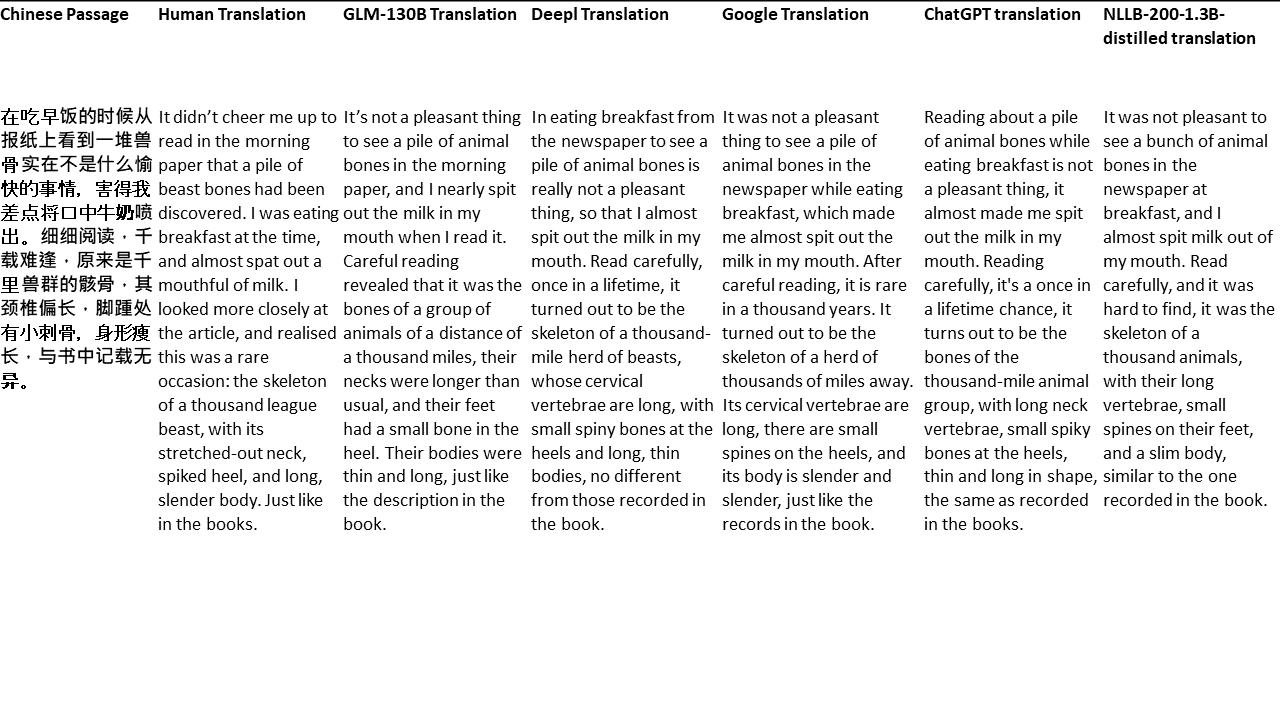

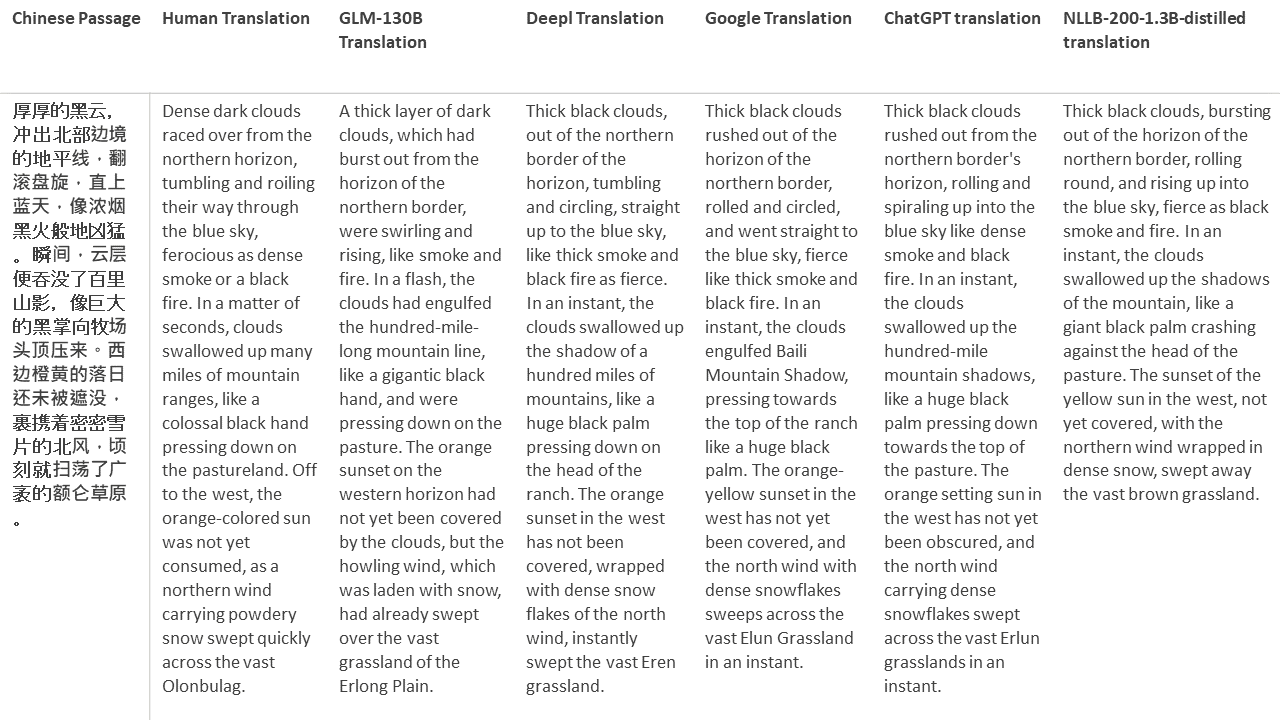

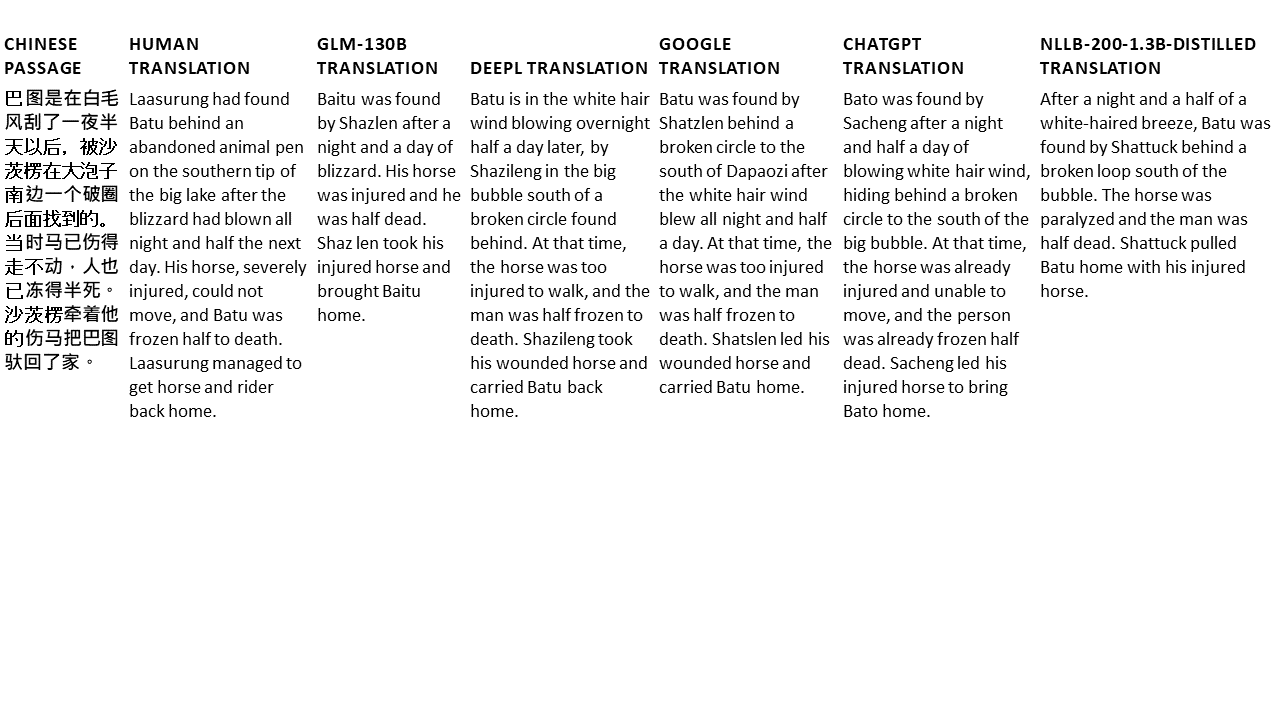

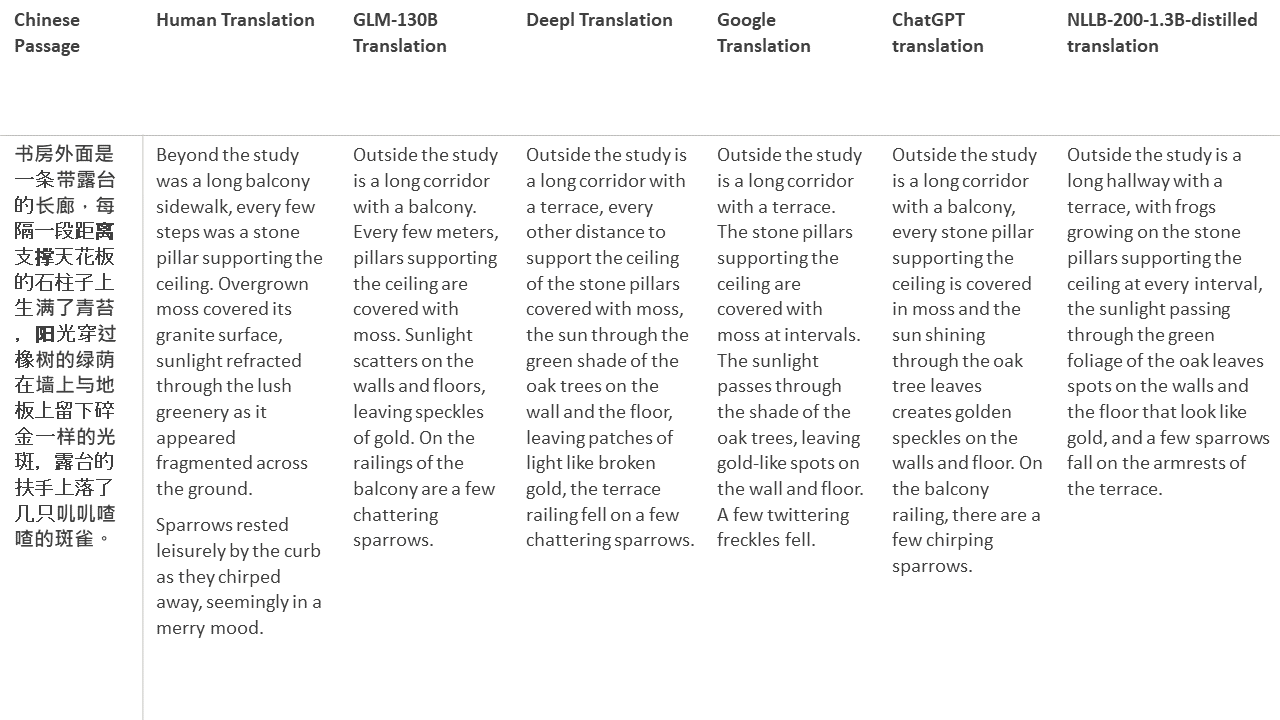

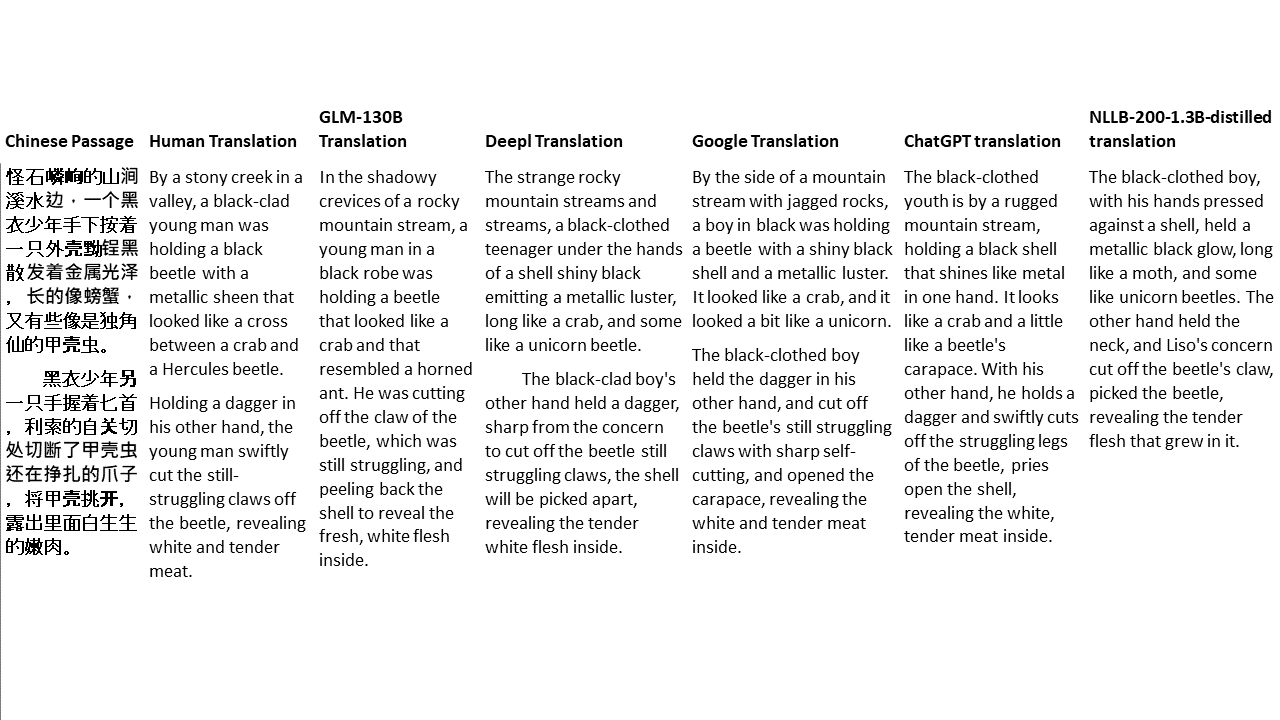

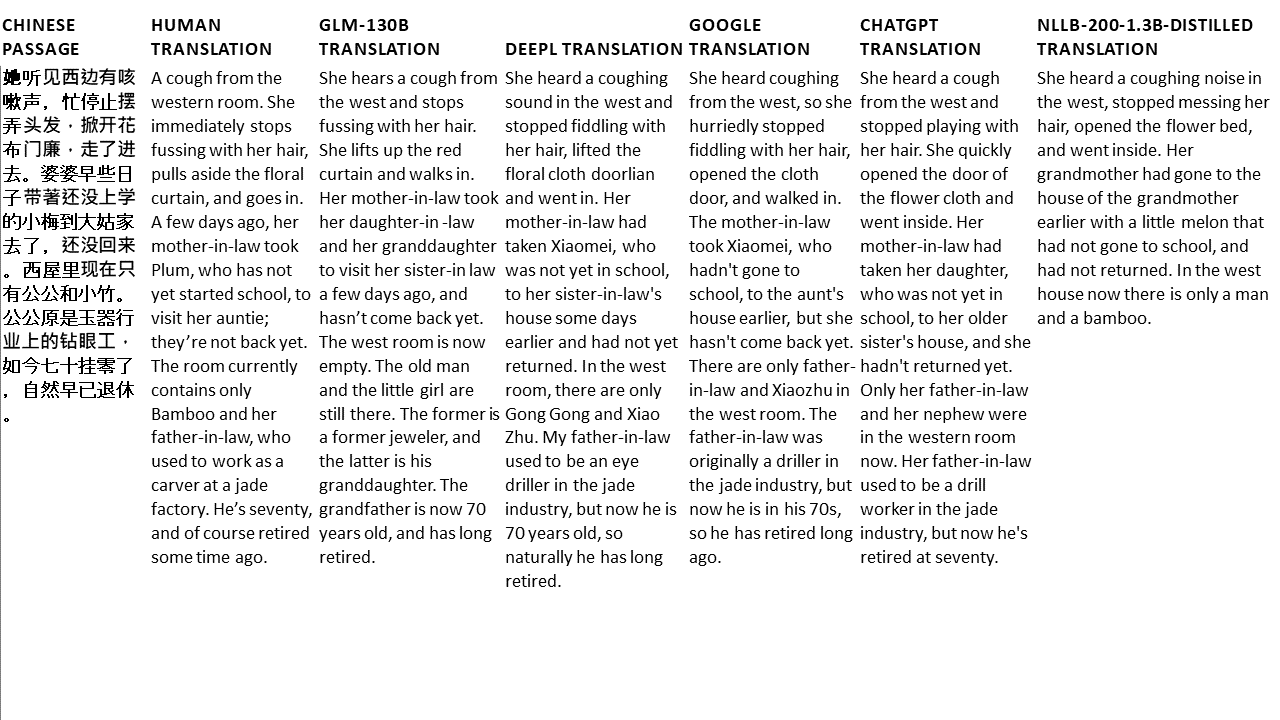

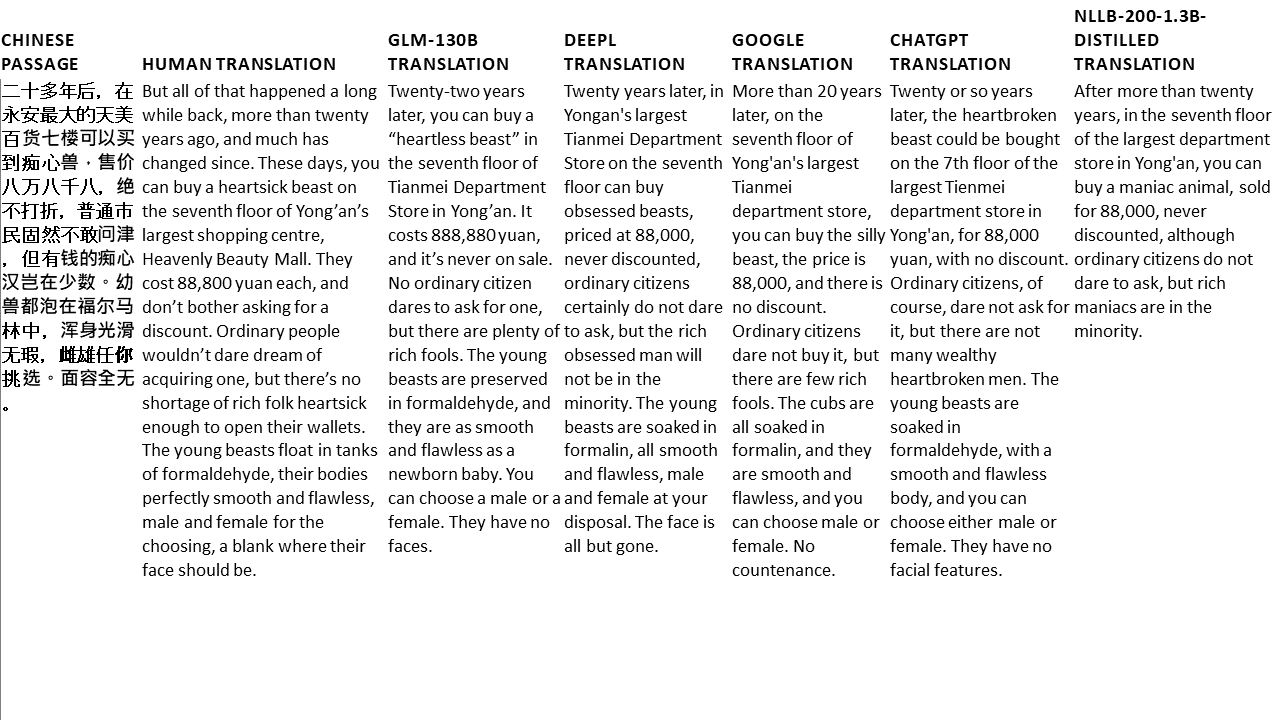

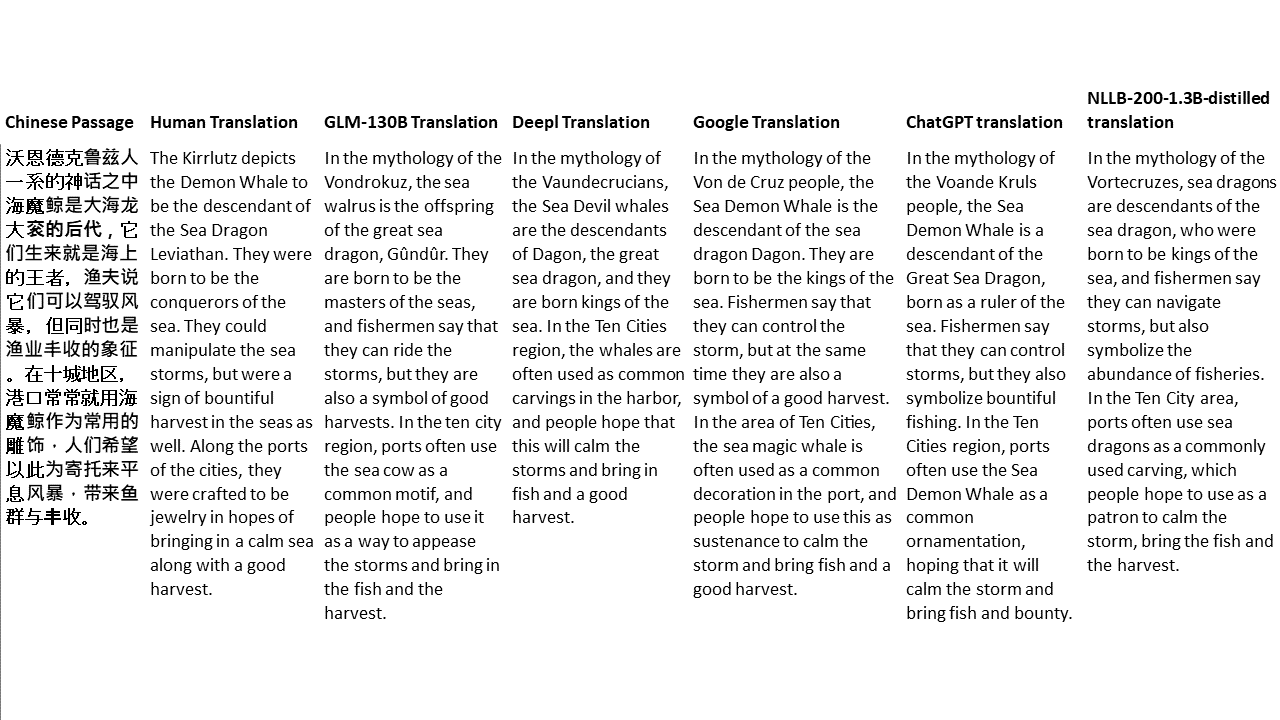

对于我的测试,我选择了文献,这是机器翻译的特别困难领域。 21段落用GLM-130B翻译,并与Deepl,Google Translate,Chatgpt和NLLB-200-1.3B延伸。这些段落是从5个小说中取样的。 Liu Xinwu举行的婚礼,Yan GE的《奇怪的野兽》,Fei Yanfu的《琥珀之剑》,《江图腾》和《超级》。这些段落是随机选择的。他们没有被挑选或再生。