شهدت تقنيات التعلم الآلي التقليدي لمعالجة الترجمة تحسينات كبيرة في السنوات القليلة الماضية. ومع ذلك ، فإنهم ما زالوا يناضلون مع اللغات المألوفة على شجرة عائلة اللغة. على سبيل المثال ، اللغة الإنجليزية والصينية/الكورية/اليابانية.

نظرًا لطبيعة لماذا تكافح هذه النماذج مع هذه المهام (عدم القدرة على استقراء السياق ، والقواعد غير المتطابقة بشكل كبير ، إلخ) ، تساءلت عن كيفية أداء نموذج اللغة الكبير المسبق (LLM) على نطاق كافي مدربة على الشركات متعددة اللغات. هل يمكن أن تقارب LLM ثنائي اللغة الإنسان ثنائي اللغة على مهام الترجمة؟

كانت الخطوة الأولى بالطبع اختيار نموذج للاختبار. هناك عدد قليل جدًا من النماذج ثنائية اللغة أو متعددة اللغات يتم تدريبها على نطاق كافٍ ولديها تمثيل بيانات تدريب متساوٍ أو بالقرب من اللغتين المعنيين. أشكر الفريق في Thudm على التدريب وإصدار GLM-130B ، وهو LLM ثنائي اللغة المدربين على 200 مليار رمز كل من اللغة الإنجليزية والصينية (إجمالي 400B). (https://github.com/thudm/glm-130b).

هذا هو النموذج الرئيسي المستخدم للاختبار. العرض التوضيحي المتاح هنا-https://huggingface.co/spaces/thudm/glm-130b لأن GLM-130B ليس مطلوبًا من الإرشادات أو الإستراتيجية القليلة المطلوبة للترجمات. في الاختبارات الأولية ، لاحظت بعض الارتباطات في تعقيد ونوعية الترجمات مع التعقيد وجودة أمثلة قليلة. نتيجة لذلك ، تتضمن موجه طلقة واحدة مقطعًا قصيرًا وترجمة مماثلة من كتاب صيني مترجم ونشر باللغة الإنجليزية.

مطالبة طلقة واحدة لـ GLM-130B

Chinese: 同北京许许多多同龄的老市民一样,薛大娘现在绝不是一个真正迷信的人,她知道迷信归根结蒂都是瞎掰,遇上听人讲述哪里有个老太太信神信鬼闹出乱子,她还会真诚地拍著大腿笑著说几句嘲讽的话;但她又同许许多多同龄的老市民一样,内心还揣著个求吉利的想法。

English: Like many Beijingers her age, she isn’t really superstitious—when you come right down to it, it’s just a bunch of random nonsense. Stories of old ladies fussing about visits from gods or ghosts have her slapping her thigh and making some cutting remark. Yet, also like many Beijingers her age, she has her own ideas about summoning good luck.

Chinese: Chinese text to translate

English: [gMASK]المعلمات افتراضية باستثناء

تعتبر نماذج GPT الخاصة بـ AI من الذكاء الاصطناعي متعددة اللغات مع التحيز الإنجليزي الشديد (~ 92.6 ٪ من اللغة الإنجليزية بواسطة عدد الكلمات) (https://github.com/openai/gpt-3/blob/master/dataset_statistics/languages_by_word_count.csv). ومع ذلك ، نظرًا لأن الكفاءة بلغة واحدة يبدو أنها تنزف في الكفاءة بلغات أخرى في LLM ذات النطاق الكافي (على القدرات متعددة اللغات لنماذج اللغة الإنجليزية واسعة النطاق للغاية-//arxiv.org/abs/2108.13349) ، أقوم أيضًا بتضمين ترجمات ChatGPT في المقارنة. نظرًا لأن chatgpt محاذاة للتعليمات ، فإن أمر ترجمة بسيط يكفي ويستخدم. تعليمات أو أمثلة محددة لتحديد أولويات الطلاقة والسيولة قد تسفر عن نتائج أفضل.

لم تترك أي لغة وراءها ، حقق NLLB-200 من META النتائج الفنية على معايير الترجمة الآلية ومقارنتها أيضًا.

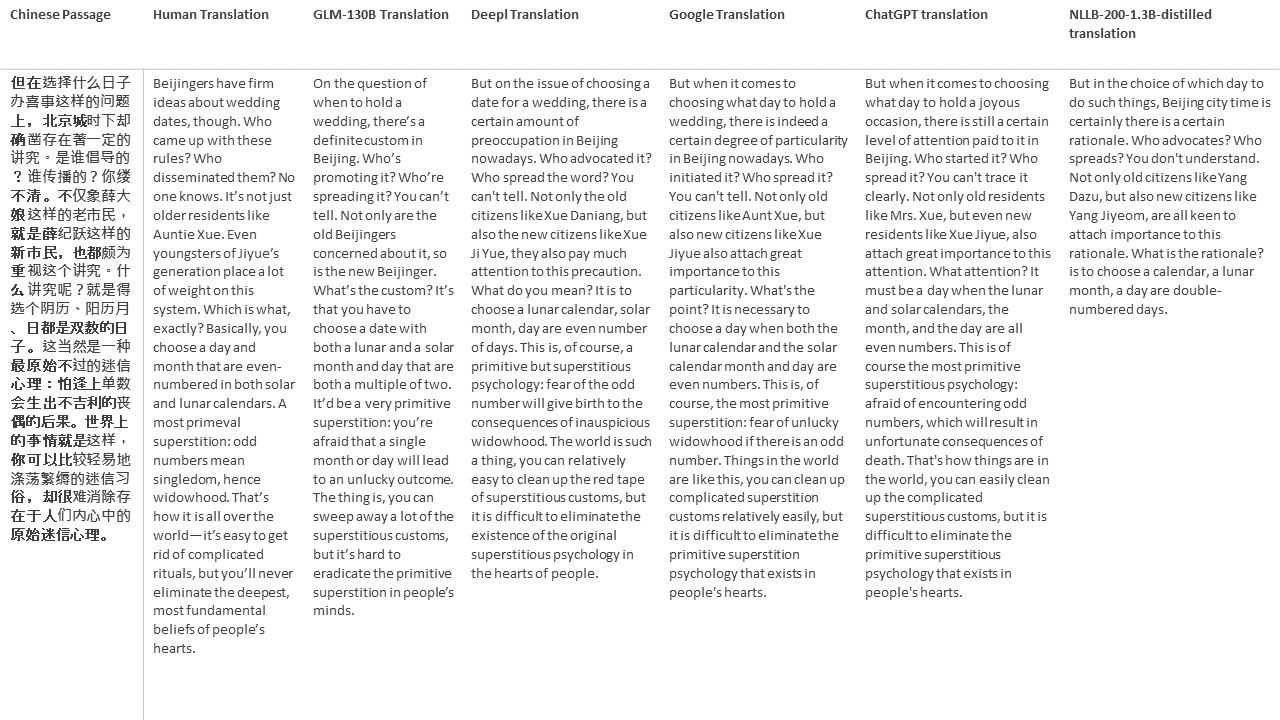

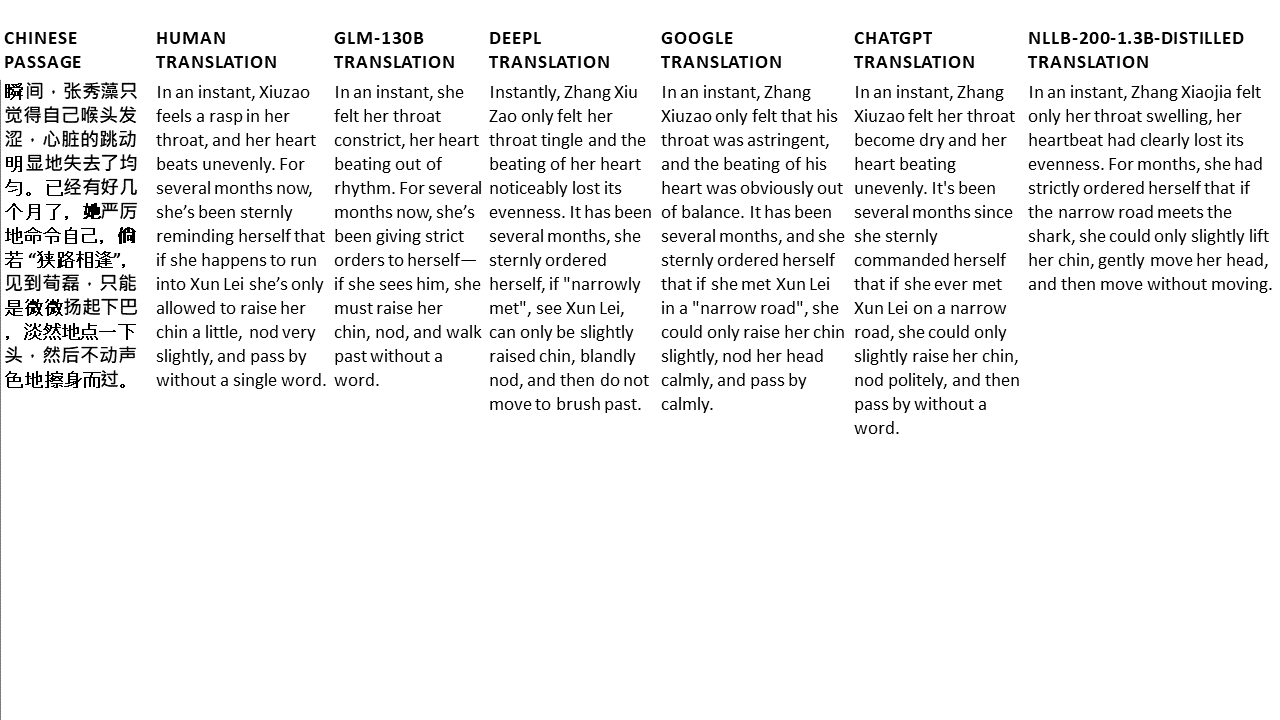

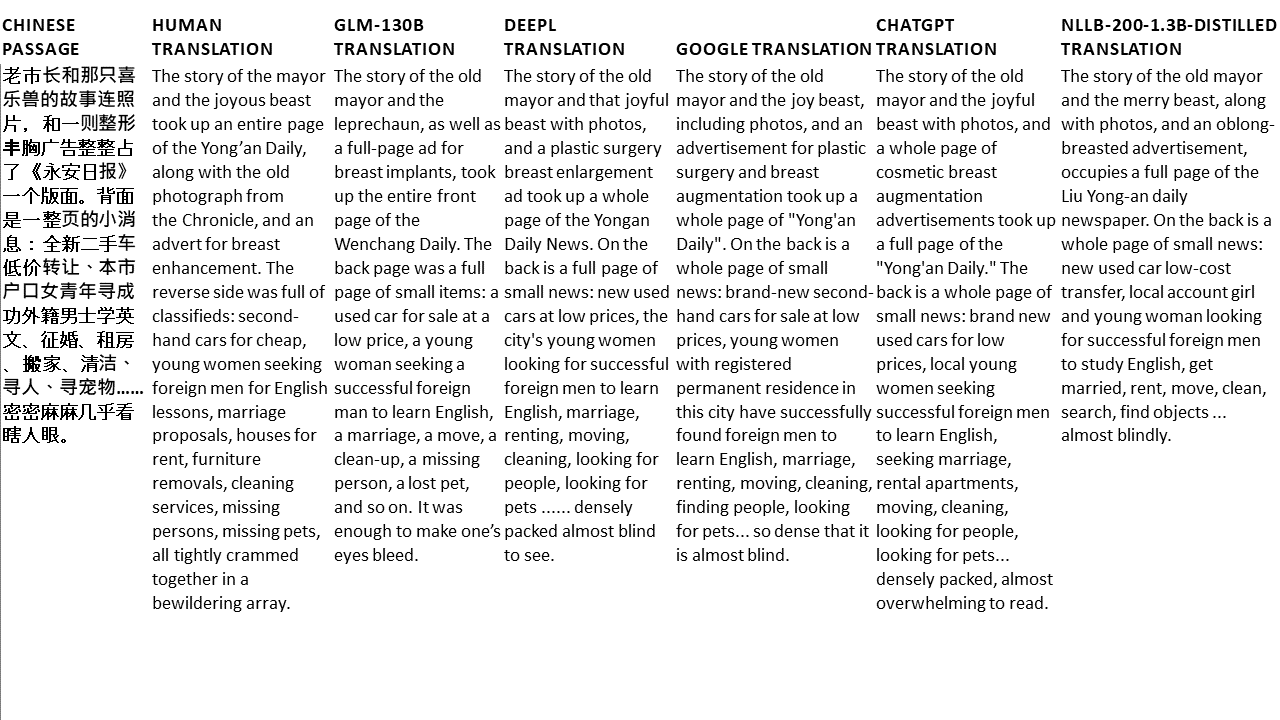

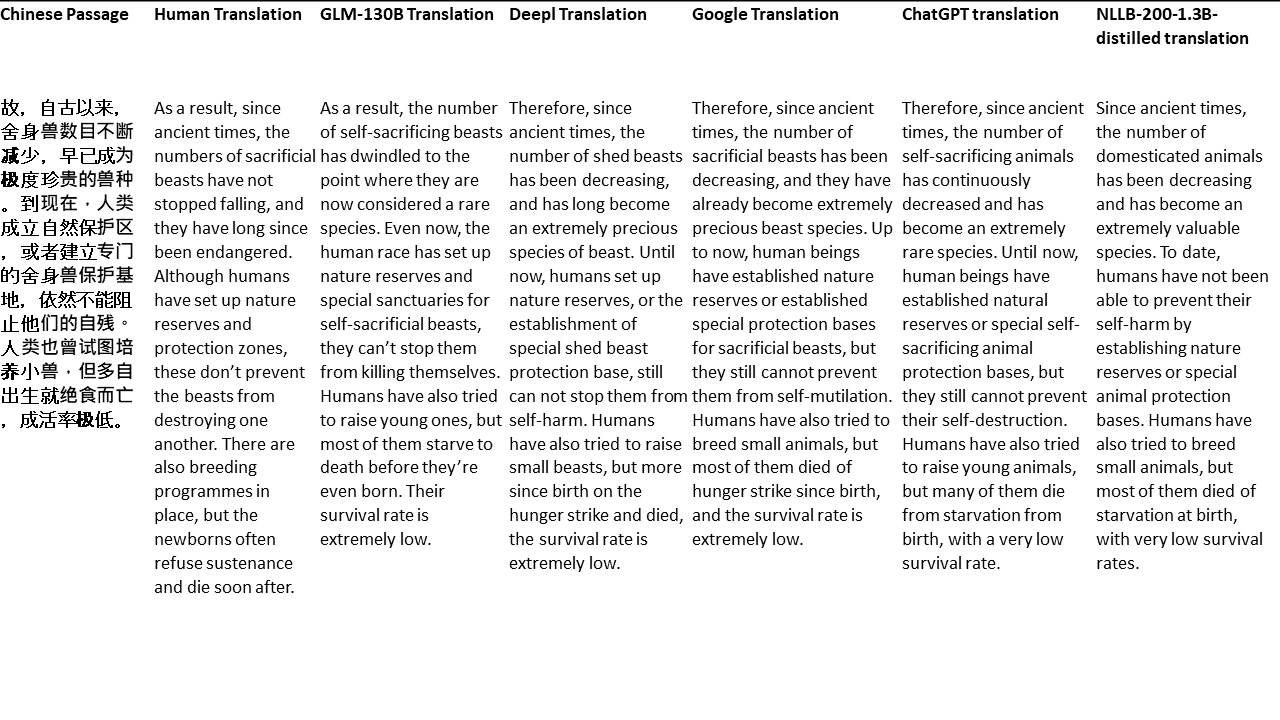

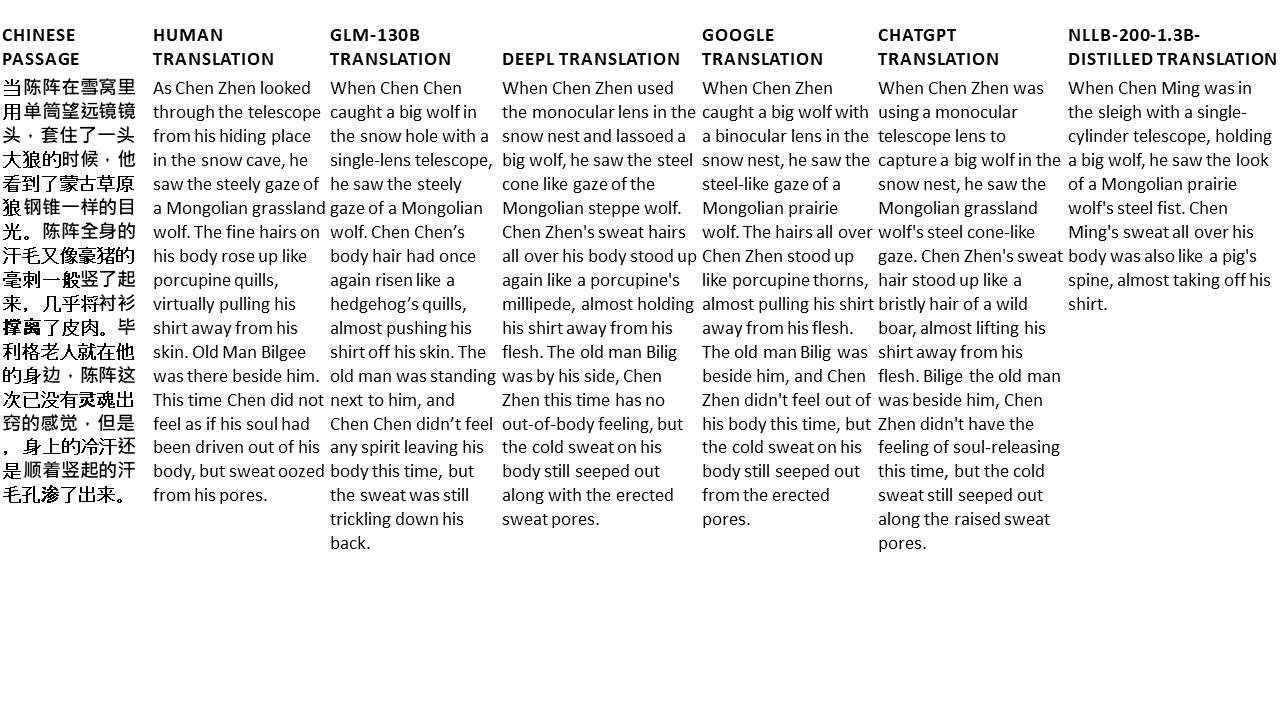

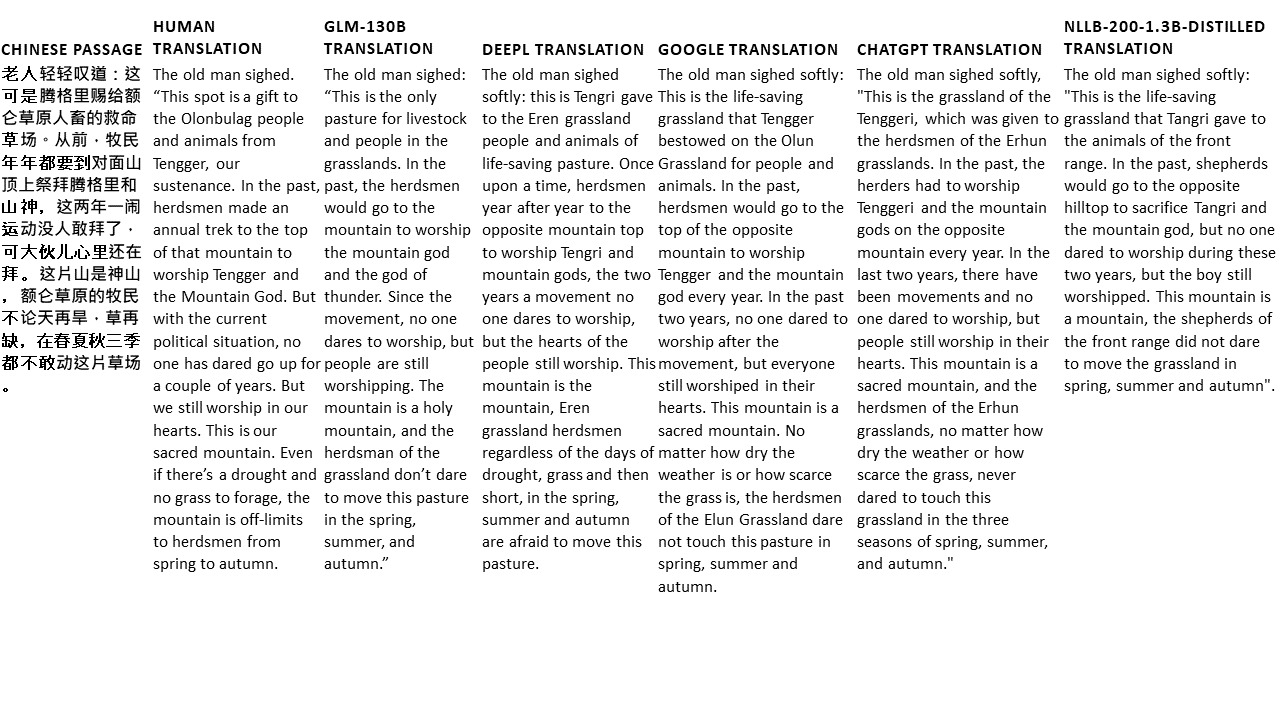

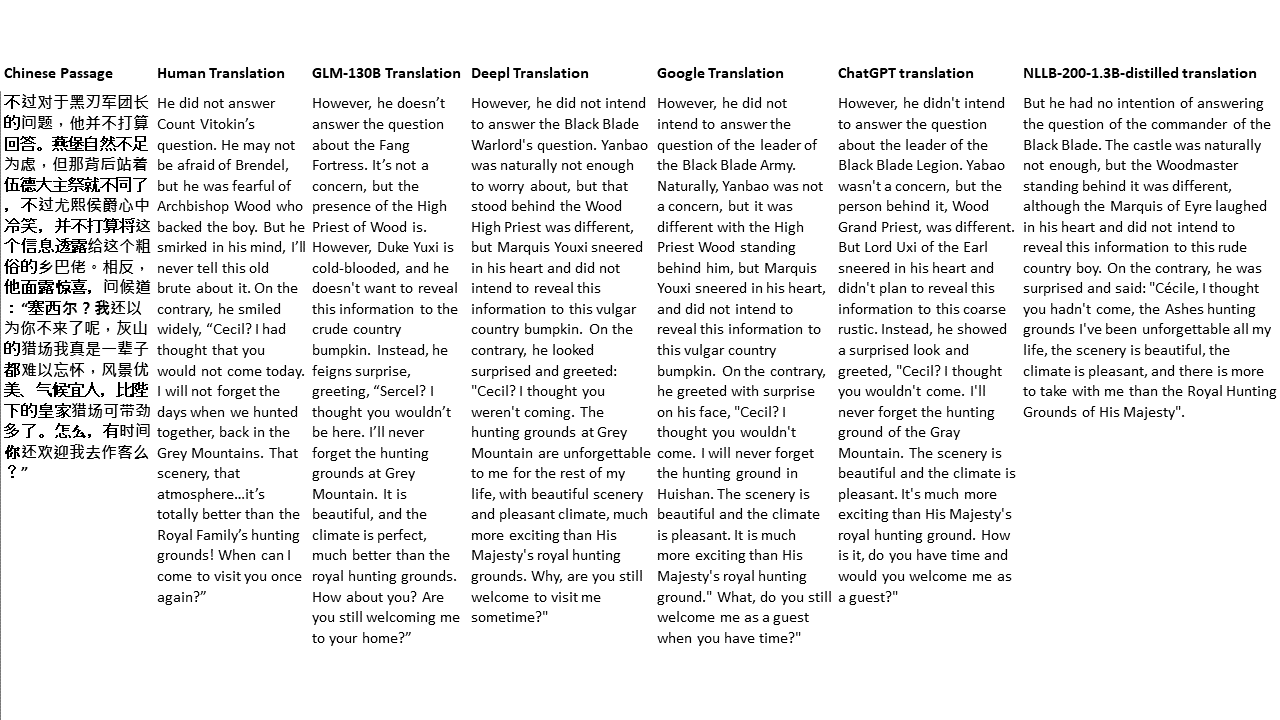

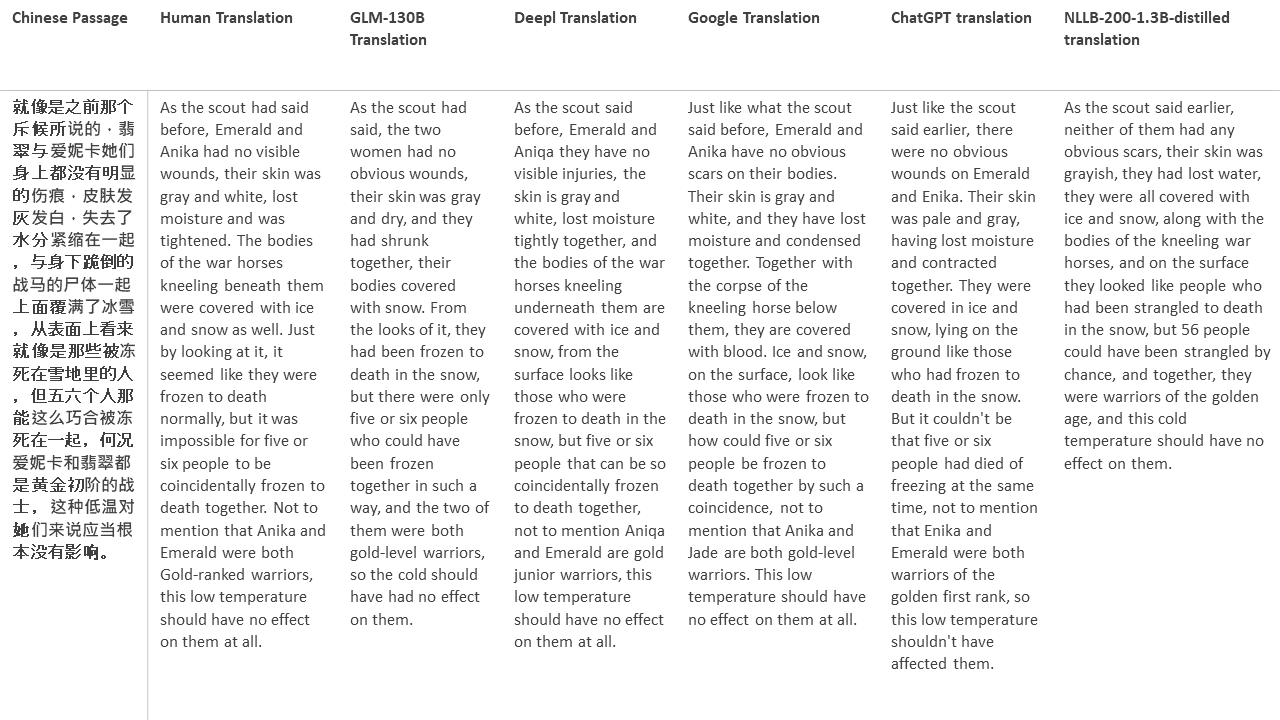

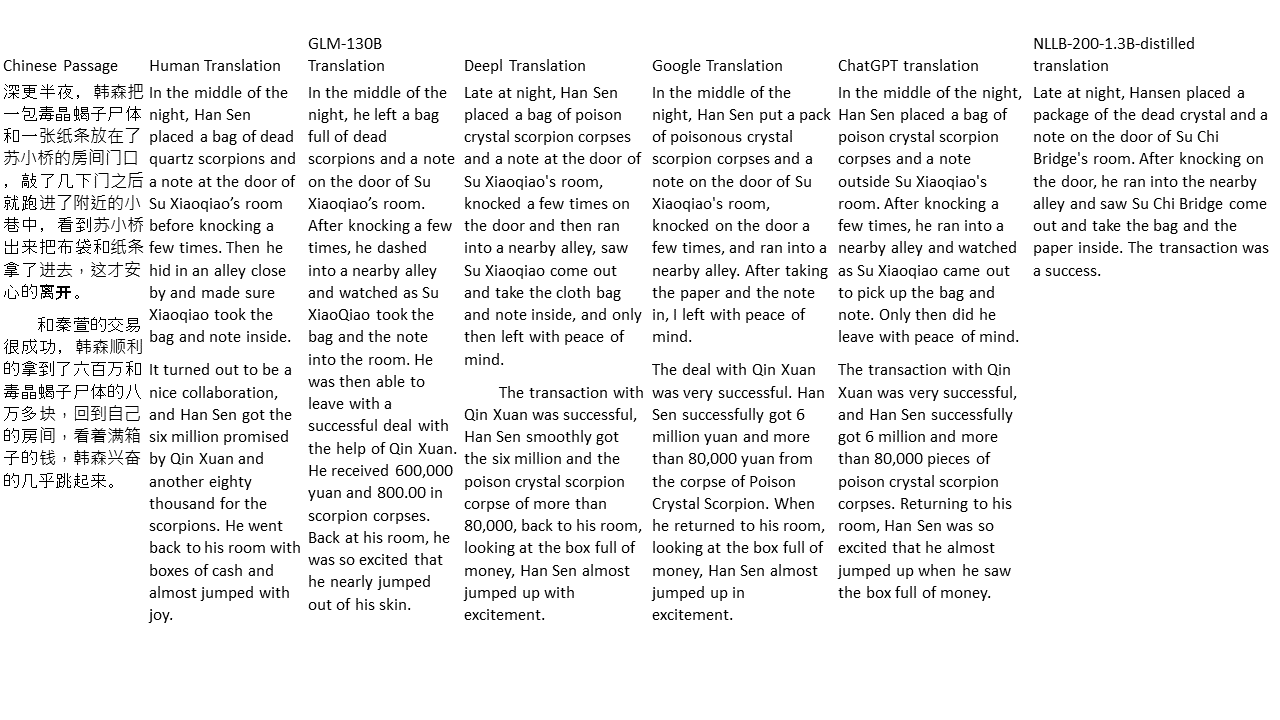

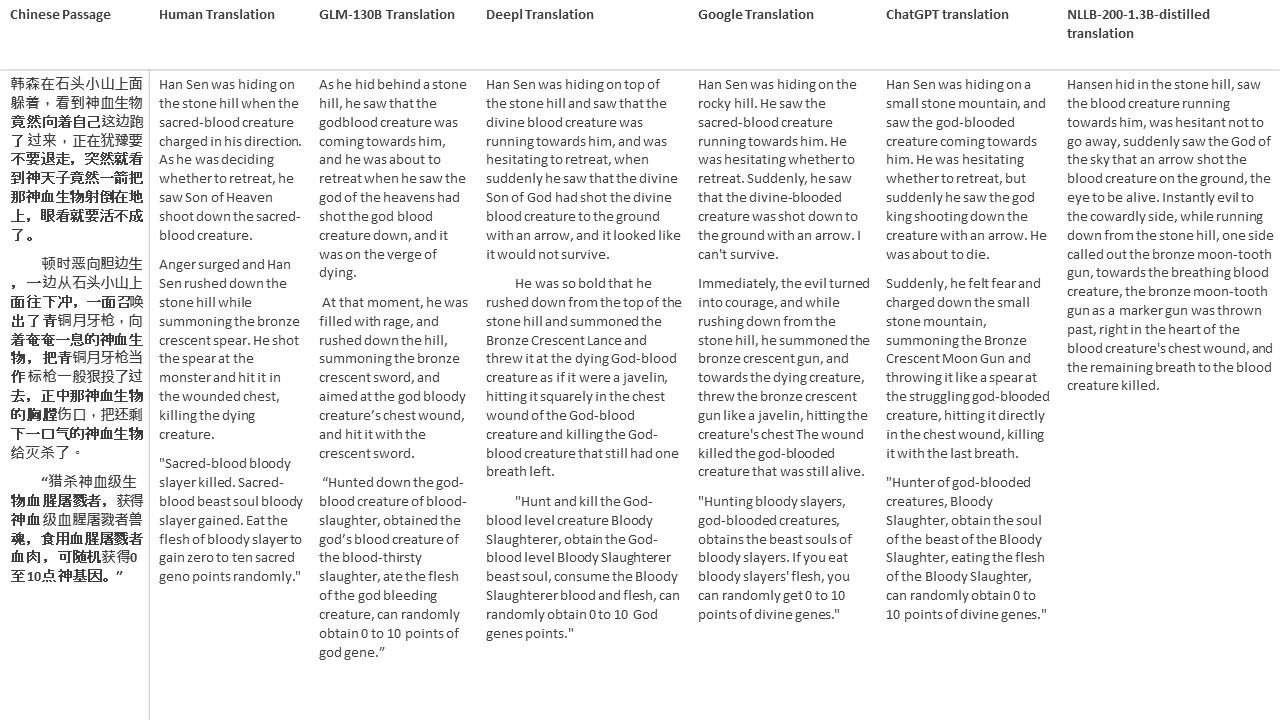

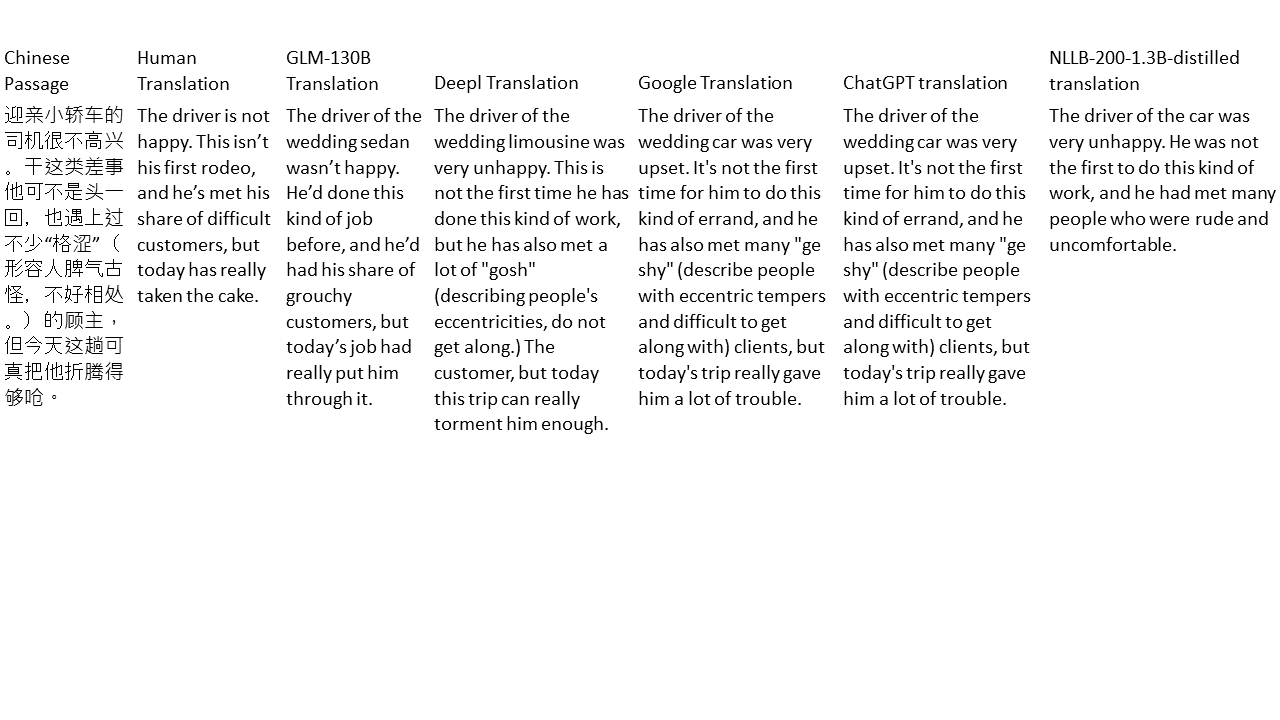

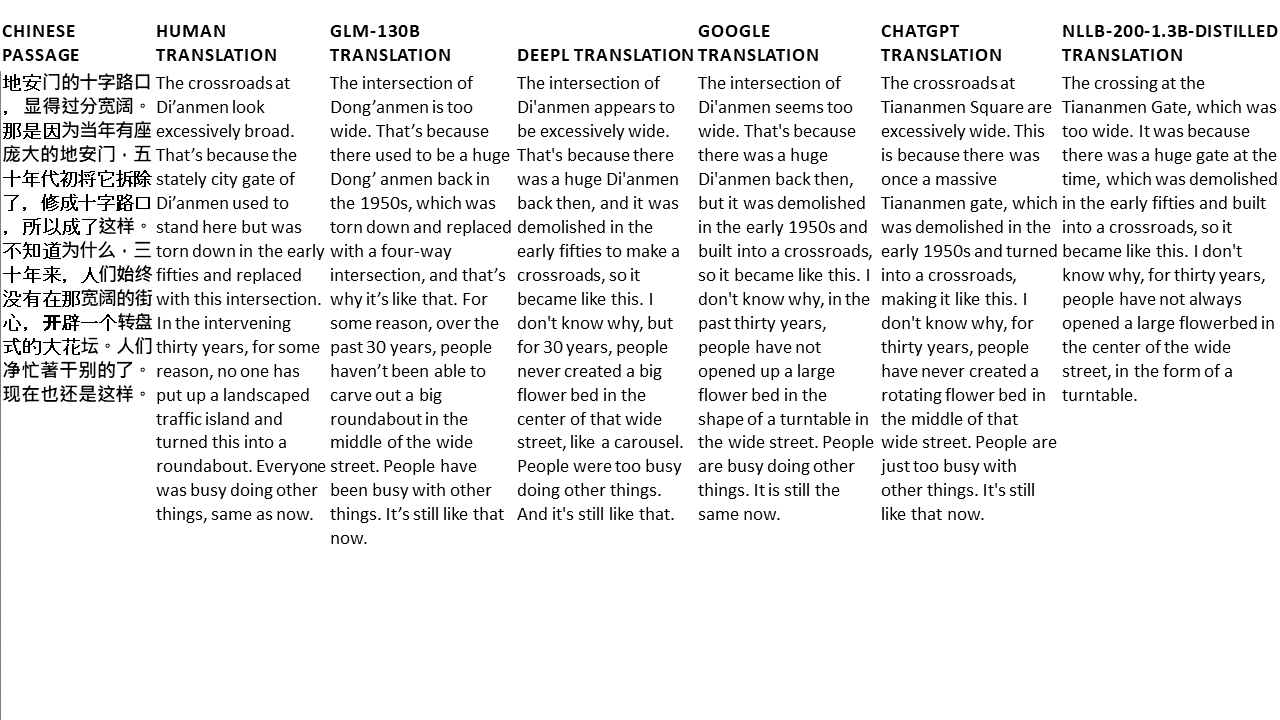

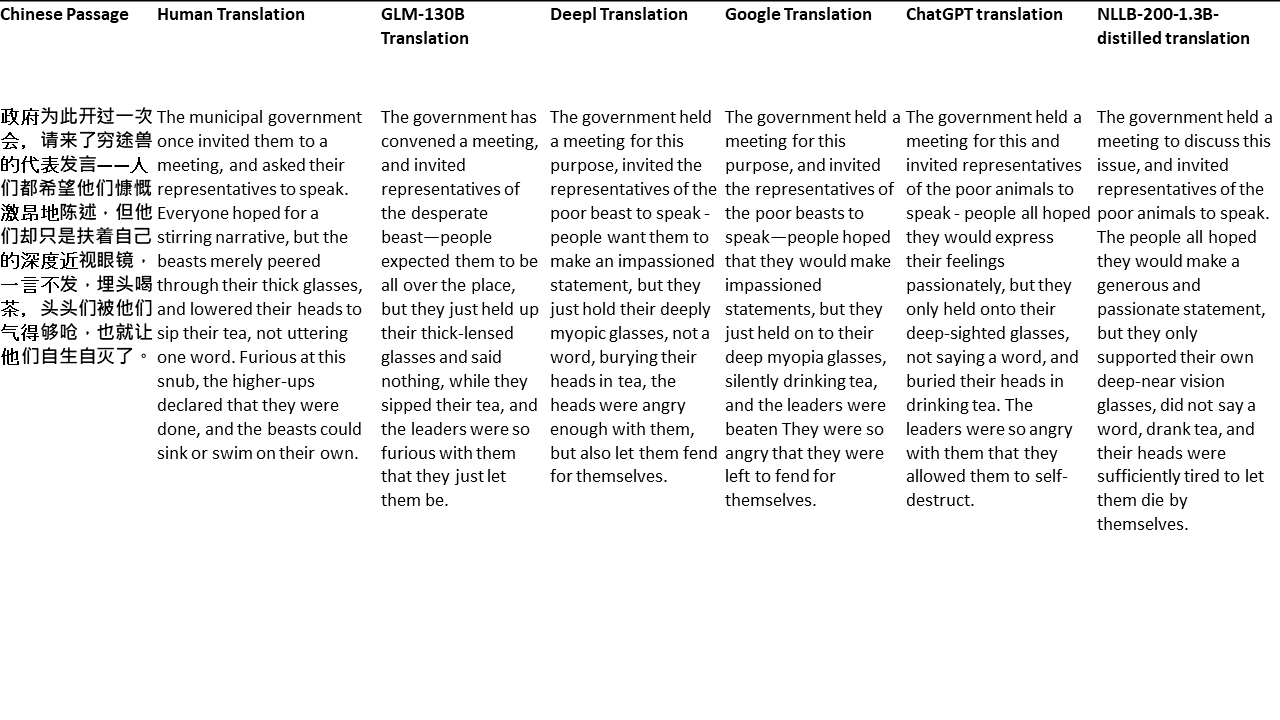

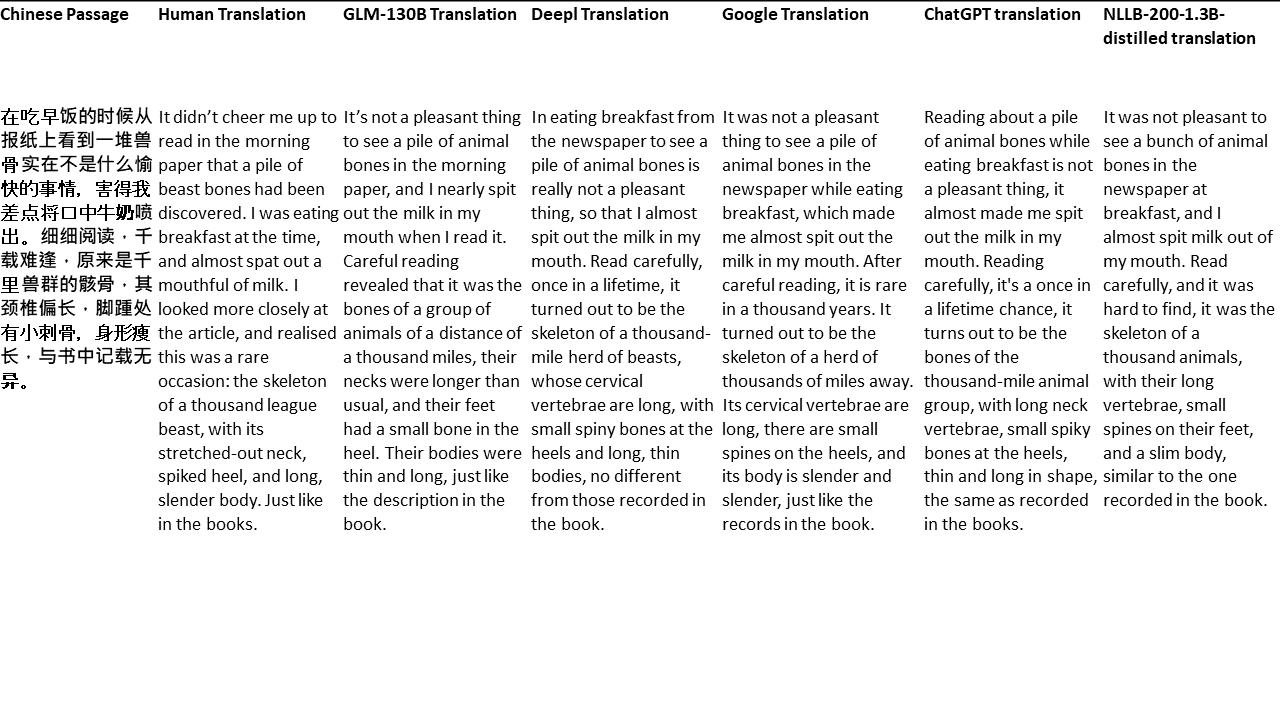

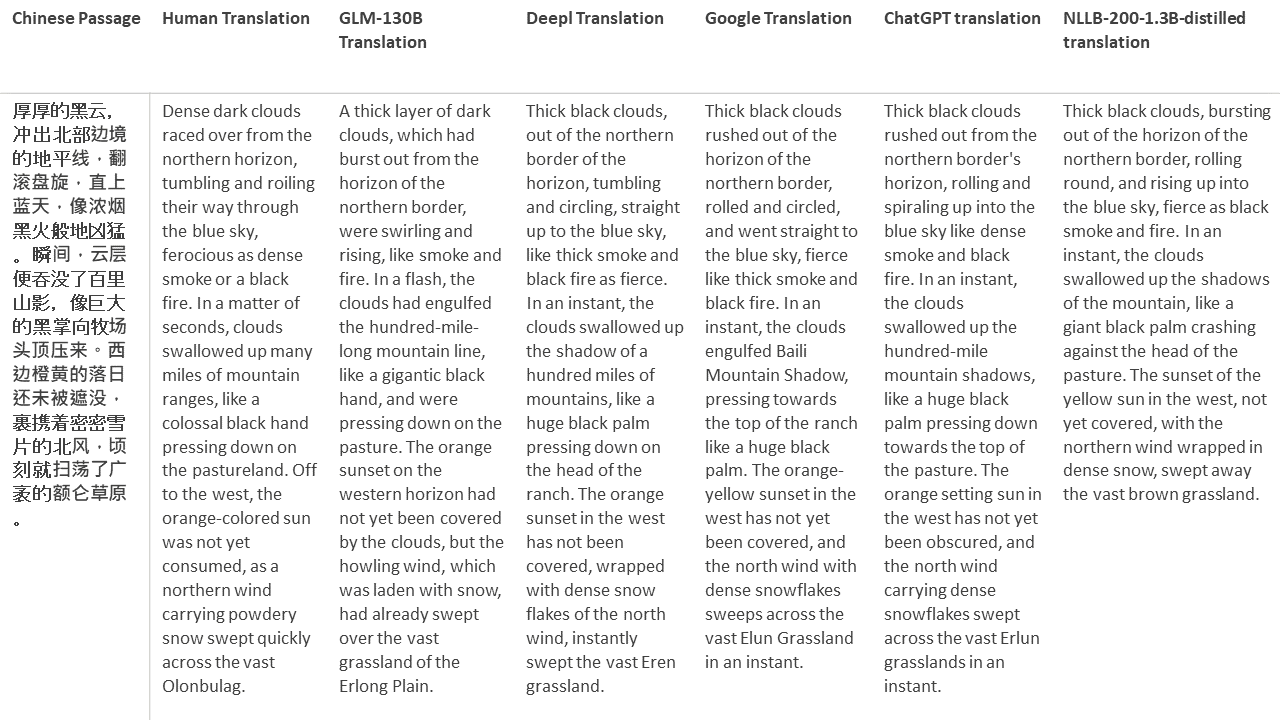

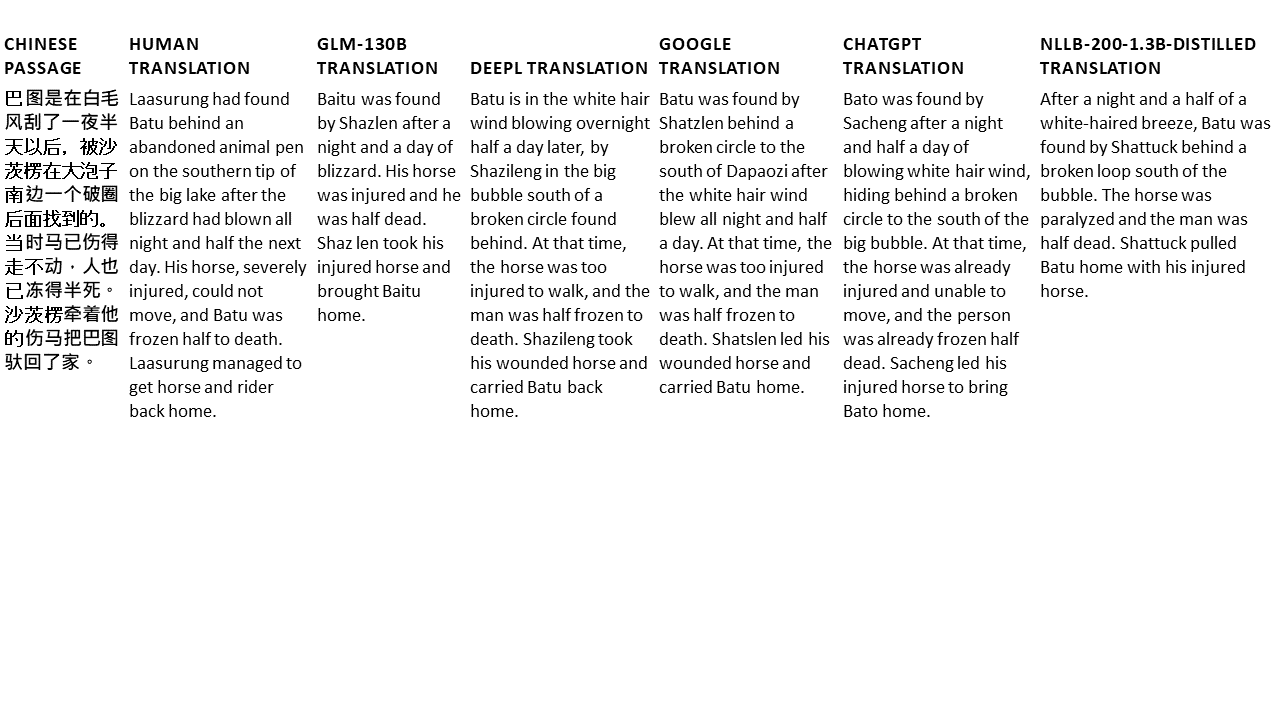

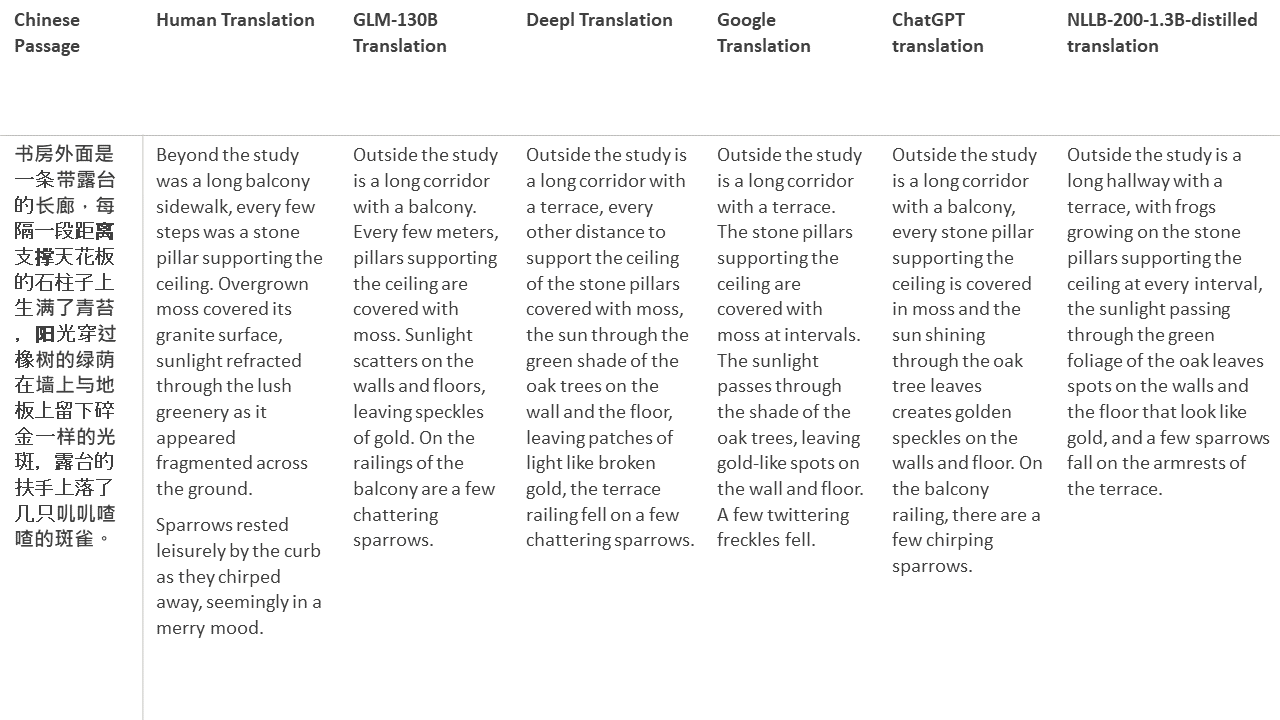

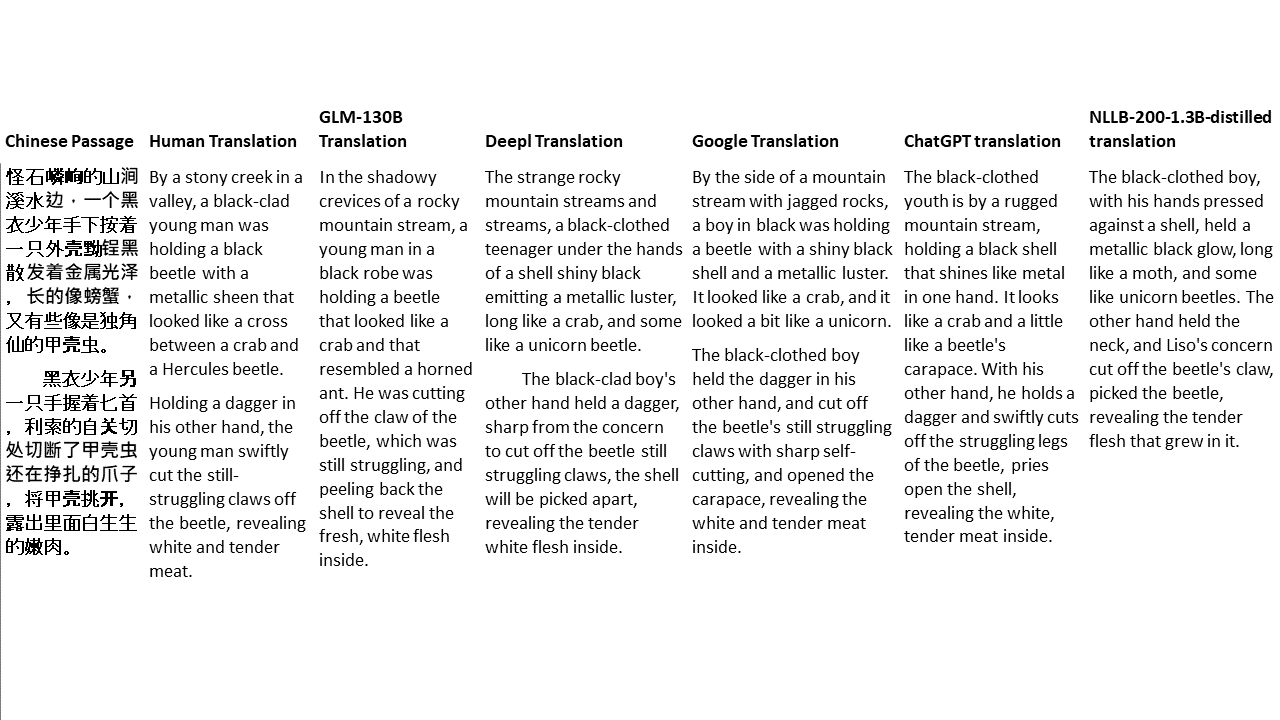

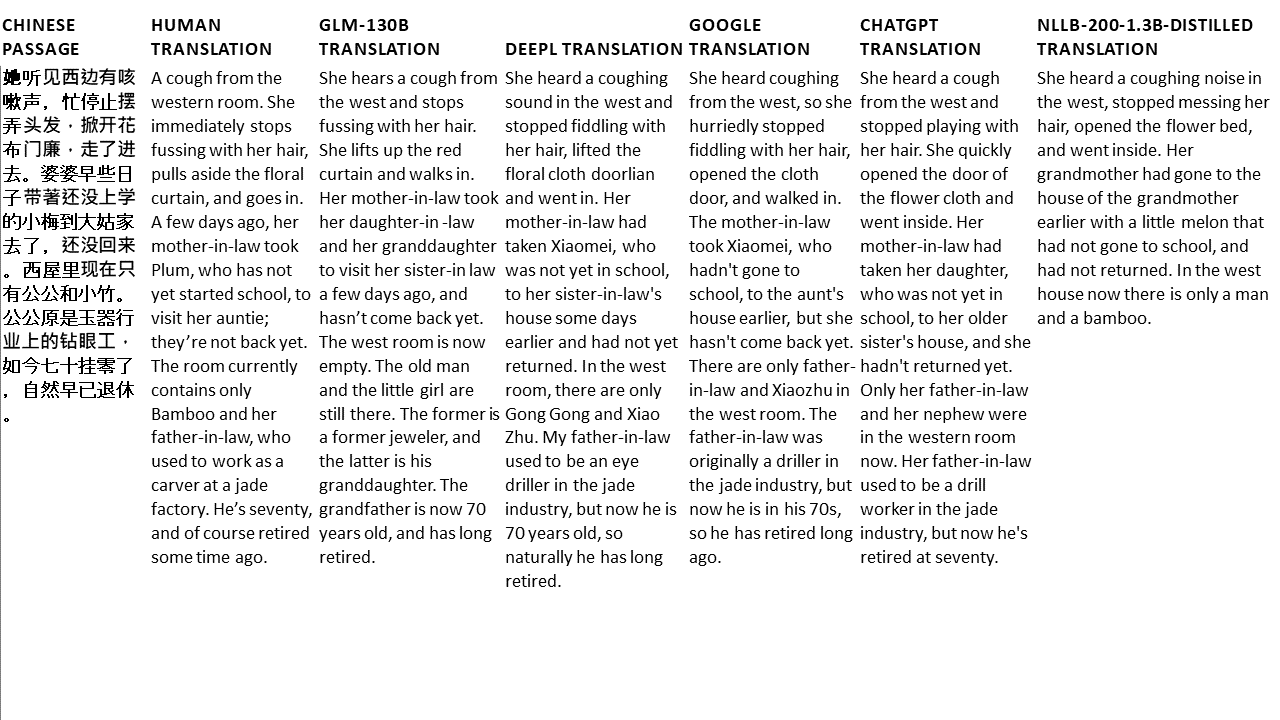

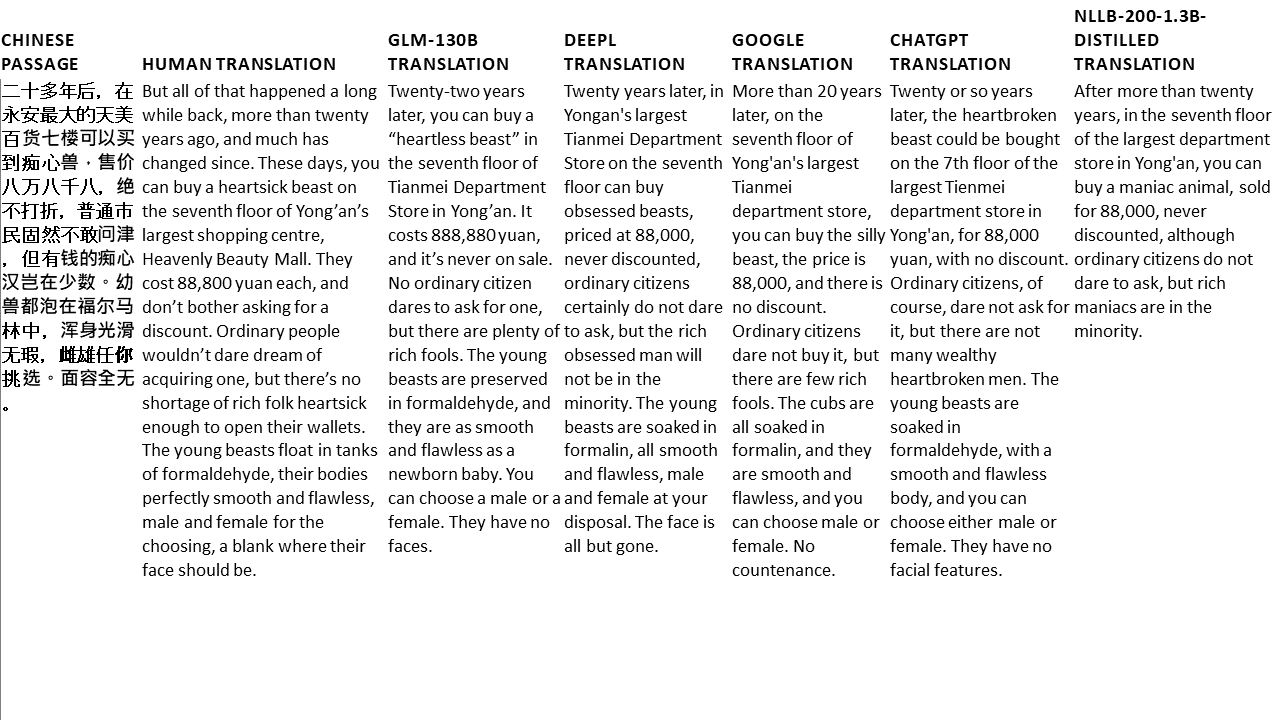

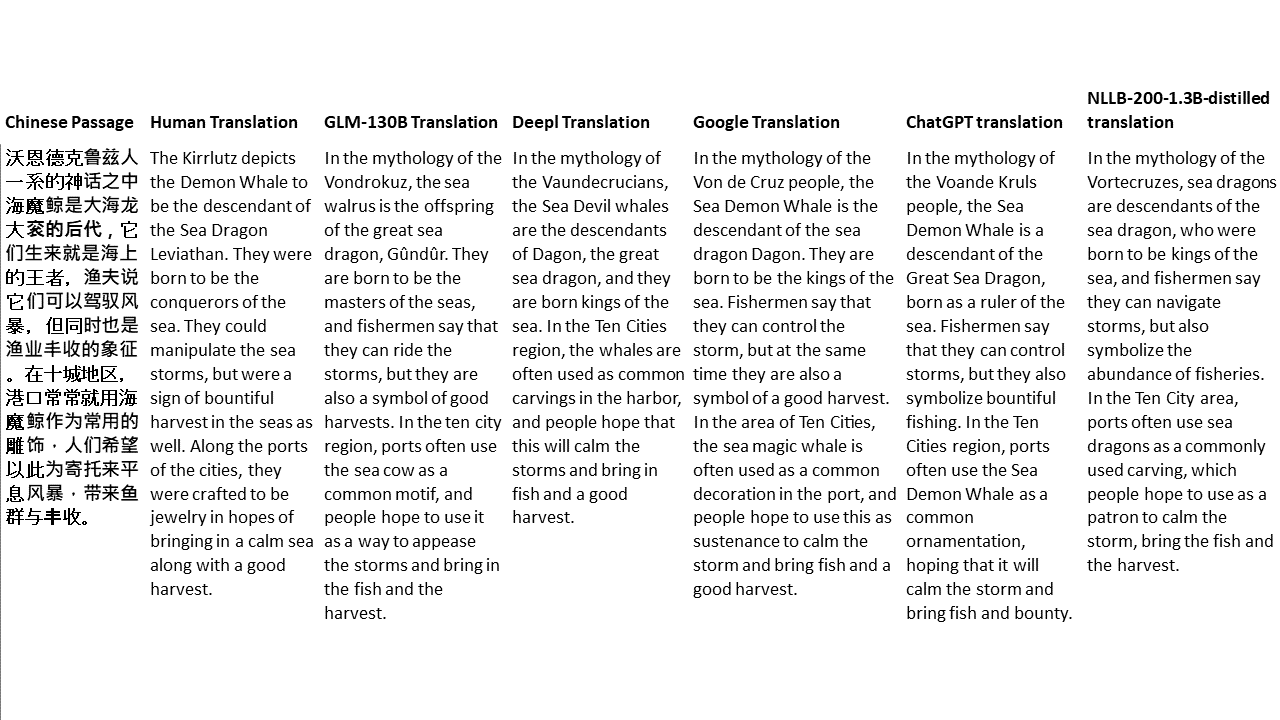

لاختباراتي ، اخترت الأدب ، وهو مجال صعب للغاية للترجمة الآلية. 21 ممرات ترجمت بـ GLM-130B ومقارنتها بـ DEERL و Google Translate و ChatGPT و NLLB-200-1.3B-DERALDED. يتم أخذ عينات من الممرات من 5 روايات. حفل زفاف ليو شينوو ، وحوش غريبة من الصين من قبل يان ج. ، سيف العنبر من قبل فاي يانفو ، وولف الطوطم بقلم جيانغ رونغ وسوبرجن. يتم اختيار المقاطع عشوائيا. إنهم لا يتم اختيارهم أو تجديدهم.