Традиционные методы машинного обучения для борьбы с переводом за последние несколько лет стали большим состоянием искусства. Тем не менее, они все еще борются с языками, которые находятся далеко друг от друга на языковом семейном древе. Например, английский и китайский/корейский/японский.

Из -за природы того, почему эти модели борются с этими задачами (неспособность экстраполировать контекст, дико несоответствующая грамматика и т. Д.) Я задавался вопросом, как будет работать предварительно предварительно предварительно языковая модель (LLM) в достаточной масштабе, обученной многоязычным корпусам. Может ли двуязычный LLM приблизиться к двуязычному человеку по задачам перевода?

Первым шагом, конечно, был выбор модели для тестирования. Существует очень мало двуязычных или многоязычных моделей, которые обучаются в достаточном масштабе и имеют равные или почти равные учебные данные для двух рассматриваемых языков. Я благодарю команду в Thudm за обучение и выпуск GLM-130B, двуязычного LLM, обученного по 200 миллиардов токенов каждый из английского и китайского языка (всего 400B). (https://github.com/thudm/glm-130b).

Это основная модель, используемая для тестирования. Демонстрация доступна здесь-https://huggingface.co/spaces/thudm/glm-130b, потому что GLM-130B не требуется, требуется несколько выстрелов или одного выстрела для переводов. В предварительных тестах я замечаю некоторую корреляцию в сложности и качестве переводов со сложностью и качеством нескольких примеров выстрела. В результате моя подсказка с одним выстрелом включает в себя короткий отрывок и соответствующий перевод из китайской книги, переведенной и опубликованной на английском языке.

Моя единственная подсказка для GLM-130B

Chinese: 同北京许许多多同龄的老市民一样,薛大娘现在绝不是一个真正迷信的人,她知道迷信归根结蒂都是瞎掰,遇上听人讲述哪里有个老太太信神信鬼闹出乱子,她还会真诚地拍著大腿笑著说几句嘲讽的话;但她又同许许多多同龄的老市民一样,内心还揣著个求吉利的想法。

English: Like many Beijingers her age, she isn’t really superstitious—when you come right down to it, it’s just a bunch of random nonsense. Stories of old ladies fussing about visits from gods or ghosts have her slapping her thigh and making some cutting remark. Yet, also like many Beijingers her age, she has her own ideas about summoning good luck.

Chinese: Chinese text to translate

English: [gMASK]Параметры по умолчанию, кроме как

Открыть модели GPT от AI многоязычные с экстремальным английским предвзятостью (~ 92,6% английского языка по слову) (https://github.com/openai/gpt-3/blob/master/dataset_statistics/languages_by_word_count.csv). Однако, поскольку компетентность на одном языке, по-видимому, истекает в компетентность на других языках в LLM достаточного масштаба (о многоязычных возможностях очень крупномасштабных моделей английского языка https: //arxiv.org/abs/2108.13349), я также включаю переводы в Chatgpt в сравнении. Поскольку CHATGPT выравнивается инструкциями, достаточно простой команды Translate достаточно и используется. Конкретные инструкции или примеры для определения приоритетов беглости и текучести могут дать лучшие результаты.

Никаких языков не осталось, NLLB-200 из Meta, достигнутого состоянием результатов искусства по контрольным показателям по машинному переводу, а также сравнивается.

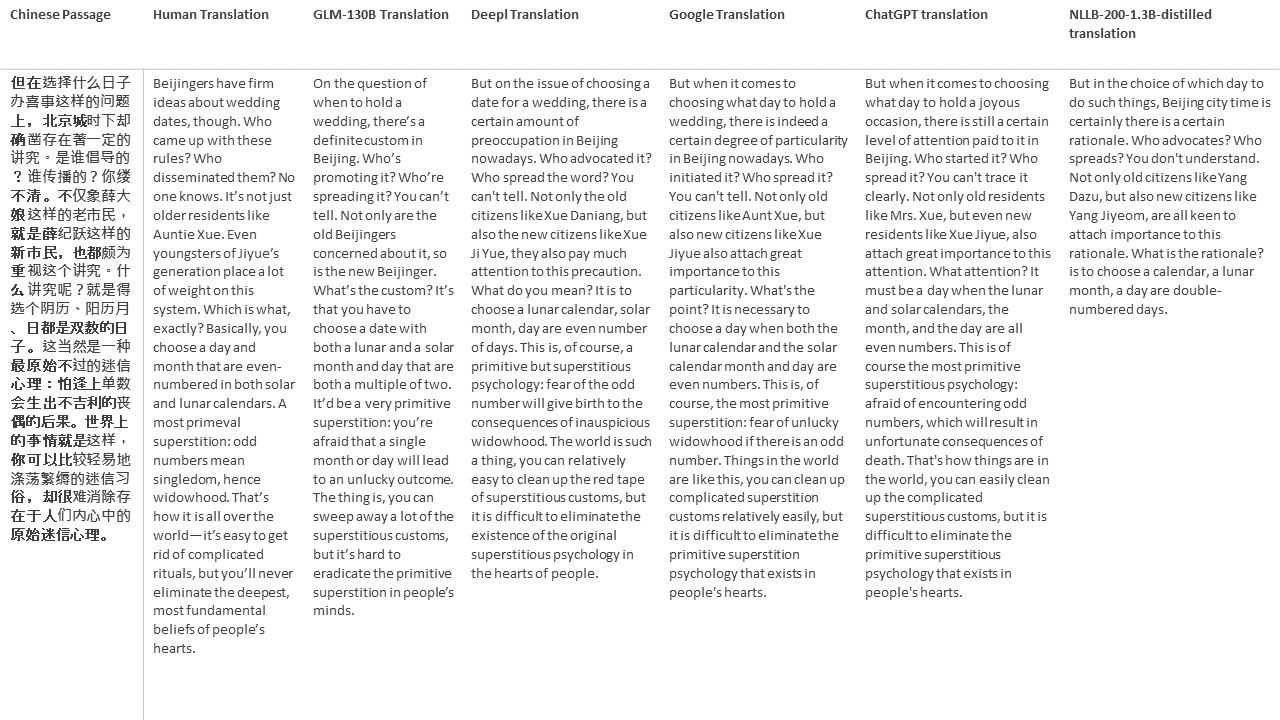

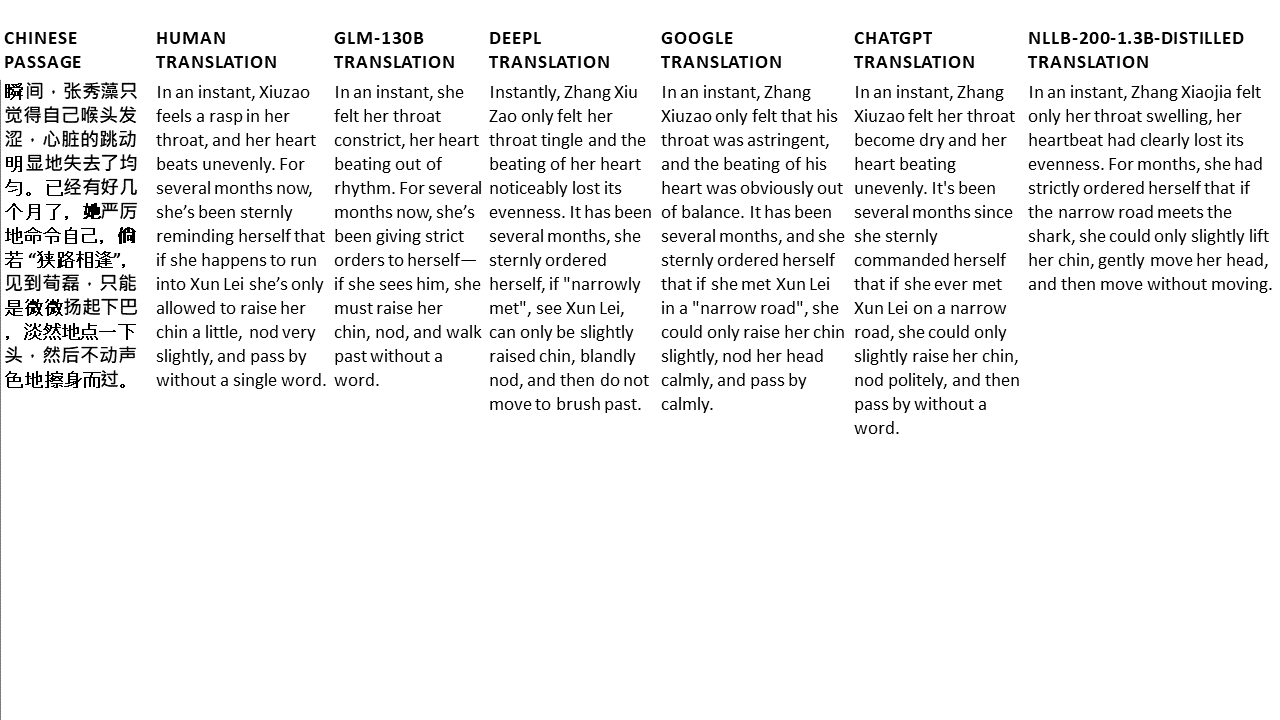

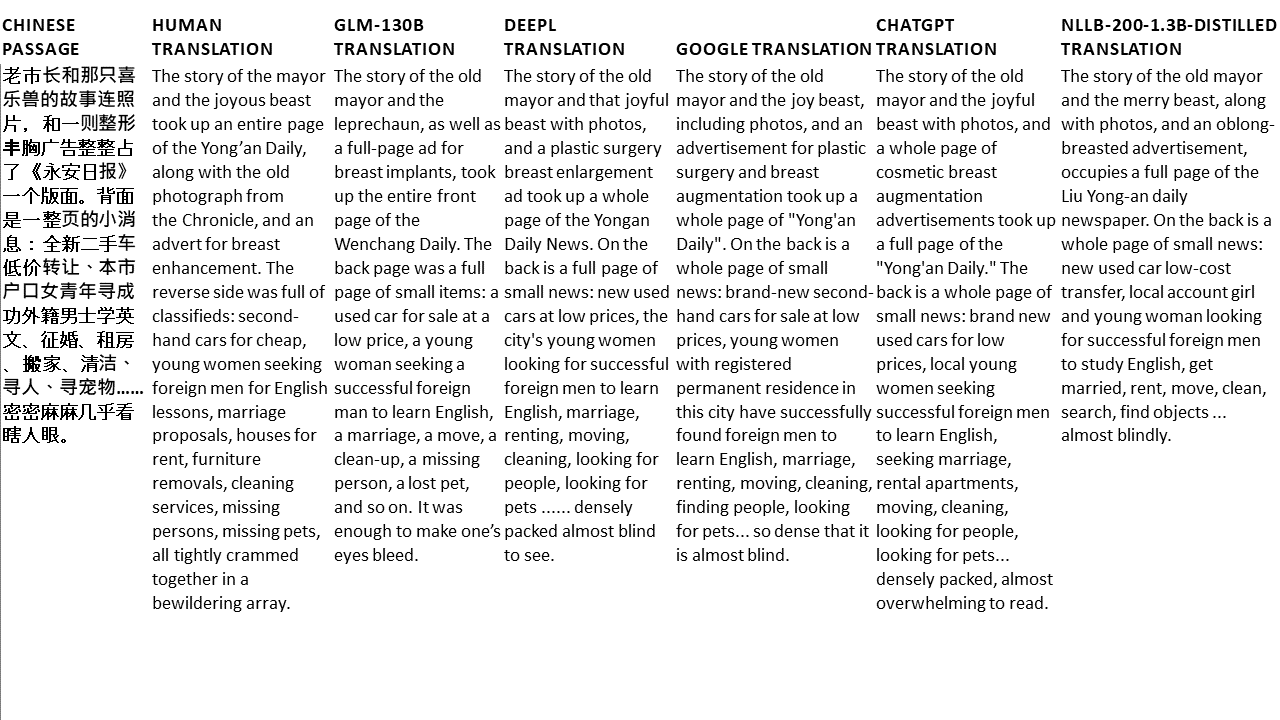

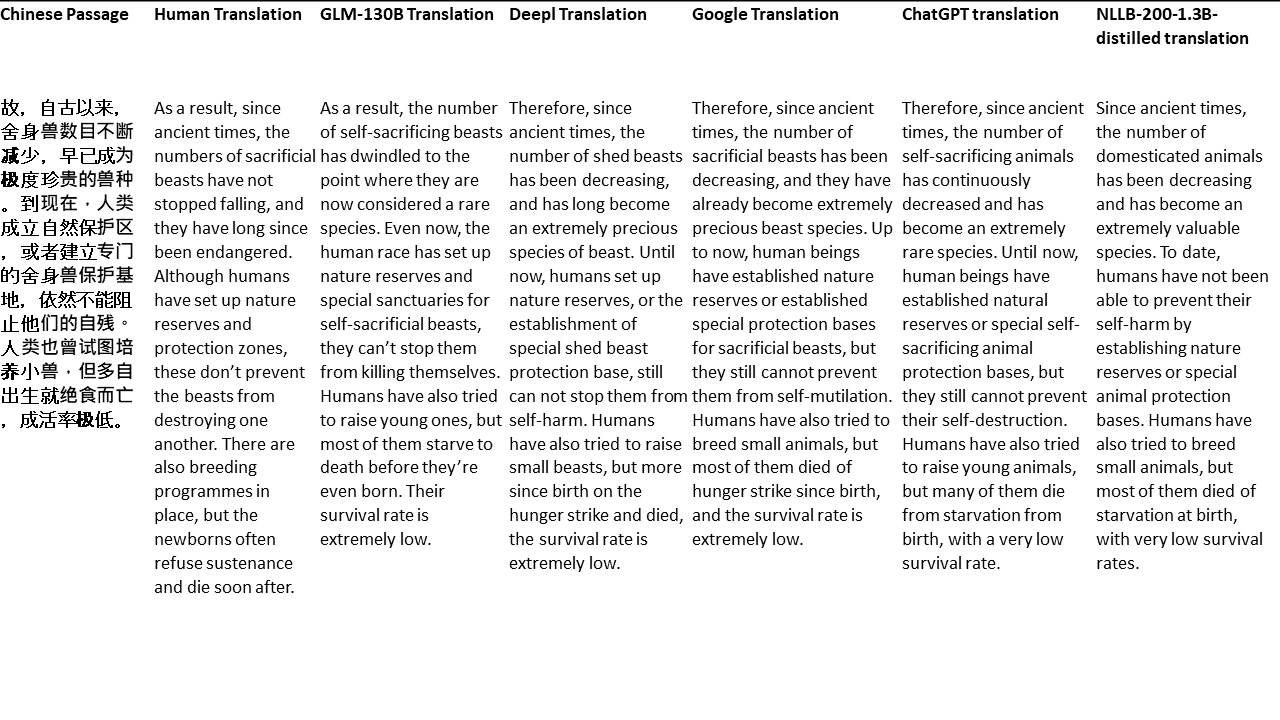

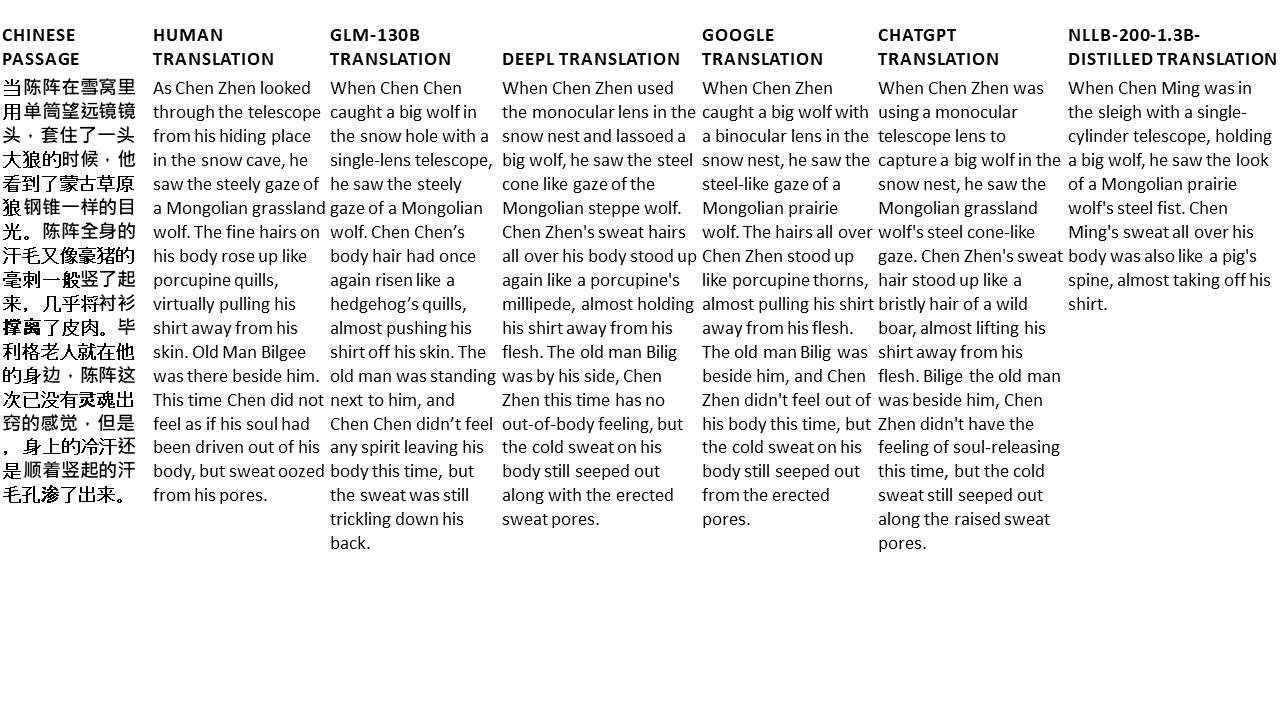

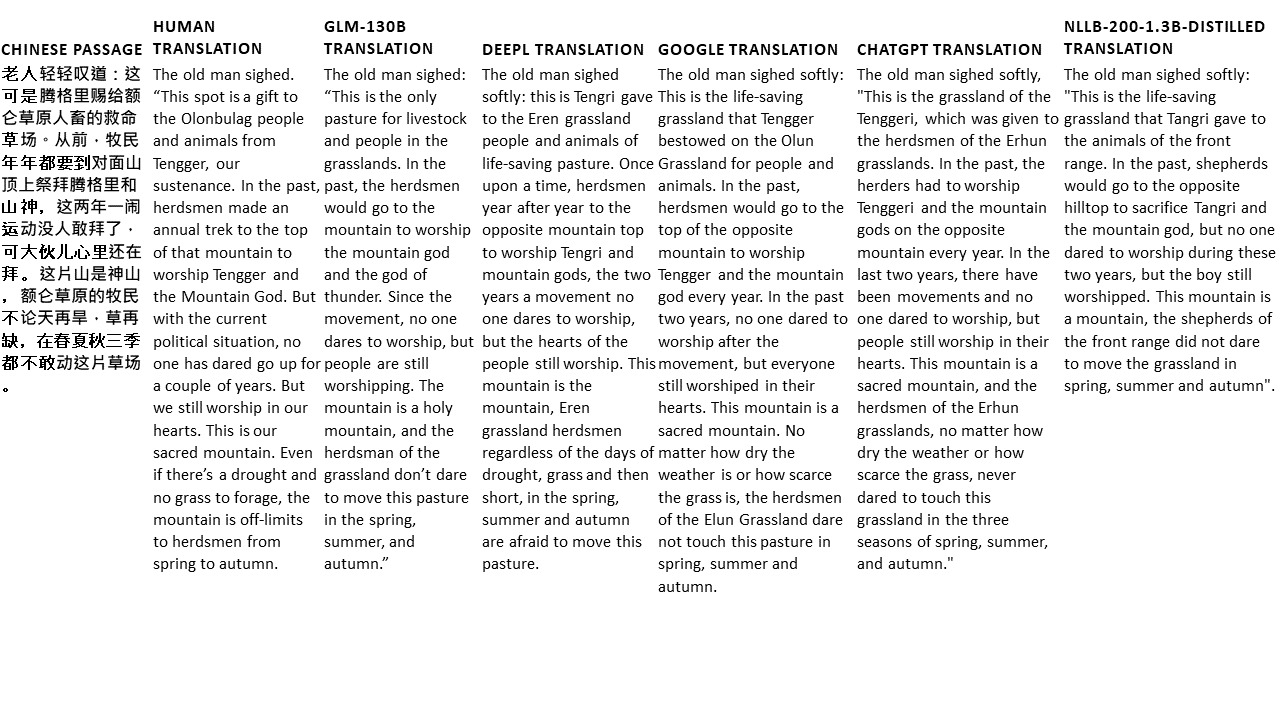

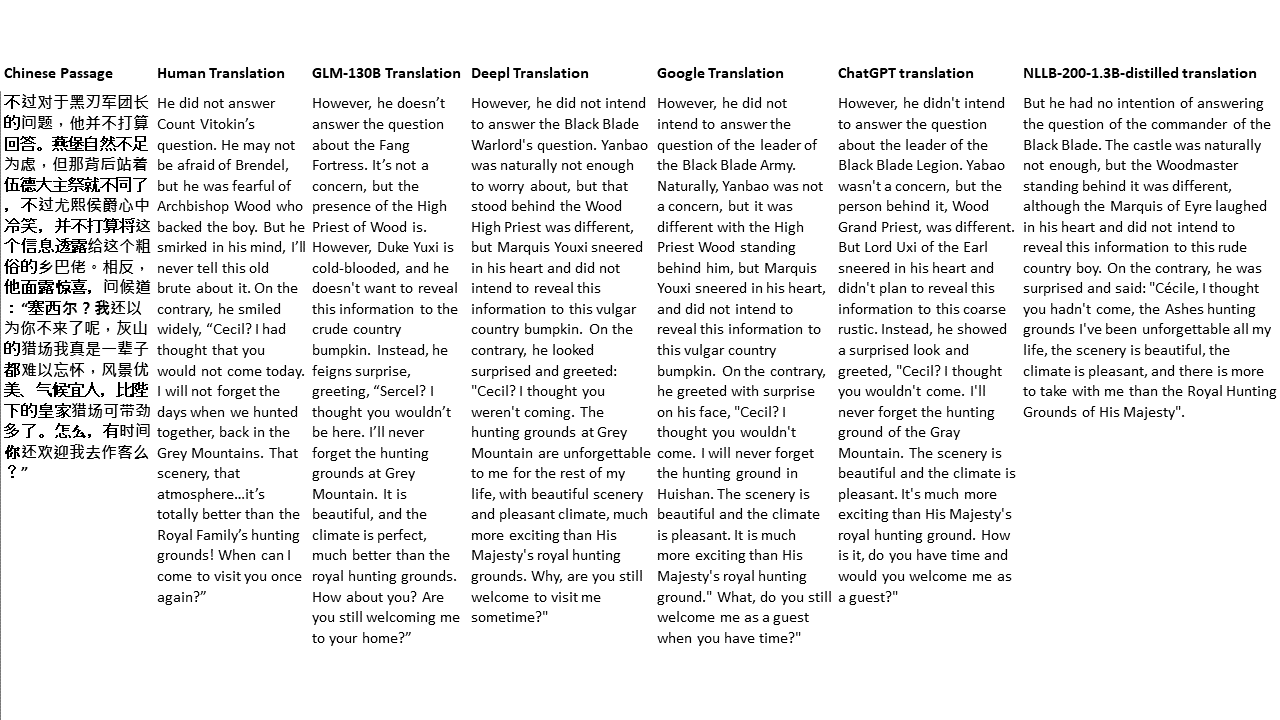

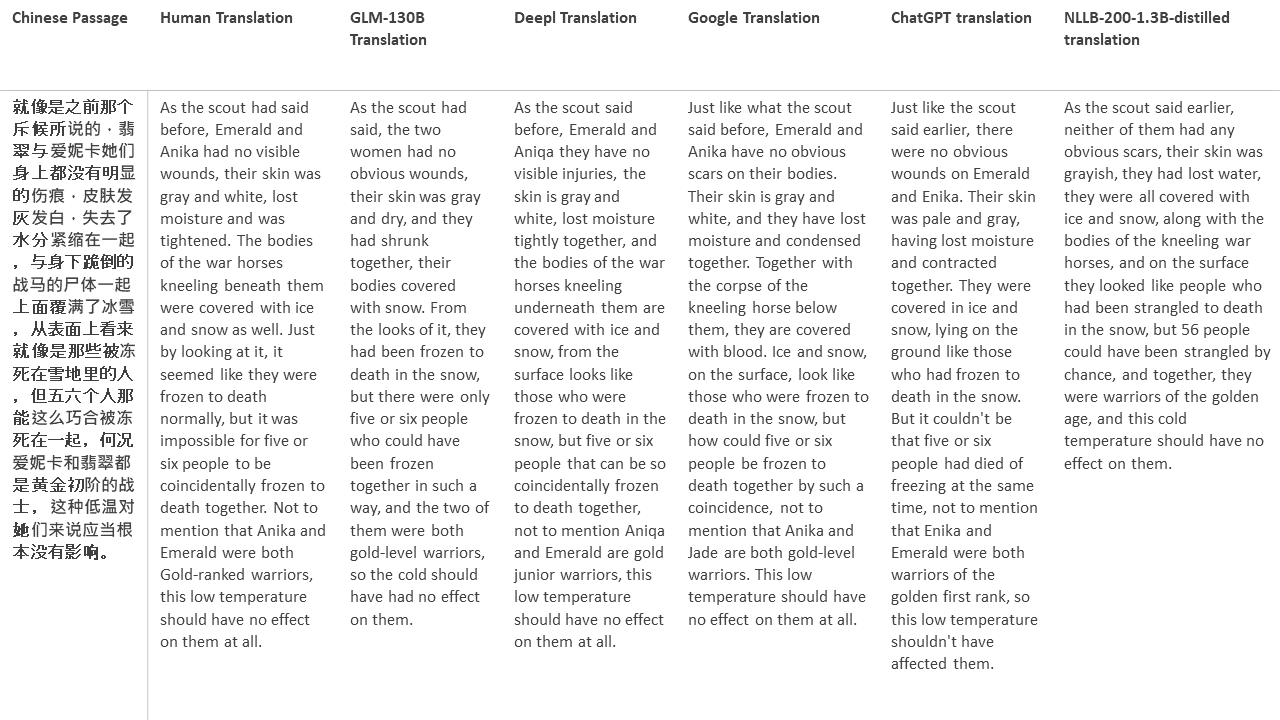

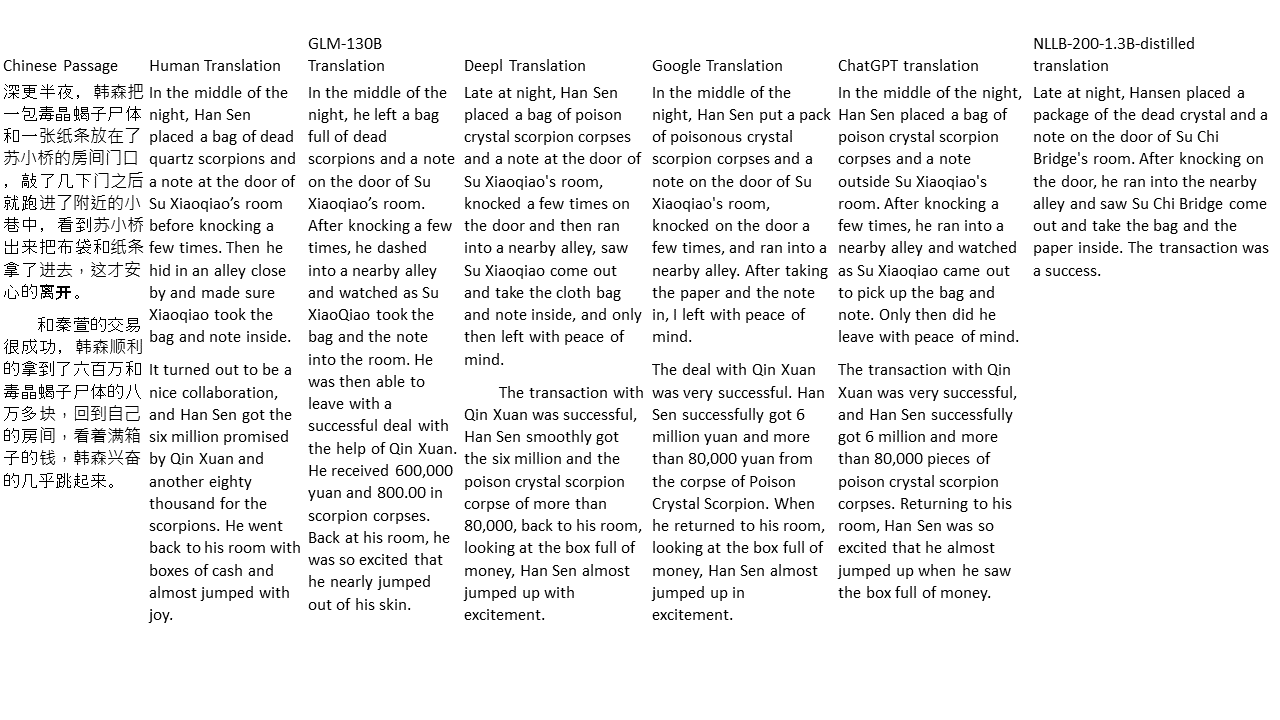

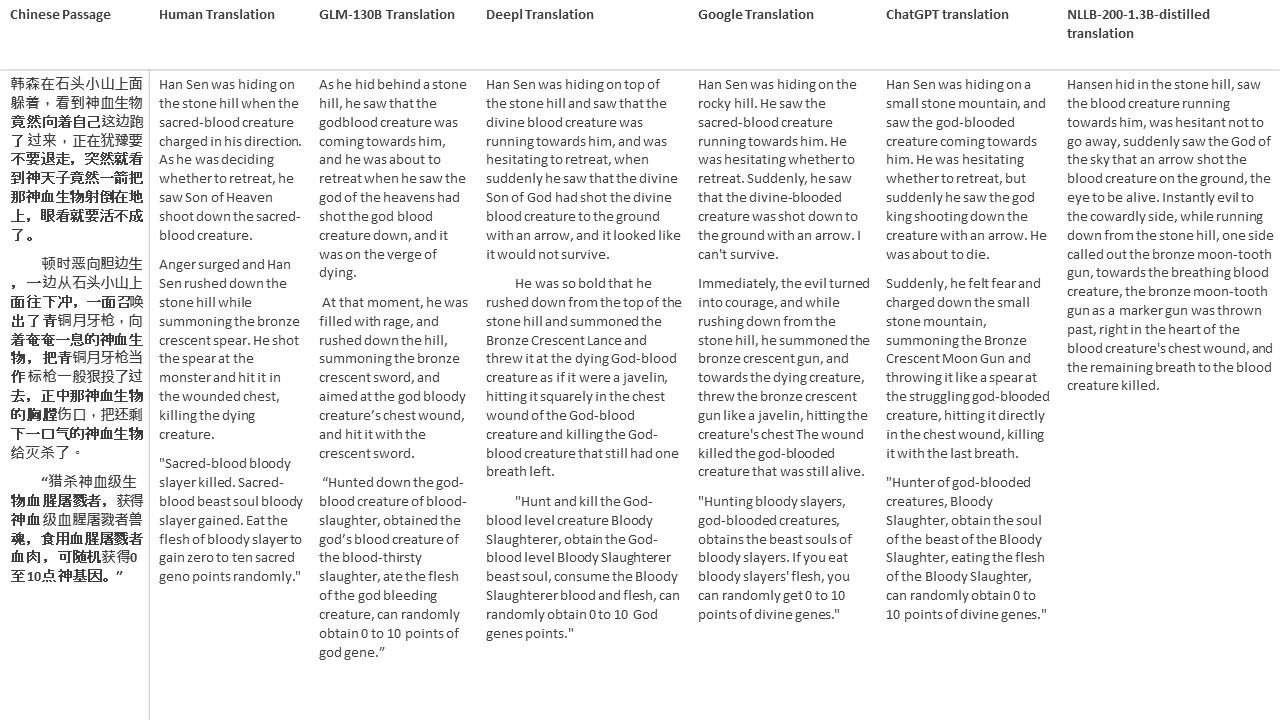

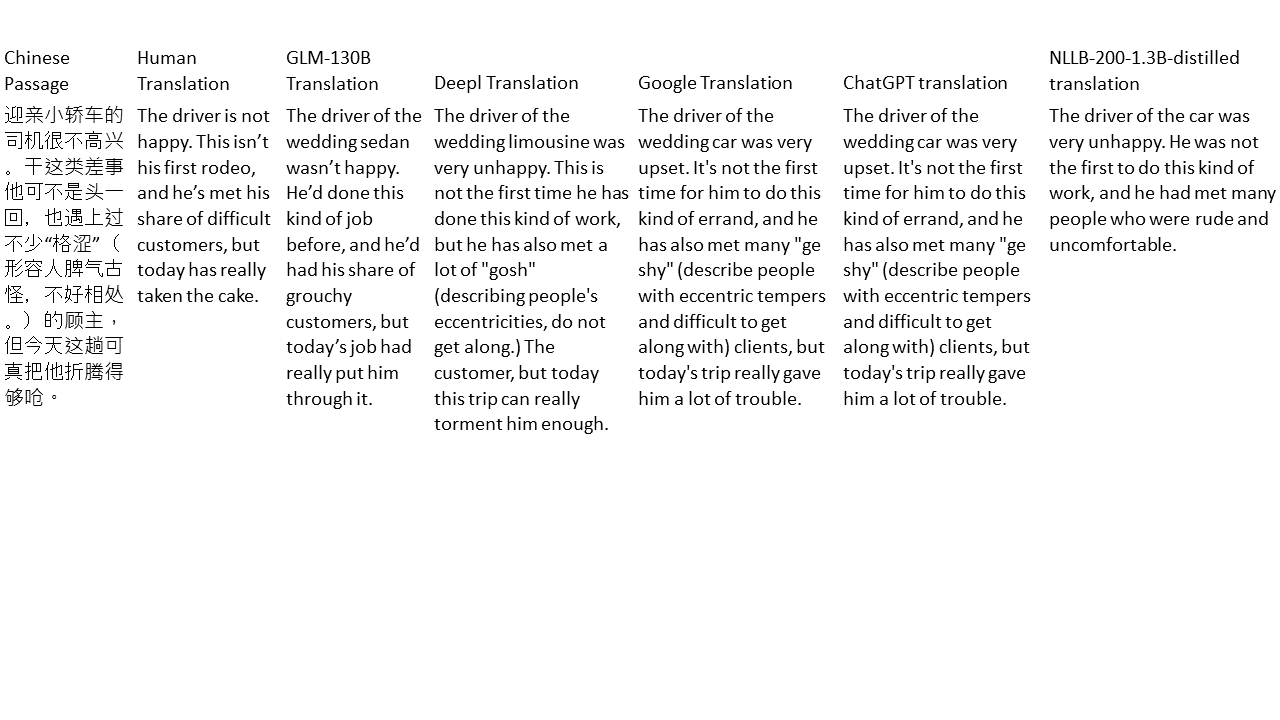

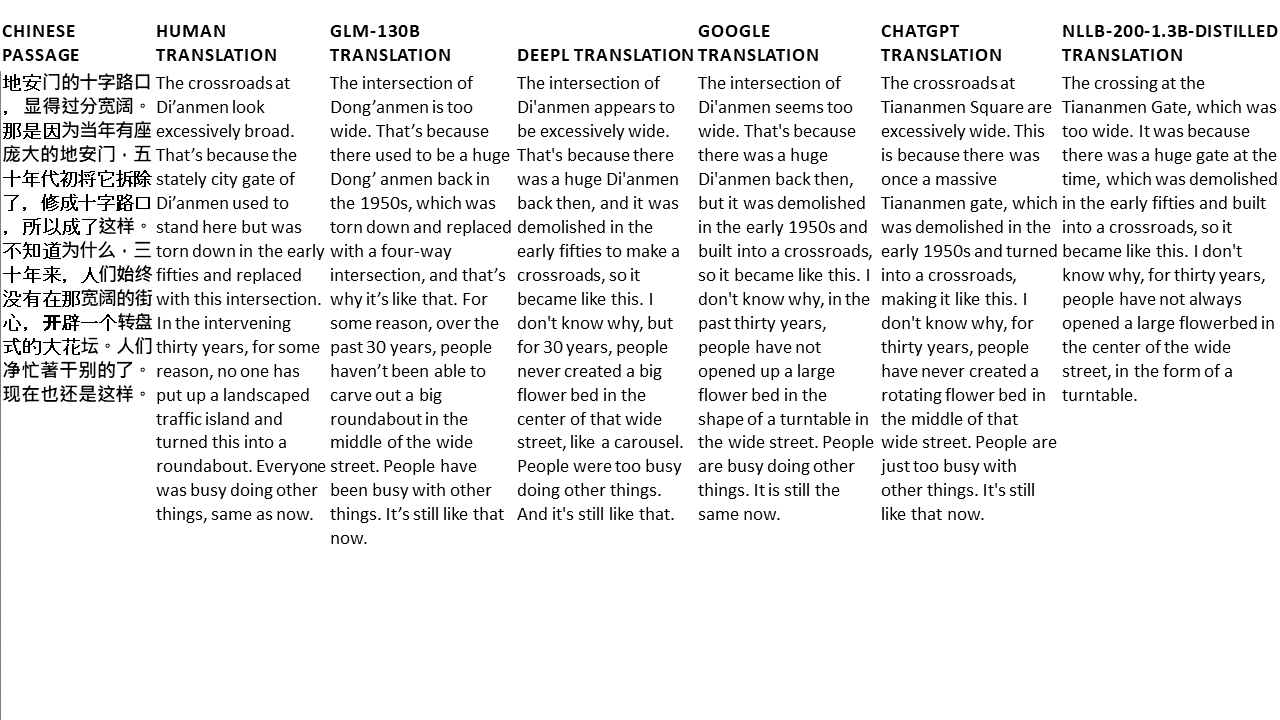

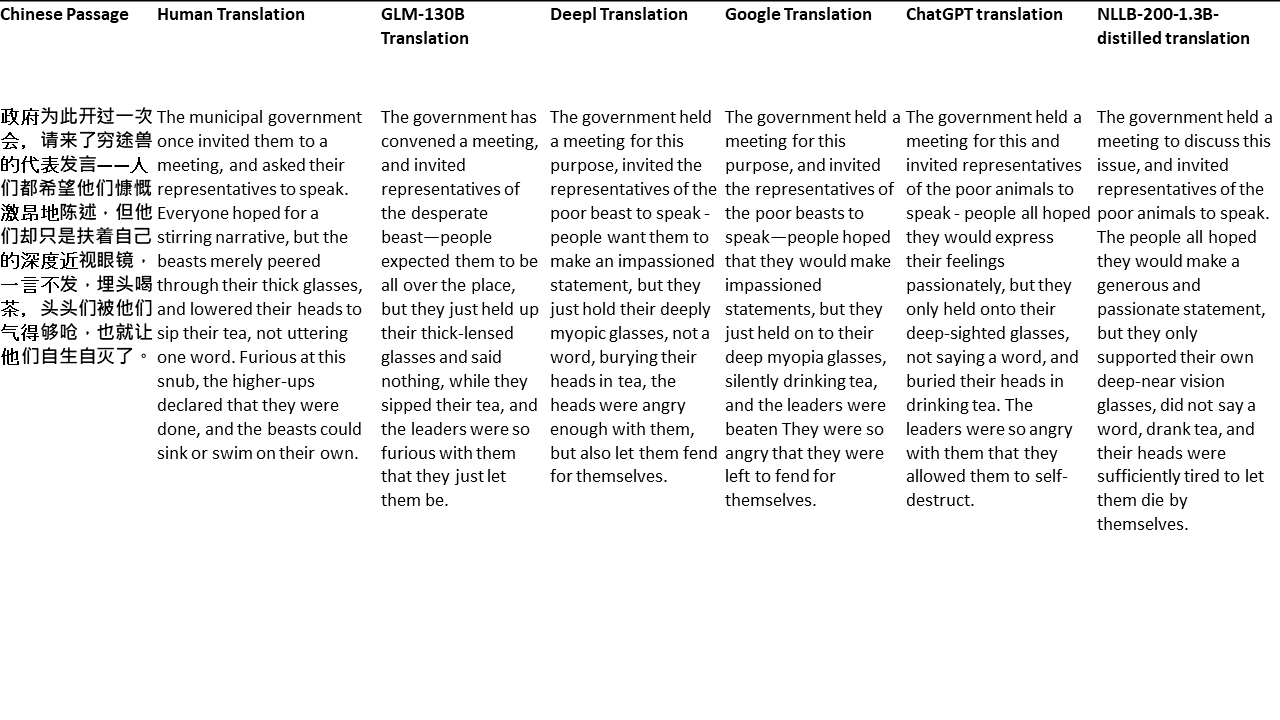

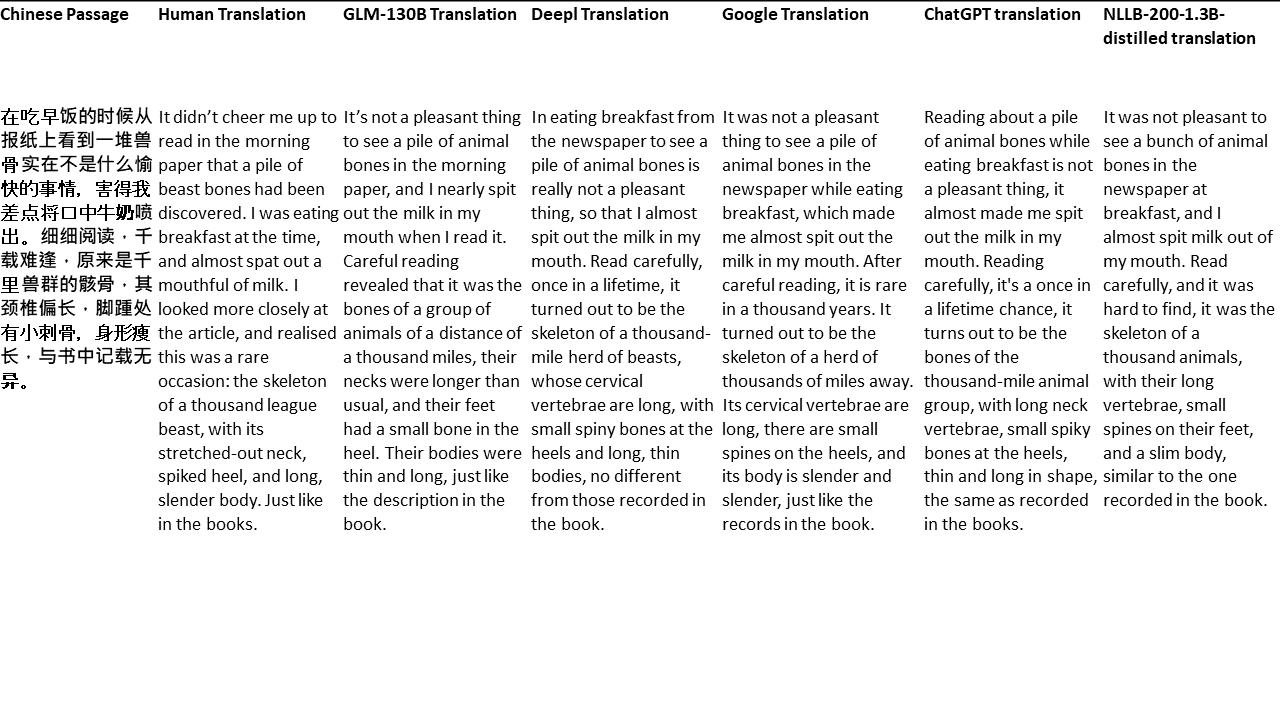

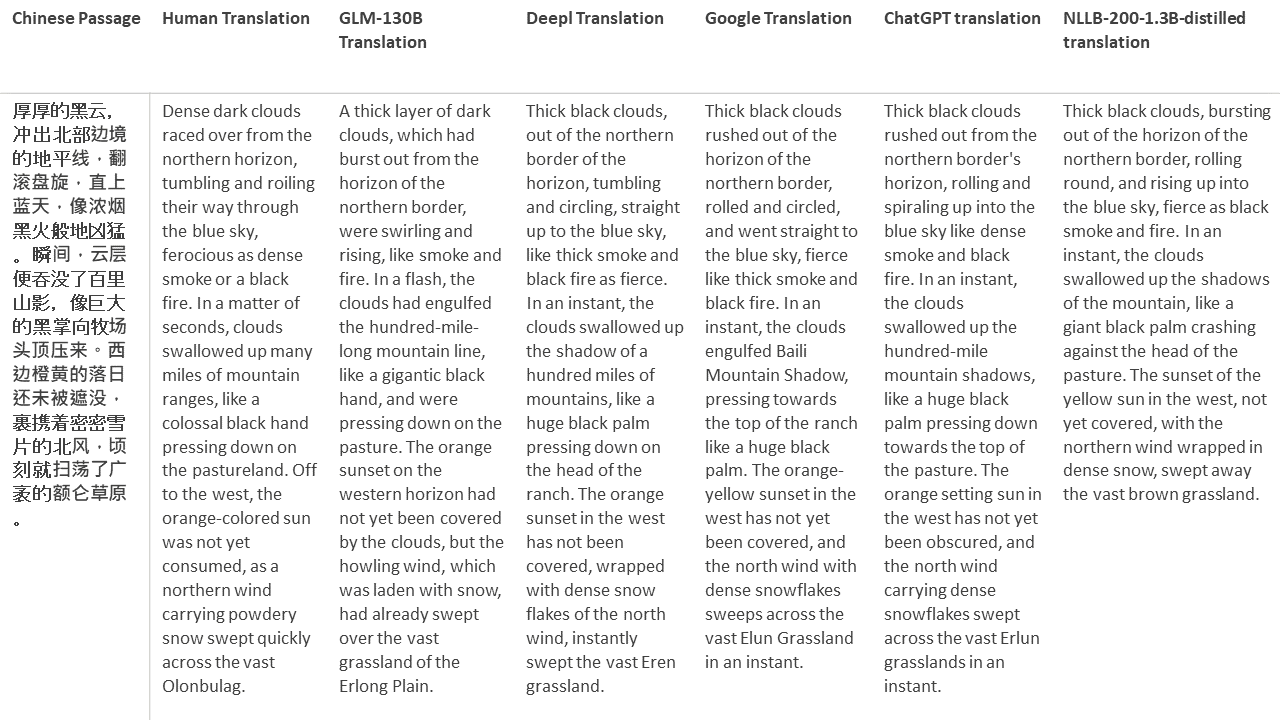

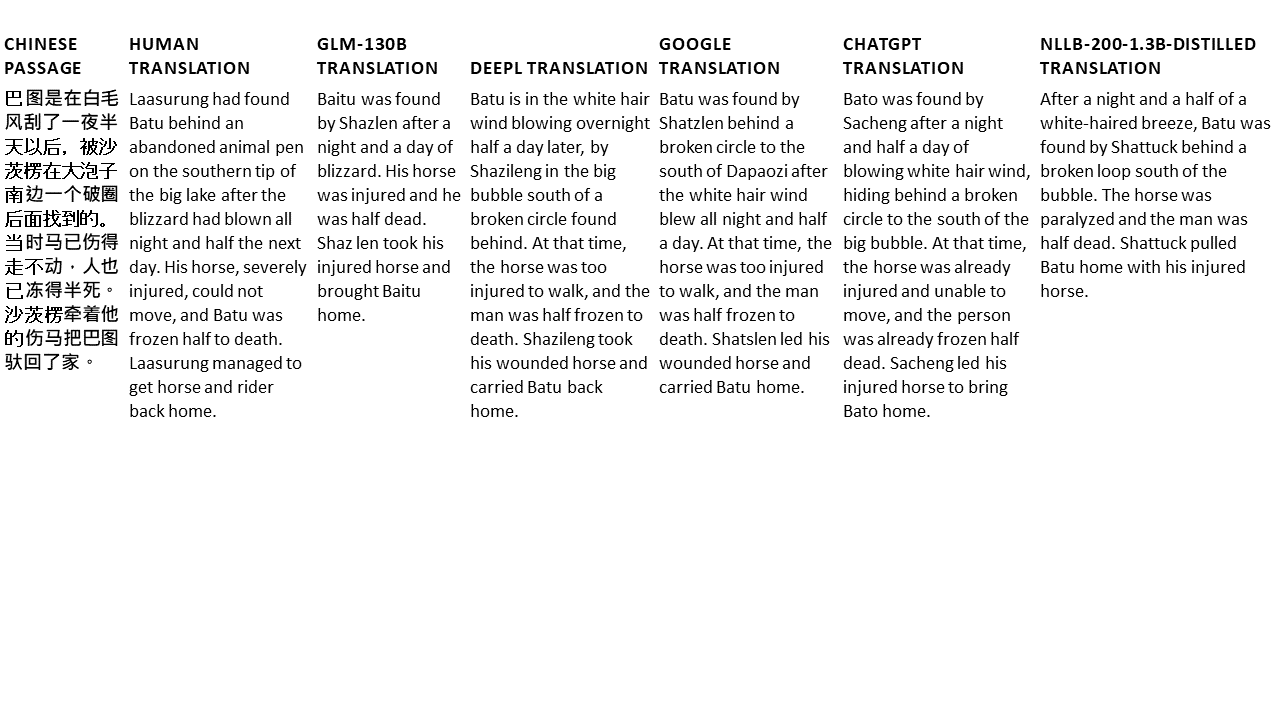

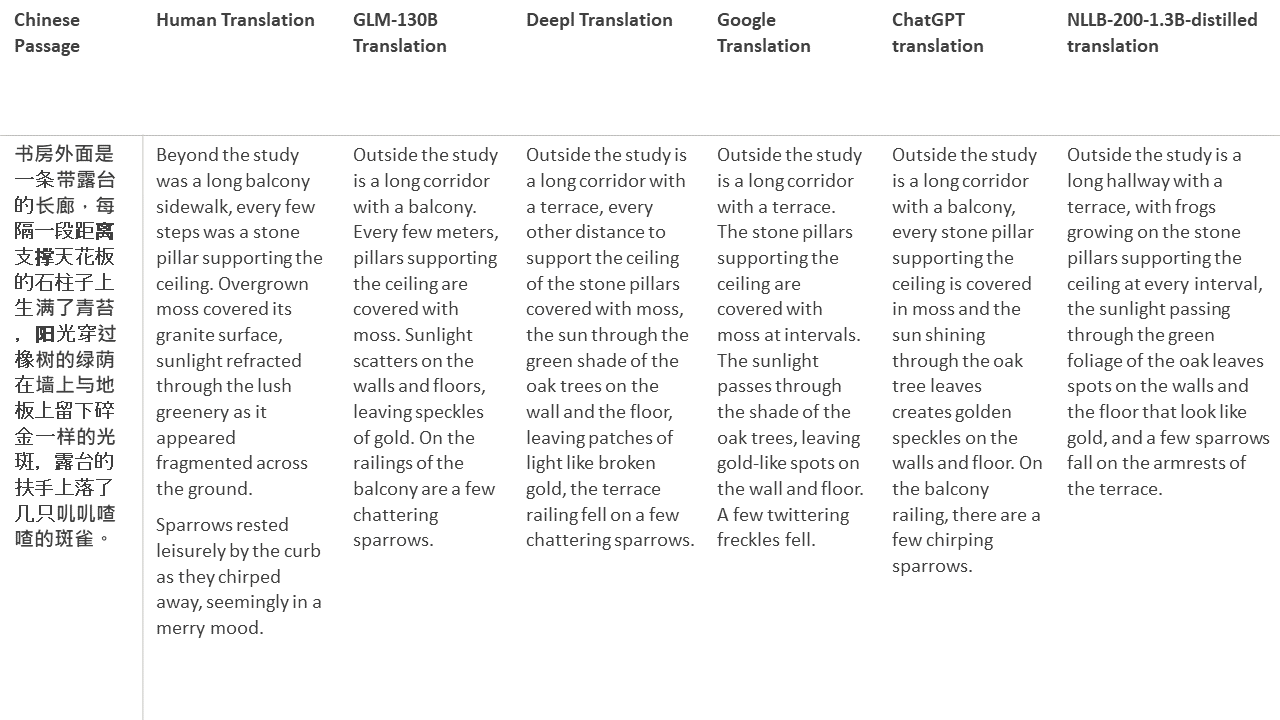

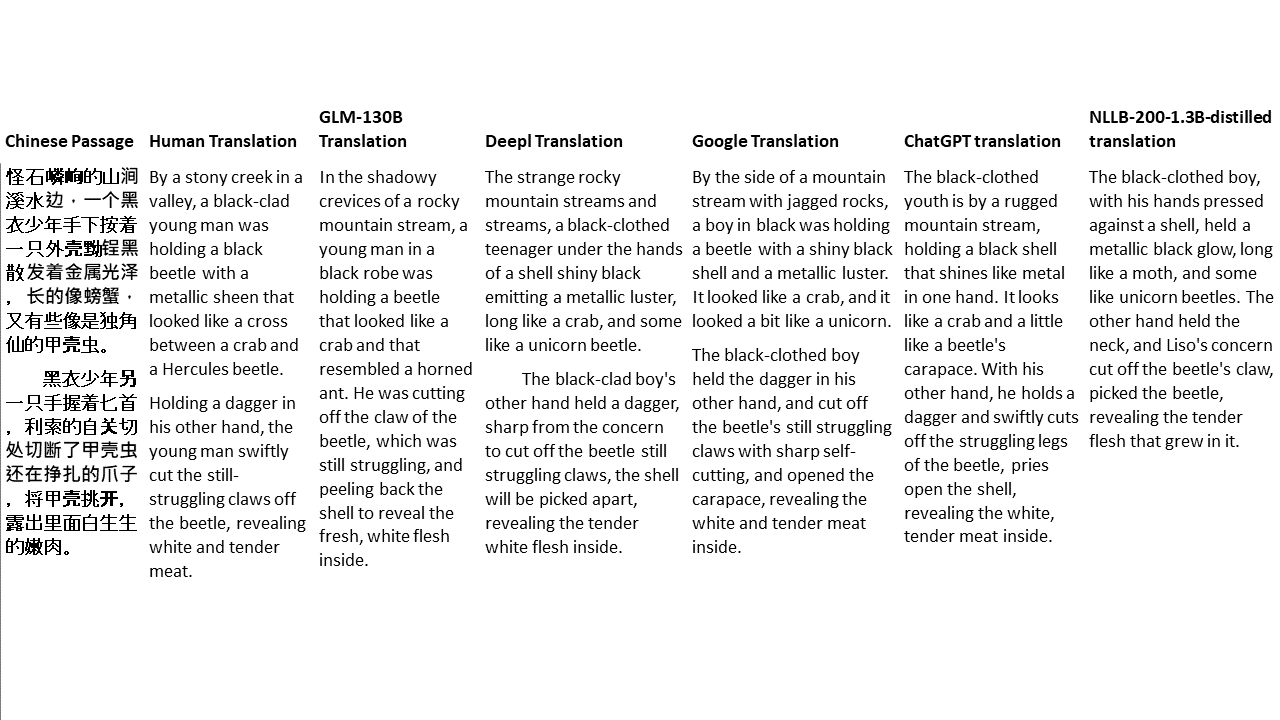

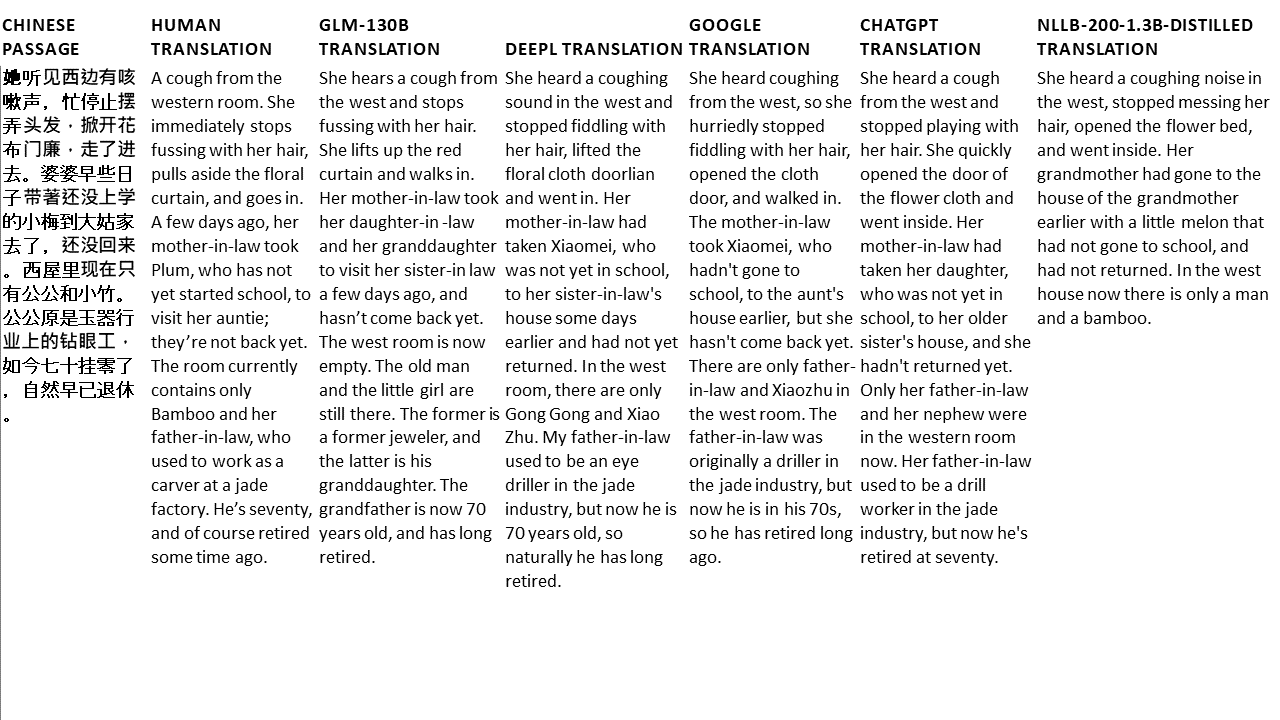

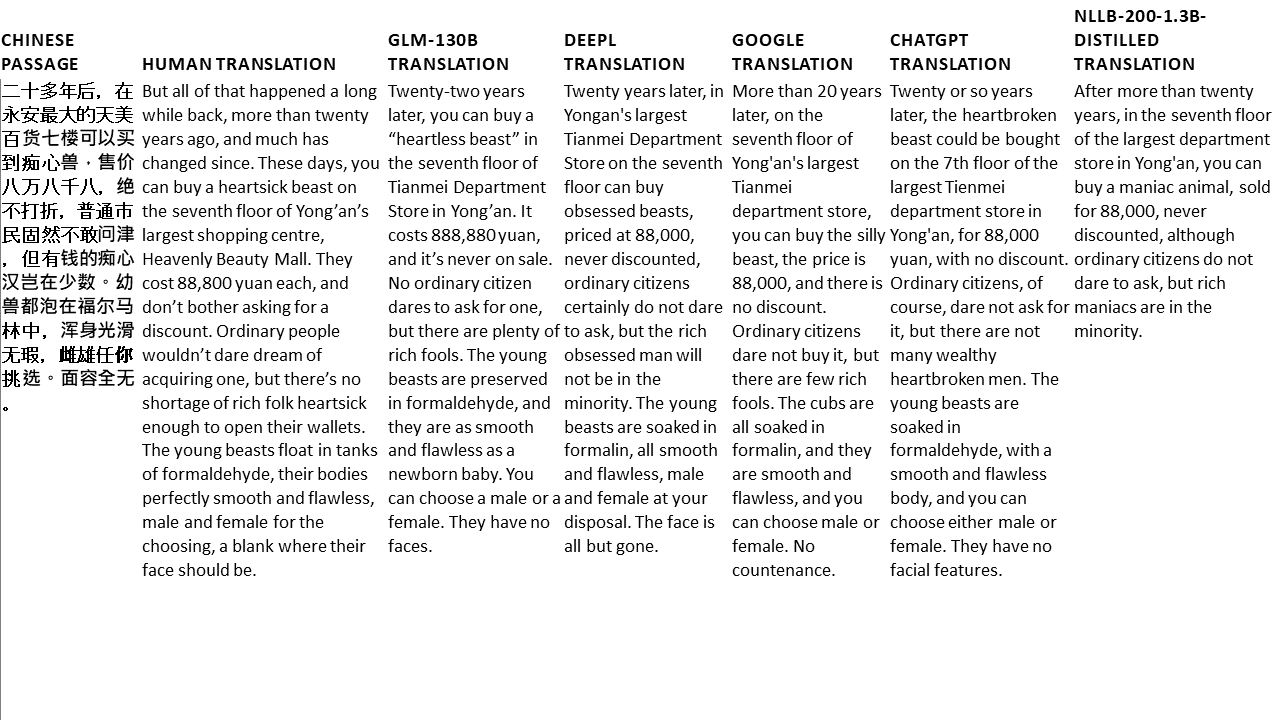

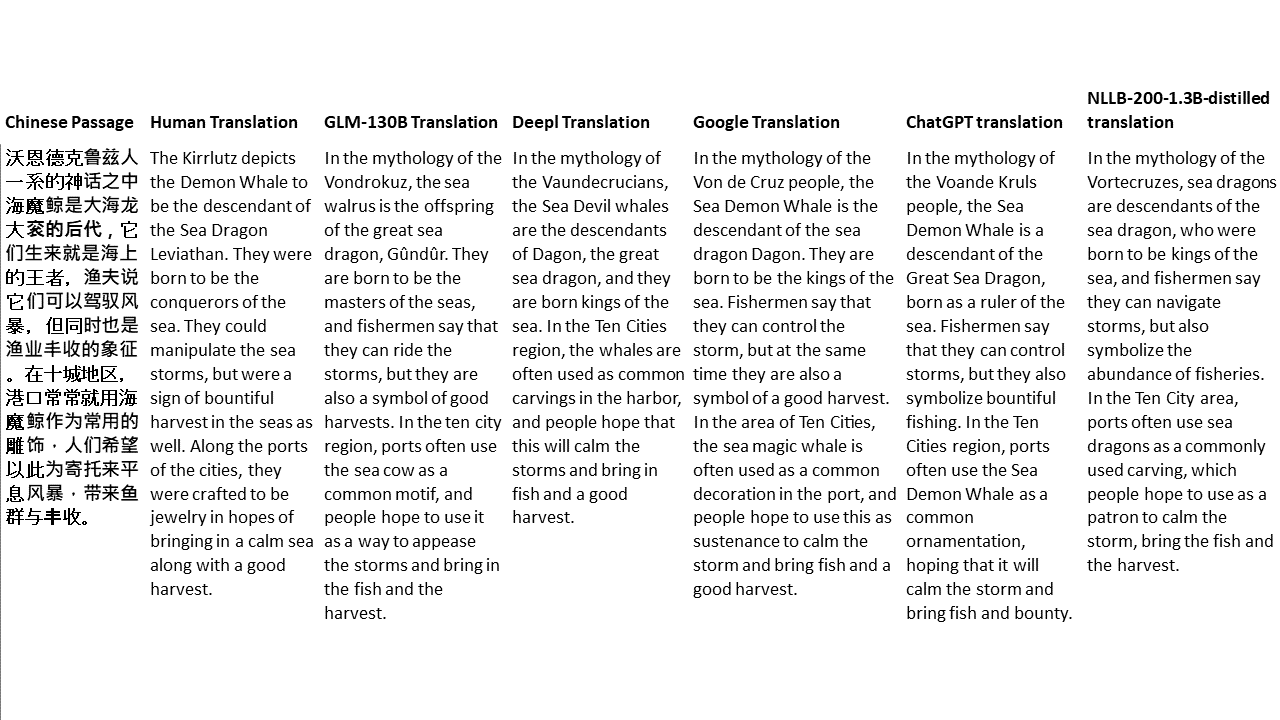

Для моих тестов я выбираю литературу, особенно сложный домен для машинного перевода. 21 отрывки, переведенные GLM-130B и по сравнению с Deepl, Google Translate, CHATGPT и NLLB-200-1.3B-Distiled. Отрывки отобраны из 5 романов. Свадебная вечеринка Лю Синьву, странные звери из Китая Ян Ге, янтарный меч Фей Янфу, Волк Тотем Цзян Ронг и Суперген. Отрывки выбираются случайным образом. Они не являются вишневыми и не регенерированными.