基于大语模型的代理人的兴起和潜力:调查

基于LLM的代理商必读论文。

?即将推出:在每篇论文中添加一句介绍。

?消息

- ☄️[2024/06/07] AgentGym已发布用于在不同环境中开发和发展基于LLM的代理!

- 纸:特工。

- 项目页面:https://agentgym.github.io/。

- 代码:平台和实现。

- 拥抱面资源:AgentTraj-L,Agenteval,Agentevol-7B。

- ? [2024/05/02] R3(通过反向课程增强学习来推理的大型语言模型)被ICML 2024接受!

- ? [2024/02/08] LLM代理推理的RL上的新纸R3已发布!论文:培训大型语言模型通过反向课程增强学习来推理。代码:LLM - 逆转录线-RL。

- ? [2023/09/20]该项目已在Github趋势上列出!这是一个很棒的荣誉!

- ? [2023/09/15]我们的调查已发布!请参阅基于大语言模型的代理人的兴起和潜力:论文的调查!

- [2023/09/14]我们创建此存储库来维护基于LLM的代理的纸质列表。更多论文即将推出!

?介绍

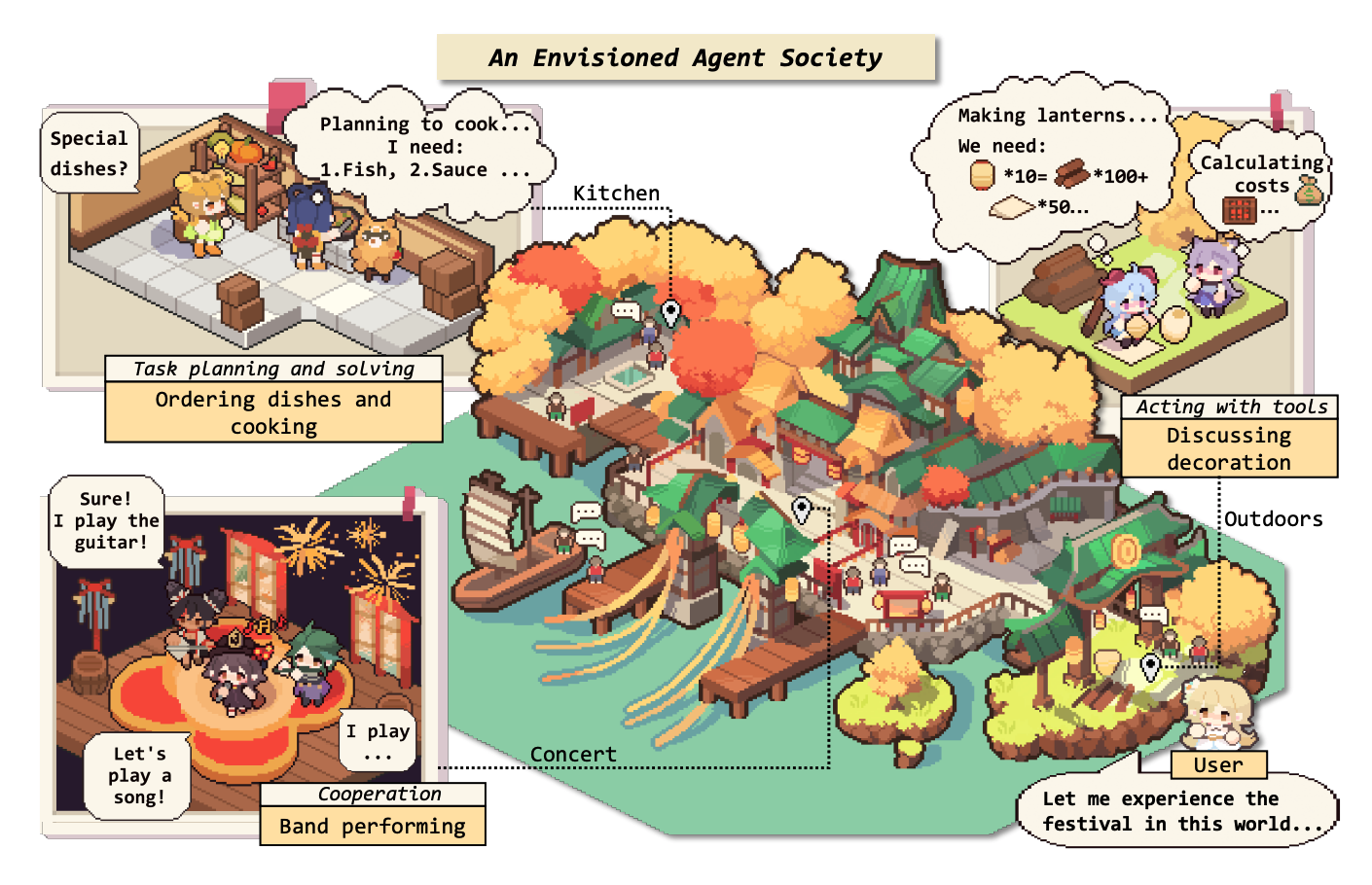

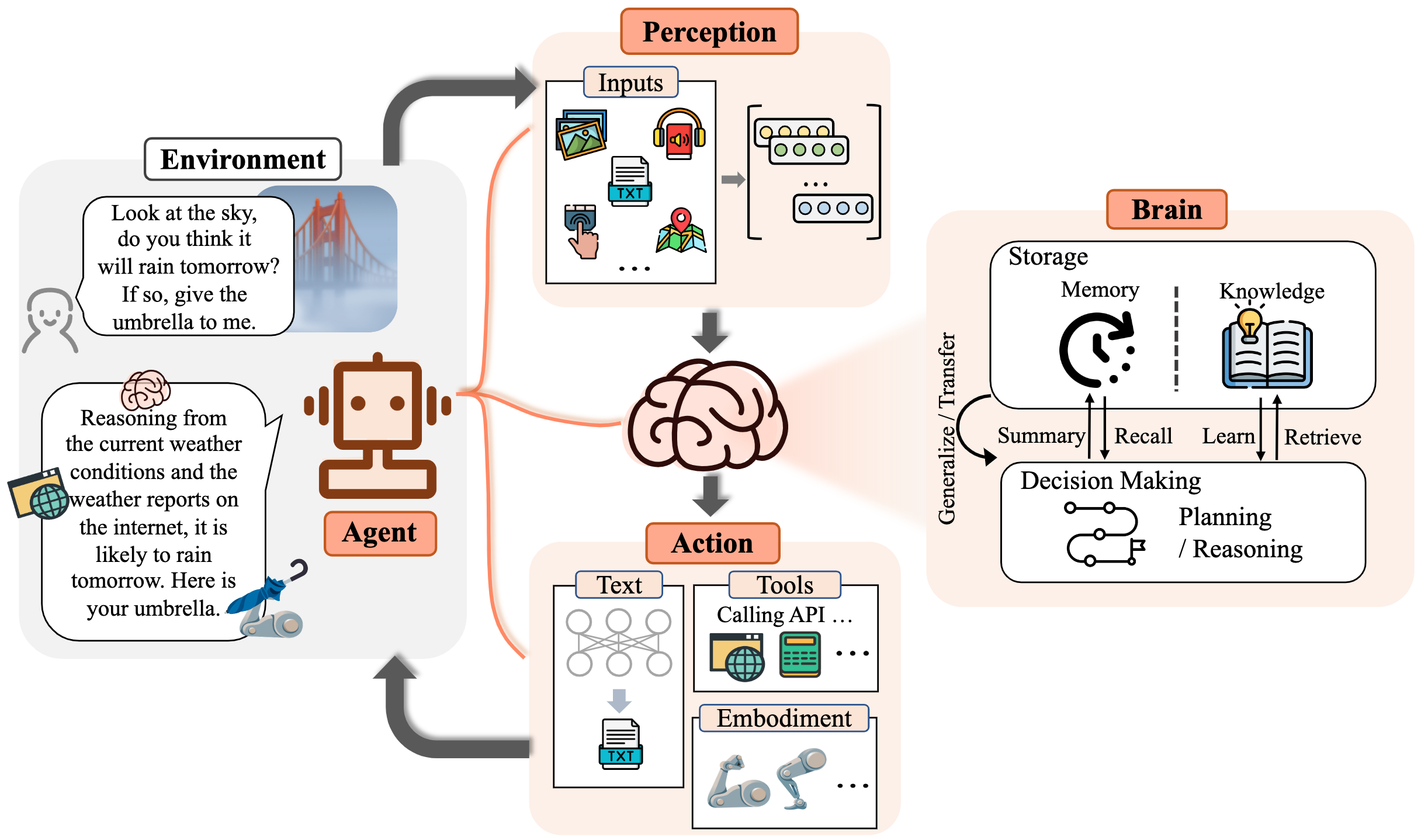

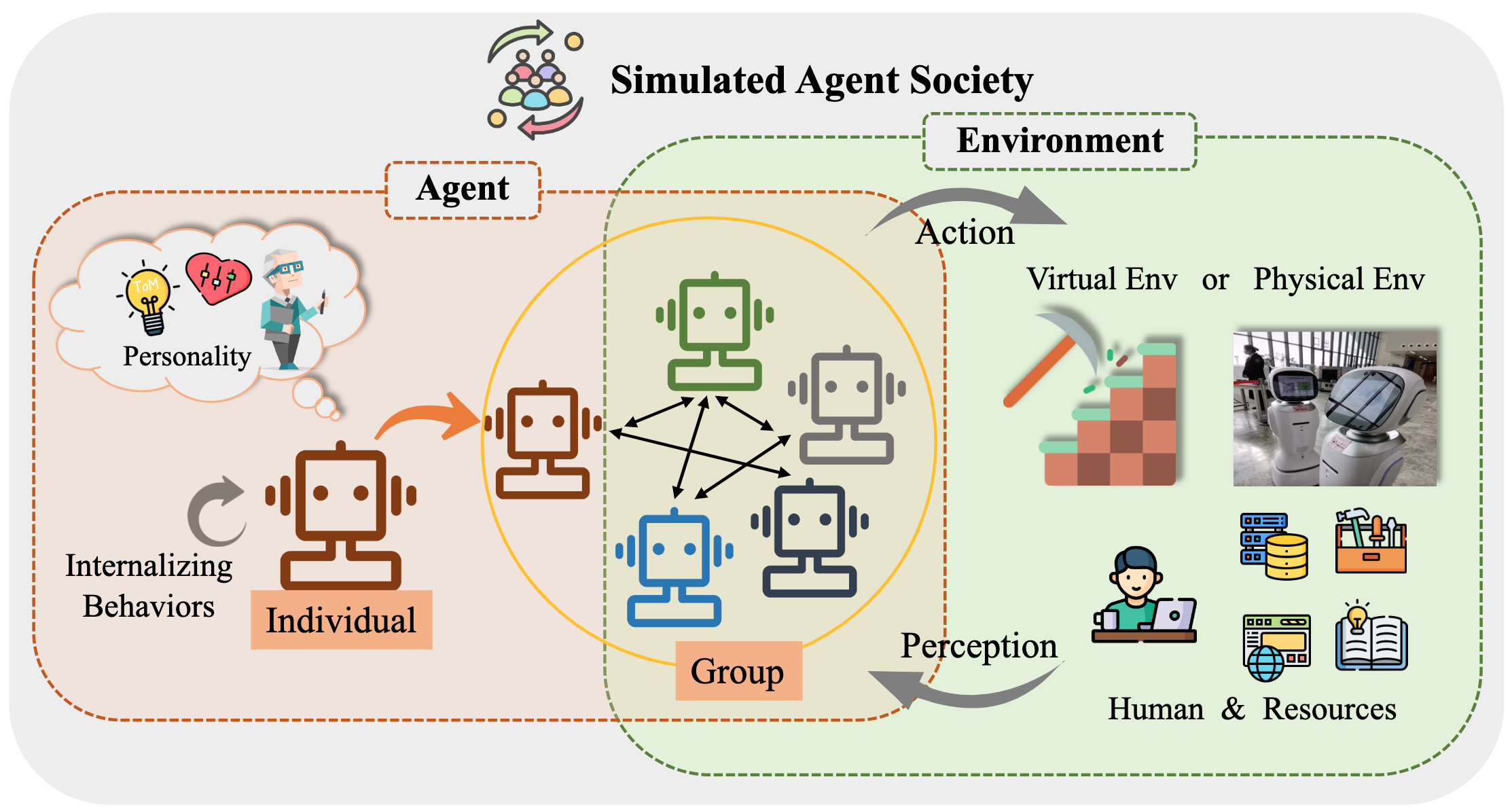

长期以来,人类一直在追求人工智能(AI)等效或超过人类水平,而AI代理被认为是这种追求的有前途的工具。人工智能代理是人为的实体,可以感知其环境,做出决定并采取行动。

由于他们证明的多功能和非凡的功能,大型语言模型(LLM)被视为人工通用智能(AGI)的潜在火花,为建立通用AI代理提供了希望。许多研究工作已利用LLM作为建立AI代理商并取得重大进展的基础。

在此存储库中,我们对基于LLM的代理提供了系统的全面调查,并列出了一些必读的论文。

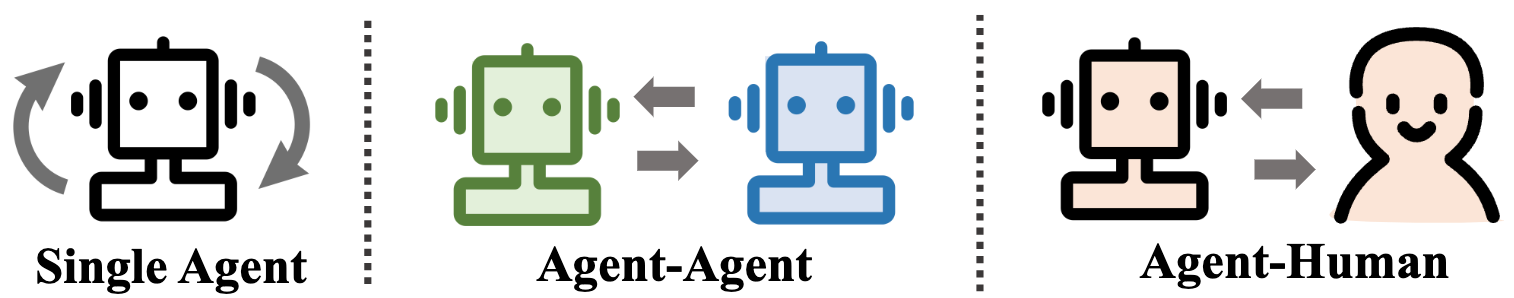

具体来说,我们从基于LLM的代理的一般概念框架开始:包括三个主要组成部分:大脑,感知和动作,并且可以量身定制框架以适合不同的应用程序。随后,我们探讨了基于LLM的代理在三个方面的广泛应用:单代理场景,多代理情景和人类代理合作。此后,我们深入研究了代理社会,探索基于LLM的代理商的行为和个性,成立社会时出现的社会现象以及他们为人类社会提供的见解。最后,我们讨论了该领域内的一系列关键主题和开放问题。

我们非常感谢通过PR,问题,电子邮件或其他方法的任何贡献。

内容表(TOC)

- 基于大语模型的代理人的兴起和潜力:调查

- ?消息

- ?介绍

- 内容表(TOC)

- 1。代理人的诞生:基于LLM的代理商的构建

- 1.1大脑:主要由LLM组成

- 1.1.1自然语言互动

- 1.1.2知识

- 预处理模型

- 语言知识

- 常识知识

- 可行的知识

- 知识的潜在问题

- 1.1.3内存

- 内存能力

- 提高变压器的长度极限

- 总结记忆

- 用向量或数据结构压缩记忆

- 内存检索

- 1.1.4推理与计划

- 1.1.5可传递性和概括性

- 1.2感知:基于LLM的代理的多模式输入

- 1.3动作:扩大基于LLM的代理的动作空间

- 2。代理在实践中:基于LLM的代理的应用

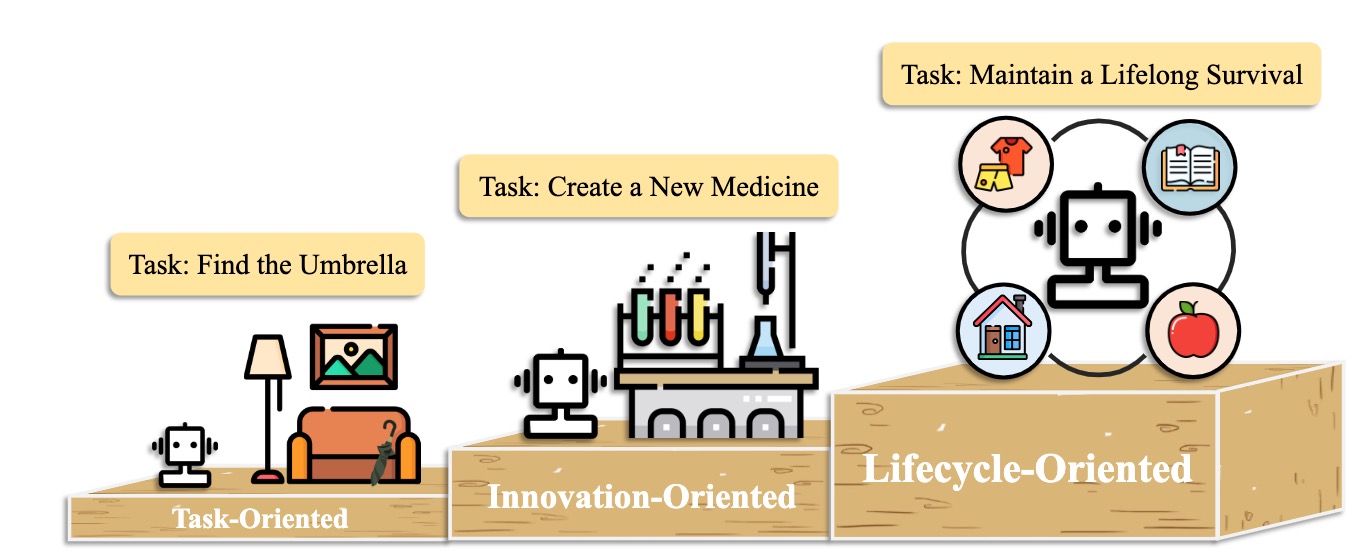

- 2.1单位代理的一般能力

- 2.1.1面向任务的部署

- 2.1.2面向创新的部署

- 2.1.3面向生命周期的部署

- 2.2多种代理的协调潜力

- 2.2.1互补性的合作互动

- 2.2.2促进的对抗互动

- 2.3人与代理商之间的互动互动

- 3.代理社会:从个性到社会性

- 3.1基于LLM的代理商的行为和个性

- 3.2代理社会环境

- 3.2.1基于文本的环境

- 3.2.2虚拟沙箱环境

- 3.2.3物理环境

- 3.3基于LLM的代理商的社会模拟

- 4。其他主题

- 4.1基于LLM的代理的基准

- 4.2培训和优化基于LLM的代理

- 引用

- 项目维护人员和贡献者

- 接触

- 星历史

1。代理人的诞生:基于LLM的代理商的构建

1.1大脑:主要由LLM组成

1.1.1自然语言互动

高质量的一代

- [2023/10]通过多模式大语言模型朝向端到端的体现决策:具有GPT4-Vision和Liang Chen等人的探索。 arxiv。 [纸] [代码]

- 这项工作提出了PCA-eval,它通过基于MLLM的端到端方法和基于LLM的工具 - 使用感知,认知和动作水平基于基于LLM的工具来实现决策。

- [2023/08]关于推理,幻觉和互动性Chatgpt的多语言,多语言,多模式评估。 Yejin Bang等。 arxiv。 [纸]

- 这项工作使用涵盖8个不同常见的NLP应用程序任务的21个数据集评估了ChatGPT的多语言,多语言和多模式方面。

- [2023/06] LLM-eval:与大语言模型的开放域对话进行统一的多维自动评估。 Yen-Ting Lin等。 arxiv。 [纸]

- LLM-Eval方法评估了评估的多个维度,例如内容,语法,相关性和适当性。

- [2023/04] chatgpt是高度流利的语法误差校正系统吗?全面评估。 Tao Fang等。 arxiv。 [纸]

- 评估结果表明,ChatGpt具有出色的错误检测功能,并且可以自由纠正错误以使校正的句子非常流利。此外,它在非英国和低资源设置中的性能突出了其在多语言GEC任务中的潜力。

深刻的理解

- [2023/06]聪明的汉斯还是神经心理理论?在大型语言模型中进行社会推理的压力测试。 Natalie Shapira等。 arxiv。 [纸]

- LLM表现出某些心理能力理论,但是这种行为远非强大。

- [2022/08]在上下文中从语言中推断出奖励。杰西·林等人。 ACL。 [纸]

- 这项工作提出了一种模型,该模型会侵入语言中的奖励,并预测在看不见的环境中的最佳行动。

- [2021/10]基于心理的辅助沟通理论在复杂的人类机器人合作中。 Moritz C. Buehler等。 arxiv。 [纸]

- 这项工作设计了一种代理寿司,并在互动过程中了解人类。

1.1.2知识

预处理模型

- [2023/04]从未标记的数据中学习句子的分布式表示。菲利克斯·希尔(剑桥大学)等。 arxiv。 [纸]

- [2020/02]您可以将多少知识包装到语言模型的参数中?亚当·罗伯茨(Google)等人。 arxiv。 [纸]

- [2020/01]神经语言模型的缩放定律。 Jared Kaplan(Johns Hopkins University)等。 arxiv。 [纸]

- [2017/12]机器智能中的常识知识。 Niket Tandon(艾伦人工智能研究所)等。 Sigmod。 [纸]

- [2011/03]自然语言处理(几乎)从头开始。罗南·科洛伯特(普林斯顿)等。 arxiv。 [纸]

语言知识

- [2023/02]关于推理,幻觉和互动性的多种语言,多语言,多模式评估。 Yejin Bang等。 arxiv。 [纸]

- [2021/06]为语义属性及其值探测预训练的语言模型。 Meriem Beloucif等。 emnlp。 [纸]

- [2020/10]探测词汇语义的验证语言模型。伊万·瓦利奇等。 arxiv。 [纸]

- [2019/04]在单词表示中查找语法的结构探测器。 John Hewitt等。 ACL。 [纸]

- [2016/04]鉴于更多的语义知识,改进了自动关键字提取。 H梁。高级应用程序的系统。 [纸]

常识知识

- [2022/10]代码的语言模型是几乎没有常识的学习者。 Aman Madaan等人。 [纸]

- [2021/04]上下文语言模型中的关系世界知识表示:评论。 Tara Safavi等。 arxiv。 [纸]

- [2019/11]我们怎么知道哪些语言模型知道? Zhengbao Jiang等人。 [纸]

可行的知识

- [2023/07]医学中的大型语言模型。 Arun James Thirunavukarasu等。自然。 [纸]

- [2023/06] DS-1000:数据科学代码生成的自然和可靠的基准。 Yuhang Lai等。 ICML。 [纸]

- [2022/10]代码的语言模型是几乎没有常识的学习者。 Aman Madaan等。 arxiv。 [纸]

- [2022/02]对大型代码模型的系统评估。 Frank F. Xu等。 [纸]

- [2021/10]培训验证者以解决数学单词问题。 Karl Cobbe等。 arxiv。 [纸]

知识的潜在问题

- [2023/10] Freshllms:使用搜索引擎增强的大型语言模型。 Tu Vu(Google)等。 Arxiv [Paper] [代码]

- [2023/05]编辑大语言模型:问题,方法和机会。 Yunzhi Yao等。 arxiv。 [纸]

- [2023/05]自我检查:使用大型语言模型进行事实检查的插件和播放模块。 Miaoran Li等。 arxiv。 [纸]

- [2023/05]评论家:大语言模型可以通过工具交互式批评自我纠正。 Zhibin Gou等。 arxiv。 [纸]

- [2023/04]使用基础模型的工具学习。 Yujia Qin等。 arxiv。 [纸]

- [2023/03] selfcheckgpt:用于生成大语言模型的零储蓄黑盒幻觉检测。 Potsawee Manakul等。 arxiv。 [纸]

- [2022/06]基于内存的模型编辑。埃里克·米切尔(Eric Mitchell)等。 arxiv。 [纸]

- [2022/04]对语言模型作为知识基础的综述。 Badr Alkhamissi等人。 [纸]

- [2021/04]在语言模型中编辑事实知识。 Nicola de Cao等。 [纸]

- [2017/08]测量神经网络中的灾难性遗忘。 Ronald Kemker等人。 [纸]

1.1.3内存

内存能力

提高变压器的长度极限

- [2023/10]模因:作为操作系统的LLMS。查尔斯·帕克(UC Berkeley)等。 arxiv。 [PAPER] [项目页面] [代码] [数据集]

- [2023/05]随机位置编码增强变压器的长度泛化。 Anian Ruoss(DeepMind)等。 arxiv。 [纸] [代码]

- [2023-03] COLT5:具有条件计算的更快的远程变压器。 Joshua Ainslie(Google Research)等。 arxiv。 [纸]

- [2022/03]使用变压器对长文档进行有效分类。 Hyunji Hayley Park(伊利诺伊大学)等。 arxiv。 [纸] [代码]

- [2021/12] Longt5:长序列的有效文本到文本变压器。 Mandy Guo(Google Research)等。 arxiv。 [纸] [代码]

- [2019/10] BART:自然语言生成,翻译和理解的序列序列训练的序列预训练。迈克尔·刘易斯(Facebook AI)等。 arxiv。 [纸] [代码]

总结记忆

- [2023/10]沿着记忆迷宫走:通过互动阅读霍华德·陈(Princeton University)等人,超越上下文限制了。 arxiv。 [纸]

- [2023/09]通过链接大语模型Yulin Chen(Tsinghua University)等人来授权私人辅导。 arxiv。 [纸]

- [2023/08]驱除:LLM代理是经验学习者。安德鲁·赵(Tsinghua University)等。 arxiv。 [纸] [代码]

- [2023/08] Chateval:通过多代理辩论迈向更好的基于LLM的评估者。 Chi-Min Chan(Tsinghua University)等。 arxiv。 [纸] [代码]

- [2023/05] MemoryBank:增强具有长期记忆的大型语言模型。 Wanjun Zhong(Harbin理工学院)等。 arxiv。 [纸] [代码]

- [2023/04]生成剂:人类行为的交互式模拟。 Joon Sung Park(Stanford University)等。 arxiv。 [纸] [代码]

- [2023/04]具有自控内存系统的大规模语言模型的无限长度输入能力。新尼亚·梁(Beihang University)等。 arxiv。 [纸] [代码]

- [2023/03]反射:具有口头增强学习的语言代理。诺亚·辛恩(Noah Shinn)(东北大学)等。 arxiv。 [纸] [代码]

- [2023/05] recurrentGpt:(任意)长文本的交互式生成。 Wangchunshu Zhou(aiwaves)等。 arxiv。 [纸] [代码]

用向量或数据结构压缩记忆

- [2023/07]软件开发的交流代理。 Chen Qian(Tsinghua University)等。 arxiv。 [纸] [代码]

- [2023/06] CHATDB:以数据库作为其象征性内存增强LLMS。 Chenxu Hu(Tsinghua University)等。 arxiv。 [纸] [代码]

- [2023/05] Minecraft中的Ghost:通过具有基于文本的知识和记忆的大语言模型,开放世界环境的通常有能力的代理。 Xizhou Zhu(Tsinghua University)等。 arxiv。 [纸] [代码]

- [2023/05] ret-llm:迈向大型语言模型的一般阅读文字记忆。 Ali Modarressi(LMU Munich)等。 arxiv。 [纸] [代码]

- [2023/05] recurrentGpt:(任意)长文本的交互式生成。 Wangchunshu Zhou(aiwaves)等。 arxiv。 [纸] [代码]

内存检索

- [2023/08]内存沙盒:对话代理的透明和交互式内存管理。 Ziheng Huang(加利福尼亚大学-San Diego)等。 arxiv。 [纸]

- [2023/08]代理:用于大语言模型评估的开源沙箱。 Jiju Lin(PTA Studio)等。 arxiv。 [纸] [项目页] [代码]

- [2023/06] CHATDB:以数据库作为其象征性内存增强LLMS。 Chenxu Hu(Tsinghua University)等。 arxiv。 [纸] [代码]

- [2023/05] MemoryBank:增强具有长期记忆的大型语言模型。 Wanjun Zhong(Harbin理工学院)等。 arxiv。 [纸] [代码]

- [2023/04]生成剂:人类行为的交互式模拟。 Joon Sung Park(Stanford)等。 arxiv。 [纸] [代码]

- [2023/05] recurrentGpt:(任意)长文本的交互式生成。 Wangchunshu Zhou(aiwaves)等。 arxiv。 [纸] [代码]

1.1.4推理与计划

推理

[2024/02]培训大型语言模型通过反向课程增强学习来推理。 Zhiheng XI(Fudan University)等。 arxiv。 [纸] [代码]

[2023/09]和解:圆桌会议通过不同的LLMS之间的共识提高了推理。 Justin Chih-Yao Chen(北卡罗来纳大学教堂山分校)等。 arxiv。 [纸] [代码]

[2023/05]自我 - 自我 - 通过问题的改进来增强大语言模型的推理。 Zhiheng XI(Fudan University)等。 arxiv。 [纸] [代码]

[2023-03]大语言模型是零击的推理器。 Takeshi Kojima(东京大学)等。 arxiv。 [纸] [代码]

[2023/03]自我refine:自我反馈的迭代精致。 Aman Madaan(Carnegie Mellon University)等。 arxiv。 [纸] [代码]

[2022/05]选择 - 键入:利用大型语言模型来解释逻辑推理。 Antonia Creswell(DeepMind)等。 arxiv。 [纸]

[2022/03]自稳定性改善了语言模型中的思想推理链。 Xuezhi Wang(Google Research)等。 arxiv。 [纸] [代码]

[2023/02]语言模型中的多模式链的推理。 Zhuosheng Zhang(上海Jiao Tong University)等。 arxiv。 [纸] [代码]

[2022/01]经过思考的链条提示在大语言模型中引起推理。 Jason Wei(Google Research)等。 arxiv。 [纸]

规划

计划公式

- [2023/11] JARVIS-1:带有内存的多模式模型的开放世界多任务代理。 Zihao Wang(北京大学)等。 arxiv。 [纸] [代码]

- [2023/10]语言代理树搜索统一了语言模型中的推理和计划。安迪周(伊利诺伊大学Urbana-Champaign)等。 arxiv。 [纸] [项目页] [代码]

- [2023/05]思想树:大型语言模型的故意解决问题。 Shunyu Yao(普林斯顿大学)等。 arxiv。 [纸] [代码]

- [2023/05]计划,消除和轨道 - 语言模型是体现代理的好老师。 Yue Wu(Carnegie Mellon University)等。 arxiv。 [纸]

- [2023/05]语言模型的推理是通过世界模型计划的。 Shibo Hao(加州大学圣地亚哥加州大学)等。 arxiv。 [纸] [代码]

- [2023/05] Swiftsage:一种生成代理,对复杂的交互式任务具有快速和缓慢的思考。 Bill Yuchen Lin(艾伦人工智能研究所)等。 arxiv。 [纸] [代码]

- [2023/04] LLM+P:具有最佳计划能力的大型语言模型。 Bo Liu(德克萨斯大学奥斯汀分校)等。 arxiv。 [纸] [代码]

- [2023/03] Hugginggpt:与Chatgpt及其朋友在拥抱的脸上解决AI任务。 Yongliang Shen(Microsoft Research Asia)等。 arxiv。 [纸] [代码]

- [2023/02]描述,解释,计划和选择:与大语言模型的互动计划可实现开放世界的多任务代理。 Zihao Wang(北京大学)等。 arxiv。 [纸] [代码]

- [2022/05]最小至最高的提示可以在大型语言模型中实现复杂的推理。 Denny Zhou(Google Research)等。 arxiv。 [纸]

- [2022/05] MRKL系统:一种模块化的神经符号结构,结合了大型语言模型,外部知识源和离散推理。 Ehud Karpas(AI21 Labs)等。 arxiv。 [纸]

- [2022/04]尽我所能,而不是我所说:机器人负担中的基础语言。 Michael Ahn(Google的机器人技术)等。 arxiv。 [纸]

- [2023/05]代理:自动语言代理的开源框架。 Wangchunshu Zhou(aiwaves)等。 arxiv。 [纸] [代码]

- [2022/12]不要生成,歧视:将语言模型接地到现实世界环境的建议。 Yu Gu(俄亥俄州立大学)等。 ACL。 [纸] [代码]

计划反思

- [2024/02] Agent-Pro:通过政策级别的反思和优化Wenqi Zhang(Zhejiang University)等人学习发展。 arxiv。 [纸] [代码]

- [2024/01]自我对比:通过不一致的解决观点Wenqi Zhang(Zhejiang University)等人进行更好的反思。 arxiv。 [纸]

- [2023/11] JARVIS-1:带有内存的多模式模型的开放世界多任务代理。 Zihao Wang(北京大学)等。 arxiv。 [纸] [代码]

- [2023/10]链接验证可减少大语言模型中的幻觉。 Shehzaad Dhuliawala(Meta ai&eth Zu rich)等。 arxiv。 [纸]

- [2023/10]激烈:对语言代理进行微调。 Baian Chen(System2 Research)等。 arxiv。 [PAPER] [项目页面] [代码] [数据集]

- [2023/08]自我检查:使用LLMS零拍摄检查自己的分步推理。 Ning Miao(牛津大学)等。 arxiv。 [纸] [代码]

- [2023/05] Chatcot:基于聊天的大语言模型的工具启动推理。 Zhipeng Chen(中国人民大学)等。 arxiv。 [纸] [代码]

- [2023/05] Voyager:具有大语言模型的开放式体现代理。 Guanzhi Wang(Nvidia)等。 arxiv。 [纸] [项目页] [代码]

- [2023/03]与环境聊天:使用大语言模型的交互式多模式感知。 Xufeng Zhao(汉堡大学)等。 arxiv。 [纸] [代码]

- [2022/12] LLM-planner:具有大型语言模型的体现代理的基础计划很少。 Chan Hee Song(俄亥俄州立大学)等。 arxiv。 [纸] [代码]

- [2022/10]反应:在语言模型中协同推理和作用。 Shunyu Yao(普林斯顿大学)等。 arxiv。 [纸] [代码]

- [2022/07]内部独白:通过使用语言模型进行计划来体现推理。 Wenlong Huang(Google的机器人技术)等。 arxiv。 [纸] [代码]

- [2021/10] AI链:通过链接大语言模型提示,透明且可控的人类互动。汤肖·吴(华盛顿大学)等。 arxiv。 [纸]

1.1.5可传递性和概括性

看不见的任务概括

- [2024/06] AgentGym:在各种环境中发展基于语言模型的大型代理。 Zhiheng XI(Fudan University)等。 arxiv。 [Paper] [Project Page] [代码和平台] [数据集] [基准] [模型]。

- [2023/10]代理tuning:启用LLMS的通用代理能力。 Aohan Zeng(Tsinghua University)等。 arxiv。 [PAPER] [项目页面] [代码] [数据集]

- [2023/10] Lemur:统一语言代理的自然语言和代码Yiheng Xu(香港大学)等。 arxiv。 [纸] [代码]

- [2023/05]培训语言模型遵循人类反馈的说明。 Long Ouyang等。神经。 [纸]

- 说明:通过对人类反馈进行微调,将语言模型与用户打算对各种任务进行对齐。

- [2023/01]多任务提示训练可以使零弹药任务概括。 Victor Sanh等。 ICLR。 [纸] [代码]

- T0:T0是一种编码器模型,可消耗文本输入并产生目标响应。它是在分区中分配到不同任务的NLP数据集的多任务混合物中训练的。

- [2022/10]缩放指令 - 限制语言模型。 Hyung Won Chung等。 arxiv。 [纸] [代码]

- 这项工作探讨了指令填充,特别着眼于扩展任务数量和模型大小,从而改善了各种模型类别的性能,提示设置和评估基准。

- [2022/08]填充语言模型是零拍的学习者。 Jason Wei等。 ICLR。 [纸]

- 弗兰(Flan):指导调整大大改善了看不见的任务的零击性能。

在文化学习中

- [2023/08]图像在图像中说话:一名通才画家,用于视觉学习。 Xinlong Wang等。 IEEE。 [纸] [代码]

- 画家:这项工作为使用“图像”中心解决方案展示了用于视觉学习的通才模型。

- [2023/08]神经编解码器语言模型是语音合成器的零声文本。 Chengyi Wang等。 arxiv。 [纸] [代码]

- VALL-E:这项工作训练了神经编解码器语言模型,该模型出现在文本学习能力。

- [2023/07]一项对文化学习的调查。 Qingxiu Dong等。 arxiv。 [纸]

- [2023/05]语言模型很少。汤姆·布朗(Openai)等。神经。 [纸]

- GPT-3:扩展语言模型会大大改善任务不合时宜的,几乎没有射击的性能,有时甚至通过先前的先进的微调方法变得更有竞争力。

持续学习

- [2023/11] JARVIS-1:带有内存的多模式模型的开放世界多任务代理。 Zihao Wang(北京大学)等。 arxiv。 [纸] [代码]

- [2023/07]渐进提示:语言模型的持续学习。 Razdaibiedina等。 arxiv。 [纸]

- 这项工作引入了渐进式提示,该提示可以向前转移并抵抗灾难性的遗忘,而无需依靠数据重播或大量特定于任务的参数。

- [2023/05] Voyager:具有大语言模型的开放式体现代理。 Guanzhi Wang(Nvidia)等。 arxiv。 [纸] [项目页] [代码]

- Voyager:这是Minecraft中LLM驱动的终身学习代理人的一个例子,它不断探索世界,获得多样化的技能,并在没有人类干预的情况下进行新颖的发现。

- [2023/01]持续学习的综合调查:理论,方法和应用。 Liyuan Wang等。 arxiv。 [纸]

- 这项调查对持续学习进行了全面的调查,试图弥合基本环境,理论基础,代表性方法和实际应用。

- [2022/11]持续学习自然语言处理任务:调查。 Zixuan Ke等。 arxiv。 [纸]

- 这项调查对NLP中CL的最新进展进行了全面的综述和分析。

1.2感知:基于LLM的代理的多模式输入

1.2.1视觉

- [2024/01]代理AI:测量多模式相互作用的视野。 Zane Durante等。 arxiv。 [纸]

- [2023/10]通过多模式大语言模型朝向端到端的体现决策:具有GPT4-Vision和Liang Chen等人的探索。 arxiv。 [纸] [代码]

- [2023/05]语言并不是您所需要的:与语言模型保持一致。 Shaohan Huang等。 arxiv。 [纸]

- [2023/05]指令:迈向带有指令调整的通用视觉模型。 Wenliang Dai等。 arxiv。 [纸]

- [2023/05]多模式-GPT:与人类对话的愿景和语言模型。道彩等。 arxiv。 [纸]

- [2023/05] Pandagpt:一种模型,可以指导全部遵循它们。 Yixuan Su等。 arxiv。 [纸]

- [2023/04]视觉说明调整。 Haotian Liu等。 arxiv。 [纸]

- [2023/04] Minigpt-4:通过先进的大语言模型增强视觉语言理解。 Deyao Zhu。 arxiv。 [纸]

- [2023/01] BLIP-2:带有冷冻图像编码器和大型语言模型的引导语言图像预训练。 Junnan Li等人。 arxiv。 [纸]

- [2022/04] Flamingo:一种用于几次学习的视觉语言模型。 Jean-Baptiste Alayrac等。 arxiv。 [纸]

- [2021/10]移动设备:轻巧,通用和移动友好的视觉变压器。 Sachin Mehta等人。 [纸]

- [2021/05] MLP-MIXER:视觉的全MLP体系结构。 Ilya Tolstikhin等人。 [纸]

- [2020/10]图像值得16x16单词:用于大规模图像识别的变压器。 Alexey Dosovitskiy等。 arxiv。 [纸]

- [2017/11]神经离散表示学习。 Aaron van den Oord等。 arxiv。 [纸]

1.2.2音频

- [2023/06] Video-llama:用于视频理解的指令音调的视听语言模型。 Hang Zhang等。 arxiv。 [纸]

- [2023/05] X-LLM:通过将多模式视为外语,自举高级大语言模型。 Feilong Chen等。 arxiv。 [纸]

- [2023/05]实习生:通过与Chatgpt互动以外的语言来解决以视觉为中心的任务。 Zhaoyang Liu等。 arxiv。 [纸]

- [2023/04] Audiogpt:理解和生成语音,音乐,声音和说话的头。 Rongjie Huang等。 arxiv。 [纸]

- [2023/03] Hugginggpt:与Chatgpt及其朋友在拥抱的脸上解决AI任务。 Yongliang Shen等人。 arxiv。 [纸]

- [2021/06]休伯特:通过掩盖隐藏单元的预测,自我监督的语音表示学习。 Wei-ning Hsu等。 arxiv。 [纸]

- [2021/04] AST:音频频谱变压器。 Yuan Gong等。 arxiv。 [纸]

1.3动作:扩大基于LLM的代理的动作空间

1.3.1使用

- [2024/02]迈向不确定性意识语言代理。柔州汉(莫纳什大学)等。 arxiv。 [纸] [项目页] [代码]

- [2023/10] OpenIgents:野外语言代理的开放平台。 Xlang Lab(香港大学)Arxiv。 [纸] [项目页] [代码] [演示]

- [2023/10] Lemur:统一语言代理的自然语言和代码Yiheng Xu(香港大学)等。 arxiv。 [纸] [代码]

- [2023/10]通过多模式大语言模型朝向端到端的体现决策:与gpt4-Vision及其以外的Liang Chen(Peking University)(Peking University)等人的探索。 arxiv。 [纸] [代码]

- Holmes是一个多机构合作框架,允许LLMS利用MLLM和API收集多模式信息以进行明智的决策。

- [2023/07] TOOLLLM:促进大型语言模型掌握16000多个现实世界中的API。 Yujia Qin(Tsinghua University)等。 arxiv。 [纸] [代码] [数据集]

- Toolllm是一个一般的工具使用框架,包括数据构建,模型培训和评估。

- [2023/05]大型语言模型作为工具制造商。 Tianle Cai(普林斯顿大学)等。 arxiv。 [纸] [代码]

- LATM是一个闭环框架,它迈出了第一步,以消除对现有工具的可用性的依赖性。

- [2023/05]创建者:通过工具创建来解开大语言模型的抽象和具体推理。 Cheng Qian(Tsinghua University)等。 arxiv。 [纸]

- 创建者是一个新颖的框架,可以通过文档和代码实现来创建自己的工具。

- [2023/04]使用基础模型的工具学习。 Yujia Qin(Tsinghua University)等。 arxiv。 [纸] [代码]

- 这项调查主要介绍了一种名为“基于基础模型的工具学习”的新范式,该范式结合了专业工具和基础模型的优势,实现了提高问题,效率和自动化问题的问题。

- [2023/04] Chemcrow:使用化学工具增强大型模型。 Andres M Bran(人工化学智能实验室,ISIC,EPFL)等。 arxiv。 [纸] [代码]

- ChemCrow是LLM化学剂,它整合了13个专家设计的工具,并增强了化学和出现新功能的LLM性能。

- [2023/04] Genegpt:使用域工具增强大型语言模型,以改善访问生物医学信息。 Qiao Jin(美国国立卫生研究院),Yifan Yang,青年陈,卢。 arxiv。 [纸] [代码]

- Genegpt是回答基因组学问题的模型。它引入了一种新颖的方法,可以通过教LLM使用Web API来处理幻觉。

- [2023/04] Openagi:LLM遇到领域专家时。 Yingqiang GE(Rutgers University)等。 arxiv。 [纸] [代码]

- Openagi是一个开源AGI研究平台。它引入了LLMS的范式,运行各种专家模型,以解决复杂的任务解决方案,并提出了一种RLTF机制来提高LLM的任务解决能力。

- [2023/03] Hugginggpt:与Chatgpt及其朋友在拥抱的脸上解决AI任务。杨安格·安(Zhejiang University)等。 arxiv。 [纸] [代码]

- Hugginggpt是一个利用LLMS在机器学习社区中连接各种和多模式的AI模型来解决AI任务的系统。

- [2023/03] Visual Chatgpt:使用Visual Foundation模型进行交谈,绘画和编辑。 Chenfei Wu(Microsoft Research Asia)等。 arxiv。 [纸] [代码]

- Visual Chatgpt是一个系统,可在视觉基础模型的帮助下开辟研究Chatgpt的视觉角色。

- [2023/02]增强语言模型:调查。 GrégoireMialon(Meta AI)等。 TMLR。 [纸]

- 这项调查评论的作品,其中LMS具有使用工具的能力增强。增强LMS可以使用外部模块来扩展其上下文处理能力。

- [2023/02]工具形式:语言模型可以教会自己使用工具。 Timo Schick(Meta AI)等。 arxiv。 [纸]

- ToolFormer表明,LLM可以教会自己使用外部工具,并为每个API提供少量演示。

- [2022/05] TALM:工具增强语言模型。亚伦·巴西(Aaron Parisi)(Google)等人。 arxiv。 [纸]

- TALM介绍了一种将非差异性工具与LMS相结合的方法,从而使模型能够访问实时或私人数据。

- [2022/05] MRKL系统:一种模块化的神经符号结构,结合了大型语言模型,外部知识源和离散推理。 Ehud Karpas(AI21 Labs)等。 arxiv。 [纸]

- MRKL系统具有易于扩展的外部知识和推理模块的LLM。

- [2022/04]尽我所能,而不是我所说:机器人负担中的基础语言。 Michael Ahn(Google)等。 Corl。 [纸]

- Say Can可以通过将LLM的高级语义知识与预训练技能的价值功能相结合,从而应用LMS。

- [2021/12] Webgpt:通过人类反馈进行浏览器辅助提问。雷伊希罗·纳卡诺(Openai)等人。 arxiv。 [纸]

- WebGPT使用WebBrowsing环境回答问题。它在训练过程中使用模仿学习,然后通过人类反馈来优化答案质量。

- [2021/07]评估经过代码训练的大型语言模型。马克·陈(Openai)等。 arxiv。 [纸] [代码]

- Codex可以从DocStrings合成程序,也就是说,基于文档创建工具。

1.3.2具体动作

- [2023/12]旨在学习一个用于体现导航的通才模型。 Zheng(香港中文大学)等。 arxiv。 [纸] [代码]

- [2023/11]在3D世界中具有体现的通才代理。 Jiangyong Huang(Bigai&Peking University)等。 arxiv。 [纸] [项目页面]

- [2023/11] JARVIS-1:带有内存的多模式模型的开放世界多任务代理。 Zihao Wang(北京大学)等。 arxiv。 [纸] [代码]

- [2023/10] Lemur:统一语言代理的自然语言和代码Yiheng Xu(香港大学)等。 arxiv。 [纸] [代码]

- [2023/10]通过多模式大语言模型朝向端到端的体现决策:具有GPT4-Vision和Liang Chen等人的探索。 arxiv。 [纸] [代码]

- [2023/07]交互式语言:实时与机器人交谈。 Corey Lynch等。 IEEE(ral) [纸]

- [2023/05] Voyager:具有大语言模型的开放式体现代理。 Guanzhi Wang(Nvidia)等。 arxiv。 [纸] [项目页] [代码]

- [2023/05] Avlen:3D环境中的音频视频体现导航。 Sudipta Paul等。神经。 [纸]

- [2023/05]体现:通过体现的思想链进行视觉语言预训练。 Yao Mu等。 Arxiv [Paper] [代码]

- [2023/05] Navgpt:具有大语言模型的视觉和语言导航中的明确推理。 Gengze Zhou等。 arxiv [纸]

- [2023/05] Alphablock:在机器人操纵中进行视觉推理的体现登录。 Chuhao Jin等。 arxiv [纸]

- [2023/03] Palm-E:一种具体的多模式模型。 Danny Driess等。 arxiv。 [纸]

- [2023/03]反射:具有口头增强学习的语言代理。 Noah Shinn等。 Arxiv [Paper] [代码]

- [2023/02]与用于体现推理的语言模型合作。 Ishita Dasgupta等。 arxiv。 [纸]

- [2023/02]代码作为策略:用于体现控制的语言模型程序。 Jacky Liang等。 IEEE(ICRA)。 [纸]

- [2022/10]反应:在语言模型中协同推理和作用。 Shunyu Yao等。 Arxiv [Paper] [代码]

- [2022/10]带有多模式变压器的指令 - 凸线。 Hao Liu等。 CVPR [Paper] [代码]

- [2022/07]内部独白:通过使用语言模型进行计划来体现推理。 Wenlong Huang等。 arxiv。 [纸]

- [2022/07] LM-NAV:具有大型语言,视觉和动作模型的机器人导航。 Dhruv Shahet Al。 Corl [Paper] [代码]

- [2022/04]尽我所能,而不是我所说:机器人负担中的基础语言。 Michael Ahn等。 arxiv。 [纸]

- [2022/01]体现AI的调查:从模拟器到研究任务。 Jiafei Duan等。 IEEE(TETCI)。 [纸]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. arxiv。 [纸] [代码]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [纸]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [纸]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arxiv。 [纸] [代码]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arxiv。 [纸]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arxiv。 [纸] [代码]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arxiv。 [纸] [代码]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arxiv。 [纸]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arxiv。 [纸] [代码]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [纸] [代码]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [纸]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [纸] [代码]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [纸]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [纸]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [纸]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [纸]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [纸] [代码]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [纸] [代码]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [纸]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [纸]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [纸]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [纸]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [纸]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [纸] [代码]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [纸] [代码]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [纸] [代码]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [纸] [代码]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [纸] [代码]

2.2 Coordinating Potential of Multiple Agents

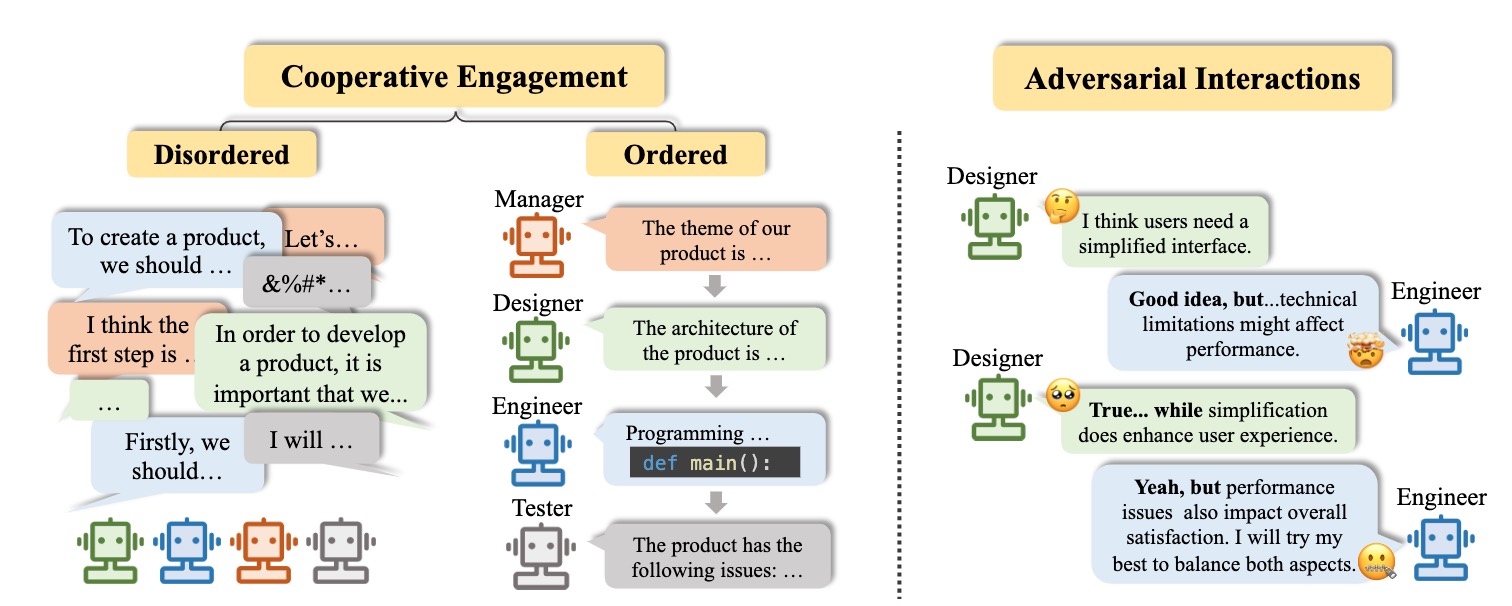

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [纸] [代码]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [纸] [代码]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [纸]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [纸]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [纸] [代码]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [纸] [代码]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [纸] [代码]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [纸]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [纸] [代码]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [纸] [代码]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [纸] [代码]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [纸] [代码]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [纸] [代码]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [纸]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [纸] [代码]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [纸] [代码]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [纸]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [纸] [代码]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [纸] [代码]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [纸]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [纸] [代码]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [纸] [代码]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [纸] [代码]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [纸]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [纸] [代码]

2.3 Interactive Engagement between Human and Agent

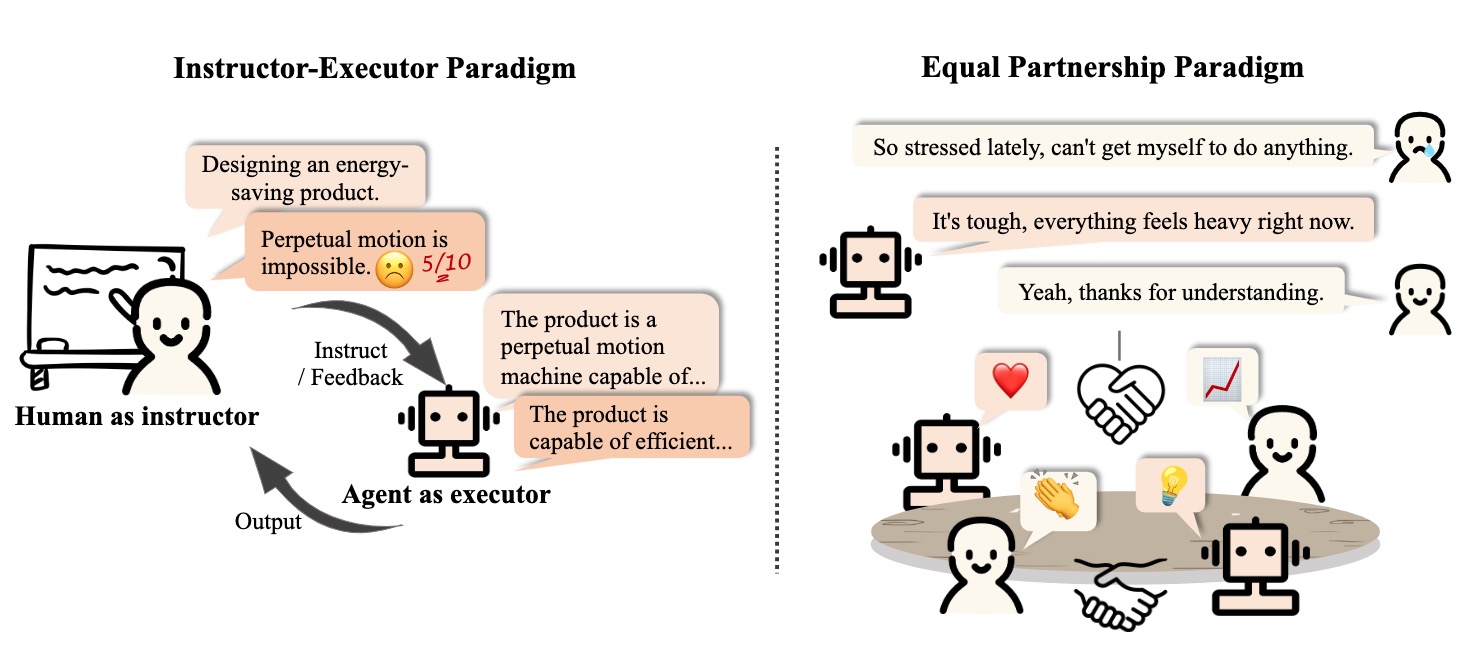

2.3.1 Instructor-Executor Paradigm

教育

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [纸]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [纸]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

健康

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [纸] [代码]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [纸]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [纸]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [纸]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE。 [纸]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [纸]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [纸]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [纸]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [纸]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [纸] [代码]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [纸] [代码]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arxiv。 [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [纸]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [纸]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [纸]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [纸]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [纸]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al.科学。 [纸]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [纸]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [纸] [代码]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [纸] [代码]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [纸]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arxiv。 [纸] [代码]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [纸] [代码]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [纸]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [纸]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [纸] [代码]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [纸] [代码]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [纸] [代码]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [纸] [代码]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arxiv。 [纸] [代码]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [纸] [代码]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [纸]

3.1.2 Personality

认识

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [纸]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [纸]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [纸]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [纸]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [纸]

情感

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [纸]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [纸]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arxiv。 [纸]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL。 [纸]

特点

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [纸] [代码]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [纸] [代码]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [纸] [代码]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [纸] [代码]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arxiv。 [纸]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [纸]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [纸] [代码]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [纸] [代码]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [纸]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [纸] [代码]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL。 [纸] [代码]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. ijcai。 [纸] [代码]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [纸] [代码]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [纸] [代码]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [纸] [代码]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arxiv。 [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [纸]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [纸] [代码]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [纸] [代码]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [纸]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arxiv。 [纸] [代码]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [纸]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [纸] [代码]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [纸] [代码]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [纸]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [纸] [代码]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arxiv。 [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [纸] [代码]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arxiv。 [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arxiv。 [纸] [代码]

引用

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

接触

星历史