Der Anstieg und das Potenzial von modellbasierten Wirkstoffen in großer Sprache: eine Umfrage

Must-Read-Papiere für LLM-basierte Agenten.

? In Kürze kommen: Fügen Sie jedem Papier Ein-Sentenz-Intro hinzu.

? Nachricht

- ☄️ [2024/06/07] Agentgym wurde für die Entwicklung und Entwicklung von LLM-basierten Agenten in verschiedenen Umgebungen veröffentlicht!

- Papier: Agentgym.

- Projektseite: https://agentgym.github.io/.

- Codes: Plattform und Implementierungen.

- Ressourcen mit Huggingface: AgentRaj-L, Agenteval, Agentevol-7b.

- ? [2024/05/02] R3 (Training großer Sprachmodelle für das Argumentieren durch Reverse -Curriculum -Verstärkungslernen) wurde von ICML 2024 akzeptiert!

- ? [2024/02/08] Neues Papier R3 auf RL für LLM -Agent -Argumentation wurde veröffentlicht! Papier: Schulung von Großsprachmodellen zum Argumentieren durch Reverse -Curriculum -Verstärkungslernen. Codes: LLM-Reverse-Courriculum-RL.

- ? [2023/09/20] Dieses Projekt wurde in GitHub -Trendwechsel aufgeführt! Es ist eine große Ehre!

- ? [2023/09/15] Unsere Umfrage wird veröffentlicht! Sehen Sie den Aufstieg und das Potenzial großer Sprachmodellbasis: Eine Umfrage für das Papier!

- [2023/09/14] Wir erstellen dieses Repository, um eine Papierliste in LLM-basierten Agenten zu verwalten. Weitere Papiere kommen bald!

? Einführung

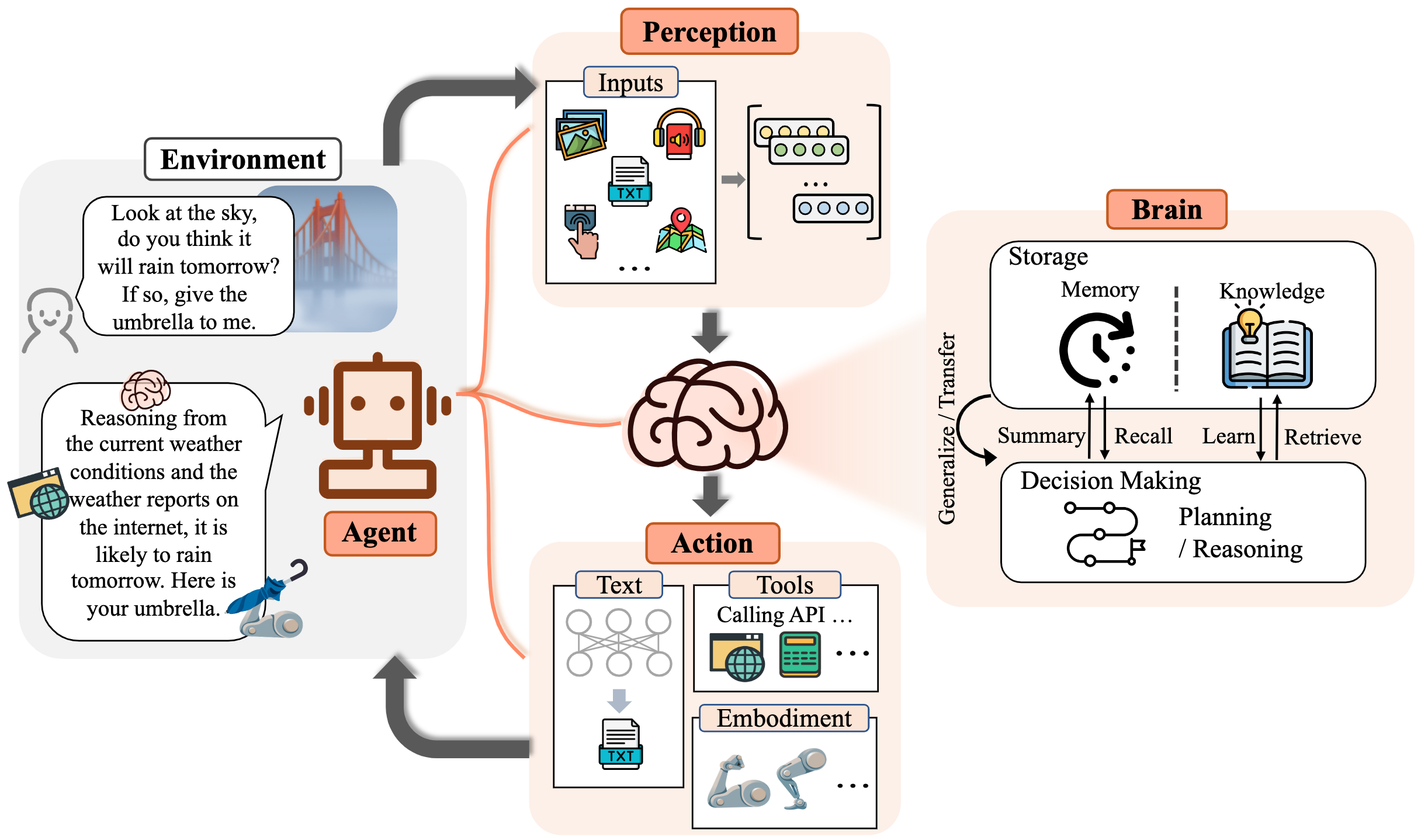

Die Menschheit verfolgt seit langer Zeit die künstliche Intelligenz (KI), die dem menschlichen Niveau äquivalent oder übertrifft, wobei AI -Agenten als vielversprechendes Fahrzeug dieser Verfolgung angesehen werden. KI -Agenten sind künstliche Einheiten, die ihre Umwelt spüren, Entscheidungen treffen und Maßnahmen ergreifen.

Aufgrund der vielseitigen und bemerkenswerten Fähigkeiten, die sie demonstrieren, gelten große Sprachmodelle (LLMs) als potenzielle Funken für künstliche allgemeine Intelligenz (AGI), die Hoffnung für den Aufbau allgemeiner KI -Agenten bieten. Viele Forschungsbemühungen haben LLMs als Grundlage für den Aufbau von KI -Agenten genutzt und erhebliche Fortschritte erzielt.

In diesem Repository bieten wir eine systematische und umfassende Umfrage zu LLM-basierten Agenten und listen einige Must-Read-Papiere auf.

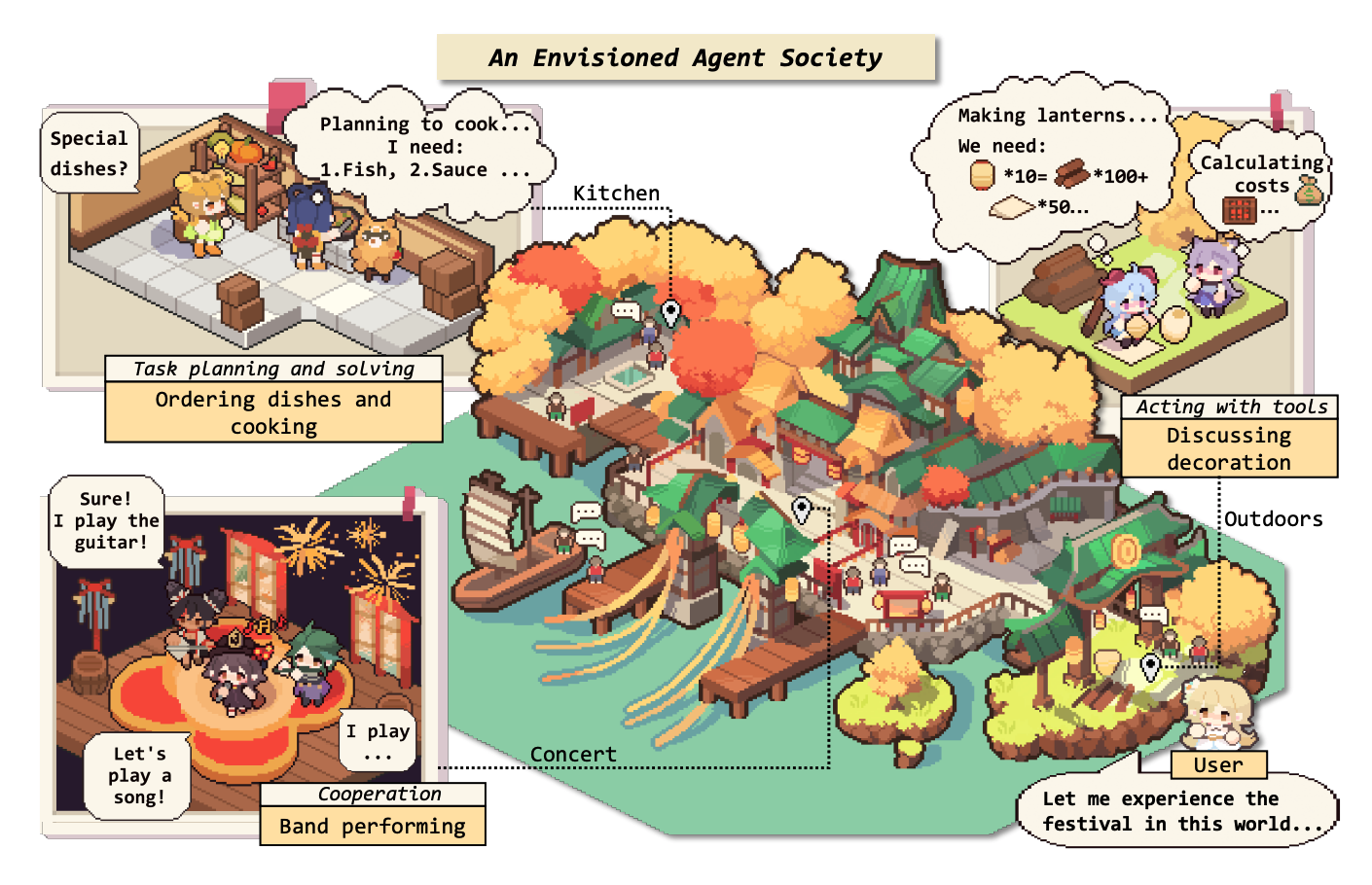

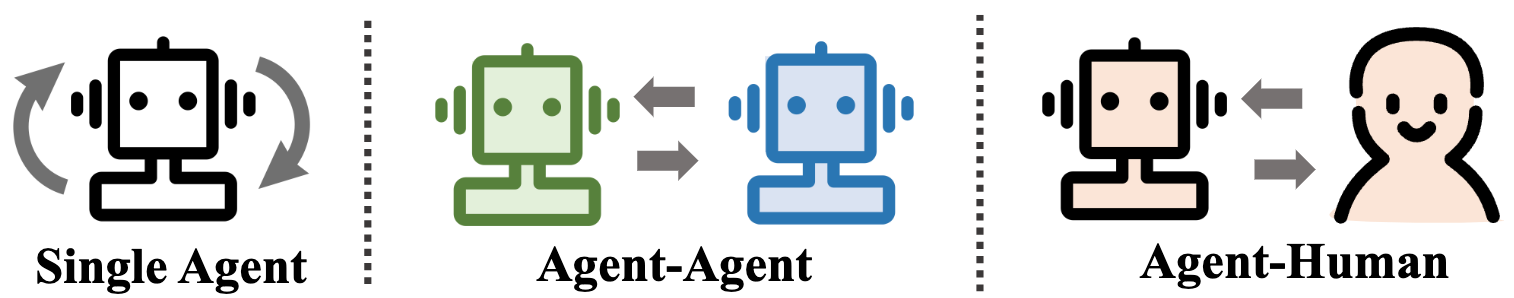

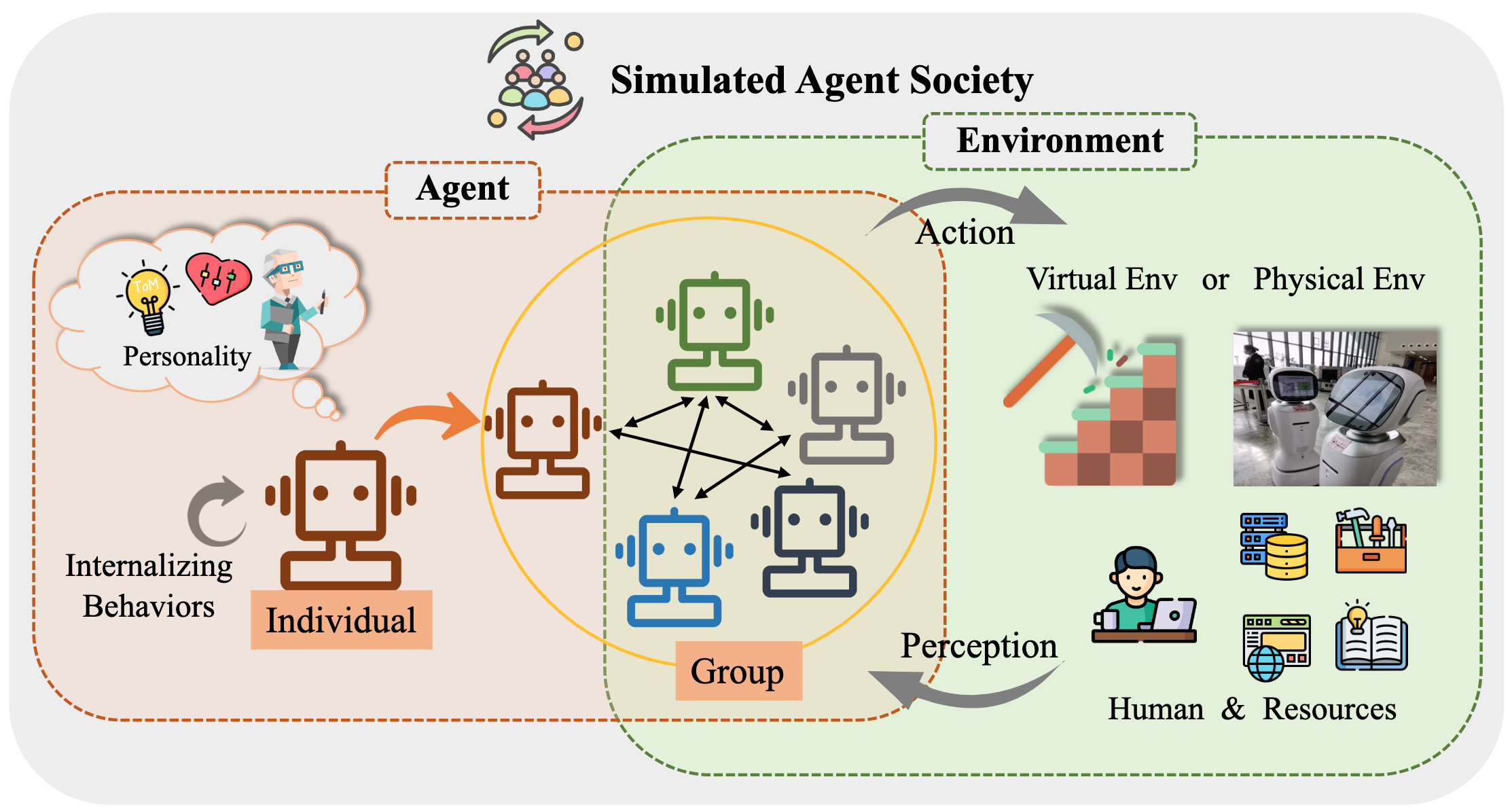

Insbesondere beginnen wir mit dem allgemeinen konzeptionellen Rahmen für LLM-basierte Agenten: Drei Hauptkomponenten: Gehirn, Wahrnehmung und Handlung und das Framework können auf verschiedene Anwendungen zugeschnitten werden. Anschließend untersuchen wir die umfangreichen Anwendungen von LLM-basierten Agenten in drei Aspekten: Single-Agent-Szenarien, Multi-Agent-Szenarien und Zusammenarbeit mit Menschenagenten. Anschließend befassen wir uns mit Agentengesellschaften und untersuchen das Verhalten und die Persönlichkeit von LLM-ansässigen Agenten, die sozialen Phänomene, die sich bei der Bildung von Gesellschaften entstehen, und die Erkenntnisse, die sie für die menschliche Gesellschaft anbieten. Schließlich diskutieren wir eine Reihe von Schlüsselthemen und offenen Problemen im Feld.

Wir schätzen alle Beiträge über PRs, Probleme, E -Mails oder andere Methoden sehr.

Tabelle des Inhalts (TOC)

- Der Anstieg und das Potenzial von modellbasierten Wirkstoffen in großer Sprache: eine Umfrage

- ? Nachricht

- ? Einführung

- Tabelle des Inhalts (TOC)

- 1. Die Geburt eines Agenten: Konstruktion von LLM-basierten Agenten

- 1.1 Gehirn: In erster Linie aus einem LLM zusammengesetzt

- 1.1.1 Interaktion mit natürlicher Sprache

- Hochwertige Generation

- Tiefes Verständnis

- 1.1.2 Wissen

- Vorbereitungsmodell

- Sprachwissen

- Commonsense -Wissen

- Umsetzbares Wissen

- Potenzielle Probleme des Wissens

- 1.1.3 Speicher

- Speicherfähigkeit

- Erhöhung der Längengrenze von Transformatoren

- Memory zusammenfassen

- Druckerinnerungen mit Vektoren oder Datenstrukturen

- Speicherabruf

- 1.1.4 Argumentation & Planung

- Argumentation

- Planung

- Planformulierung

- Planenreflexion

- 1.1.5 Übertragbarkeit und Verallgemeinerung

- Unsichtbare Aufgabenverallgemeinerung

- In-Kontext-Lernen

- Kontinuierliches Lernen

- 1.2 Wahrnehmung: Multimodale Eingaben für LLM-basierte Agenten

- 1.2.1 visuell

- 1.2.2 Audio

- 1.3 Aktion: Aktionsraum von LLM-basierten Agenten erweitern

- 1.3.1 Tool Verwenden

- 1.3.2 verkörperte Aktion

- 2. Agenten in der Praxis: Anwendungen von LLM-basierten Agenten

- 2.1 Allgemeine Fähigkeit von Einzelagenten

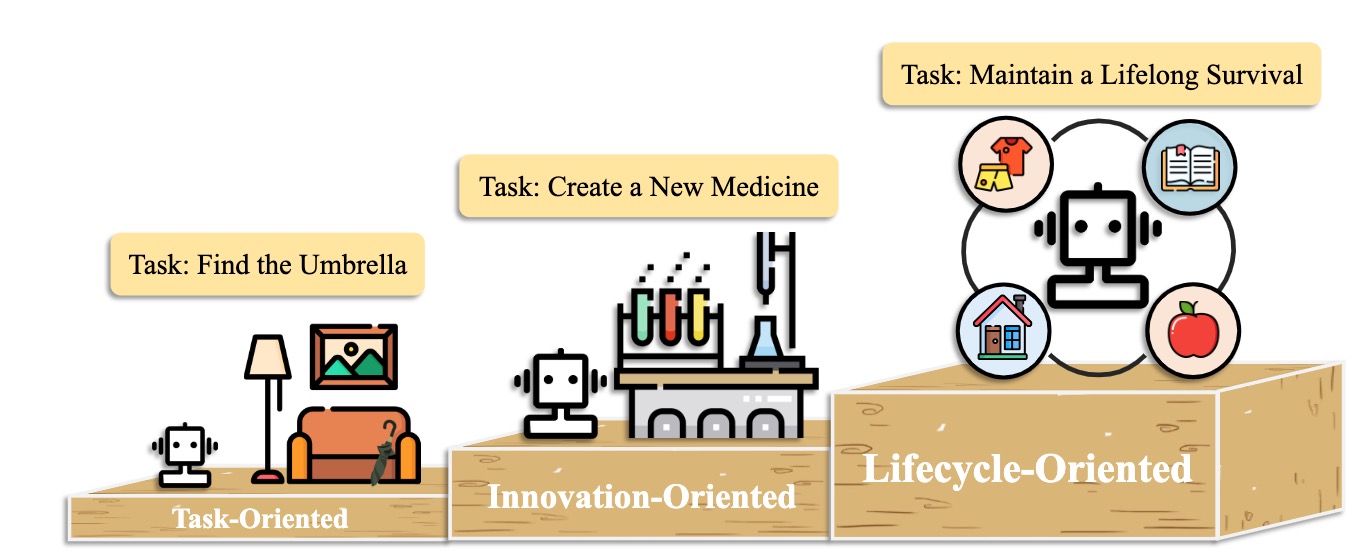

- 2.1.1 Aufgabenorientierte Bereitstellung

- 2.1.2 Innovationsorientierter Einsatz

- 2.1.3 Lebenszyklusorientierter Einsatz

- 2.2 Koordinationspotential mehrerer Agenten

- 2.2.1 Kooperative Wechselwirkung zur Komplementarität

- 2.2.2 Konversarische Interaktion für den Aufstieg

- 2.3 Interaktives Engagement zwischen Mensch und Agent

- 2.3.1 Ausbilder-Exezutor-Paradigma

- Ausbildung

- Gesundheit

- Andere Anwendung

- 2.3.2 Paradigma für gleiches Partnerschaft

- Einfühlsamer Kommunikator

- Teilnehmer auf Menschenebene

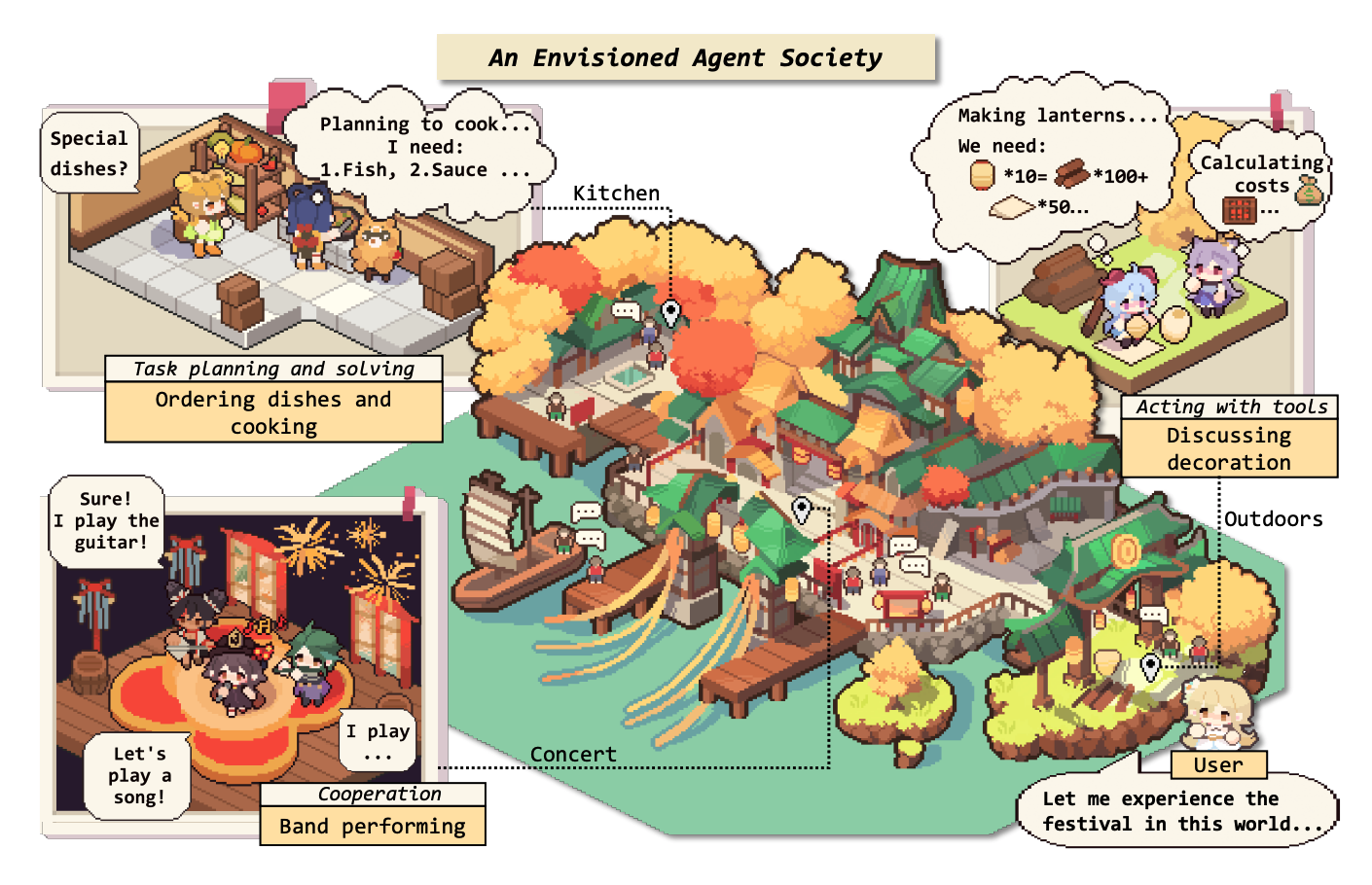

- 3. Agentengesellschaft: Von Individualität zur Sozialität

- 3.1 Verhalten und Persönlichkeit von LLM-basierten Agenten

- 3.1.1 Soziales Verhalten

- Individuelle Verhaltensweisen

- Gruppenverhalten

- 3.1.2 Persönlichkeit

- Erkenntnis

- Emotion

- Charakter

- 3.2 Umwelt für die Agent -Gesellschaft

- 3.2.1 textbasierte Umgebung

- 3.2.2 Umgebung der virtuellen Sandkasten

- 3.2.3 Physische Umgebung

- 3.3 Simulation der Gesellschaft mit LLM-basierten Agenten

- 4. Andere Themen

- 4.1 Benchmarks für LLM-Basis-Agenten

- 4.2 Training und Optimierung von LLM-basierten Agenten

- Zitat

- Projektbauer und Mitwirkende

- Kontakt

- Sterngeschichte

1. Die Geburt eines Agenten: Konstruktion von LLM-basierten Agenten

1.1 Gehirn: In erster Linie aus einem LLM zusammengesetzt

1.1.1 Interaktion mit natürlicher Sprache

Hochwertige Generation

- [2023/10] In Richtung End-to-End-verkörperter Entscheidungsfindung über multi-modales Großsprachmodell: Erkundungen mit GPT4-Vision und über Liang Chen et al. Arxiv. [Papier] [Code]

- Diese Arbeit schlägt PCA-EVAL vor, das die Entscheidungsfindung durch MLLM-basierte End-to-End-Methode und LLM-basierte Tool-U-Us-Methoden aus Wahrnehmung, Wahrnehmung und Handlungsebenen verkörperte.

- [2023/08] Eine Multitasking, mehrsprachige, multimodale Bewertung von ChatGPT über Argumentation, Halluzination und Interaktivität. Yejin Bang et al. Arxiv. [Papier]

- Diese Arbeit bewertet die Multitasking-, mehrsprachigen und multimodalen Aspekte von ChatGPT unter Verwendung von 21 Datensätzen, die 8 verschiedene gemeinsame NLP -Anwendungsaufgaben abdecken.

- [2023/06] LLM-EVAL: Einheitliche multidimensionale automatische Bewertung für Gespräche mit Open-Domänen mit großen Sprachmodellen. Yen-ting Lin et al. Arxiv. [Papier]

- Die LLM-EVAL-Methode bewertet mehrere Bewertungsdimensionen wie Inhalt, Grammatik, Relevanz und Angemessenheit.

- [2023/04] Ist Chatgpt ein hochfließendes grammatikalisches Fehlerkorrektursystem? Eine umfassende Bewertung. Tao Fang et al. Arxiv. [Papier]

- Die Ergebnisse der Bewertung zeigen, dass ChatGPT hervorragende Fehlererkennungsfunktionen aufweist und Fehler frei korrigieren kann, um die korrigierten Sätze sehr fließend zu machen. Darüber hinaus unterstreicht die Leistung in nicht englischen und ressourcenarmen Umgebungen ihr Potenzial bei mehrsprachigen GEC-Aufgaben.

Tiefes Verständnis

- [2023/06] Clevere Hans oder Neural Theory of Mind? Stressprüfung sozialer Denken in Großsprachmodellen. Natalie Shapira et al. Arxiv. [Papier]

- LLMs weisen eine bestimmte Theorie von Geistesfähigkeiten auf, aber dieses Verhalten ist weit davon entfernt, robust zu sein.

- [2022/08] Abschließung von Belohnungen aus der Sprache im Kontext. Jessy Lin et al. ACL. [Papier]

- Diese Arbeit präsentiert ein Modell, das Belohnungen aus der Sprache färbt und optimale Aktionen in unsichtbarer Umgebung vorhersagt.

- [2021/10] Theorie der mindbasierten assistiven Kommunikation in komplexer menschlicher Roboterkooperation. Moritz C. Buhler et al. Arxiv. [Papier]

- Diese Arbeit entwirft einen Agenten Sushi mit einem Verständnis des Menschen während der Interaktion.

1.1.2 Wissen

Vorbereitungsmodell

- [2023/04] Lernen verteilte Darstellungen von Sätzen aus unbeschriebenen Daten. Felix Hill (Universität von Cambridge) et al. Arxiv. [Papier]

- [2020/02] Wie viel Wissen können Sie in die Parameter eines Sprachmodells packen? Adam Roberts (Google) et al. Arxiv. [Papier]

- [2020/01] Skalierungsgesetze für Modelle für neuronale Sprache. Jared Kaplan (Johns Hopkins University) et al. Arxiv. [Papier]

- [2017/12] Commonsense -Wissen in maschineller Intelligenz. Niket Tandon (Allen Institute für künstliche Intelligenz) et al. Sigmod. [Papier]

- [2011/03] Natürliche Sprachverarbeitung (fast) von Grund auf neu. Ronan Collobert (Princeton) et al. Arxiv. [Papier]

Sprachwissen

- [2023/02] Eine Multitasking, mehrsprachige, multimodale Bewertung von ChatGPT über Argumentation, Halluzination und Interaktivität. Yejin Bang et al. Arxiv. [Papier]

- [2021/06] Untersuchung vorgebildeter Sprachmodelle für semantische Attribute und deren Werte. Meriem Beloucif et al. EMNLP. [Papier]

- [2020/10] Probe vorbereitete Sprachmodelle für lexikalische Semantik. Ivan Vulić et al. Arxiv. [Papier]

- [2019/04] Eine Struktursonde zum Auffinden von Syntax in Wortdarstellungen. John Hewitt et al. ACL. [Papier]

- [2016/04] Verbesserte automatische Keyword -Extraktion bei mehr semantischem Wissen. H Leung. Systeme für fortschrittliche Anwendungen. [Papier]

Commonsense -Wissen

- [2022/10] Sprachmodelle von Code sind nur wenige Lernende von Commonsense. Aman Madaan et al.Arxiv. [Papier]

- [2021/04] Relational World Wissensrepräsentation in kontextuellen Sprachmodellen: Eine Überprüfung. Tara Safavi et al. Arxiv. [Papier]

- [2019/11] Wie können wir wissen, was Sprachmodelle wissen? Zhengbao Jiang et al.Arxiv. [Papier]

Umsetzbares Wissen

- [2023/07] Großsprachige Modelle in der Medizin. Arun James Thirunavukarasu et al. Natur. [Papier]

- [2023/06] DS-1000: Ein natürlicher und zuverlässiger Benchmark für die Erzeugung von Data Science Code. Yuhang Lai et al. ICML. [Papier]

- [2022/10] Sprachmodelle von Code sind nur wenige Lernende von Commonsense. Aman Madaan et al. Arxiv. [Papier]

- [2022/02] Eine systematische Bewertung großer Sprachmodelle von Code. Frank F. Xu et al.Arxiv. [Papier]

- [2021/10] Trainingsprüfer zur Lösung mathematischer Wortprobleme. Karl Cobbe et al. Arxiv. [Papier]

Potenzielle Probleme des Wissens

- [2023/10] Freshllms: Erfrischende große Sprachmodelle mit Suchmaschinenvergrößerung. Tu Vu (Google) et al. ARXIV [Papier] [Code]

- [2023/05] Bearbeitung großer Sprachmodelle: Probleme, Methoden und Möglichkeiten. Yunzhi Yao et al. Arxiv. [Papier]

- [2023/05] Selbstbesprecher: Plug-and-Play-Module für die Überprüfung von Fakten mit großen Sprachmodellen. Miaoran Li et al. Arxiv. [Papier]

- [2023/05] Kritiker: Große Sprachmodelle können sich mit Werkzeuginteraktiven kritisieren. Zhibin Gou et al. Arxiv. [Papier]

- [2023/04] Werkzeuglernen mit Fundamentmodellen. Yujia Qin et al. Arxiv. [Papier]

- [2023/03] selfCeckgpt: Null-Ressource-Black-Box-Halluzinationserkennung für generative Großsprachenmodelle. Potsawee Manakul et al. Arxiv. [Papier]

- [2022/06] Speicherbasierte Modellbearbeitung im Maßstab. Eric Mitchell et al. Arxiv. [Papier]

- [2022/04] Eine Übersicht über Sprachmodelle als Wissensbasis. Badr Alkhamissi et al.Arxiv. [Papier]

- [2021/04] Sachkenntnisse in Sprachmodellen bearbeiten. Nicola de Cao et al.Arxiv. [Papier]

- [2017/08] Messung des katastrophalen Vergessens in neuronalen Netzwerken. Ronald Kemker et al.Arxiv. [Papier]

1.1.3 Speicher

Speicherfähigkeit

Erhöhung der Längengrenze von Transformatoren

- [2023/10] MEMGPT: In Richtung LLMs als Betriebssysteme. Charles Packer (UC Berkeley) et al. Arxiv. [Papier] [Projektseite] [Code] [Datensatz]

- [2023/05] Randomisierte Positionscodierungen steigern die Länge der Verallgemeinerung von Transformatoren. Anian Ruoss (DeepMind) et al. Arxiv. [Papier] [Code]

- [2023-03] Colt5: schnellere Langstreckentransformatoren mit bedingter Berechnung. Joshua Ainslie (Google Research) et al. Arxiv. [Papier]

- [2022/03] Effiziente Klassifizierung langer Dokumente unter Verwendung von Transformatoren. Hyunji Hayley Park (Illinois University) et al. Arxiv. [Papier] [Code]

- [2021/12] LONGT5: Effizienter Text-zu-Text-Transformator für lange Sequenzen. Mandy Guo (Google Research) et al. Arxiv. [Papier] [Code]

- [2019/10] BART: Denoising-Sequenz-zu-Sequence-Voraberzeugung für die Erzeugung, Übersetzung und das Verständnis der natürlichen Sprache. Michael Lewis (Facebook AI) et al. Arxiv. [Papier] [Code]

Memory zusammenfassen

- [2023/10] Das Gedächtnislabyrinth hinuntergehen: Beyond Context Limit durch interaktives Lesen Howard Chen (Princeton University) et al. Arxiv. [Papier]

- [2023/09] Ermächtigung privater Nachhilfe durch die Erkettung von großen Sprachmodellen Yulin Chen (Tsinghua University) et al. Arxiv. [Papier]

- [2023/08] Expel: LLM -Wirkstoffe sind experimentelle Lernende. Andrew Zhao (Tsinghua University) et al. Arxiv. [Papier] [Code]

- [2023/08] Chateval: Auf dem Weg zu besseren LLM-basierten Evaluatoren durch Multi-Agent-Debatte. Chi-min Chan (Tsinghua University) et al. Arxiv. [Papier] [Code]

- [2023/05] MemoryBank: Verbesserung großer Sprachmodelle mit Langzeitgedächtnis. Wanjun Zhong (Harbin Institute of Technology) et al. Arxiv. [Papier] [Code]

- [2023/04] Generative Agents: Interaktive Simulacra des menschlichen Verhaltens. Joon Sung Park (Stanford University) et al. Arxiv. [Papier] [Code]

- [2023/04] Entfeinigung der Eingabekapazität für groß angelegte Sprachmodelle mit selbstgesteuerter Speichersystem. Xinnian Liang (Beihang University) et al. Arxiv. [Papier] [Code]

- [2023/03] Reflexion: Sprachmittel mit verbalem Verstärkungslernen. Noah Shinn (Northeastern University) et al. Arxiv. [Papier] [Code]

- [2023/05] RecurrentGPT: Interaktive Erzeugung von (willkürlich) langen Text. Wangchunshu Zhou (Aiwaves) et al. Arxiv. [Papier] [Code]

Druckerinnerungen mit Vektoren oder Datenstrukturen

- [2023/07] Kommunikative für die Softwareentwicklung. Chen Qian (Tsinghua University) et al. Arxiv. [Papier] [Code]

- [2023/06] CHATDB: Augmenting LLMs mit Datenbanken als symbolischem Speicher. Chenxu Hu (Tsinghua University) et al. Arxiv. [Papier] [Code]

- [2023/05] Geister im Minecraft: Im Allgemeinen fähige Agenten für Umgebungen mit offener Welt über Großsprachenmodelle mit textbasiertem Wissen und Gedächtnis. Xizhou Zhu (Tsinghua University) et al. Arxiv. [Papier] [Code]

- [2023/05] ret-llm: Auf dem Weg zu einem allgemeinen Leseschreibergedächtnis für große Sprachmodelle. Ali modarressi (LMU München) et al. Arxiv. [Papier] [Code]

- [2023/05] RecurrentGPT: Interaktive Erzeugung von (willkürlich) langen Text. Wangchunshu Zhou (Aiwaves) et al. Arxiv. [Papier] [Code]

Speicherabruf

- [2023/08] Speicher Sandbox: transparente und interaktive Speicherverwaltung für Konversationsmittel. Ziheng Huang (Universität von Kalifornien - San Diego) et al. Arxiv. [Papier]

- [2023/08] Agenten: Ein Open-Source-Sandkasten für die Bewertung des großsprachigen Modells. Jiaju Lin (PTA Studio) et al. Arxiv. [Papier] [Projektseite] [Code]

- [2023/06] CHATDB: Augmenting LLMs mit Datenbanken als symbolischem Speicher. Chenxu Hu (Tsinghua University) et al. Arxiv. [Papier] [Code]

- [2023/05] MemoryBank: Verbesserung großer Sprachmodelle mit Langzeitgedächtnis. Wanjun Zhong (Harbin Institute of Technology) et al. Arxiv. [Papier] [Code]

- [2023/04] Generative Agents: Interaktive Simulacra des menschlichen Verhaltens. Joon Sung Park (Stanford) et al. Arxiv. [Papier] [Code]

- [2023/05] RecurrentGPT: Interaktive Erzeugung von (willkürlich) langen Text. Wangchunshu Zhou (Aiwaves) et al. Arxiv. [Papier] [Code]

1.1.4 Argumentation & Planung

Argumentation

[2024/02] Schulung von großsprachigen Modellen für das Argumentieren durch das Lernen des umgekehrten Lehrplans. Zhiheng XI (Fudan University) et al. Arxiv. [Papier] [Code]

[2023/09] Versöhnung: Die Rund-Tisch-Konferenz verbessert den Argument durch den Konsens zwischen verschiedenen LLMs. Justin Chih-yao Chen (Universität von North Carolina in Chapel Hill) et al. Arxiv. [Papier] [Code]

[2023/05] Selbstpolischer: Verbesserung der Argumentation in Großsprachenmodellen durch Problemraffinierung. Zhiheng XI (Fudan University) et al. Arxiv. [Papier] [Code]

[2023-03] Große Sprachmodelle sind Null-Shot-Vernunft. Takeshi Kojima (Universität von Tokio) et al. Arxiv. [Papier] [Code]

[2023/03] Selbstrefine: iterative Verfeinerung mit Selbstversorgungsback. Aman Madaan (Carnegie Mellon University) et al. Arxiv. [Papier] [Code]

[2022/05] Selection-Inferenz: Ausnutzung großer Sprachmodelle für interpretierbare logische Argumentation. Antonia Creswell (DeepMind) et al. Arxiv. [Papier]

[2022/03] Selbstkonsistenz verbessert die Kette des Denkens in Sprachmodellen. Xuezhi Wang (Google Research) et al. Arxiv. [Papier] [Code]

[2023/02] Multimodale Kette des Gedankens in Sprachmodellen. Zhuoscheng Zhang (Shanghai Jiao Tong University) et al. Arxiv. [Papier] [Code]

[2022/01] Kette der Gedanken, die Anlauferdienste in großem Sprachmodellen ausgelöst. Jason Wei (Google Research) et al. Arxiv. [Papier]

Planung

Planformulierung

- [2023/11] Jarvis-1: Open-World Multi-Task-Agenten mit maßstabsgeräten multimodalen Sprachmodellen. Zihao Wang (Peking University) et al. Arxiv. [Papier] [Code]

- [2023/10] Sprachagent -Baumsuche vereint das Argumentation und Planung in Sprachmodellen. Andy Zhou (Universität von Illinois Urbana-Champaign) et al. Arxiv. [Papier] [Projektseite] [Code]

- [2023/05] Baumbaum: Absichtliche Problemlösung mit großen Sprachmodellen. Shunyu Yao (Princeton University) et al. Arxiv. [Papier] [Code]

- [2023/05] Planen, eliminieren und verfolgen - Sprachmodelle sind gute Lehrer für verkörperte Wirkstoffe. Yue Wu (Carnegie Mellon University) et al. Arxiv. [Papier]

- [2023/05] Die Argumentation mit Sprachmodell plant mit dem Weltmodell. Shibo Hao (UC San Diego) et al. Arxiv. [Papier] [Code]

- [2023/05] SwiftSage: Ein generatives Agent mit schnellem und langsamem Denken für komplexe interaktive Aufgaben. Bill Yuchen Lin (Allen Institute für künstliche Intelligenz) et al. Arxiv. [Papier] [Code]

- [2023/04] LLM+P: Ermächtigung großer Sprachmodelle mit optimalen Planungskenntnissen. Bo Liu (Universität von Texas in Austin) et al. Arxiv. [Papier] [Code]

- [2023/03] Hugginggpt: Lösen von KI -Aufgaben mit Chatgpt und seinen Freunden im Umarmungsgesicht. Yongliang Shen (Microsoft Research Asia) et al. Arxiv. [Papier] [Code]

- [2023/02] Beschreiben, Erklären, Planen und Auswählen: Interaktive Planung mit großsprachigen Modellen ermöglicht Open-World Multi-Task-Agenten. Zihao Wang (Peking University) et al. Arxiv. [Papier] [Code]

- [2022/05] Ermöglicht die Einführung von am wenigsten zu einem komplexen Denken in Großsprachenmodellen. Denny Zhou (Google Research) et al. Arxiv. [Papier]

- [2022/05] MRKL-Systeme: Eine modulare, neurosymbolische Architektur, die große Sprachmodelle, externe Wissensquellen und diskretes Denken kombiniert. Ehud Karpas (AI21 Labs) et al. Arxiv. [Papier]

- [2022/04] Tun ich das, was ich kann, nicht wie ich sage: Erdungssprache in Roboterverdienern. Michael Ahn (Robotik bei Google) et al. Arxiv. [Papier]

- [2023/05] Agenten: Ein Open-Source-Rahmen für autonome Sprachagenten. Wangchunshu Zhou (Aiwaves) et al. Arxiv. [Papier] [Code]

- [2022/12] Erzeugen Sie nicht, diskriminieren Sie: Ein Vorschlag für die Erdungssprachmodelle in reale Umgebungen. Yu Gu (die Ohio State University) et al. ACL. [Papier] [Code]

Planenreflexion

- [2024/02] Agent-Pro: Das Lernen, sich durch Reflexion und Optimierung auf Politikebene zu entwickeln, Wenqi Zhang (Zhejiang University) et al. Arxiv. [Papier] [Code]

- [2024/01] Selbstkontrast: Bessere Reflexion durch inkonsistente Lösung von Perspektiven Wenqi Zhang (Zhejiang University) et al. Arxiv. [Papier]

- [2023/11] Jarvis-1: Open-World Multi-Task-Agenten mit maßstabsgeräten multimodalen Sprachmodellen. Zihao Wang (Peking University) et al. Arxiv. [Papier] [Code]

- [2023/10] Die Kette der Verschreibung reduziert die Halluzination in Großsprachenmodellen. Shehzaad Dhuliawala (Meta AI & Eth Zu ̈rich) et al. Arxiv. [Papier]

- [2023/10] Schienen: Auf dem Weg zu Sprachagenten Feinabstimmung. Baian Chen (System2 Research) et al. Arxiv. [Papier] [Projektseite] [Code] [Datensatz]

- [2023/08] SelfCheck: Verwenden von LLMs bis Zero-Shot, die ihre eigene schrittweise Argumentation überprüfen. Ning Miao (Universität Oxford) et al. Arxiv. [Papier] [Code]

- [2023/05] CHATCOT: Tool-ausgelöste Kette der Gedanken auf Chat-basierte große Sprachmodelle. Zhipeng Chen (Renmin University of China) et al. Arxiv. [Papier] [Code]

- [2023/05] Voyager: Ein offenes verkörpertes Wirkstoff mit großen Sprachmodellen. Guanzhi Wang (Nvidia) et al. Arxiv. [Papier] [Projektseite] [Code]

- [2023/03] Chat mit der Umgebung: Interaktive multimodale Wahrnehmung mit großer Sprachmodellen. Xufeng Zhao (Universität Hamburg) et al. Arxiv. [Papier] [Code]

- [2022/12] LLM-Planner: Wenige schienen geerdete Planung für verkörperte Wirkstoffe mit großartigen Modellen. Chan Hee Song (die Ohio State University) et al. Arxiv. [Papier] [Code]

- [2022/10] Reaktieren: Synergisierung von Argumentation und Handeln in Sprachmodellen. Shunyu Yao (Princeton University) et al. Arxiv. [Papier] [Code]

- [2022/07] innerer Monolog: Verkörperte Argumentation durch Planung mit Sprachmodellen. Wenlong Huang (Robotik bei Google) et al. Arxiv. [Papier] [Code]

- [2021/10] AI-Ketten: transparente und kontrollierbare Human-AI-Interaktion durch Erkettung von großsprachigen Modellaufforderungen. Tongshuang Wu (Universität Washington) et al. Arxiv. [Papier]

1.1.5 Übertragbarkeit und Verallgemeinerung

Unsichtbare Aufgabenverallgemeinerung

- [2024/06] Agentgymus: Entwicklung von modellbasierten Wirkstoffen in großer Sprache in verschiedenen Umgebungen. Zhiheng XI (Fudan University) et al. Arxiv. [Papier] [Projektseite] [Codes und Plattform] [Datensatz] [Benchmark] [Modell].

- [2023/10] AgentTuning: Aktivieren verallgemeinerter Agentenfähigkeiten für LLMs. Aohan Zeng (Tsinghua University) et al. Arxiv. [Papier] [Projektseite] [Code] [Datensatz]

- [2023/10] Lemur: Harmonisierung der natürlichen Sprache und Code für Sprachagenten Yiheng Xu (Universität von Hongkong) et al. Arxiv. [Papier] [Code]

- [2023/05] Trainingssprachmodelle, um Anweisungen mit menschlichem Feedback zu befolgen. Langes Ouyang et al. Neurips. [Papier]

- InstructGPT: Ausrichtung von Sprachmodellen auf eine Vielzahl von Aufgaben durch Feinabstimmung mit menschlichem Feedback.

- [2023/01] Multitaskante zum Training ermöglicht die Verallgemeinerung von Aufgaben in der Null-Shot. Victor Sanh et al. ICLR. [Papier] [Code]

- T0: T0 ist ein Encoder-Decoder-Modell, das Texteingaben verbraucht und Zielantworten erzeugt. Es wird auf einer Multitask -Mischung aus NLP -Datensätzen trainiert, die in unterschiedliche Aufgaben aufgeteilt sind.

- [2022/10] Skalierung von Sprachmodellen mit Anweisungen. Hyung gewann Chung et al. Arxiv. [Papier] [Code]

- In dieser Arbeit werden die Anweisungsfinetuning untersucht, wobei ein besonderer Schwerpunkt auf der Skalierung der Anzahl der Aufgaben und der Modellgröße liegt, wodurch die Leistung an verschiedenen Modellklassen, die Aufrechterhaltung von Setups und Bewertungsbenchmarks verbessert wird.

- [2022/08] Finetuned-Sprachmodelle sind Null-Shot-Lernende. Jason Wei et al. ICLR. [Papier]

- FLAN: Die Unterrichtsstimmung verbessert die Leistung der Nullschüsse bei unsichtbaren Aufgaben.

In-Kontext-Lernen

- [2023/08] Bilder sprechen in Bildern: ein Generalist Maler für das visuelle Lernen in Kontext. Xinlong Wang et al. IEEE. [Papier] [Code]

- Maler: Diese Arbeit präsentiert ein Generalist-Modell für das visuelle Lernen in Kontext mit einer "Bild" -zentrischen Lösung.

- [2023/08] Neuronale Codec-Sprachmodelle sind Null-Shot-Text für Sprachsynthesizer. Chengyi Wang et al. Arxiv. [Papier] [Code]

- VALL-E: Diese Arbeit bildet ein neuronales Codec-Sprachmodell aus, das in Kontextlernfunktionen entsteht.

- [2023/07] Eine Umfrage zum Kontextlernen. Qingxiu Dong et al. Arxiv. [Papier]

- Diese Umfrage fasst die Fortschritte und Herausforderungen des In-Context-Lernens (ICL) zusammen.

- [2023/05] Sprachmodelle sind nur wenige Lernende. Tom B. Brown (Openai) et al. Neurips. [Papier]

- GPT-3: Die Skalierung von Sprachmodellen verbessert erheblich die Aufgaben-Agnostic-Leistung, nur wenige Auftritte und werden manchmal sogar mit früheren hochkarätigen Feinabstimmungsansätzen wettbewerbsfähig.

Kontinuierliches Lernen

- [2023/11] Jarvis-1: Open-World Multi-Task-Agenten mit maßstabsgeräten multimodalen Sprachmodellen. Zihao Wang (Peking University) et al. Arxiv. [Papier] [Code]

- [2023/07] Progressive Eingabeaufforderungen: Kontinuierliches Lernen für Sprachmodelle. Razdaibiedina et al. Arxiv. [Papier]

- In dieser Arbeit werden progressive Eingabeaufforderungen eingeführt, die die Vorwärtsübertragung ermöglichen und das katastrophale Vergessen widerstehen, ohne sich auf die Datenreplay oder eine große Anzahl von aufgabenspezifischen Parametern zu verlassen.

- [2023/05] Voyager: Ein offenes verkörpertes Wirkstoff mit großen Sprachmodellen. Guanzhi Wang (Nvidia) et al. Arxiv. [Papier] [Projektseite] [Code]

- Voyager: Dies ist ein Beispiel für LLM-Anbieter-verkörperte lebenslange Lernagentin in Minecraft, die die Welt kontinuierlich erforscht, verschiedene Fähigkeiten erwirbt und neue Entdeckungen ohne menschliche Intervention macht.

- [2023/01] Eine umfassende Übersicht über das kontinuierliche Lernen: Theorie, Methode und Anwendung. Liyuan Wang et al. Arxiv. [Papier]

- Diese Umfrage stellt eine umfassende Übersicht über kontinuierliches Lernen vor, um die grundlegenden Einstellungen, theoretischen Grundlagen, repräsentativen Methoden und praktischen Anwendungen zu schließen.

- [2022/11] Kontinuierliches Lernen von Aufgaben der natürlichen Sprachverarbeitung: Eine Umfrage. Zixuan Ke et al. Arxiv. [Papier]

- Diese Umfrage enthält eine umfassende Überprüfung und Analyse des jüngsten Fortschritts von CL in NLP.

1.2 Wahrnehmung: Multimodale Eingaben für LLM-basierte Agenten

1.2.1 visuell

- [2024/01] Agent AI: Vermessung des Horizons der multimodalen Interaktion. Zane Durante et al. Arxiv. [Papier]

- [2023/10] In Richtung End-to-End-verkörperter Entscheidungsfindung über multi-modales Großsprachmodell: Erkundungen mit GPT4-Vision und über Liang Chen et al. Arxiv. [Papier] [Code]

- [2023/05] Sprache ist nicht alles, was Sie brauchen: Wahrnehmung mit Sprachmodellen. Shaohan Huang et al. Arxiv. [Papier]

- [2023/05] InstructBlip: Auf dem Weg zu allgemeinen Visionsprachenmodellen mit Anweisungsstimmung. Wenliang Dai et al. Arxiv. [Papier]

- [2023/05] Multimodal-GPT: Ein Vision- und Sprachmodell für den Dialog mit Menschen. Tao Gong et al. Arxiv. [Papier]

- [2023/05] Pandagpt: Ein Modell, um sie alle zu befolgen. Yixuan Su et al. Arxiv. [Papier]

- [2023/04] Visuelle Anweisungsstimmung. Haotian Liu et al. Arxiv. [Papier]

- [2023/04] MiniGPT-4: Verbesserung des Verständnisses der Visionsprachen mit fortgeschrittenen Großsprachmodellen. Deyao Zhu. Arxiv. [Papier]

- [2023/01] BLIP-2: Bootstrapping-Sprach-Image-Vor-Training mit gefrorenen Bildcodierern und großen Sprachmodellen. Junnan Li et al. Arxiv. [Papier]

- [2022/04] Flamingo: Ein visuelles Sprachmodell für wenige Lernen. Jean-Baptiste Alayrac et al. Arxiv. [Papier]

- [2021/10] Mobilevit: Leichtes, allgemeines und mobilfreundliches Vision-Transformator. Sachin Mehta et al.Arxiv. [Papier]

- [2021/05] MLP-MIXER: Eine All-MLP-Architektur für Vision. Ilya Tolstikhin et al.Arxiv. [Papier]

- [2020/10] Ein Bild ist 16x16 Wörter wert: Transformatoren für die Bilderkennung im Maßstab. Alexey Dosovitskiy et al. Arxiv. [Papier]

- [2017/11] Lernen für neuronale diskrete Repräsentation. Aaron van Den Oord et al. Arxiv. [Papier]

1.2.2 Audio

- [2023/06] VIDEO-LLAMA: Ein mit Anweisungen abgestimmter audiovisueller Sprachmodell für Videoverständnis. Hang Zhang et al. Arxiv. [Papier]

- [2023/05] X-LlM: Bootstrapping Advanced Großsprachmodelle durch Behandlung von Multimodalitäten als Fremdsprachen. Feilong Chen et al. Arxiv. [Papier]

- [2023/05] Interngpt: Sehensorientierte Aufgaben durch Interaktion mit Chatgpt jenseits der Sprache. Zhaoyang Liu et al. Arxiv. [Papier]

- [2023/04] Audiogpt: Verstehen und Generieren von Sprache, Musik, Klang und sprechendem Kopf. Rongjie Huang et al. Arxiv. [Papier]

- [2023/03] Hugginggpt: Lösen von KI -Aufgaben mit Chatgpt und seinen Freunden im Umarmungsgesicht. Yongliang Shen et al. Arxiv. [Papier]

- [2021/06] Hubert: Lernen von selbstbewertetem Sprachrepräsentation durch maskierte Vorhersage versteckter Einheiten. WeiiNning Hsu et al. Arxiv. [Papier]

- [2021/04] AST: Audiospektrogramm -Transformator. Yuan Gong et al. Arxiv. [Papier]

1.3 Aktion: Aktionsraum von LLM-basierten Agenten erweitern

1.3.1 Tool Verwenden

- [2024/02] Auf dem Weg zu Unsicherheit, der einen Vertreter der Unsicherheit hat. Jiuzhou Han (Monash University) et al. Arxiv. [Papier] [Projektseite] [Code]

- [2023/10] OpenAgents: Eine offene Plattform für Sprachagenten in freier Wildbahn. Xlang Lab (Universität von Hongkong) Arxiv. [Papier] [Projektseite] [Code] [Demo]

- [2023/10] Lemur: Harmonisierung der natürlichen Sprache und Code für Sprachagenten Yiheng Xu (Universität von Hongkong) et al. Arxiv. [Papier] [Code]

- [2023/10] In Richtung End-to-End-verkörperter Entscheidungsfindung über multi-modales Großsprachmodell: Erkundungen mit GPT4-Vision und darüber hinaus über Liang Chen (Peking University) et al. Arxiv. [Papier] [Code]

- Holmes ist ein Multi-Agent-Kooperations-Framework, mit dem LLMs MLLMS und APIs nutzen können, multimodale Informationen für fundierte Entscheidungen zu sammeln.

- [2023/07] Toolllm: Erleichterung großer Sprachmodelle, um 16000+ reale APIs zu beherrschen. Yujia Qin (Tsinghua University) et al. Arxiv. [Papier] [Code] [Datensatz]

- TOLLLM ist ein allgemeines Tool-Use-Framework, das Datenkonstruktion, Modelltraining und -bewertung umfasst.

- [2023/05] Großsprachige Modelle als Werkzeughersteller. Tianle Cai (Princeton University) et al. Arxiv. [Papier] [Code]

- LATM ist ein Framework mit geschlossenem Kreislauf, das einen ersten Schritt zur Beseitigung der Abhängigkeit von der Verfügbarkeit vorhandener Tools unternimmt.

- [2023/05] Schöpfer: Entfernt abstrakte und konkrete Argumentation von großsprachigen Modellen durch Werkzeugerstellung. Cheng Qian (Tsinghua University) et al. Arxiv. [Papier]

- Creator ist ein neuartiger Framework, der LLMs ermöglicht, ihre eigenen Tools durch Dokumentation und Code zu erstellen.

- [2023/04] Werkzeuglernen mit Fundamentmodellen. Yujia Qin (Tsinghua University) et al. Arxiv. [Papier] [Code]

- In dieser Umfrage wird in erster Linie ein neues Paradigma namens "Tool-Lernen basierend auf Grundmodellen" vorgestellt, das die Vorteile von speziellen Tools und Grundmodellen kombiniert und eine höhere Präzision, Effizienz und Automatisierung bei der Problemlösung erzielt.

- [2023/04] CHEMCROW: Erweiterung von Modellen mit großer Sprache mit Chemiewerkzeugen. Andres M Bran (Labor für künstliche chemische Intelligenz, ISIC, EPFL) et al. Arxiv. [Papier] [Code]

- Chemcrow ist ein LLM-Chemie-Mittel, das 13 Experten entworfene Werkzeuge integriert und die LLM-Leistung in Chemie und neue Funktionen ergibt.

- [2023/04] Genegpt: Erweiterung großer Sprachmodelle mit Domänenwerkzeugen für einen verbesserten Zugang zu biomedizinischen Informationen. Qiao Jin (National Institutes of Health), Yifan Yang, Qingyu Chen, Zhiyong Lu. Arxiv. [Papier] [Code]

- Genegpt ist ein Modell, das die Genomikfragen beantwortet. Es führt eine neuartige Methode zum Umgang mit Herausforderungen mit Halluzinationen durch, indem Sie LLMs für die Verwendung der Web -APIs unterrichten.

- [2023/04] OpenAgi: Wenn LLM Domain -Experten trifft. Yingqiang GE (Rutgers University) et al. Arxiv. [Papier] [Code]

- OpenAgi ist eine Open-Source-AGI-Forschungsplattform. Es führt ein Paradigma von LLMs ein, das verschiedene Expertenmodelle für komplexe Aufgabenlösung betreibt, und schlägt einen RLTF-Mechanismus vor, um die Fähigkeit zur Aufgabenlösung der LLM zu verbessern.

- [2023/03] Hugginggpt: Lösen von KI -Aufgaben mit Chatgpt und seinen Freunden im Umarmungsgesicht. Yongliang Shen (Zhejiang University) et al. Arxiv. [Papier] [Code]

- HuggingGpt ist ein System, das LLMs nutzt, um verschiedene und multimodale KI -Modelle in maschinellen Lerngemeinschaften zu verbinden, um KI -Aufgaben zu lösen.

- [2023/03] Visual Chatgpt: Reden, Zeichnen und Bearbeiten mit visuellen Grundlagenmodellen. Chenfei Wu (Microsoft Research Asia) et al. Arxiv. [Papier] [Code]

- Visual Chatgpt ist ein System, das die Tür für die Untersuchung der visuellen Rollen von ChatGPT mit Hilfe von Modellen der visuellen Grundierung öffnet.

- [2023/02] Erweiterte Sprachmodelle: Eine Umfrage. Grégoire Mialon (Meta Ai) et al. Tmlr. [Papier]

- Diese Umfrage bewertet Werke, in denen LMS durch die Verwendung von Tools verstärkt werden. Augmented LMS kann externe Module verwenden, um ihre Kontextverarbeitungsfähigkeit zu erweitern.

- [2023/02] Toolformer: Sprachmodelle können sich selbst beibringen, Tools zu verwenden. Timo Schick (Meta Ai) et al. Arxiv. [Papier]

- Toolformer zeigt, dass LLMs sich selbst beibringen können, externe Tools mit einer Handvoll Demonstrationen für jede API zu verwenden.

- [2022/05] TALM: Tool erweiterte Sprachmodelle. Aaron Parisi (Google) et al. Arxiv. [Papier]

- Talm führt eine Methode ein, die nicht differenzierbare Tools mit LMS kombiniert, sodass das Modell auf Echtzeit- oder private Daten zugreifen kann.

- [2022/05] MRKL-Systeme: Eine modulare, neurosymbolische Architektur, die große Sprachmodelle, externe Wissensquellen und diskretes Denken kombiniert. Ehud Karpas (AI21 Labs) et al. Arxiv. [Papier]

- MRKL Systems erweitert LLMs mit einem leicht erweiterbaren Satz externer Wissens- und Argumentationsmodule.

- [2022/04] Tun ich das, was ich kann, nicht wie ich sage: Erdungssprache in Roboterverdienern. Michael Ahn (Google) et al. Corl. [Papier]

- Saycan wendet LMS in realen Roboteraufgaben an, indem sie erweitertes semantisches Wissen aus LLMs mit der Wertfunktion vorgebliebener Fähigkeiten kombiniert.

- [2021/12] WebGPT: Browser-unterstützte Frage-Answer mit menschlichem Feedback. Reiichiro Nakano (Openai) et al. Arxiv. [Papier]

- WebGPT beantworten Fragen mithilfe einer Webbrowsing -Umgebung. Es verwendet Nachahmungslernen während des Trainings und optimiert dann die Antwortqualität durch menschliches Feedback.

- [2021/07] Bewertung großer Sprachmodelle, die auf Code geschult sind. Mark Chen (Openai) et al. Arxiv. [Papier] [Code]

- Codex kann Programme aus Docstrings synthetisieren, dh Erstellen von Tools basierend auf Dokumentation.

1.3.2 verkörperte Aktion

- [2023/12] Um ein Generalistenmodell für eine verkörperte Navigation zu lernen. Duo Zheng (die chinesische Universität von Hongkong) et al. Arxiv. [Papier] [Code]

- [2023/11] Ein verkörperter Generalist in der 3D -Welt. Jiangyong Huang (Bigai & Peking University) et al. Arxiv. [Papier] [Projektseite]

- [2023/11] Jarvis-1: Open-World Multi-Task-Agenten mit maßstabsgeräten multimodalen Sprachmodellen. Zihao Wang (Peking University) et al. Arxiv. [Papier] [Code]

- [2023/10] Lemur: Harmonisierung der natürlichen Sprache und Code für Sprachagenten Yiheng Xu (Universität von Hongkong) et al. Arxiv. [Papier] [Code]

- [2023/10] In Richtung End-to-End-verkörperter Entscheidungsfindung über multi-modales Großsprachmodell: Erkundungen mit GPT4-Vision und über Liang Chen et al. Arxiv. [Papier] [Code]

- [2023/07] Interaktive Sprache: In Echtzeit mit Robotern sprechen. Corey Lynch et al. IEEE (RAL) [Papier]

- [2023/05] Voyager: Ein offenes verkörpertes Wirkstoff mit großen Sprachmodellen. Guanzhi Wang (Nvidia) et al. Arxiv. [Papier] [Projektseite] [Code]

- [2023/05] AVLEN: Audio-visual-sprachliche Navigation in 3D-Umgebungen. Sudipta Paul et al. Neurips. [Papier]

- [2023/05] verkörpert: Visionsprachen vor der Ausbildung über eine verkörperte Denkkette. Yao Mu et al. ARXIV [Papier] [Code]

- [2023/05] NAVGPT: Explizite Argumentation in der Vision- und Sprachnavigation mit großen Sprachmodellen. Gengze Zhou et al. Arxiv [Papier]

- [2023/05] Alphablock: verkörperte Finetuning für die Sehvermögensbekämpfung in der Manipulation von Roboter. Chuhao Jin et al. Arxiv [Papier]

- [2023/03] Palm-E: Ein verkörpertes multimodales Sprachmodell. Danny Driess et al. Arxiv. [Papier]

- [2023/03] Reflexion: Sprachmittel mit verbalem Verstärkungslernen. Noah Shinn et al. Arxiv [paper] [code]

- [2023/02] Collaborating with language models for embodied reasoning. Ishita Dasgupta et al. Arxiv. [Papier]

- [2023/02] Code as Policies: Language Model Programs for Embodied Control. Jacky Liang et al. IEEE (ICRA). [Papier]

- [2022/10] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao et al. Arxiv [paper] [code]

- [2022/10] Instruction-Following Agents with Multimodal Transformer. Hao Liu et al. CVPR [paper] [code]

- [2022/07] Inner Monologue: Embodied Reasoning through Planning with Language Models. Wenlong Huang et al. Arxiv. [Papier]

- [2022/07] LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action. Dhruv Shahet al. CoRL [paper] [code]

- [2022/04] Do As I Can, Not As I Say: Grounding Language in Robotic Affordances. Michael Ahn et al. Arxiv. [Papier]

- [2022/01] A Survey of Embodied AI: From Simulators to Research Tasks. Jiafei Duan et al. IEEE (TETCI). [Papier]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [Papier] [Code]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [Papier]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [Papier]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arXiv. [Papier] [Code]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arXiv. [Papier]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [Papier] [Code]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arXiv. [Papier] [Code]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [Papier]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [Papier] [Code]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [Papier] [Code]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [Papier]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [Papier] [Code]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [Papier]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [Papier]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [Papier]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [Papier]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [Papier] [Code]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [Papier] [Code]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [Papier]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [Papier]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [Papier]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [Papier]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [Papier]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [Papier] [Code]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [Papier] [Code]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [Papier] [Code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [Papier] [Code]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [Papier] [Code]

2.2 Coordinating Potential of Multiple Agents

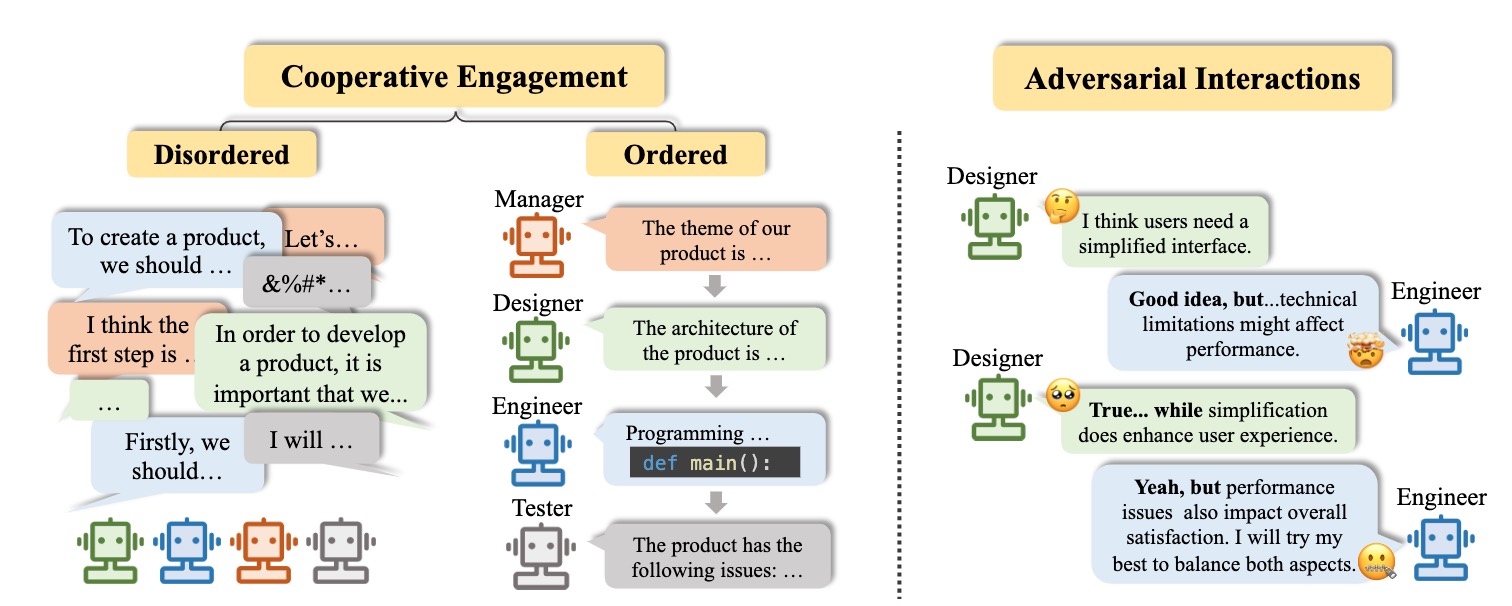

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [Papier] [Code]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [Papier] [Code]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [Papier]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [Papier]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [Papier] [Code]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [Papier] [Code]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [Papier] [Code]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [Papier]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [Papier] [Code]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [Papier] [Code]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [Papier] [Code]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [Papier] [Code]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [Papier] [Code]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [Papier]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [Papier] [Code]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [Papier] [Code]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [Papier]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [Papier] [Code]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [Papier] [Code]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [Papier]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [Papier] [Code]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [Papier] [Code]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [Papier] [Code]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [Papier]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [Papier] [Code]

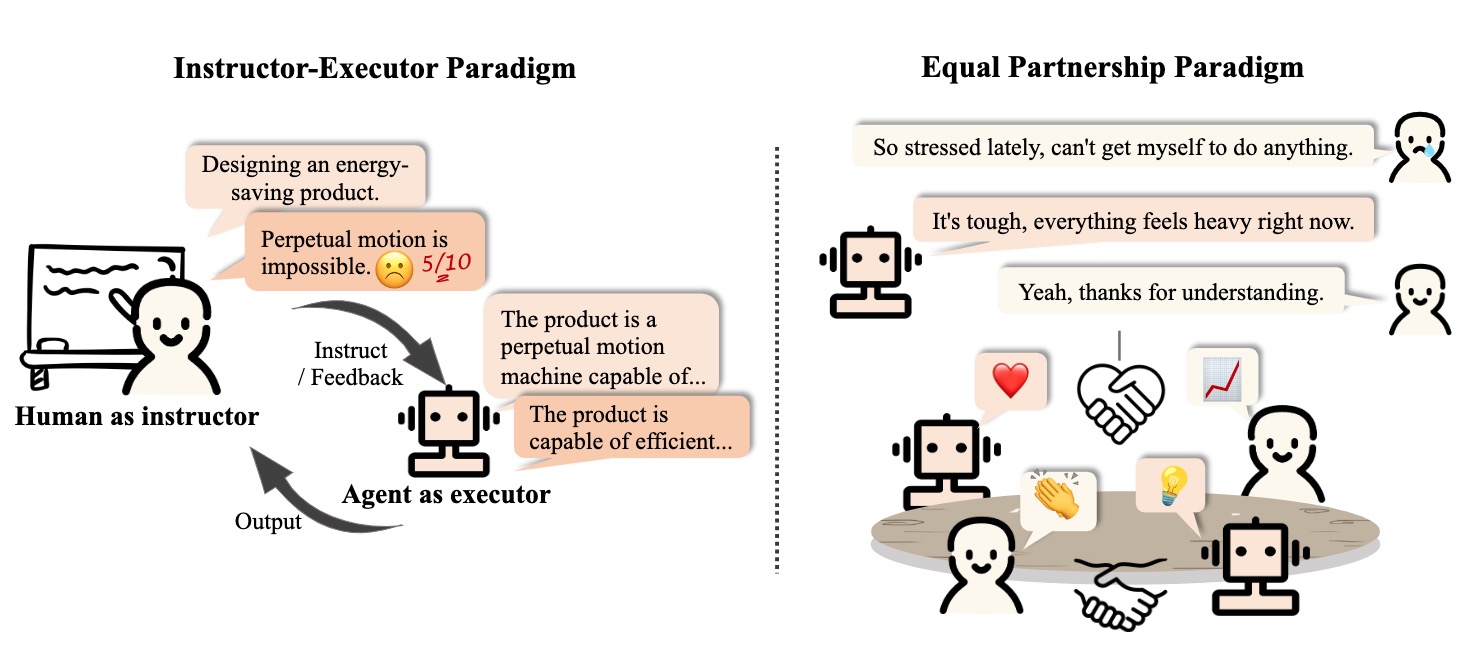

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

Ausbildung

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [Papier]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [Papier]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

Gesundheit

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [Papier] [Code]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [Papier]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [Papier]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [Papier]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [Papier]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [Papier]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [Papier]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [Papier]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [Papier]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [Papier] [Code]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [Papier] [Code]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [Papier]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [Papier]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [Papier]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [Papier]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [Papier]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al. Wissenschaft. [Papier]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [Papier]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [Papier] [Code]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [Papier] [Code]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [Papier]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [Papier] [Code]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [Papier] [Code]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [Papier]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [Papier]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [Papier] [Code]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [Papier] [Code]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [Papier] [Code]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [Papier] [Code]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [Papier] [Code]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [Papier] [Code]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [Papier]

3.1.2 Personality

Erkenntnis

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [Papier]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [Papier]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [Papier]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [Papier]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [Papier]

Emotion

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [Papier]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [Papier]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [Papier]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [Papier]

Charakter

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [Papier] [Code]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [Papier] [Code]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [Papier] [Code]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [Papier] [Code]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [Papier]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [Papier]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [Papier] [Code]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [Papier] [Code]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [Papier]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [Papier] [Code]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [Papier] [Code]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [Papier] [Code]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [Papier] [Code]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [Papier] [Code]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [Papier] [Code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [Papier]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [Papier] [Code]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [Papier] [Code]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [Papier]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [Papier] [Code]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [Papier]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [Papier] [Code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [Papier] [Code]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [Papier]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [Papier] [Code]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [Papier] [Code]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [Papier] [Code]

Zitat

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

Kontakt

Sterngeschichte