A ascensão e potencial de grandes agentes baseados em modelos de linguagem: uma pesquisa

Os artigos de leitura obrigatória para agentes baseados em LLM.

? Em breve: adicione uma introdução de uma frase a cada artigo.

? Notícias

- ☄️ [2024/06/07] O AgentGym foi lançado para desenvolver e evoluir agentes baseados em LLM em diversos ambientes!

- Papel: Agentgym.

- Página do projeto: https://agentgym.github.io/.

- Códigos: plataforma e implementações.

- Recursos HuggingFace: Agenttraj-L, AgentEval, AgentEvol-7B.

- ? [2024/05/02] R3 (treinando grandes modelos de idiomas para o raciocínio por meio do aprendizado de reforço do currículo reverso) foi aceito pelo ICML 2024!

- ? [2024/02/08] Novo artigo R3 no RL para o raciocínio do agente LLM foi lançado! Artigo: Treinando grandes modelos de idiomas para o raciocínio por meio de aprendizado de reforço de currículo reverso. Códigos: LLM-Reverse-Curriculum-RL.

- ? [2023/09/20] Este projeto foi listado nas tendências do GitHub! É uma grande honra!

- ? [2023/09/15] Nossa pesquisa foi lançada! Veja a ascensão e o potencial de grandes agentes baseados em modelos de linguagem: uma pesquisa para o artigo!

- [2023/09/14] Criamos esse repositório para manter uma lista de papel sobre agentes baseados em LLM. Mais documentos estão chegando em breve!

? Introdução

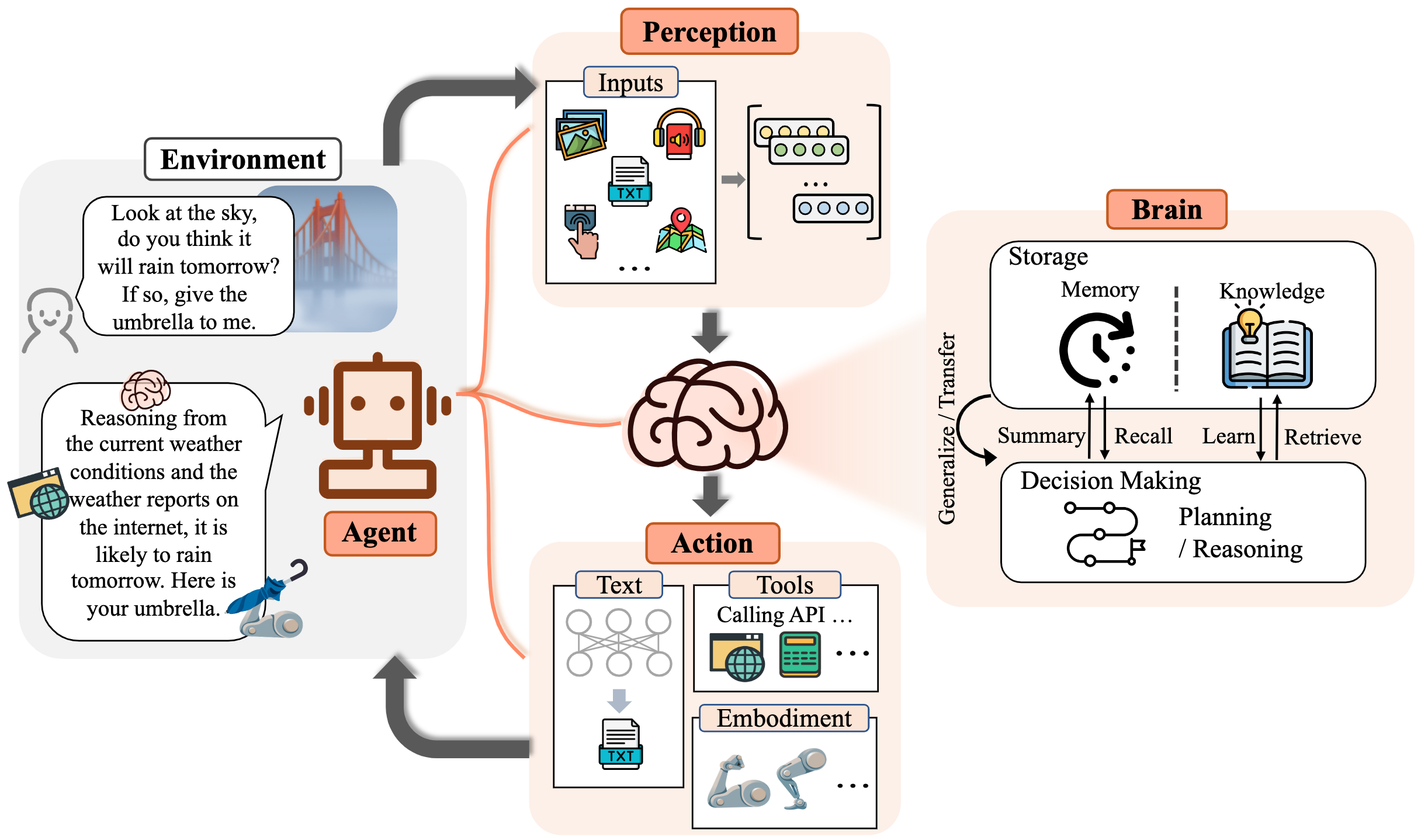

Por um longo tempo, a humanidade buscou inteligência artificial (AI) equivalente a ou superando o nível humano, com agentes de IA considerados como um veículo promissor dessa busca. Os agentes da IA são entidades artificiais que sentem seu ambiente, tomam decisões e tomam ações.

Devido às capacidades versáteis e notáveis que demonstram, os grandes modelos de idiomas (LLMs) são considerados faíscas em potencial para a inteligência geral artificial (AGI), oferecendo esperança para a construção de agentes gerais de IA. Muitos esforços de pesquisa aproveitaram o LLMS como base para construir agentes de IA e alcançaram progresso significativo.

Neste repositório, fornecemos uma pesquisa sistemática e abrangente sobre agentes baseados em LLM e listamos alguns trabalhos de leitura obrigatória.

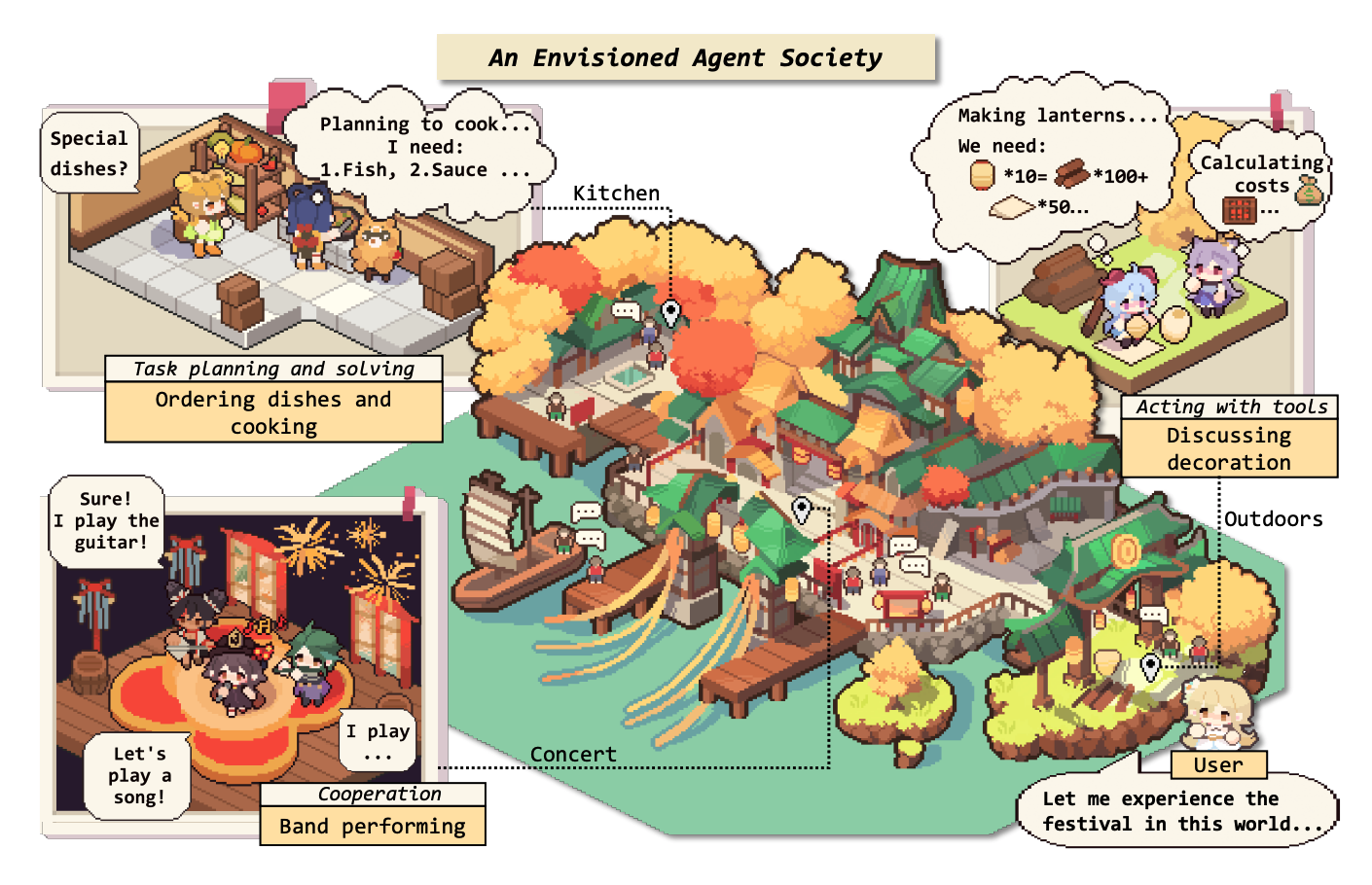

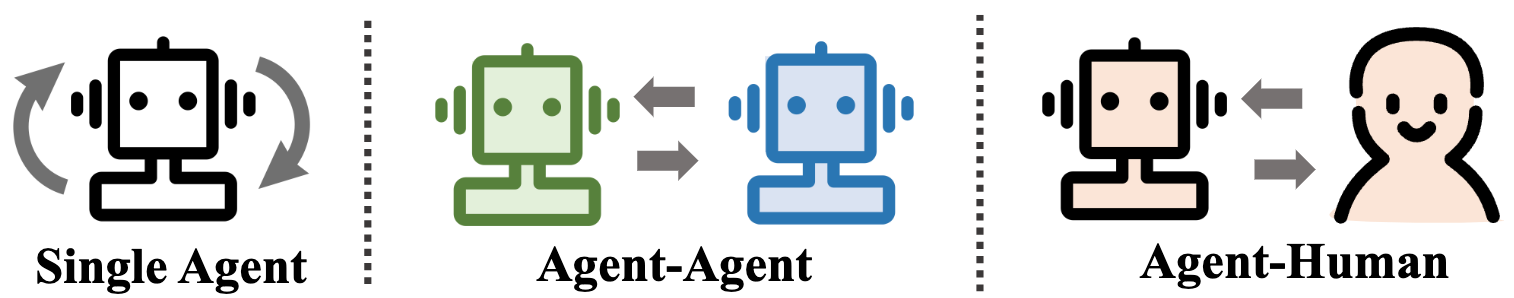

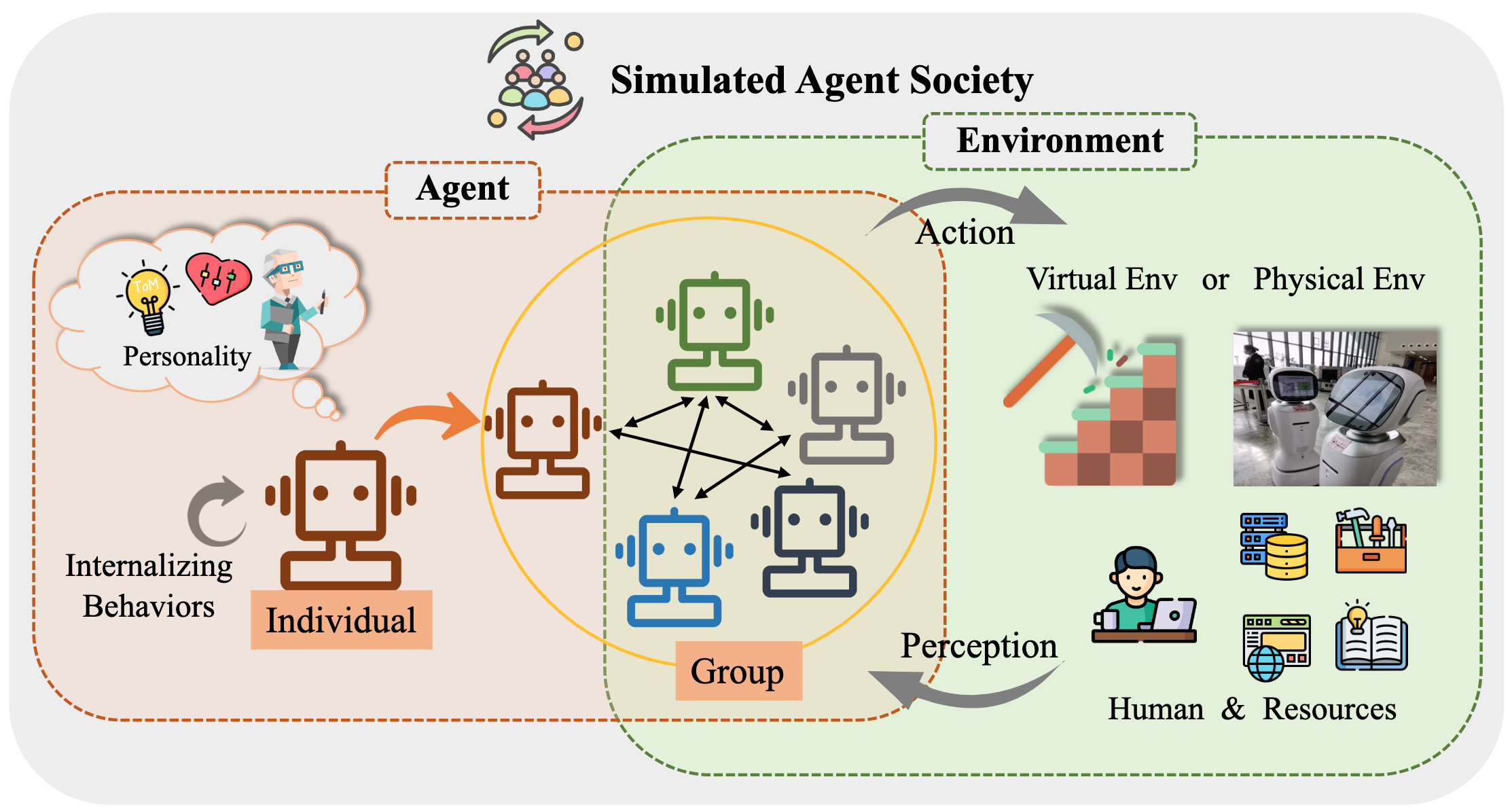

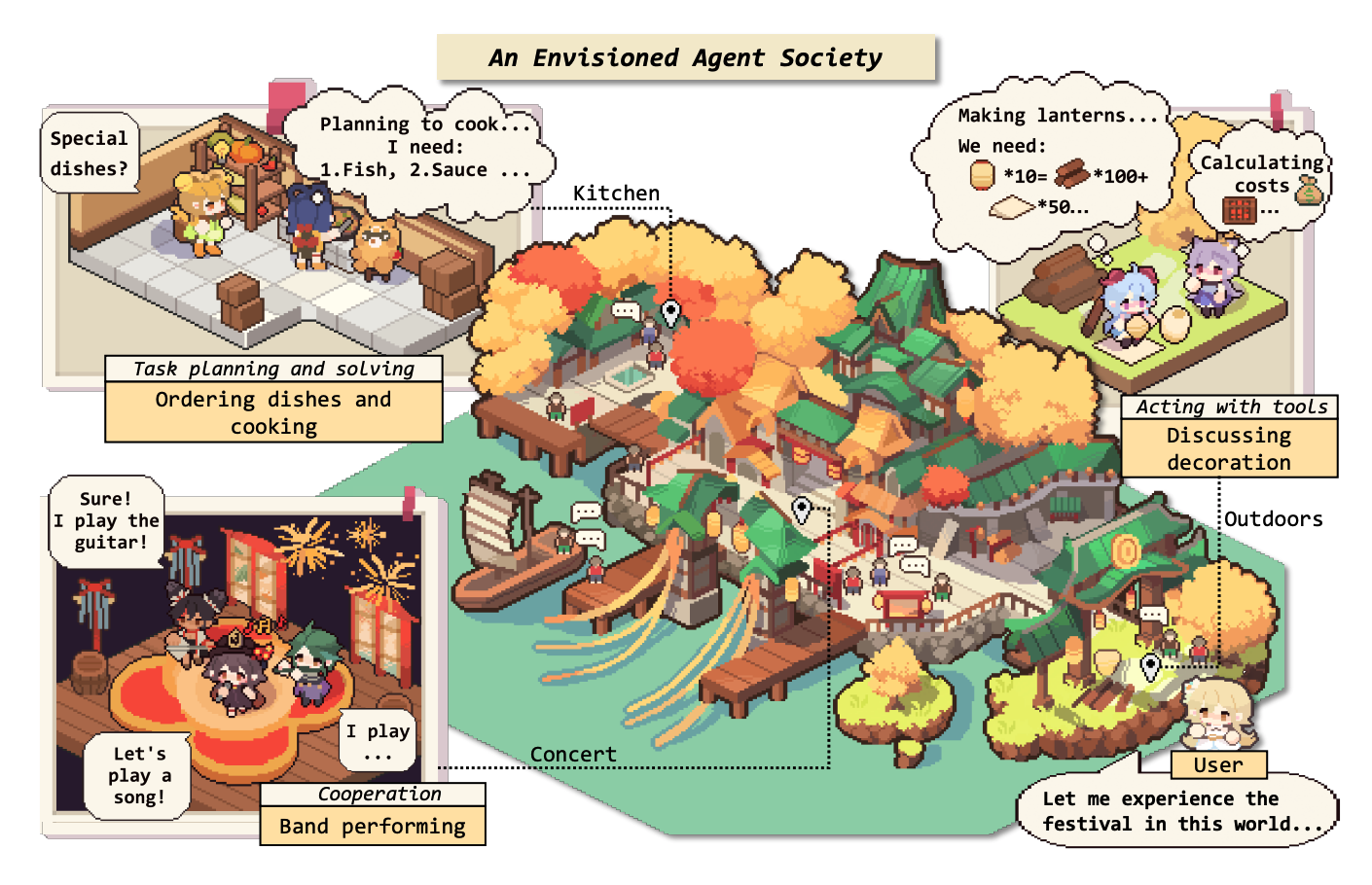

Especificamente, começamos pela estrutura conceitual geral para agentes baseados em LLM: compreendendo três componentes principais: cérebro, percepção e ação, e a estrutura pode ser adaptada para atender a diferentes aplicações. Posteriormente, exploramos as extensas aplicações de agentes baseados em LLM em três aspectos: cenários de agente único, cenários multi-agentes e cooperação humana-agente. Depois disso, nos aprofundamos nas sociedades de agentes, explorando o comportamento e a personalidade dos agentes baseados em LLM, os fenômenos sociais que emergem quando formam sociedades e as idéias que eles oferecem para a sociedade humana. Finalmente, discutimos uma série de tópicos -chave e problemas de abertura no campo.

Agradecemos muito quaisquer contribuições via PRS, questões, e -mails ou outros métodos.

Tabela de conteúdo (TOC)

- A ascensão e potencial de grandes agentes baseados em modelos de linguagem: uma pesquisa

- ? Notícias

- ? Introdução

- Tabela de conteúdo (TOC)

- 1. O nascimento de um agente: Construção de agentes baseados em LLM

- 1.1 Cérebro: composto principalmente por um LLM

- 1.1.1 Interação da linguagem natural

- Geração de alta qualidade

- Compreensão profunda

- 1.1.2 Conhecimento

- Modelo de pré -atrain

- Conhecimento linguístico

- Conhecimento de senso comum

- Conhecimento acionável

- Questões potenciais de conhecimento

- 1.1.3 Memória

- Capacidade de memória

- Levantando o limite de comprimento dos transformadores

- Resumindo a memória

- Compressionando memórias com vetores ou estruturas de dados

- Recuperação de memória

- 1.1.4 Raciocínio e planejamento

- Raciocínio

- Planejamento

- Formulação do plano

- Reflexão do plano

- 1.1.5 Transferibilidade e generalização

- Generalização de tarefas invisíveis

- Aprendizagem no contexto

- Aprendizado contínuo

- 1.2 Percepção: entradas multimodais para agentes baseados em LLM

- 1.3 Ação: expandir o espaço de ação dos agentes baseados em LLM

- 1.3.1 Ferramenta usando

- 1.3.2 Ação incorporada

- 2 agentes na prática: aplicações de agentes baseados em LLM

- 2.1 Capacidade geral de agente único

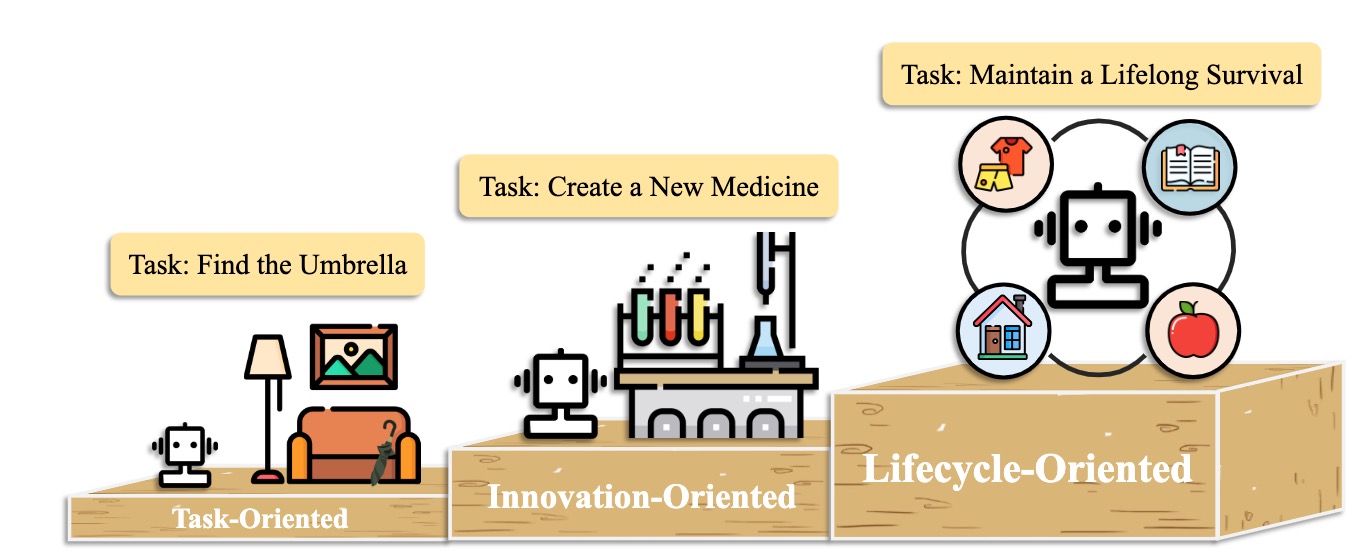

- 2.1.1 implantação orientada para a tarefa

- 2.1.2 implantação orientada para a inovação

- 2.1.3 implantação orientada para ciclo de vida

- 2.2 Potencial de coordenação de múltiplos agentes

- 2.2.1 Interação cooperativa para complementaridade

- 2.2.2 Interação adversária para avanço

- 2.3 Engajamento interativo entre humano e agente

- 2.3.1 Paradigma do instrutor-executor

- Educação

- Saúde

- Outra aplicação

- 2.3.2 Paradigma de parceria igual

- Comunicador Empático

- Participante em nível humano

- 3. Sociedade de agente: da individualidade à socialidade

- 3.1 Comportamento e personalidade de agentes baseados em LLM

- 3.1.1 Comportamento social

- Comportamentos individuais

- Comportamentos de grupo

- 3.1.2 Personalidade

- Cognição

- Emoção

- Personagem

- 3.2 Ambiente para a Sociedade de Agentes

- 3.2.1 Ambiente baseado em texto

- 3.2.2 ambiente virtual de sandbox

- 3.2.3 Ambiente físico

- 3.3 Simulação da sociedade com agentes baseados em LLM

- 4. Outros tópicos

- 4.1 Benchmarks para agentes baseados em LLM

- 4.2 Treinamento e otimização de agentes baseados em LLM

- Citação

- Mantenedores de projeto e colaboradores

- Contato

- História da estrela

1. O nascimento de um agente: Construção de agentes baseados em LLM

1.1 Cérebro: composto principalmente por um LLM

1.1.1 Interação da linguagem natural

Geração de alta qualidade

- [2023/10] Para a tomada de decisão incorporada de ponta a ponta por meio de um modelo de linguagem grande multimodal: Explorações com GPT4-Vision e Beyond Liang Chen et al. arxiv. [papel] [Código]

- Este trabalho propõe o PCA-EVAL, que os benchmarks incorporam a tomada de decisão por meio de métodos de ponta a ponta baseados em MLLM e métodos de uso de ferramentas baseados em LLM, desde os níveis de percepção, cognição e ação.

- [2023/08] Uma avaliação multitarefa multitarefa, multilíngue e multimodal do CHATGPT sobre raciocínio, alucinação e interatividade. Yejin Bang et al. arxiv. [papel]

- Este trabalho avalia os aspectos multitarefa, multilíngues e multimodais do ChatGPT usando 21 conjuntos de dados, cobrindo 8 tarefas de aplicativos comuns comuns.

- [2023/06] LLM-EVAL: Avaliação automática multidimensional unificada para conversas de domínio aberto com grandes modelos de linguagem. Yen-Ting Lin et al. arxiv. [papel]

- O método LLM-EVAL avalia múltiplas dimensões de avaliação, como conteúdo, gramática, relevância e adequação.

- [2023/04] O CHATGPT é um sistema de correção de erro gramatical altamente fluente? Uma avaliação abrangente. Tao Fang et al. arxiv. [papel]

- Os resultados da avaliação demonstram que o ChatGPT possui excelentes recursos de detecção de erros e pode corrigir livremente erros para tornar as frases corrigidas muito fluentes. Além disso, seu desempenho em configurações não inglesas e de baixo recurso destaca seu potencial em tarefas multilíngues do GEC.

Compreensão profunda

- [2023/06] Hans inteligentes ou teoria neural da mente? Teste de estresse Raciocínio social em grandes modelos de idiomas. Natalie Shapira et al. arxiv. [papel]

- Os LLMs exibem certas teoria das habilidades da mente, mas esse comportamento está longe de ser robusto.

- [2022/08] inferir recompensas da linguagem no contexto. Jessy Lin et al. ACL. [papel]

- Este trabalho apresenta um modelo que depende recompensas da linguagem e prevê ações ideais no ambiente invisível.

- [2021/10] Comunicação Assistente da Teoria da Mente em cooperação complexa de robôs humanos. Moritz C. Buehler et al. arxiv. [papel]

- Este trabalho projeta um agente sushi com uma compreensão do humano durante a interação.

1.1.2 Conhecimento

Modelo de pré -atrain

- [2023/04] Aprendizando representações distribuídas de frases a partir de dados não marcados. Felix Hill (Universidade de Cambridge) et al. arxiv. [papel]

- [2020/02] Quanto conhecimento você pode incluir nos parâmetros de um modelo de idioma? Adam Roberts (Google) et al. arxiv. [papel]

- [2020/01] Escalando leis para modelos de linguagem neural. Jared Kaplan (Universidade Johns Hopkins) et al. arxiv. [papel]

- [2017/12] Conhecimento de senso comum na inteligência da máquina. Niket Tandon (Instituto Allen de Inteligência Artificial) et al. Sigmod. [papel]

- [2011/03] Processamento de linguagem natural (quase) do zero. Ronan Collobert (Princeton) et al. arxiv. [papel]

Conhecimento linguístico

- [2023/02] Uma avaliação multitarefa multitarefa, multilíngue e multimodal do chatgpt no raciocínio, alucinação e interatividade. Yejin Bang et al. arxiv. [papel]

- [2021/06] sondando modelos de linguagem pré-treinados para atributos semânticos e seus valores. Meriem Beloucif et al. Emnlp. [papel]

- [2020/10] sondando modelos de linguagem pré -gravados para semântica lexical. Ivan Vulić et al. arxiv. [papel]

- [2019/04] Uma sonda estrutural para encontrar sintaxe nas representações de palavras. John Hewitt et al. ACL. [papel]

- [2016/04] Melhor extração automática de palavras -chave, dado mais conhecimento semântico. H Leung. Sistemas para aplicações avançadas. [papel]

Conhecimento de senso comum

- [2022/10] Os modelos de idiomas de código são poucos alunos do senso comum. Aman Madaan et al.arxiv. [papel]

- [2021/04] Representação do conhecimento do mundo relacional em modelos de linguagem contextual: uma revisão. Tara Safavi et al. arxiv. [papel]

- [2019/11] Como podemos saber quais modelos de idiomas sabem? Zhengbao Jiang et al.arxiv. [papel]

Conhecimento acionável

- [2023/07] grandes modelos de idiomas em medicina. Arun James Thirunavukarasu et al. natureza. [papel]

- [2023/06] DS-1000: Um benchmark natural e confiável para geração de código de ciência de dados. Yuhang Lai et al. ICML. [papel]

- [2022/10] Os modelos de idiomas de código são poucos alunos do senso comum. Aman Madaan et al. arxiv. [papel]

- [2022/02] Uma avaliação sistemática de grandes modelos de idiomas de código. Frank F. Xu et al.arxiv. [papel]

- [2021/10] Verificadores de treinamento para resolver problemas de palavras matemáticas. Karl Cobbe et al. arxiv. [papel]

Questões potenciais de conhecimento

- [2023/10] Freshllms: refrescando grandes modelos de linguagem com aumento do mecanismo de pesquisa. Tu Vu (Google) et al. Arxiv [Paper] [Código]

- [2023/05] Editando grandes modelos de idiomas: problemas, métodos e oportunidades. Yunzhi Yao et al. arxiv. [papel]

- [2023/05] Auto-checker: módulos plug-and-play para verificar fatos com grandes modelos de idiomas. Miaoran Li et al. arxiv. [papel]

- [2023/05] Crítico: Modelos de idiomas grandes podem se auto-corrigir com a crítica interativa da ferramenta. Zhibin Gou et al. arxiv. [papel]

- [2023/04] Aprendizagem de ferramentas com modelos de fundação. Yujia Qin et al. arxiv. [papel]

- [2023/03] SelfCeckGPT: detecção de alucinação de caixa preta com resistência zero para modelos generativos de grandes linguagens. Potsawee Manakul et al. arxiv. [papel]

- [2022/06] Edição de modelo baseada em memória em escala. Eric Mitchell et al. arxiv. [papel]

- [2022/04] Uma revisão sobre modelos de idiomas como bases de conhecimento. Badr Alkhamissi et al.arxiv. [papel]

- [2021/04] Editando conhecimento factual em modelos de idiomas. Nicola de Cao et al.arxiv. [papel]

- [2017/08] medindo o esquecimento catastrófico nas redes neurais. Ronald Kemker et al.arxiv. [papel]

1.1.3 Memória

Capacidade de memória

Levantando o limite de comprimento dos transformadores

- [2023/10] MEMGPT: Rumo a LLMS como sistemas operacionais. Charles Packer (UC Berkeley) et al. arxiv. [Paper] [Página do projeto] [Código] [DataSet]

- [2023/05] codificações posicionais randomizadas aumentam a generalização do comprimento dos transformadores. Anian Ruoss (Deepmind) et al. arxiv. [papel] [Código]

- [2023-03] Colt5: transformadores de longo alcance mais rápidos com computação condicional. Joshua Ainslie (Google Research) et al. arxiv. [papel]

- [2022/03] Classificação eficiente de documentos longos usando transformadores. Hyunji Hayley Park (Universidade de Illinois) et al. arxiv. [papel] [Código]

- [2021/12] Longt5: transformador de texto em texto eficiente para sequências longas. Mandy Guo (Google Research) et al. arxiv. [papel] [Código]

- [2019/10] BART: DenOising Sequence-to-Sevence Pré-treinamento para geração, tradução e compreensão de linguagem natural. Michael Lewis (Facebook AI) et al. arxiv. [papel] [Código]

Resumindo a memória

- [2023/10] Andando pelo labirinto de memória: além do limite de contexto através da leitura interativa Howard Chen (Universidade de Princeton) et al. arxiv. [papel]

- [2023/09] Capacitar a aulas particulares encadeando modelos de idiomas grandes Yulin Chen (Universidade de Tsinghua) et al. arxiv. [papel]

- [2023/08] Expel: Os agentes LLM são aprendizes experimentais. Andrew Zhao (Universidade de Tsinghua) et al. arxiv. [papel] [Código]

- [2023/08] ChateVal: para melhores avaliadores baseados em LLM por meio de um debate multi-agente. Chi-min Chan (Universidade de Tsinghua) et al. arxiv. [papel] [Código]

- [2023/05] Memorybank: aprimorando os grandes modelos de linguagem com memória de longo prazo. Wanjun Zhong (Instituto de Tecnologia Harbin) et al. arxiv. [papel] [Código]

- [2023/04] Agentes generativos: simulacra interativo do comportamento humano. Joon Sung Park (Stanford University) et al. arxiv. [papel] [Código]

- [2023/04] Liberando a capacidade de entrada de comprimento infinito para modelos de idiomas em larga escala com sistema de memória autocontrolada. Xinniano Liang (Universidade de Beihang) et al. arxiv. [papel] [Código]

- [2023/03] Reflexão: agentes de idiomas com aprendizado de reforço verbal. Noah Shinn (Northeastern University) et al. arxiv. [papel] [Código]

- [2023/05] Recorrentgpt: geração interativa de texto longo (arbitrariamente). Wangchunshu Zhou (Aiwaves) et al. arxiv. [papel] [Código]

Compressionando memórias com vetores ou estruturas de dados

- [2023/07] Agentes comunicativos para desenvolvimento de software. Chen Qian (Universidade de Tsinghua) et al. arxiv. [papel] [Código]

- [2023/06] Chatdb: Augmenting LLMS com bancos de dados como sua memória simbólica. Chenxu Hu (Universidade de Tsinghua) et al. arxiv. [papel] [Código]

- [2023/05] Ghost in the Minecraft: Agentes geralmente capazes para ambientes de mundo aberto por meio de grandes modelos de linguagem com conhecimento e memória baseados em texto. Xizhou Zhu (Universidade de Tsinghua) et al. arxiv. [papel] [Código]

- [2023/05] ret-llm: em direção a uma memória geral de leitura de leitura para grandes modelos de idiomas. Ali Modarressi (LMU Munique) et al. arxiv. [papel] [Código]

- [2023/05] Recorrentgpt: geração interativa de texto longo (arbitrariamente). Wangchunshu Zhou (Aiwaves) et al. arxiv. [papel] [Código]

Recuperação de memória

- [2023/08] Sandbox de memória: Gerenciamento de memória transparente e interativo para agentes de conversação. Ziheng Huang (Universidade da Califórnia - San Diego) et al. arxiv. [papel]

- [2023/08] agentes: uma caixa de areia de código aberto para uma grande avaliação do modelo de idioma. Jiaju Lin (PTA Studio) et al. arxiv. [Paper] [Página do projeto] [Código]

- [2023/06] Chatdb: Augmenting LLMS com bancos de dados como sua memória simbólica. Chenxu Hu (Universidade de Tsinghua) et al. arxiv. [papel] [Código]

- [2023/05] Memorybank: aprimorando os grandes modelos de linguagem com memória de longo prazo. Wanjun Zhong (Instituto de Tecnologia Harbin) et al. arxiv. [papel] [Código]

- [2023/04] Agentes generativos: simulacra interativo do comportamento humano. Joon Sung Park (Stanford) et al. arxiv. [papel] [Código]

- [2023/05] Recorrentgpt: geração interativa de texto longo (arbitrariamente). Wangchunshu Zhou (Aiwaves) et al. arxiv. [papel] [Código]

1.1.4 Raciocínio e planejamento

Raciocínio

[2024/02] Treinando grandes modelos de linguagem para raciocínio por meio de aprendizado de reforço de currículo reverso. Zhiheng Xi (Universidade Fudan) et al. arxiv. [papel] [Código]

[2023/09] Reconcílio: a conferência redonda melhora o raciocínio por consenso entre os diversos LLMs. Justin Chih-Yao Chen (Universidade da Carolina do Norte em Chapel Hill) et al. arxiv. [papel] [Código]

[2023/05] autopolish: aprimore o raciocínio em grandes modelos de linguagem por meio de refinamento de problemas. Zhiheng Xi (Universidade Fudan) et al. arxiv. [papel] [Código]

[2023-03] Modelos de linguagem grandes são raciocínio zero. Takeshi Kojima (Universidade de Tóquio) et al. arxiv. [papel] [Código]

[2023/03] Auto-refinado: refinamento iterativo com auto-feedback. Aman Madaan (Universidade Carnegie Mellon) et al. arxiv. [papel] [Código]

[2022/05] Inferência de seleção: explorando grandes modelos de idiomas para o raciocínio lógico interpretável. Antonia Creswell (Deepmind) et al. arxiv. [papel]

[2022/03] A autoconsistência melhora o raciocínio da cadeia de pensamentos em modelos de idiomas. Xuezhi Wang (Google Research) et al. arxiv. [papel] [Código]

[2023/02] Raciocínio multimodal de cadeia de pensamentos em modelos de idiomas. Zhuosheng Zhang (Xangai Jiao Tong University) et al. arxiv. [papel] [Código]

[2022/01] A cadeia de pensamentos provocam o raciocínio em grandes modelos de idiomas. Jason Wei (Google Research) et al. arxiv. [papel]

Planejamento

Formulação do plano

- [2023/11] JARVIS-1: Agentes multi-tarefas do mundo aberto com modelos de linguagem multimodal com memória. Zihao Wang (Universidade de Pequim) et al. arxiv. [papel] [Código]

- [2023/10] A pesquisa de árvores de agentes de idiomas unifica o raciocínio de atuação e planejamento em modelos de idiomas. Andy Zhou (Universidade de Illinois Urbana-Champaign) et al. arxiv. [Paper] [Página do projeto] [Código]

- [2023/05] Árvore dos pensamentos: resolução deliberada de problemas com grandes modelos de linguagem. Shunyu Yao (Universidade de Princeton) et al. arxiv. [papel] [Código]

- [2023/05] Plano, eliminar e rastrear - modelos de idiomas são bons professores para agentes incorporados. Yue Wu (Universidade Carnegie Mellon) et al. arxiv. [papel]

- [2023/05] O raciocínio com o modelo de idioma está planejando com o modelo mundial. Shibo Hao (UC San Diego) et al. arxiv. [papel] [Código]

- [2023/05] SwiftSage: um agente generativo com pensamento rápido e lento para tarefas interativas complexas. Bill Yuchen Lin (Instituto Allen de Inteligência Artificial) et al. arxiv. [papel] [Código]

- [2023/04] LLM+P: Empoderando grandes modelos de linguagem com proficiência de planejamento ideal. Bo Liu (Universidade do Texas em Austin) et al. arxiv. [papel] [Código]

- [2023/03] HuggingGPT: resolver as tarefas de IA com o ChatGPT e seus amigos em abraçar o rosto. Yongliang Shen (Microsoft Research Asia) et al. arxiv. [papel] [Código]

- [2023/02] Descreva, explique, planeje e selecione: Planejamento interativo com grandes modelos de idiomas permite agentes de várias tarefas do mundo aberto. Zihao Wang (Universidade de Pequim) et al. arxiv. [papel] [Código]

- [2022/05] O pedido menos ao máximo permite um raciocínio complexo em grandes modelos de idiomas. Denny Zhou (Google Research) et al. arxiv. [papel]

- [2022/05] Sistemas MRKL: uma arquitetura modular e neuro-simbólica que combina grandes modelos de linguagem, fontes de conhecimento externas e raciocínio discreto. Ehud Karpas (AI21 Labs) et al. arxiv. [papel]

- [2022/04] Faça o que eu puder, não como eu digo: linguagem de aterramento em preços robóticos. Michael Ahn (Robotics no Google) et al. arxiv. [papel]

- [2023/05] Agentes: uma estrutura de código aberto para agentes de idiomas autônomos. Wangchunshu Zhou (Aiwaves) et al. arxiv. [papel] [Código]

- [2022/12] Não gerar, discriminar: uma proposta para modelos de linguagem de aterramento para ambientes do mundo real. Yu Gu (Universidade Estadual de Ohio) et al. ACL. [papel] [Código]

Reflexão do plano

- [2024/02] Agente-Pro: Aprendendo a evoluir por meio de reflexão e otimização em nível de política Wenqi Zhang (Universidade de Zhejiang) et al. arxiv. [papel] [Código]

- [2024/01] Autocontraste: melhor reflexão por meio de perspectivas de solução inconsistente Wenqi Zhang (Universidade de Zhejiang) et al. arxiv. [papel]

- [2023/11] JARVIS-1: Agentes multi-tarefas do mundo aberto com modelos de linguagem multimodal com memória. Zihao Wang (Universidade de Pequim) et al. arxiv. [papel] [Código]

- [2023/10] A cadeia de verificação reduz a alucinação em grandes modelos de idiomas. Shehzaad dhuliawala (Meta Ai & eth Zu ̈rich) et al. arxiv. [papel]

- [2023/10] FIREACT: Para o agente do idioma, ajuste fino. Baian Chen (System2 Research) et al. arxiv. [Paper] [Página do projeto] [Código] [DataSet]

- [2023/08] Selfeck: Usando LLMS para zero shot, verifique seu próprio raciocínio passo a passo. Ning Miao (Universidade de Oxford) et al. arxiv. [papel] [Código]

- [2023/05] ChatCot: Raciocínio de cadeia de pensamento com ferramentas com ferramentas em grandes modelos de idiomas baseados em bate-papo. Zhipeng Chen (Universidade Renmin da China) et al. arxiv. [papel] [Código]

- [2023/05] Voyager: um agente incorporado aberto com grandes modelos de idiomas. Guanzhi Wang (Nvidia) et al. arxiv. [Paper] [Página do projeto] [Código]

- [2023/03] Converse com o ambiente: percepção multimodal interativa usando modelos de idiomas grandes. Xufeng Zhao (Universidade Hamburgo) et al. arxiv. [papel] [Código]

- [2022/12] LLM-Planner: Planejamento fundamentado de poucas fotos para agentes incorporados com grandes modelos de linguagem. Chan Hee Song (The Ohio State University) et al. arxiv. [papel] [Código]

- [2022/10] React: sinergizando o raciocínio e atuação em modelos de idiomas. Shunyu Yao (Universidade de Princeton) et al. arxiv. [papel] [Código]

- [2022/07] Monólogo interno: raciocínio incorporado através do planejamento com modelos de idiomas. Wenlong Huang (robótica no Google) et al. arxiv. [papel] [Código]

- [2021/10] Cadeias de AI: interação transparente e controlável de Human-AI, enchendo os avisos do modelo de linguagem. Tongshuang Wu (Universidade de Washington) et al. arxiv. [papel]

1.1.5 Transferibilidade e generalização

Generalização de tarefas invisíveis

- [2024/06] AgentGym: Evoluindo grandes agentes baseados em modelos de linguagem em diversos ambientes. Zhiheng Xi (Universidade Fudan) et al. arxiv. [Paper] [Página do projeto] [Códigos e plataforma] [DataSet] [Benchmark] [Model].

- [2023/10] AgentTuning: permitindo habilidades de agentes generalizados para LLMS. Aohan Zeng (Universidade de Tsinghua) et al. arxiv. [Paper] [Página do projeto] [Código] [DataSet]

- [2023/10] Lemur: Harmonizando a linguagem e o código naturais dos agentes de idiomas Yiheng Xu (Universidade de Hong Kong) et al. arxiv. [papel] [Código]

- [2023/05] Modelos de linguagem de treinamento para seguir as instruções com feedback humano. Long Ouyang et al. Neurips. [papel]

- InstructGPT: alinhar modelos de linguagem com o usuário com intenção de uma ampla gama de tarefas, ajustando o feedback humano.

- [2023/01] O treinamento solicitado por várias tarefas permite a generalização da tarefa zero-tiro. Victor Sanh et al. ICLR. [papel] [Código]

- T0: T0 é um modelo de codificador-decodificador que consome entradas textuais e produz respostas-alvo. Ele é treinado em uma mistura multitarefa de conjuntos de dados PNL particionados em tarefas diferentes.

- [2022/10] Modelos de idiomas de instrução de escala-finetunados. Hyung Won Chung et al. arxiv. [papel] [Código]

- Este trabalho explora a instrução Finetuning com um foco particular em escalar o número de tarefas e o tamanho do modelo, o que melhora o desempenho em uma variedade de classes de modelos, solicitando configurações e benchmarks de avaliação.

- [2022/08] Os modelos de idiomas FinetUned são aprendizes de tiro zero. Jason Wei et al. ICLR. [papel]

- Flan: o ajuste da instrução melhora substancialmente o desempenho de tiro zero em tarefas invisíveis.

Aprendizagem no contexto

- [2023/08] As imagens falam em imagens: um pintor generalista para o aprendizado visual no contexto. Xinlong Wang et al. IEEE. [papel] [Código]

- Painter: Este trabalho apresenta um modelo generalista para o aprendizado visual no contexto com uma solução centrada na "imagem".

- [2023/08] Os modelos de idiomas do codec neural são o texto zero para sintetizadores de fala. Chengyi Wang et al. arxiv. [papel] [Código]

- Vall-e: Este trabalho treina um modelo de idioma de codec neural, que emerge recursos de aprendizado no contexto.

- [2023/07] Uma pesquisa para aprendizado no contexto. Qingxiu Dong et al. arxiv. [papel]

- Esta pesquisa resume o progresso e os desafios da aprendizagem no contexto (ICL).

- [2023/05] Os modelos de idiomas são poucos alunos. Tom B. Brown (Openai) et al. Neurips. [papel]

- GPT-3: A ampliação dos modelos de linguagem melhora bastante o desempenho agnóstico da tarefa e de poucos anos, às vezes até se tornando competitivo com as abordagens anteriores de ajuste fina de ponta.

Aprendizado contínuo

- [2023/11] JARVIS-1: Agentes multi-tarefas do mundo aberto com modelos de linguagem multimodal com memória. Zihao Wang (Universidade de Pequim) et al. arxiv. [papel] [Código]

- [2023/07] Prompts progressivos: Aprendizagem contínua para modelos de idiomas. Razdaibiedina et al. arxiv. [papel]

- Este trabalho apresenta instruções progressivas, o que permite a transferência direta e resiste ao esquecimento catastrófico, sem depender da repetição de dados ou de um grande número de parâmetros específicos da tarefa.

- [2023/05] Voyager: um agente incorporado aberto com grandes modelos de idiomas. Guanzhi Wang (Nvidia) et al. arxiv. [Paper] [Página do projeto] [Código]

- Voyager: Este é um exemplo de agente de aprendizado incorporado ao longo da vida de LLM que explora continuamente o mundo, adquire diversas habilidades e faz novas descobertas sem intervenção humana.

- [2023/01] Uma pesquisa abrangente de aprendizado contínuo: teoria, método e aplicação. Liyuan Wang et al. arxiv. [papel]

- Esta pesquisa apresenta uma pesquisa abrangente de aprendizado contínuo, buscando preencher as configurações básicas, fundações teóricas, métodos representativos e aplicações práticas.

- [2022/11] Aprendizagem contínua de tarefas de processamento de linguagem natural: uma pesquisa. Zixuan Ke et al. arxiv. [papel]

- Esta pesquisa apresenta uma revisão e análise abrangentes do recente progresso do CL na PNL.

1.2 Percepção: entradas multimodais para agentes baseados em LLM

1.2.1 Visual

- [2024/01] Agente AI: examinando os horizontes da interação multimodal. Zane Durante et al. arxiv. [papel]

- [2023/10] Para a tomada de decisão incorporada de ponta a ponta por meio de um modelo de linguagem grande multimodal: Explorações com GPT4-Vision e Beyond Liang Chen et al. arxiv. [papel] [Código]

- [2023/05] O idioma não é tudo o que você precisa: alinhar a percepção com os modelos de idiomas. Shaohan Huang et al. arxiv. [papel]

- [2023/05] InstructBlip: Rumo a modelos de linguagem de visão geral com ajuste de instrução. Wenliang Dai et al. arxiv. [papel]

- [2023/05] Multimodal-GPT: um modelo de visão e linguagem para diálogo com humanos. Tao Gong et al. arxiv. [papel]

- [2023/05] PANDAGPT: Um modelo para segui-las para segui-las. Yixuan Su et al. arxiv. [papel]

- [2023/04] Ajuste da instrução visual. Haotian Liu et al. arxiv. [papel]

- [2023/04] Minigpt-4: Aprimorando o entendimento da linguagem da visão com modelos de linguagem grande avançada. Deyao Zhu. arxiv. [papel]

- [2023/01] BLIP-2: Pré-treinamento de imagem de linguagem de inicialização com codificadores de imagem congelados e grandes modelos de linguagem. Junnan Li et al. arxiv. [papel]

- [2022/04] Flamingo: um modelo de linguagem visual para aprendizado de poucos anos. Jean-Baptiste Alayrac et al. arxiv. [papel]

- [2021/10] MobileVit: Transformador de visão leve, de uso geral, de uso geral e móvel. Sachin Mehta et al.arxiv. [papel]

- [2021/05] MLP-MIXER: Uma arquitetura All-MLP for Vision. Ilya Tolstikhin et al.arxiv. [papel]

- [2020/10] Uma imagem vale 16x16 palavras: transformadores para reconhecimento de imagem em escala. Alexey Dosovitskiy et al. arxiv. [papel]

- [2017/11] Aprendizagem neural de representação discreta. Aaron van den Oord et al. arxiv. [papel]

1.2.2 Áudio

- [2023/06] VIDEO-LLAMA: Um modelo de linguagem audiovisual ajustado para instruções para entendimento de vídeo. Hang Zhang et al. arxiv. [papel]

- [2023/05] X-LLM: Modelos avançados de linguagem avançada de Bootstrapping tratando multimodalidades como idiomas estrangeiros. Feilong Chen et al. arxiv. [papel]

- [2023/05] Interngpt: resolvendo tarefas centradas na visão, interagindo com o ChatGPT além da linguagem. Zhaoyang Liu et al. arxiv. [papel]

- [2023/04] Audiogpt: Entendendo e gerando fala, música, som e cabeça de falar. Rongjie Huang et al. arxiv. [papel]

- [2023/03] HuggingGPT: resolver as tarefas de IA com o ChatGPT e seus amigos em abraçar o rosto. Yongliang Shen et al. arxiv. [papel]

- [2021/06] Hubert: Aprendizagem de representação da fala auto-supervisionada por previsão mascarada de unidades ocultas. Wei-Ning Hsu et al. arxiv. [papel]

- [2021/04] AST: transformador de espectrograma de áudio. Yuan Gong et al. arxiv. [papel]

1.3 Ação: expandir o espaço de ação dos agentes baseados em LLM

1.3.1 Ferramenta usando

- [2024/02] para agente de idiomas com consciência da incerteza. Jiuzhou Han (Monash University) et al. arxiv. [Paper] [Página do projeto] [Código]

- [2023/10] Openagents: uma plataforma aberta para agentes de idiomas na natureza. Xlang Lab (Universidade de Hong Kong) Arxiv. [Paper] [Página do projeto] [Código] [Demo]

- [2023/10] Lemur: Harmonizando a linguagem e o código naturais dos agentes de idiomas Yiheng Xu (Universidade de Hong Kong) et al. arxiv. [papel] [Código]

- [2023/10] Para a tomada de decisão incorporada de ponta a ponta por meio de um modelo de linguagem grande multimodal: Explorações com GPT4-Vision e Beyond Liang Chen (Peking University) et al. arxiv. [papel] [Código]

- Holmes é uma estrutura de cooperação multi-agente que permite que o LLMS aproveite MLLMs e APIs para coletar informações multimodais para a tomada de decisão informada.

- [2023/07] Toolllm: facilitando grandes modelos de idiomas para dominar mais de 16000 APIs no mundo real. Yujia Qin (Universidade de Tsinghua) et al. arxiv. [Paper] [Código] [DataSet]

- O Toolllm é uma estrutura geral de uso de ferramentas que abrange a construção de dados, o treinamento e a avaliação de modelos.

- [2023/05] Modelos de idiomas grandes como fabricantes de ferramentas. Tianle Cai (Universidade de Princeton) et al. arxiv. [papel] [Código]

- O LATM é uma estrutura de circuito fechado que dá um passo inicial para remover a dependência da disponibilidade das ferramentas existentes.

- [2023/05] Criador: desembaraçando raciocínio abstrato e concreto de grandes modelos de linguagem através da criação de ferramentas. Cheng Qian (Universidade de Tsinghua) et al. arxiv. [papel]

- O Creator é uma nova estrutura que capacita o LLMS para criar suas próprias ferramentas por meio de documentação e realização de código.

- [2023/04] Aprendizagem de ferramentas com modelos de fundação. Yujia Qin (Universidade de Tsinghua) et al. arxiv. [papel] [Código]

- Esta pesquisa apresenta principalmente um novo paradigma chamado "Aprendizagem de ferramentas com base em modelos fundamentais", que combina as vantagens de ferramentas especializadas e modelos fundamentais, alcançando maior precisão, eficiência e automação na solução de problemas.

- [2023/04] ChemCrow: Aumentando modelos de grande língua com ferramentas de química. Andres M Bran (Laboratório de Inteligência Química Artificial, ISIC, EPFL) et al. arxiv. [papel] [Código]

- A ChemCrow é um agente de química LLM que integra 13 ferramentas projetadas por especialistas e aumenta o desempenho do LLM em química e emerge novos recursos.

- [2023/04] Genegpt: Aumentando grandes modelos de idiomas com ferramentas de domínio para melhorar o acesso a informações biomédicas. Qiao Jin (Institutos Nacionais de Saúde), Yifan Yang, Qingyu Chen, Zhiyong Lu. arxiv. [papel] [Código]

- Genegpt é um modelo que responde a perguntas genômicas. Ele apresenta um novo método para lidar com desafios com alucinações, ensinando LLMs a usar as APIs da Web.

- [2023/04] Openagi: quando o LLM atende a especialistas em domínio. Yingqiang GE (Universidade Rutgers) et al. arxiv. [papel] [Código]

- O Openagi é uma plataforma de pesquisa da AGI de código aberto. Ele apresenta um paradigma de LLMs operando vários modelos especializados para resolver tarefas complexas e propõe um mecanismo de RLTF para melhorar a capacidade de solução de tarefas do LLM.

- [2023/03] HuggingGPT: resolver as tarefas de IA com o ChatGPT e seus amigos em abraçar o rosto. Yongliang Shen (Universidade de Zhejiang) et al. arxiv. [papel] [Código]

- O HuggingGPT é um sistema que aproveita o LLMS para conectar vários e multimodais modelos de IA nas comunidades de aprendizado de máquina para resolver tarefas de IA.

- [2023/03] Visual Chatgpt: conversando, desenhando e editando com modelos visuais de fundação. Chenfei Wu (Microsoft Research Asia) et al. arxiv. [papel] [Código]

- O Visual Chatgpt é um sistema que abre a porta para investigar os papéis visuais do ChatGPT com a ajuda de modelos de fundação visual.

- [2023/02] Modelos de idiomas aumentados: uma pesquisa. Grégoire Mialon (Meta AI) et al. Tmlr. [papel]

- Esta pesquisa analisa as obras nos quais o LMS é aumentado com a capacidade de usar ferramentas. O LMS aumentado pode usar módulos externos para expandir sua capacidade de processamento de contexto.

- [2023/02] Ferramentas: modelos de idiomas podem se ensinar a usar ferramentas. Timo Schick (Meta AI) et al. arxiv. [papel]

- O Ferramentas mostra que os LLMs podem se ensinar a usar ferramentas externas com um punhado de demonstrações para cada API.

- [2022/05] TALM: modelos de idiomas aumentados em ferramentas. Aaron Parisi (Google) et al. arxiv. [papel]

- A Talm apresenta um método que combina ferramentas não diferenciáveis com o LMS, permitindo que o modelo acesse dados em tempo real ou privado.

- [2022/05] Sistemas MRKL: uma arquitetura modular e neuro-simbólica que combina grandes modelos de linguagem, fontes de conhecimento externas e raciocínio discreto. Ehud Karpas (AI21 Labs) et al. arxiv. [papel]

- A MRKL Systems aumenta o LLMS com um conjunto facilmente extensível de conhecimentos externos e módulos de raciocínio.

- [2022/04] Faça o que eu puder, não como eu digo: linguagem de aterramento em preços robóticos. Michael Ahn (Google) et al. Corl. [papel]

- O SayCan aplica LMS em tarefas robóticas do mundo real, combinando conhecimento semântico avançado do LLMS com a função de valor das habilidades pré-treinadas.

- [2021/12] WebGPT: Pergunta assistida por navegador-Responsando com feedback humano. Reiichiro Nakano (Openai) et al. arxiv. [papel]

- WebGPT responde a perguntas usando um ambiente de abreção da web. Ele usa o aprendizado de imitação durante o treinamento e depois otimiza a qualidade da resposta através do feedback humano.

- [2021/07] Avaliando grandes modelos de linguagem treinados no código. Mark Chen (Openai) et al. arxiv. [papel] [Código]

- O Codex pode sintetizar os programas da DocStrings, ou seja, criando ferramentas com base na documentação.

1.3.2 Ação incorporada

- [2023/12] Para aprender um modelo generalista para navegação incorporada. Duo Zheng (Universidade Chinesa de Hong Kong) et al. arxiv. [papel] [Código]

- [2023/11] Um agente generalista incorporado no mundo 3D. Jiangyong Huang (Universidade Bigai e Pequim) et al. arxiv. [Papel] [Página do projeto]

- [2023/11] JARVIS-1: Agentes multi-tarefas do mundo aberto com modelos de linguagem multimodal com memória. Zihao Wang (Universidade de Pequim) et al. arxiv. [papel] [Código]

- [2023/10] Lemur: Harmonizando a linguagem e o código naturais dos agentes de idiomas Yiheng Xu (Universidade de Hong Kong) et al. arxiv. [papel] [Código]

- [2023/10] Para a tomada de decisão incorporada de ponta a ponta por meio de um modelo de linguagem grande multimodal: Explorações com GPT4-Vision e Beyond Liang Chen et al. arxiv. [papel] [Código]

- [2023/07] Linguagem interativa: conversando com robôs em tempo real. Corey Lynch et al. IEEE (RAL) [papel]

- [2023/05] Voyager: um agente incorporado aberto com grandes modelos de idiomas. Guanzhi Wang (Nvidia) et al. arxiv. [Paper] [Página do projeto] [Código]

- [2023/05] Avlen: navegação incorporada em linguagem audiovisual em ambientes 3D. Sudipta Paul et al. Neurips. [papel]

- [2023/05] Incorporado: pré-treinamento em linguagem da visão por meio de cadeia de pensamento incorporada. Yao Mu et al. Arxiv [Paper] [Código]

- [2023/05] NAVGPT: Raciocínio explícito na navegação de visão e linguagem com grandes modelos de idiomas. Gengze Zhou et al. Arxiv [papel]

- [2023/05] Alphablock: Finetuning incorporado para o raciocínio da linguagem da visão na manipulação do robô. Chuhao Jin et al. Arxiv [papel]

- [2023/03] PALM-E: Um modelo de linguagem multimodal incorporado. Danny Driess et al. Arxiv. [papel]

- [2023/03] Reflexão: agentes de idiomas com aprendizado de reforço verbal. Noah Shinn et al. Arxiv [paper] [code]

- [2023/02] Collaborating with language models for embodied reasoning. Ishita Dasgupta et al. Arxiv. [papel]

- [2023/02] Code as Policies: Language Model Programs for Embodied Control. Jacky Liang et al. IEEE (ICRA). [papel]

- [2022/10] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao et al. Arxiv [paper] [code]

- [2022/10] Instruction-Following Agents with Multimodal Transformer. Hao Liu et al. CVPR [paper] [code]

- [2022/07] Inner Monologue: Embodied Reasoning through Planning with Language Models. Wenlong Huang et al. Arxiv. [papel]

- [2022/07] LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action. Dhruv Shahet al. CoRL [paper] [code]

- [2022/04] Do As I Can, Not As I Say: Grounding Language in Robotic Affordances. Michael Ahn et al. Arxiv. [papel]

- [2022/01] A Survey of Embodied AI: From Simulators to Research Tasks. Jiafei Duan et al. IEEE (TETCI). [papel]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [papel] [Código]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [papel]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [papel]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arXiv. [papel] [Código]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arXiv. [papel]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [papel] [Código]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arXiv. [papel] [Código]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [papel]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [papel] [Código]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [papel] [Código]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [papel]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [papel] [Código]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [papel]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [papel]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [papel]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [papel]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [papel] [Código]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [papel] [Código]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [papel]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [papel]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [papel]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [papel]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [papel]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [papel] [Código]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [papel] [Código]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [papel] [Código]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [papel] [Código]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [papel] [Código]

2.2 Coordinating Potential of Multiple Agents

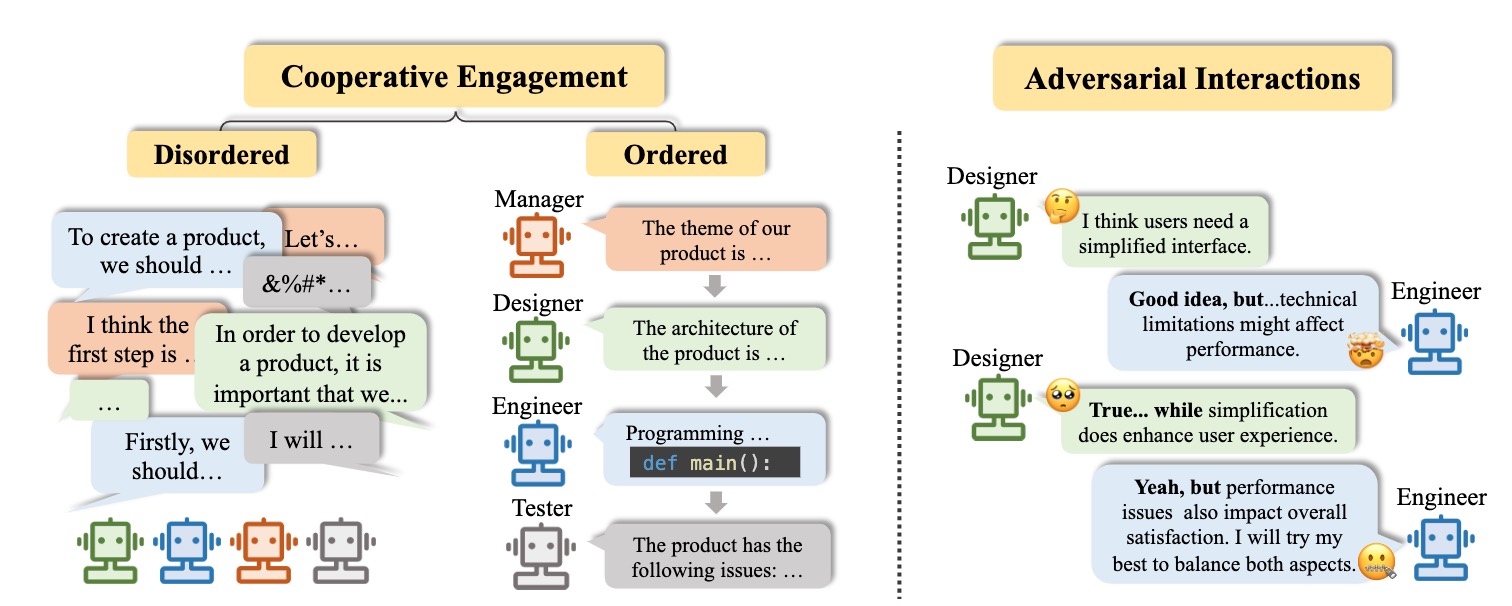

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [papel] [Código]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [papel] [Código]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [papel]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [papel]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [papel] [Código]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [papel] [Código]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [papel] [Código]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [papel]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [papel] [Código]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [papel] [Código]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [papel] [Código]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [papel] [Código]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [papel] [Código]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [papel]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [papel] [Código]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [papel] [Código]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [papel]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [papel] [Código]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [papel] [Código]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [papel]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [papel] [Código]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [papel] [Código]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [papel] [Código]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [papel]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [papel] [Código]

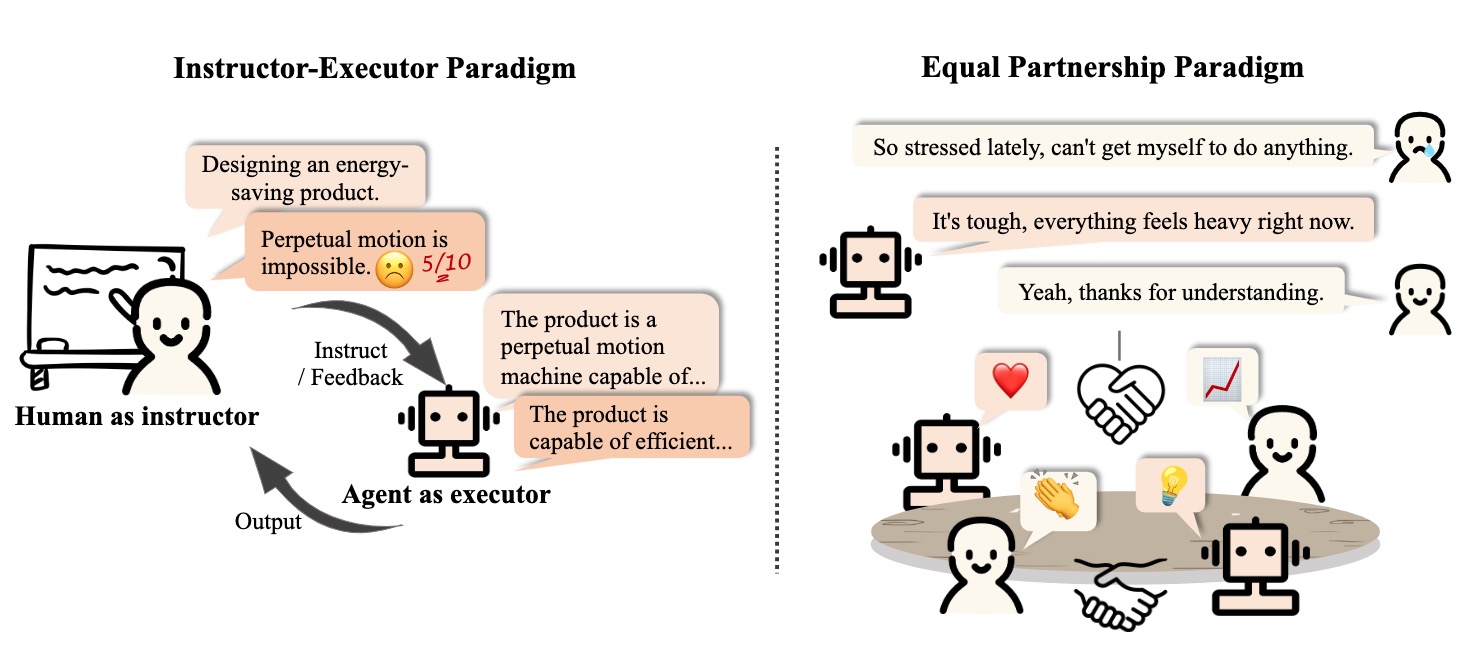

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

Educação

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [papel]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [papel]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

Saúde

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [papel] [Código]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [papel]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [papel]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [papel]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [papel]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [papel]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [papel]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [papel]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [papel]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [papel] [Código]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [papel] [Código]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [papel]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [papel]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [papel]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [papel]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [papel]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al. Ciência. [papel]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [papel]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [papel] [Código]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [papel] [Código]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [papel]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [papel] [Código]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [papel] [Código]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [papel]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [papel]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [papel] [Código]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [papel] [Código]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [papel] [Código]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [papel] [Código]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [papel] [Código]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [papel] [Código]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [papel]

3.1.2 Personality

Cognition

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [papel]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [papel]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [papel]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [papel]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [papel]

Emoção

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [papel]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [papel]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [papel]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [papel]

Personagem

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [papel] [Código]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [papel] [Código]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [papel] [Código]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [papel] [Código]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [papel]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [papel]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [papel] [Código]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [papel] [Código]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [papel]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [papel] [Código]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [papel] [Código]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [papel] [Código]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [papel] [Código]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [papel] [Código]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [papel] [Código]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [papel]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [papel] [Código]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [papel] [Código]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [papel]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [papel] [Código]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [papel]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [papel] [Código]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [paper] [code]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [papel]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [paper] [code]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [paper] [code]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [paper] [code]

Citação

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

Contato

História da estrela