La montée et le potentiel des agents basés sur un modèle de langue grande: une enquête

Doit lire des articles pour les agents basés sur LLM.

? À venir bientôt: Ajoutez une intro à une phrase à chaque article.

? Nouvelles

- ☄️ [2024/06/07] AgentGym a été publié pour développer et évoluer des agents basés sur LLM dans divers environnements!

- Papier: AgentGym.

- Page du projet: https://agentgym.github.io/.

- Codes: plate-forme et implémentations.

- HuggingFace Ressources: AgentTraj-L, AgentEval, AgentEvol-7b.

- ? [2024/05/02] R3 (formation de grands modèles de langue pour le raisonnement par l'apprentissage du renforcement du curriculum inversé) a été accepté par ICML 2024!

- ? [2024/02/08] Le nouveau papier R3 sur RL pour le raisonnement de l'agent LLM a été publié! Document: Formation de modèles de grandes langues pour raisonner grâce à l'apprentissage du renforcement du curriculum inversé. Codes: LLM-Reverse-Curriculum-RL.

- ? [2023/09/20] Ce projet a été répertorié sur les tendances GitHub! C'est un grand honneur!

- ? [2023/09/15] Notre enquête est publiée! Voir la montée et le potentiel des grands agents basés sur des modèles de langage: une enquête pour le document!

- [2023/09/14] Nous créons ce référentiel pour maintenir une liste de papier sur des agents basés sur LLM. Plus de papiers arrivent bientôt!

? Introduction

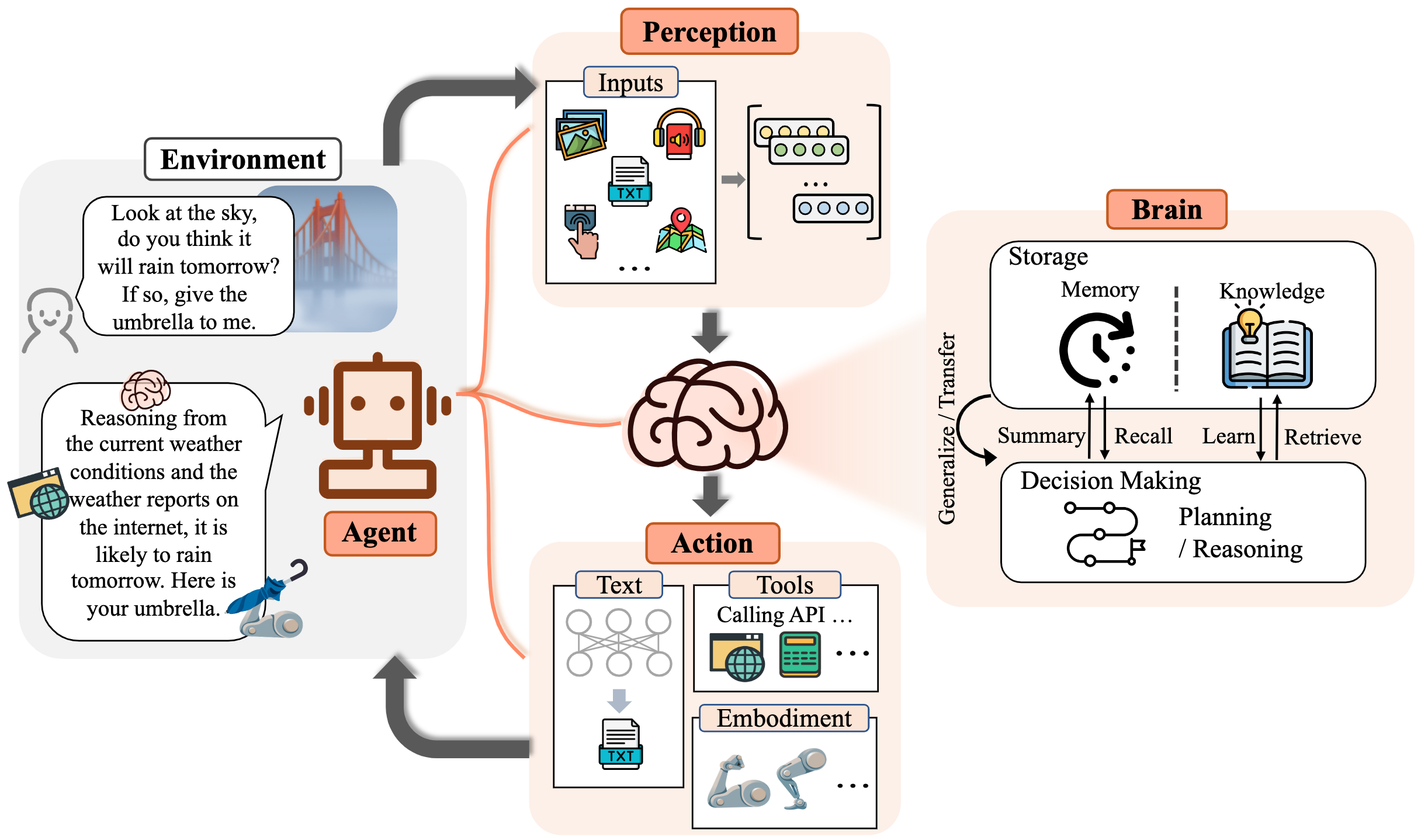

Pendant longtemps, l'humanité a poursuivi l'intelligence artificielle (IA) équivalente ou dépassant le niveau humain, avec des agents de l'IA considérés comme un véhicule prometteur de cette poursuite. Les agents de l'IA sont des entités artificielles qui ressentent leur environnement, prennent des décisions et prennent des mesures.

En raison des capacités polyvalentes et remarquables qu'ils démontrent, les modèles de grandes langues (LLM) sont considérés comme des étincelles potentielles pour l'intelligence générale artificielle (AGI), offrant de l'espoir pour la construction d'agents d'IA généraux. De nombreux efforts de recherche ont mis à profit les LLM comme fondation pour construire des agents de l'IA et ont réalisé des progrès significatifs.

Dans ce référentiel, nous fournissons une enquête systématique et complète sur les agents basés sur LLM et répertorions certains articles à lire à lire.

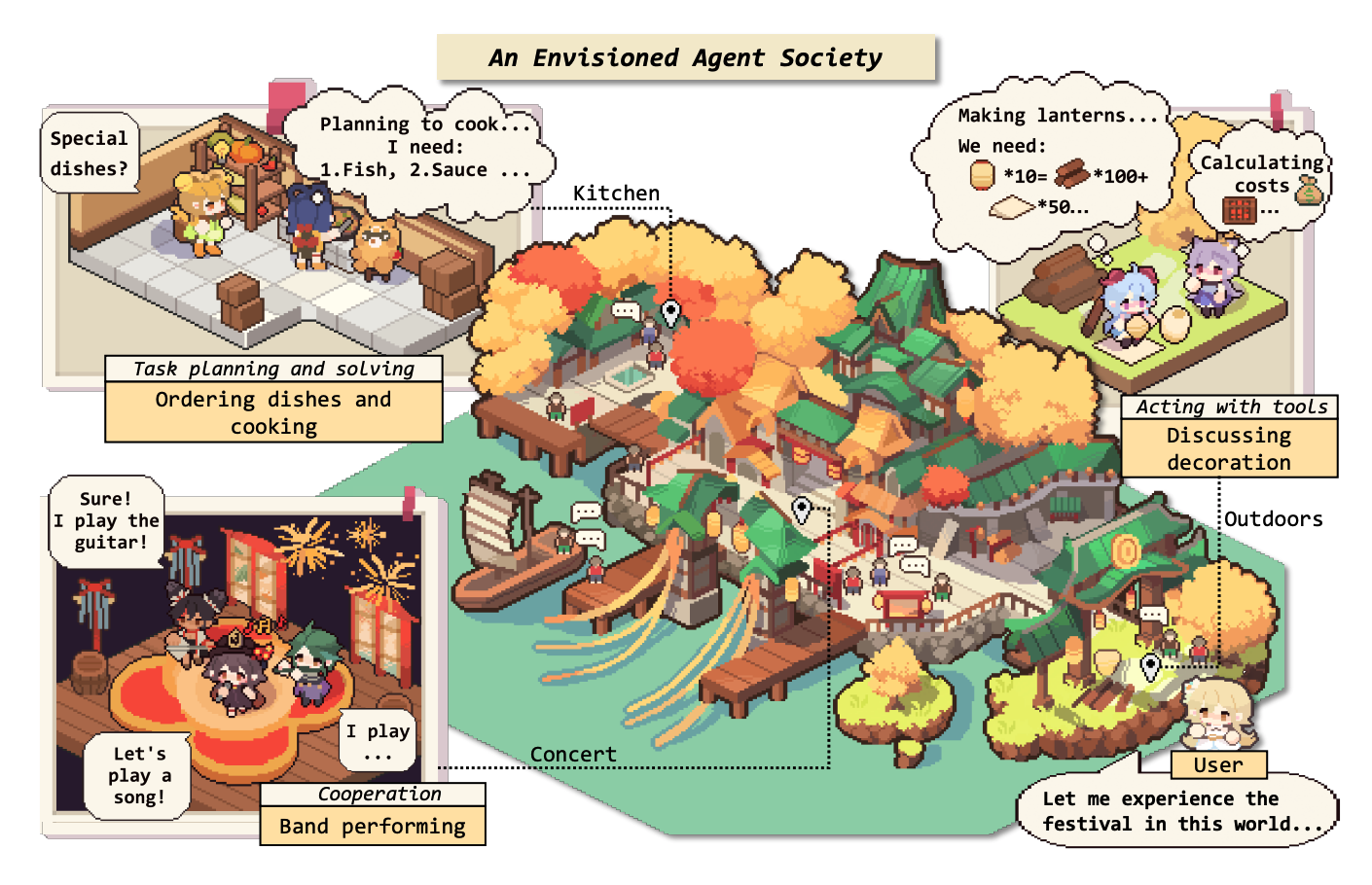

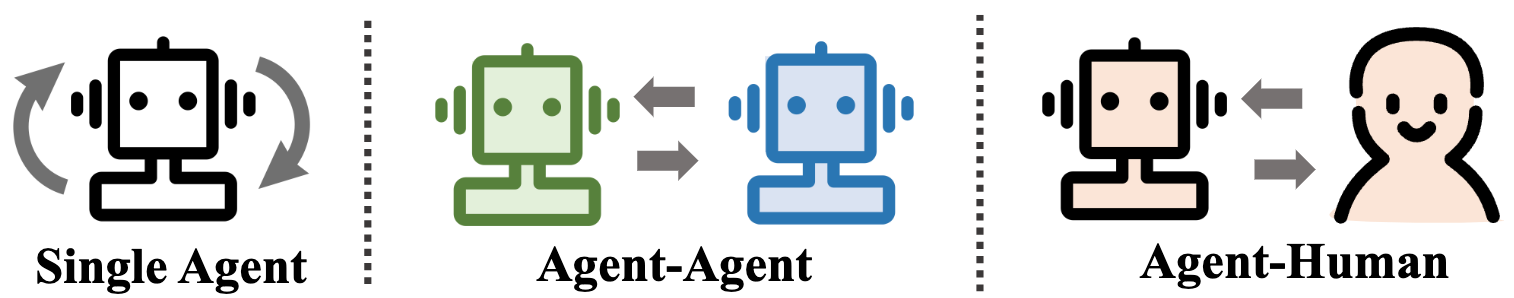

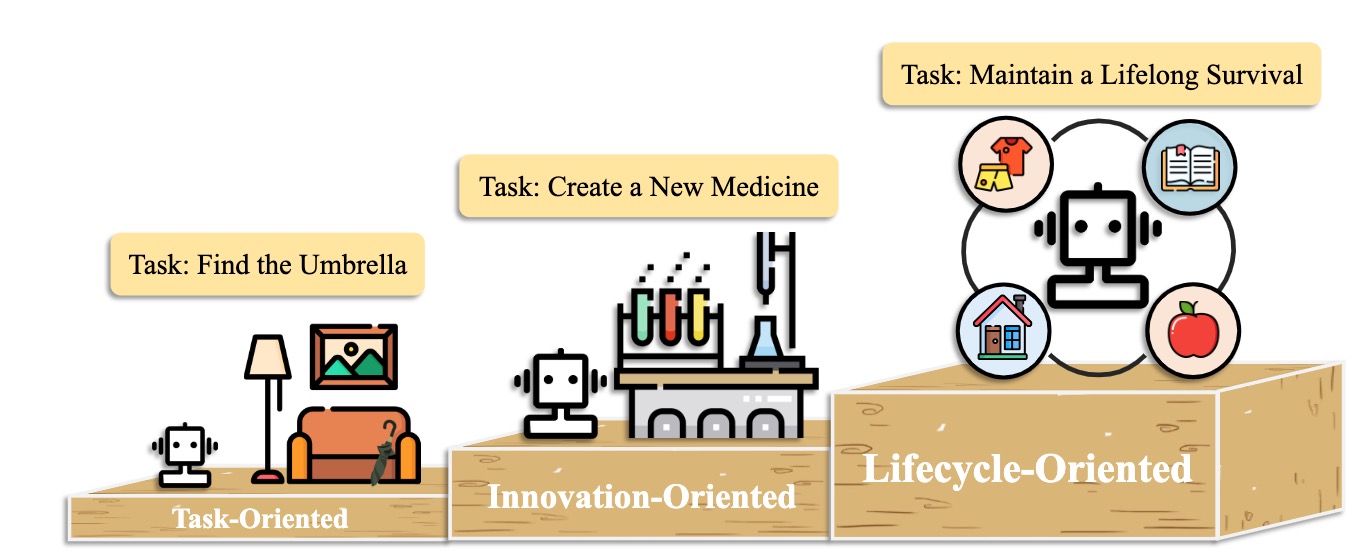

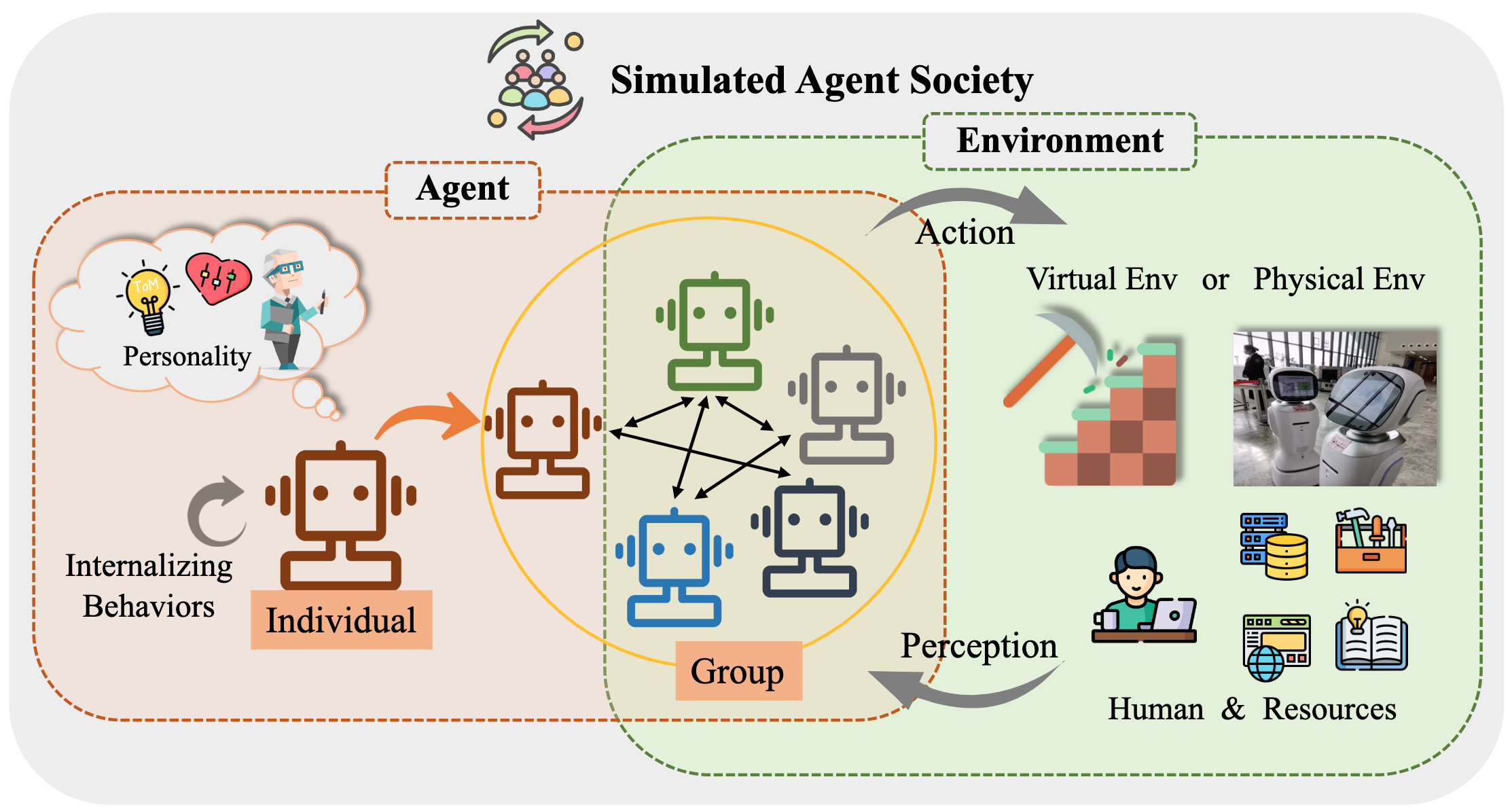

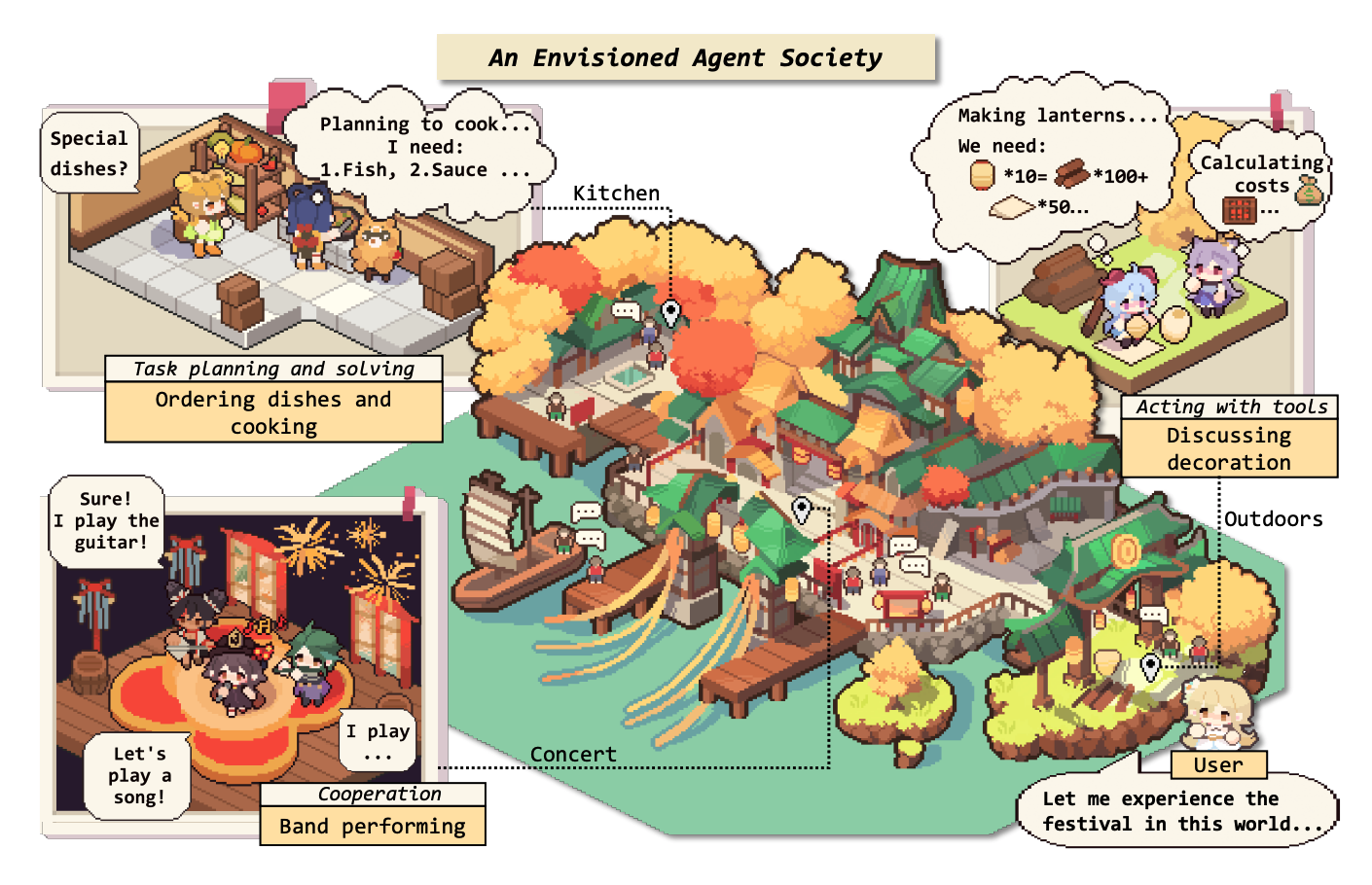

Plus précisément, nous commençons par le cadre conceptuel général pour les agents basés sur LLM: comprenant trois composantes principales: le cerveau, la perception et l'action, et le cadre peut être adapté à différentes applications. Par la suite, nous explorons les applications approfondies des agents basés sur LLM sous trois aspects: scénarios d'agent unique, scénarios multi-agents et coopération d'agent humain. Suite à cela, nous nous plongeons dans les sociétés d'agent, explorant le comportement et la personnalité des agents basés sur LLM, les phénomènes sociaux qui émergent lorsqu'ils forment des sociétés et les idées qu'ils offrent à la société humaine. Enfin, nous discutons d'une gamme de sujets clés et de problèmes ouverts dans le domaine.

Nous apprécions grandement toute contribution via PRS, problèmes, e-mails ou autres méthodes.

Tableau de contenu (TOC)

- La montée et le potentiel des agents basés sur un modèle de langue grande: une enquête

- ? Nouvelles

- ? Introduction

- Tableau de contenu (TOC)

- 1. La naissance d'un agent: construction d'agents basés sur LLM

- 1.1 Brain: principalement composé d'un LLM

- 1.1.1 Interaction du langage naturel

- Génération de haute qualité

- Compréhension approfondie

- 1.1.2 Connaissances

- Modèle de pré-séjour

- Connaissance linguistique

- Connaissances de bon sens

- Connaissances exploitables

- Problèmes potentiels de la connaissance

- 1.1.3 Mémoire

- Capacité de mémoire

- Augmenter la limite de longueur des transformateurs

- Résumer la mémoire

- Comprimer des souvenirs avec des vecteurs ou des structures de données

- Récupération de la mémoire

- 1.1.4 Raisonnement et planification

- Raisonnement

- Planification

- Formulation de plan

- Planifier la réflexion

- 1.1.5 Transférabilité et généralisation

- Généralisation des tâches invisibles

- Apprentissage en contexte

- Apprentissage continu

- 1.2 Perception: entrées multimodales pour les agents basés sur LLM

- 1.3 Action: élargir l'espace d'action des agents basés sur LLM

- 1.3.1 Utilisation de l'outil

- 1.3.2 Action incarnée

- 2. Agents in Practice: Applications des agents basés sur LLM

- 2.1 Capacité générale de l'agent unique

- 2.1.1 Déploiement axé sur les tâches

- 2.1.2 Déploiement axé sur l'innovation

- 2.1.3 Déploiement axé sur le cycle de vie

- 2.2 Potentiel de coordination de plusieurs agents

- 2.2.1 Interaction coopérative pour la complémentarité

- 2.2.2 Interaction contradictoire pour l'avancement

- 2.3 Engagement interactif entre humain et agent

- 2.3.1 Paradigme de l'instructeur-excuteur

- Éducation

- Santé

- Autre application

- 2.3.2 Paradigme de partenariat égal

- Communicateur empathique

- Participant au niveau de l'homme

- 3. Société d'agent: de l'individualité à la socialité

- 3.1 Comportement et personnalité des agents basés sur LLM

- 3.1.1 Comportement social

- Comportements individuels

- Comportements de groupe

- 3.1.2 Personnalité

- Cognition

- Émotion

- Personnage

- 3.2 Environnement pour la société d'agent

- 3.2.1 Environnement textuel

- 3.2.2 Environnement de bac à sable virtuel

- 3.2.3 Environnement physique

- 3.3 Simulation de la société avec des agents basés sur LLM

- 4. Autres sujets

- 4.1 Benchmarks pour les agents basés sur LLM

- 4.2 Formation et optimisation des agents basés sur LLM

- Citation

- RETOURS ET CONTRIBURES DE PROJET

- Contact

- Histoire des étoiles

1. La naissance d'un agent: construction d'agents basés sur LLM

1.1 Brain: principalement composé d'un LLM

1.1.1 Interaction du langage naturel

Génération de haute qualité

- [2023/10] Vers la prise de décision incarnée de bout en bout via un modèle de langage grand multimodal: explorations avec GPT4-vision et au-delà de Liang Chen et al. arXiv. [papier] [Code]

- Ce travail propose PCA-EVAL, qui benchmarks incarne la prise de décision via une méthode de bout en bout basée sur MLLM et des méthodes d'utilisation d'outils basées sur LLM à partir de la perception, de la cognition et des niveaux d'action.

- [2023/08] Une évaluation multimodale multimodale et multimodale du Chatgpt sur le raisonnement, l'hallucination et l'interactivité. Yejin Bang et al. arXiv. [papier]

- Ce travail évalue les aspects multiples, multilingues et multimodaux de Chatgpt en utilisant 21 ensembles de données couvrant 8 différentes tâches d'application NLP communes.

- [2023/06] LLM-EVAL: évaluation automatique multidimensionnelle unifiée pour les conversations en domaine ouvert avec des modèles de grands langues. Yen-Ting Lin et al. arXiv. [papier]

- La méthode LLM-Eval évalue plusieurs dimensions de l'évaluation, telles que le contenu, la grammaire, la pertinence et la pertinence.

- [2023/04] Chatgpt est-il un système de correction d'erreur grammatical très fluide? Une évaluation complète. Tao Fang et al. arXiv. [papier]

- Les résultats de l'évaluation démontrent que ChatGpt a d'excellentes capacités de détection d'erreur et peut correctement corriger les erreurs pour rendre les phrases corrigées très courantes. De plus, ses performances dans les paramètres non anglophones et à faibles ressources mettent en évidence son potentiel dans les tâches GEC multilingues.

Compréhension approfondie

- [2023/06] Hans intelligent ou théorie neurale de l'esprit? Test de stress Raisonnement social dans les modèles de grande langue. Natalie Shapira et al. arXiv. [papier]

- Les LLM présentent certaines théorie des capacités de l'esprit, mais ce comportement est loin d'être robuste.

- [2022/08] déduire les récompenses du langage dans le contexte. Jessy Lin et al. ACL. [papier]

- Ce travail présente un modèle qui tire des récompenses du langage et prédit des actions optimales dans un environnement invisible.

- [2021/10] Théorie de la communication d'assistance basée sur l'esprit dans la coopération complexe des robots humains. Moritz C. Buehler et al. arXiv. [papier]

- Ce travail conçoit un agent sushis avec une compréhension de l'humain pendant l'interaction.

1.1.2 Connaissances

Modèle de pré-séjour

- [2023/04] Apprentissage des représentations distribuées des phrases à partir de données non étiquetées. Felix Hill (Université de Cambridge) et al. arXiv. [papier]

- [2020/02] Combien de connaissances pouvez-vous emballer dans les paramètres d'un modèle de langue? Adam Roberts (Google) et al. arXiv. [papier]

- [2020/01] Échelle des lois pour les modèles de langage neuronal. Jared Kaplan (Université Johns Hopkins) et al. arXiv. [papier]

- [2017/12] Connaissances de bon sens dans l'intelligence machine. Niket Tandon (Allen Institute for Artificial Intelligence) et al. Sigmod. [papier]

- [2011/03] Traitement du langage naturel (presque) à partir de zéro. Ronan Collobert (Princeton) et al. arXiv. [papier]

Connaissance linguistique

- [2023/02] Une évaluation multimodale multimodale, multilingue et multimodale du raisonnement, de l'hallucination et de l'interactivité. Yejin Bang et al. arXiv. [papier]

- [2021/06] Probant des modèles de langage pré-formés pour les attributs sémantiques et leurs valeurs. Meriem Beloucif et al. EMNLP. [papier]

- [2020/10] sonder des modèles de langage pré-entraîné pour la sémantique lexicale. Ivan Vullić et al. arXiv. [papier]

- [2019/04] Une sonde structurelle pour trouver une syntaxe dans les représentations des mots. John Hewitt et al. ACL. [papier]

- [2016/04] Amélioration de l'extraction automatique des mots clés compte tenu des connaissances plus sémantiques. H Leung. Systèmes pour applications avancées. [papier]

Connaissances de bon sens

- [2022/10] Les modèles de code linguistiques sont des apprenants de bon sens à quelques coups. Aman Madaan et al.arxiv. [papier]

- [2021/04] Représentation des connaissances du monde relationnel dans les modèles de langage contextuel: une revue. Tara Safavi et al. arXiv. [papier]

- [2019/11] Comment pouvons-nous savoir ce que les modèles de langue savent? Zhengbao Jiang et al.arxiv. [papier]

Connaissances exploitables

- [2023/07] Modèles de grande langue en médecine. Arun James Thirunavukarasu et al. nature. [papier]

- [2023/06] DS-1000: une référence naturelle et fiable pour la génération de code scientifique des données. Yuhang Lai et al. Icml. [papier]

- [2022/10] Les modèles de code linguistiques sont des apprenants de bon sens à quelques coups. Aman Madaan et al. arXiv. [papier]

- [2022/02] Une évaluation systématique des modèles de code de grande langue. Frank F. Xu et al.arxiv. [papier]

- [2021/10] Formation de vérificateurs pour résoudre les problèmes de mots mathématiques. Karl Cobbe et al. arXiv. [papier]

Problèmes potentiels de la connaissance

- [2023/10] Freshllms: Modèles de grande langue rafraîchissants avec augmentation du moteur de recherche. Tu vu (Google) et al. arXiv [papier] [code]

- [2023/05] Édition de grands modèles de langage: problèmes, méthodes et opportunités. Yunzhi Yao et al. arXiv. [papier]

- [2023/05] Modules auto-vérifiables: modules de plug-and-play pour la vérification des faits avec des modèles de grands langues. Miaoran Li et al. arXiv. [papier]

- [2023/05] Critique: les modèles de grandes langues peuvent s'auto-corriger avec une critique interactive-outil. Zhibin Gou et al. arXiv. [papier]

- [2023/04] Apprentissage d'outils avec des modèles de fondation. Yujia Qin et al. arXiv. [papier]

- [2023/03] SelfCheckgpt: détection d'hallucination noire zéro-ressource pour les modèles génératifs de grande langue. Potsawee Manakul et al. arXiv. [papier]

- [2022/06] Édition de modèle basée sur la mémoire à grande échelle. Eric Mitchell et al. arXiv. [papier]

- [2022/04] Une revue sur les modèles de langue comme bases de connaissances. Badr Alkhamisssi et al.arxiv. [papier]

- [2021/04] Modification des connaissances factuelles dans les modèles de langue. Nicola de Cao et al.arxiv. [papier]

- [2017/08] Mesurer l'oubli catastrophique dans les réseaux de neurones. Ronald Kemker et al.arxiv. [papier]

1.1.3 Mémoire

Capacité de mémoire

Augmenter la limite de longueur des transformateurs

- [2023/10] MEMGPT: Vers LLMS en tant que systèmes d'exploitation. Charles Packer (UC Berkeley) et al. arXiv. [Paper] [Page du projet] [Code] [ensemble de données]

- [2023/05] Les codages de position randomisés augmentent la généralisation de la longueur des transformateurs. Anian Ruoss (Deepmind) et al. arXiv. [papier] [Code]

- [2023-03] COLT5: Transformers à longue portée plus rapides avec calcul conditionnel. Joshua Ainslie (Google Research) et al. arXiv. [papier]

- [2022/03] Classification efficace des documents longs à l'aide de transformateurs. Hyunji Hayley Park (Illinois University) et al. arXiv. [papier] [Code]

- [2021/12] Longt5: transformateur text-to-texte efficace pour les séquences longues. Mandy Guo (Google Research) et al. arXiv. [papier] [Code]

- [2019/10] BART: pré-formation de séquence à la séquence à la séquence pour la génération, la traduction et la compréhension du langage naturel. Michael Lewis (Facebook AI) et al. arXiv. [papier] [Code]

Résumer la mémoire

- [2023/10] En descendant dans le labyrinthe de mémoire: au-delà de la limite de contexte par la lecture interactive Howard Chen (Princeton University) et al. arXiv. [papier]

- [2023/09] Autonomiser le tutorat privé par les modèles de grande langue de grande langue Yulin Chen (Université Tsinghua) et al. arXiv. [papier]

- [2023/08] Expulsion: les agents LLM sont des apprenants expérientiels. Andrew Zhao (Université Tsinghua) et al. arXiv. [papier] [Code]

- [2023/08] Chateval: Vers de meilleurs évaluateurs basés sur LLM par le biais d'un débat multi-agents. Chi-Min Chan (Université Tsinghua) et al. arXiv. [papier] [Code]

- [2023/05] MemoryBank: Amélioration des modèles de langues grands avec mémoire à long terme. Wanjun Zhong (Harbin Institute of Technology) et al. arXiv. [papier] [Code]

- [2023/04] Agents génératifs: simulacra interactif du comportement humain. Joon Sung Park (Stanford University) et al. arXiv. [papier] [Code]

- [2023/04] Lifère la capacité d'entrée de longueur infinie pour les modèles de langage à grande échelle avec un système de mémoire auto-contrôlé. Xinnian Liang (Université Beihang) et al. arXiv. [papier] [Code]

- [2023/03] Réflexion: agents linguistiques avec apprentissage par renforcement verbal. Noah Shinn (Northeastern University) et al. arXiv. [papier] [Code]

- [2023/05] RecurrentGpt: génération interactive de texte long (arbitrairement). Wangchunshu Zhou (Aiwaves) et al. arXiv. [papier] [Code]

Comprimer des souvenirs avec des vecteurs ou des structures de données

- [2023/07] Agents communicatifs pour le développement de logiciels. Chen Qian (Université Tsinghua) et al. arXiv. [papier] [Code]

- [2023/06] CHATDB: augmenter les LLM avec des bases de données comme mémoire symbolique. Chenxu Hu (Université Tsinghua) et al. arXiv. [papier] [Code]

- [2023/05] Ghost in the Minecraft: des agents généralement capables pour les environnements en monde ouvert via des modèles de grands langues avec des connaissances et de la mémoire basées sur le texte. Xizhou Zhu (Université Tsinghua) et al. arXiv. [papier] [Code]

- [2023/05] RET-LLM: Vers une mémoire générale en lecture pour les modèles de grande langue. Ali Modarresssi (LMU Munich) et al. arXiv. [papier] [Code]

- [2023/05] RecurrentGpt: génération interactive de texte long (arbitrairement). Wangchunshu Zhou (Aiwaves) et al. arXiv. [papier] [Code]

Récupération de la mémoire

- [2023/08] Sandbox de mémoire: gestion de la mémoire transparente et interactive pour les agents conversationnels. Ziheng Huang (Université de Californie - San Diego) et al. arXiv. [papier]

- [2023/08] AgentsIms: un bac à sable open source pour l'évaluation du modèle de langue grande. Jiaju Lin (PTA Studio) et al. arXiv. [Paper] [Page du projet] [Code]

- [2023/06] CHATDB: augmenter les LLM avec des bases de données comme mémoire symbolique. Chenxu Hu (Université Tsinghua) et al. arXiv. [papier] [Code]

- [2023/05] MemoryBank: Amélioration des modèles de langues grands avec mémoire à long terme. Wanjun Zhong (Harbin Institute of Technology) et al. arXiv. [papier] [Code]

- [2023/04] Agents génératifs: simulacra interactif du comportement humain. Joon Sung Park (Stanford) et al. arXiv. [papier] [Code]

- [2023/05] RecurrentGpt: génération interactive de texte long (arbitrairement). Wangchunshu Zhou (Aiwaves) et al. arXiv. [papier] [Code]

1.1.4 Raisonnement et planification

Raisonnement

[2024/02] Formation de modèles de grandes langues pour le raisonnement par l'apprentissage du renforcement du curriculum inversé. Zhiheng Xi (Fudan University) et al. arXiv. [papier] [Code]

[2023/09] CONCRIPATION: La conférence de la table ronde améliore le raisonnement via un consensus entre diverses LLM. Justin Chih-Yao Chen (Université de Caroline du Nord à Chapel Hill) et al. arXiv. [papier] [Code]

[2023/05] Auto-polonais: améliorer le raisonnement dans les modèles de gros langues via le raffinement des problèmes. Zhiheng Xi (Fudan University) et al. arXiv. [papier] [Code]

[2023-03] Les grands modèles de langue sont des raisonneurs à tirs zéro. Takeshi Kojima (Université de Tokyo) et al. arXiv. [papier] [Code]

[2023/03] Auto-raffine: raffinement itératif avec auto-alimentation. Aman Madaan (Carnegie Mellon University) et al. arXiv. [papier] [Code]

[2022/05] Indigence de sélection: exploiter des modèles de langues importants pour le raisonnement logique interprétable. Antonia Creswell (Deepmind) et al. arXiv. [papier]

[2022/03] L'auto-cohérence améliore le raisonnement de la chaîne de pensée dans les modèles de langue. Xuezhi Wang (Google Research) et al. arXiv. [papier] [Code]

[2023/02] Raisonnement multimodal de la chaîne de pensées dans les modèles de langue. ZhuoSheng Zhang (Université Shanghai Jiao Tong) et al. arXiv. [papier] [Code]

[2022/01] L'incitation en chaîne de pensées suscite le raisonnement dans les modèles de grande langue. Jason Wei (Google Research) et al. arXiv. [papier]

Planification

Formulation de plan

- [2023/11] JARVIS-1: Agents multi-tâches du monde ouvert avec des modèles de langage multimodal auprès de la mémoire. Zihao Wang (Université de Pékin) et al. arXiv. [papier] [Code]

- [2023/10] La recherche d'arbre d'agent linguistique unifie le raisonnement et la planification dans les modèles de langage. Andy Zhou (Université de l'Illinois Urbana-Champaign) et al. arXiv. [Paper] [Page du projet] [Code]

- [2023/05] ARBRE DE PENSÉES: résolution de problèmes délibérée avec de grands modèles de langage. Shunyu Yao (Princeton University) et al. arXiv. [papier] [Code]

- [2023/05] Planifier, éliminer et suivre les modèles de langue sont de bons enseignants pour les agents incarnés. Yue Wu (Université Carnegie Mellon) et al. arXiv. [papier]

- [2023/05] Le raisonnement avec le modèle de langue est la planification avec le modèle mondial. Shibo Hao (UC San Diego) et al. arXiv. [papier] [Code]

- [2023/05] Swiftsage: un agent génératif avec une réflexion rapide et lente pour les tâches interactives complexes. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [papier] [Code]

- [2023/04] LLM + P: autonomiser les modèles de gros langues avec une maîtrise de planification optimale. Bo Liu (Université du Texas à Austin) et al. arXiv. [papier] [Code]

- [2023/03] Hugginggpt: résoudre des tâches AI avec Chatgpt et ses amis dans l'étreinte. Yongliang Shen (Microsoft Research Asia) et al. arXiv. [papier] [Code]

- [2023/02] Décrire, expliquer, planifier et sélectionner: la planification interactive avec des modèles de gros langues permet aux agents multi-tâches en monde ouvert. Zihao Wang (Université de Pékin) et al. arXiv. [papier] [Code]

- [2022/05] La moindre incitation la plus élevée permet un raisonnement complexe dans les modèles de grande langue. Denny Zhou (Google Research) et al. arXiv. [papier]

- [2022/05] Systèmes MRKL: une architecture modulaire et neuro-symbolique qui combine de grands modèles de langage, des sources de connaissances externes et un raisonnement discret. Ehud Karpas (AI21 Labs) et al. arXiv. [papier]

- [2022/04] Faites ce que je peux, pas comme je le dis: la langue de mise à la terre dans les possibilités robotiques. Michael Ahn (robotique chez Google) et al. arXiv. [papier]

- [2023/05] Agents: un cadre open source pour les agents en langue autonome. Wangchunshu Zhou (Aiwaves) et al. arXiv. [papier] [Code]

- [2022/12] Ne générez pas, discriminez: une proposition de mise à la terre des modèles de langage dans des environnements réels. Yu Gu (l'Ohio State University) et al. ACL. [papier] [Code]

Planifier la réflexion

- [2024/02] Agent-PRO: Apprendre à évoluer via la réflexion et l'optimisation au niveau de la politique Wenqi Zhang (Zhejiang University) et al. arXiv. [papier] [Code]

- [2024/01] Contraste de soi: meilleure réflexion à travers des perspectives de résolution incohérentes Wenqi Zhang (Université de Zhejiang) et al. arXiv. [papier]

- [2023/11] JARVIS-1: Agents multi-tâches du monde ouvert avec des modèles de langage multimodal auprès de la mémoire. Zihao Wang (Université de Pékin) et al. arXiv. [papier] [Code]

- [2023/10] La chaîne de vérification réduit l'hallucination dans les modèles de grande langue. Shehzaad Dhuliawa (Meta Ai & Eth Zu ̈rich) et al. arXiv. [papier]

- [2023/10] FIREACT: Vers l'agent linguistique affineur. Baian Chen (System2 Research) et al. arXiv. [Paper] [Page du projet] [Code] [ensemble de données]

- [2023/08] SelfCheck: Utilisation de LLMS pour zero-shot Vérifiez leur propre raisonnement étape par étape. Ning Miao (Université d'Oxford) et al. arXiv. [papier] [Code]

- [2023/05] CHATCOT: raisonnement en chaîne de la chaîne auprès d'outils sur les modèles de grande langue basés sur le chat. Zhipng Chen (Université Renmin de Chine) et al. arXiv. [papier] [Code]

- [2023/05] Voyager: un agent incarné à extrémité ouverte avec de grands modèles de langage. Guanzhi Wang (Nvidia) et al. arXiv. [Paper] [Page du projet] [Code]

- [2023/03] Discutez avec l'environnement: perception multimodale interactive à l'aide de modèles de langues importants. Xufeng Zhao (University Hambourg) et al. arXiv. [papier] [Code]

- [2022/12] LLM-Planner: Planification fondée sur quelques tirs pour les agents incarnés avec de grands modèles de langage. Chan Hee Song (The Ohio State University) et al. arXiv. [papier] [Code]

- [2022/10] REACT: Synergie Raisonnement et Agissant dans les modèles de langage. Shunyu Yao (Princeton University) et al. arXiv. [papier] [Code]

- [2022/07] Monologue intérieur: raisonnement incarné par la planification avec des modèles de langue. Wenlong Huang (robotique chez Google) et al. arXiv. [papier] [Code]

- [2021/10] Chaînes AI: interaction humain-AI transparente et contrôlable par le chaîne de modèles de gros langage. Tonghuang Wu (Université de Washington) et al. arXiv. [papier]

1.1.5 Transférabilité et généralisation

Généralisation des tâches invisibles

- [2024/06] AgentGyM: évoluer des agents basés sur un modèle de langue dans divers environnements. Zhiheng Xi (Fudan University) et al. arXiv. [Paper] [Page du projet] [codes et plate-forme] [ensemble de données] [Benchmark] [modèle].

- [2023/10] Agenttuning: permettant des capacités d'agent généralisées pour les LLM. Aohan Zeng (Université Tsinghua) et al. arXiv. [Paper] [Page du projet] [Code] [ensemble de données]

- [2023/10] Lemur: harmonisation du langage naturel et du code pour les agents linguistiques Yiheng Xu (Université de Hong Kong) et al. arXiv. [papier] [Code]

- [2023/05] Formation de modèles de langue pour suivre les instructions avec la rétroaction humaine. Long Ouyang et al. Neurips. [papier]

- InstructGPT: Alignez les modèles de langue avec l'utilisateur inscrit sur un large éventail de tâches en affinant avec les commentaires humains.

- [2023/01] La formation invitée multitâche permet une généralisation des tâches à tirs zéro. Victor Sanh et al. Iclr. [papier] [Code]

- T0: T0 est un modèle d'encodeur-décodeur qui consomme des entrées textuelles et produit des réponses cibles. Il est formé sur un mélange multitâche d'ensembles de données NLP partitionnés en différentes tâches.

- [2022/10] Modèles de langage d'instructions à l'échelle. Hyung a remporté Chung et al. arXiv. [papier] [Code]

- Ce travail explore l'instruction en train de financer avec un accent particulier sur la mise à l'échelle du nombre de tâches et de la taille du modèle, ce qui améliore les performances d'une variété de classes de modèles, d'incitation aux configurations et de références d'évaluation.

- [2022/08] Les modèles de langage finetuné sont des apprenants à tirs zéro. Jason Wei et al. Iclr. [papier]

- FLAN: Le réglage des instructions améliore considérablement les performances de zéro sur les tâches invisibles.

Apprentissage en contexte

- [2023/08] Les images parlent en images: un peintre généraliste pour l'apprentissage visuel dans le contexte. Xinlong Wang et al. IEEE. [papier] [Code]

- Painter: Ce travail présente un modèle généraliste pour l'apprentissage visuel en contexte avec une solution centrale "image".

- [2023/08] Les modèles de langage de codec neuronal sont des synthétiseurs de texte à tirs zéro. Chengyi Wang et al. arXiv. [papier] [Code]

- VALL-E: Ce travail forme un modèle de langage de codec neural, qui émerge les capacités d'apprentissage en contexte.

- [2023/07] Une enquête pour l'apprentissage dans le contexte. Qingxiu Dong et al. arXiv. [papier]

- Cette enquête résume les progrès et les défis de l'apprentissage en contexte (ICL).

- [2023/05] Les modèles de langue sont des apprenants à quelques coups. Tom B. Brown (Openai) et al. Neurips. [papier]

- GPT-3: La mise à l'échelle des modèles de langage améliore considérablement les performances agnostiques de tâche, à quelques coups, devenant parfois même compétitives avec des approches de réglage fin de pointe.

Apprentissage continu

- [2023/11] JARVIS-1: Agents multi-tâches du monde ouvert avec des modèles de langage multimodal auprès de la mémoire. Zihao Wang (Université de Pékin) et al. arXiv. [papier] [Code]

- [2023/07] Invites progressives: apprentissage continu pour les modèles de langue. Razdaibiedina et al. arXiv. [papier]

- Ce travail introduit des invites progressives, qui permet un transfert vers l'avant et résiste à l'oubli catastrophique, sans s'appuyer sur la rediffusion de données ou un grand nombre de paramètres spécifiques à la tâche.

- [2023/05] Voyager: un agent incarné à extrémité ouverte avec de grands modèles de langage. Guanzhi Wang (Nvidia) et al. arXiv. [Paper] [Page du projet] [Code]

- Voyager: Il s'agit d'un exemple d'agent d'apprentissage intégré à vie à LLM à Minecraft qui explore continuellement le monde, acquiert diverses compétences et fait de nouvelles découvertes sans intervention humaine.

- [2023/01] Une étude complète de l'apprentissage continu: théorie, méthode et application. Liyuan Wang et al. arXiv. [papier]

- Cette enquête présente une enquête complète sur l'apprentissage continu, cherchant à combler les paramètres de base, les fondations théoriques, les méthodes représentatives et les applications pratiques.

- [2022/11] Apprentissage continu des tâches de traitement du langage naturel: une enquête. Zixuan Ke et al. arXiv. [papier]

- Cette enquête présente une revue complète et une analyse des progrès récents du CL dans la PNL.

1.2 Perception: entrées multimodales pour les agents basés sur LLM

1.2.1 visuel

- [2024/01] Agent AI: surveillance des horizons de l'interaction multimodale. Zane Durante et al. arXiv. [papier]

- [2023/10] Vers la prise de décision incarnée de bout en bout via un modèle de langage grand multimodal: explorations avec GPT4-vision et au-delà de Liang Chen et al. arXiv. [papier] [Code]

- [2023/05] La langue n'est pas tout ce dont vous avez besoin: aligner la perception avec les modèles de langue. Shaohan Huang et al. arXiv. [papier]

- [2023/05] InstructBlip: vers des modèles de langue de vision générale avec réglage des instructions. Wenliang Dai et al. arXiv. [papier]

- [2023/05] Multimodal-GPT: un modèle de vision et de langue pour le dialogue avec les humains. Tao Gong et al. arXiv. [papier]

- [2023/05] Pandagpt: un modèle pour les suivre tous. Yixuan Su et al. arXiv. [papier]

- [2023/04] réglage de l'instruction visuelle. Haotian Liu et al. arXiv. [papier]

- [2023/04] MINIGPT-4: Amélioration de la compréhension de la vision avec des modèles avancés de grande langue. Deyao Zhu. arXiv. [papier]

- [2023/01] BLIP-2: Bootstraping Language-Image Pré-formation avec des encodeurs d'images congelés et de grands modèles de langage. Junnan Li et al. arXiv. [papier]

- [2022/04] Flamingo: un modèle de langage visuel pour l'apprentissage à quelques coups. Jean-Baptiste Alayrac et al. arXiv. [papier]

- [2021/10] Mobilevit: Transformateur de vision à usage général, à usage général et à mobile. Sachin Mehta et al.arxiv. [papier]

- [2021/05] MLP-MIXER: une architecture All-MLP pour la vision. Ilya Tolstikhin et al.arxiv. [papier]

- [2020/10] Une image vaut 16x16 mots: transformateurs pour la reconnaissance d'image à grande échelle. Alexey Dosovitskiy et al. arXiv. [papier]

- [2017/11] Apprentissage de représentation discrète neuronale. Aaron van den Oord et al. arXiv. [papier]

1.2.2 Audio

- [2023/06] VIDEO-LALAMA: un modèle de langage audio-visuel réglé par l'instruction pour la compréhension de la vidéo. Hang Zhang et al. arXiv. [papier]

- [2023/05] X-LLM: Bootstrap des modèles de grande langue avancés en traitant des multi-modalités comme des langues étrangères. Feilong Chen et al. arXiv. [papier]

- [2023/05] InternGpt: résoudre des tâches centrées sur la vision en interagissant avec le chatppt au-delà du langage. Zhaoyang Liu et al. arXiv. [papier]

- [2023/04] Audiogpt: compréhension et génération de discours, de musique, de son et de tête parlante. Rongjie Huang et al. arXiv. [papier]

- [2023/03] Hugginggpt: résoudre des tâches AI avec Chatgpt et ses amis dans l'étreinte. Yongliang Shen et al. arXiv. [papier]

- [2021/06] Hubert: Représentation de la parole auto-supervisée par prédiction masquée des unités cachées. Wei-ning Hsu et al. arXiv. [papier]

- [2021/04] AST: transformateur de spectrogramme audio. Yuan Gong et al. arXiv. [papier]

1.3 Action: élargir l'espace d'action des agents basés sur LLM

1.3.1 Utilisation de l'outil

- [2024/02] Vers l'agent linguistique incertain. Jiuzhou Han (Monash University) et al. arXiv. [Paper] [Page du projet] [Code]

- [2023/10] OpenAgents: une plate-forme ouverte pour les agents linguistiques à l'état sauvage. Xlang Lab (Université de Hong Kong) Arxiv. [Paper] [Page du projet] [Code] [Demo]

- [2023/10] Lemur: harmonisation du langage naturel et du code pour les agents linguistiques Yiheng Xu (Université de Hong Kong) et al. arXiv. [papier] [Code]

- [2023/10] Vers la prise de décision incarnée de bout en bout via un modèle de langue grande multimodale: explorations avec GPT4-vision et au-delà de Liang Chen (Université de Pékin) et al. arXiv. [papier] [Code]

- Holmes est un cadre de coopération multi-agents qui permet à LLMS de tirer parti des MLLM et des API de recueillir des informations multimodales pour la prise de décision éclairée.

- [2023/07] TOOLLLM: facilitant les modèles de grande langue pour maîtriser 16000+ API réels. Yujia Qin (Université Tsinghua) et al. arXiv. [Paper] [Code] [ensemble de données]

- TOOLLLM est un cadre général d'utilisation d'outils englobant la construction de données, la formation et l'évaluation du modèle.

- [2023/05] Modèles de grande langue en tant que fabricants d'outils. Tianle Cai (Princeton University) et al. arXiv. [papier] [Code]

- LATM est un cadre en boucle fermée qui fait une première étape vers la suppression de la dépendance à la disponibilité des outils existants.

- [2023/05] Créateur: démolir des raisons abstraites et concrètes de modèles de grande langue grâce à la création d'outils. Cheng Qian (Université Tsinghua) et al. arXiv. [papier]

- Creator est un nouveau cadre qui permet aux LLMS de créer leurs propres outils grâce à la documentation et à la réalisation du code.

- [2023/04] Apprentissage d'outils avec des modèles de fondation. Yujia Qin (Université Tsinghua) et al. arXiv. [papier] [Code]

- Cette enquête introduit principalement un nouveau paradigme appelé «apprentissage d'outils basé sur des modèles fondamentaux», qui combine les avantages des outils spécialisés et des modèles fondamentaux, atteignant une précision, une efficacité et une automatisation plus élevées dans la résolution de problèmes.

- [2023/04] ChemCrow: augmenter les modèles de grande langue avec des outils de chimie. Andres M Bran (Laboratoire de l'intelligence chimique artificielle, ISIC, EPFL) et al. arXiv. [papier] [Code]

- ChemCrow est un agent de chimie LLM qui intègre 13 outils conçus par des experts et augmente les performances LLM en chimie et émerge de nouvelles capacités.

- [2023/04] Genegpt: augmenter les modèles de gros langues avec des outils de domaine pour améliorer l'accès aux informations biomédicales. Qiao Jin (National Institutes of Health), Yifan Yang, Qingyu Chen, Zhiyong Lu. arXiv. [papier] [Code]

- Genegpt est un modèle qui répond aux questions génomiques. Il introduit une nouvelle méthode pour gérer les défis avec les hallucinations en enseignant aux LLM pour utiliser les API Web.

- [2023/04] OpenAgi: lorsque LLM rencontre des experts du domaine. Yingqiang GE (Rutgers University) et al. arXiv. [papier] [Code]

- OpenAgi est une plate-forme de recherche AGI open source. Il introduit un paradigme de LLMS fonctionnant sur divers modèles d'experts pour la résolution complexe des tâches et propose un mécanisme RLTF pour améliorer la capacité de résolution de tâches du LLM.

- [2023/03] Hugginggpt: résoudre des tâches AI avec Chatgpt et ses amis dans l'étreinte. Yongliang Shen (Université de Zhejiang) et al. arXiv. [papier] [Code]

- HuggingGpt est un système qui exploite les LLM pour connecter divers modèles d'IA multimodaux dans les communautés d'apprentissage automatique pour résoudre les tâches d'IA.

- [2023/03] Visual Chatgpt: Talking, Drawing and Modiot with Visual Foundation Models. Chenfei Wu (Microsoft Research Asia) et al. arXiv. [papier] [Code]

- Visual Chatgpt est un système qui ouvre la porte à l'étude des rôles visuels de Chatgpt à l'aide de modèles de fondation visuelle.

- [2023/02] Modèles de langue augmentée: une enquête. Grégoire Mialon (Meta Ai) et al. TMLR. [papier]

- Cette enquête examine les travaux dans lesquels les LM sont augmentées avec la possibilité d'utiliser des outils. LMS augmentée peut utiliser des modules externes pour étendre leur capacité de traitement de contexte.

- [2023/02] TOLLFORMATEUR: les modèles de langage peuvent s'apprendre à utiliser des outils. Timo Schick (Meta Ai) et al. arXiv. [papier]

- ToolFormer montre que les LLM peuvent s'apprendre à utiliser des outils externes avec une poignée de démonstrations pour chaque API.

- [2022/05] TALM: Modèles de langage augmenté d'outil. Aaron Parisi (Google) et al. arXiv. [papier]

- TALM présente une méthode qui combine des outils non différentibles avec LMS, permettant au modèle d'accéder aux données en temps réel ou privées.

- [2022/05] Systèmes MRKL: une architecture modulaire et neuro-symbolique qui combine de grands modèles de langage, des sources de connaissances externes et un raisonnement discret. Ehud Karpas (AI21 Labs) et al. arXiv. [papier]

- MRKL Systems augmente les LLM avec un ensemble facilement extensible de connaissances externes et de modules de raisonnement.

- [2022/04] Faites ce que je peux, pas comme je le dis: la langue de mise à la terre dans les possibilités robotiques. Michael Ahn (Google) et al. Corl. [papier]

- SayCan applique LMS dans les tâches robotiques du monde réel en combinant les connaissances sémantiques avancées de LLMS avec la fonction de valeur des compétences pré-formées.

- [2021/12] WebGPT: Assaillant de questions assisté par le navigateur avec commentaires humains. Reiichiro Nakano (Openai) et al. arXiv. [papier]

- WebGPT répond aux questions à l'aide d'un environnement WebBrowsing. Il utilise l'apprentissage de l'imitation pendant la formation, puis optimise la qualité des réponses grâce à la rétroaction humaine.

- [2021/07] Évaluation de modèles de gros langues formés sur le code. Mark Chen (Openai) et al. arXiv. [papier] [Code]

- Codex peut synthétiser les programmes à partir de docstrings, c'est-à-dire la création d'outils basés sur la documentation.

1.3.2 Action incarnée

- [2023/12] vers l'apprentissage d'un modèle généraliste pour la navigation incarnée. Duo Zheng (l'Université chinoise de Hong Kong) et al. arXiv. [papier] [Code]

- [2023/11] Un agent généraliste incarné dans le monde 3D. Jiangyong Huang (Bigai & Peking University) et al. arXiv. [Paper] [Page du projet]

- [2023/11] JARVIS-1: Agents multi-tâches du monde ouvert avec des modèles de langage multimodal auprès de la mémoire. Zihao Wang (Université de Pékin) et al. arXiv. [papier] [Code]

- [2023/10] Lemur: harmonisation du langage naturel et du code pour les agents linguistiques Yiheng Xu (Université de Hong Kong) et al. arXiv. [papier] [Code]

- [2023/10] Vers la prise de décision incarnée de bout en bout via un modèle de langage grand multimodal: explorations avec GPT4-vision et au-delà de Liang Chen et al. arXiv. [papier] [Code]

- [2023/07] Langue interactive: parler aux robots en temps réel. Corey Lynch et al. IEEE (RAL) [papier]

- [2023/05] Voyager: un agent incarné à extrémité ouverte avec de grands modèles de langage. Guanzhi Wang (Nvidia) et al. arXiv. [Paper] [Page du projet] [Code]

- [2023/05] Avlen: navigation incarnée en langage audio-visuel dans les environnements 3D. Sudipta Paul et al. Neurips. [papier]

- [2023/05] incarnégpt: pré-formation en langue visuelle via une chaîne de pensée incarnée. Yao Mu et al. ArXiv [papier] [code]

- [2023/05] NAVGPT: Raisonnement explicite dans la navigation de vision et de langage avec des modèles de grands langues. Gengze Zhou et al. ArXiv [papier]

- [2023/05] Alphablock: finetun incarné pour le raisonnement en langue visuelle dans la manipulation du robot. Chuhao Jin et al. ArXiv [papier]

- [2023/03] PALM-E: Un modèle de langage multimodal incarné. Danny Driess et al. ArXiv. [papier]

- [2023/03] Réflexion: agents linguistiques avec apprentissage par renforcement verbal. Noah Shinn et al. Arxiv [paper] [code]

- [2023/02] Collaborating with language models for embodied reasoning. Ishita Dasgupta et al. Arxiv. [papier]

- [2023/02] Code as Policies: Language Model Programs for Embodied Control. Jacky Liang et al. IEEE (ICRA). [papier]

- [2022/10] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao et al. Arxiv [paper] [code]

- [2022/10] Instruction-Following Agents with Multimodal Transformer. Hao Liu et al. CVPR [paper] [code]

- [2022/07] Inner Monologue: Embodied Reasoning through Planning with Language Models. Wenlong Huang et al. Arxiv. [papier]

- [2022/07] LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action. Dhruv Shahet al. CoRL [paper] [code]

- [2022/04] Do As I Can, Not As I Say: Grounding Language in Robotic Affordances. Michael Ahn et al. Arxiv. [papier]

- [2022/01] A Survey of Embodied AI: From Simulators to Research Tasks. Jiafei Duan et al. IEEE (TETCI). [papier]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [papier] [Code]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [papier]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [papier]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arXiv. [papier] [Code]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arXiv. [papier]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [papier] [Code]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arXiv. [papier] [Code]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [papier]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [papier] [Code]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [papier] [Code]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [papier]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [papier] [Code]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [papier]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [papier]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [papier]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [papier]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [papier] [Code]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [papier] [Code]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [papier]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [papier]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [papier]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [papier]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [papier]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [papier] [Code]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [papier] [Code]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [papier] [Code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [papier] [Code]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [papier] [Code]

2.2 Coordinating Potential of Multiple Agents

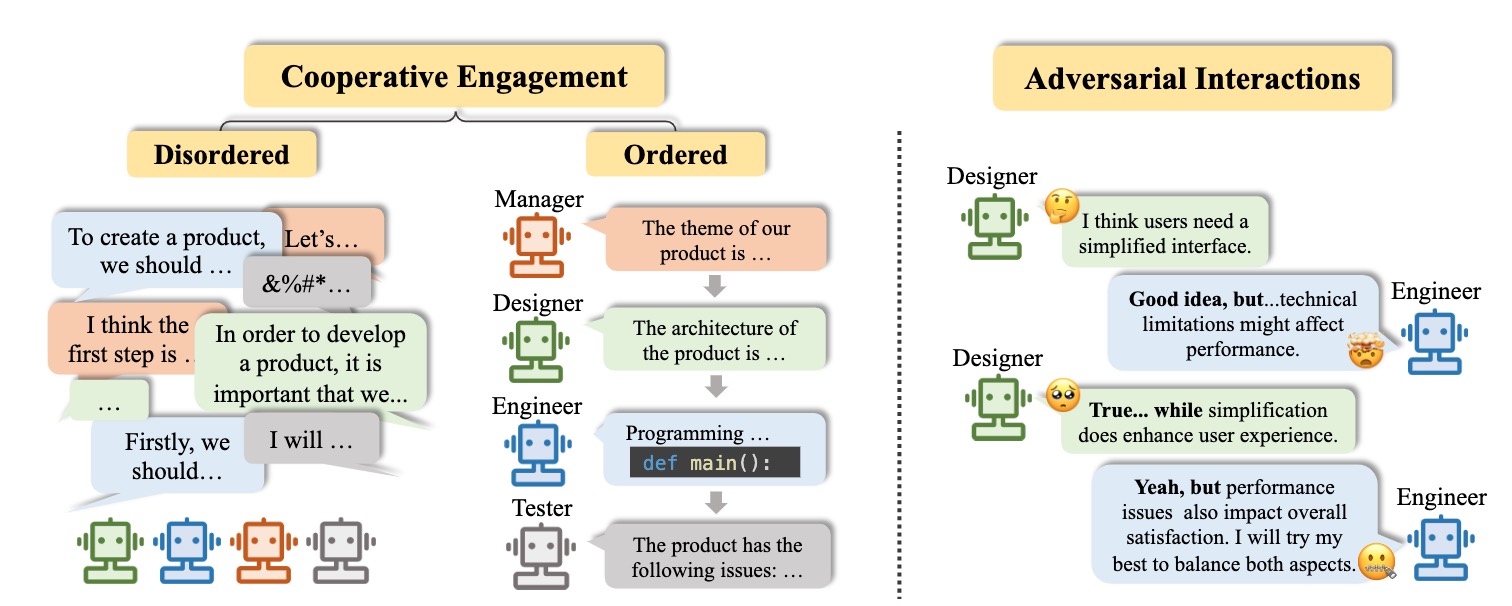

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [papier] [Code]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [papier] [Code]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [papier]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [papier]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [papier] [Code]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [papier] [Code]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [papier] [Code]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [papier]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [papier] [Code]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [papier] [Code]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [papier] [Code]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [papier] [Code]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [papier] [Code]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [papier]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [papier] [Code]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [papier] [Code]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [papier]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [papier] [Code]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [papier] [Code]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [papier]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [papier] [Code]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [papier] [Code]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [papier] [Code]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [papier]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [papier] [Code]

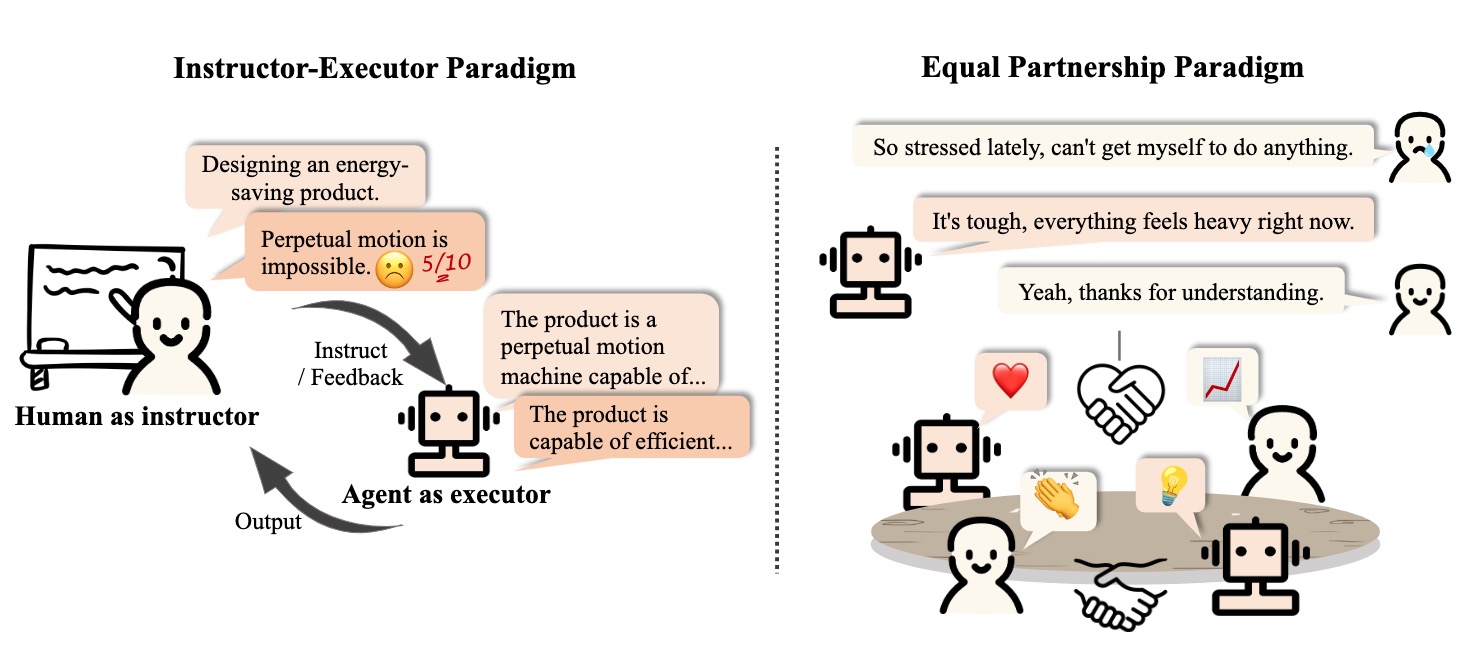

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

Éducation

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [papier]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [papier]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

Santé

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [papier] [Code]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [papier]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [papier]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [papier]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [papier]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [papier]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [papier]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [papier]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [papier]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [papier] [Code]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [papier] [Code]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [papier]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [papier]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [papier]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [papier]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [papier]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al. Science. [papier]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [papier]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [papier] [Code]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [papier] [Code]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [papier]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [papier] [Code]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [papier] [Code]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [papier]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [papier]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [papier] [Code]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [papier] [Code]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [papier] [Code]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [papier] [Code]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [papier] [Code]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [papier] [Code]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [papier]

3.1.2 Personality

Cognition

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [papier]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [papier]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [papier]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [papier]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [papier]

Émotion

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [papier]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [papier]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [papier]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [papier]

Personnage

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [papier] [Code]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [papier] [Code]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [papier] [Code]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [papier] [Code]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [papier]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [papier]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [papier] [Code]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [papier] [Code]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [papier]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [papier] [Code]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [papier] [Code]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [papier] [Code]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [papier] [Code]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [papier] [Code]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [papier] [Code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [papier]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [papier] [Code]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [papier] [Code]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [papier]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [papier] [Code]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [papier]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [papier] [Code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [papier] [Code]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [papier]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [papier] [Code]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [papier] [Code]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [papier] [Code]

Citation

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

Contact

Histoire des étoiles