대형 언어 모델 기반 에이전트의 상승 및 잠재력 : 조사

LLM 기반 에이전트를위한 필수 논문.

? 곧 출시 예정 : 각 용지에 한 문장 소개를 추가하십시오.

? 소식

- ☄️ [2024/06/07] Agentgym은 다양한 환경에서 LLM 기반 에이전트를 개발하고 발전시키기 위해 출시되었습니다!

- 종이 : 에이전트가 있습니다.

- 프로젝트 페이지 : https://agentgym.github.io/.

- 코드 : 플랫폼 및 구현.

- Huggingface Resources : Agenttraj-L, Agenteval, Agentevol-7b.

- ? [2024/05/02] R3 (리버스 커리큘럼 강화 학습을 통한 추론을위한 대형 언어 모델 훈련)은 ICML 2024에 의해 받아 들여졌습니다!

- ? [2024/02/08] LLM 에이전트 추론을위한 RL에 대한 새로운 논문 R3이 발표되었습니다! 논문 : 역 교과 과정 강화 학습을 통한 추론을위한 대형 언어 모델 교육. 코드 : LLM-Reverse-Curriculum-RL.

- ? [2023/09/20]이 프로젝트는 Github 트렌드에 등재되었습니다! 그것은 큰 영광입니다!

- ? [2023/09/15] 설문 조사가 발표되었습니다! 대형 언어 모델 기반 에이전트의 상승과 잠재력을 참조하십시오 : 논문에 대한 설문 조사!

- [2023/09/14] 우리는 LLM 기반 에이전트에 대한 종이 목록을 유지하기 위해이 저장소를 작성합니다. 더 많은 서류가 곧 올 것입니다!

? 소개

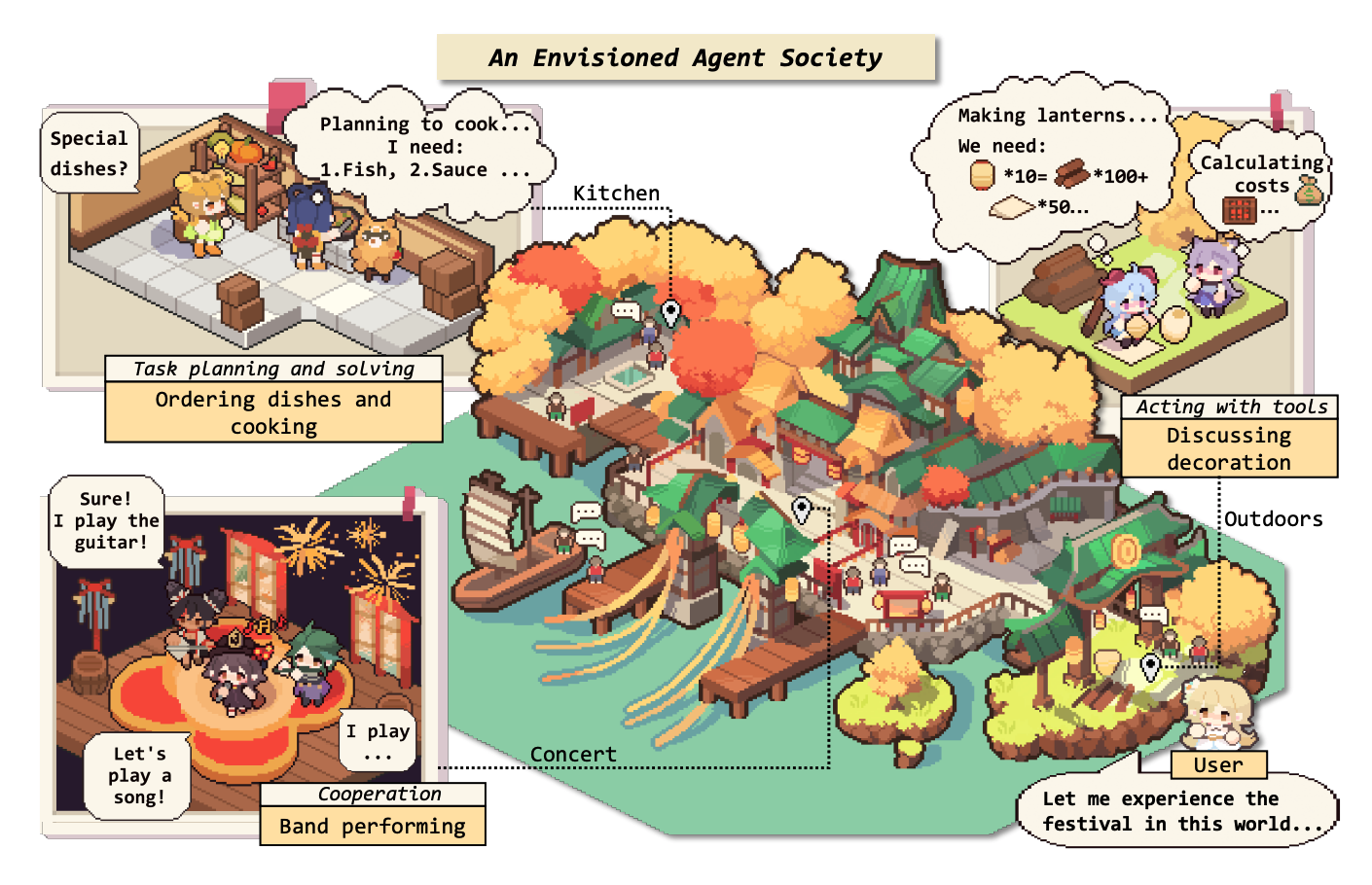

오랫동안 인류는 인공 지능 (AI)을 추구 해 왔으며, 인간 수준과 동등한 인물 수준을 추구해 왔으며, AI 요원은이 추구의 유망한 차량으로 간주됩니다. AI 요원은 자신의 환경을 감지하고 결정을 내리고 행동을 취하는 인공 기관입니다.

다재다능하고 놀라운 기능으로 인해 LLMS (Large Language Models)는 인공 일반 정보 (AGI)의 잠재적 스파크로 간주되어 AI 에이전트 일반 제작에 대한 희망을 제공합니다. 많은 연구 노력으로 AI 에이전트를 구축하기위한 기초로 LLM을 활용했으며 상당한 진전을 이루었습니다.

이 저장소에서는 LLM 기반 에이전트에 대한 체계적이고 포괄적 인 설문 조사를 제공하고 몇 가지 필수 용지를 나열합니다.

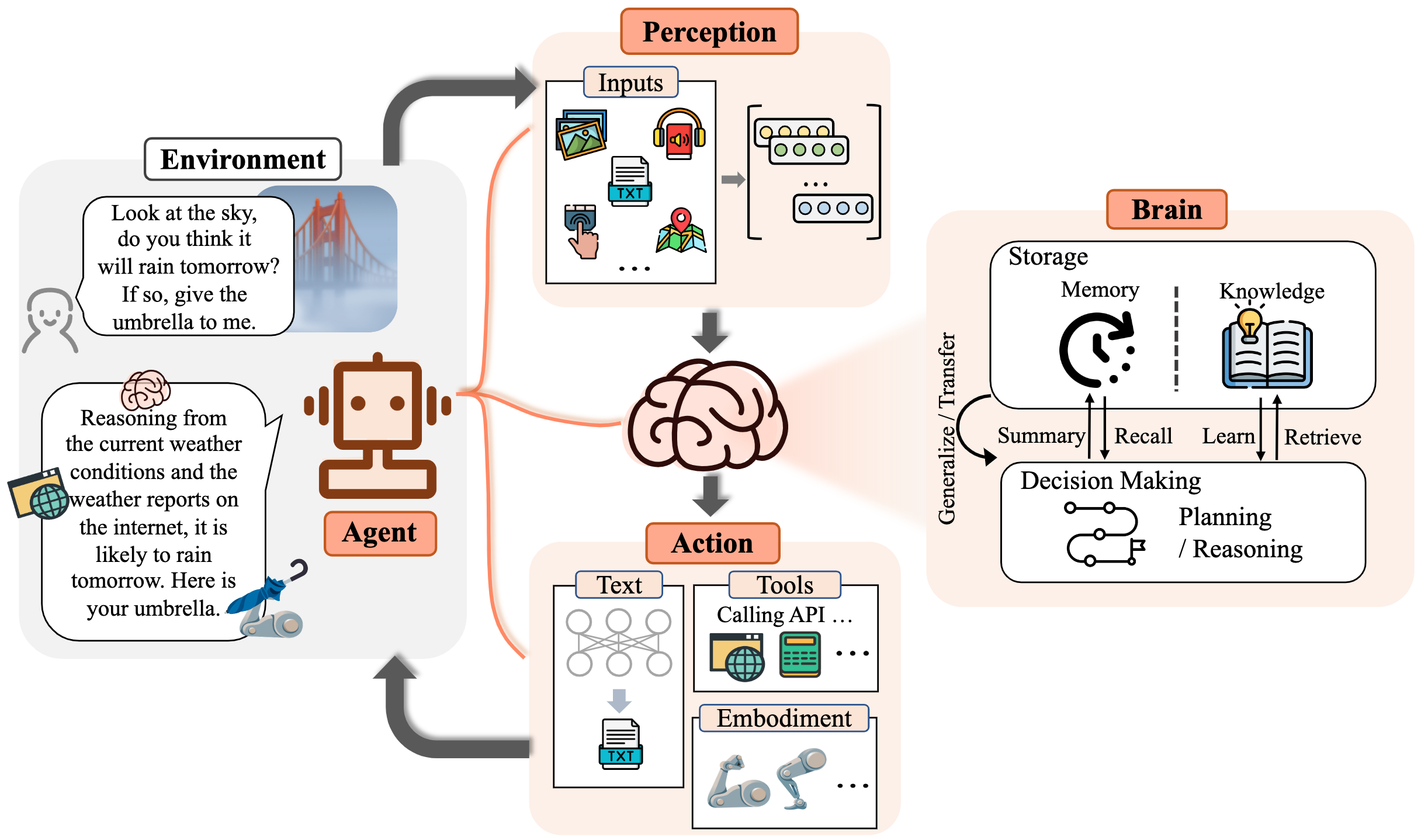

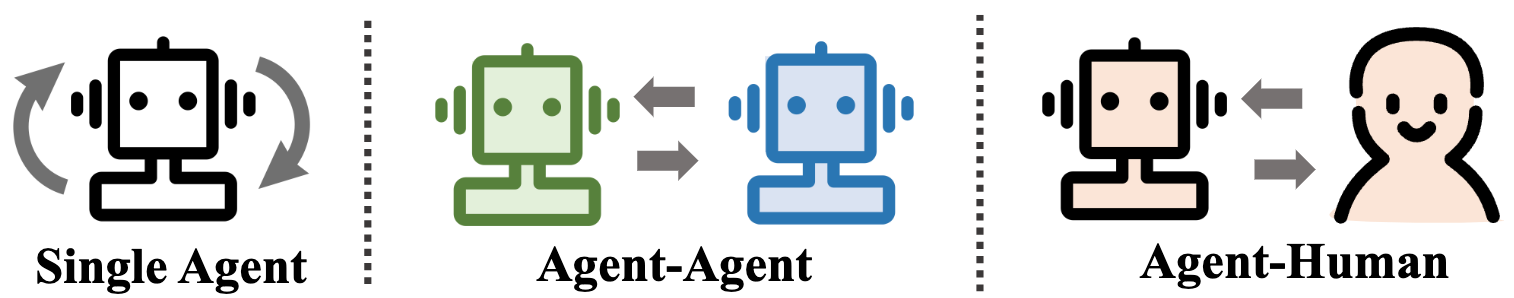

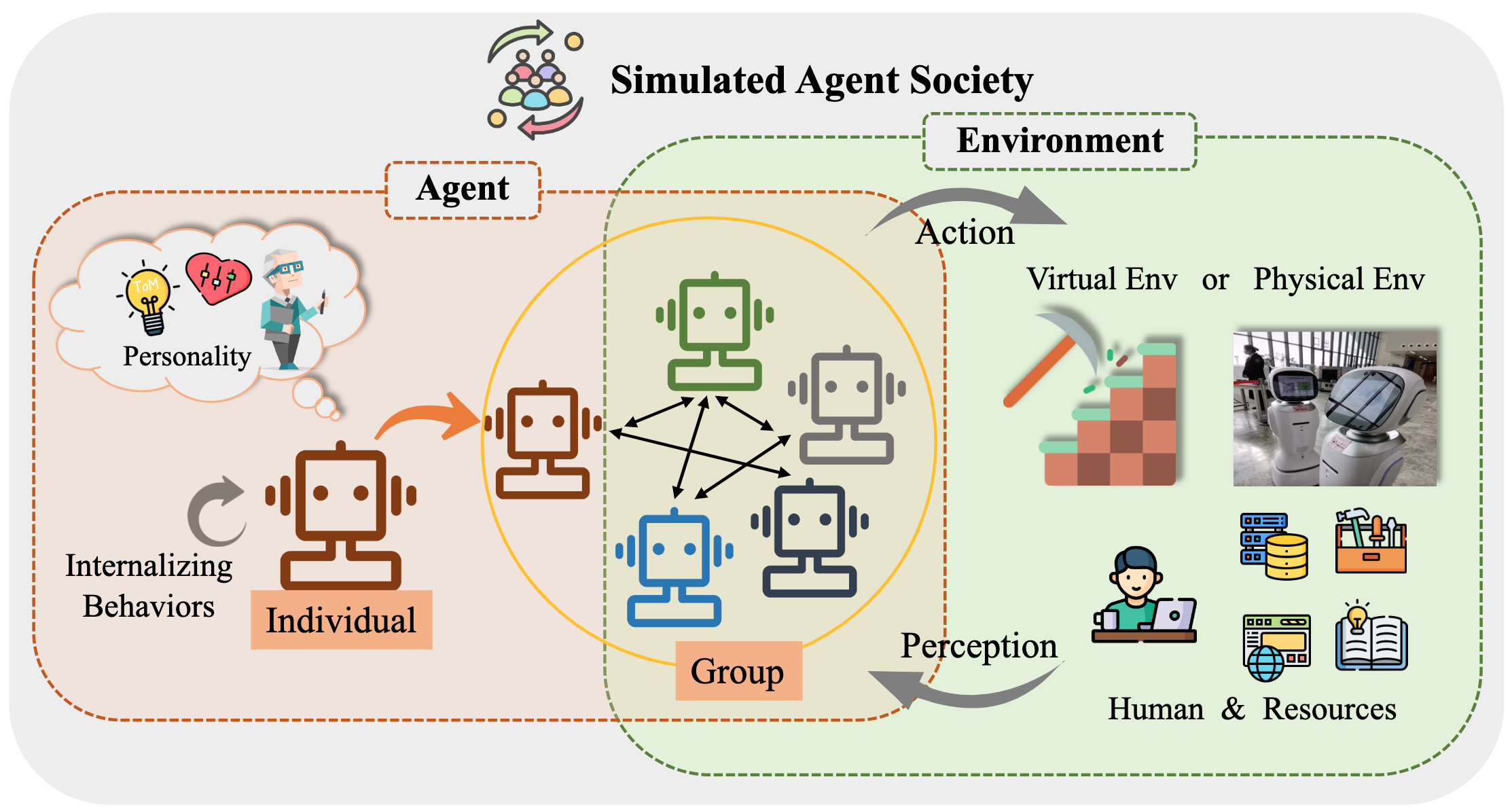

구체적으로, 우리는 LLM 기반 에이전트의 일반적인 개념 프레임 워크를 시작합니다. 세 가지 주요 구성 요소, 즉 뇌, 인식 및 행동, 그리고 프레임 워크는 다른 응용 프로그램에 맞게 조정될 수 있습니다. 그 후, 우리는 단일 에이전트 시나리오, 다중 에이전트 시나리오 및 인간 에이전트 협력의 세 가지 측면에서 LLM 기반 에이전트의 광범위한 응용을 탐구합니다. 그 후, 우리는 에이전트 사회를 탐구하여 LLM 기반 요원의 행동과 성격, 사회를 형성 할 때 나타나는 사회적 현상, 그리고 인간 사회를 위해 제공하는 통찰력을 탐구합니다. 마지막으로, 우리는 다양한 주요 주제와 현장 내에서 열린 문제에 대해 논의합니다.

PR, 문제, 이메일 또는 기타 방법을 통한 모든 기여에 감사드립니다.

콘텐츠 테이블 (TOC)

- 대형 언어 모델 기반 에이전트의 상승 및 잠재력 : 조사

- ? 소식

- ? 소개

- 콘텐츠 테이블 (TOC)

- 1. 에이전트의 탄생 : LLM 기반 에이전트의 건설

- 1.1 뇌 : 주로 LLM으로 구성됩니다

- 1.1.1 자연어 상호 작용

- 1.1.2 지식

- 프리 트레인 모델

- 언어 지식

- 상식 지식

- 실행 가능한 지식

- 잠재적 인 지식 문제

- 1.1.3 메모리

- 메모리 기능

- 변압기의 길이 제한을 높입니다

- 메모리 요약

- 벡터 또는 데이터 구조로 메모리를 압축합니다

- 메모리 검색

- 1.1.4 추론 및 계획

- 1.1.5 양도 및 일반화

- 보이지 않는 작업 일반화

- 텍스트 내 학습

- 지속적인 학습

- 1.2 인식 : LLM 기반 에이전트의 복합 입력

- 1.3 조치 : LLM 기반 에이전트의 액션 공간 확장

- 1.3.1 도구 사용

- 1.3.2 구체화 된 행동

- 2. 실습 에이전트 : LLM 기반 에이전트의 응용

- 2.1 단일 에이전트의 일반적인 능력

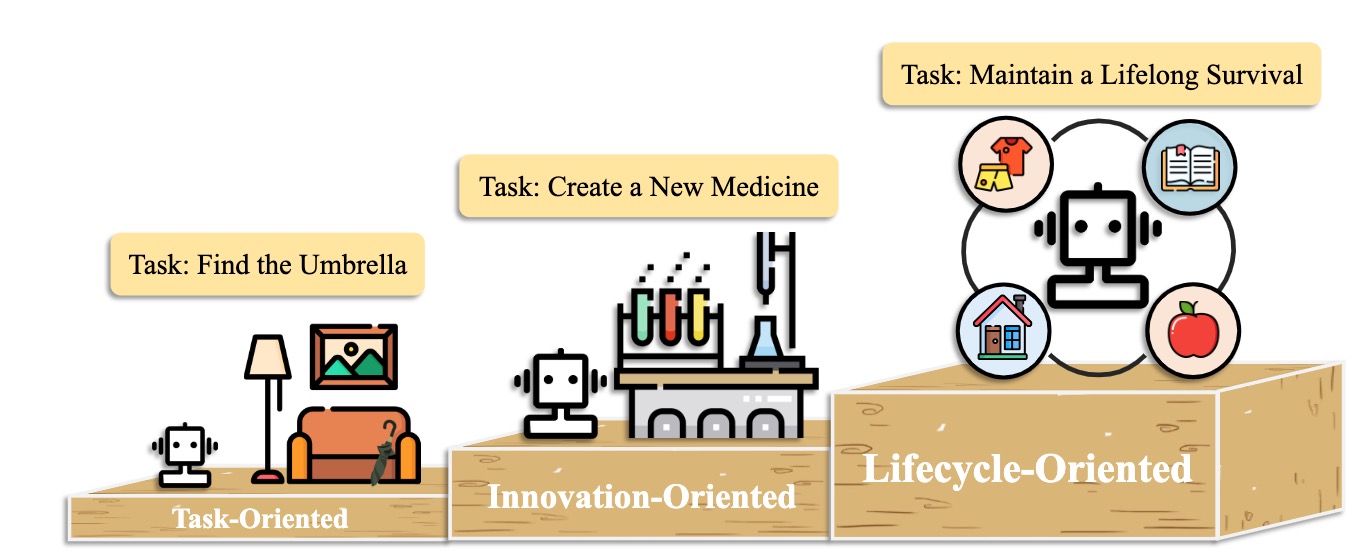

- 2.1.1 작업 지향 배포

- 2.1.2 혁신 지향 배포

- 2.1.3 수명주기 지향 배포

- 2.2 여러 에이전트의 잠재력 조정

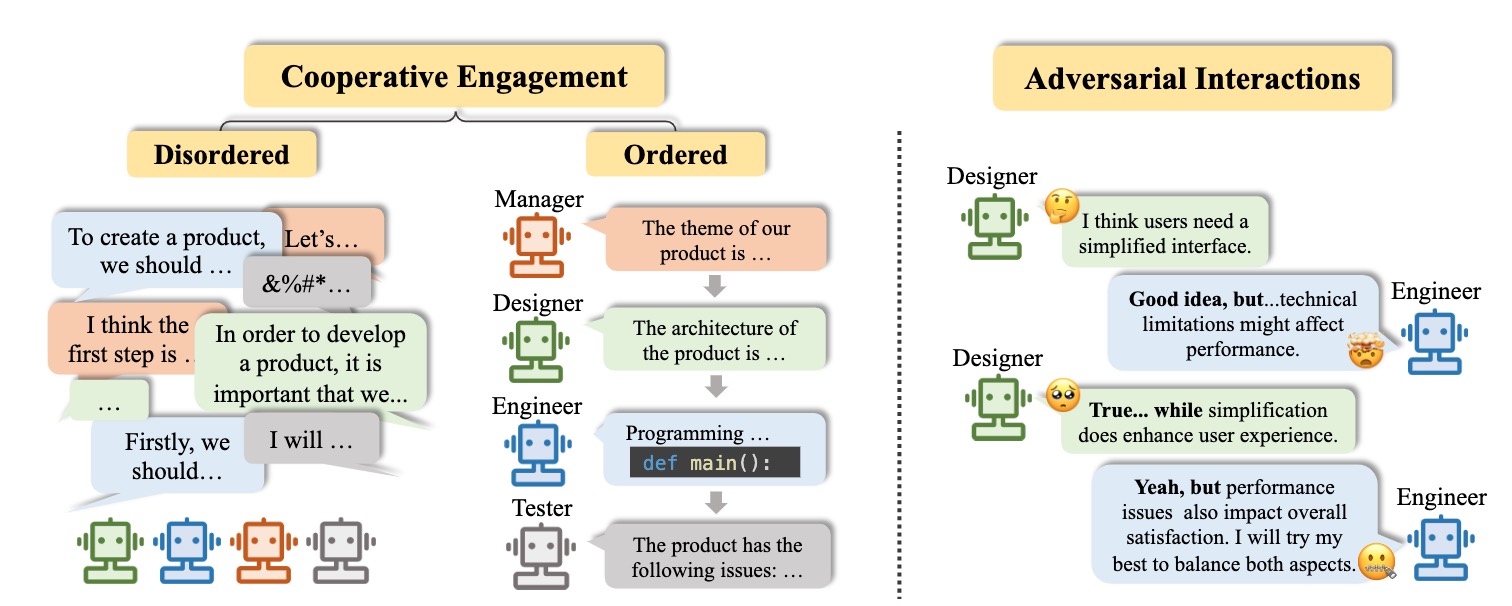

- 2.2.1 상보성을위한 협력 상호 작용

- 2.2.2 발전을위한 적대적 상호 작용

- 2.3 인간과 에이전트 간의 대화식 참여

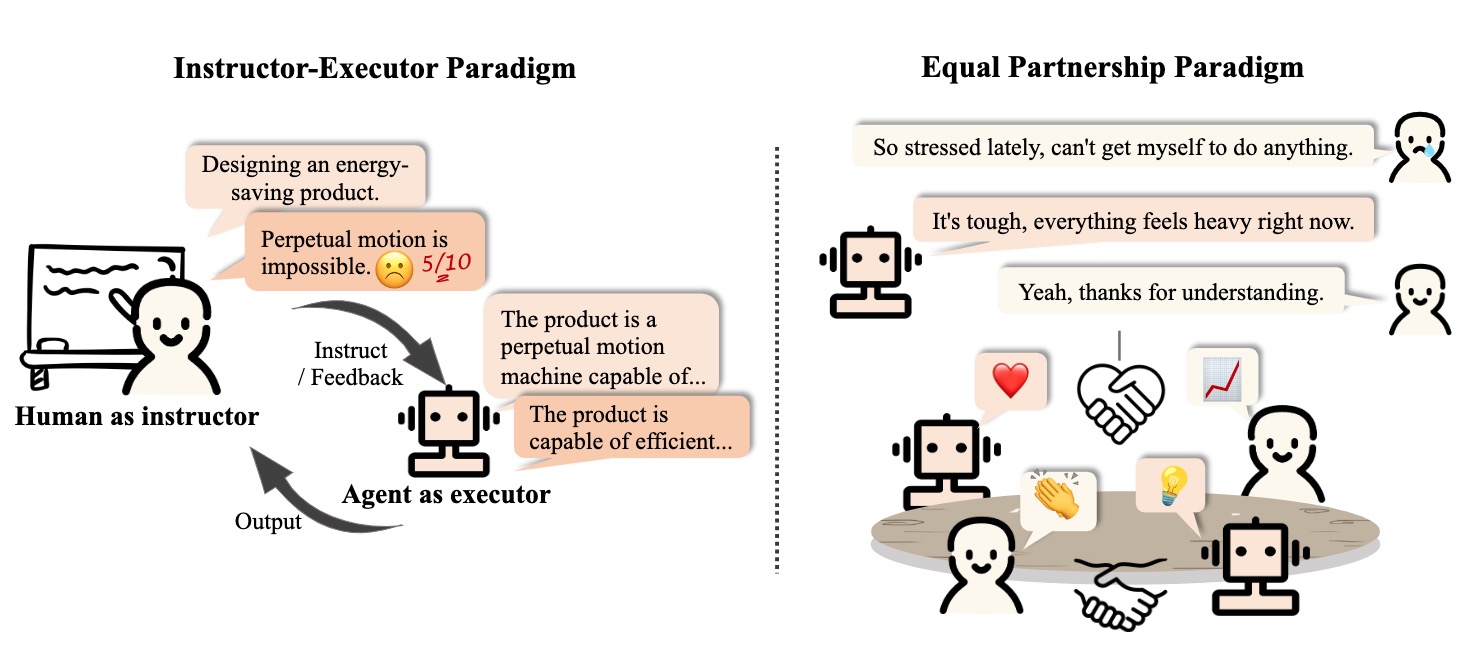

- 2.3.1 강사-실행자 패러다임

- 2.3.2 동등한 파트너십 패러다임

- 3. 에이전트 사회 : 개성에서 사회에 이르기까지

- 3.1 LLM 기반 에이전트의 행동과 성격

- 3.2 에이전트 사회를위한 환경

- 3.2.1 텍스트 기반 환경

- 3.2.2 가상 샌드 박스 환경

- 3.2.3 물리적 환경

- 3.3 LLM 기반 에이전트와의 사회 시뮬레이션

- 4. 다른 주제

- 4.1 LLM 기반 에이전트의 벤치 마크

- 4.2 LLM 기반 에이전트 교육 및 최적화

- 소환

- 프로젝트 관리자 및 기여자

- 연락하다

- 스타 역사

1. 에이전트의 탄생 : LLM 기반 에이전트의 건설

1.1 뇌 : 주로 LLM으로 구성됩니다

1.1.1 자연어 상호 작용

고품질 세대

- [2023/10] 다중 모달 대형 언어 모델을 통한 엔드 투 엔드 구체화 의사 결정 : GPT4- vision 및 Beyond Liang Chen et al. arxiv. [종이] [코드]

- 이 연구는 PCA-Eval을 제안합니다.이 작업은 MLLM 기반 엔드 투 엔드 방법 및 LLM 기반 도구 사용 방법을 통한 의사 결정을 구체화 한 PCA-Eval을 제안합니다.

- [2023/08] 추론, 환각 및 상호 작용에 대한 chatgpt의 멀티 태스킹, 다국어, 멀티 모달 평가. Yejin Bang et al. arxiv. [종이]

- 이 작업은 8 가지 일반적인 NLP 애플리케이션 작업을 다루는 21 개의 데이터 세트를 사용하여 ChatGpt의 멀티 태스킹, 다국어 및 멀티 모드 측면을 평가합니다.

- [2023/06] LLM-Eval : 대형 언어 모델과의 오픈 도메인 대화를위한 통합 다차원 자동 평가. 엔 팅 린 등. arxiv. [종이]

- LLM-Eval 방법은 내용, 문법, 관련성 및 적절성과 같은 여러 차원의 평가를 평가합니다.

- [2023/04] Chatgpt는 매우 유창한 문법 오류 수정 시스템입니까? 포괄적 인 평가. Tao Fang et al. arxiv. [종이]

- 평가 결과는 ChatGpt가 우수한 오류 감지 기능을 가지고 있으며 수정 된 문장을 매우 유창하게 만들기 위해 오류를 자유롭게 수정할 수 있음을 보여줍니다. 또한 영어 이외의 외과 및 저주적 설정에서의 성능은 다국어 GEC 작업의 잠재력을 강조합니다.

깊은 이해

- [2023/06] 영리한 한스 또는 신경 이론? 대형 언어 모델에서 사회 추론을 테스트하는 스트레스. Natalie Shapira et al. arxiv. [종이]

- LLM은 특정한 마음의 능력 이론을 나타내지 만,이 행동은 강력하지 않습니다.

- [2022/08] 맥락에서 언어로부터 보상을 유추한다. Jessy Lin et al. ACL. [종이]

- 이 작업은 언어의 보상을 유도하고 보이지 않는 환경에서 최적의 행동을 예측하는 모델을 제시합니다.

- [2021/10] 복잡한 인간 로봇 협력에서의 마음 기반 보조 커뮤니케이션 이론. Moritz C. Buehler et al. arxiv. [종이]

- 이 작업은 상호 작용 중에 인간을 이해하여 에이전트 스시를 설계합니다.

1.1.2 지식

프리 트레인 모델

- [2023/04] 표지되지 않은 데이터에서 문장의 분산 표현 학습. 펠릭스 힐 (Cambridge of Cambridge) et al. arxiv. [종이]

- [2020/02] 언어 모델의 매개 변수에 얼마나 많은 지식을 포장 할 수 있습니까? Adam Roberts (Google) et al. arxiv. [종이]

- [2020/01] 신경 언어 모델에 대한 법률 스케일링 법. Jared Kaplan (Johns Hopkins University) et al. arxiv. [종이]

- [2017/12] 기계 지능에 대한 상식 지식. Niket Tandon (Allen Institute for Artificial Intelligence) et al. 시그 모드. [종이]

- [2011/03] 자연 언어 처리 (거의) 처음부터. Ronan Collobert (Princeton) et al. arxiv. [종이]

언어 지식

- [2023/02] 추론, 환각 및 상호 작용에 대한 chatgpt의 멀티 태스킹, 다국어, 멀티 모달 평가. Yejin Bang et al. arxiv. [종이]

- [2021/06] 시맨틱 속성 및 그 가치에 대한 미리 훈련 된 언어 모델을 조사합니다. Meriem Beloucif et al. emnlp. [종이]

- [2020/10] 어휘 의미론에 대한 사전에 걸린 언어 모델 조사. Ivan Vulić et al. arxiv. [종이]

- [2019/04] 단어 표현에서 구문을 찾기위한 구조 프로브. John Hewitt et al. ACL. [종이]

- [2016/04] 더 많은 의미 지식을 고려하여 자동 키워드 추출이 향상되었습니다. H Leung. 고급 응용 프로그램을위한 시스템. [종이]

상식 지식

- [2022/10] 코드의 언어 모델은 소수의 상식 학습자입니다. Aman Madaan et al.Arxiv. [종이]

- [2021/04] 문맥 언어 모델에서의 관계 세계 지식 표현 : 검토. Tara Safavi et al. arxiv. [종이]

- [2019/11] 언어 모델이 무엇을 알고 있는지 어떻게 알 수 있습니까? Zhengbao Jiang et al.arxiv. [종이]

실행 가능한 지식

- [2023/07] 의학의 큰 언어 모델. Arun James Thirunavukarasu et al. 자연. [종이]

- [2023/06] DS-1000 : 데이터 과학 코드 생성을위한 자연스럽고 신뢰할 수있는 벤치 마크. Yuhang Lai et al. ICML. [종이]

- [2022/10] 코드의 언어 모델은 소수의 상식 학습자입니다. Aman Madaan et al. arxiv. [종이]

- [2022/02] 큰 언어 모델의 체계적인 평가. Frank F. Xu et al.Arxiv. [종이]

- [2021/10] 수학 단어 문제를 해결하기위한 교육 검증 자. Karl Cobbe et al. arxiv. [종이]

잠재적 인 지식 문제

- [2023/10] Freshllms : 검색 엔진 확대로 대형 언어 모델을 새로 고치고 있습니다. Tu Vu (Google) et al. arxiv [종이] [코드]

- [2023/05] 대형 언어 모델 편집 : 문제, 방법 및 기회. Yunzhi Yao et al. arxiv. [종이]

- [2023/05] 자체 체커 : 큰 언어 모델로 사실 확인을위한 플러그 앤 플레이 모듈. Miaoran Li et al. arxiv. [종이]

- [2023/05] 비평가 : 대형 언어 모델은 도구 인터랙티브 비평을 자체적으로 취급 할 수 있습니다. Zhibin Gou et al. arxiv. [종이]

- [2023/04] 기초 모델을 사용한 도구 학습. Yujia Qin et al. arxiv. [종이]

- [2023/03] Selfcheckgpt : 생성 대형 언어 모델에 대한 Zero-Resource Black-Box 환각 탐지. Potsawee Manakul et al. arxiv. [종이]

- [2022/06] 메모리 기반 모델 편집. Eric Mitchell et al. arxiv. [종이]

- [2022/04] 지식 기반으로 언어 모델에 대한 검토. Badr Alkhamissi et al.Arxiv. [종이]

- [2021/04] 언어 모델의 사실 지식 편집. Nicola de Cao et al.Arxiv. [종이]

- [2017/08] 신경망에서 치명적인 잊어 버리는 측정. Ronald Kemker et al.arxiv. [종이]

1.1.3 메모리

메모리 기능

변압기의 길이 제한을 높입니다

- [2023/10] memgpt : 운영 체제로서 LLM을 향해. Charles Packer (UC Berkeley) et al. arxiv. [종이] [프로젝트 페이지] [코드] [데이터 세트]

- [2023/05] 무작위 위치 인코딩은 변압기의 길이 일반화를 향상시킨다. Anian Ruoss (Deepmind) et al. arxiv. [종이] [코드]

- [2023-03] Colt5 : 조건부 계산을 가진 더 빠른 장거리 변압기. Joshua Ainslie (Google Research) et al. arxiv. [종이]

- [2022/03] 변압기를 사용한 긴 문서의 효율적인 분류. 현지 헤일리 파크 (일리노이 대학교) et al. arxiv. [종이] [코드]

- [2021/12] Longt5 : 긴 시퀀스에 대한 효율적인 텍스트-텍스트 변압기. Mandy Guo (Google Research) et al. arxiv. [종이] [코드]

- [2019/10] BART : 자연 언어 생성, 번역 및 이해를위한 시퀀스-시퀀스 사전 훈련. Michael Lewis (Facebook AI) et al. arxiv. [종이] [코드]

메모리 요약

- [2023/10] 메모리 미로를 걷는다 : 대화식 독서를 통해 맥락 한계를 넘어 Howard Chen (Princeton University) et al. arxiv. [종이]

- [2023/09] 큰 언어 모델을 체인함으로써 개인지도 권한을 부여하는 권한을 부여합니다 . Yulin Chen (Tsinghua University) et al. arxiv. [종이]

- [2023/08] Expel : LLM 에이전트는 체험 학습자입니다. Andrew Zhao (Tsinghua University) et al. arxiv. [종이] [코드]

- [2023/08] Chateval : 다중 에이전트 토론을 통해 더 나은 LLM 기반 평가자를 향해. Chi-Min Chan (Tsinghua University) et al. arxiv. [종이] [코드]

- [2023/05] MemoryBank : 장기 메모리를 가진 대형 언어 모델 향상. Wanjun Zhong (Harbin Institute of Technology) et al. arxiv. [종이] [코드]

- [2023/04] 생성제 : 인간 행동의 대화식 시뮬 라 크라. Joon Sung Park (Stanford University) et al. arxiv. [종이] [코드]

- [2023/04] 자체 제어 메모리 시스템을 갖춘 대규모 언어 모델의 무한 길이 입력 용량을 해제합니다. Xinnian Liang (Beihang University) et al. arxiv. [종이] [코드]

- [2023/03] 반사 : 언어 강화 학습을 가진 언어 에이전트. 노아 신 (Northeastern University) et al. arxiv. [종이] [코드]

- [2023/05] ReburrentGpt : 대화식 생성 (임의로) 긴 텍스트. Wangchunshu Zhou (Aiwaves) et al. arxiv. [종이] [코드]

벡터 또는 데이터 구조로 메모리를 압축합니다

- [2023/07] 소프트웨어 개발을위한 의사 소통 에이전트. Chen Qian (Tsinghua University) et al. arxiv. [종이] [코드]

- [2023/06] ChatDB : 데이터베이스를 상징적 인 메모리로 확대하는 LLM. Chenxu Hu (Tsinghua University) et al. arxiv. [종이] [코드]

- [2023/05] Minecraft의 유령 : 일반적으로 텍스트 기반 지식과 기억을 가진 대형 언어 모델을 통해 오픈 월드 환경을위한 유능한 에이전트. Xizhou Zhu (Tsinghua University) et al. arxiv. [종이] [코드]

- [2023/05] ret-llm : 대형 언어 모델에 대한 일반적인 읽기 제기 메모리를 향해. Ali Modarressi (LMU Munich) et al. arxiv. [종이] [코드]

- [2023/05] ReburrentGpt : 대화식 생성 (임의로) 긴 텍스트. Wangchunshu Zhou (Aiwaves) et al. arxiv. [종이] [코드]

메모리 검색

- [2023/08] 메모리 샌드 박스 : 대화 에이전트를위한 투명하고 대화식 메모리 관리. Ziheng Huang (캘리포니아 대학 - 산 디에고) et al. arxiv. [종이]

- [2023/08] Agentims : 대형 언어 모델 평가를위한 오픈 소스 샌드 박스. Jiaju Lin (PTA Studio) et al. arxiv. [종이] [프로젝트 페이지] [코드]

- [2023/06] ChatDB : 데이터베이스를 상징적 인 메모리로 확대하는 LLM. Chenxu Hu (Tsinghua University) et al. arxiv. [종이] [코드]

- [2023/05] MemoryBank : 장기 메모리를 가진 대형 언어 모델 향상. Wanjun Zhong (Harbin Institute of Technology) et al. arxiv. [종이] [코드]

- [2023/04] 생성제 : 인간 행동의 대화식 시뮬 라 크라. Joon Sung Park (Stanford) et al. arxiv. [종이] [코드]

- [2023/05] ReburrentGpt : 대화식 생성 (임의로) 긴 텍스트. Wangchunshu Zhou (Aiwaves) et al. arxiv. [종이] [코드]

1.1.4 추론 및 계획

추리

[2024/02] 리버스 커리큘럼 강화 학습을 통한 추론을위한 대형 언어 모델 교육. Zhiheng XI (Fudan University) et al. arxiv. [종이] [코드]

[2023/09] 조정 : 라운드 테이블 컨퍼런스는 다양한 LLM 간의 합의를 통해 추론을 향상시킵니다. Justin Chih-Yao Chen (Chapel Hill의 노스 캐롤라이나 대학교) et al. arxiv. [종이] [코드]

[2023/05] 자기 폴리쉬 : 문제 개선을 통해 큰 언어 모델의 추론을 향상시킵니다. Zhiheng XI (Fudan University) et al. arxiv. [종이] [코드]

[2023-03] 대형 언어 모델은 제로 샷 추론 자입니다. Takeshi Kojima (The University of Tokyo) et al. arxiv. [종이] [코드]

[2023/03] self-refine : 자기 피드백을 통한 반복 개선. Aman Madaan (Carnegie Mellon University) et al. arxiv. [종이] [코드]

[2022/05] 선발 주도 : 해석 가능한 논리적 추론을위한 대형 언어 모델 악용. Antonia Creswell (Deepmind) et al. arxiv. [종이]

[2022/03] 자기 일관성은 언어 모델에서 사고 추론의 사슬을 향상시킵니다. Xuezhi Wang (Google Research) et al. arxiv. [종이] [코드]

[2023/02] 언어 모델에서의 다중 모드 체인 추론. Zhuosheng Zhang (Shanghai Jiao Tong University) et al. arxiv. [종이] [코드]

[2022/01] 고려한 체인은 큰 언어 모델에서 추론을 유도합니다. Jason Wei (Google Research) et al. arxiv. [종이]

계획

계획 제형

- [2023/11] JARVIS-1 : 메모리-구분 다중 모드 언어 모델이있는 오픈 월드 멀티 태스킹 에이전트. Zihao Wang (Peking University) et al. arxiv. [종이] [코드]

- [2023/10] 언어 에이전트 트리 검색은 언어 모델에서 연기 및 계획을 통합합니다. Andy Zhou (University of Illinois Urbana-Champaign) et al. arxiv. [종이] [프로젝트 페이지] [코드]

- [2023/05] 사고의 나무 : 큰 언어 모델로 고의적 인 문제 해결. Shunyu Yao (Princeton University) et al. arxiv. [종이] [코드]

- [2023/05] 계획, 제거 및 추적 - 언어 모델은 구현 된 에이전트를위한 훌륭한 교사입니다. Yue Wu (Carnegie Mellon University) et al. arxiv. [종이]

- [2023/05] 언어 모델을 사용한 추론은 세계 모델로 계획하고 있습니다. Shibo Hao (UC San Diego) et al. arxiv. [종이] [코드]

- [2023/05] Swiftsage : 복잡한 대화식 작업에 대한 빠르고 느린 생각을 가진 생성 에이전트. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arxiv. [종이] [코드]

- [2023/04] LLM+P : 최적의 계획 능력으로 대형 언어 모델을 강화합니다. Bo Liu (Austin의 텍사스 대학교) et al. arxiv. [종이] [코드]

- [2023/03] Hugginggpt : chatgpt와 친구들과 함께 AI 작업을 포옹하는 얼굴에 AI 작업을 해결합니다. Yongliang Shen (Microsoft Research Asia) et al. arxiv. [종이] [코드]

- [2023/02] 설명, 설명, 계획 및 선택 : 대형 언어 모델을 사용한 대화식 계획을 사용하면 오픈 월드 멀티 태스킹 에이전트가 가능합니다. Zihao Wang (Peking University) et al. arxiv. [종이] [코드]

- [2022/05] 가장 큰 프롬프트는 대형 언어 모델에서 복잡한 추론을 가능하게합니다. Denny Zhou (Google Research) et al. arxiv. [종이]

- [2022/05] MRKL Systems : 대형 언어 모델, 외부 지식 소스 및 개별 추론을 결합한 모듈 식 신경 상징적 아키텍처. Ehud Karpas (AI21 Labs) et al. arxiv. [종이]

- [2022/04] 내가 말한대로 할 수있는대로 : 로봇 여유지의 접지 언어. Michael Ahn (Google의 Robotics) et al. arxiv. [종이]

- [2023/05] 에이전트 : 자율 언어 에이전트를위한 오픈 소스 프레임 워크. Wangchunshu Zhou (Aiwaves) et al. arxiv. [종이] [코드]

- [2022/12] 생성, 차별 : 언어 모델을 실제 환경에 접지하는 제안. Yu Gu (오하이오 주립 대학) et al. ACL. [종이] [코드]

계획 반사

- [2024/02] Agent-Pro : 정책 수준의 반영 및 최적화를 통해 진화하는 법을 배우는 학습 Wenqi Zhang (Zhejiang University) et al. arxiv. [종이] [코드]

- [2024/01] 자제력 : 일관되지 않은 해결 관점을 통한 더 나은 반사 Wenqi Zhang (Zhejiang University) et al. arxiv. [종이]

- [2023/11] JARVIS-1 : 메모리-구분 다중 모드 언어 모델이있는 오픈 월드 멀티 태스킹 에이전트. Zihao Wang (Peking University) et al. arxiv. [종이] [코드]

- [2023/10] 검증 체인은 큰 언어 모델에서 환각을 줄입니다. Shehzaad Dhuliawala (Meta Ai & Eth Zu ̈rich) et al. arxiv. [종이]

- [2023/10] FireAct : 언어 에이전트 미세 조정을 향해. Baian Chen (System2 Research) et al. arxiv. [종이] [프로젝트 페이지] [코드] [데이터 세트]

- [2023/08] SelfCheck : LLMS를 사용하여 자신의 단계별 추론을 확인하십시오. Ning Miao (University of Oxford) et al. arxiv. [종이] [코드]

- [2023/05] Chatcot : Chat 기반 대형 언어 모델에 대한 도구를 구입 한 추론. Zhipeng Chen (Renmin University of China) et al. arxiv. [종이] [코드]

- [2023/05] Voyager : 대형 언어 모델을 가진 개방형 구현제. Guanzhi Wang (Nvidia) et al. arxiv. [종이] [프로젝트 페이지] [코드]

- [2023/03] 환경과 채팅 : 대형 언어 모델을 사용한 대화식 멀티 모달 인식. Xufeng Zhao (University Hamburg) et al. arxiv. [종이] [코드]

- [2022/12] LLM-PLANNER : 대형 언어 모델을 갖는 구체화 된 에이전트에 대한 기초가 거의 없다. Chan Hee Song (Ohio State University) et al. arxiv. [종이] [코드]

- [2022/10] 반응 : 언어 모델에서 상승 추론 및 행동. Shunyu Yao (Princeton University) et al. arxiv. [종이] [코드]

- [2022/07] 내부 독백 : 언어 모델로 계획을 통한 구체화 된 추론. Wenlong Huang (Google의 로봇 공학) et al. arxiv. [종이] [코드]

- [2021/10] AI 사슬 : 대형 언어 모델 프롬프트를 연결하여 투명하고 제어 가능한 인간 AI 상호 작용. Tongshuang Wu (Washington University) et al. arxiv. [종이]

1.1.5 양도 및 일반화

보이지 않는 작업 일반화

- [2024/06] Agentgym : 다양한 환경에서 대형 언어 모델 기반 에이전트를 발전시킵니다. Zhiheng XI (Fudan University) et al. arxiv. [종이] [프로젝트 페이지] [코드 및 플랫폼] [데이터 세트] [벤치 마크] [모델].

- [2023/10] Agenttuning : LLM의 일반화 된 에이전트 능력 활성화. Aohan Zeng (Tsinghua University) et al. arxiv. [종이] [프로젝트 페이지] [코드] [데이터 세트]

- [2023/10] 여우 원숭이 : 언어 에이전트의 자연 언어 및 코드 조화 Yiheng Xu (University of Hong Kong) et al. arxiv. [종이] [코드]

- [2023/05] 인간의 피드백으로 지침을 따르는 언어 모델 교육. Long Ouyang et al. 신경관. [종이]

- InstructGpt : 인간의 피드백을 미세 조정하여 광범위한 작업에 대한 사용자 의도와 언어 모델을 정렬합니다.

- [2023/01] 멀티 태스킹 프롬프트 교육은 제로 샷 작업 일반화를 가능하게합니다. Victor Sanh et al. ICLR. [종이] [코드]

- T0 : T0은 텍스트 입력을 소비하고 대상 응답을 생성하는 인코더 디코더 모델입니다. 다른 작업으로 분할 된 NLP 데이터 세트의 멀티 태스킹 혼합물에 대해 교육을 받았습니다.

- [2022/10] 스케일링 명령-결절 언어 모델. 형은 Chung et al. arxiv. [종이] [코드]

- 이 작업은 작업 횟수와 모델 크기를 확장하는 데 특히 중점을 둔 지침 조정을 탐구하여 다양한 모델 클래스의 성능, 프롬프트 설정 및 평가 벤치 마크에서 성능을 향상시킵니다.

- [2022/08] Finetuned Language 모델은 제로 샷 학습자입니다. Jason Wei et al. ICLR. [종이]

- FLAN : 명령 조정은 보이지 않는 작업에서 제로 샷 성능을 크게 향상시킵니다.

텍스트 내 학습

- [2023/08] 이미지는 이미지에서 연설을합니다. 텍스트 내 시각적 학습을위한 일반 화가. Xinlong Wang et al. IEEE. [종이] [코드]

- 화가 :이 작품은 "이미지"중심 솔루션으로 텍스트 내 시각적 학습을위한 일반적인 모델을 제시합니다.

- [2023/08] 신경 코덱 언어 모델은 음성 신디사이저에 대한 제로 샷 텍스트입니다. Chengyi Wang et al. arxiv. [종이] [코드]

- Vall-E :이 작업은 신경 코덱 언어 모델을 훈련시켜 텍스트 내 학습 기능이 나타납니다.

- [2023/07] 텍스트 내 학습을위한 설문 조사. Qingxiu Dong et al. arxiv. [종이]

- 이 설문 조사는 텍스트 내 학습 (ICL)의 진행 상황과 과제를 요약합니다.

- [2023/05] 언어 모델은 소수의 학습자입니다. Tom B. Brown (Openai) et al. 신경관. [종이]

- GPT-3 : 언어 모델을 확장하면 작업에 대한 비수성, 소수의 성능이 크게 향상되며 때로는 최첨단 미세 조정 접근 방식과 경쟁력이 있습니다.

지속적인 학습

- [2023/11] JARVIS-1 : 메모리-구분 다중 모드 언어 모델이있는 오픈 월드 멀티 태스킹 에이전트. Zihao Wang (Peking University) et al. arxiv. [종이] [코드]

- [2023/07] 진보적 프롬프트 : 언어 모델에 대한 지속적인 학습. Razdaibiedina et al. arxiv. [종이]

- 이 작업은 진보적 인 프롬프트를 소개합니다.이 프롬프트는 데이터 재생 또는 다수의 작업 별 매개 변수에 의존하지 않고 앞으로의 전송 및 재앙을 저항 할 수 있습니다.

- [2023/05] Voyager : 대형 언어 모델을 가진 개방형 구현제. Guanzhi Wang (Nvidia) et al. arxiv. [종이] [프로젝트 페이지] [코드]

- Voyager : 이것은 Minecraft의 LLM 기반 구체화 평생 학습 대리인의 예이며, 세계를 지속적으로 탐구하고 다양한 기술을 습득하며 인간의 개입없이 새로운 발견을합니다.

- [2023/01] 지속적인 학습에 대한 포괄적 인 조사 : 이론, 방법 및 응용. Liyuan Wang et al. arxiv. [종이]

- 이 설문 조사는 지속적인 학습에 대한 포괄적 인 설문 조사를 제공하며 기본 설정, 이론적 기초, 대표 방법 및 실제 응용 프로그램을 연결하려고합니다.

- [2022/11] 자연 언어 처리 작업에 대한 지속적인 학습 : 설문 조사. Zixuan Ke et al. arxiv. [종이]

- 이 설문 조사는 NLP에서 CL의 최근 진행 상황에 대한 포괄적 인 검토 및 분석을 제시합니다.

1.2 인식 : LLM 기반 에이전트의 복합 입력

1.2.1 비주얼

- [2024/01] 에이전트 AI : 복합 상호 작용의 수평선 조사. Zane Durante et al. arxiv. [종이]

- [2023/10] 다중 모달 대형 언어 모델을 통한 엔드 투 엔드 구체화 의사 결정 : GPT4- vision 및 Beyond Liang Chen et al. arxiv. [종이] [코드]

- [2023/05] 언어가 필요한 것은 아닙니다. 언어 모델과의 인식을 정렬합니다. Shaohan Huang et al. arxiv. [종이]

- [2023/05] OrstructBlip : 명령 튜닝이있는 일반 목적 비전 언어 모델을 향해. Wenliang Dai et al. arxiv. [종이]

- [2023/05] Multimodal-Gpt : 인간과의 대화를위한 비전 및 언어 모델. Tao Gong et al. arxiv. [종이]

- [2023/05] Pandagpt : 하나의 모델을 지시하는 한 가지 모델. Yixuan Su et al. arxiv. [종이]

- [2023/04] 시각적 명령 튜닝. Haotian Liu et al. arxiv. [종이]

- [2023/04] MINIGPT-4 : 고급 대형 언어 모델로 비전 언어 이해 향상. Deyao Zhu. arxiv. [종이]

- [2023/01] Blip-2 : 얼어 붙은 이미지 인코더 및 대형 언어 모델로 언어 이미지 사전 훈련 부트 스트랩. Junnan Li et al. arxiv. [종이]

- [2022/04] Flamingo : 소수의 학습을위한 시각적 언어 모델. Jean-Baptiste Alayrac et al. arxiv. [종이]

- [2021/10] MobileVit : 가벼운 가중, 일반적인 목적 및 모바일 친화적 인 비전 변압기. Sachin Mehta et al.Arxiv. [종이]

- [2021/05] MLP-MIXER : 비전을위한 모든 MLP 아키텍처. Ilya Tolstikhin et al.arxiv. [종이]

- [2020/10] 이미지는 16x16의 가치가 있습니다. 단어 : 이미지 인식을위한 변압기. Alexey Dosovitskiy et al. arxiv. [종이]

- [2017/11] 신경 개별 표현 학습. Aaron van Den Oord et al. arxiv. [종이]

1.2.2 오디오

- [2023/06] Video-Llama : 비디오 이해를위한 지시 조정 시청각 언어 모델. Hang Zhang et al. arxiv. [종이]

- [2023/05] X-LLM : 다중 공동성을 외국어로 취급하여 고급 대형 언어 모델을 부트 스트랩하는 것. Feilong Chen et al. arxiv. [종이]

- [2023/05] Interngpt : 언어를 넘어 Chatgpt와 상호 작용하여 비전 중심 작업을 해결합니다. Zhaoyang Liu et al. arxiv. [종이]

- [2023/04] Audiogpt : 연설, 음악, 소리 및 말하는 머리를 이해하고 생성합니다. Rongjie Huang et al. arxiv. [종이]

- [2023/03] Hugginggpt : chatgpt와 친구들과 함께 AI 작업을 포옹하는 얼굴에 AI 작업을 해결합니다. Yongliang Shen et al. arxiv. [종이]

- [2021/06] Hubert : 숨겨진 단위의 가면을 쓴 예측에 의한 자체 감독 언어 표현 학습. Wei-uning Hsu et al. arxiv. [종이]

- [2021/04] AST : 오디오 스펙트로 그램 변압기. Yuan Gong et al. arxiv. [종이]

1.3 조치 : LLM 기반 에이전트의 액션 공간 확장

1.3.1 도구 사용

- [2024/02] 불확실성 인식 언어 에이전트를 향한. Jiuzhou Han (Monash University) et al. arxiv. [종이] [프로젝트 페이지] [코드]

- [2023/10] OpenAgents : 야생의 언어 에이전트를위한 개방형 플랫폼. Xlang Lab (홍콩 대학교) Arxiv. [종이] [프로젝트 페이지] [코드] [데모]

- [2023/10] 여우 원숭이 : 언어 에이전트의 자연 언어 및 코드 조화 Yiheng Xu (University of Hong Kong) et al. arxiv. [종이] [코드]

- [2023/10] 다중 모달 큰 언어 모델을 통한 엔드 투 엔드 구체화 의사 결정 : GPT4- vision 및 Beyond Liang Chen (Peking University) et al. arxiv. [종이] [코드]

- Holmes는 LLM이 MLLMS 및 API를 활용하여 정보에 입각 한 의사 결정을위한 멀티 모달 정보를 수집 할 수있는 다중 에이전트 협력 프레임 워크입니다.

- [2023/07] TOOLLLM : 16000+ 실제 API를 마스터하기 위해 대형 언어 모델을 용이하게합니다. Yujia Qin (Tsinghua University) et al. arxiv. [논문] [코드] [데이터 세트]

- Toolllm은 데이터 구성, 모델 교육 및 평가를 포함하는 일반적인 도구 사용 프레임 워크입니다.

- [2023/05] 도구 제조업체로서 대형 언어 모델. Tianle Cai (Princeton University) et al. arxiv. [종이] [코드]

- LATM은 기존 도구의 가용성에 대한 의존성을 제거하기위한 초기 단계를 수행하는 폐쇄 루프 프레임 워크입니다.

- [2023/05] Creator : 도구 생성을 통한 대형 언어 모델의 초록 및 구체적인 추론을 분리합니다. Cheng Qian (Tsinghua University) et al. arxiv. [종이]

- Creator는 LLM이 문서화 및 코드 실현을 통해 자신의 도구를 만들 수있는 새로운 프레임 워크입니다.

- [2023/04] 기초 모델을 사용한 도구 학습. Yujia Qin (Tsinghua University) et al. arxiv. [종이] [코드]

- 이 설문 조사는 주로 "기초 모델을 기반으로 한 도구 학습"이라는 새로운 패러다임을 소개합니다. 이는 전문 도구와 기초 모델의 장점을 결합하여 문제 해결의 정밀도, 효율성 및 자동화를 달성합니다.

- [2023/04] Chemcrow : 화학 도구로 대규모 모델을 늘리기. Andres M Bran (인공 화학 지능 실험실, ISIC, EPFL) et al. arxiv. [종이] [코드]

- Chemcrow는 13 개의 전문가가 설계 한 도구를 통합하고 화학의 LLM 성능을 강화하고 새로운 기능을 강화하는 LLM 화학 에이전트입니다.

- [2023/04] Genegpt : 생물 의학 정보에 대한 액세스를 개선하기 위해 도메인 도구로 대형 언어 모델을 늘립니다. Qiao Jin (National Institutes of Health), Yifan Yang, Qingyu Chen, Zhiyong Lu. arxiv. [종이] [코드]

- Genegpt는 유전체학 질문에 답하는 모델입니다. LLMS에 웹 API를 사용하도록 가르치는 환각 문제를 처리하기위한 새로운 방법을 소개합니다.

- [2023/04] Openagi : LLM이 도메인 전문가를 만나는 경우. Yingqiang GE (Rutgers University) et al. arxiv. [종이] [코드]

- Openagi는 오픈 소스 AGI 연구 플랫폼입니다. 복잡한 작업 해결을위한 다양한 전문가 모델을 운영하는 LLM의 패러다임을 소개하고 LLM의 작업 해결 능력을 향상시키기위한 RLTF 메커니즘을 제안합니다.

- [2023/03] Hugginggpt : chatgpt와 친구들과 함께 AI 작업을 포옹하는 얼굴에 AI 작업을 해결합니다. Yongliang Shen (Zhejiang University) et al. arxiv. [종이] [코드]

- HuggingGpt는 LLM을 활용하여 기계 학습 커뮤니티에서 다양한 및 멀티 모달 AI 모델을 연결하여 AI 작업을 해결하는 시스템입니다.

- [2023/03] Visual Chatgpt : Visual Foundation 모델로 말하기, 그리기 및 편집. Chenfei Wu (Microsoft Research Asia) et al. arxiv. [종이] [코드]

- Visual Chatgpt는 시각적 기초 모델을 사용하여 Chatgpt의 시각적 역할을 조사하는 문을 열어주는 시스템입니다.

- [2023/02] 증강 언어 모델 : 설문 조사. Grégoire Mialon (Meta AI) et al. tmlr. [종이]

- 이 설문 조사 검토는 도구를 사용하는 기능으로 LMS가 보강되는 작업을 수행합니다. 증강 된 LMS는 외부 모듈을 사용하여 컨텍스트 처리 능력을 확장 할 수 있습니다.

- [2023/02] 도구 포맷 : 언어 모델은 도구를 사용하도록 가르 칠 수 있습니다. Timo Schick (Meta AI) et al. arxiv. [종이]

- Toolformer는 LLM이 각 API에 대해 소수의 데모와 함께 외부 도구를 사용하도록 가르 칠 수 있음을 보여줍니다.

- [2022/05] Talm : 도구 증강 언어 모델. Aaron Parisi (Google) et al. arxiv. [종이]

- Talm은 분리 불가능한 도구와 LMS를 결합하여 모델이 실시간 또는 개인 데이터에 액세스 할 수있는 방법을 소개합니다.

- [2022/05] MRKL Systems : 대형 언어 모델, 외부 지식 소스 및 개별 추론을 결합한 모듈 식 신경 상징적 아키텍처. Ehud Karpas (AI21 Labs) et al. arxiv. [종이]

- MRKL Systems는 쉽게 확장 가능한 외부 지식 및 추론 모듈 세트로 LLM을 보강합니다.

- [2022/04] 내가 말한대로 할 수있는대로 : 로봇 여유지의 접지 언어. Michael Ahn (Google) et al. CORL. [종이]

- Saycan은 LLM의 고급 시맨틱 지식을 미리 훈련 된 기술의 가치 기능과 결합하여 실제 로봇 작업에 LMS를 적용합니다.

- [2021/12] WebGpt : 인간의 피드백을 가진 브라우저 지원 질문 응답. Reiichiro Nakano (Openai) et al. arxiv. [종이]

- WebGpt는 웹 브라우징 환경을 사용하여 질문에 답변합니다. 훈련 중에 모방 학습을 사용한 다음 인간 피드백을 통해 답변 품질을 최적화합니다.

- [2021/07] 코드에서 훈련 된 대형 언어 모델 평가. Mark Chen (Openai) et al. arxiv. [종이] [코드]

- Codex는 문서를 기반으로 도구를 작성하여 Docstrings의 프로그램을 종합 할 수 있습니다.

1.3.2 구체화 된 행동

- [2023/12] 구체화 된 내비게이션을위한 일반적인 모델을 배우기 위해. Duo Zheng (중국 홍콩 대학교) et al. arxiv. [종이] [코드]

- [2023/11] 3D 세계의 구체화 된 일반 요원. Jiangyong Huang (Bigai & Peking University) et al. arxiv. [종이] [프로젝트 페이지]

- [2023/11] JARVIS-1 : 메모리-구분 다중 모드 언어 모델이있는 오픈 월드 멀티 태스킹 에이전트. Zihao Wang (Peking University) et al. arxiv. [종이] [코드]

- [2023/10] 여우 원숭이 : 언어 에이전트의 자연 언어 및 코드 조화 Yiheng Xu (University of Hong Kong) et al. arxiv. [종이] [코드]

- [2023/10] 다중 모달 대형 언어 모델을 통한 엔드 투 엔드 구체화 의사 결정 : GPT4- vision 및 Beyond Liang Chen et al. arxiv. [종이] [코드]

- [2023/07] 대화식 언어 : 실시간 로봇과 대화. Corey Lynch et al. IEEE (RAL) [종이]

- [2023/05] Voyager : 대형 언어 모델을 가진 개방형 구현제. Guanzhi Wang (Nvidia) et al. arxiv. [종이] [프로젝트 페이지] [코드]

- [2023/05] Avlen : 3D 환경에서의 시청각 언어 구현 내비게이션. Sudipta Paul et al. 신경관. [종이]

- [2023/05] 구체화 된 사고 사슬을 통한 시력 사전 훈련. Yao Mu et al. arxiv [종이] [코드]

- [2023/05] Navgpt : 큰 언어 모델을 사용한 비전 및 언어 내비게이션의 명시 적 추론. Gengze Zhou et al. Arxiv [종이]

- [2023/05] Alphablock : 로봇 조작에서 시력 언어 추론을위한 구체화 된 벌금. Chuhao Jin et al. Arxiv [종이]

- [2023/03] Palm-E : 구현 된 다중 모드 언어 모델. Danny Driess et al. arxiv. [종이]

- [2023/03] 반사 : 언어 강화 학습을 가진 언어 에이전트. Noah Shinn et al. Arxiv [paper] [code]

- [2023/02] Collaborating with language models for embodied reasoning. Ishita Dasgupta et al. Arxiv. [종이]

- [2023/02] Code as Policies: Language Model Programs for Embodied Control. Jacky Liang et al. IEEE (ICRA). [종이]

- [2022/10] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao et al. Arxiv [paper] [code]

- [2022/10] Instruction-Following Agents with Multimodal Transformer. Hao Liu et al. CVPR [paper] [code]

- [2022/07] Inner Monologue: Embodied Reasoning through Planning with Language Models. Wenlong Huang et al. Arxiv. [종이]

- [2022/07] LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action. Dhruv Shahet al. CoRL [paper] [code]

- [2022/04] Do As I Can, Not As I Say: Grounding Language in Robotic Affordances. Michael Ahn et al. Arxiv. [종이]

- [2022/01] A Survey of Embodied AI: From Simulators to Research Tasks. Jiafei Duan et al. IEEE (TETCI). [종이]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [종이] [코드]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [종이]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [종이]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arXiv. [종이] [코드]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arXiv. [종이]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [종이] [코드]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arXiv. [종이] [코드]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [종이]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [종이] [코드]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [종이] [코드]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [종이]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [종이] [코드]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [종이]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [종이]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [종이]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [종이]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [종이] [코드]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [종이] [코드]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [종이]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [종이]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [종이]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [종이]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [종이]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [종이] [코드]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [종이] [코드]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [종이] [코드]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [종이] [코드]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [종이] [코드]

2.2 Coordinating Potential of Multiple Agents

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [종이] [코드]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [종이] [코드]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [종이]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [종이]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [종이] [코드]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [종이] [코드]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [종이] [코드]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [종이]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [종이] [코드]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [종이] [코드]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [종이] [코드]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [종이] [코드]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [종이] [코드]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [종이]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [종이] [코드]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [종이] [코드]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [종이]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [종이] [코드]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [종이] [코드]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [종이]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [종이] [코드]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [종이] [코드]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [종이] [코드]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [종이]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [종이] [코드]

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

교육

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [종이]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [종이]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

건강

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [종이] [코드]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [종이]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [종이]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [종이]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [종이]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [종이]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [종이]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [종이]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [종이]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [종이] [코드]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [종이] [코드]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [종이]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [종이]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [종이]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [종이]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [종이]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al. 과학. [종이]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [종이]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [종이] [코드]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [종이] [코드]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [종이]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [종이] [코드]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [종이] [코드]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [종이]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [종이]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [종이] [코드]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [종이] [코드]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [종이] [코드]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [종이] [코드]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [종이] [코드]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [종이] [코드]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [종이]

3.1.2 Personality

인식

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [종이]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [종이]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [종이]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [종이]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [종이]

감정

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [종이]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [종이]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [종이]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [종이]

성격

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [종이] [코드]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [종이] [코드]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [종이] [코드]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [종이] [코드]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [종이]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [종이]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [종이] [코드]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [종이] [코드]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [종이]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [종이] [코드]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [종이] [코드]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [종이] [코드]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [종이] [코드]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [종이] [코드]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [종이] [코드]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [종이]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [종이] [코드]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [종이] [코드]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [종이]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [종이] [코드]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [종이]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [종이] [코드]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [종이] [코드]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [종이]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [종이] [코드]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [종이] [코드]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [종이] [코드]

소환

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

연락하다

Star History