Рост и потенциал агентов, основанных на моделях, на основе крупных языковых моделей: опрос

Обязательные документы для агентов на основе LLM.

? Скоро: добавьте вступление в каждую статью в одну предложение.

? Новости

- ☄ [2024/06/07] Agentgym был выпущен для разработки и развития агентов на основе LLM в различных средах!

- Бумага: AgentGym.

- Страница проекта: https://agentgym.github.io/.

- Коды: платформа и реализации.

- Ресурсы HuggingFace: AgentTraj-L, AgentEval, AgentEvol-7b.

- ? [2024/05/02] R3 (обучение крупных языковых моделей для рассуждений с помощью обучения подкреплению обратной программы) был принят ICML 2024!

- ? [2024/02/08] Новая бумага R3 на RL для Agent Agent Agage Agage Agivity! Документ: Обучение больших языковых моделей для рассуждения с помощью обучения подкреплению обратной программы. Коды: LLM-reverse-curriculum-rl.

- ? [2023/09/20] Этот проект был перечислен на трендах Github! Это большая честь!

- ? [2023/09/15] Наш опрос выпущен! Посмотрите на рост и потенциал агентов, основанных на моделях крупных языков: опрос для статьи!

- [2023/09/14] Мы создаем этот репозиторий для сохранения бумажного списка на агентах на основе LLM. Скоро появится больше документов!

? Введение

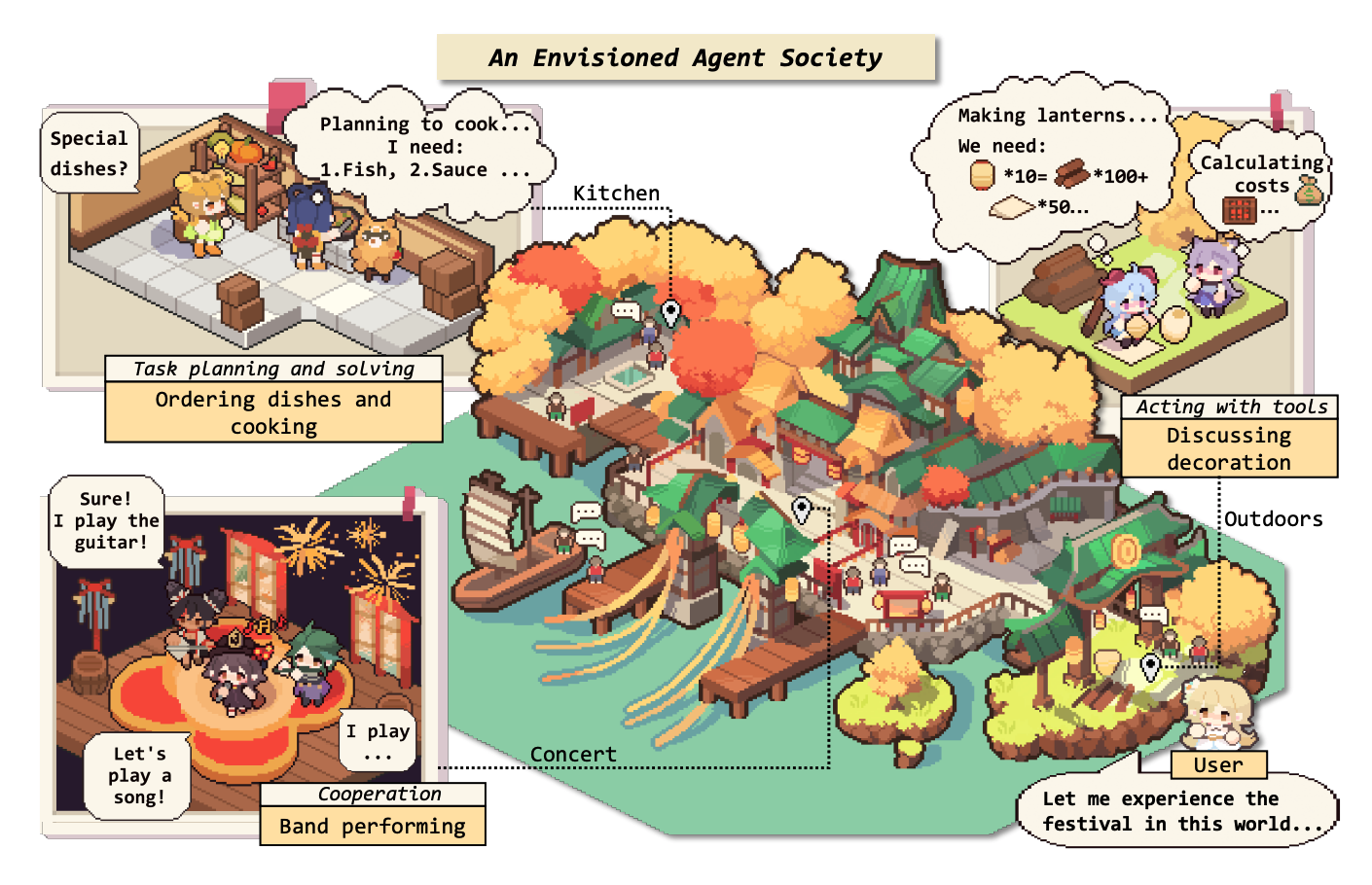

В течение долгого времени человечество преследовало искусственный интеллект (ИИ), эквивалентный или превосходящему человеческому уровню, при этом агенты ИИ считаются многообещающим средством этого преследования. Агенты ИИ - это искусственные сущности, которые ощущают свою среду, принимают решения и принимают действия.

Из -за универсальных и замечательных возможностей, которые они демонстрируют, крупные языковые модели (LLMS) рассматриваются как потенциальные искры для искусственного общего интеллекта (AGI), предлагая надежду на создание общих агентов ИИ. Многие исследовательские усилия использовали LLM в качестве основы для создания агентов ИИ и достигли значительного прогресса.

В этом репозитории мы предоставляем систематический и всесторонний опрос агентов на основе LLM и перечислим некоторые обязательные документы.

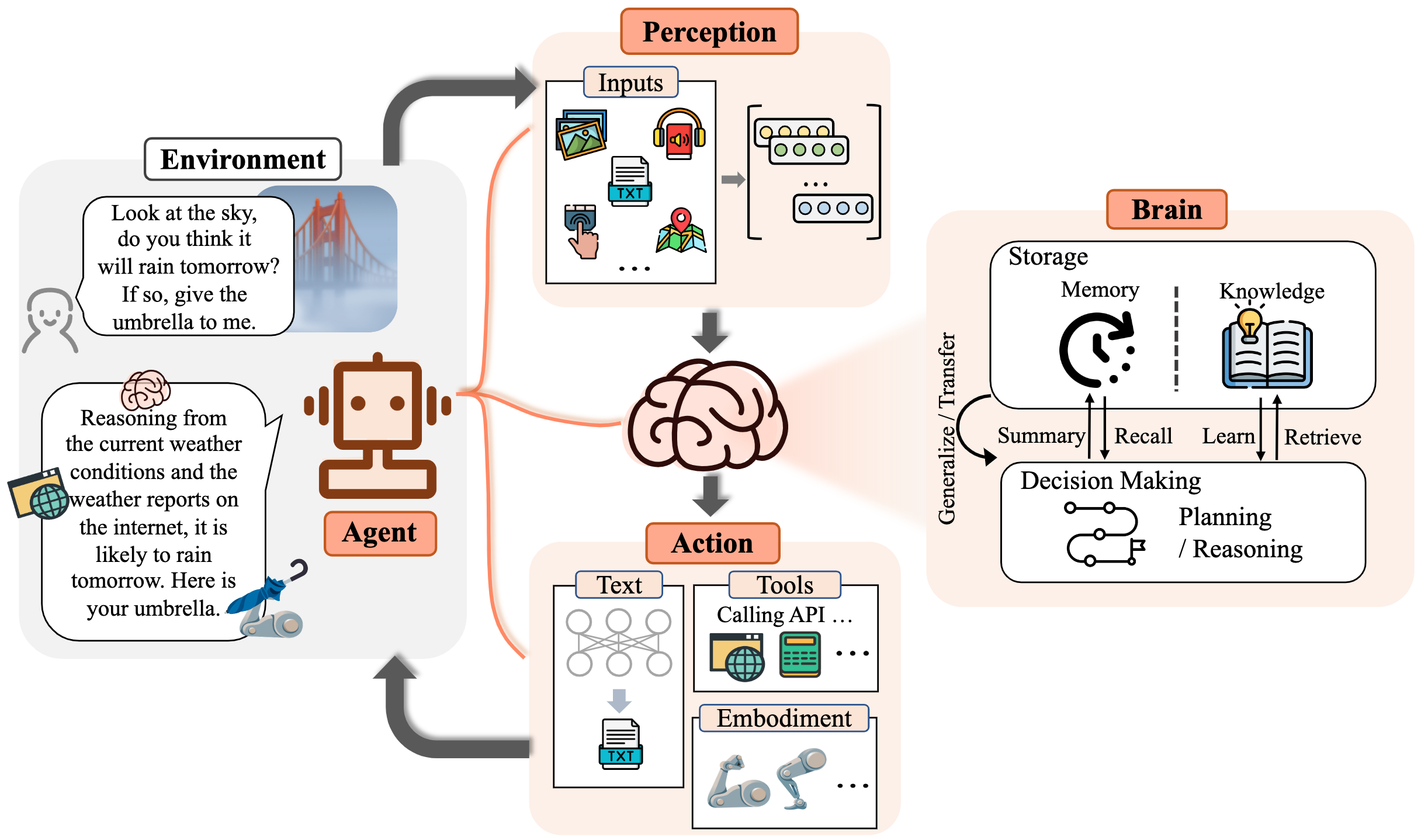

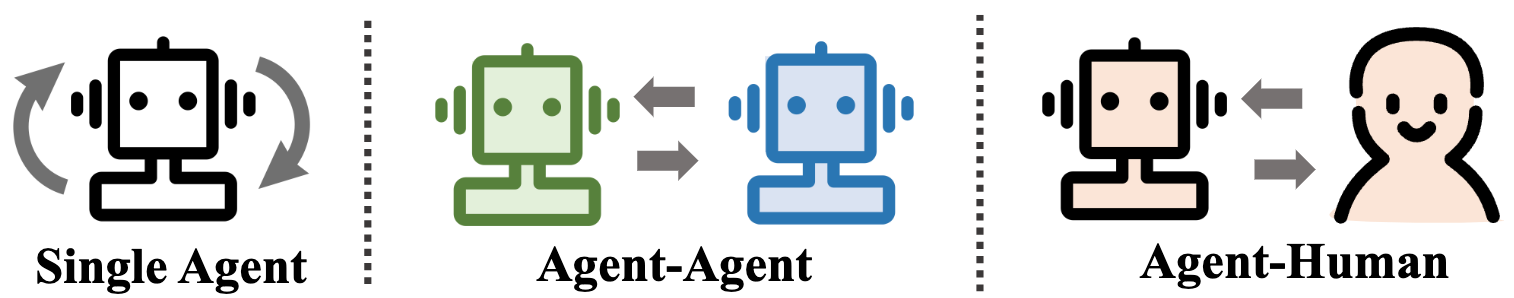

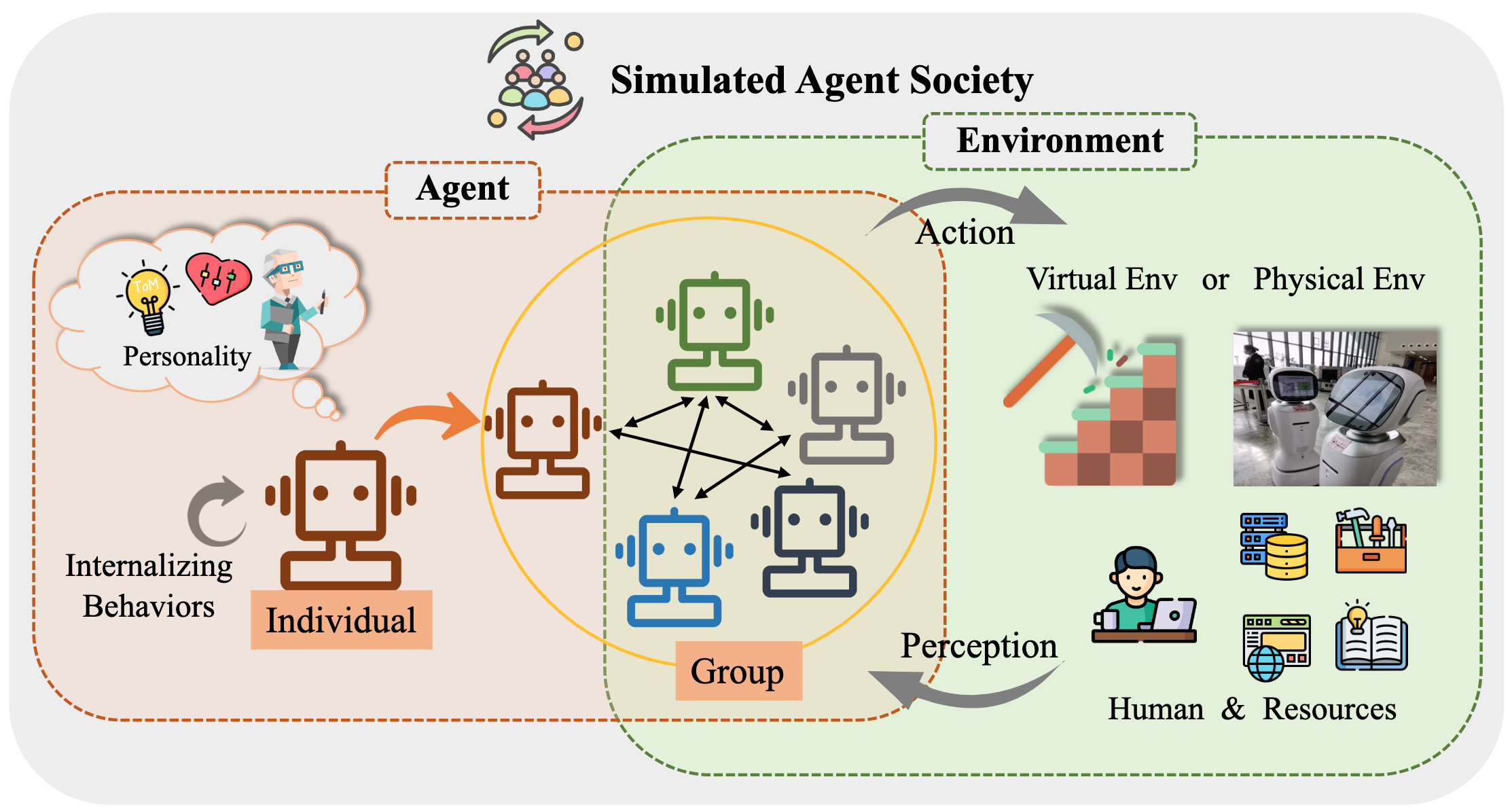

В частности, мы начинаем с общей концептуальной основы для агентов на основе LLM: включающие три основных компонента: мозг, восприятие и действие, а структура может быть адаптирована в соответствии с различными приложениями. Впоследствии мы исследуем обширные применения агентов на основе LLM в трех аспектах: сценарии с одним агентом, многоагентные сценарии и сотрудничество с агентом человека. После этого мы углубимся в агентские общества, исследуя поведение и личность агентов, основанных на LLM, социальные явления, которые возникают, когда они формируют общества, и понимание, которое они предлагают для человеческого общества. Наконец, мы обсуждаем ряд ключевых тем и открытых проблем в этой области.

Мы очень ценим любой вклад с помощью PRS, проблем, электронных писем или других методов.

Таблица содержания (TOC)

- Рост и потенциал агентов, основанных на моделях, на основе крупных языковых моделей: опрос

- ? Новости

- ? Введение

- Таблица содержания (TOC)

- 1. Рождение агента: строительство агентов на основе LLM

- 1.1 мозг: в основном состоит из LLM

- 1.1.1 Взаимодействие естественного языка

- Высококачественное поколение

- Глубокое понимание

- 1.1.2 Знание

- Предварительная модель

- Лингвистические знания

- Знание здравого смысла

- Действенные знания

- Потенциальные проблемы знаний

- 1.1.3 Память

- Возможность памяти

- Повышение предела длины трансформаторов

- Суммирование памяти

- Сжатие воспоминаний с векторами или структурами данных

- Поиск памяти

- 1.1.4 Рассуждение и планирование

- Рассуждение

- Планирование

- План формулировки

- Отражение плана

- 1.1.5 Переносимость и обобщение

- Невидимое обобщение задачи

- Внутреннее обучение

- Постоянное обучение

- 1.2 Восприятие: мультимодальные входы для агентов на основе LLM

- 1.3 Действие: расширить пространство действий агентов на основе LLM

- 1.3.1 Инструмент с использованием

- 1.3.2 воплощенное действие

- 2. Агенты на практике: применение агентов на основе LLM

- 2.1 Общая способность отдельного агента

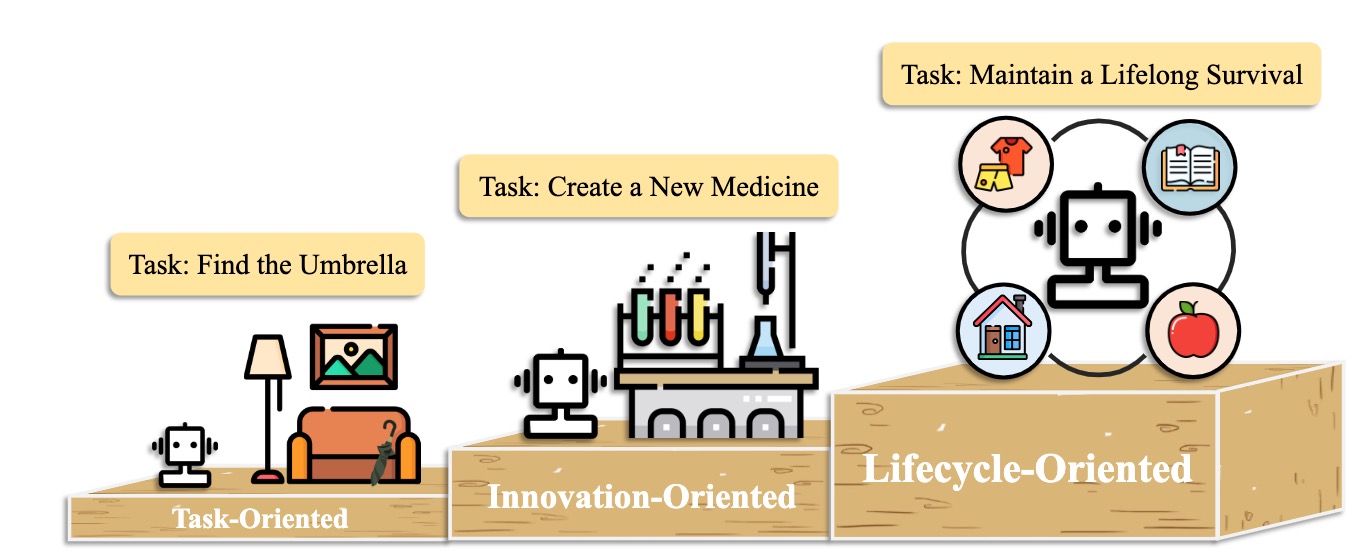

- 2.1.1. Ориентированное на задачу развертывание

- 2.1.2 Инновационное развертывание

- 2.1.3 Развертывание жизненного цикла

- 2.2 Координирующий потенциал множественных агентов

- 2.2.1 Кооперативное взаимодействие для взаимодополняемости

- 2.2.2 Адверскую взаимодействие для продвижения по службе

- 2.3 Интерактивное взаимодействие между человеком и агентом

- 2.3.1 Парадигма инструктора-Executor

- Образование

- Здоровье

- Другое приложение

- 2.3.2 Равное партнерство парадигма

- Эмпатический коммуникатор

- Участник на уровне человека

- 3. Агентное общество: от индивидуальности до социальности

- 3.1 Поведение и личность агентов на основе LLM

- 3.1.1 Социальное поведение

- Индивидуальное поведение

- Групповое поведение

- 3.1.2 Личность

- 3.2 Среда для агентского общества

- 3.2.1 Текстовая среда

- 3.2.2 Среда виртуальной песочницы

- 3.2.3 Физическая среда

- 3.3 Общество моделирование с агентами на основе LLM

- 4. Другие темы

- 4.1 тесты для агентов на основе LLM

- 4.2 Обучение и оптимизация агентов на основе LLM

- Цитирование

- Содействия проектам и участники

- Контакт

- Звездная история

1. Рождение агента: строительство агентов на основе LLM

1.1 мозг: в основном состоит из LLM

1.1.1 Взаимодействие естественного языка

Высококачественное поколение

- [2023/10] На пути к принятию решений с заклейкой через многомодальную большую языковую модель: исследования с GPT4-Vision и за пределами Liang Chen et al. arxiv. [Paper] [Код]

- В этой работе предлагается PCA-eval, в которой задачи воплощают решения с помощью методов, основанных на MLLM на основе MLLM, и методов использования инструментов на основе LLM из уровней восприятия, познания и действий.

- [2023/08] многозадачная многоязычная, мультимодальная оценка CHATGPT по рассуждениям, галлюцинации и интерактивности. Yejin Bang et al. arxiv. [бумага]

- Эта работа оценивает многозадачные, многоязычные и мультимодальные аспекты CHATGPT с использованием 21 набора данных, охватывающих 8 различных общих задач приложения NLP.

- [2023/06] LLM-Eval: единая многомерная автоматическая оценка для разговоров с открытым доменом с большими языковыми моделями. Yen-Ting Lin et al. arxiv. [бумага]

- Метод LLM-Eval оценивает множество аспектов оценки, таких как содержание, грамматика, актуальность и уместность.

- [2023/04] Является ли CHATGPT высокоэффективной системой коррекции грамматических ошибок? Комплексная оценка. Дао Фан и соавт. arxiv. [бумага]

- Результаты оценки показывают, что CHATGPT обладает отличными возможностями обнаружения ошибок и может свободно исправить ошибки, чтобы сделать исправленные предложения очень беглыми. Кроме того, его производительность в условиях неанглийских и низких ресурсов подчеркивает его потенциал в многоязычных задачах GEC.

Глубокое понимание

- [2023/06] Умный Ганс или Нейронная теория ума? Стресс -тестирование социальных рассуждений в моделях крупных языков. Натали Шапира и соавт. arxiv. [бумага]

- LLM демонстрируют определенную теорию способностей ума, но это поведение далеко не надежно.

- [2022/08] Вывод на вознаграждения из языка в контексте. Джесси Лин и соавт. Acl. [бумага]

- Эта работа представляет собой модель, которая предоставляет вознаграждения от языка и предсказывает оптимальные действия в невидимой среде.

- [2021/10] Теория вспомогательного общения на основе разума в сложном сотрудничестве с роботом человека. Moritz C. Buehler et al. arxiv. [бумага]

- Эта работа разрабатывает агента суши с пониманием человека во время взаимодействия.

1.1.2 Знание

Предварительная модель

- [2023/04] Обучение распределенным представлениям предложений из немапендированных данных. Феликс Хилл (Кембриджский университет) и др. arxiv. [бумага]

- [2020/02] Сколько знаний вы можете собрать в параметры языковой модели? Адам Робертс (Google) и соавт. arxiv. [бумага]

- [2020/01] Законы масштабирования для моделей нейронного языка. Джаред Каплан (Университет Джона Хопкинса) и др. arxiv. [бумага]

- [2017/12] Знание Commonsense в машинном интеллекте. Niket Tandon (Аллен Институт искусственного интеллекта) и соавт. Сигмод. [бумага]

- [2011/03] Обработка естественного языка (почти) с нуля. Ronan Collobert (Принстон) и соавт. arxiv. [бумага]

Лингвистические знания

- [2023/02] многозадачная многоязычная, мультимодальная оценка CHATGPT по рассуждениям, галлюцинации и интерактивности. Yejin Bang et al. arxiv. [бумага]

- [2021/06] Процессы для предварительно обученных языковых моделей для семантических атрибутов и их ценностей. Meriem Beloucif et al. Emnlp. [бумага]

- [2020/10] Исследование моделей на предварительно подготовленных языках для лексической семантики. Иван Вулич и соавт. arxiv. [бумага]

- [2019/04] Структурный зонд для поиска синтаксиса в представлениях слов. John Hewitt et al. Acl. [бумага]

- [2016/04] Улучшение автоматического извлечения ключевых слов с учетом более семантических знаний. H LEUNG. Системы для передовых приложений. [бумага]

Знание здравого смысла

- [2022/10] Языковые модели кода являются учащимися в здравом смысле. Aman Madaan et al.arxiv. [бумага]

- [2021/04] Реляционное представление о мировых знаниях в контекстных языковых моделях: обзор. Tara Safavi et al. arxiv. [бумага]

- [2019/11] Как мы можем узнать, какие языковые модели знают? Zhengbao Jiang et al.arxiv. [бумага]

Действенные знания

- [2023/07] Большие языковые модели в медицине. Arun James Thirunavukarasu et al. природа. [бумага]

- [2023/06] DS-1000: естественный и надежный эталон для генерации кодов данных. Yuhang Lai et al. ICML. [бумага]

- [2022/10] Языковые модели кода являются учащимися в здравом смысле. Aman Madaan et al. arxiv. [бумага]

- [2022/02] Систематическая оценка крупных языковых моделей кода. Фрэнк Ф. Сюй и др. Арксив. [бумага]

- [2021/10] Обучение проверки для решения задач математического слова. Karl Cobbe et al. arxiv. [бумага]

Потенциальные проблемы знаний

- [2023/10] Freshllms: освежающие большие языковые модели с увеличением поисковой системы. Tu Vu (Google) и соавт. arxiv [paper] [код]

- [2023/05] Редактирование больших языковых моделей: проблемы, методы и возможности. Yunzhi Yao et al. arxiv. [бумага]

- [2023/05] Самоучека: модули подключаемого и игрока для проверки фактов с большими языковыми моделями. Miaoran Li et al. arxiv. [бумага]

- [2023/05] Критик: Модели больших языков могут самокорректировать с интерационной критикой инструмента. Zhibin Gou et al. arxiv. [бумага]

- [2023/04] Изучение инструментов с моделями фундамента. Yujia Qin et al. arxiv. [бумага]

- [2023/03] SelfCheckgpt: Обнаружение галлюцинации черного ящика с нулевым ресурсом для генеративных моделей крупных языков. Потсави Манакул и соавт. arxiv. [бумага]

- [2022/06] Редактирование модели на основе памяти в масштабе. Eric Mitchell et al. arxiv. [бумага]

- [2022/04] Обзор языковых моделей в качестве баз знаний. Badr Alkhamissi et al.arxiv. [бумага]

- [2021/04] Редактирование фактических знаний в языковых моделях. Никола де Као и др. Арксив. [бумага]

- [2017/08] Измерение катастрофических забывений в нейронных сетях. Рональд Кемкер и соавт. [бумага]

1.1.3 Память

Возможность памяти

Повышение предела длины трансформаторов

- [2023/10] MEMGPT: к LLMS в качестве операционных систем. Charles Packer (UC Berkeley) et al. arxiv. [Paper] [Project Page] [Code] [DataSet]

- [2023/05] Рандомизированные позиционные кодировки повышают длина длина генерализации трансформаторов. Anian Ruoss (DeepMind) et al. arxiv. [Paper] [Код]

- [2023-03] COLT5: более быстрые преобразователи на большие расстояния с условными вычислениями. Джошуа Эйнсли (Google Research) и соавт. arxiv. [бумага]

- [2022/03] Эффективная классификация длинных документов с использованием трансформаторов. Hyunji Hayley Park (Университет Иллинойса) и др. arxiv. [Paper] [Код]

- [2021/12] Longt5: эффективный трансформатор текста в текст для длинных последовательностей. Мэнди Го (Google Research) et al. arxiv. [Paper] [Код]

- [2019/10] BART: двойная последовательность к последовательности предварительной тренировки для генерации, перевода и понимания естественного языка. Майкл Льюис (Facebook AI) и соавт. arxiv. [Paper] [Код]

Суммирование памяти

- [2023/10] Прогулка по лабиринту памяти: за пределами контекста через интерактивное чтение Говард Чен (Принстонский университет) и соавт. arxiv. [бумага]

- [2023/09] Расширение возможностей частного репетитора путем цепочки крупных языковых моделей Юлин Чен (Университет Цингхуа) и др. arxiv. [бумага]

- [2023/08] Экспет: Агенты LLM являются опытными учащимися. Эндрю Чжао (Университет Цингхуа) и др. arxiv. [Paper] [Код]

- [2023/08] Chateval: к лучшим оценщикам на основе LLM посредством многоагентных дебатов. Chi-Min Chan (Университет Цинхуа) и др. arxiv. [Paper] [Код]

- [2023/05] Bemory Bank: улучшение больших языковых моделей с долговременной памятью. Wanjun Zhong (Харбинский технологический институт) и соавт. arxiv. [Paper] [Код]

- [2023/04] Генеративные агенты: интерактивная симулякра человеческого поведения. Joon Sung Park (Стэнфордский университет) и др. arxiv. [Paper] [Код]

- [2023/04] Выключение входной способности бесконечной длины для крупномасштабных языковых моделей с самоконтролируемой системой памяти. Синнян Лян (Университет Бейханга) и соавт. arxiv. [Paper] [Код]

- [2023/03] Рефлексия: языковые агенты с устным обучением подкрепления. Noah Shinn (Северо -Восточный университет) и др. arxiv. [Paper] [Код]

- [2023/05] RecurrentGPT: интерактивная генерация (произвольно) длинного текста. Wangchunshu Zhou (AIwaves) et al. arxiv. [Paper] [Код]

Сжатие воспоминаний с векторами или структурами данных

- [2023/07] Коммуникативные агенты для разработки программного обеспечения. Чен Цянь (Университет Цингхуа) и соавт. arxiv. [Paper] [Код]

- [2023/06] Чатдб: расширение LLM с базами данных в качестве их символической памяти. Chenxu Hu (Университет Цинхуа) и др. arxiv. [Paper] [Код]

- [2023/05] Призрак в Minecraft: в целом способные агенты для среды открытого мира с помощью крупных языковых моделей с текстовыми знаниями и памятью. Xizhou Zhu (Университет Цингхуа) и др. arxiv. [Paper] [Код]

- [2023/05] ret-llm: к общей памяти чтения для чтения для больших языковых моделей. Ali Modarressi (LMU Munich) и соавт. arxiv. [Paper] [Код]

- [2023/05] RecurrentGPT: интерактивная генерация (произвольно) длинного текста. Wangchunshu Zhou (AIwaves) et al. arxiv. [Paper] [Код]

Поиск памяти

- [2023/08] Песочница памяти: прозрачное и интерактивное управление памятью для разговорных агентов. Ziheng Huang (Калифорнийский университет - San Diego) et al. arxiv. [бумага]

- [2023/08] Агентсими: песочница с открытым исходным кодом для оценки модели большой языка. Jiaju Lin (PTA Studio) и соавт. arxiv. [Paper] [Project Page] [Код]

- [2023/06] Чатдб: расширение LLM с базами данных в качестве их символической памяти. Chenxu Hu (Университет Цинхуа) и др. arxiv. [Paper] [Код]

- [2023/05] Bemory Bank: улучшение больших языковых моделей с долговременной памятью. Wanjun Zhong (Харбинский технологический институт) и соавт. arxiv. [Paper] [Код]

- [2023/04] Генеративные агенты: интерактивная симулякра человеческого поведения. Joon Sung Park (Стэнфорд) и соавт. arxiv. [Paper] [Код]

- [2023/05] RecurrentGPT: интерактивная генерация (произвольно) длинного текста. Wangchunshu Zhou (AIwaves) et al. arxiv. [Paper] [Код]

1.1.4 Рассуждение и планирование

Рассуждение

[2024/02] Обучение большим языковым моделям для рассуждений с помощью обучения подкреплению обратной учебной программы. Zhiheng XI (Университет Фудана) и соавт. arxiv. [Paper] [Код]

[2023/09] Примирение: конференция за круглым столом улучшает рассуждения посредством консенсуса среди разнообразных LLM. Джастин Чих-Яо Чен (Университет Северной Каролины в Чапел-Хилл) и соавт. arxiv. [Paper] [Код]

[2023/05] Самополиш: улучшить рассуждения в крупных языковых моделях посредством уточнения проблем. Zhiheng XI (Университет Фудана) и соавт. arxiv. [Paper] [Код]

[2023-03] Большие языковые модели-это с нулевыми выстрелами. Такеши Кодзима (Университет Токио) и соавт. arxiv. [Paper] [Код]

[2023/03] Саморефина: итеративная уточнение с помощью самоотдачи. Аман Мадан (Университет Карнеги -Меллона) и др. arxiv. [Paper] [Код]

[2022/05] Отбор инференции: использование больших языковых моделей для интерпретируемого логического рассуждения. Antonia Creswell (DeepMind) et al. arxiv. [бумага]

[2022/03] самосогласованность улучшает цепочку мышления в языковых моделях. Xuezhi Wang (Google Research) et al. arxiv. [Paper] [Код]

[2023/02] Мультимодальная цепочка мышления в языковых моделях. Zhuosheng Zhang (Университет Шанхай Цзяо Тонг) и др. arxiv. [Paper] [Код]

[2022/01] Индикация цепочки мыслей вызывает рассуждения в моделях крупных языков. Джейсон Вэй (Google Research) и соавт. arxiv. [бумага]

Планирование

План формулировки

- [2023/11] Джарвис-1: мультизадачные агенты с открытым миром с моделями с мультимодальным языком с автокьюменом. Zihao Wang (Peking University) et al. arxiv. [Paper] [Код]

- [2023/10] Языковые агенты Поиск дерева объединяет рассуждения и планирование в языковых моделях. Энди Чжоу (Университет Иллинойса Урбана-Шампейн) и соавт. arxiv. [Paper] [Project Page] [Код]

- [2023/05] Дерево мыслей: преднамеренное решение проблем с большими языковыми моделями. Shunyu Yao (Принстонский университет) и др. arxiv. [Paper] [Код]

- [2023/05] План, устранение и отслеживание - языковые модели являются хорошими учителями для воплощенных агентов. Юэ У (Университет Карнеги -Меллона) и др. arxiv. [бумага]

- [2023/05] Рассуждение с языковой моделью планирует с мировой моделью. Shibo Hao (UC San Diego) et al. arxiv. [Paper] [Код]

- [2023/05] Swiftsage: генеративный агент с быстрым и медленным мышлением для сложных интерактивных задач. Билл Юхен Лин (Институт искусственного интеллекта Аллена (Аллен) и соавт. arxiv. [Paper] [Код]

- [2023/04] LLM+P: расширение возможностей крупных языковых моделей с оптимальным мастерством планирования. Бо Лю (Университет Техаса в Остине) и соавт. arxiv. [Paper] [Код]

- [2023/03] HuggingGpt: решение задач AI с Chatgpt и его друзьями в обнимании лица. Yongliang Shen (Microsoft Research Asia) et al. arxiv. [Paper] [Код]

- [2023/02] Опишите, объясните, планируйте и выберите: интерактивное планирование с большими языковыми моделями позволяет многозадачному открытому миру. Zihao Wang (Peking University) et al. arxiv. [Paper] [Код]

- [2022/05] Наименьшее количество подсказок позволяет сложные рассуждения в моделях крупных языков. Denny Zhou (Google Research) et al. arxiv. [бумага]

- [2022/05] Системы MRKL: модульная нейро-символическая архитектура, которая сочетает в себе крупные языковые модели, внешние источники знаний и дискретные рассуждения. Ehud Karpas (AI21 Labs) et al. arxiv. [бумага]

- [2022/04] Делайте так, как я могу, не как я говорю: основание языка роботизированных возможностей. Michael Ahn (Robotics at Google) и соавт. arxiv. [бумага]

- [2023/05] Агенты: рамка с открытым исходным кодом для автономных языковых агентов. Wangchunshu Zhou (AIwaves) et al. arxiv. [Paper] [Код]

- [2022/12] Не генерируйте, дискриминация: предложение о основании языковых моделей в реальных средах. Ю Гу (Университет штата Огайо) и соавт. Acl. [Paper] [Код]

Отражение плана

- [2024/02] Agent-Pro: Learning для развития посредством размышлений и оптимизации на уровне политики Wenqi Zhang (Университет Чжэцзян) и др. arxiv. [Paper] [Код]

- [2024/01] Самоконтрастирование: лучшее размышление посредством непоследовательных перспектив решения Wenqi Zhang (Университет Чжэцзян) и др. arxiv. [бумага]

- [2023/11] Джарвис-1: мультизадачные агенты с открытым миром с моделями с мультимодальным языком с автокьюменом. Zihao Wang (Peking University) et al. arxiv. [Paper] [Код]

- [2023/10] Цепочка проверки уменьшает галлюцинацию в моделях крупных языков. Shehzaad Dhuliawala (Meta Ai & Eth Zu ̈rich) и соавт. arxiv. [бумага]

- [2023/10] Fireact: к языковому агенту тонкую настройку. Baian Chen (System2 Research) et al. arxiv. [Paper] [Project Page] [Code] [DataSet]

- [2023/08] SelfeCheck: Использование LLMS для нулевого выстрела Проверьте их собственные пошаговые рассуждения. Ning Miao (Оксфордский университет) и др. arxiv. [Paper] [Код]

- [2023/05] Чаткот: Абюссионная инструментальная цепочка для цепочки мыслей о больших языковых моделях, основанных на чате. Zhipeng Chen (Китайский университет Ренмин) и соавт. arxiv. [Paper] [Код]

- [2023/05] Voyager: открытый воплощенный агент с большими языковыми моделями. Гуаньчхи Ван (NVIDIA) и соавт. arxiv. [Paper] [Project Page] [Код]

- [2023/03] Общайтесь с окружающей средой: интерактивное мультимодальное восприятие с использованием крупных языковых моделей. Xufeng Zhao (University Hamburg) et al. arxiv. [Paper] [Код]

- [2022/12] LLM-Planner: несколько выстрелов в планировании воплощенных агентов с большими языковыми моделями. Чан Хи Сонг (Университет штата Огайо) и соавт. arxiv. [Paper] [Код]

- [2022/10] React: синергирование рассуждений и действия в языковых моделях. Shunyu Yao (Принстонский университет) и др. arxiv. [Paper] [Код]

- [2022/07] Внутренний монолог: воплощенные рассуждения посредством планирования с языковыми моделями. Wenlong Huang (Robotics at Google) и соавт. arxiv. [Paper] [Код]

- [2021/10] Цепочки AI: прозрачное и контролируемое взаимодействие человека-AI путем цепочки подсказок с большим языком. Tongshuang Wu (Университет Вашингтона) и др. arxiv. [бумага]

1.1.5 Переносимость и обобщение

Невидимое обобщение задачи

- [2024/06] Agentgym: развитие крупных языковых агентов на основе моделей в различных средах. Zhiheng XI (Университет Фудана) и соавт. arxiv. [Paper] [Project Page] [Коды и платформа] [DataSet] [Benchmark] [Модель].

- [2023/10] Агент. Aohan Zeng (Университет Цингхуа) и др. arxiv. [Paper] [Project Page] [Code] [DataSet]

- [2023/10] Лемур: гармонизирующий естественный язык и код для языковых агентов Yiheng Xu (Университет Гонконга) и др. arxiv. [Paper] [Код]

- [2023/05] Обучение языковых моделей, чтобы следовать инструкциям с отзывами человека. Long Ouyang et al. Невра. [бумага]

- INSTRUCTGPT: выравнивание языковых моделей с намерением пользователя в широком диапазоне задач путем точной настройки с обратной связью с человека.

- [2023/01] Многозадачная подготовка позволяет обобщать задачи с нулевым выстрелом. Виктор Сан и соавт. ICLR. [Paper] [Код]

- T0: T0-это модель Encoder-Decoder, которая потребляет текстовые входы и производит целевые ответы. Он обучается многозадачному смесь наборов данных NLP, разделенных на различные задачи.

- [2022/10] масштабирование инструкционно-финологичных языковых моделей. Hyung Win Chung et al. arxiv. [Paper] [Код]

- В этой работе исследуется создание инструкций с особым акцентом на масштабирование количества задач и размера модели, что повышает производительность в различных классах моделей, подсказывании настройки и оценке оценки.

- [2022/08] Созданные языковые модели являются учениками с нулевым выстрелом. Джейсон Вэй и соавт. ICLR. [бумага]

- ФЛАН: Настройка инструкций существенно повышает производительность с нулевым выстрелом по невидимым задачам.

Внутреннее обучение

- [2023/08] Изображения говорят на изображениях: художник-генеральный художник для визуального обучения в контексте. Xinlong Wang et al. IEEE. [Paper] [Код]

- Художник: Эта работа представляет собой обобщенную модель для визуального обучения в контексте с помощью «изображения» -центрического решения.

- [2023/08] Языковые модели нейронного кодека представляют собой нулевой выстрел текст к речевым синтезаторам. Ченги Ван и соавт. arxiv. [Paper] [Код]

- VALL-E: Эта работа обучает языковой модели нейронного кодека, которая появляется в контексте обучения.

- [2023/07] Опрос для обучения в контексте. Qingxiu Dong et al. arxiv. [бумага]

- В этом опросе суммируется прогресс и проблемы в контексте обучения (ICL).

- [2023/05] Языковые модели-это несколько выстрелов. Том Б. Браун (Openai) и соавт. Невра. [бумага]

- GPT-3: масштабирование языковых моделей значительно улучшает, агрессические, невысокие результаты, иногда даже становясь конкурентоспособными с предыдущими современными подходами к тонкой настройке.

Постоянное обучение

- [2023/11] Джарвис-1: мультизадачные агенты с открытым миром с моделями с мультимодальным языком с автокьюменом. Zihao Wang (Peking University) et al. arxiv. [Paper] [Код]

- [2023/07] Прогрессивные подсказки: постоянное обучение для языковых моделей. Razdaibiedina et al. arxiv. [бумага]

- Эта работа вводит прогрессивные подсказки, которые позволяют перспективно переносить и сопротивляться катастрофическим забываниям, не полагаясь на воспроизведение данных или большое количество параметров, специфичных для задачи.

- [2023/05] Voyager: открытый воплощенный агент с большими языковыми моделями. Гуаньчхи Ван (NVIDIA) и соавт. arxiv. [Paper] [Project Page] [Код]

- Voyager: Это пример воплощенного LLM-обучающего агента в Minecraft, который постоянно исследует мир, приобретает различные навыки и делает новые открытия без вмешательства человека.

- [2023/01] Комплексный обзор постоянного обучения: теория, метод и применение. Liyuan Wang et al. arxiv. [бумага]

- В этом опросе представлена комплексное обследование постоянного обучения, стремящегося преодолеть основные условия, теоретические основы, репрезентативные методы и практические применения.

- [2022/11] Постоянное изучение задач обработки естественного языка: опрос. Zixuan Ke et al. arxiv. [бумага]

- В этом опросе представлен всеобъемлющий обзор и анализ недавнего прогресса CL в НЛП.

1.2 Восприятие: мультимодальные входы для агентов на основе LLM

1.2.1 Визуал

- [2024/01] Агент AI: Обследование горизонтов мультимодального взаимодействия. Zane Durante et al. arxiv. [бумага]

- [2023/10] На пути к принятию решений с заклейкой через многомодальную большую языковую модель: исследования с GPT4-Vision и за пределами Liang Chen et al. arxiv. [Paper] [Код]

- [2023/05] Язык - это не все, что вам нужно: согласование восприятия с языковыми моделями. Shaohan Huang et al. arxiv. [бумага]

- [2023/05] Инструктируйте: к моделям общего назначения на языке зрения с настройкой инструкций. Wenliang Dai et al. arxiv. [бумага]

- [2023/05] Мультимодальный-ГПТ: видение и языковая модель для диалога с людьми. Тао Гонг и соавт. arxiv. [бумага]

- [2023/05] Pandagpt: одна модель для подготовки к их всеми. Yixuan Su et al. arxiv. [бумага]

- [2023/04] Настройка визуальной инструкции. Haotian Liu et al. arxiv. [бумага]

- [2023/04] Minigpt-4: улучшение понимания зрения с помощью расширенных моделей крупных языков. Деяо Чжу. arxiv. [бумага]

- [2023/01] BLIP-2: предварительная тренировка языка на начальной загрузке с замороженными кодерами изображения и большими языковыми моделями. Junnan Li et al. arxiv. [бумага]

- [2022/04] Фламинго: модель визуального языка для нескольких выстрелов. Жан-Батист Alayrac et al. arxiv. [бумага]

- [2021/10] MobileVit: легкий, общий и мобильный трансформатор. Sachin Mehta et al.arxiv. [бумага]

- [2021/05] MLP-Mixer: архитектура All-MLP для зрения. Илья Толстихин и др. Арксив. [бумага]

- [2020/10] Изображение стоит 16x16 слов: трансформаторы для распознавания изображений в масштабе. Alexey Dosovitskiy et al. arxiv. [бумага]

- [2017/11] Нейронное дискретное обучение. Aaron van den Oord et al. arxiv. [бумага]

1.2.2 Аудио

- [2023/06] Видео-лама: модель аудиовизуального языка, настроенная на инструкции для понимания видео. Hang Zhang et al. arxiv. [бумага]

- [2023/05] X-LLM: начальная загрузка расширенных крупных языковых моделей, рассматривая мультимодалитеты как иностранные языки. Feilong Chen et al. arxiv. [бумага]

- [2023/05] Interngpt: решение, ориентированные на зрение задач, взаимодействуя с Chatgpt за пределами языка. Zhaoyang Liu et al. arxiv. [бумага]

- [2023/04] Audiogpt: понимание и генерирование речи, музыки, звука и говорящей головы. Rongjie Huang et al. arxiv. [бумага]

- [2023/03] HuggingGpt: решение задач AI с Chatgpt и его друзьями в обнимании лица. Yongliang Shen et al. arxiv. [бумага]

- [2021/06] Хьюберт: самоотверженное обучение речи с помощью предсказания скрытых подразделений замаскированного. Wei-eng Hsu et al. arxiv. [бумага]

- [2021/04] AST: Аудио -спектрограмма трансформатор. Yuan Gong et al. arxiv. [бумага]

1.3 Действие: расширить пространство действий агентов на основе LLM

1.3.1 Инструмент с использованием

- [2024/02] На пути к неопределенному языковому агенту. Jiuzhou Han (Университет Монаш) и соавт. arxiv. [Paper] [Project Page] [Код]

- [2023/10] Openagents: открытая платформа для языковых агентов в дикой природе. Xlang Lab (Университет Гонконга) Arxiv. [Paper] [Project Page] [Code] [Демо]

- [2023/10] Лемур: гармонизирующий естественный язык и код для языковых агентов Yiheng Xu (Университет Гонконга) и др. arxiv. [Paper] [Код]

- [2023/10] На пути к принятию решений с заклейкой через многомодальную модель большого языка: исследования с GPT4-Vision и за пределами Liang Chen (Peking University) et al. arxiv. [Paper] [Код]

- Holmes-это многоагентная структура сотрудничества, которая позволяет LLMS использовать MLLM и API для сбора мультимодальной информации для информированного принятия решений.

- [2023/07] TOOLLLM: Облегчение больших языковых моделей для освоения API-интерфейсов реального мира 16000+. Юдзия Цинь (Университет Цинхуа) и др. arxiv. [Paper] [Code] [Набор данных]

- TOOLLLM-это общая структура использования инструментов, охватывающая конструкцию данных, обучение и оценку модели.

- [2023/05] Большие языковые модели в качестве производителей инструментов. Tianle Cai (Принстонский университет) и др. arxiv. [Paper] [Код]

- LATM-это структура с замкнутым контуром, которая делает начальный шаг к удалению зависимости от доступности существующих инструментов.

- [2023/05] Создатель: рассеяние абстрактных и конкретных рассуждений крупных языковых моделей посредством создания инструментов. Ченг Цянь (Университет Цингхуа) и др. arxiv. [бумага]

- Creator - это новая структура, которая расширяет возможности LLM для создания своих собственных инструментов посредством документации и реализации кода.

- [2023/04] Изучение инструментов с моделями фундамента. Юдзия Цинь (Университет Цинхуа) и др. arxiv. [Paper] [Код]

- Этот опрос в первую очередь вводит новую парадигму, называемую «обучение инструментам на основе основополагающих моделей», которая сочетает в себе преимущества специализированных инструментов и основополагающих моделей, достигая более высокой точности, эффективности и автоматизации в решении проблем.

- [2023/04] Chemcrow: увеличение крупных моделей с помощью химических инструментов. Andres M Bran (Лаборатория искусственного химического интеллекта, ISIC, EPFL) и соавт. arxiv. [Paper] [Код]

- Chemcrow-это агент химии LLM, который интегрирует 13 разработанных экспертами инструментами и повышает производительность LLM в химии и получает новые возможности.

- [2023/04] Genegpt: увеличение больших языковых моделей с помощью инструментов домена для улучшения доступа к биомедицинской информации. Цяо Джин (Национальные институты здравоохранения), Йифан Ян, Циню Чен, Чжийонг Лу. arxiv. [Paper] [Код]

- Genegpt - это модель, которая отвечает на вопросы геномики. Он вводит новый метод для решения проблем с галлюцинациями путем обучения LLMS для использования веб -API.

- [2023/04] Openagi: когда LLM встречает экспертов по домену. Yingqiang GE (Университет Рутгерса) и соавт. arxiv. [Paper] [Код]

- Openagi-это исследовательская платформа AGI с открытым исходным кодом. Он вводит парадигму LLMS, работающих на различных экспертных моделях для сложного решения задач, и предлагает механизм RLTF для улучшения способности LLM для решения задач.

- [2023/03] HuggingGpt: решение задач AI с Chatgpt и его друзьями в обнимании лица. Yongliang Shen (Университет Чжэцзян) и др. arxiv. [Paper] [Код]

- HuggingGpt - это система, которая использует LLM для подключения различных и мультимодальных моделей искусственного интеллекта в сообществах машинного обучения для решения задач ИИ.

- [2023/03] Visual Chatgpt: разговор, рисование и редактирование с моделями Visual Foundation. Chenfei Wu (Microsoft Research Asia) et al. arxiv. [Paper] [Код]

- Visual Chatgpt - это система, которая открывает дверь для изучения визуальных ролей CHATGPT с помощью моделей Visual Foundation.

- [2023/02] Модели дополненного языка: опрос. Gregoire Mialon (Meta Ai) и соавт. Tmlr. [бумага]

- Этот обзор обзоров работает, в которых LMS дополняется способностью использовать инструменты. Дополненные LMS могут использовать внешние модули для расширения своей способности обработки контекста.

- [2023/02] Toolformer: Языковые модели могут научить себя использовать инструменты. Тимо Шик (Meta Ai) и соавт. arxiv. [бумага]

- Toolformer показывает, что LLMS может научить себя использовать внешние инструменты с несколькими демонстрациями для каждого API.

- [2022/05] Talm: инструмент с наполненными языковыми моделями. Aaron Parisi (Google) и соавт. arxiv. [бумага]

- TALM представляет метод, который объединяет не дифференцируемые инструменты с LMS, что позволяет модели доступа к реальному или частному данным.

- [2022/05] Системы MRKL: модульная нейро-символическая архитектура, которая сочетает в себе крупные языковые модели, внешние источники знаний и дискретные рассуждения. Ehud Karpas (AI21 Labs) et al. arxiv. [бумага]

- Systems MRKL увеличивает LLMS легко расширяемым набором внешних знаний и модулей рассуждений.

- [2022/04] Делайте так, как я могу, не как я говорю: основание языка роботизированных возможностей. Майкл Ан (Google) и соавт. Корл. [бумага]

- Saycan применяет LMS в реальных роботизированных задачах, объединяя усовершенствованные семантические знания от LLMS с ценной функцией предварительно обученных навыков.

- [2021/12] Webgpt: браузер с помощью вопросов-ответа с человеческой обратной связью. Reiichiro Nakano (Openai) et al. arxiv. [бумага]

- WebGPT отвечает на вопросы с использованием среды веб -мошенничества. Он использует имитационное обучение во время обучения, а затем оптимизирует качество ответов посредством обратной связи человека.

- [2021/07] Оценка крупных языковых моделей, обученных коду. Mark Chen (Openai) и соавт. arxiv. [Paper] [Код]

- Кодекс может синтезировать программы от DocStrings, то есть создание инструментов на основе документации.

1.3.2 воплощенное действие

- [2023/12] для изучения универсальной модели для воплощенной навигации. Дуэт Чжэн (Китайский университет Гонконга) и др. arxiv. [Paper] [Код]

- [2023/11] воплощенный генеральный агент в 3D мира. Jiangoong Huang (Bigai & Peking University) et al. arxiv. [Paper] [Project Page]

- [2023/11] Джарвис-1: мультизадачные агенты с открытым миром с моделями с мультимодальным языком с автокьюменом. Zihao Wang (Peking University) et al. arxiv. [Paper] [Код]

- [2023/10] Лемур: гармонизирующий естественный язык и код для языковых агентов Yiheng Xu (Университет Гонконга) и др. arxiv. [Paper] [Код]

- [2023/10] Towards End-to-End Embodied Decision Making via Multi-modal Large Language Model: Explorations with GPT4-Vision and Beyond Liang Chen et al. arXiv. [paper] [code]

- [2023/07] Interactive language: Talking to robots in real time. Corey Lynch et al. IEEE (RAL) [paper]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [бумага]

- [2023/05] EmbodiedGPT: Vision-Language Pre-Training via Embodied Chain of Thought. Yao Mu et al. Arxiv [paper] [code]

- [2023/05] NavGPT: Explicit Reasoning in Vision-and-Language Navigation with Large Language Models. Gengze Zhou et al. Arxiv [paper]

- [2023/05] AlphaBlock: Embodied Finetuning for Vision-Language Reasoning in Robot Manipulation. Chuhao Jin et al. Arxiv [paper]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess et al. Arxiv. [бумага]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn et al. Arxiv [paper] [code]

- [2023/02] Collaborating with language models for embodied reasoning. Ishita Dasgupta et al. Arxiv. [бумага]

- [2023/02] Code as Policies: Language Model Programs for Embodied Control. Jacky Liang et al. IEEE (ICRA). [бумага]

- [2022/10] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao et al. Arxiv [paper] [code]

- [2022/10] Instruction-Following Agents with Multimodal Transformer. Hao Liu et al. CVPR [paper] [code]

- [2022/07] Inner Monologue: Embodied Reasoning through Planning with Language Models. Wenlong Huang et al. Arxiv. [бумага]

- [2022/07] LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action. Dhruv Shahet al. CoRL [paper] [code]

- [2022/04] Do As I Can, Not As I Say: Grounding Language in Robotic Affordances. Michael Ahn et al. Arxiv. [бумага]

- [2022/01] A Survey of Embodied AI: From Simulators to Research Tasks. Jiafei Duan et al. IEEE (TETCI). [бумага]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [paper] [code]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [бумага]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [бумага]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arXiv. [paper] [code]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arXiv. [бумага]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [paper] [code]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arXiv. [paper] [code]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [бумага]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [paper] [code]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [paper] [code]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [бумага]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [бумага]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [бумага]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [бумага]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [бумага]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [paper] [code]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [paper] [code]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [бумага]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [бумага]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [бумага]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [бумага]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [бумага]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [paper] [code]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [paper] [code]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [paper] [code]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [paper] [code]

2.2 Coordinating Potential of Multiple Agents

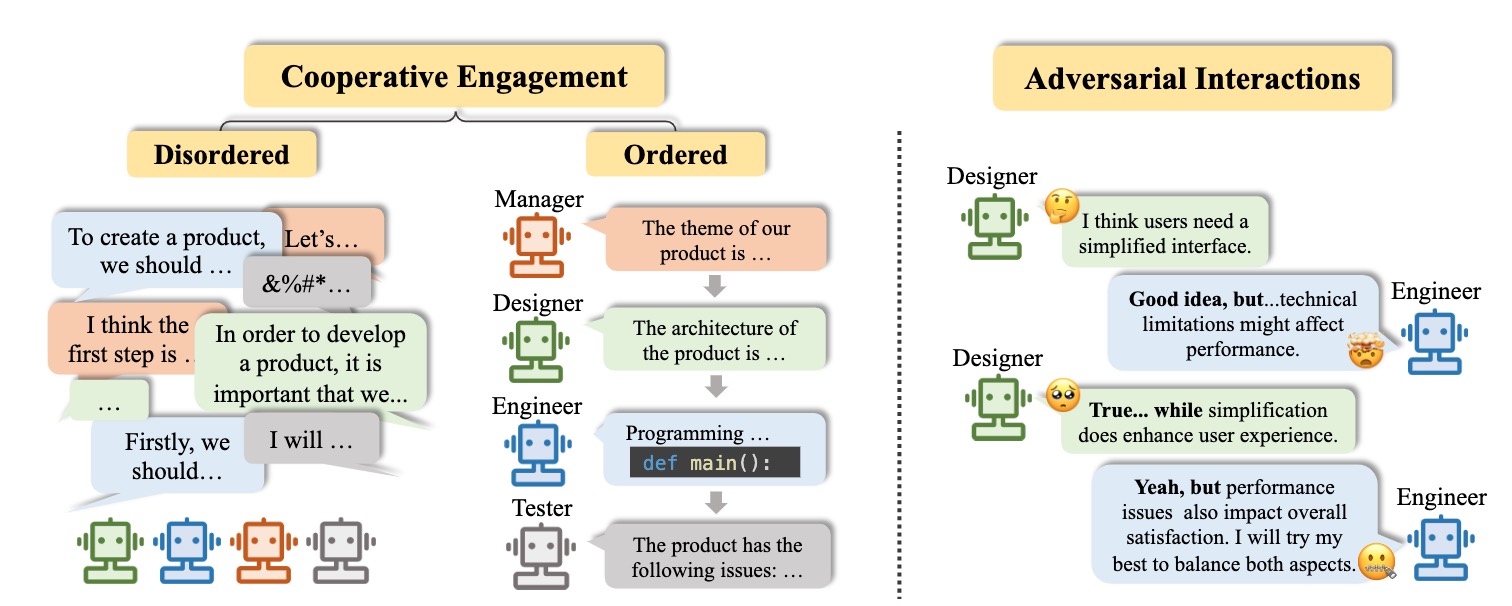

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [paper] [code]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [paper] [code]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [бумага]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [бумага]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [paper] [code]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [paper] [code]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [бумага]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [paper] [code]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [paper] [code]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [paper] [code]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [бумага]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [paper] [code]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [бумага]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [paper] [code]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [paper] [code]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [бумага]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [paper] [code]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [paper] [code]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [бумага]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [paper] [code]

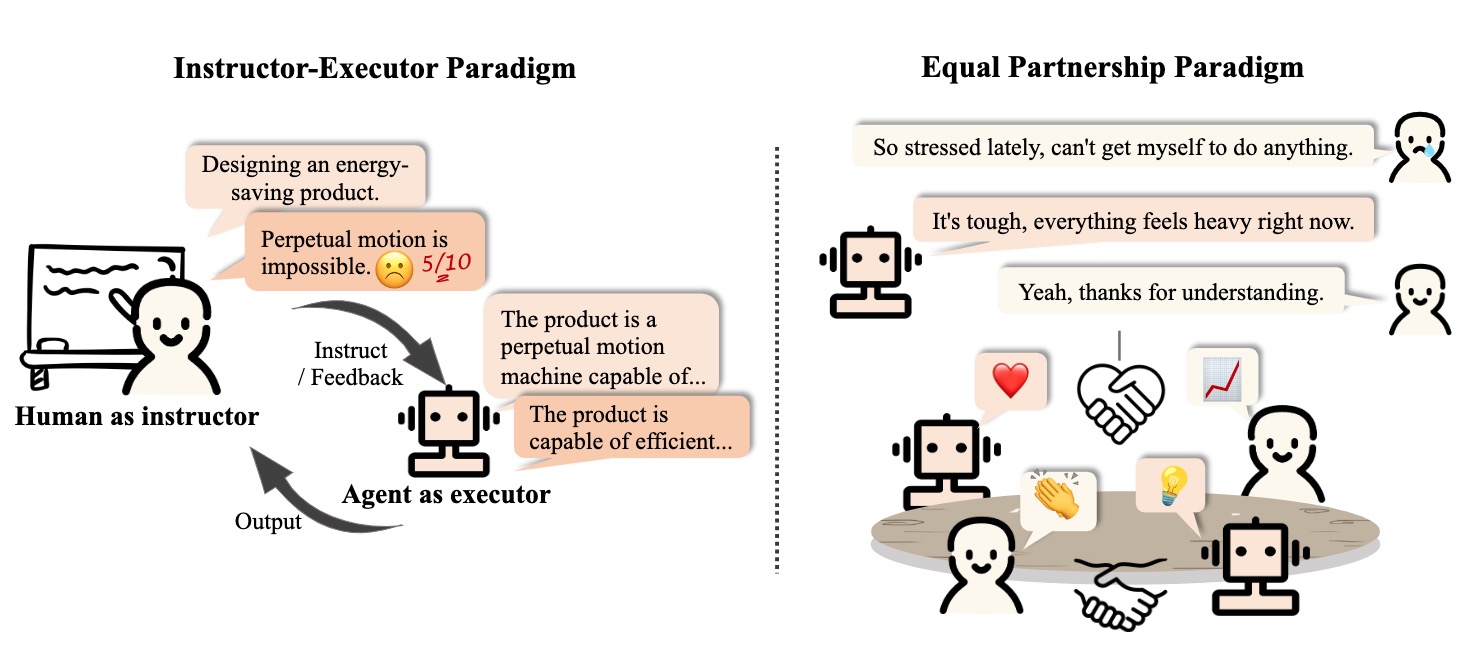

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

Образование

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [бумага]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [бумага]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

Здоровье

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [paper] [code]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [бумага]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [бумага]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [бумага]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [бумага]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [бумага]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [бумага]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [бумага]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [бумага]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [paper] [code]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [бумага]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [бумага]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [бумага]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [бумага]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [бумага]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al. Наука. [бумага]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [бумага]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [paper] [code]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [paper] [code]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [бумага]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [paper] [code]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [paper] [code]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [бумага]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [бумага]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [paper] [code]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [paper] [code]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [paper] [code]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [paper] [code]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [paper] [code]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [paper] [code]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [бумага]

3.1.2 Personality

Cognition

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [бумага]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [бумага]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [бумага]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [бумага]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [бумага]

Emotion

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [бумага]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [бумага]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [бумага]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [бумага]

Характер

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [paper] [code]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [paper] [code]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [paper] [code]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [paper] [code]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [бумага]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [бумага]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [paper] [code]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [paper] [code]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [бумага]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [paper] [code]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [paper] [code]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [paper] [code]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [paper] [code]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [paper] [code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [бумага]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [paper] [code]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [paper] [code]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [бумага]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [paper] [code]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [бумага]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [paper] [code]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [бумага]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [paper] [code]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [paper] [code]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [paper] [code]

Цитирование

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

Контакт

Звездная история