การเพิ่มขึ้นและศักยภาพของเอเจนต์แบบจำลองภาษาขนาดใหญ่: การสำรวจ

เอกสารที่ต้องอ่านสำหรับตัวแทนที่ใช้ LLM

- เร็ว ๆ นี้: เพิ่มอินโทรหนึ่งประโยคลงในกระดาษแต่ละฉบับ

- ข่าว

- ☄ [2024/06/07] AgentGym ได้รับการปล่อยตัวสำหรับการพัฒนาและพัฒนาตัวแทนที่ใช้ LLM ในสภาพแวดล้อมที่หลากหลาย!

- กระดาษ: AgentGym

- หน้าโครงการ: https://agentgym.github.io/

- รหัส: แพลตฟอร์มและการใช้งาน

- HuggingFace Resources: Agenttraj-L, Agenteval, Agentevol-7b

- - [2024/05/02] R3 (การฝึกอบรมแบบจำลองภาษาขนาดใหญ่เพื่อการให้เหตุผลผ่านการเรียนรู้การเสริมแรงหลักสูตรย้อนกลับ) ได้รับการยอมรับจาก ICML 2024!

- - [2024/02/08] กระดาษใหม่ R3 บน RL สำหรับการให้เหตุผลตัวแทน LLM ได้รับการปล่อยตัว! กระดาษ: การฝึกอบรมแบบจำลองภาษาขนาดใหญ่เพื่อการให้เหตุผลผ่านการเรียนรู้การเสริมแรงหลักสูตรย้อนกลับ รหัส: LLM-REVERSE-CURRICULUM-RL

- - [2023/09/20] โครงการนี้ได้รับการจดทะเบียนในเทรนด์ GitHub! เป็นเกียรติอย่างยิ่ง!

- - [2023/09/15] การสำรวจของเราได้รับการปล่อยตัว! ดูการเพิ่มขึ้นและศักยภาพของเอเจนต์แบบจำลองภาษาขนาดใหญ่: การสำรวจกระดาษ!

- [2023/09/14] เราสร้างที่เก็บนี้เพื่อรักษารายการกระดาษในตัวแทนที่ใช้ LLM เอกสารเพิ่มเติมกำลังจะมาเร็ว ๆ นี้!

- การแนะนำ

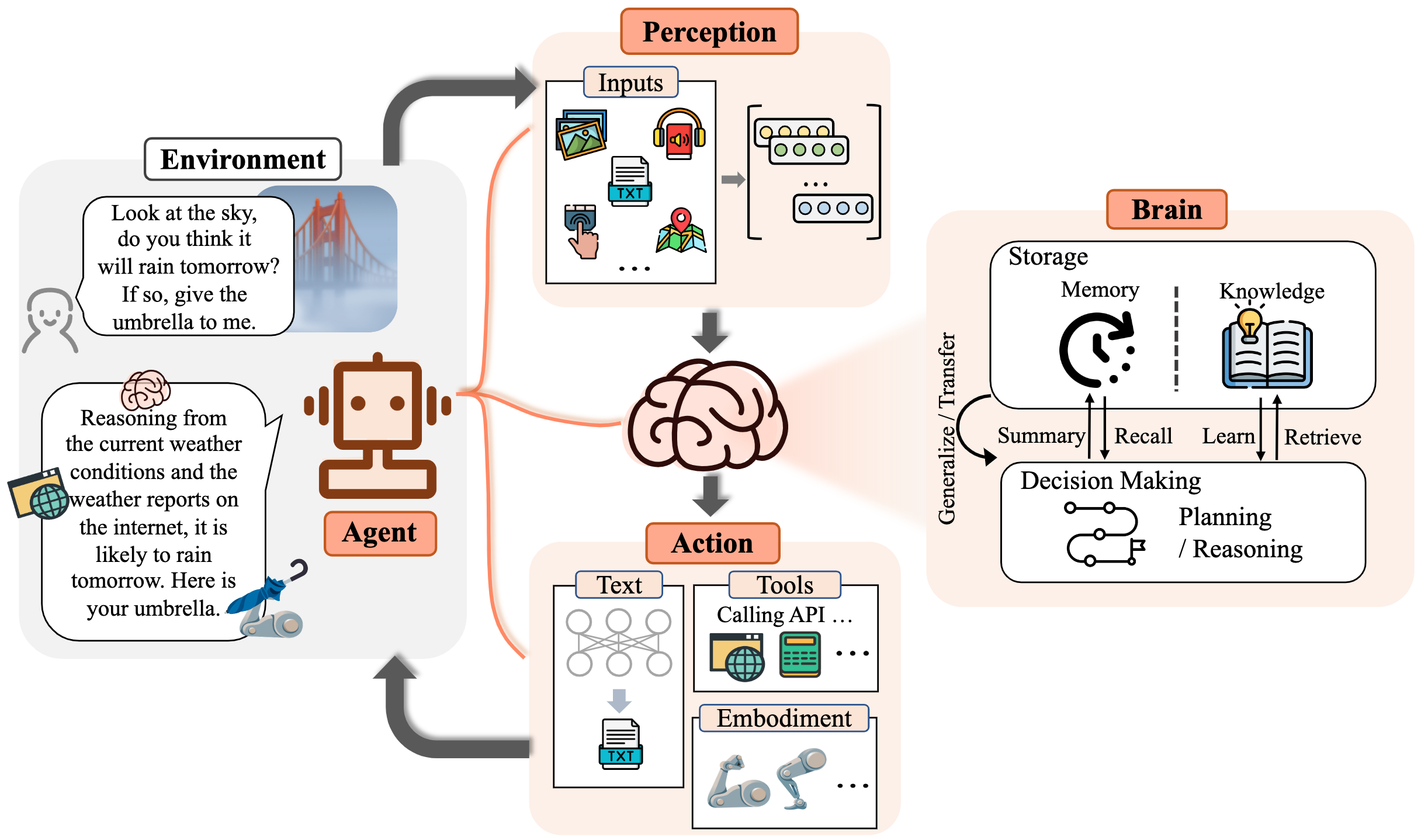

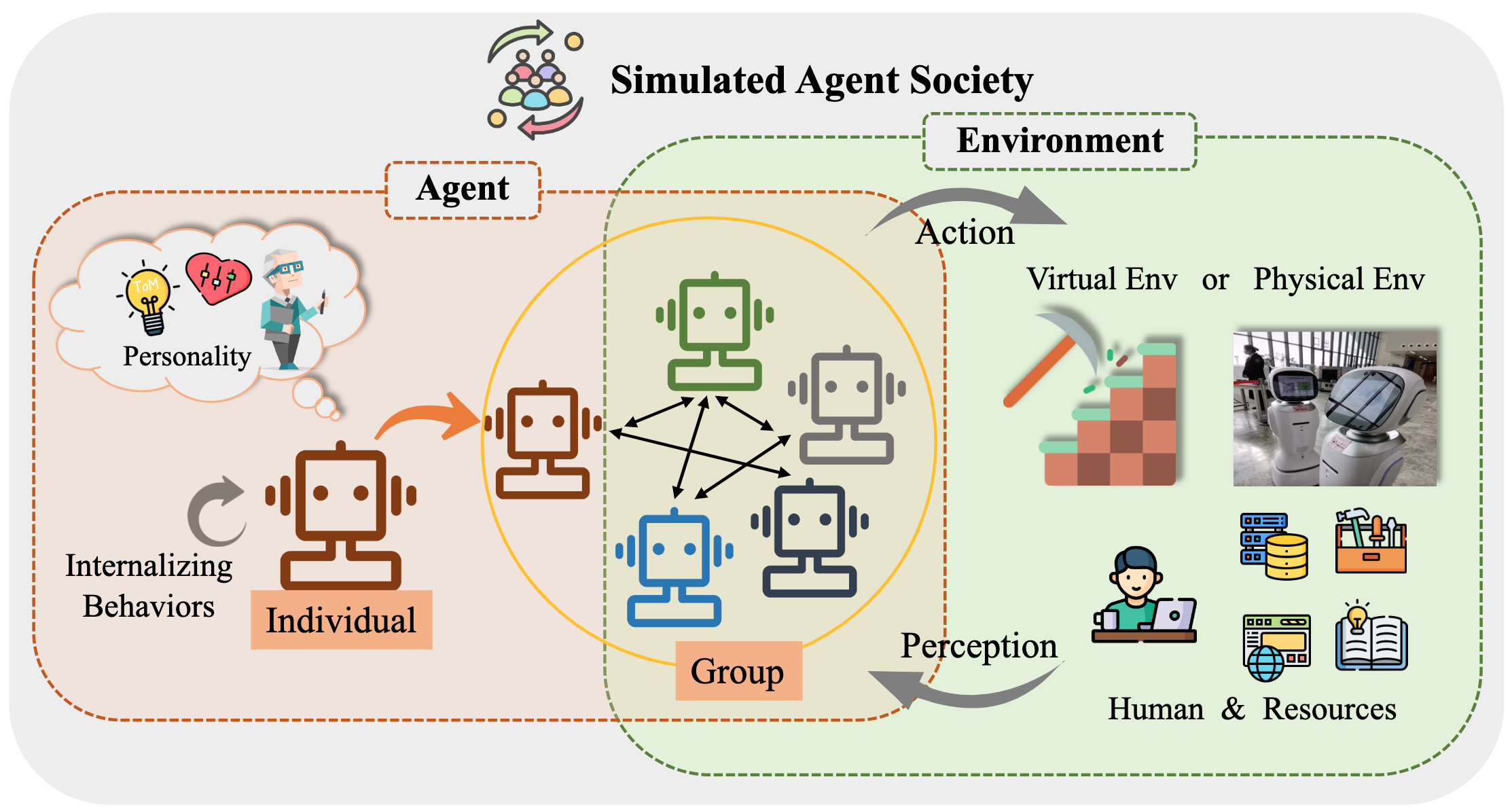

เป็นเวลานานมนุษยชาติได้ติดตามปัญญาประดิษฐ์ (AI) เทียบเท่าหรือเกินระดับมนุษย์โดยมีตัวแทน AI ถือเป็นยานพาหนะที่มีแนวโน้มของการแสวงหานี้ ตัวแทน AI เป็นหน่วยงานเทียมที่รับรู้สภาพแวดล้อมของพวกเขาตัดสินใจและดำเนินการ

เนื่องจากความสามารถที่หลากหลายและน่าทึ่งที่พวกเขาแสดงให้เห็นถึงรูปแบบภาษาขนาดใหญ่ (LLMS) ถือเป็นประกายไฟที่มีศักยภาพสำหรับหน่วยสืบราชการลับทั่วไป (AGI) ที่ให้ความหวังในการสร้างตัวแทน AI ทั่วไป ความพยายามในการวิจัยหลายอย่างได้ใช้ประโยชน์จาก LLMS เป็นรากฐานในการสร้างตัวแทน AI และประสบความสำเร็จอย่างมาก

ในพื้นที่เก็บข้อมูลนี้เราให้การสำรวจอย่างเป็นระบบและครอบคลุมเกี่ยวกับตัวแทนที่ใช้ LLM และแสดงรายการเอกสารที่ต้องอ่าน

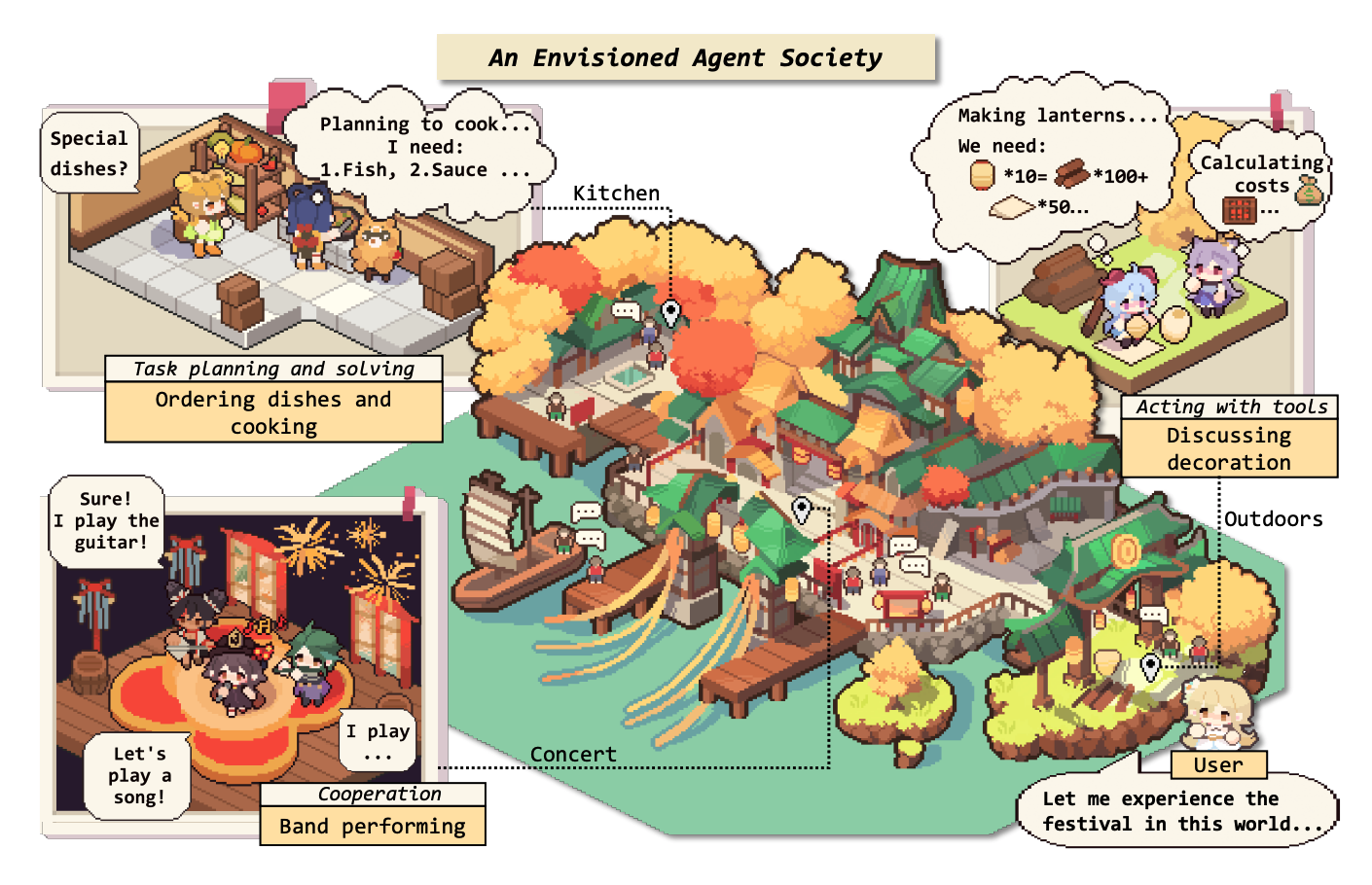

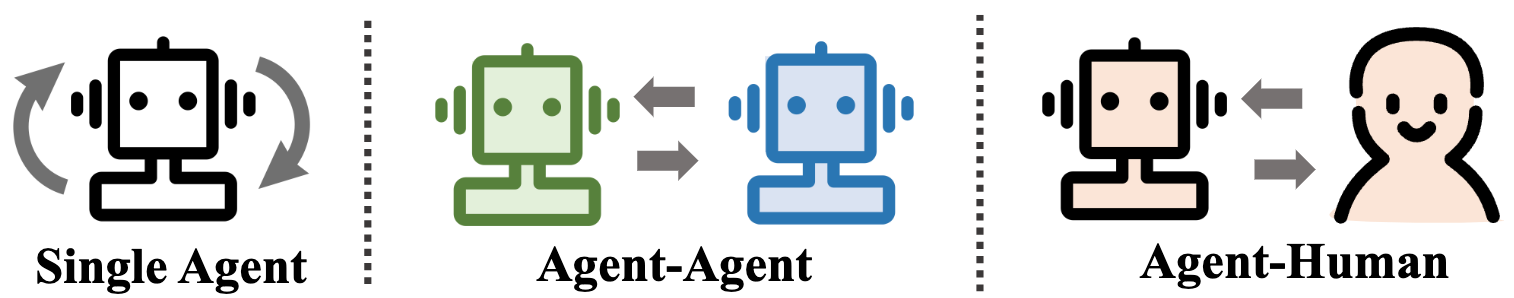

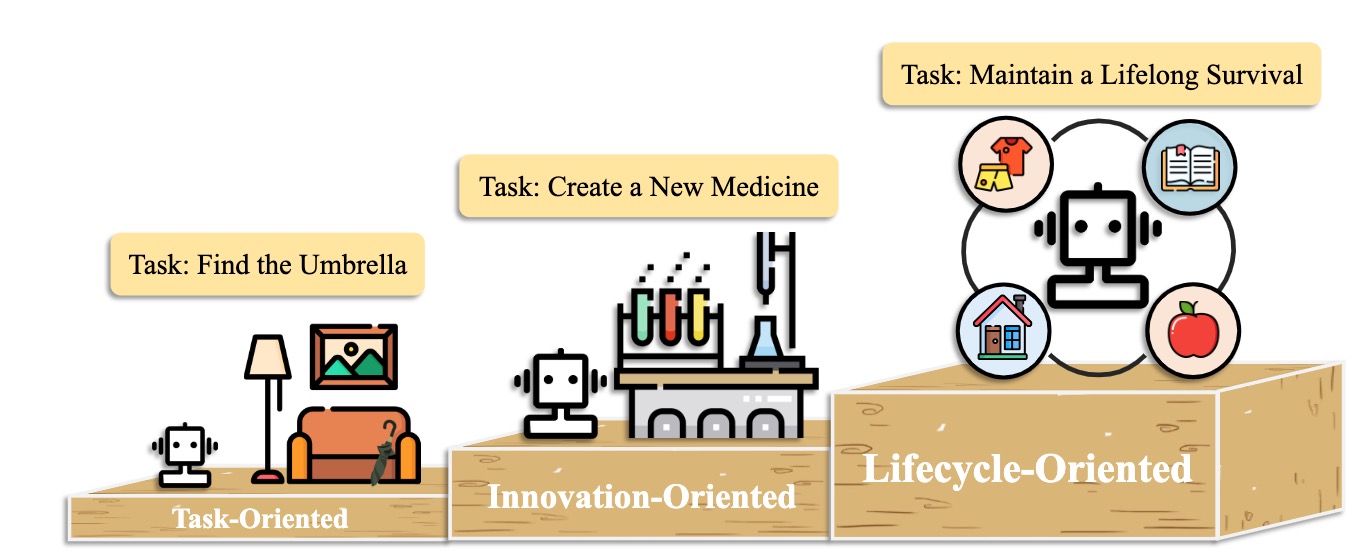

โดยเฉพาะเราเริ่มต้นด้วยกรอบแนวคิดทั่วไปสำหรับตัวแทนที่ใช้ LLM: ประกอบด้วยสามองค์ประกอบหลัก: สมองการรับรู้และการกระทำและเฟรมเวิร์กสามารถปรับให้เหมาะกับการใช้งานที่แตกต่างกัน ต่อจากนั้นเราสำรวจแอปพลิเคชันที่กว้างขวางของตัวแทนที่ใช้ LLM ในสามด้าน: สถานการณ์ตัวแทนเดี่ยวสถานการณ์หลายตัวแทนและความร่วมมือจากมนุษย์-ตัวแทน หลังจากนี้เราเจาะลึกเข้าไปในสังคมตัวแทนสำรวจพฤติกรรมและบุคลิกภาพของตัวแทนที่ใช้ LLM ปรากฏการณ์ทางสังคมที่เกิดขึ้นเมื่อพวกเขาก่อตั้งสังคมและข้อมูลเชิงลึกที่พวกเขาเสนอให้กับสังคมมนุษย์ ในที่สุดเราจะหารือเกี่ยวกับหัวข้อสำคัญและปัญหาที่เปิดอยู่ภายในสนาม

เราขอขอบคุณการมีส่วนร่วมใด ๆ ผ่าน PRS ปัญหาอีเมลหรือวิธีการอื่น ๆ

เนื้อหาของเนื้อหา (TOC)

- การเพิ่มขึ้นและศักยภาพของเอเจนต์แบบจำลองภาษาขนาดใหญ่: การสำรวจ

- - ข่าว

- - การแนะนำ

- เนื้อหาของเนื้อหา (TOC)

- 1. การเกิดของตัวแทน: การก่อสร้างตัวแทนที่ใช้ LLM

- 1.1 สมอง: ส่วนใหญ่ประกอบด้วย LLM

- 1.1.1 ปฏิสัมพันธ์ภาษาธรรมชาติ

- รุ่นที่มีคุณภาพสูง

- ความเข้าใจอย่างลึกซึ้ง

- 1.1.2 ความรู้

- รูปแบบ pretrain

- ความรู้ทางภาษา

- ความรู้ทั่วไป

- ความรู้ที่สามารถดำเนินการได้

- ปัญหาที่อาจเกิดขึ้นจากความรู้

- 1.1.3 หน่วยความจำ

- ความสามารถด้านหน่วยความจำ

- การเพิ่มขีดจำกัดความยาวของหม้อแปลง

- สรุปหน่วยความจำ

- บีบอัดความทรงจำด้วยเวกเตอร์หรือโครงสร้างข้อมูล

- การดึงหน่วยความจำ

- 1.1.4 การใช้เหตุผลและการวางแผน

- การให้เหตุผล

- การวางแผน

- การกำหนดแผน

- วางแผนการไตร่ตรอง

- 1.1.5 ความสามารถในการถ่ายโอนและการวางนัยทั่วไป

- ภาพรวมของงานที่มองไม่เห็น

- การเรียนรู้ในบริบท

- การเรียนรู้อย่างต่อเนื่อง

- 1.2 การรับรู้: อินพุตหลายรูปแบบสำหรับตัวแทนที่ใช้ LLM

- 1.3 การกระทำ: ขยายพื้นที่การกระทำของตัวแทนที่ใช้ LLM

- 1.3.1 เครื่องมือใช้

- 1.3.2 การกระทำที่เป็นตัวเป็นตน

- 2. ตัวแทนในทางปฏิบัติ: การประยุกต์ใช้ตัวแทนที่ใช้ LLM

- 2.1 ความสามารถทั่วไปของตัวแทนเดี่ยว

- 2.1.1 การปรับใช้ที่มุ่งเน้นงาน

- 2.1.2 การปรับใช้เชิงนวัตกรรม

- 2.1.3 การปรับใช้ที่เน้นวงจรชีวิต

- 2.2 การประสานงานศักยภาพของตัวแทนหลายตัว

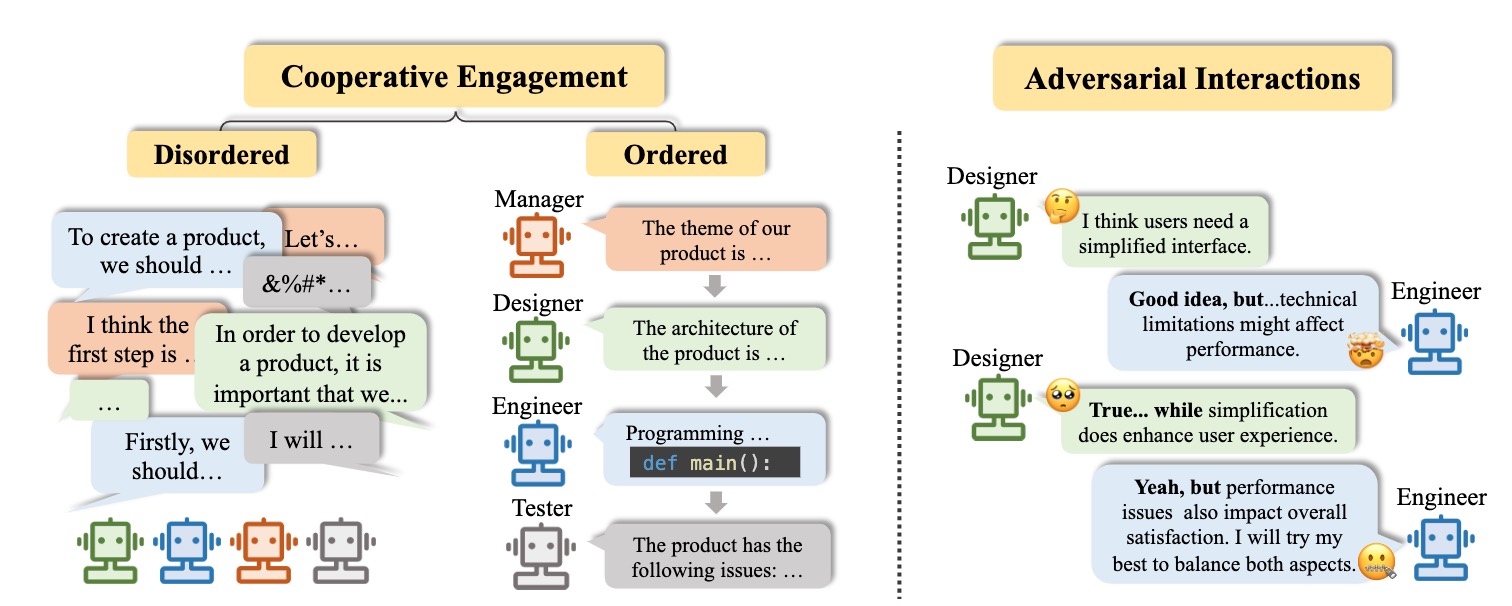

- 2.2.1 การมีปฏิสัมพันธ์แบบร่วมมือเพื่อการเสริมความสมบูรณ์

- 2.2.2 ปฏิสัมพันธ์ของฝ่ายตรงข้ามเพื่อความก้าวหน้า

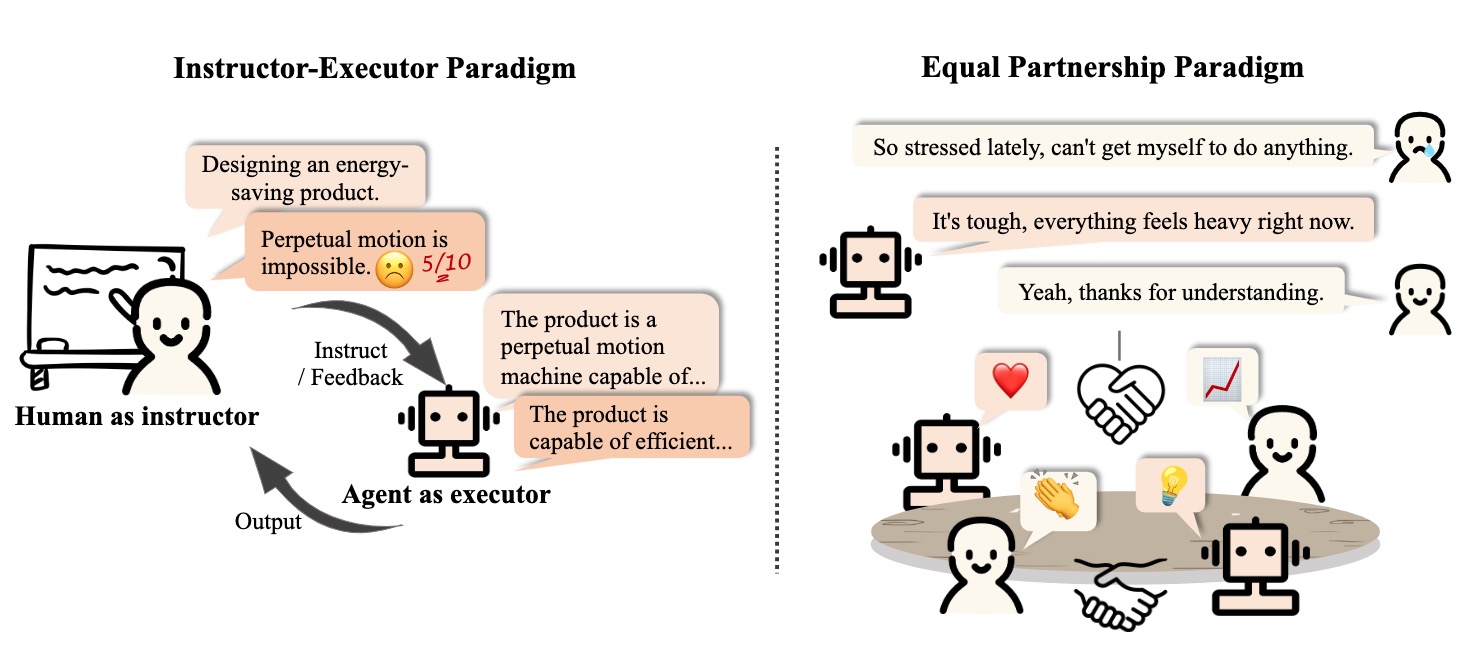

- 2.3 การมีส่วนร่วมแบบโต้ตอบระหว่างมนุษย์และตัวแทน

- 2.3.1 กระบวนทัศน์ผู้สอน-ผู้สอน

- การศึกษา

- สุขภาพ

- แอปพลิเคชันอื่น ๆ

- 2.3.2 กระบวนทัศน์การเป็นหุ้นส่วนที่เท่าเทียมกัน

- ผู้สื่อสารที่เอาใจใส่

- ผู้เข้าร่วมระดับมนุษย์

- 3. Agent Society: จากความเป็นปัจเจกชนไปจนถึงสังคม

- 3.1 พฤติกรรมและบุคลิกภาพของตัวแทนที่ใช้ LLM

- 3.1.1 พฤติกรรมทางสังคม

- พฤติกรรมส่วนบุคคล

- พฤติกรรมของกลุ่ม

- 3.1.2 บุคลิกภาพ

- ความรู้ความเข้าใจ

- อารมณ์

- อักขระ

- 3.2 สภาพแวดล้อมสำหรับสมาคมตัวแทน

- 3.2.1 สภาพแวดล้อมที่ใช้ข้อความ

- 3.2.2 สภาพแวดล้อม Sandbox เสมือนจริง

- 3.2.3 สภาพแวดล้อมทางกายภาพ

- 3.3 การจำลองสังคมกับตัวแทนที่ใช้ LLM

- 4. หัวข้ออื่น ๆ

- 4.1 มาตรฐานสำหรับตัวแทนที่ใช้ LLM

- 4.2 การฝึกอบรมและการเพิ่มประสิทธิภาพตัวแทนที่ใช้ LLM

- การอ้างอิง

- ผู้ดูแลโครงการและผู้สนับสนุน

- ติดต่อ

- ประวัติดาว

1. การเกิดของตัวแทน: การก่อสร้างตัวแทนที่ใช้ LLM

1.1 สมอง: ส่วนใหญ่ประกอบด้วย LLM

1.1.1 ปฏิสัมพันธ์ภาษาธรรมชาติ

รุ่นที่มีคุณภาพสูง

- [2023/10] ไปสู่การตัดสินใจที่เป็นตัวเป็นตนแบบ end-to-end ผ่านแบบจำลองภาษาขนาดใหญ่หลายรูปแบบ: การสำรวจด้วย GPT4-Vision และ Beyond Liang Chen et al arxiv. [กระดาษ] [รหัส]

- งานนี้เสนอ PCA-Eval ซึ่งเป็นการเปรียบเทียบการตัดสินใจที่เป็นตัวเป็นตนด้วยวิธีการแบบครบวงจรที่ใช้ MLLM และวิธีการใช้เครื่องมือที่ใช้ LLM จากการรับรู้การรับรู้และระดับการกระทำ

- [2023/08] การประเมินผลหลายภาษาหลายภาษาการประเมินผลหลายรูปแบบของ CHATGPT เกี่ยวกับการใช้เหตุผลภาพหลอนและการโต้ตอบ Yejin Bang และคณะ arxiv. [กระดาษ]

- งานนี้ประเมินผลหลายภาษาหลายภาษาและหลายรูปแบบของ ChatGPT โดยใช้ชุดข้อมูล 21 ชุดครอบคลุมงานแอปพลิเคชัน NLP ทั่วไป 8 รายการที่แตกต่างกัน

- [2023/06] LLM-EVAL: การประเมินอัตโนมัติแบบหลายมิติแบบครบวงจรสำหรับการสนทนาแบบเปิดโดเมนด้วยแบบจำลองภาษาขนาดใหญ่ Yen-Ting Lin และคณะ arxiv. [กระดาษ]

- วิธี LLM-Eval ประเมินหลายมิติของการประเมินเช่นเนื้อหาไวยากรณ์ความเกี่ยวข้องและความเหมาะสม

- [2023/04] Chatgpt เป็นระบบแก้ไขข้อผิดพลาดทางไวยากรณ์ที่คล่องแคล่วสูงหรือไม่? การประเมินที่ครอบคลุม Tao Fang และคณะ arxiv. [กระดาษ]

- ผลลัพธ์ของการประเมินแสดงให้เห็นว่า chatgpt มีความสามารถในการตรวจจับข้อผิดพลาดที่ยอดเยี่ยมและสามารถแก้ไขข้อผิดพลาดได้อย่างอิสระเพื่อให้ประโยคที่ถูกต้องได้รับการแก้ไขอย่างคล่องแคล่ว นอกจากนี้ประสิทธิภาพในการตั้งค่าที่ไม่ใช่ภาษาอังกฤษและทรัพยากรต่ำเน้นถึงศักยภาพในงาน GEC หลายภาษา

ความเข้าใจอย่างลึกซึ้ง

- [2023/06] ฮันส์ที่ฉลาดหรือทฤษฎีประสาท? การทดสอบความเครียดการให้เหตุผลทางสังคมในรูปแบบภาษาขนาดใหญ่ Natalie Shapira และคณะ arxiv. [กระดาษ]

- LLM แสดงทฤษฎีความสามารถบางอย่างของจิตใจ แต่พฤติกรรมนี้ยังห่างไกลจากความแข็งแกร่ง

- [2022/08] อนุมานรางวัลจากภาษาในบริบท Jessy Lin et al. ACL [กระดาษ]

- งานนี้นำเสนอแบบจำลองที่ทำให้รางวัลจากภาษาและทำนายการกระทำที่ดีที่สุดในสภาพแวดล้อมที่มองไม่เห็น

- [2021/10] ทฤษฎีการสื่อสารด้วยความช่วยเหลือจากจิตใจในความร่วมมือหุ่นยนต์ของมนุษย์ที่ซับซ้อน Moritz C. Buehler และคณะ arxiv. [กระดาษ]

- งานนี้ออกแบบซูชิตัวแทนด้วยความเข้าใจของมนุษย์ในระหว่างการมีปฏิสัมพันธ์

1.1.2 ความรู้

รูปแบบ pretrain

- [2023/04] การเรียนรู้การเป็นตัวแทนของประโยคจากข้อมูลที่ไม่มีป้ายกำกับ เฟลิกซ์ฮิลล์ (มหาวิทยาลัยเคมบริดจ์) และคณะ arxiv. [กระดาษ]

- [2020/02] คุณสามารถเก็บความรู้ไว้ในพารามิเตอร์ของแบบจำลองภาษาได้มากแค่ไหน? Adam Roberts (Google) และคณะ arxiv. [กระดาษ]

- [2020/01] การปรับขนาดกฎหมายสำหรับแบบจำลองภาษาประสาท Jared Kaplan (มหาวิทยาลัย Johns Hopkins) และคณะ arxiv. [กระดาษ]

- [2017/12] ความรู้ทั่วไปเกี่ยวกับข่าวกรองของเครื่องจักร Niket Tandon (Allen Institute เพื่อปัญญาประดิษฐ์) และคณะ Sigmod [กระดาษ]

- [2011/03] การประมวลผลภาษาธรรมชาติ (เกือบ) ตั้งแต่เริ่มต้น Ronan Collobert (Princeton) และคณะ arxiv. [กระดาษ]

ความรู้ทางภาษา

- [2023/02] การประเมินผลหลายภาษาหลายภาษาการประเมินผลหลายรูปแบบของ CHATGPT เกี่ยวกับการใช้เหตุผลภาพหลอนและการโต้ตอบ Yejin Bang และคณะ arxiv. [กระดาษ]

- [2021/06] การตรวจสอบแบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อนสำหรับคุณลักษณะความหมายและค่าของพวกเขา Meriem Beloucif และคณะ emnlp [กระดาษ]

- [2020/10] แบบจำลองภาษาที่ผ่านการฝึกฝนสำหรับความหมายของคำศัพท์ Ivan Vulićและคณะ arxiv. [กระดาษ]

- [2019/04] โพรบโครงสร้างสำหรับการค้นหาไวยากรณ์ในการแสดงคำ John Hewitt และคณะ ACL [กระดาษ]

- [2016/04] ปรับปรุงการสกัดคำหลักอัตโนมัติให้ความรู้เชิงความหมายมากขึ้น H เหลียง ระบบสำหรับแอปพลิเคชันขั้นสูง [กระดาษ]

ความรู้ทั่วไป

- [2022/10] รูปแบบภาษาของรหัสเป็นผู้เรียนไม่กี่คน Aman Madaan et al.Arxiv [กระดาษ]

- [2021/04] การเป็นตัวแทนความรู้โลกเชิงสัมพันธ์ในรูปแบบภาษาบริบท: การทบทวน Tara Safavi และคณะ arxiv. [กระดาษ]

- [2019/11] เราจะรู้ได้อย่างไรว่ารูปแบบภาษารู้อะไรบ้าง? Zhengbao Jiang et al.arxiv [กระดาษ]

ความรู้ที่สามารถดำเนินการได้

- [2023/07] รูปแบบภาษาขนาดใหญ่ในการแพทย์ Arun James Thirunavukarasu และคณะ ธรรมชาติ. [กระดาษ]

- [2023/06] DS-1000: เกณฑ์มาตรฐานตามธรรมชาติและเชื่อถือได้สำหรับการสร้างรหัสวิทยาศาสตร์ข้อมูล Yuhang Lai และคณะ ICML [กระดาษ]

- [2022/10] รูปแบบภาษาของรหัสเป็นผู้เรียนไม่กี่คน Aman Madaan และคณะ arxiv. [กระดาษ]

- [2022/02] การประเมินอย่างเป็นระบบของรูปแบบภาษาขนาดใหญ่ของรหัส Frank F. Xu et al.Arxiv [กระดาษ]

- [2021/10] ผู้ตรวจสอบการฝึกอบรมเพื่อแก้ปัญหาคำคณิตศาสตร์ Karl Cobbe และคณะ arxiv. [กระดาษ]

ปัญหาที่อาจเกิดขึ้นจากความรู้

- [2023/10] Freshllms: รีเฟรชรุ่นภาษาขนาดใหญ่พร้อมการเสริมเครื่องมือค้นหา Tu Vu (Google) และคณะ arxiv [กระดาษ] [รหัส]

- [2023/05] การแก้ไขแบบจำลองภาษาขนาดใหญ่: ปัญหาวิธีการและโอกาส Yunzhi Yao และคณะ arxiv. [กระดาษ]

- [2023/05] ตรวจสอบตัวเอง: โมดูลแบบปลั๊กแอนด์เพลย์สำหรับการตรวจสอบข้อเท็จจริงด้วยรูปแบบภาษาขนาดใหญ่ Miaoran Li et al. arxiv. [กระดาษ]

- [2023/05] นักวิจารณ์: โมเดลภาษาขนาดใหญ่สามารถแก้ไขตนเองได้ด้วยการวิพากษ์วิจารณ์เครื่องมือ Zhibin Gou และคณะ arxiv. [กระดาษ]

- [2023/04] การเรียนรู้เครื่องมือกับแบบจำลองพื้นฐาน Yujia Qin และคณะ arxiv. [กระดาษ]

- [2023/03] SelfCheckGPT: การตรวจจับภาพหลอนกล่องดำแบบซอร์ส-ทรัพยากรเป็นศูนย์สำหรับแบบจำลองภาษาขนาดใหญ่กำเนิด Potsawee Manakul และคณะ arxiv. [กระดาษ]

- [2022/06] การแก้ไขแบบจำลองหน่วยความจำที่สเกล Eric Mitchell และคณะ arxiv. [กระดาษ]

- [2022/04] การทบทวนแบบจำลองภาษาเป็นฐานความรู้ Badr Alkhamissi et al.arxiv [กระดาษ]

- [2021/04] การแก้ไขความรู้จริงในรูปแบบภาษา Nicola de Cao et al.Arxiv [กระดาษ]

- [2017/08] การวัดความหายนะที่ลืมในเครือข่ายประสาท Ronald Kemker et al.Arxiv [กระดาษ]

1.1.3 หน่วยความจำ

ความสามารถด้านหน่วยความจำ

การเพิ่มขีดจำกัดความยาวของหม้อแปลง

- [2023/10] MEMGPT: สู่ LLMS เป็นระบบปฏิบัติการ Charles Packer (UC Berkeley) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัส] [ชุดข้อมูล]

- [2023/05] การเข้ารหัสตำแหน่งแบบสุ่มช่วยเพิ่มความยาวทั่วไปของหม้อแปลง Anian Ruoss (DeepMind) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023-03] Colt5: หม้อแปลงระยะยาวที่เร็วขึ้นพร้อมการคำนวณแบบมีเงื่อนไข Joshua Ainslie (Google Research) และคณะ arxiv. [กระดาษ]

- [2022/03] การจำแนกประเภทที่มีประสิทธิภาพของเอกสารยาวโดยใช้หม้อแปลง Hyunji Hayley Park (มหาวิทยาลัยอิลลินอยส์) และคณะ arxiv. [กระดาษ] [รหัส]

- [2021/12] LongT5: Transformer ข้อความถึงข้อความที่มีประสิทธิภาพสำหรับลำดับยาว Mandy Guo (Google Research) และคณะ arxiv. [กระดาษ] [รหัส]

- [2019/10] Bart: denoising sequence to-sequence pre-training สำหรับการสร้างภาษาธรรมชาติการแปลและความเข้าใจ Michael Lewis (Facebook AI) และคณะ arxiv. [กระดาษ] [รหัส]

สรุปหน่วยความจำ

- [2023/10] เดินลงเขาวงกตความทรงจำ: เกินขีด จำกัด บริบทผ่านการอ่านแบบโต้ตอบ Howard Chen (มหาวิทยาลัยพรินซ์ตัน) และคณะ arxiv. [กระดาษ]

- [2023/09] การสอนการสอนส่วนตัวโดยการผูกมัดรูปแบบภาษาขนาดใหญ่ Yulin Chen (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ]

- [2023/08] Expel: ตัวแทน LLM เป็นผู้เรียนรู้จากประสบการณ์ Andrew Zhao (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/08] Chateval: ไปสู่ผู้ประเมินที่ใช้ LLM ที่ดีขึ้นผ่านการอภิปรายหลายตัวแทน Chi-Min Chan (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] MemoryBank: การเพิ่มโมเดลภาษาขนาดใหญ่ด้วยหน่วยความจำระยะยาว Wanjun Zhong (Harbin Institute of Technology) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/04] ตัวแทนกำเนิด: simulacra แบบโต้ตอบของพฤติกรรมมนุษย์ จุนซองพาร์ค (มหาวิทยาลัยสแตนฟอร์ด) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/04] ปลดปล่อยความสามารถในการป้อนข้อมูลที่มีความยาวไม่สิ้นสุดสำหรับรุ่นภาษาขนาดใหญ่ที่มีระบบหน่วยความจำที่ควบคุมตนเอง Xinnian Liang (มหาวิทยาลัย Beihang) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/03] การสะท้อนกลับ: ตัวแทนภาษาที่มีการเรียนรู้การเสริมแรงทางวาจา Noah Shinn (Northeastern University) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] RecurrentGPT: การสร้างแบบโต้ตอบของข้อความยาว (โดยพลการ) Wangchunshu Zhou (Aiwaves) และคณะ arxiv. [กระดาษ] [รหัส]

บีบอัดความทรงจำด้วยเวกเตอร์หรือโครงสร้างข้อมูล

- [2023/07] ตัวแทนการสื่อสารสำหรับการพัฒนาซอฟต์แวร์ Chen Qian (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/06] chatdb: เพิ่ม LLMs ด้วยฐานข้อมูลเป็นหน่วยความจำสัญลักษณ์ Chenxu Hu (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] ผีใน Minecraft: ตัวแทนที่มีความสามารถโดยทั่วไปสำหรับสภาพแวดล้อมแบบเปิดโลกผ่านแบบจำลองภาษาขนาดใหญ่ที่มีความรู้และหน่วยความจำบนข้อความ Xizhou Zhu (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] RET-LLM: ไปยังหน่วยความจำการอ่าน-เขียนทั่วไปสำหรับโมเดลภาษาขนาดใหญ่ Ali Modarressi (LMU MUNICH) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] RecurrentGPT: การสร้างแบบโต้ตอบของข้อความยาว (โดยพลการ) Wangchunshu Zhou (Aiwaves) และคณะ arxiv. [กระดาษ] [รหัส]

การดึงหน่วยความจำ

- [2023/08] Memory Sandbox: การจัดการหน่วยความจำที่โปร่งใสและโต้ตอบสำหรับตัวแทนการสนทนา Ziheng Huang (มหาวิทยาลัยแห่งแคลิฟอร์เนีย - ซานดิเอโก) และคณะ arxiv. [กระดาษ]

- [2023/08] Agentsims: กล่องทรายโอเพนซอร์ซสำหรับการประเมินแบบจำลองภาษาขนาดใหญ่ Jiaju Lin (PTA Studio) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัส]

- [2023/06] chatdb: เพิ่ม LLMs ด้วยฐานข้อมูลเป็นหน่วยความจำสัญลักษณ์ Chenxu Hu (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] MemoryBank: การเพิ่มโมเดลภาษาขนาดใหญ่ด้วยหน่วยความจำระยะยาว Wanjun Zhong (Harbin Institute of Technology) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/04] ตัวแทนกำเนิด: simulacra แบบโต้ตอบของพฤติกรรมมนุษย์ จุนซองพาร์ค (สแตนฟอร์ด) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] RecurrentGPT: การสร้างแบบโต้ตอบของข้อความยาว (โดยพลการ) Wangchunshu Zhou (Aiwaves) และคณะ arxiv. [กระดาษ] [รหัส]

1.1.4 การใช้เหตุผลและการวางแผน

การให้เหตุผล

[2024/02] การฝึกอบรมแบบจำลองภาษาขนาดใหญ่เพื่อการให้เหตุผลผ่านการเรียนรู้การเสริมแรงหลักสูตรย้อนกลับ Zhiheng XI (Fudan University) และคณะ arxiv. [กระดาษ] [รหัส]

[2023/09] การกระทบยอด: การประชุมรอบโต๊ะช่วยปรับปรุงการใช้เหตุผลผ่านฉันทามติในหมู่ LLM ที่หลากหลาย Justin Chih-Yao Chen (มหาวิทยาลัยนอร์ ธ แคโรไลน่าที่ Chapel Hill) และคณะ arxiv. [กระดาษ] [รหัส]

[2023/05] การปูพื้นเอง: เพิ่มการใช้เหตุผลในแบบจำลองภาษาขนาดใหญ่ผ่านการปรับแต่งปัญหา Zhiheng XI (Fudan University) และคณะ arxiv. [กระดาษ] [รหัส]

[2023-03] โมเดลภาษาขนาดใหญ่เป็นเหตุผลที่ไม่มีการช็อต Takeshi Kojima (มหาวิทยาลัยโตเกียว) และคณะ arxiv. [กระดาษ] [รหัส]

[2023/03] REFINE ตัวเอง: การปรับแต่งซ้ำ ๆ ด้วยการตอบสนองด้วยตนเอง Aman Madaan (Carnegie Mellon University) และคณะ arxiv. [กระดาษ] [รหัส]

[2022/05] การเลือกการเลือก: ใช้ประโยชน์จากแบบจำลองภาษาขนาดใหญ่สำหรับการใช้เหตุผลเชิงตรรกะที่ตีความได้ Antonia Creswell (DeepMind) และคณะ arxiv. [กระดาษ]

[2022/03] ความสม่ำเสมอของตนเองช่วยปรับปรุงห่วงโซ่ของการใช้เหตุผลทางความคิดในแบบจำลองภาษา Xuezhi Wang (Google Research) และคณะ arxiv. [กระดาษ] [รหัส]

[2023/02] การใช้เหตุผลแบบหลายรูปแบบในรูปแบบภาษา Zhuosheng Zhang (มหาวิทยาลัยเซี่ยงไฮ้ Jiao Tong) และคณะ arxiv. [กระดาษ] [รหัส]

[2022/01] ห่วงโซ่ของความคิดกระตุ้นให้เกิดการให้เหตุผลในรูปแบบภาษาขนาดใหญ่ Jason Wei (Google Research) และคณะ arxiv. [กระดาษ]

การวางแผน

การกำหนดแผน

- [2023/11] JARVIS-1: เอเจนต์หลายงานแบบเปิด-โลกพร้อมโมเดลภาษาหลายรูปแบบหน่วยความจำ Zihao Wang (Peking University) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/10] การค้นหาต้นไม้ตัวแทนภาษารวมการใช้เหตุผลการแสดงและการวางแผนในรูปแบบภาษา Andy Zhou (University of Illinois Urbana-Champaign) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัส]

- [2023/05] ต้นไม้แห่งความคิด: การแก้ปัญหาโดยเจตนาด้วยแบบจำลองภาษาขนาดใหญ่ Shunyu Yao (Princeton University) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] แผนกำจัดและติดตาม - แบบจำลองภาษาเป็นครูที่ดีสำหรับตัวแทนที่เป็นตัวเป็นตน Yue Wu (Carnegie Mellon University) และคณะ arxiv. [กระดาษ]

- [2023/05] การใช้เหตุผลกับรูปแบบภาษากำลังวางแผนกับโมเดลโลก Shibo Hao (UC San Diego) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] SwiftSage: ตัวแทนกำเนิดที่มีการคิดอย่างรวดเร็วและช้าสำหรับงานที่ซับซ้อน Bill Yuchen Lin (อัลเลนสถาบันปัญญาประดิษฐ์) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/04] LLM+P: เพิ่มขีดความสามารถของแบบจำลองภาษาขนาดใหญ่ด้วยความสามารถในการวางแผนที่ดีที่สุด Bo Liu (มหาวิทยาลัยเท็กซัสที่ออสติน) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/03] HuggingGpt: การแก้ปัญหา AI กับ CHATGPT และเพื่อน ๆ ในการกอด Yongliang Shen (Microsoft Research Asia) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/02] อธิบายอธิบายวางแผนและเลือก: การวางแผนแบบโต้ตอบด้วยแบบจำลองภาษาขนาดใหญ่ช่วยให้ตัวแทนหลายงานเปิดกว้าง Zihao Wang (Peking University) และคณะ arxiv. [กระดาษ] [รหัส]

- [2022/05] การแจ้งเตือนอย่างน้อยที่สุดช่วยให้การใช้เหตุผลที่ซับซ้อนในรูปแบบภาษาขนาดใหญ่ Denny Zhou (Google Research) และคณะ arxiv. [กระดาษ]

- [2022/05] ระบบ MRKL: สถาปัตยกรรมแบบแยกส่วน, neuro-symbolic ที่รวมโมเดลภาษาขนาดใหญ่แหล่งความรู้ภายนอกและการใช้เหตุผลแบบไม่ต่อเนื่อง Ehud Karpas (AI21 Labs) และคณะ arxiv. [กระดาษ]

- [2022/04] ทำเท่าที่จะทำได้ไม่ใช่อย่างที่ฉันพูด: ภาษาที่มีพื้นฐานในการจ่ายหุ่นยนต์ Michael Ahn (หุ่นยนต์ที่ Google) และคณะ arxiv. [กระดาษ]

- [2023/05] ตัวแทน: กรอบโอเพนซอร์ซสำหรับตัวแทนภาษาอิสระ Wangchunshu Zhou (Aiwaves) และคณะ arxiv. [กระดาษ] [รหัส]

- [2022/12] อย่าสร้าง, แยกแยะ: ข้อเสนอสำหรับแบบจำลองภาษาที่ต่อสายดินกับสภาพแวดล้อมในโลกแห่งความเป็นจริง Yu Gu (มหาวิทยาลัยแห่งรัฐโอไฮโอ) และคณะ ACL [กระดาษ] [รหัส]

วางแผนการไตร่ตรอง

- [2024/02] Agent-Pro: การเรียนรู้ที่จะพัฒนาผ่านการไตร่ตรองระดับนโยบายและการเพิ่มประสิทธิภาพ Wenqi Zhang (มหาวิทยาลัยเจ้อเจียง) และคณะ arxiv. [กระดาษ] [รหัส]

- [2024/01] การคอนทราสต์ตนเอง: การสะท้อนที่ดีขึ้นผ่านมุมมองการแก้ปัญหาที่ไม่สอดคล้องกัน Wenqi Zhang (มหาวิทยาลัยเจ้อเจียง) และคณะ arxiv. [กระดาษ]

- [2023/11] JARVIS-1: เอเจนต์หลายงานแบบเปิด-โลกพร้อมโมเดลภาษาหลายรูปแบบหน่วยความจำ Zihao Wang (Peking University) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/10] โซ่การตรวจสอบช่วยลดภาพหลอนในรูปแบบภาษาขนาดใหญ่ Shehzaad Dhuliawala (Meta Ai & Eth Zu ̈rich) และคณะ arxiv. [กระดาษ]

- [2023/10] FireAct: ไปสู่การปรับแต่งตัวแทนภาษา Baian Chen (System2 Research) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัส] [ชุดข้อมูล]

- [2023/08] SelfCheck: การใช้ LLMS เป็นศูนย์ตรวจสอบการใช้เหตุผลทีละขั้นตอน Ning Miao (University of Oxford) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] Chatcot: การให้เหตุผลที่เพิ่มขึ้นของโซ่ที่ใช้ความคิดเกี่ยวกับรูปแบบภาษาขนาดใหญ่ที่ใช้การแชท Zhipeng Chen (Renmin University of China) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] Voyager: ตัวแทนที่เป็นตัวเป็นตนปลายเปิดพร้อมรูปแบบภาษาขนาดใหญ่ Guanzhi Wang (Nvidia) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัส]

- [2023/03] แชทกับสภาพแวดล้อม: การรับรู้หลายรูปแบบแบบโต้ตอบโดยใช้แบบจำลองภาษาขนาดใหญ่ Xufeng Zhao (University Hamburg) และคณะ arxiv. [กระดาษ] [รหัส]

- [2022/12] LLM-Planner: การวางแผนที่มีพื้นฐานไม่กี่นัดสำหรับตัวแทนที่เป็นตัวเป็นตนด้วยรูปแบบภาษาขนาดใหญ่ Chan Hee Song (มหาวิทยาลัยแห่งรัฐโอไฮโอ) และคณะ arxiv. [กระดาษ] [รหัส]

- [2022/10] ตอบสนอง: การรวมเหตุผลและการทำหน้าที่ในรูปแบบภาษา Shunyu Yao (Princeton University) และคณะ arxiv. [กระดาษ] [รหัส]

- [2022/07] การพูดคนเดียวภายใน: การใช้เหตุผลที่เป็นตัวเป็นตนผ่านการวางแผนด้วยแบบจำลองภาษา Wenlong Huang (หุ่นยนต์ที่ Google) และคณะ arxiv. [กระดาษ] [รหัส]

- [2021/10] โซ่ AI: การมีปฏิสัมพันธ์ระหว่างมนุษย์และควบคุมความโปร่งใสและควบคุมได้โดยการผูกมัดแบบจำลองภาษาขนาดใหญ่ Tongshuang Wu (มหาวิทยาลัยวอชิงตัน) และคณะ arxiv. [กระดาษ]

1.1.5 ความสามารถในการถ่ายโอนและการวางนัยทั่วไป

ภาพรวมของงานที่มองไม่เห็น

- [2024/06] AgentGym: การพัฒนาตัวแทนแบบจำลองภาษาขนาดใหญ่ในสภาพแวดล้อมที่หลากหลาย Zhiheng XI (Fudan University) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัสและแพลตฟอร์ม] [ชุดข้อมูล] [เบนช์มาร์ก] [รุ่น]

- [2023/10] AgentTuning: การเปิดใช้งานความสามารถของตัวแทนทั่วไปสำหรับ LLMS Aohan Zeng (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัส] [ชุดข้อมูล]

- [2023/10] LeMur: การประสานภาษาธรรมชาติและรหัสสำหรับตัวแทนภาษา Yiheng Xu (มหาวิทยาลัยฮ่องกง) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/05] แบบจำลองภาษาการฝึกอบรมเพื่อทำตามคำแนะนำด้วยความคิดเห็นของมนุษย์ Long Ouyang และคณะ ประสาท [กระดาษ]

- InstructGPT: จัดแนวโมเดลภาษาให้สอดคล้องกับความตั้งใจของผู้ใช้ในงานที่หลากหลายโดยการปรับแต่งอย่างละเอียดกับคำติชมของมนุษย์

- [2023/01] การฝึกอบรมมัลติทาสก์ทำให้การฝึกอบรมเป็นแบบไม่ใช้งาน Victor Sanh และคณะ ICLR [กระดาษ] [รหัส]

- T0: T0 เป็นโมเดลตัวเข้ารหัสที่ใช้อินพุตที่เป็นข้อความและสร้างการตอบสนองเป้าหมาย ได้รับการฝึกฝนเกี่ยวกับส่วนผสมของมัลติทาสก์ของชุดข้อมูล NLP ที่แบ่งพาร์ติชันเป็นงานที่แตกต่างกัน

- [2022/10] โมเดลภาษาที่ใช้คำแนะนำในการปรับขนาด Hyung Won Chung และคณะ arxiv. [กระดาษ] [รหัส]

- งานนี้สำรวจการเรียนการสอนด้วยการมุ่งเน้นเฉพาะในการปรับขนาดของงานและขนาดของรุ่นซึ่งปรับปรุงประสิทธิภาพในคลาสโมเดลที่หลากหลายพร้อมการตั้งค่าและการประเมินผลการประเมิน

- [2022/08] โมเดลภาษา Finetuned เป็นผู้เรียนที่ไม่ได้ช็อต Jason Wei และคณะ ICLR [กระดาษ]

- Flan: การปรับแต่งการปรับแต่งช่วยเพิ่มประสิทธิภาพการยิงแบบศูนย์อย่างมากในงานที่มองไม่เห็น

การเรียนรู้ในบริบท

- [2023/08] ภาพพูดในภาพ: จิตรกรทั่วไปสำหรับการเรียนรู้ด้วยภาพในบริบท Xinlong Wang และคณะ IEEE [กระดาษ] [รหัส]

- จิตรกร: งานนี้นำเสนอแบบจำลองทั่วไปสำหรับการเรียนรู้ด้วยภาพในบริบทด้วย "ภาพ"-โซลูชันที่เป็นศูนย์กลาง

- [2023/08] โมเดลภาษาตัวแปลงสัญญาณประสาทเป็นข้อความแบบไม่มีการยิงไปยัง synthesizers คำพูด Chengyi Wang และคณะ arxiv. [กระดาษ] [รหัส]

- VALL-E: งานนี้ฝึกฝนรูปแบบภาษาตัวแปลงสัญญาณประสาทซึ่งเกิดความสามารถในการเรียนรู้ในบริบท

- [2023/07] การสำรวจสำหรับการเรียนรู้ในบริบท Qingxiu Dong และคณะ arxiv. [กระดาษ]

- การสำรวจนี้สรุปความคืบหน้าและความท้าทายของการเรียนรู้ในบริบท (ICL)

- [2023/05] รูปแบบภาษาเป็นผู้เรียนไม่กี่คน Tom B. Brown (Openai) และคณะ ประสาท [กระดาษ]

- GPT-3: การปรับขนาดแบบจำลองภาษาช่วยปรับปรุงประสิทธิภาพการทำงานที่ไม่คาดคิดการยิงไม่กี่ครั้งบางครั้งถึงแม้จะมีการแข่งขันด้วยวิธีการปรับแต่งที่ทันสมัยก่อนหน้านี้

การเรียนรู้อย่างต่อเนื่อง

- [2023/11] JARVIS-1: เอเจนต์หลายงานแบบเปิด-โลกพร้อมโมเดลภาษาหลายรูปแบบหน่วยความจำ Zihao Wang (Peking University) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/07] พรอมต์แบบก้าวหน้า: การเรียนรู้อย่างต่อเนื่องสำหรับแบบจำลองภาษา Razdaibiedina และคณะ arxiv. [กระดาษ]

- งานนี้แนะนำพรอมต์แบบก้าวหน้าซึ่งช่วยให้การถ่ายโอนไปข้างหน้าและต่อต้านการลืมหายนะโดยไม่ต้องพึ่งพาการเล่นซ้ำข้อมูลหรือพารามิเตอร์เฉพาะงานจำนวนมาก

- [2023/05] Voyager: ตัวแทนที่เป็นตัวเป็นตนปลายเปิดพร้อมรูปแบบภาษาขนาดใหญ่ Guanzhi Wang (Nvidia) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัส]

- Voyager: นี่เป็นตัวอย่างของตัวแทนการเรียนรู้ตลอดชีวิตที่เป็นตัวเป็นตน LLM ใน Minecraft ที่สำรวจโลกอย่างต่อเนื่องได้รับทักษะที่หลากหลายและทำการค้นพบใหม่โดยไม่ต้องแทรกแซงมนุษย์

- [2023/01] การสำรวจที่ครอบคลุมเกี่ยวกับการเรียนรู้อย่างต่อเนื่อง: ทฤษฎีวิธีการและแอปพลิเคชัน Liyuan Wang และคณะ arxiv. [กระดาษ]

- การสำรวจครั้งนี้นำเสนอการสำรวจที่ครอบคลุมเกี่ยวกับการเรียนรู้อย่างต่อเนื่องการค้นหาสะพานการตั้งค่าพื้นฐานฐานรากเชิงทฤษฎีวิธีการตัวแทนและการใช้งานจริง

- [2022/11] การเรียนรู้อย่างต่อเนื่องเกี่ยวกับงานการประมวลผลภาษาธรรมชาติ: การสำรวจ Zixuan Ke et al. arxiv. [กระดาษ]

- การสำรวจนี้นำเสนอการทบทวนและการวิเคราะห์ที่ครอบคลุมถึงความคืบหน้าล่าสุดของ CL ใน NLP

1.2 การรับรู้: อินพุตหลายรูปแบบสำหรับตัวแทนที่ใช้ LLM

1.2.1 ภาพ

- [2024/01] Agent AI: การสำรวจขอบเขตของปฏิสัมพันธ์หลายรูปแบบ Zane Durante และคณะ arxiv. [กระดาษ]

- [2023/10] ไปสู่การตัดสินใจที่เป็นตัวเป็นตนแบบ end-to-end ผ่านแบบจำลองภาษาขนาดใหญ่หลายรูปแบบ: การสำรวจด้วย GPT4-Vision และ Beyond Liang Chen et al arxiv. [กระดาษ] [รหัส]

- [2023/05] ภาษาไม่ใช่ทั้งหมดที่คุณต้องการ: จัดตำแหน่งการรับรู้กับแบบจำลองภาษา Shaohan Huang และคณะ arxiv. [กระดาษ]

- [2023/05] คำแนะนำ: ไปสู่โมเดลภาษาวิสัยทัศน์ที่มีวัตถุประสงค์ทั่วไปพร้อมการปรับแต่งการเรียนการสอน Wenliang Dai et al. arxiv. [กระดาษ]

- [2023/05] Multimodal-GPT: รูปแบบการมองเห็นและภาษาสำหรับการสนทนากับมนุษย์ เต่ากงและคณะ arxiv. [กระดาษ]

- [2023/05] Pandagpt: รุ่นเดียวในการเรียนการสอนเพื่อติดตามพวกเขาทั้งหมด Yixuan Su et al. arxiv. [กระดาษ]

- [2023/04] การปรับแต่งคำแนะนำด้วยภาพ Haotian Liu และคณะ arxiv. [กระดาษ]

- [2023/04] MINIGPT-4: เพิ่มความเข้าใจในการมองเห็นด้วยวิสัยทัศน์ด้วยแบบจำลองภาษาขนาดใหญ่ขั้นสูง Deyao Zhu arxiv. [กระดาษ]

- [2023/01] BLIP-2: Bootstrapping ภาษา-ภาพการฝึกอบรมล่วงหน้าด้วยการเข้ารหัสภาพแช่แข็งและโมเดลภาษาขนาดใหญ่ Junnan Li et al. arxiv. [กระดาษ]

- [2022/04] Flamingo: รูปแบบภาษาภาพสำหรับการเรียนรู้ไม่กี่นัด Jean-Baptiste Alayrac และคณะ arxiv. [กระดาษ]

- [2021/10] Mobilevit: น้ำหนักเบา, อเนกประสงค์, และหม้อแปลงวิสัยทัศน์ที่เป็นมิตรกับมือถือ Sachin Mehta et al.arxiv [กระดาษ]

- [2021/05] MLP-MIXER: สถาปัตยกรรม All-MLP สำหรับการมองเห็น Ilya Tolstikhin et al.arxiv [กระดาษ]

- [2020/10] ภาพมีค่า 16x16 คำ: หม้อแปลงสำหรับการจดจำภาพในระดับ Alexey Dosovitskiy และคณะ arxiv. [กระดาษ]

- [2017/11] การเรียนรู้การเป็นตัวแทนแบบไม่ต่อเนื่องของระบบประสาท Aaron van den Oord และคณะ arxiv. [กระดาษ]

1.2.2 เสียง

- [2023/06] Video-Llama: โมเดลภาษาภาพและเสียงที่ได้รับการปรับแต่งสำหรับการทำความเข้าใจวิดีโอ Hang Zhang et al. arxiv. [กระดาษ]

- [2023/05] X-LLM: Bootstrapping แบบจำลองภาษาขนาดใหญ่ขั้นสูงโดยการปฏิบัติหลายภาษาเป็นภาษาต่างประเทศ Feilong Chen และคณะ arxiv. [กระดาษ]

- [2023/05] InternGPT: การแก้ปัญหาการมองเห็นเป็นศูนย์กลางโดยการโต้ตอบกับ Chatgpt Beyond Language Zhaoyang Liu และคณะ arxiv. [กระดาษ]

- [2023/04] Audiogpt: การทำความเข้าใจและสร้างคำพูดดนตรีเสียงและหัวพูด Rongjie Huang และคณะ arxiv. [กระดาษ]

- [2023/03] HuggingGpt: การแก้ปัญหา AI กับ CHATGPT และเพื่อน ๆ ในการกอด Yongliang Shen และคณะ arxiv. [กระดาษ]

- [2021/06] ฮิวเบิร์ต: การเรียนรู้การเป็นตัวแทนการพูดด้วยตนเองโดยการทำนายการสวมหน้ากากของหน่วยที่ซ่อนอยู่ Wei-ning Hsu และคณะ arxiv. [กระดาษ]

- [2021/04] AST: Audio Spectrogram Transformer หยวนกงและคณะ arxiv. [กระดาษ]

1.3 การกระทำ: ขยายพื้นที่การกระทำของตัวแทนที่ใช้ LLM

1.3.1 เครื่องมือใช้

- [2024/02] ไปสู่ตัวแทนภาษาที่ไม่แน่นอน Jiuzhou Han (Monash University) และคณะ arxiv. [กระดาษ] [หน้าโครงการ] [รหัส]

- [2023/10] OpenAgents: แพลตฟอร์มเปิดสำหรับตัวแทนภาษาในป่า Xlang Lab (มหาวิทยาลัยฮ่องกง) Arxiv [กระดาษ] [หน้าโครงการ] [รหัส] [สาธิต]

- [2023/10] LeMur: การประสานภาษาธรรมชาติและรหัสสำหรับตัวแทนภาษา Yiheng Xu (มหาวิทยาลัยฮ่องกง) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/10] ไปสู่การตัดสินใจที่เป็นตัวเป็นตนแบบ end-to-end ผ่านรูปแบบภาษาขนาดใหญ่หลายรูปแบบ: การสำรวจด้วย GPT4-Vision และ Beyond Liang Chen (Peking University) และคณะ arxiv. [กระดาษ] [รหัส]

- โฮล์มส์เป็นกรอบความร่วมมือหลายตัวแทนที่อนุญาตให้ LLMs ใช้ประโยชน์จาก MLLMS และ APIs เพื่อรวบรวมข้อมูลหลายรูปแบบสำหรับการตัดสินใจอย่างชาญฉลาด

- [2023/07] TOOLLLM: อำนวยความสะดวกในรูปแบบภาษาขนาดใหญ่เพื่อควบคุม APIs 16000+ โลกแห่งความเป็นจริง Yujia Qin (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [รหัส] [ชุดข้อมูล]

- Toolllm เป็นกรอบการใช้เครื่องมือทั่วไปที่ครอบคลุมการสร้างข้อมูลการฝึกอบรมแบบจำลองและการประเมินผล

- [2023/05] โมเดลภาษาขนาดใหญ่เป็นผู้ผลิตเครื่องมือ Tianle Cai (มหาวิทยาลัยพรินซ์ตัน) และคณะ arxiv. [กระดาษ] [รหัส]

- LATM เป็นเฟรมเวิร์กวงปิดที่ใช้ขั้นตอนเริ่มต้นในการลบการพึ่งพาการพึ่งพาความพร้อมใช้งานของเครื่องมือที่มีอยู่

- [2023/05] ผู้สร้าง: การแยกแยะบทคัดย่อและเหตุผลที่เป็นรูปธรรมของแบบจำลองภาษาขนาดใหญ่ผ่านการสร้างเครื่องมือ Cheng Qian (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ]

- ผู้สร้างเป็นกรอบนวนิยายที่ให้อำนาจ LLM เพื่อสร้างเครื่องมือของตัวเองผ่านเอกสารและการรับรู้รหัส

- [2023/04] การเรียนรู้เครื่องมือกับแบบจำลองพื้นฐาน Yujia Qin (มหาวิทยาลัย Tsinghua) และคณะ arxiv. [กระดาษ] [รหัส]

- การสำรวจครั้งนี้แนะนำกระบวนทัศน์ใหม่ที่เรียกว่า "การเรียนรู้เครื่องมือตามรูปแบบพื้นฐาน" ซึ่งรวมข้อดีของเครื่องมือพิเศษและแบบจำลองพื้นฐานเพื่อให้ได้ความแม่นยำสูงประสิทธิภาพและระบบอัตโนมัติในการแก้ปัญหา

- [2023/04] Chemcrow: การเพิ่มโมเดลภาษาขนาดใหญ่ด้วยเครื่องมือเคมี Andres M Bran (ห้องปฏิบัติการข่าวกรองเคมีประดิษฐ์, ISIC, EPFL) และคณะ arxiv. [กระดาษ] [รหัส]

- Chemcrow เป็นสารเคมี LLM ที่รวมเครื่องมือที่ออกแบบโดยผู้เชี่ยวชาญ 13 ตัวและเพิ่มประสิทธิภาพ LLM ในวิชาเคมีและเกิดความสามารถใหม่

- [2023/04] Genegpt: การเพิ่มโมเดลภาษาขนาดใหญ่ด้วยเครื่องมือโดเมนสำหรับการปรับปรุงการเข้าถึงข้อมูลชีวการแพทย์ Qiao Jin (สถาบันสุขภาพแห่งชาติ), Yifan Yang, Qingyu Chen, Zhiyong Lu arxiv. [กระดาษ] [รหัส]

- Genegpt เป็นแบบจำลองที่ตอบคำถามจีโนม มันแนะนำวิธีการใหม่สำหรับการจัดการความท้าทายด้วยภาพหลอนโดยการสอน LLMS ให้ใช้เว็บ APIs

- [2023/04] OpenAgi: เมื่อ LLM พบกับผู้เชี่ยวชาญโดเมน Yingqiang GE (Rutgers University) และคณะ arxiv. [กระดาษ] [รหัส]

- OpenAgi เป็นแพลตฟอร์มการวิจัย AGI โอเพนซอร์ส มันแนะนำกระบวนทัศน์ของ LLMs ที่ใช้งานแบบจำลองผู้เชี่ยวชาญต่าง ๆ สำหรับการแก้งานที่ซับซ้อนและเสนอกลไก RLTF เพื่อปรับปรุงความสามารถในการแก้ปัญหางานของ LLM

- [2023/03] HuggingGpt: การแก้ปัญหา AI กับ CHATGPT และเพื่อน ๆ ในการกอด Yongliang Shen (มหาวิทยาลัยเจ้อเจียง) และคณะ arxiv. [กระดาษ] [รหัส]

- HuggingGpt เป็นระบบที่ใช้ประโยชน์จาก LLM เพื่อเชื่อมต่อโมเดล AI ที่หลากหลายและหลายรูปแบบในชุมชนการเรียนรู้ของเครื่องเพื่อแก้ปัญหา AI

- [2023/03] Visual Chatgpt: การพูดคุยการวาดและการแก้ไขด้วยโมเดลพื้นฐานภาพ Chenfei Wu (Microsoft Research Asia) และคณะ arxiv. [กระดาษ] [รหัส]

- Visual Chatgpt เป็นระบบที่เปิดประตูสู่การตรวจสอบบทบาทที่มองเห็นได้ของ ChatGPT ด้วยความช่วยเหลือของโมเดลพื้นฐานภาพ

- [2023/02] แบบจำลองภาษาที่เพิ่มขึ้น: การสำรวจ Grégoire Mialon (Meta AI) และคณะ tmlr [กระดาษ]

- บทวิจารณ์แบบสำรวจนี้ใช้งานได้ซึ่ง LMS ได้รับการเสริมด้วยความสามารถในการใช้เครื่องมือ Augmented LMS สามารถใช้โมดูลภายนอกเพื่อขยายความสามารถในการประมวลผลบริบท

- [2023/02] Toolformer: แบบจำลองภาษาสามารถสอนตัวเองให้ใช้เครื่องมือ Timo Schick (Meta AI) และคณะ arxiv. [กระดาษ]

- Toolformer แสดงให้เห็นว่า LLM สามารถสอนตัวเองให้ใช้เครื่องมือภายนอกด้วยการสาธิตจำนวนหนึ่งสำหรับแต่ละ API

- [2022/05] TALM: โมเดลภาษาเสริมเครื่องมือ Aaron Parisi (Google) และคณะ arxiv. [กระดาษ]

- TALM แนะนำวิธีการที่รวมเครื่องมือที่ไม่แตกต่างกับ LMS ทำให้โมเดลสามารถเข้าถึงข้อมูลแบบเรียลไทม์หรือส่วนตัวได้

- [2022/05] ระบบ MRKL: สถาปัตยกรรมแบบแยกส่วน, neuro-symbolic ที่รวมโมเดลภาษาขนาดใหญ่แหล่งความรู้ภายนอกและการใช้เหตุผลแบบไม่ต่อเนื่อง Ehud Karpas (AI21 Labs) และคณะ arxiv. [กระดาษ]

- ระบบ MRKL เพิ่ม LLM ด้วยชุดความรู้ภายนอกและโมดูลการให้เหตุผลที่ขยายได้อย่างง่ายดาย

- [2022/04] ทำเท่าที่จะทำได้ไม่ใช่อย่างที่ฉันพูด: ภาษาที่มีพื้นฐานในการจ่ายหุ่นยนต์ Michael Ahn (Google) และคณะ Corl. [กระดาษ]

- Saycan ใช้ LMS ในงานหุ่นยนต์ในโลกแห่งความเป็นจริงโดยการรวมความรู้เชิงความหมายขั้นสูงจาก LLMs กับฟังก์ชั่นค่าของทักษะการฝึกอบรมก่อน

- [2021/12] WebGPT: การตอบคำถามเบราว์เซอร์ช่วยตอบคำถามของมนุษย์ Reiichiro Nakano (Openai) และคณะ arxiv. [กระดาษ]

- WebGPT ตอบคำถามโดยใช้สภาพแวดล้อมการเรียกเว็บ มันใช้การเรียนรู้การเลียนแบบระหว่างการฝึกอบรมและเพิ่มประสิทธิภาพการตอบคุณภาพผ่านข้อเสนอแนะของมนุษย์

- [2021/07] การประเมินแบบจำลองภาษาขนาดใหญ่ที่ผ่านการฝึกอบรมเกี่ยวกับรหัส Mark Chen (Openai) และคณะ arxiv. [กระดาษ] [รหัส]

- Codex สามารถสังเคราะห์โปรแกรมจาก DocStrings นั่นคือการสร้างเครื่องมือตามเอกสาร

1.3.2 การกระทำที่เป็นตัวเป็นตน

- [2023/12] สู่การเรียนรู้แบบจำลองทั่วไปสำหรับการนำทางที่เป็นตัวเป็นตน Duo Zheng (มหาวิทยาลัยจีนแห่งฮ่องกง) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/11] ตัวแทนทั่วไปที่เป็นตัวเป็นตนในโลก 3 มิติ Jiangyong Huang (Bigai & Peking University) และคณะ arxiv. [กระดาษ] [หน้าโครงการ]

- [2023/11] JARVIS-1: เอเจนต์หลายงานแบบเปิด-โลกพร้อมโมเดลภาษาหลายรูปแบบหน่วยความจำ Zihao Wang (Peking University) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/10] LeMur: การประสานภาษาธรรมชาติและรหัสสำหรับตัวแทนภาษา Yiheng Xu (มหาวิทยาลัยฮ่องกง) และคณะ arxiv. [กระดาษ] [รหัส]

- [2023/10] Towards End-to-End Embodied Decision Making via Multi-modal Large Language Model: Explorations with GPT4-Vision and Beyond Liang Chen et al. arXiv. [paper] [code]

- [2023/07] Interactive language: Talking to robots in real time. Corey Lynch et al. IEEE (RAL) [paper]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [กระดาษ]

- [2023/05] EmbodiedGPT: Vision-Language Pre-Training via Embodied Chain of Thought. Yao Mu et al. Arxiv [paper] [code]

- [2023/05] NavGPT: Explicit Reasoning in Vision-and-Language Navigation with Large Language Models. Gengze Zhou et al. Arxiv [paper]

- [2023/05] AlphaBlock: Embodied Finetuning for Vision-Language Reasoning in Robot Manipulation. Chuhao Jin et al. Arxiv [paper]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess et al. Arxiv. [กระดาษ]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn et al. Arxiv [paper] [code]

- [2023/02] Collaborating with language models for embodied reasoning. Ishita Dasgupta et al. Arxiv. [กระดาษ]

- [2023/02] Code as Policies: Language Model Programs for Embodied Control. Jacky Liang et al. IEEE (ICRA). [กระดาษ]

- [2022/10] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao et al. Arxiv [paper] [code]

- [2022/10] Instruction-Following Agents with Multimodal Transformer. Hao Liu et al. CVPR [paper] [code]

- [2022/07] Inner Monologue: Embodied Reasoning through Planning with Language Models. Wenlong Huang et al. Arxiv. [กระดาษ]

- [2022/07] LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action. Dhruv Shahet al. CoRL [paper] [code]

- [2022/04] Do As I Can, Not As I Say: Grounding Language in Robotic Affordances. Michael Ahn et al. Arxiv. [กระดาษ]

- [2022/01] A Survey of Embodied AI: From Simulators to Research Tasks. Jiafei Duan et al. IEEE (TETCI). [กระดาษ]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [paper] [code]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [กระดาษ]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [กระดาษ]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arXiv. [paper] [code]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arXiv. [กระดาษ]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [paper] [code]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arXiv. [paper] [code]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [กระดาษ]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [paper] [code]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [paper] [code]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [กระดาษ]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [กระดาษ]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [กระดาษ]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [กระดาษ]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [กระดาษ]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [paper] [code]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [paper] [code]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [กระดาษ]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [กระดาษ]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [กระดาษ]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [กระดาษ]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [กระดาษ]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [paper] [code]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [paper] [code]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [paper] [code]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [paper] [code]

2.2 Coordinating Potential of Multiple Agents

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [paper] [code]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [paper] [code]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [กระดาษ]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [กระดาษ]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [paper] [code]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [paper] [code]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [กระดาษ]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [paper] [code]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [paper] [code]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [paper] [code]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [กระดาษ]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [paper] [code]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [กระดาษ]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [paper] [code]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [paper] [code]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [กระดาษ]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [paper] [code]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [paper] [code]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [กระดาษ]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [paper] [code]

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

การศึกษา

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [กระดาษ]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [กระดาษ]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

สุขภาพ

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [paper] [code]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [กระดาษ]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [กระดาษ]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [กระดาษ]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [กระดาษ]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [กระดาษ]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [กระดาษ]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [กระดาษ]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [กระดาษ]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [paper] [code]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [กระดาษ]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [กระดาษ]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [กระดาษ]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [กระดาษ]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [กระดาษ]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al. ศาสตร์. [กระดาษ]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [กระดาษ]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [paper] [code]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [paper] [code]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [กระดาษ]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [paper] [code]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [paper] [code]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [กระดาษ]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [กระดาษ]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [paper] [code]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [paper] [code]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [paper] [code]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [paper] [code]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [paper] [code]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [paper] [code]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [กระดาษ]

3.1.2 Personality

Cognition

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [กระดาษ]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [กระดาษ]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [กระดาษ]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [กระดาษ]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [กระดาษ]

อารมณ์

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [กระดาษ]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [กระดาษ]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [กระดาษ]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [กระดาษ]

อักขระ

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [paper] [code]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [paper] [code]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [paper] [code]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [paper] [code]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [กระดาษ]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [กระดาษ]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [paper] [code]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [paper] [code]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [กระดาษ]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [paper] [code]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [paper] [code]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [paper] [code]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [paper] [code]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [paper] [code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [กระดาษ]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [paper] [code]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [paper] [code]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [กระดาษ]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [paper] [code]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [กระดาษ]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [paper] [code]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [กระดาษ]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [paper] [code]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [paper] [code]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [paper] [code]

การอ้างอิง

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

ติดต่อ

Star History