صعود وإمكانات الوكلاء القائم على نموذج اللغة الكبيرة: دراسة استقصائية

يجب قراءة الأوراق للوكلاء القائمة على LLM.

؟ قريباً: أضف مقدمة واحدة إلى كل ورقة.

؟ أخبار

- ☄ [2024/06/07] تم إصدار Agentgym لتطوير وتطور العوامل القائمة على LLM عبر بيئات متنوعة!

- ورقة: Agentgym.

- صفحة المشروع: https://agentgym.github.io/.

- الرموز: النظام الأساسي والتطبيقات.

- موارد Huggingface: Agenttraj-L ، Agenteval ، Agentevol-7B.

- ؟ [2024/05/02] تم قبول R3 (تدريب نماذج لغة كبيرة للتفكير من خلال التعلم العكسي لتعزيز المناهج الدراسية) بواسطة ICML 2024!

- ؟ [2024/02/08] تم إصدار ورقة جديدة R3 على RL لعدل وكيل LLM! الورق: تدريب نماذج لغة كبيرة للتفكير من خلال التعلم العكسي لتعزيز المناهج الدراسية. الرموز: LLM-Curriculum-RL.

- ؟ [2023/09/20] تم إدراج هذا المشروع في GitHub Trendings! إنه شرف رائع!

- ؟ [2023/09/15] تم إصدار استطلاعنا! شاهد صعود وإمكانات العوامل القائمة على نموذج اللغة الكبيرة: مسح للورقة!

- [2023/09/14] نقوم بإنشاء هذا المستودع للحفاظ على قائمة ورقية على الوكلاء المستندة إلى LLM. المزيد من الأوراق قريبا!

؟ مقدمة

لفترة طويلة ، تابعت الإنسانية الذكاء الاصطناعي (AI) المكافئة أو تجاوز المستوى البشري ، مع اعتبار عوامل الذكاء الاصطناعى وسيلة واعدة لهذا المطاردة. وكلاء الذكاء الاصطناعى هي كيانات اصطناعية تستشعر بيئتها ، واتخاذ القرارات ، واتخاذ الإجراءات.

نظرًا للقدرات المتعددة الاستخدامات والرائعة التي يثبتونها ، تعتبر نماذج اللغة الكبيرة (LLMS) شرارات محتملة للذكاء العام الاصطناعي (AGI) ، مما يوفر الأمل لبناء وكلاء الذكاء الاصطناعى العامين. استفادت العديد من الجهود البحثية من LLMs كأساس لبناء وكلاء الذكاء الاصطناعي وحقق تقدمًا كبيرًا.

في هذا المستودع ، نقدم مسحًا منهجيًا وشاملًا على الوكلاء المستندة إلى LLM ، وندرج بعض الأوراق التي يجب قراءتها.

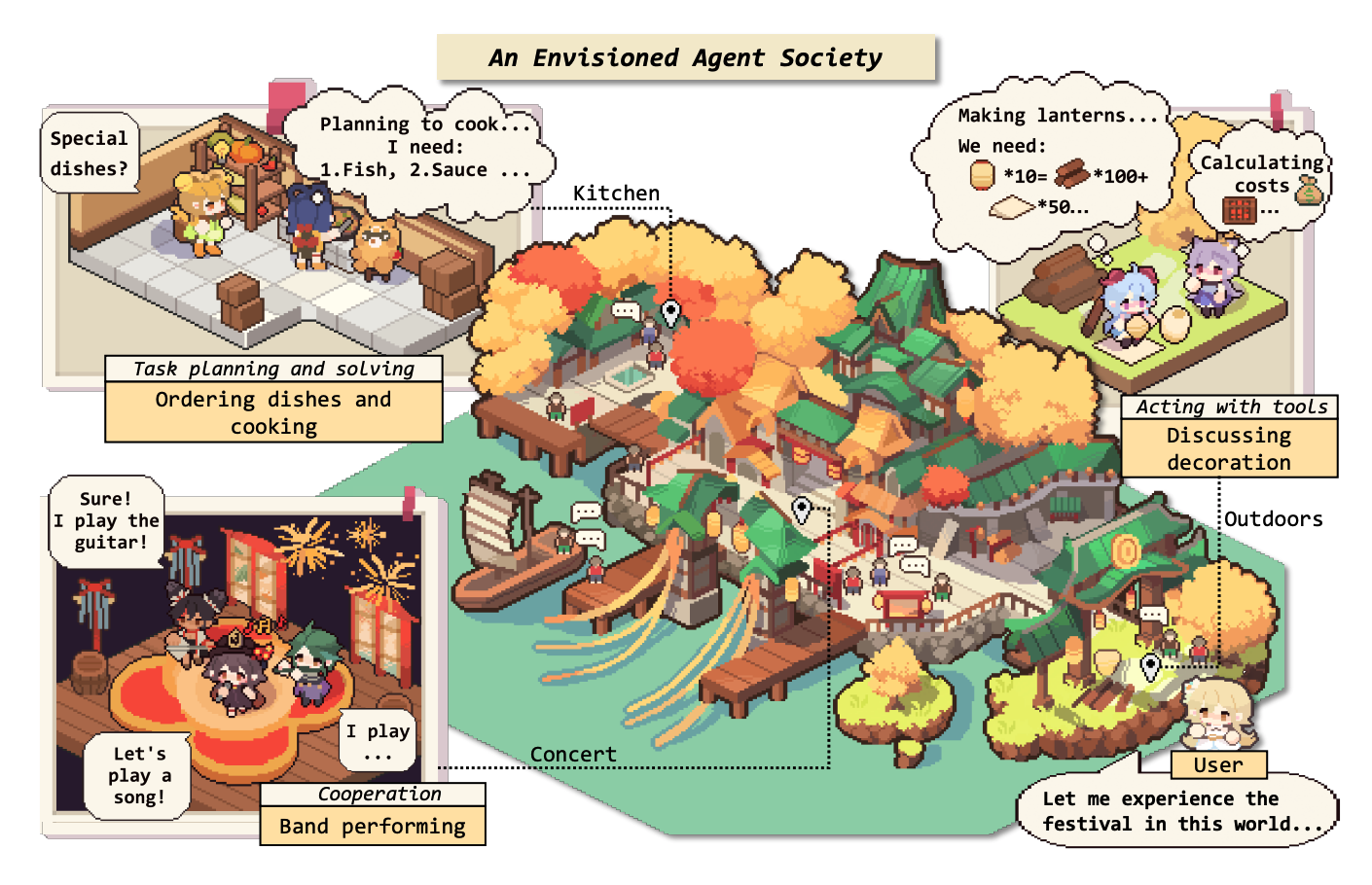

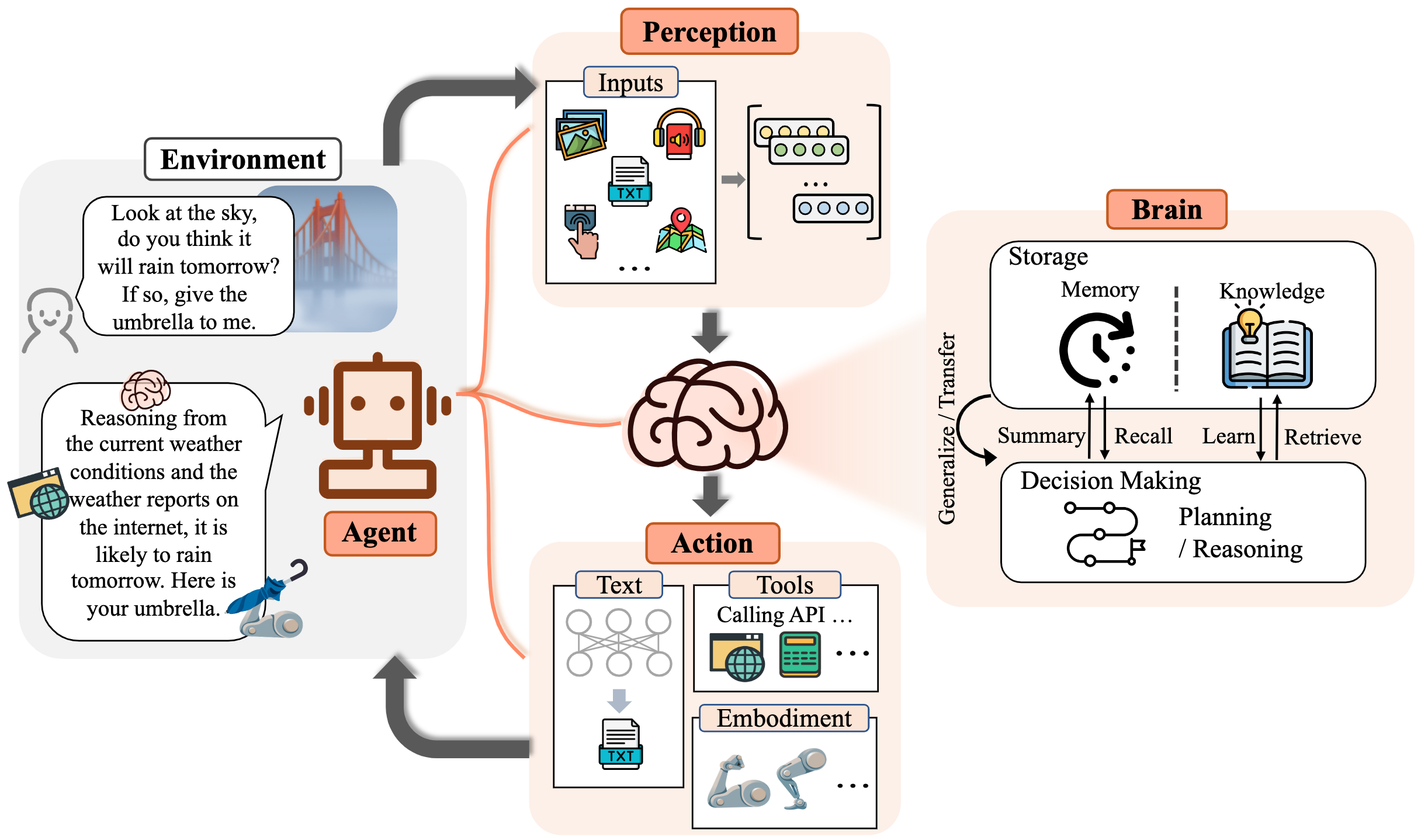

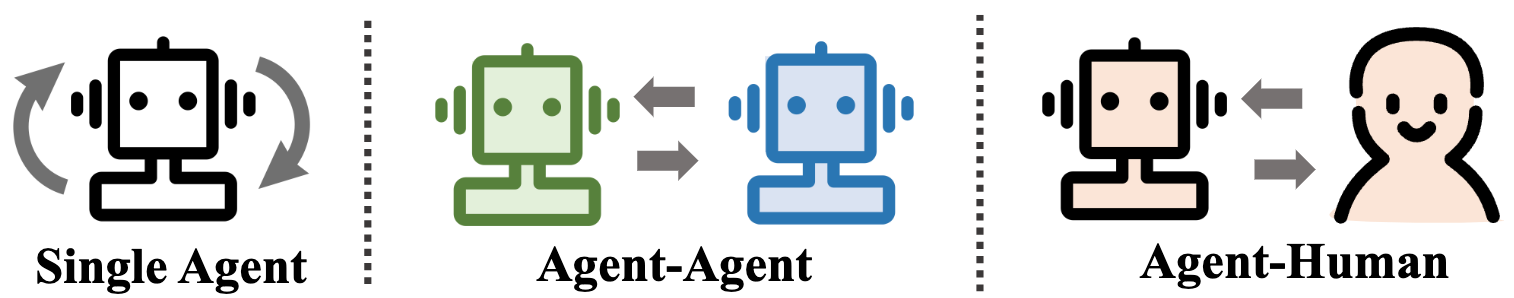

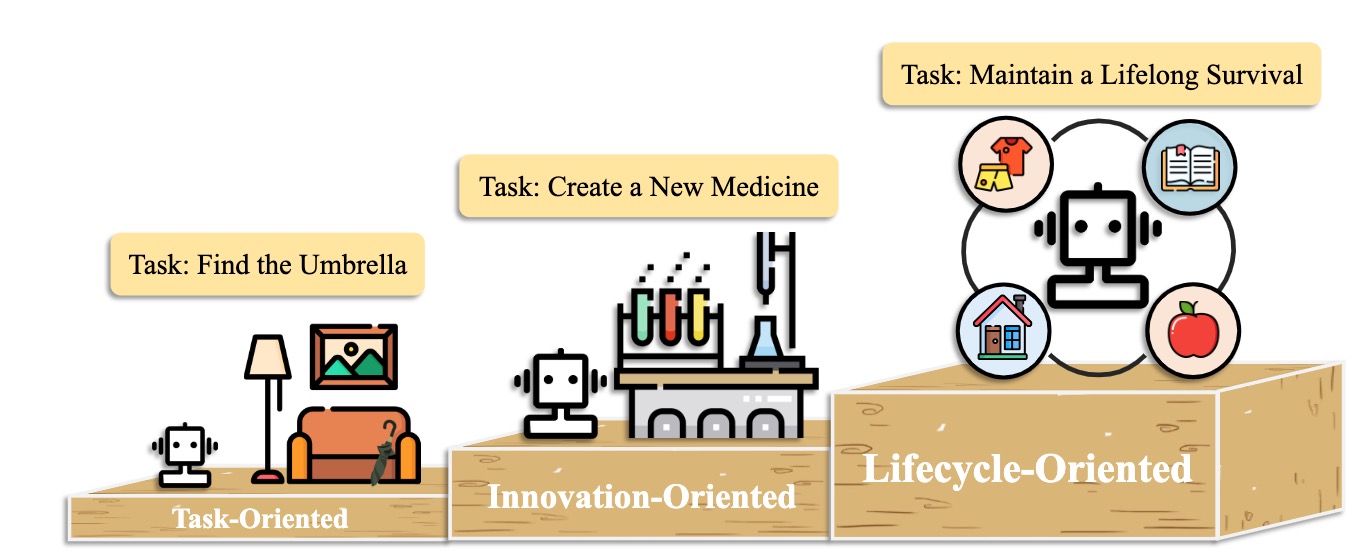

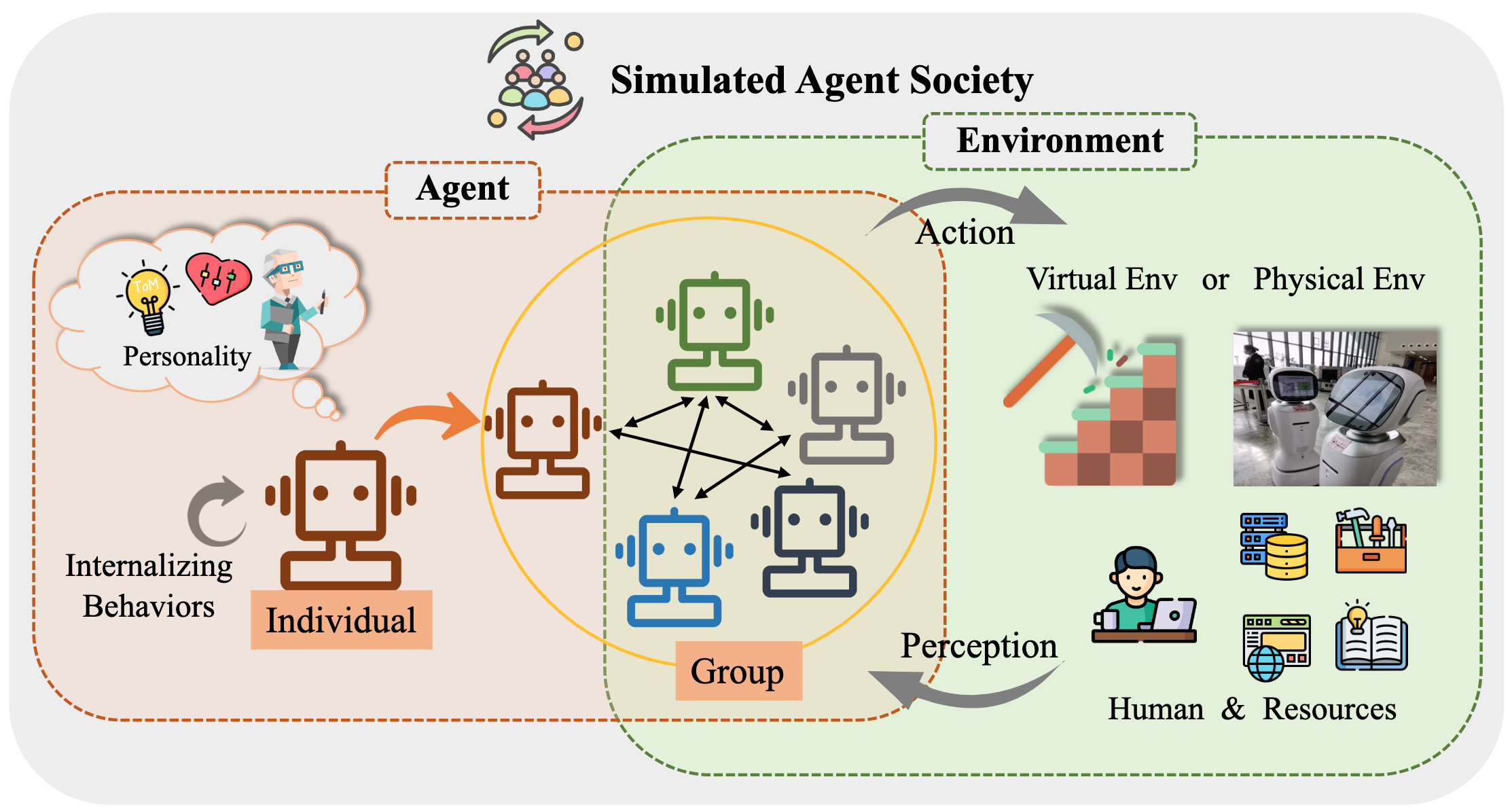

على وجه التحديد ، نبدأ بالإطار المفاهيمي العام للعوامل المستندة إلى LLM: تضم ثلاثة مكونات رئيسية: الدماغ ، والإدراك ، والعمل ، ويمكن تصميم الإطار لتناسب تطبيقات مختلفة. بعد ذلك ، نستكشف التطبيقات الواسعة للعوامل المستندة إلى LLM في ثلاثة جوانب: سيناريوهات الوكيل الواحد ، وسيناريوهات متعددة الوكلاء ، والتعاون بين الوكيل البشري. بعد ذلك ، نتعمق في مجتمعات الوكلاء ، واستكشاف سلوك وشخصية العوامل القائمة على LLM ، والظواهر الاجتماعية التي تظهر عندما تشكل المجتمعات ، والرؤى التي يقدمونها للمجتمع البشري. أخيرًا ، نناقش مجموعة من الموضوعات الرئيسية والمشاكل المفتوحة داخل الحقل.

نحن نقدر بشدة أي مساهمات عبر PRS أو القضايا أو رسائل البريد الإلكتروني أو غيرها من الطرق.

جدول المحتوى (TOC)

- صعود وإمكانات الوكلاء القائم على نموذج اللغة الكبيرة: دراسة استقصائية

- ؟ أخبار

- ؟ مقدمة

- جدول المحتوى (TOC)

- 1. ولادة الوكيل: بناء الوكلاء القائم على LLM

- 1.1 الدماغ: يتكون في المقام الأول من LLM

- 1.1.1 تفاعل اللغة الطبيعية

- 1.1.2 المعرفة

- نموذج ما قبل

- المعرفة اللغوية

- المعرفة المنطقية

- المعرفة القابلة للتنفيذ

- القضايا المحتملة للمعرفة

- 1.1.3 الذاكرة

- قدرة الذاكرة

- رفع الحد الأقصى لطول المحولات

- تلخيص الذاكرة

- ضغط الذكريات مع المتجهات أو هياكل البيانات

- استرجاع الذاكرة

- 1.1.4 التفكير والتخطيط

- 1.1.5 قابلية النقل والتعميم

- تعميم المهام غير المرئي

- التعلم داخل السياق

- التعلم المستمر

- 1.2 الإدراك: مدخلات متعددة الوسائط للعوامل المستندة إلى LLM

- 1.3 الإجراء: قم بتوسيع مساحة عمل الوكلاء المستندة إلى LLM

- 1.3.1 أداة باستخدام

- 1.3.2 عمل تجسيد

- 2. الوكلاء في الممارسة: تطبيقات الوكلاء المستندة إلى LLM

- 2.1 القدرة العامة للوكيل الوحيد

- 2.1.1 النشر الموجهة للمهمة

- 2.1.2 النشر الموجهة للابتكار

- 2.1.3 النشر الموجهة نحو دورة الحياة

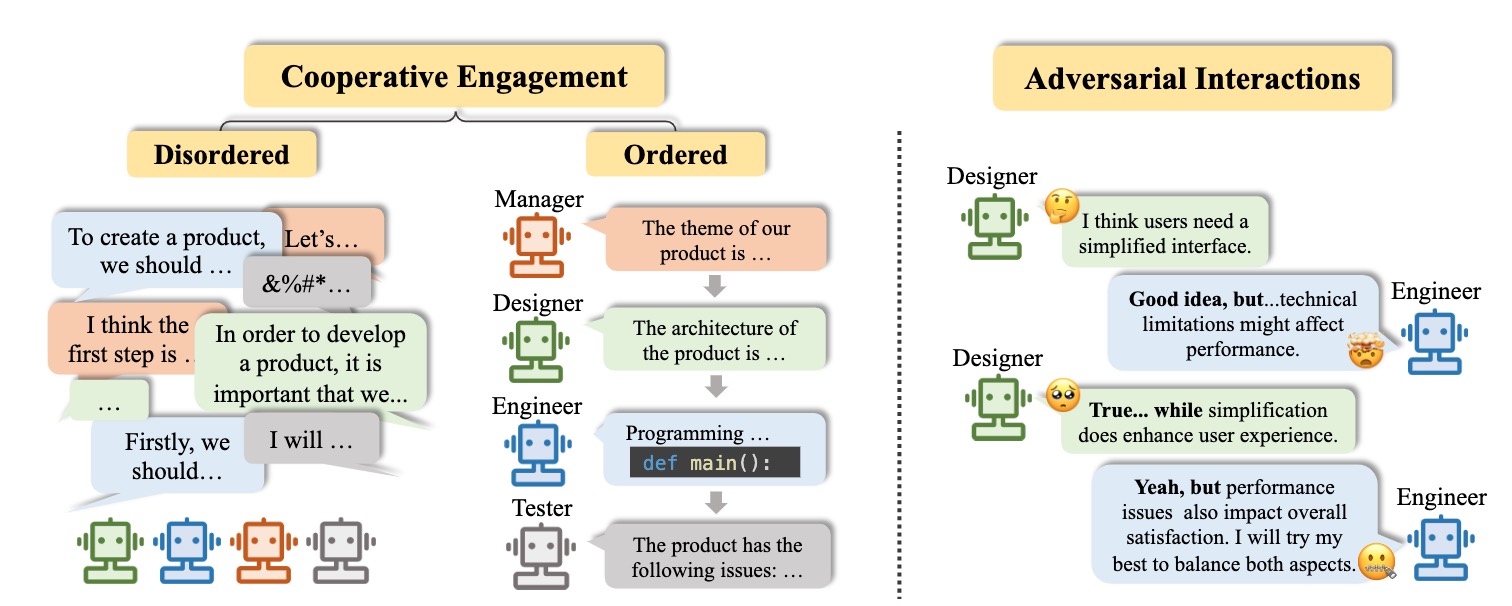

- 2.2 تنسيق إمكانات عوامل متعددة

- 2.2.1 التفاعل التعاوني للتكامل

- 2.2.2 التفاعل العدواني للتقدم

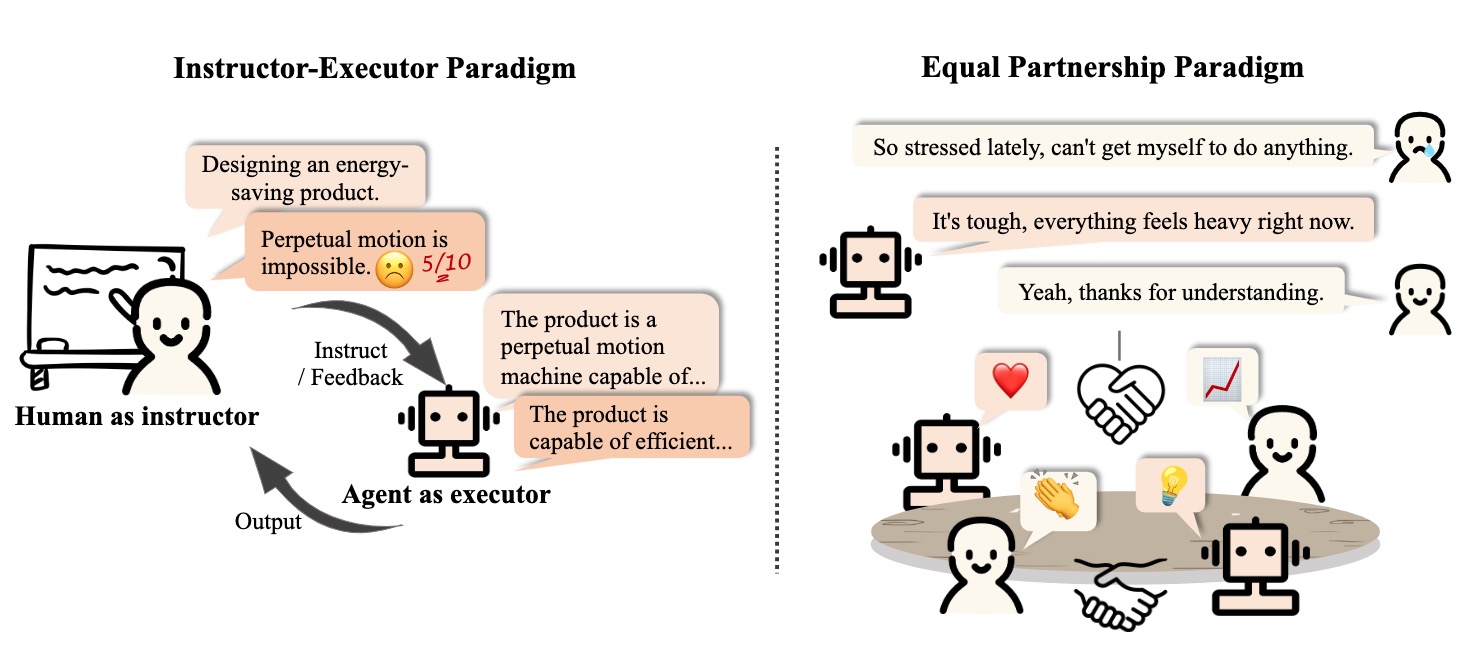

- 2.3 المشاركة التفاعلية بين الإنسان والعامل

- 2.3.1 نموذج المعلم التنفيذي

- 2.3.2 نموذج شراكة متساوية

- التواصل التعاطف

- مشارك على مستوى الإنسان

- 3. جمعية الوكيل: من الفردانية إلى الاجتماعية

- 3.1 سلوك وشخصية العوامل القائمة على LLM

- 3.1.1 السلوك الاجتماعي

- السلوكيات الفردية

- السلوكيات الجماعية

- 3.1.2 الشخصية

- 3.2 بيئة لمجتمع الوكيل

- 3.2.1 البيئة القائمة على النص

- 3.2.2 بيئة صندوق الرمل الافتراضي

- 3.2.3 البيئة المادية

- 3.3 محاكاة المجتمع مع الوكلاء القائم على LLM

- 4. مواضيع أخرى

- 4.1 معايير الوكلاء المستندة إلى LLM

- 4.2 التدريب وتحسين الوكلاء القائم على LLM

- اقتباس

- المشروع المشاريع والمساهمين

- اتصال

- تاريخ النجوم

1. ولادة الوكيل: بناء الوكلاء القائم على LLM

1.1 الدماغ: يتكون في المقام الأول من LLM

1.1.1 تفاعل اللغة الطبيعية

جيل عالي الجودة

- [2023/10] نحو اتخاذ القرارات المتجسدة من طرف إلى النهاية من خلال نموذج اللغة الكبيرة متعددة الوسائط: الاستكشافات مع GPT4-Vision وخارج Liang Chen et al. arxiv. [ورقة] [رمز]

- يقترح هذا العمل PCA-eval ، الذي يتجسد المعايير من اتخاذ القرارات من خلال طريقة شاملة إلى طرف مستندة إلى MLLM وطرق استخدام الأدوات المستندة إلى LLM من مستويات الإدراك والإدراك ومستويات الإجراء.

- [2023/08] تقييم متعدد المهام ، متعدد اللغات ، متعدد الوسائط لـ ChatGPT على التفكير والهلوسة والتفاعل. Yejin Bang et al. arxiv. [ورق]

- يقوم هذا العمل بتقييم الجوانب متعددة المهام ، متعددة اللغات ومتعددة الوسائط لـ ChatGPT باستخدام 21 مجموعة بيانات تغطي 8 مهام تطبيقات NLP شائعة مختلفة.

- [2023/06] LLM-Eval: التقييم التلقائي متعدد الأبعاد الموحد لمحادثات المجال المفتوح مع نماذج لغة كبيرة. يننغ لين وآخرون. arxiv. [ورق]

- تقوم طريقة LLM-Eval بتقييم أبعاد متعددة للتقييم ، مثل المحتوى ، والقواعد ، والأهمية ، والملاءمة.

- [2023/04] هل chatgpt نظام تصحيح الخطأ النحوي للغاية؟ تقييم شامل. تاو فانغ وآخرون. arxiv. [ورق]

- توضح نتائج التقييم أن ChatGPT لديها قدرات ممتازة لاكتشاف الأخطاء ويمكن أن تصحح الأخطاء بحرية لجعل الجمل المصححة بطلاقة للغاية. بالإضافة إلى ذلك ، يسلط أدائها في الإعدادات غير الإنجليزية والموارد المنخفضة الضوء على إمكاناتها في مهام GEC متعددة اللغات.

فهم عميق

- [2023/06] هانز ذكي أو نظرية العقل العصبية؟ اختبار الإجهاد التفكير الاجتماعي في نماذج اللغة الكبيرة. ناتالي شابيرا وآخرون. arxiv. [ورق]

- تظهر LLMs نظرية معينة لقدرات العقل ، لكن هذا السلوك بعيد عن أن يكون قويًا.

- [2022/08] استنتاج المكافآت من اللغة في السياق. جيسي لين وآخرون. ACL. [ورق]

- يعرض هذا العمل نموذجًا يعاني من مكافآت من اللغة ويتوقع الإجراءات المثلى في البيئة غير المرئية.

- [2021/10] نظرية التواصل المساعدة القائم على العقل في التعاون الروبوت البشري المعقد. Moritz C. Buehler et al. arxiv. [ورق]

- يصمم هذا العمل السوشي وكيل مع فهم للإنسان أثناء التفاعل.

1.1.2 المعرفة

نموذج ما قبل

- [2023/04] تعلم تمثيلات موزعة للجمل من البيانات غير المسمى. فيليكس هيل (جامعة كامبريدج) وآخرون. arxiv. [ورق]

- [2020/02] ما مقدار المعرفة التي يمكنك حزمها في معلمات نموذج اللغة؟ آدم روبرتس (جوجل) وآخرون. arxiv. [ورق]

- [2020/01] تحجيم قوانين نماذج اللغة العصبية. جاريد كابلان (جامعة جونز هوبكنز) وآخرون. arxiv. [ورق]

- [2017/12] المعرفة المنطقية في الذكاء الآلي. نيك تاندون (معهد ألين للذكاء الاصطناعي) وآخرون. سيغمود. [ورق]

- [2011/03] معالجة اللغة الطبيعية (تقريبًا) من الصفر. رونان كولوبرت (برينستون) وآخرون. arxiv. [ورق]

المعرفة اللغوية

- [2023/02] تقييم متعدد المهام ، متعدد اللغات ، متعدد الوسائط لـ ChatGPT على التفكير والهلوسة والتفاعل. Yejin Bang et al. arxiv. [ورق]

- [2021/06] استقصاء نماذج اللغة التي تم تدريبها مسبقًا للسمات الدلالية وقيمها. Meriem Beloucif et al. emnlp. [ورق]

- [2020/10] التحقيق في نماذج اللغة المسبقة للدلالات المعجمية. إيفان فوليتش وآخرون. arxiv. [ورق]

- [2019/04] مسبار هيكلي لإيجاد بناء جملة في تمثيلات الكلمات. جون هيويت وآخرون. ACL. [ورق]

- [2016/04] تحسين استخراج الكلمات الرئيسية التلقائية بالنظر إلى المزيد من المعرفة الدلالية. ح ليونج. أنظمة التطبيقات المتقدمة. [ورق]

المعرفة المنطقية

- [2022/10] نماذج اللغة من الكود هي متعلمين من طلقة قليلة. أمان مادان وآخرون. [ورق]

- [2021/04] تمثيل المعرفة في العالم العلائقي في نماذج اللغة السياقية: مراجعة. تارا صفافي وآخرون. arxiv. [ورق]

- [2019/11] كيف يمكننا معرفة ما هي نماذج اللغة تعرف؟ Zhengbao Jiang et al.arxiv. [ورق]

المعرفة القابلة للتنفيذ

- [2023/07] نماذج لغة كبيرة في الطب. أرون جيمس ثيرونافوكاراسو وآخرون. طبيعة. [ورق]

- [2023/06] DS-1000: معيار طبيعي وموثوق لتوليد رمز علوم البيانات. Yuhang Lai et al. ICML. [ورق]

- [2022/10] نماذج اللغة من الكود هي متعلمين من طلقة قليلة. أمان مادان وآخرون. arxiv. [ورق]

- [2022/02] تقييم منهجي لنماذج اللغة الكبيرة من التعليمات البرمجية. فرانك ف. شو وآخرون. [ورق]

- [2021/10] تحديات التدريب لحل مشاكل كلمات الرياضيات. Karl Cobbe et al. arxiv. [ورق]

القضايا المحتملة للمعرفة

- [2023/10] FreshLlms: طرز لغة كبيرة منعشة مع زيادة محرك البحث. Tu Vu (Google) et al. arxiv [ورقة] [رمز]

- [2023/05] تحرير نماذج اللغة الكبيرة: المشاكل والأساليب والفرص. يونزهي ياو وآخرون. arxiv. [ورق]

- [2023/05] الفحص الذاتي: وحدات التوصيل والتشغيل لتكوين الحقائق مع نماذج لغة كبيرة. مياوران لي وآخرون. arxiv. [ورق]

- [2023/05] الناقد: يمكن أن تصاعد نماذج اللغة الكبيرة ذاتية الأدوات. Zhibin Gou et al. arxiv. [ورق]

- [2023/04] أدوات تعلم مع نماذج الأساس. يوجيا تشين وآخرون. arxiv. [ورق]

- [2023/03] SelfCheckgpt: اكتشاف الهلوسة الصفر في المورد الأسود لنماذج اللغة الكبيرة التوليدية. Potsawee Manakul et al. arxiv. [ورق]

- [2022/06] تحرير الطراز القائم على الذاكرة على نطاق واسع. إريك ميتشل وآخرون. arxiv. [ورق]

- [2022/04] مراجعة لنماذج اللغة كقواعد المعرفة. بدري كلبكسي وآخرون. [ورق]

- [2021/04] تحرير المعرفة الواقعية في نماذج اللغة. Nicola de Cao et al.arxiv. [ورق]

- [2017/08] قياس نسيان كارثي في الشبكات العصبية. رونالد كيمكر وآخرون. [ورق]

1.1.3 الذاكرة

قدرة الذاكرة

رفع الحد الأقصى لطول المحولات

- [2023/10] MEMGPT: نحو LLMS كنظم تشغيل. تشارلز باكر (UC Berkeley) وآخرون. arxiv. [ورقة] [صفحة المشروع] [رمز] [مجموعة البيانات]

- [2023/05] تشفير الموضع العشوائي يعزز طول الطول من المحولات. Anian Ruoss (DeepMind) et al. arxiv. [ورقة] [رمز]

- [2023-03] Colt5: محولات أسرع طويلة المدى مع حساب مشروط. Joshua Ainslie (Google Research) et al. arxiv. [ورق]

- [2022/03] تصنيف فعال للمستندات الطويلة باستخدام المحولات. Hyunji Hayley Park (جامعة إلينوي) وآخرون. arxiv. [ورقة] [رمز]

- [2021/12] Longt5: محول نص إلى نص فعال للتسلسلات الطويلة. Mandy Guo (Google Research) et al. arxiv. [ورقة] [رمز]

- [2019/10] بارت: تقليل التسلسل إلى التسلسل قبل التدريب لتوليد اللغة الطبيعية والترجمة والفهم. مايكل لويس (Facebook AI) وآخرون. arxiv. [ورقة] [رمز]

تلخيص الذاكرة

- [2023/10] السير في متاهة الذاكرة: ما وراء الحد من السياق من خلال القراءة التفاعلية هوارد تشن (جامعة برينستون) وآخرون. arxiv. [ورق]

- [2023/09] تمكين التدريس الخاص من خلال تسلسل نماذج اللغة الكبيرة Yulin Chen (جامعة Tsinghua) وآخرون. arxiv. [ورق]

- [2023/08] طرد: عوامل LLM هي متعلمين تجريبيين. أندرو تشاو (جامعة تسينغهوا) وآخرون. arxiv. [ورقة] [رمز]

- [2023/08] Chateval: نحو مُقيِّم أفضل من LLM من خلال نقاش متعدد الوكلاء. تشي مين تشان (جامعة تسينغهوا) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] MemoryBank: تعزيز نماذج لغة كبيرة مع ذاكرة طويلة الأجل. وانجون تشونغ (معهد هاربين للتكنولوجيا) وآخرون. arxiv. [ورقة] [رمز]

- [2023/04] العوامل التوليدية: simulacra التفاعلية للسلوك البشري. جون سونغ بارك (جامعة ستانفورد) وآخرون. arxiv. [ورقة] [رمز]

- [2023/04] تطلق سعة إدخال الطول غير المحدودة لنماذج اللغة على نطاق واسع مع نظام الذاكرة الذي يتم التحكم فيه ذاتيًا. شينيان ليانغ (جامعة بيهانغ) وآخرون. arxiv. [ورقة] [رمز]

- [2023/03] رد الفعل: عوامل اللغة مع التعلم التعزيز اللفظي. نوح شين (الجامعة الشمالية الشرقية) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] متكرر: توليد تفاعلي من النص الطويل (التعسفي). Wangchunshu Zhou (Aiwaves) et al. arxiv. [ورقة] [رمز]

ضغط الذكريات مع المتجهات أو هياكل البيانات

- [2023/07] وكلاء التواصل لتطوير البرمجيات. تشن تشيان (جامعة تسينغهوا) وآخرون. arxiv. [ورقة] [رمز]

- [2023/06] ChatDB: زيادة LLMs مع قواعد البيانات كذاكرة رمزية لها. Chenxu Hu (جامعة Tsinghua) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] Ghost in the Minecraft: عمومًا عوامل قادرة على البيئات المفتوحة عبر نماذج لغة كبيرة مع المعرفة والذاكرة المستندة إلى النص. Xizhou Zhu (جامعة Tsinghua) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] RET-LLM: نحو ذاكرة عامة للقراءة والكتابة لنماذج اللغة الكبيرة. علي مودرريس (LMU ميونيخ) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] متكرر: توليد تفاعلي من النص الطويل (التعسفي). Wangchunshu Zhou (Aiwaves) et al. arxiv. [ورقة] [رمز]

استرجاع الذاكرة

- [2023/08] صندوق رمل الذاكرة: إدارة الذاكرة الشفافة والتفاعلية لعوامل المحادثة. Ziheng Huang (جامعة كاليفورنيا - San Diego) وآخرون. arxiv. [ورق]

- [2023/08] الموكب: صندوق رمل مفتوح المصدر لتقييم نموذج اللغة الكبير. Jiaju Lin (PTA Studio) et al. arxiv. [ورقة] [صفحة المشروع] [رمز]

- [2023/06] ChatDB: زيادة LLMs مع قواعد البيانات كذاكرة رمزية لها. Chenxu Hu (جامعة Tsinghua) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] MemoryBank: تعزيز نماذج لغة كبيرة مع ذاكرة طويلة الأجل. وانجون تشونغ (معهد هاربين للتكنولوجيا) وآخرون. arxiv. [ورقة] [رمز]

- [2023/04] العوامل التوليدية: simulacra التفاعلية للسلوك البشري. جون سونغ بارك (ستانفورد) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] متكرر: توليد تفاعلي من النص الطويل (التعسفي). Wangchunshu Zhou (Aiwaves) et al. arxiv. [ورقة] [رمز]

1.1.4 التفكير والتخطيط

التفكير

[2024/02] تدريب نماذج لغة كبيرة للتفكير من خلال التعلم العكسي لتعزيز المناهج الدراسية. Zhiheng XI (جامعة فودان) وآخرون. arxiv. [ورقة] [رمز]

[2023/09] التوفيق: يحسن مؤتمر الطاولة المستديرة التفكير من خلال الإجماع بين LLMs المتنوعة. جاستن تشيه ياو تشن (جامعة نورث كارولينا في تشابل هيل) وآخرون. arxiv. [ورقة] [رمز]

[2023/05] polish الذاتي: تعزيز التفكير في نماذج اللغة الكبيرة من خلال تحسين المشكلة. Zhiheng XI (جامعة فودان) وآخرون. arxiv. [ورقة] [رمز]

[2023-03] نماذج لغة كبيرة هي أسباب صفرية. تاكيشي كوجيما (جامعة طوكيو) وآخرون. arxiv. [ورقة] [رمز]

[2023/03] الإنقاذ الذاتي: التحسين التكراري مع التراجع الذاتي. أمان ماداان (جامعة كارنيجي ميلون) وآخرون. arxiv. [ورقة] [رمز]

[2022/05] الاختيار: استغلال نماذج اللغة الكبيرة للتفسير المنطقي القابل للتفسير. أنطونيا كريسويل (DeepMind) وآخرون. arxiv. [ورق]

[2022/03] يعمل التوافق الذاتي على تحسين سلسلة التفكير في نماذج اللغة. Xuezhi Wang (Google Research) et al. arxiv. [ورقة] [رمز]

[2023/02] تفكير سلسلة الوسائط المتعددة في نماذج اللغة. Zhuosheng Zhang (جامعة شنغهاي جياو تونغ) وآخرون. arxiv. [ورقة] [رمز]

[2022/01] تثير سلسلة من الفكر في نماذج اللغة الكبيرة. Jason Wei (Google Research) et al. arxiv. [ورق]

تخطيط

صياغة خطة

- [2023/11] Jarvis-1: عوامل متعددة المهام في العالم المفتوح مع نماذج لغة متعددة الوسائط ذات الذاكرة. Zihao Wang (جامعة بكين) وآخرون. arxiv. [ورقة] [رمز]

- [2023/10] يوحد البحث عن شجرة وكيل اللغة المنطق التمثيل والتخطيط في نماذج اللغة. آندي تشو (جامعة إلينوي أوربانا شامبين) وآخرون. arxiv. [ورقة] [صفحة المشروع] [رمز]

- [2023/05] شجرة الأفكار: حل المشكلات المتعمدة مع نماذج اللغة الكبيرة. شونيو ياو (جامعة برينستون) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] خطة ، القضاء ، وتتبع النماذج اللغوية هي معلمين جيدين للعوامل المجسدة. يو وو (جامعة كارنيجي ميلون) وآخرون. arxiv. [ورق]

- [2023/05] المنطق مع نموذج اللغة هو التخطيط مع نموذج العالم. Shibo Hao (UC San Diego) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] swiftsage: عامل توليدي مع تفكير سريع وبطيء للمهام التفاعلية المعقدة. بيل يوشن لين (معهد ألين للذكاء الاصطناعي) وآخرون. arxiv. [ورقة] [رمز]

- [2023/04] LLM+P: تمكين نماذج اللغة الكبيرة ذات الكفاءة المثلى للتخطيط. بو ليو (جامعة تكساس في أوستن) وآخرون. arxiv. [ورقة] [رمز]

- [2023/03] HuggingGpt: حل مهام الذكاء الاصطناعي مع ChatGpt وأصدقائها في وجه المعانقة. Yongliang Shen (Microsoft Research Asia) et al. arxiv. [ورقة] [رمز]

- [2023/02] وصف وشرح وتخطيط واختيار: التخطيط التفاعلي مع نماذج اللغة الكبيرة يتيح عوامل متعددة المهام في العالم المفتوح. Zihao Wang (جامعة بكين) وآخرون. arxiv. [ورقة] [رمز]

- [2022/05] يمكّن أقل من ذلك من خلال التطورات المعقدة في نماذج اللغة الكبيرة. Denny Zhou (Google Research) et al. arxiv. [ورق]

- [2022/05] أنظمة MRKL: بنية متجانسة وعصبية تجمع بين نماذج اللغة الكبيرة ومصادر المعرفة الخارجية والتفكير المنفصل. ehud karpas (AI21 Labs) et al. arxiv. [ورق]

- [2022/04] افعل ما أستطيع ، وليس كما أقول: لغة التأريض في المعادلة الآلية. مايكل آهن (الروبوتات في Google) وآخرون. arxiv. [ورق]

- [2023/05] الوكلاء: إطار عمل مفتوح المصدر لوكلاء اللغة المستقلة. Wangchunshu Zhou (Aiwaves) et al. arxiv. [ورقة] [رمز]

- [2022/12] لا تنشئ ، تمييز: اقتراح لنماذج لغة التأريض للبيئات في العالم الحقيقي. يو جو (جامعة ولاية أوهايو) وآخرون. ACL. [ورقة] [رمز]

خطة انعكاس

- [2024/02] Agent-Pro: تعلم التطور عبر انعكاس على مستوى السياسة والتحسين Wenqi Zhang (جامعة Zhejiang) وآخرون. arxiv. [ورقة] [رمز]

- [2024/01] التبادل الذاتي: انعكاس أفضل من خلال منظور حل غير متناسق وينكي تشانغ (جامعة تشجيانغ) وآخرون. arxiv. [ورق]

- [2023/11] Jarvis-1: عوامل متعددة المهام في العالم المفتوح مع نماذج لغة متعددة الوسائط ذات الذاكرة. Zihao Wang (جامعة بكين) وآخرون. arxiv. [ورقة] [رمز]

- [2023/10] يقلل سلسلة التكسير الهلوسة في نماذج اللغة الكبيرة. Shehzaad Dhuliawala (Meta AI & eth zu ̈rich) et al. arxiv. [ورق]

- [2023/10] Firect: نحو صقل وكيل اللغة. Baian Chen (System2 Research) et al. arxiv. [ورقة] [صفحة المشروع] [رمز] [مجموعة البيانات]

- [2023/08] SelfCheck: باستخدام LLMS إلى صفوف ، تحقق من التفكير في خطوة بخطوة. نينغ مياو (جامعة أكسفورد) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] Chatcot: سلسلة من الأدوات المنطقية الفكر في نماذج اللغة الكبيرة القائمة على الدردشة. Zhipeng Chen (جامعة رينمين في الصين) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] Voyager: عامل مجسد مفتوح مع نماذج لغة كبيرة. Guanzhi Wang (Nvidia) et al. arxiv. [ورقة] [صفحة المشروع] [رمز]

- [2023/03] الدردشة مع البيئة: التصور التفاعلي متعدد الوسائط باستخدام نماذج لغة كبيرة. Xufeng Zhao (جامعة هامبورغ) وآخرون. arxiv. [ورقة] [رمز]

- [2022/12] LLM-Planner: تخطيط قليلة على الأرض للعوامل المجسدة مع نماذج لغة كبيرة. تشان هي سونغ (جامعة ولاية أوهايو) وآخرون. arxiv. [ورقة] [رمز]

- [2022/10] رد فعل: تآزر التفكير والتمثيل في نماذج اللغة. شونيو ياو (جامعة برينستون) وآخرون. arxiv. [ورقة] [رمز]

- [2022/07] المونولوج الداخلي: تجسيد التفكير من خلال التخطيط مع نماذج اللغة. Wenlong Huang (Robotics at Google) et al. arxiv. [ورقة] [رمز]

- [2021/10] سلاسل الذكاء الاصطناعى: تفاعل الإنسان الشفاف الذي يمكن التحكم فيه عن طريق تخصيص مطالبات نموذج لغة كبيرة. Tongshuang Wu (جامعة واشنطن) وآخرون. arxiv. [ورق]

1.1.5 قابلية النقل والتعميم

تعميم المهام غير المرئي

- [2024/06] Agentgym: تطور العوامل القائمة على نموذج اللغة الكبيرة عبر بيئات متنوعة. Zhiheng XI (جامعة فودان) وآخرون. arxiv. [ورقة] [صفحة المشروع] [الرموز والمنصة] [Dataset] [المعيار] [النموذج].

- [2023/10] AgentTuning: تمكين قدرات الوكيل المعممة لـ LLMS. Aohan Zeng (University Tsinghua) وآخرون. arxiv. [ورقة] [صفحة المشروع] [رمز] [مجموعة البيانات]

- [2023/10] Lemur: تنسيق اللغة الطبيعية ورمز لوكلاء اللغة Yiheng Xu (جامعة هونغ كونغ) وآخرون. arxiv. [ورقة] [رمز]

- [2023/05] نماذج لغة التدريب لمتابعة التعليمات مع التعليقات البشرية. Long Ouyang et al. العصبية. [ورق]

- EndRuctGPT: مواءمة نماذج اللغة مع نية المستخدم على مجموعة واسعة من المهام من خلال صقل التعليقات البشرية.

- [2023/01] تمكين التدريب المتعدد المهام التي تتيح تعميم المهمة صفرية. فيكتور سانه وآخرون. ICLR. [ورقة] [رمز]

- T0: T0 هو نموذج ترميز التشفير الذي يستهلك المدخلات النصية وينتج استجابات مستهدفة. يتم تدريبه على مزيج متعدد المهام من مجموعات بيانات NLP المقسمة إلى مهام مختلفة.

- [2022/10] نماذج لغة تعليمات التوسع. فاز هيونغ تشونغ وآخرون. arxiv. [ورقة] [رمز]

- يستكشف هذا العمل تعليمات التعليم مع التركيز بشكل خاص على توسيع عدد المهام وحجم النموذج ، مما يحسن الأداء في مجموعة متنوعة من فئات النماذج ، مما يثير الإعدادات ، ومعايير التقييم.

- [2022/08] نماذج اللغة المحببة هي متعلمين صفري. جيسون وي وآخرون. ICLR. [ورق]

- فلان: ضبط التعليمات بشكل كبير يحسن الأداء الصفري على المهام غير المرئية.

التعلم داخل السياق

- [2023/08] تتحدث الصور في الصور: رسام عام للتعلم البصري داخل السياق. Xinlong Wang et al. IEEE. [ورقة] [رمز]

- الرسام: يقدم هذا العمل نموذجًا عامًا للتعلم المرئي داخل السياق مع حل "صورة".

- [2023/08] نماذج لغة الترميز العصبي هي نص صفري إلى توليفات الكلام. Chengyi Wang et al. arxiv. [ورقة] [رمز]

- VALL-E: يدرب هذا العمل نموذج لغة برامج الترميز العصبية ، والذي يظهر إمكانيات التعلم في السياق.

- [2023/07] دراسة استقصائية للتعلم داخل السياق. Qingxiu Dong et al. arxiv. [ورق]

- يلخص هذا الاستطلاع التقدم والتحديات في التعلم في السياق (ICL).

- [2023/05] نماذج اللغات هي متعلمين قليلة. توم براون (Openai) وآخرون. العصبية. [ورق]

- GPT-3: تحسن توسيع نطاق نماذج اللغة بشكل كبير من الأداء العادن للمهمة ، وقليل من اللقطة ، وأحيانًا يصبح تنافسيًا مع أساليب الضبط المسبقة السابقة.

التعلم المستمر

- [2023/11] Jarvis-1: عوامل متعددة المهام في العالم المفتوح مع نماذج لغة متعددة الوسائط ذات الذاكرة. Zihao Wang (جامعة بكين) وآخرون. arxiv. [ورقة] [رمز]

- [2023/07] المطالبات التقدمية: التعلم المستمر لنماذج اللغة. Razdaibiedina وآخرون. arxiv. [ورق]

- يقدم هذا العمل مطالبات تقدمية ، والتي تتيح النقل إلى الأمام ويقاوم النسيان الكارثي ، دون الاعتماد على إعادة تشغيل البيانات أو عدد كبير من المعلمات الخاصة بالمهمة.

- [2023/05] Voyager: عامل مجسد مفتوح مع نماذج لغة كبيرة. Guanzhi Wang (Nvidia) et al. arxiv. [ورقة] [صفحة المشروع] [رمز]

- Voyager: هذا مثال على وكيل التعلم المجسّد الذي يعمل به LLM في Minecraft والذي يستكشف باستمرار العالم ، ويحصل على مهارات متنوعة ، ويقوم باكتشافات جديدة دون تدخل بشري.

- [2023/01] مسح شامل للتعلم المستمر: النظرية والطريقة والتطبيق. Liyuan Wang et al. arxiv. [ورق]

- يقدم هذا الاستطلاع دراسة استقصائية شاملة للتعلم المستمر ، وتسعى إلى سد الإعدادات الأساسية ، والمؤسسات النظرية ، والأساليب التمثيلية ، والتطبيقات العملية.

- [2022/11] التعلم المستمر لمهام معالجة اللغة الطبيعية: مسح. Zixuan Ke et al. arxiv. [ورق]

- يقدم هذا المسح مراجعة وتحليلًا شاملين للتقدم الأخير لـ CL في NLP.

1.2 الإدراك: مدخلات متعددة الوسائط للعوامل المستندة إلى LLM

1.2.1 بصرية

- [2024/01] Agent AI: مسح آفاق التفاعل متعدد الوسائط. Zane Durante et al. arxiv. [ورق]

- [2023/10] نحو اتخاذ القرارات المتجسدة من طرف إلى النهاية من خلال نموذج اللغة الكبيرة متعددة الوسائط: الاستكشافات مع GPT4-Vision وخارج Liang Chen et al. arxiv. [ورقة] [رمز]

- [2023/05] اللغة ليست كل ما تحتاجه: مواءمة الإدراك مع نماذج اللغة. شوهان هوانغ وآخرون. arxiv. [ورق]

- [2023/05] instructBlip: نحو نماذج لغة الرؤية للأغراض العامة مع ضبط التعليمات. وينليانغ داي وآخرون. arxiv. [ورق]

- [2023/05] GPT متعدد الوسائط: نموذج رؤية ولغة للحوار مع البشر. تاو غونغ وآخرون. arxiv. [ورق]

- [2023/05] Pandagpt: نموذج واحد للتعليم يتبعهم جميعًا. Yixuan Su et al. arxiv. [ورق]

- [2023/04] ضبط التعليمات البصرية. هاوتيان ليو وآخرون. arxiv. [ورق]

- [2023/04] MINIGPT-4: تعزيز فهم لغة الرؤية مع نماذج اللغة الكبيرة المتقدمة. دياو تشو. arxiv. [ورق]

- [2023/01] BLIP-2: تمهيد اللغات-صورة ما قبل التدريب مع تشفير الصور المجمدة ونماذج اللغة الكبيرة. جونان لي وآخرون. arxiv. [ورق]

- [2022/04] Flamingo: نموذج لغة مرئية للتعلم قليلًا. جان بابتيست Alayrac et al. arxiv. [ورق]

- [2021/10] MobileVit: محول الرؤية الخفيفة والخفيفة والأغراض العامة والصديق للهاتف المحمول. ساشين ميهتا وآخرون. [ورق]

- [2021/05] MLP-Mixer: بنية All-MLP للرؤية. إيليا تولستخين وآخرون. [ورق]

- [2020/10] تستحق الصورة 16 × 16 الكلمات: محولات للتعرف على الصور على نطاق واسع. Alexey Dosovitskiy et al. arxiv. [ورق]

- [2017/11] التعلم التمثيل المنفصل العصبي. آرون فان دن أوورد وآخرون. arxiv. [ورق]

1.2.2 الصوت

- [2023/06] فيديو-لاما: نموذج لغة صوتية ومرئية لتصنيف تعليمات لفهم الفيديو. شنق Zhang et al. arxiv. [ورق]

- [2023/05] X-LLM: Bootstrapping نماذج لغة كبيرة متطورة من خلال التعامل مع التعددية المتعددة كلغات أجنبية. Feilong Chen et al. arxiv. [ورق]

- [2023/05] Interngpt: حل المهام التي تركز على الرؤية من خلال التفاعل مع ChatGPT وراء اللغة. Zhaoyang Liu et al. arxiv. [ورق]

- [2023/04] Audiogpt: فهم وتوليد الكلام والموسيقى والصوت ورأس الحديث. رونغجي هوانغ وآخرون. arxiv. [ورق]

- [2023/03] HuggingGpt: حل مهام الذكاء الاصطناعي مع ChatGpt وأصدقائها في وجه المعانقة. Yongliang Shen et al. arxiv. [ورق]

- [2021/06] Hubert: تمثيل الكلام الخاضع للإشراف على التعلم من خلال التنبؤ المقنع للوحدات المخفية. Wei-Gening Hsu et al. arxiv. [ورق]

- [2021/04] AST: محول طيف الصوت. يوان غونغ وآخرون. arxiv. [ورق]

1.3 الإجراء: قم بتوسيع مساحة عمل الوكلاء المستندة إلى LLM

1.3.1 أداة باستخدام

- [2024/02] نحو وكيل لغة عدم اليقين. Jiuzhou Han (جامعة موناش) وآخرون. arxiv. [ورقة] [صفحة المشروع] [رمز]

- [2023/10] Openagents: منصة مفتوحة لوكلاء اللغة في البرية. Xlang Lab (جامعة هونغ كونغ) Arxiv. [ورقة] [صفحة المشروع] [رمز] [العرض التوضيحي]

- [2023/10] Lemur: تنسيق اللغة الطبيعية ورمز لوكلاء اللغة Yiheng Xu (جامعة هونغ كونغ) وآخرون. arxiv. [ورقة] [رمز]

- [2023/10] نحو اتخاذ القرارات المتجسدة من طرف إلى النهاية من خلال نموذج اللغة الكبيرة متعددة الوسائط: الاستكشافات مع GPT4-Vision وخارج Liang Chen (جامعة بكين) وآخرون. arxiv. [ورقة] [رمز]

- Holmes هو إطار تعاون متعدد الوكلاء يسمح LLMs بالاستفادة من MLLMs و APIs لجمع معلومات متعددة الوسائط لاتخاذ القرارات المستنيرة.

- [2023/07] TOOLLLM: تسهيل نماذج اللغة الكبيرة لإتقان 16000+ واجهات برمجة التطبيقات في العالم الحقيقي. يوجيا تشين (جامعة تسينغهوا) وآخرون. arxiv. [ورقة] [رمز] [مجموعة البيانات]

- TOLLLM هو إطار عام لاستخدام الأدوات يشمل بناء البيانات والتدريب والتقييم.

- [2023/05] نماذج لغة كبيرة مثل صانعي الأدوات. تيانلي كاي (جامعة برينستون) وآخرون. arxiv. [ورقة] [رمز]

- LATM هو إطار حلقة مغلقة يتخذ خطوة أولية نحو إزالة الاعتماد على توافر الأدوات الموجودة.

- [2023/05] المبدع: تفكيك الأسباب المجردة والملموسة لنماذج اللغة الكبيرة من خلال إنشاء الأدوات. تشنغ تشيان (جامعة تسينغهوا) وآخرون. arxiv. [ورق]

- Creator هو إطار جديد يمكّن LLMS من إنشاء أدواته الخاصة من خلال الوثائق وتحقيق الكود.

- [2023/04] أدوات تعلم مع نماذج الأساس. يوجيا تشين (جامعة تسينغهوا) وآخرون. arxiv. [ورقة] [رمز]

- يقدم هذا الاستطلاع في المقام الأول نموذجًا جديدًا يسمى "تعلم الأدوات على أساس النماذج الأساسية" ، والذي يجمع بين مزايا الأدوات المتخصصة والنماذج الأساسية ، وتحقيق الدقة العالية والكفاءة والأتمتة في حل المشكلات.

- [2023/04] Chemcrow: زيادة النماذج ذات اللغة الكبيرة مع أدوات الكيمياء. Andres M Bran (مختبر الذكاء الكيميائي الاصطناعي ، ISIC ، EPFL) وآخرون. arxiv. [ورقة] [رمز]

- ChemCrow هو عامل كيمياء LLM يدمج 13 أداة مصممة من الخبراء ويزيد من أداء LLM في الكيمياء ويظهر قدرات جديدة.

- [2023/04] Genegpt: زيادة نماذج اللغة الكبيرة مع أدوات المجال لتحسين الوصول إلى المعلومات الطبية الحيوية. تشياو جين (المعاهد الوطنية للصحة) ، ييفان يانغ ، تشينغو تشن ، تشايونج لو. arxiv. [ورقة] [رمز]

- Genegpt هو نموذج يجيب على أسئلة الجينوم. يقدم طريقة جديدة للتعامل مع التحديات مع الهلوسة من خلال تدريس LLMs لاستخدام واجهات برمجة التطبيقات على الويب.

- [2023/04] Openagi: عندما تلتقي LLM خبراء المجال. Yingqiang GE (جامعة روتجرز) وآخرون. arxiv. [ورقة] [رمز]

- Openagi هي منصة أبحاث AGI مفتوحة المصدر. يقدم نموذجًا من LLMs لتشغيل نماذج خبراء مختلفة لحل المهام المعقدة ويقترح آلية RLTF لتحسين قدرة حل المهام LLM.

- [2023/03] HuggingGpt: حل مهام الذكاء الاصطناعي مع ChatGpt وأصدقائها في وجه المعانقة. يونغليانغ شين (جامعة تشجيانغ) وآخرون. arxiv. [ورقة] [رمز]

- Hugginggpt هو نظام يستفيد من LLMs لتوصيل نماذج الذكاء الاصطناعي المختلفة والمتعددة الوسائط في مجتمعات التعلم الآلي لحل مهام الذكاء الاصطناعي.

- [2023/03] chatgpt البصرية: الحديث ، الرسم والتحرير مع نماذج الأساس المرئي. Chenfei Wu (Microsoft Research Asia) et al. arxiv. [ورقة] [رمز]

- Visual ChatGPT هو نظام يفتح الباب للتحقيق في الأدوار المرئية لـ ChatGPT بمساعدة نماذج الأساس المرئي.

- [2023/02] نماذج اللغة المعززة: مسح. Grégoire Mialon (Meta AI) et al. TMLR. [ورق]

- تعمل هذه المسحات التي يتم فيها زيادة LMS مع القدرة على استخدام الأدوات. يمكن أن تستخدم LMS المعززة الوحدات الخارجية لتوسيع قدرتها على معالجة السياق.

- [2023/02] Toolformer: يمكن أن تعلّم نماذج اللغة نفسها استخدام الأدوات. تيمو شيك (ميتا AI) وآخرون. arxiv. [ورق]

- يوضح Toolformer أن LLMs يمكن أن يعلم نفسها استخدام أدوات خارجية مع حفنة من العروض التوضيحية لكل واجهة برمجة تطبيقات.

- [2022/05] TALM: نماذج اللغة المعززة للأداة. آرون باريسي (جوجل) وآخرون. arxiv. [ورق]

- يقدم Talm طريقة تجمع بين الأدوات غير المتمايزة مع LMS ، مما يتيح النموذج من الوصول إلى البيانات في الوقت الفعلي أو الخاص.

- [2022/05] أنظمة MRKL: بنية متجانسة وعصبية تجمع بين نماذج اللغة الكبيرة ومصادر المعرفة الخارجية والتفكير المنفصل. ehud karpas (AI21 Labs) et al. arxiv. [ورق]

- تعزز أنظمة MRKL LLMs مع مجموعة سهلة التوسيع من المعرفة الخارجية والوحدات النمطية.

- [2022/04] افعل ما أستطيع ، وليس كما أقول: لغة التأريض في المعادلة الآلية. مايكل آهن (جوجل) وآخرون. كورل. [ورق]

- يطبق Saycan LMS في المهام الآلية في العالم الحقيقي من خلال الجمع بين المعرفة الدلالية المتقدمة من LLMs مع وظيفة القيمة للمهارات التي تم تدريبها مسبقًا.

- [2021/12] WebGPT: استعراض أسئلة بمساعدة المتصفح مع ردود الفعل البشرية. Reiichiro Nakano (Openai) et al. arxiv. [ورق]

- WebGPT الإجابة على الأسئلة باستخدام بيئة WebBrowsing. يستخدم التعلم المقلد أثناء التدريب ثم يحسن جودة الإجابة من خلال التعليقات البشرية.

- [2021/07] تقييم نماذج اللغة الكبيرة المدربة على الكود. مارك تشن (Openai) وآخرون. arxiv. [ورقة] [رمز]

- يمكن لـ Codex تجميع البرامج من DocStrings ، أي إنشاء أدوات بناءً على الوثائق.

1.3.2 عمل تجسيد

- [2023/12] نحو تعلم نموذج العمومي للملاحة المجسدة. الثنائي تشنغ (الجامعة الصينية في هونغ كونغ) وآخرون. arxiv. [ورقة] [رمز]

- [2023/11] عميل عامة مجسدة في العالم ثلاثي الأبعاد. Jiangyong Huang (Bigai & Peking University) et al. arxiv. [ورقة] [صفحة المشروع]

- [2023/11] Jarvis-1: عوامل متعددة المهام في العالم المفتوح مع نماذج لغة متعددة الوسائط ذات الذاكرة. Zihao Wang (جامعة بكين) وآخرون. arxiv. [ورقة] [رمز]

- [2023/10] Lemur: تنسيق اللغة الطبيعية ورمز لوكلاء اللغة Yiheng Xu (جامعة هونغ كونغ) وآخرون. arxiv. [ورقة] [رمز]

- [2023/10] Towards End-to-End Embodied Decision Making via Multi-modal Large Language Model: Explorations with GPT4-Vision and Beyond Liang Chen et al. arXiv. [paper] [code]

- [2023/07] Interactive language: Talking to robots in real time. Corey Lynch et al. IEEE (RAL) [paper]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [ورق]

- [2023/05] EmbodiedGPT: Vision-Language Pre-Training via Embodied Chain of Thought. Yao Mu et al. Arxiv [paper] [code]

- [2023/05] NavGPT: Explicit Reasoning in Vision-and-Language Navigation with Large Language Models. Gengze Zhou et al. Arxiv [paper]

- [2023/05] AlphaBlock: Embodied Finetuning for Vision-Language Reasoning in Robot Manipulation. Chuhao Jin et al. Arxiv [paper]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess et al. Arxiv. [ورق]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn et al. Arxiv [paper] [code]

- [2023/02] Collaborating with language models for embodied reasoning. Ishita Dasgupta et al. Arxiv. [ورق]

- [2023/02] Code as Policies: Language Model Programs for Embodied Control. Jacky Liang et al. IEEE (ICRA). [ورق]

- [2022/10] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao et al. Arxiv [paper] [code]

- [2022/10] Instruction-Following Agents with Multimodal Transformer. Hao Liu et al. CVPR [paper] [code]

- [2022/07] Inner Monologue: Embodied Reasoning through Planning with Language Models. Wenlong Huang et al. Arxiv. [ورق]

- [2022/07] LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action. Dhruv Shahet al. CoRL [paper] [code]

- [2022/04] Do As I Can, Not As I Say: Grounding Language in Robotic Affordances. Michael Ahn et al. Arxiv. [ورق]

- [2022/01] A Survey of Embodied AI: From Simulators to Research Tasks. Jiafei Duan et al. IEEE (TETCI). [ورق]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [paper] [code]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [ورق]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [ورق]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arXiv. [paper] [code]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arXiv. [ورق]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [paper] [code]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arXiv. [paper] [code]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [ورق]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [paper] [code]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [paper] [code]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [ورق]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [ورق]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [ورق]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [ورق]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [ورق]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [paper] [code]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [paper] [code]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [ورق]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [ورق]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [ورق]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [ورق]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [ورق]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [paper] [code]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [paper] [code]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [paper] [code]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [paper] [code]

2.2 Coordinating Potential of Multiple Agents

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [paper] [code]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [paper] [code]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [ورق]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [ورق]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [paper] [code]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [paper] [code]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [ورق]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [paper] [code]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [paper] [code]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [paper] [code]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [ورق]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [paper] [code]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [ورق]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [paper] [code]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [paper] [code]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [ورق]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [paper] [code]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [paper] [code]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [paper] [code]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [ورق]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [paper] [code]

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

تعليم

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [ورق]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [ورق]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

صحة

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [paper] [code]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [ورق]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [ورق]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [ورق]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [ورق]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [ورق]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [ورق]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [ورق]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [ورق]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [paper] [code]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [paper] [code]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [ورق]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [ورق]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [ورق]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [ورق]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [ورق]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al. علوم. [ورق]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [ورق]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [paper] [code]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [paper] [code]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [ورق]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [paper] [code]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [paper] [code]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [ورق]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [ورق]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [paper] [code]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [paper] [code]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [paper] [code]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [paper] [code]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [paper] [code]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [paper] [code]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [ورق]

3.1.2 Personality

Cognition

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [ورق]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [ورق]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [ورق]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [ورق]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [ورق]

Emotion

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [ورق]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [ورق]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [ورق]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [ورق]

شخصية

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [paper] [code]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [paper] [code]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [paper] [code]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [paper] [code]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [ورق]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [ورق]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [paper] [code]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [paper] [code]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [ورق]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [paper] [code]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [paper] [code]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [paper] [code]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [paper] [code]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [paper] [code]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [ورق]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [paper] [code]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [paper] [code]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [ورق]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [paper] [code]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [ورق]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [paper] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [paper] [code]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [ورق]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [paper] [code]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [paper] [code]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [paper] [code]

اقتباس

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

اتصال

تاريخ النجوم