El aumento y el potencial de los agentes basados en modelos de idiomas grandes: una encuesta

Documentos de lectura imprescindible para agentes basados en LLM.

? Próximamente: agregue una introducción de una oración a cada papel.

? Noticias

- ☄️ [2024/06/07] ¡Se ha lanzado el agente de agente para desarrollar y evolucionar agentes basados en LLM en diversos entornos!

- Documento: Agentgym.

- Página del proyecto: https://agentgym.github.io/.

- Códigos: plataforma e implementaciones.

- Recursos de Huggingface: Agenttraj-L, Agenteval, Agentevol-7b.

- ? [2024/05/02] R3 (capacitación de modelos de idiomas grandes para el razonamiento a través del aprendizaje de refuerzo del plan de estudios inverso) fue aceptado por ICML 2024!

- ? [2024/02/08] ¡Se ha lanzado un nuevo documento R3 en RL para el razonamiento del agente LLM! Documento: capacitación de modelos de idiomas grandes para el razonamiento a través del aprendizaje de refuerzo del plan de estudios inverso. Códigos: LLM-Reverse-Curriculum-RL.

- ? [2023/09/20] ¡Este proyecto ha sido incluido en las tendencias de GitHub! ¡Es un gran honor!

- ? [2023/09/15] ¡Nuestra encuesta se publica! Vea el aumento y el potencial de los agentes basados en modelos de idiomas grandes: ¡una encuesta para el documento!

- [2023/09/14] Creamos este repositorio para mantener una lista de documentos sobre los agentes basados en LLM. ¡Más documentos llegarán pronto!

? Introducción

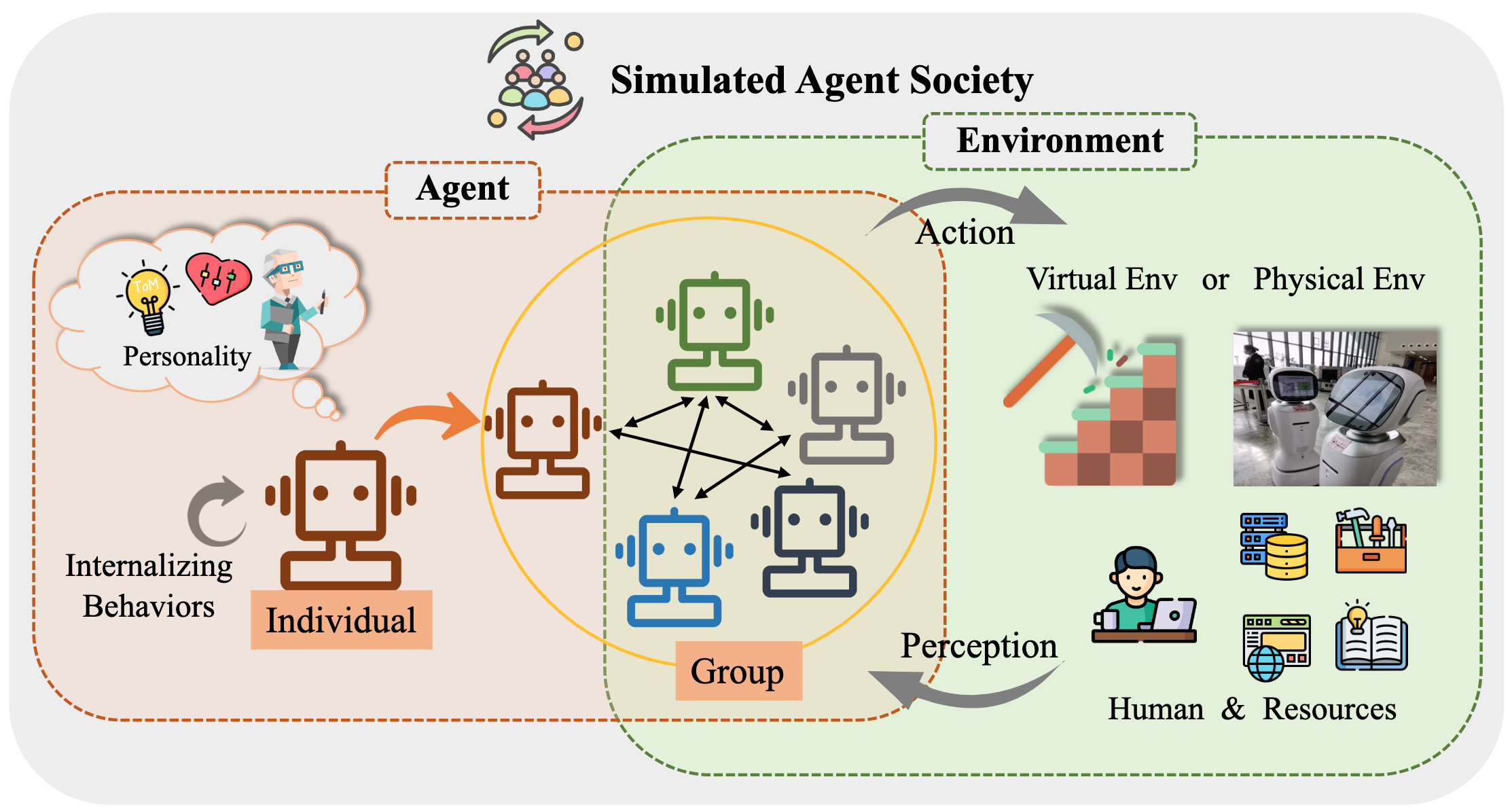

Durante mucho tiempo, la humanidad ha seguido la inteligencia artificial (IA) equivalente o superando el nivel humano, con agentes de IA considerados como un vehículo prometedor de esta búsqueda. Los agentes de IA son entidades artificiales que sienten su entorno, toman decisiones y toman medidas.

Debido a las capacidades versátiles y notables que demuestran, los modelos de idiomas grandes (LLM) se consideran posibles chispas para la inteligencia general artificial (AGI), ofreciendo esperanza para construir agentes generales de IA. Muchos esfuerzos de investigación han aprovechado los LLM como la base para construir agentes de IA y han logrado un progreso significativo.

En este repositorio, proporcionamos una encuesta sistemática e integral sobre agentes basados en LLM, y enumeramos algunos artículos de lectura obligada.

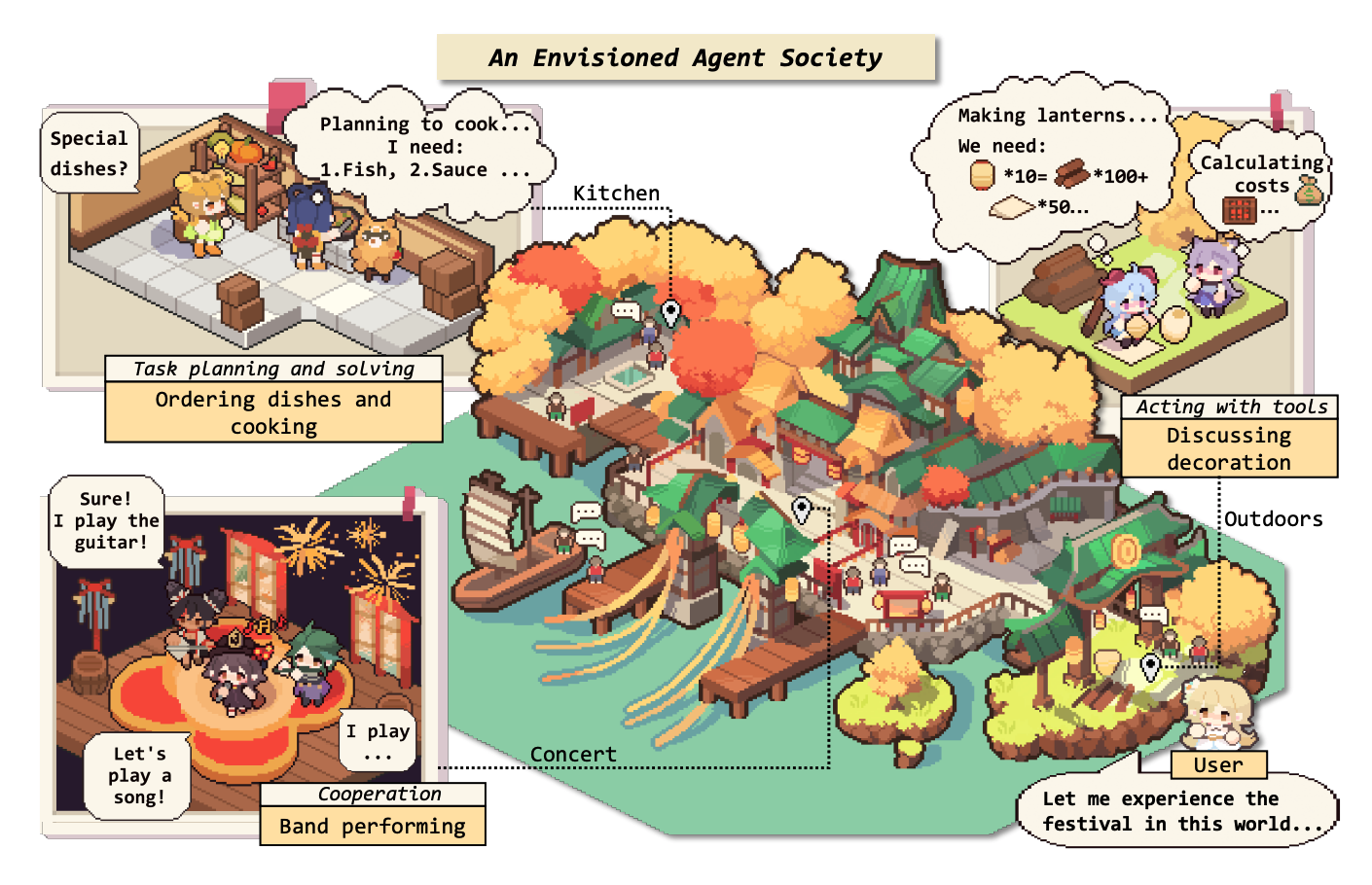

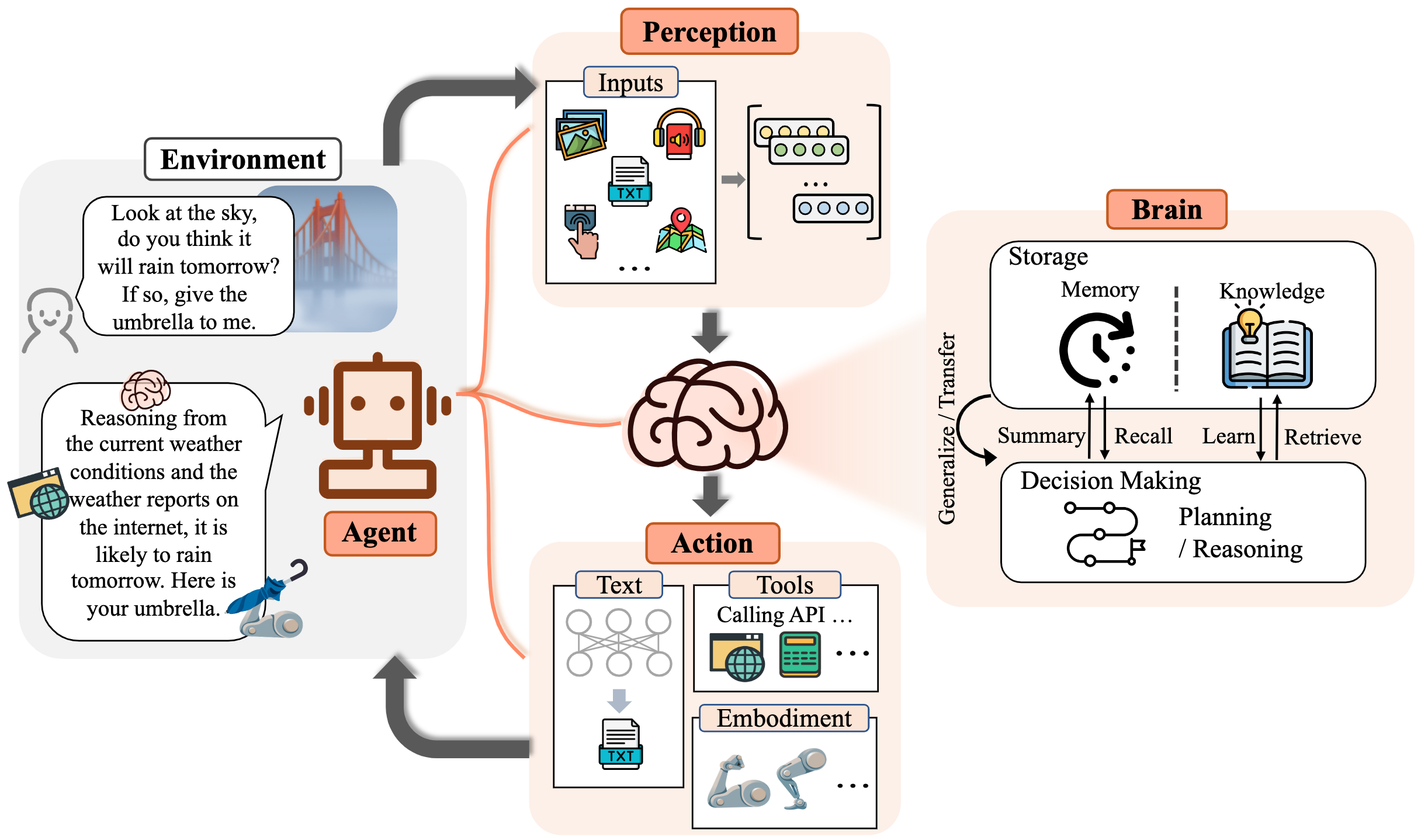

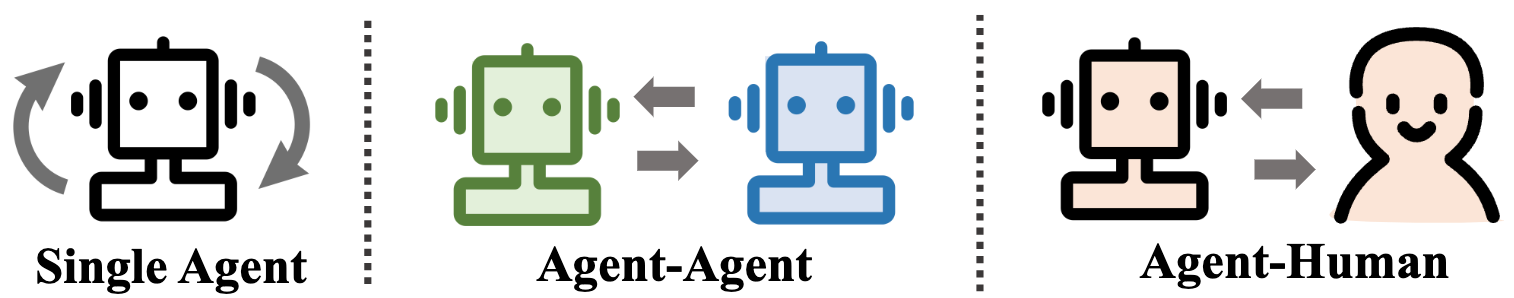

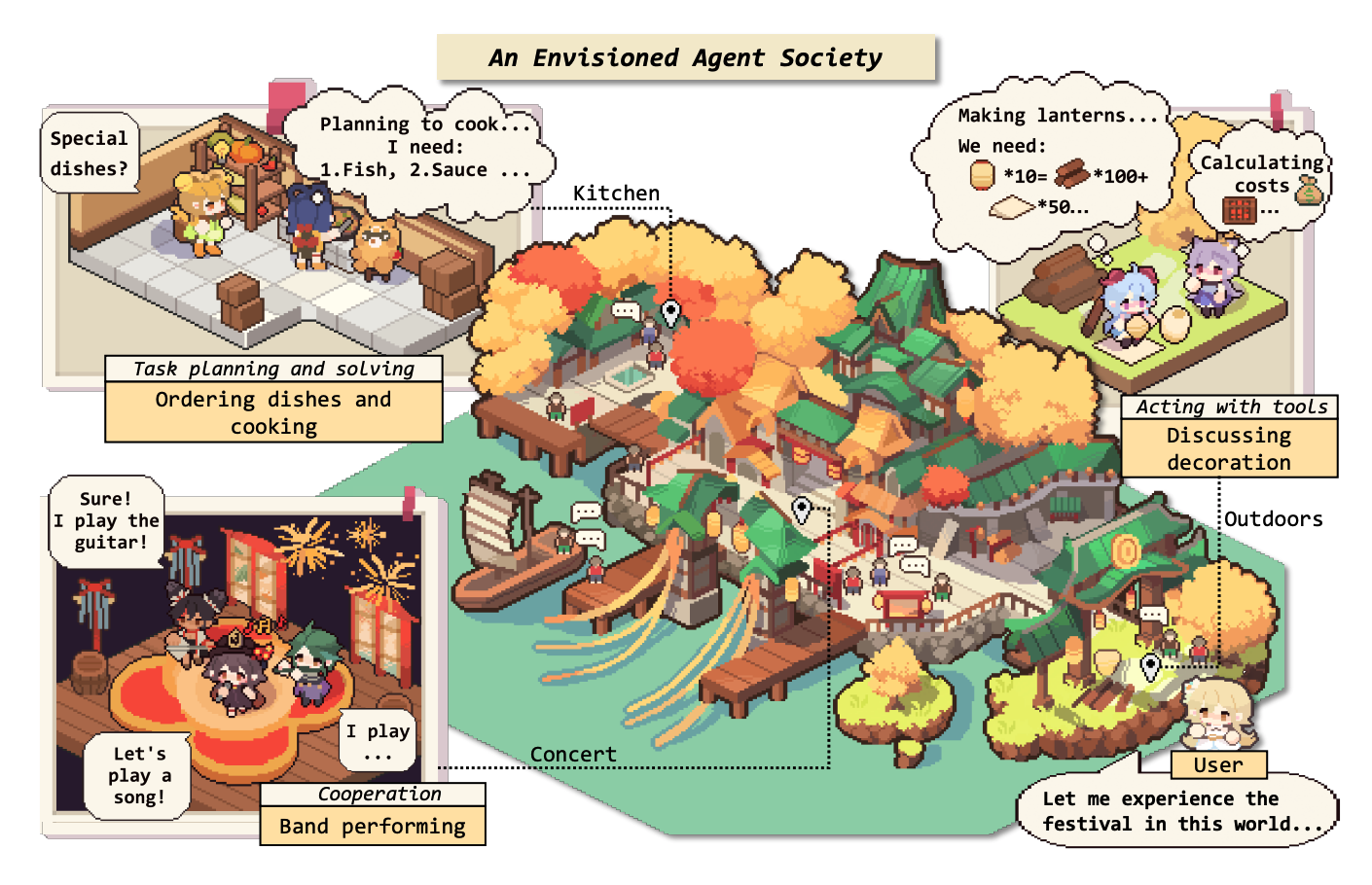

Específicamente, comenzamos por el marco conceptual general para los agentes basados en LLM: que comprende tres componentes principales: cerebro, percepción y acción, y el marco se puede adaptar para adaptarse a diferentes aplicaciones. Posteriormente, exploramos las extensas aplicaciones de los agentes basados en LLM en tres aspectos: escenarios de un solo agente, escenarios de agentes múltiples y cooperación de agentes humanos. Después de esto, profundizamos en sociedades de agentes, explorando el comportamiento y la personalidad de los agentes con sede en LLM, los fenómenos sociales que emergen cuando forman sociedades y las ideas que ofrecen para la sociedad humana. Finalmente, discutimos una variedad de temas clave y problemas abiertos dentro del campo.

Apreciamos enormemente cualquier contribución a través de PRS, problemas, correos electrónicos u otros métodos.

Tabla de contenido (TOC)

- El aumento y el potencial de los agentes basados en modelos de idiomas grandes: una encuesta

- ? Noticias

- ? Introducción

- Tabla de contenido (TOC)

- 1. El nacimiento de un agente: construcción de agentes basados en LLM

- 1.1 Cerebro: compuesto principalmente por un LLM

- 1.1.1 Interacción del lenguaje natural

- Generación de alta calidad

- Comprensión profunda

- 1.1.2 Conocimiento

- Modelo previo

- Conocimiento lingüístico

- Conocimiento de sentido común

- Conocimiento procesable

- Posibles problemas de conocimiento

- 1.1.3 memoria

- Capacidad de memoria

- Elevando el límite de longitud de los transformadores

- Resumiendo la memoria

- Comprimir recuerdos con vectores o estructuras de datos

- Recuperación de memoria

- 1.1.4 razonamiento y planificación

- Razonamiento

- Planificación

- Formulación de plan

- Reflexión del plan

- 1.1.5 Transferibilidad y generalización

- Generalización de tareas invisibles

- Aprendizaje en contexto

- Aprendizaje continuo

- 1.2 Percepción: entradas multimodales para agentes basados en LLM

- 1.3 Acción: expandir el espacio de acción de los agentes basados en LLM

- 1.3.1 Herramienta utilizando

- 1.3.2 Acción encarnada

- 2. Agentes en la práctica: Aplicaciones de agentes basados en LLM

- 2.1 Capacidad general del agente único

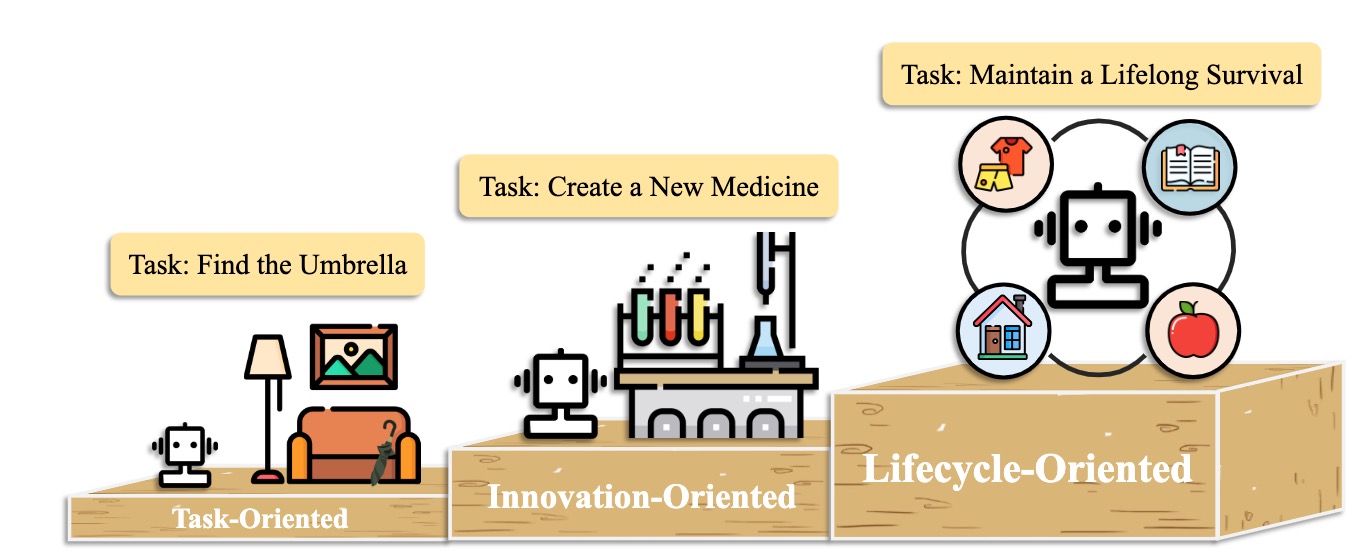

- 2.1.1 Implementación orientada a tareas

- 2.1.2 Implementación orientada a la innovación

- 2.1.3 despliegue orientado al ciclo de vida

- 2.2 Potencial de coordinación de múltiples agentes

- 2.2.1 Interacción cooperativa para la complementariedad

- 2.2.2 Interacción adversaria para el avance

- 2.3 Compromiso interactivo entre humanos y agentes

- 2.3.1 Paradigma del instructor-ejecutor

- Educación

- Salud

- Otra aplicación

- 2.3.2 Paradigma de la Asociación Igual

- Comunicador empático

- Participante a nivel humano

- 3. Sociedad de agentes: de individualidad a socialidad

- 3.1 Comportamiento y personalidad de agentes basados en LLM

- 3.1.1 Comportamiento social

- Comportamientos individuales

- Comportamientos grupales

- 3.1.2 Personalidad

- Cognición

- Emoción

- Personaje

- 3.2 Medio ambiente para la sociedad de agentes

- 3.2.1 Entorno basado en texto

- 3.2.2 Entorno virtual de sandbox

- 3.2.3 Entorno físico

- 3.3 Simulación de la sociedad con agentes basados en LLM

- 4. Otros temas

- 4.1 puntos de referencia para agentes basados en LLM

- 4.2 Entrenamiento y optimización de agentes basados en LLM

- Citación

- Mantenedores de proyectos y colaboradores

- Contacto

- Historia de la estrella

1. El nacimiento de un agente: construcción de agentes basados en LLM

1.1 Cerebro: compuesto principalmente por un LLM

1.1.1 Interacción del lenguaje natural

Generación de alta calidad

- [2023/10] Hacia la toma de decisiones encarnadas de extremo a extremo a través del modelo de lenguaje grande multimodal: exploraciones con visión GPT4 y más allá de Liang Chen et al. arxiv. [documento] [código]

- Este trabajo propone PCA-EVAL, que comparó la toma de decisiones incorporadas a través del método de extremo a extremo basado en MLLM y los métodos de uso de herramientas basados en LLM a partir de la percepción, la cognición y los niveles de acción.

- [2023/08] Una evaluación multitingüe, multilingüe, multimodal de ChatGPT sobre razonamiento, alucinación e interactividad. Yejin Bang et al. arxiv. [papel]

- Este trabajo evalúa los aspectos multitarea, multilingüe y multimodal de CHATGPT utilizando 21 conjuntos de datos que cubren 8 tareas de aplicación NLP comunes diferentes.

- [2023/06] LLM-EVAL: Evaluación automática multidimensional unificada para conversaciones de dominio abierto con modelos de idiomas grandes. Yen-ting Lin et al. arxiv. [papel]

- El método LLM-EVAL evalúa múltiples dimensiones de evaluación, como contenido, gramática, relevancia y idoneidad.

- [2023/04] ¿Es ChatGPT un sistema de corrección de errores gramaticales altamente fluidos? Una evaluación integral. Tao Fang et al. arxiv. [papel]

- Los resultados de la evaluación demuestran que ChatGPT tiene excelentes capacidades de detección de errores y puede corregir libremente los errores para que las oraciones corregidas sean muy fluidas. Además, su rendimiento en la configuración no inglesa y de baja recursos resalta su potencial en las tareas multilingües de GEC.

Comprensión profunda

- [2023/06] ¿Hans inteligente o teoría de la mente neural? Prueba de estrés razonamiento social en modelos de idiomas grandes. Natalie Shapira et al. arxiv. [papel]

- Los LLM exhiben ciertas habilidades de la teoría de la mente, pero este comportamiento está lejos de ser robusto.

- [2022/08] Inferir recompensas del lenguaje en contexto. Jessy Lin et al. Acl. [papel]

- Este trabajo presenta un modelo que infiere recompensas del lenguaje y predice acciones óptimas en un entorno invisible.

- [2021/10] La teoría de la comunicación de asistencia basada en la mente en la cooperación compleja de robots humanos. Moritz C. Buehler et al. arxiv. [papel]

- Este trabajo diseña un sushi de agente con una comprensión del humano durante la interacción.

1.1.2 Conocimiento

Modelo previo

- [2023/04] Aprendizaje de representaciones distribuidas de oraciones a partir de datos no etiquetados. Felix Hill (Universidad de Cambridge) et al. arxiv. [papel]

- [2020/02] ¿Cuánto conocimiento puede empacar en los parámetros de un modelo de idioma? Adam Roberts (Google) et al. arxiv. [papel]

- [2020/01] Leyes de escala para modelos de lenguaje neuronal. Jared Kaplan (Universidad Johns Hopkins) et al. arxiv. [papel]

- [2017/12] Conocimiento de sentido común en inteligencia de máquinas. Niket Tandon (Instituto Allen de Inteligencia Artificial) et al. Sigmod. [papel]

- [2011/03] Procesamiento del lenguaje natural (casi) desde cero. Ronan Collobert (Princeton) et al. arxiv. [papel]

Conocimiento lingüístico

- [2023/02] Una evaluación multitingüe, multilingüe, multimodal de ChatGPT sobre razonamiento, alucinación e interactividad. Yejin Bang et al. arxiv. [papel]

- [2021/06] Probar modelos de lenguaje previamente capacitados para atributos semánticos y sus valores. Meriem Beloucif et al. EMNLP. [papel]

- [2020/10] Suponiendo modelos de lenguaje previo a la semántica léxica. Ivan Vulić et al. arxiv. [papel]

- [2019/04] Una sonda estructural para encontrar sintaxis en representaciones de palabras. John Hewitt et al. Acl. [papel]

- [2016/04] Extracción de palabras clave automáticas mejoradas dado más conocimiento semántico. H Leung. Sistemas para aplicaciones avanzadas. [papel]

Conocimiento de sentido común

- [2022/10] Los modelos de lenguaje de código son aprendices de sentido común de pocos disparos. Aman Madaan et al.arxiv. [papel]

- [2021/04] Representación del conocimiento del mundo relacional en modelos de lenguaje contextual: una revisión. Tara Safavi et al. arxiv. [papel]

- [2019/11] ¿Cómo podemos saber qué saben los modelos de idiomas? Zhengbao Jiang et al.arxiv. [papel]

Conocimiento procesable

- [2023/07] Modelos de idiomas grandes en medicina. Arun James Thirunavukarasu et al. naturaleza. [papel]

- [2023/06] DS-1000: un punto de referencia natural y confiable para la generación de código de ciencia de datos. Yuhang Lai et al. ICML. [papel]

- [2022/10] Los modelos de lenguaje de código son aprendices de sentido común de pocos disparos. Aman Madaan et al. arxiv. [papel]

- [2022/02] Una evaluación sistemática de modelos de código de lenguaje grandes. Frank F. Xu et al.arxiv. [papel]

- [2021/10] VERIFICADORES DE CONSTRUCCIÓN para resolver problemas de palabras matemáticas. Karl Cobbe et al. arxiv. [papel]

Posibles problemas de conocimiento

- [2023/10] Freshllms: refrescante modelos de idiomas grandes con aumento del motor de búsqueda. Tu Vu (Google) et al. arxiv [documento] [código]

- [2023/05] Edición de grandes modelos de idiomas: problemas, métodos y oportunidades. Yunzhi Yao et al. arxiv. [papel]

- [2023/05] Autonorgulador: módulos de plug-and-play para verificar con grandes modelos de idiomas. Miaoran Li et al. arxiv. [papel]

- [2023/05] CRÍTICO: Los modelos de idiomas grandes pueden autocorregarse con una crítica interactiva para herramientas. Zhibin Gou et al. arxiv. [papel]

- [2023/04] Aprendizaje de herramientas con modelos de base. Yujia Qin et al. arxiv. [papel]

- [2023/03] SelfCheckGPT: detección de alucinación de caja negra de recursos cero para modelos generativos de idiomas grandes. Potsawee Manakul et al. arxiv. [papel]

- [2022/06] Edición de modelo basada en la memoria a escala. Eric Mitchell et al. arxiv. [papel]

- [2022/04] Una revisión sobre modelos de idiomas como bases de conocimiento. Badr Alkhamissi et al.arxiv. [papel]

- [2021/04] Edición de conocimientos fácticos en modelos de idiomas. Nicola de Cao et al.arxiv. [papel]

- [2017/08] midiendo el olvido catastrófico en las redes neuronales. Ronald Kemker et al.arxiv. [papel]

1.1.3 memoria

Capacidad de memoria

Elevando el límite de longitud de los transformadores

- [2023/10] MEMGPT: hacia LLMS como sistemas operativos. Charles Packer (UC Berkeley) et al. arxiv. [Paper] [Página del proyecto] [Código] [DataSet]

- [2023/05] Codificaciones posicionales aleatorias Generalización de longitud de aumento de los transformadores. Anian Ruoss (DeepMind) et al. arxiv. [documento] [código]

- [2023-03] Colt5: Transformadores de largo alcance más rápidos con cálculo condicional. Joshua Ainslie (Google Research) et al. arxiv. [papel]

- [2022/03] Clasificación eficiente de documentos largos utilizando transformadores. Hyunji Hayley Park (Universidad de Illinois) et al. arxiv. [documento] [código]

- [2021/12] Longt5: transformador eficiente de texto a texto para secuencias largas. Mandy Guo (Google Research) et al. arxiv. [documento] [código]

- [2019/10] BART: Pre-Training de secuencia a secuencia de desanimación para generación de lenguaje natural, traducción y comprensión. Michael Lewis (Facebook AI) et al. arxiv. [documento] [código]

Resumiendo la memoria

- [2023/10] Caminando por el laberinto de memoria: más allá del límite de contexto a través de la lectura interactiva Howard Chen (Universidad de Princeton) et al. arxiv. [papel]

- [2023/09] Empoderando la tutoría privada al encadenar modelos de idiomas grandes Yulin Chen (Universidad de Tsinghua) et al. arxiv. [papel]

- [2023/08] Expel: los agentes de LLM son estudiantes experimentales. Andrew Zhao (Universidad de Tsinghua) et al. arxiv. [documento] [código]

- [2023/08] Chateval: Hacia mejores evaluadores basados en LLM a través del debate de múltiples agentes. Chi-Min Chan (Universidad de Tsinghua) et al. arxiv. [documento] [código]

- [2023/05] MemoryBank: Mejora de modelos de lenguaje grandes con memoria a largo plazo. Wanjun Zhong (Harbin Institute of Technology) et al. arxiv. [documento] [código]

- [2023/04] Agentes generativos: simulacros interactivos del comportamiento humano. Joon Sung Park (Universidad de Stanford) et al. arxiv. [documento] [código]

- [2023/04] Desatar la capacidad de entrada infinita para modelos de lenguaje a gran escala con un sistema de memoria autocontrolado. Xinnian Liang (Universidad de Beihang) et al. arxiv. [documento] [código]

- [2023/03] Reflexión: Agentes del lenguaje con aprendizaje verbal de refuerzo. Noah Shinn (Northeastern University) et al. arxiv. [documento] [código]

- [2023/05] RecurrentGPT: generación interactiva de texto (arbitrariamente) largo. Wangchunshu Zhou (Aiwaves) et al. arxiv. [documento] [código]

Comprimir recuerdos con vectores o estructuras de datos

- [2023/07] Agentes comunicativos para el desarrollo de software. Chen Qian (Universidad de Tsinghua) et al. arxiv. [documento] [código]

- [2023/06] CHATDB: Aumento de LLM con bases de datos como su memoria simbólica. Chenxu Hu (Universidad de Tsinghua) et al. arxiv. [documento] [código]

- [2023/05] Ghost en el Minecraft: agentes generalmente capaces para entornos de mundo abierto a través de modelos de lenguaje grandes con conocimiento y memoria basados en texto. Xizhou Zhu (Universidad de Tsinghua) et al. arxiv. [documento] [código]

- [2023/05] Ret-llm: hacia una memoria general de lectura-escritura para modelos de idiomas grandes. Ali Modarressi (LMU Munich) et al. arxiv. [documento] [código]

- [2023/05] RecurrentGPT: generación interactiva de texto (arbitrariamente) largo. Wangchunshu Zhou (Aiwaves) et al. arxiv. [documento] [código]

Recuperación de memoria

- [2023/08] Memory Sandbox: gestión de memoria transparente e interactiva para agentes conversacionales. Ziheng Huang (Universidad de California - San Diego) et al. arxiv. [papel]

- [2023/08] Agentsims: una caja de arena de código abierto para una evaluación del modelo de lenguaje grande. Jiaju Lin (PTA Studio) et al. arxiv. [documento] [Página del proyecto] [Código]

- [2023/06] CHATDB: Aumento de LLM con bases de datos como su memoria simbólica. Chenxu Hu (Universidad de Tsinghua) et al. arxiv. [documento] [código]

- [2023/05] MemoryBank: Mejora de modelos de lenguaje grandes con memoria a largo plazo. Wanjun Zhong (Harbin Institute of Technology) et al. arxiv. [documento] [código]

- [2023/04] Agentes generativos: simulacros interactivos del comportamiento humano. Joon Sung Park (Stanford) et al. arxiv. [documento] [código]

- [2023/05] RecurrentGPT: generación interactiva de texto (arbitrariamente) largo. Wangchunshu Zhou (Aiwaves) et al. arxiv. [documento] [código]

1.1.4 razonamiento y planificación

Razonamiento

[2024/02] Entrenamiento de grandes modelos de idiomas para el razonamiento a través del aprendizaje de refuerzo del plan de estudios inverso. Zhiheng XI (Universidad de Fudan) et al. arxiv. [documento] [código]

[2023/09] Concile: la conferencia de mesa redonda mejora el razonamiento a través del consenso entre diversos LLM. Justin Chih-Yao Chen (Universidad de Carolina del Norte en Chapel Hill) et al. arxiv. [documento] [código]

[2023/05] Autopolish: mejorar el razonamiento en modelos de idiomas grandes a través del refinamiento de problemas. Zhiheng XI (Universidad de Fudan) et al. arxiv. [documento] [código]

[2023-03] Los modelos de idiomas grandes son razonadores de disparo cero. Takeshi Kojima (Universidad de Tokio) et al. arxiv. [documento] [código]

[2023/03] AutoRefino: refinamiento iterativo con autocuración. Aman Madaan (Universidad Carnegie Mellon) et al. arxiv. [documento] [código]

[2022/05] Inferencia de selección: explotar modelos de lenguaje grandes para un razonamiento lógico interpretable. Antonia Creswell (Deepmind) et al. arxiv. [papel]

[2022/03] La autoconsistencia mejora el razonamiento de la cadena de pensamiento en los modelos de idiomas. Xuezhi Wang (Google Research) et al. arxiv. [documento] [código]

[2023/02] razonamiento multimodal de la cadena de pensamiento en modelos de idiomas. Zhuosheng Zhang (Universidad de Shanghai Jiao Tong) et al. arxiv. [documento] [código]

[2022/01] La provisión de la cadena de pensamiento provoca un razonamiento en modelos de idiomas grandes. Jason Wei (Google Research) et al. arxiv. [papel]

Planificación

Formulación de plan

- [2023/11] JARVIS-1: Agentes de tareas múltiples de mundo abierto con modelos de lenguaje multimodal acuático. Zihao Wang (Universidad de Pekín) et al. arxiv. [documento] [código]

- [2023/10] La búsqueda del árbol del agente de idiomas unifica el razonamiento de la actuación y la planificación en los modelos de idiomas. Andy Zhou (Universidad de Illinois Urbana-Champaign) et al. arxiv. [documento] [Página del proyecto] [Código]

- [2023/05] Árbol de pensamientos: resolución deliberada de problemas con modelos de idiomas grandes. Shunyu Yao (Universidad de Princeton) et al. arxiv. [documento] [código]

- [2023/05] Plan, eliminar y rastrear: los modelos de idiomas son buenos maestros para agentes encarnados. Yue Wu (Universidad Carnegie Mellon) et al. arxiv. [papel]

- [2023/05] El razonamiento con el modelo de idioma es planificar con el modelo mundial. Shibo Hao (UC San Diego) et al. arxiv. [documento] [código]

- [2023/05] Swiftsage: un agente generativo con un pensamiento rápido y lento para tareas interactivas complejas. Bill Yuchen Lin (Instituto Allen de Inteligencia Artificial) et al. arxiv. [documento] [código]

- [2023/04] LLM+P: Empoderar modelos de idiomas grandes con competencia de planificación óptima. Bo Liu (Universidad de Texas en Austin) et al. arxiv. [documento] [código]

- [2023/03] HuggingGPT: Resolver tareas de IA con ChatGPT y sus amigos en la cara abrazada. Yongliang Shen (Microsoft Research Asia) et al. arxiv. [documento] [código]

- [2023/02] Describa, explique, planifique y seleccione: La planificación interactiva con modelos de idiomas grandes permite agentes de tareas múltiples del mundo abierto. Zihao Wang (Universidad de Pekín) et al. arxiv. [documento] [código]

- [2022/05] La solicitud de menos a la mayoría permite un razonamiento complejo en modelos de idiomas grandes. Denny Zhou (Google Research) et al. arxiv. [papel]

- [2022/05] Sistemas MRKL: una arquitectura modular y neurombólica que combina modelos de idiomas grandes, fuentes de conocimiento externas y razonamiento discreto. Ehud Karpas (AI21 Labs) et al. arxiv. [papel]

- [2022/04] Haga lo que pueda, no como yo digo: lenguaje de base en posibilidades robóticas. Michael Ahn (robótica en Google) et al. arxiv. [papel]

- [2023/05] Agentes: un marco de código abierto para agentes de idiomas autónomos. Wangchunshu Zhou (Aiwaves) et al. arxiv. [documento] [código]

- [2022/12] No genere, discriminan: una propuesta para modelos de lenguaje de base a entornos del mundo real. Yu Gu (la Universidad Estatal de Ohio) et al. Acl. [documento] [código]

Reflexión del plan

- [2024/02] Agente-Pro: Aprender a evolucionar a través de la reflexión y optimización a nivel de política Wenqi Zhang (Universidad de Zhejiang) et al. arxiv. [documento] [código]

- [2024/01] Autocontraste: mejor reflexión a través de perspectivas de resolución inconsistentes Wenqi Zhang (Universidad de Zhejiang) et al. arxiv. [papel]

- [2023/11] JARVIS-1: Agentes de tareas múltiples de mundo abierto con modelos de lenguaje multimodal acuático. Zihao Wang (Universidad de Pekín) et al. arxiv. [documento] [código]

- [2023/10] La cadena de verificación reduce la alucinación en modelos de idiomas grandes. Shehzaad Dhuliawala (Meta Ai y Eth Zu ̈rich) et al. arxiv. [papel]

- [2023/10] FireAct: hacia el agente del lenguaje ajustado. Baian Chen (System2 Research) et al. arxiv. [Paper] [Página del proyecto] [Código] [DataSet]

- [2023/08] Selfcheck: Uso de LLM a cero disparo Verifique su propio razonamiento paso a paso. Ning Miao (Universidad de Oxford) et al. arxiv. [documento] [código]

- [2023/05] ChatCot: razonamiento de la cadena de pensamiento de herramienta en modelos de idiomas grandes basados en chat. Zhipeng Chen (Universidad Renmin de China) et al. arxiv. [documento] [código]

- [2023/05] Voyager: un agente incorporado abierto con modelos de idiomas grandes. Guanzhi Wang (Nvidia) et al. arxiv. [documento] [Página del proyecto] [Código]

- [2023/03] Chatear con el entorno: percepción multimodal interactiva utilizando modelos de idiomas grandes. Xufeng Zhao (University Hamburg) et al. arxiv. [documento] [código]

- [2022/12] LLM-Planner: Planificación de pocos disparos para agentes encarnados con grandes modelos de idiomas. Canción de Chan Hee (la Universidad Estatal de Ohio) et al. arxiv. [documento] [código]

- [2022/10] React: sinergizando razonamiento y actuación en modelos de idiomas. Shunyu Yao (Universidad de Princeton) et al. arxiv. [documento] [código]

- [2022/07] Monólogo interno: razonamiento incorporado a través de la planificación con modelos de idiomas. Wenlong Huang (Robótica en Google) et al. arxiv. [documento] [código]

- [2021/10] Cadenas de IA: interacción Human-AI transparente y controlable al encadenar las indicaciones del modelo de lenguaje grandes. Tongshuang Wu (Universidad de Washington) et al. arxiv. [papel]

1.1.5 Transferibilidad y generalización

Generalización de tareas invisibles

- [2024/06] Agente: evolucionando agentes de modelos de lenguaje grande en diversos entornos. Zhiheng XI (Universidad de Fudan) et al. arxiv. [Paper] [Página del proyecto] [Códigos y plataforma] [DataSet] [Benchmark] [Modelo].

- [2023/10] Agente: habilitar habilidades de agente generalizado para LLM. Aohan Zeng (Universidad de Tsinghua) et al. arxiv. [Paper] [Página del proyecto] [Código] [DataSet]

- [2023/10] Lemur: armonización del lenguaje natural y el código para los agentes del lenguaje Yiheng Xu (Universidad de Hong Kong) et al. arxiv. [documento] [código]

- [2023/05] Modelos de lenguaje de capacitación para seguir las instrucciones con comentarios humanos. Long Oyang et al. Neuripas. [papel]

- InstructGPT: Alineando modelos de lenguaje con la intención del usuario en una amplia gama de tareas al ajustar con la retroalimentación humana.

- [2023/01] La capacitación impulsada por múltiples tareas permite la generalización de tareas de disparo cero. Victor Sanh et al. ICLR. [documento] [código]

- T0: T0 es un modelo de codificador codificador que consume entradas textuales y produce respuestas objetivo. Está capacitado en una mezcla multitarea de conjuntos de datos NLP divididos en diferentes tareas.

- [2022/10] Escalado de modelos de lenguaje de instrucción definida. Hyung Won Chung et al. arxiv. [documento] [código]

- Este trabajo explora la fina de instrucciones con un enfoque particular en escalar el número de tareas y el tamaño del modelo, lo que mejora el rendimiento en una variedad de clases de modelos, incorporando configuraciones y puntos de referencia de evaluación.

- [2022/08] Los modelos de lenguaje Finetuned son estudiantes de cero disparos. Jason Wei et al. ICLR. [papel]

- FLAN: La sintonización de instrucciones mejora sustancialmente el rendimiento de disparo cero en tareas invisibles.

Aprendizaje en contexto

- [2023/08] Las imágenes hablan en imágenes: un pintor generalista para el aprendizaje visual en contexto. Xinlong Wang et al. IEEE. [documento] [código]

- Pintor: este trabajo presenta un modelo generalista para el aprendizaje visual en contexto con una solución centrada en "imagen".

- [2023/08] Los modelos de lenguaje de códec neural son sintetizadores de texto a cero de texto a voz. Chengyi Wang et al. arxiv. [documento] [código]

- Vall-E: Este trabajo entrena un modelo de lenguaje de códec neural, que emerge capacidades de aprendizaje en contexto.

- [2023/07] Una encuesta para el aprendizaje en contexto. Qingxiu Dong et al. arxiv. [papel]

- Esta encuesta resume el progreso y los desafíos del aprendizaje en contexto (ICL).

- [2023/05] Los modelos de idiomas son alumnos de pocos disparos. Tom B. Brown (Openai) et al. Neuripas. [papel]

- GPT-3: Escalar los modelos de lenguaje mejora en gran medida el rendimiento de la tarea y el rendimiento de pocos disparos, a veces incluso se vuelve competitivo con los enfoques de ajuste finos anteriores.

Aprendizaje continuo

- [2023/11] JARVIS-1: Agentes de tareas múltiples de mundo abierto con modelos de lenguaje multimodal acuático. Zihao Wang (Universidad de Pekín) et al. arxiv. [documento] [código]

- [2023/07] Iniciado progresivo: aprendizaje continuo para modelos de idiomas. Razdaibiedina et al. arxiv. [papel]

- Este trabajo introduce indicaciones progresivas, lo que permite la transferencia hacia adelante y resiste el olvido catastrófico, sin confiar en la repetición de datos o una gran cantidad de parámetros específicos de tareas.

- [2023/05] Voyager: un agente incorporado abierto con modelos de idiomas grandes. Guanzhi Wang (Nvidia) et al. arxiv. [documento] [Página del proyecto] [Código]

- Voyager: Este es un ejemplo de agente de aprendizaje realizado para toda la vida realizado por LLM en Minecraft que explora continuamente el mundo, adquiere diversas habilidades y hace nuevos descubrimientos sin intervención humana.

- [2023/01] Una encuesta integral del aprendizaje continuo: teoría, método y aplicación. Liyuan Wang et al. arxiv. [papel]

- Esta encuesta presenta una encuesta integral del aprendizaje continuo, que busca cerrar la configuración básica, los fundamentos teóricos, los métodos representativos y las aplicaciones prácticas.

- [2022/11] Aprendizaje continuo de tareas de procesamiento del lenguaje natural: una encuesta. Zixuan Ke et al. arxiv. [papel]

- Esta encuesta presenta una revisión y análisis exhaustivos del progreso reciente de CL en PNL.

1.2 Percepción: entradas multimodales para agentes basados en LLM

1.2.1 visual

- [2024/01] Agente AI: encuestando los horizontes de la interacción multimodal. Zane Durante et al. arxiv. [papel]

- [2023/10] Hacia la toma de decisiones encarnadas de extremo a extremo a través del modelo de lenguaje grande multimodal: exploraciones con visión GPT4 y más allá de Liang Chen et al. arxiv. [documento] [código]

- [2023/05] El lenguaje no es todo lo que necesita: alinear la percepción con los modelos de idiomas. Shaohan Huang et al. arxiv. [papel]

- [2023/05] InstructBlip: Hacia modelos de lenguaje de visión de uso general con ajuste de instrucciones. Wenliang Dai et al. arxiv. [papel]

- [2023/05] GPT multimodal: un modelo de visión e lenguaje para el diálogo con humanos. Tao Gong et al. arxiv. [papel]

- [2023/05] Pandagpt: un modelo para las instrucciones seguimos a todos. Yixuan Su et al. arxiv. [papel]

- [2023/04] Ajuste de instrucciones visuales. Haotian Liu et al. arxiv. [papel]

- [2023/04] Minigpt-4: Mejora de la comprensión del idioma de la visión con modelos avanzados de idiomas grandes. Deyao Zhu. arxiv. [papel]

- [2023/01] BLIP-2: Bootstrapping Language-Image Pretringing con codificadores de imágenes congeladas y modelos de idiomas grandes. Junnan Li et al. arxiv. [papel]

- [2022/04] Flamingo: un modelo de lenguaje visual para el aprendizaje de pocos disparos. Jean-Baptiste Alayrac et al. arxiv. [papel]

- [2021/10] MobileVit: transformador de visión ligero, de uso general y amigable para dispositivos móviles. Sachin Mehta et al.arxiv. [papel]

- [2021/05] MLP-Mixer: una arquitectura All-MLP para la visión. Ilya Tolstikhin et al.arxiv. [papel]

- [2020/10] Una imagen vale 16x16 palabras: transformadores para el reconocimiento de imágenes a escala. Alexey Dosovitskiy et al. arxiv. [papel]

- [2017/11] Aprendizaje neuronal de representación discreta. Aaron van den Oord et al. arxiv. [papel]

1.2.2 audio

- [2023/06] Video-llama: un modelo de lenguaje audiovisual ajustado a instrucciones para la comprensión de video. Hang Zhang et al. arxiv. [papel]

- [2023/05] X-LLM: Bootstrapping Modelos avanzados de idiomas grandes tratando multimodalidades como idiomas extranjeros. Feilong Chen et al. arxiv. [papel]

- [2023/05] Interno: Resolver tareas centradas en la visión interactuando con ChatGPT más allá del lenguaje. Zhaoyang Liu et al. arxiv. [papel]

- [2023/04] Audiogpt: Comprender y generar discurso, música, sonido y cabeza parlante. Rongjie Huang et al. arxiv. [papel]

- [2023/03] HuggingGPT: Resolver tareas de IA con ChatGPT y sus amigos en la cara abrazada. Yongliang Shen et al. arxiv. [papel]

- [2021/06] Hubert: aprendizaje de la representación del habla auto-supervisada mediante la predicción enmascarada de las unidades ocultas. Wei-Ging Hsu et al. arxiv. [papel]

- [2021/04] AST: transformador de espectrograma de audio. Yuan Gong et al. arxiv. [papel]

1.3 Acción: expandir el espacio de acción de los agentes basados en LLM

1.3.1 Herramienta utilizando

- [2024/02] Hacia el agente de idiomas consciente de la incertidumbre. Jiuzhou Han (Universidad de Monash) et al. arxiv. [documento] [Página del proyecto] [Código]

- [2023/10] OpenAgents: una plataforma abierta para agentes del idioma en la naturaleza. Xlang Lab (la Universidad de Hong Kong) Arxiv. [Paper] [Página del proyecto] [Código] [Demo]

- [2023/10] Lemur: armonización del lenguaje natural y el código para los agentes del lenguaje Yiheng Xu (Universidad de Hong Kong) et al. arxiv. [documento] [código]

- [2023/10] Hacia la toma de decisiones encarnadas de extremo a extremo a través del modelo de lenguaje grande multimodal: exploraciones con visión GPT4 y más allá de Liang Chen (Universidad de Pekín) et al. arxiv. [documento] [código]

- Holmes es un marco de cooperación de múltiples agentes que permite a LLM aprovechar MLLMS y API para recopilar información multimodal para la toma de decisiones informadas.

- [2023/07] TOOLLLM: Facilitar modelos de idiomas grandes para dominar más de 16000 API del mundo real. Yujia Qin (Universidad de Tsinghua) et al. arxiv. [Paper] [Código] [DataSet]

- TOOLLLM es un marco general de uso de herramientas que abarca la construcción de datos, capacitación y evaluación del modelo.

- [2023/05] Modelos de idiomas grandes como creadores de herramientas. Tianle Cai (Universidad de Princeton) et al. arxiv. [documento] [código]

- LATM es un marco de circuito cerrado que da un paso inicial para eliminar la dependencia de la disponibilidad de herramientas existentes.

- [2023/05] Creador: desenredado de razonamientos abstractos y concretos de modelos de idiomas grandes a través de la creación de herramientas. Cheng Qian (Universidad de Tsinghua) et al. arxiv. [papel]

- Creator es un marco novedoso que faculta a los LLM para crear sus propias herramientas a través de la documentación y la realización del código.

- [2023/04] Aprendizaje de herramientas con modelos de base. Yujia Qin (Universidad de Tsinghua) et al. arxiv. [documento] [código]

- Esta encuesta presenta principalmente un nuevo paradigma llamado "aprendizaje de herramientas basado en modelos fundamentales", que combina las ventajas de herramientas especializadas y modelos fundamentales, logrando una mayor precisión, eficiencia y automatización en la resolución de problemas.

- [2023/04] Chemcrow: Aumento de modelos de gran lenguaje con herramientas de química. Andrés M Bran (Laboratorio de Inteligencia Química Artificial, ISIC, EPFL) et al. arxiv. [documento] [código]

- Chemcrow es un agente de química de LLM que integra 13 herramientas diseñadas por expertos y aumenta el rendimiento de LLM en química y emerge nuevas capacidades.

- [2023/04] Genegpt: Aumento de modelos de idiomas grandes con herramientas de dominio para mejorar el acceso a la información biomédica. Qiao Jin (Institutos Nacionales de Salud), Yifan Yang, Qingyu Chen, Zhiyong Lu. arxiv. [documento] [código]

- GeneGpt es un modelo que responde las preguntas de la genómica. Presenta un método novedoso para manejar desafíos con alucinaciones mediante la enseñanza de LLM para usar las API web.

- [2023/04] Openagi: cuando LLM conoce a expertos en dominios. Yingqiang Ge (Universidad de Rutgers) et al. arxiv. [documento] [código]

- Openagi es una plataforma de investigación AGI de código abierto. Presenta un paradigma de LLM que operan varios modelos expertos para la resolución de tareas complejas y propone un mecanismo RLTF para mejorar la capacidad de resolución de tareas de la LLM.

- [2023/03] HuggingGPT: Resolver tareas de IA con ChatGPT y sus amigos en la cara abrazada. Yongliang Shen (Universidad de Zhejiang) et al. arxiv. [documento] [código]

- HuggingGPT es un sistema que aprovecha los LLM para conectar varios modelos de IA multimodales en las comunidades de aprendizaje automático para resolver tareas de IA.

- [2023/03] Visual ChatGPT: hablar, dibujar y editar con modelos Visual Foundation. Chenfei Wu (Microsoft Research Asia) et al. arxiv. [documento] [código]

- Visual ChatGPT es un sistema que abre la puerta para investigar los roles visuales de ChatGPT con la ayuda de los modelos de Visual Foundation.

- [2023/02] Modelos de lenguaje aumentado: una encuesta. Grégoire Mialon (Meta AI) et al. Tmlr. [papel]

- Esta encuesta revisa los trabajos en los que los LM se aumentan con la capacidad de usar herramientas. Los LM aumentados pueden usar módulos externos para expandir su capacidad de procesamiento de contexto.

- [2023/02] Formador de herramientas: los modelos de idiomas pueden enseñarse a usar herramientas. Timo Schick (Meta AI) et al. arxiv. [papel]

- El formador de herramientas muestra que los LLM pueden enseñar a usar herramientas externas con un puñado de demostraciones para cada API.

- [2022/05] Talm: modelos de lenguaje aumentado de herramientas. Aaron Parisi (Google) et al. arxiv. [papel]

- Talm presenta un método que combina herramientas no diferenciables con LMS, lo que permite que el modelo acceda a datos en tiempo real o privado.

- [2022/05] Sistemas MRKL: una arquitectura modular y neurombólica que combina modelos de idiomas grandes, fuentes de conocimiento externas y razonamiento discreto. Ehud Karpas (AI21 Labs) et al. arxiv. [papel]

- MRKL Systems aumenta LLM con un conjunto fácilmente extensible de módulos de conocimiento y razonamiento fáciles.

- [2022/04] Haga lo que pueda, no como yo digo: lenguaje de base en posibilidades robóticas. Michael Ahn (Google) et al. Corl. [papel]

- Saycan aplica LMS en tareas robóticas del mundo real al combinar el conocimiento semántico avanzado de las LLM con la función de valor de las habilidades previamente capacitadas.

- [2021/12] WebGPT: preguntas asistidas por el navegador-respuesta con comentarios humanos. Reiichiro Nakano (Openai) et al. arxiv. [papel]

- WebGPT responde preguntas utilizando un entorno webbrowsing. Utiliza el aprendizaje de imitación durante la capacitación y luego optimiza la calidad de la respuesta a través de la retroalimentación humana.

- [2021/07] Evaluación de modelos de idiomas grandes capacitados en código. Mark Chen (Openai) et al. arxiv. [documento] [código]

- Codex puede sintetizar programas de documentos, es decir, crear herramientas basadas en la documentación.

1.3.2 Acción encarnada

- [2023/12] Hacia el aprendizaje de un modelo generalista para la navegación incorporada. Duo Zheng (La Universidad China de Hong Kong) et al. arxiv. [documento] [código]

- [2023/11] Un agente generalista incorporado en el mundo 3D. Jiangyong Huang (Universidad Bigái y Pekín) et al. arxiv. [Documento] [Página del proyecto]

- [2023/11] JARVIS-1: Agentes de tareas múltiples de mundo abierto con modelos de lenguaje multimodal acuático. Zihao Wang (Universidad de Pekín) et al. arxiv. [documento] [código]

- [2023/10] Lemur: armonización del lenguaje natural y el código para los agentes del lenguaje Yiheng Xu (Universidad de Hong Kong) et al. arxiv. [documento] [código]

- [2023/10] Hacia la toma de decisiones encarnadas de extremo a extremo a través del modelo de lenguaje grande multimodal: exploraciones con visión GPT4 y más allá de Liang Chen et al. arxiv. [documento] [código]

- [2023/07] Idioma interactivo: hablar con robots en tiempo real. Corey Lynch et al. IEEE (RAL) [PAPEL]

- [2023/05] Voyager: un agente incorporado abierto con modelos de idiomas grandes. Guanzhi Wang (Nvidia) et al. arxiv. [documento] [Página del proyecto] [Código]

- [2023/05] Avlen: navegación incorporada en audio visual en entornos 3D. Sudipta Paul et al. Neuripas. [papel]

- [2023/05] EmbodiedGPT: pretruento en lenguaje de visión a través de una cadena de pensamiento incorporada. Yao Mu et al. Arxiv [documento] [código]

- [2023/05] NavGPT: razonamiento explícito en la navegación de visión y lenguaje con modelos de idiomas grandes. Gengze Zhou et al. Arxiv [papel]

- [2023/05] Alphablock: Finetuning incorporado para el razonamiento del lenguaje de la visión en la manipulación de robots. Chuhao Jin et al. Arxiv [papel]

- [2023/03] Palm-E: un modelo de lenguaje multimodal incorporado. Danny Driess et al. Arxiv. [papel]

- [2023/03] Reflexión: Agentes del lenguaje con aprendizaje verbal de refuerzo. Noah Shinn et al. Arxiv [paper] [code]

- [2023/02] Collaborating with language models for embodied reasoning. Ishita Dasgupta et al. Arxiv. [papel]

- [2023/02] Code as Policies: Language Model Programs for Embodied Control. Jacky Liang et al. IEEE (ICRA). [papel]

- [2022/10] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao et al. Arxiv [paper] [code]

- [2022/10] Instruction-Following Agents with Multimodal Transformer. Hao Liu et al. CVPR [paper] [code]

- [2022/07] Inner Monologue: Embodied Reasoning through Planning with Language Models. Wenlong Huang et al. Arxiv. [papel]

- [2022/07] LM-Nav: Robotic Navigation with Large Pre-Trained Models of Language, Vision, and Action. Dhruv Shahet al. CoRL [paper] [code]

- [2022/04] Do As I Can, Not As I Say: Grounding Language in Robotic Affordances. Michael Ahn et al. Arxiv. [papel]

- [2022/01] A Survey of Embodied AI: From Simulators to Research Tasks. Jiafei Duan et al. IEEE (TETCI). [papel]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [documento] [código]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [papel]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [papel]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arXiv. [documento] [código]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arXiv. [papel]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [documento] [código]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arXiv. [documento] [código]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [papel]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [documento] [código]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [documento] [código]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [papel]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [documento] [código]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [papel]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [papel]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [papel]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [papel]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [documento] [código]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [documento] [código]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [papel]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [papel]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [papel]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [papel]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [papel]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [documento] [código]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [documento] [código]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [documento] [código]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [documento] [código]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [documento] [código]

2.2 Coordinating Potential of Multiple Agents

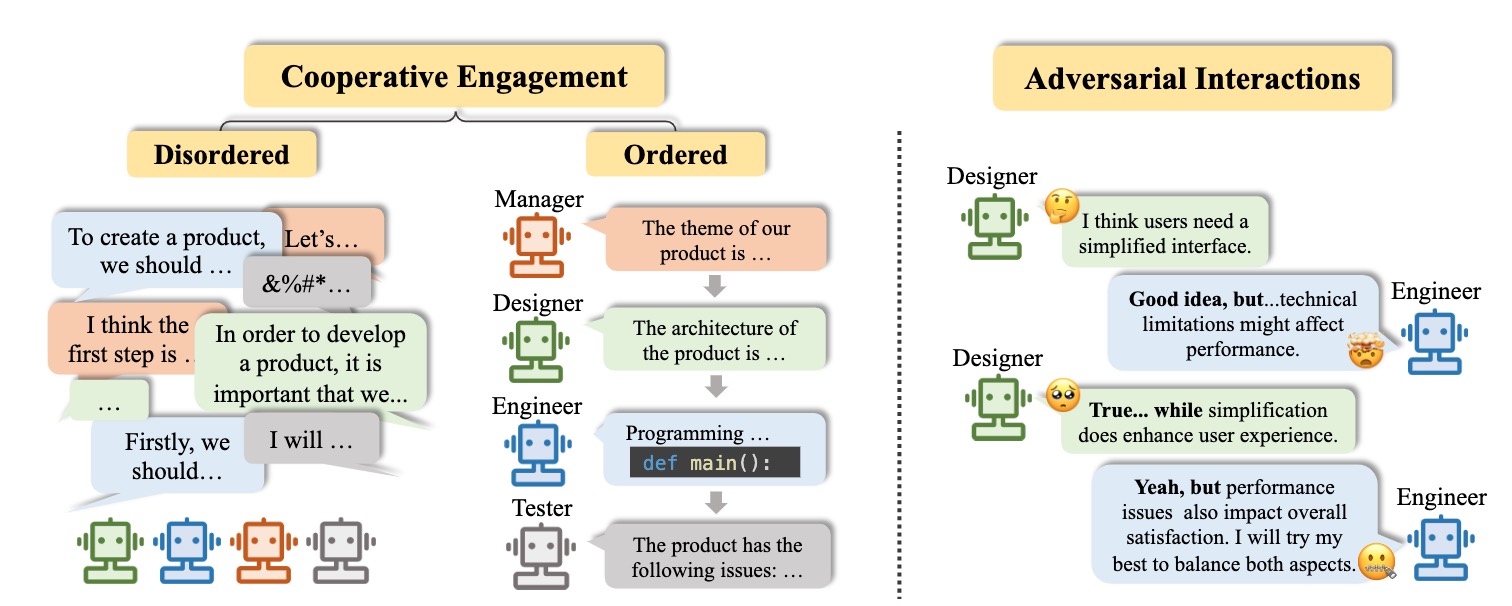

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [documento] [código]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [documento] [código]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [papel]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [papel]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [documento] [código]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arXiv. [documento] [código]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [documento] [código]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arXiv. [papel]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [documento] [código]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [documento] [código]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [documento] [código]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [documento] [código]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [documento] [código]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [papel]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [documento] [código]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arXiv. [documento] [código]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [papel]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [documento] [código]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [documento] [código]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [papel]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [documento] [código]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [documento] [código]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [documento] [código]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [papel]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [documento] [código]

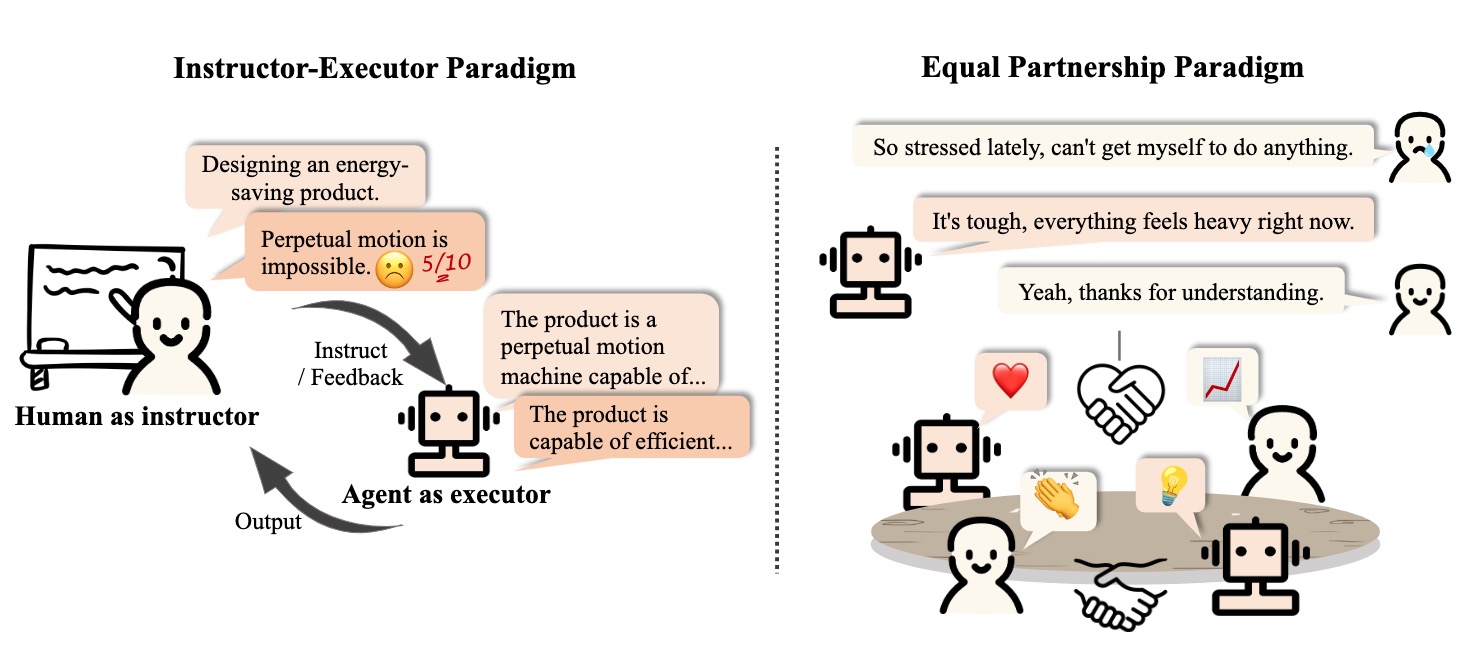

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

Educación

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [papel]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [papel]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

Salud

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [documento] [código]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [papel]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [papel]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [papel]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [papel]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arXiv. [papel]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [papel]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [papel]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [papel]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [documento] [código]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [documento] [código]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [papel]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [papel]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [papel]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [papel]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [papel]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al. Ciencia. [papel]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [papel]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [documento] [código]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [documento] [código]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [papel]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [documento] [código]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [documento] [código]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [papel]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [papel]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [documento] [código]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arXiv. [documento] [código]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [documento] [código]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [documento] [código]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [documento] [código]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [documento] [código]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [papel]

3.1.2 Personality

Cognición

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [papel]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [papel]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [papel]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arXiv. [papel]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [papel]

Emoción

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [papel]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [papel]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [papel]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [papel]

Personaje

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [documento] [código]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arXiv. [documento] [código]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [documento] [código]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [documento] [código]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [papel]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [papel]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [documento] [código]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [documento] [código]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [papel]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [documento] [código]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [documento] [código]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [documento] [código]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [documento] [código]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [documento] [código]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [documento] [código]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [papel]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [documento] [código]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [documento] [código]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [papel]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [documento] [código]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [papel]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [documento] [código]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [documento] [código]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [papel]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [documento] [código]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [documento] [código]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [documento] [código]

Citación

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

Contacto

Historia de la estrella