大規模な言語モデルベースのエージェントの上昇と可能性:調査

LLMベースのエージェント向けの必見の論文。

?近日公開:各論文に1文のイントロを追加します。

?ニュース

- ☄️[2024/06/07] AgentGymは、多様な環境でLLMベースのエージェントを開発および進化させるためにリリースされました!

- 論文:AgentGym。

- プロジェクトページ:https://agentgym.github.io/。

- コード:プラットフォームと実装。

- Huggingface Resources:AgentTraj-L、AgentEval、AgentEvol-7B。

- ? [2024/05/02] R3(逆カリキュラム補強学習を通じて推論するための大規模な言語モデルのトレーニング)は、ICML 2024によって受け入れられました!

- ? [2024/02/08] LLMエージェントのRLの新しい論文R3がリリースされました!論文:逆カリキュラムの補強学習を通じて推論のための大規模な言語モデルのトレーニング。コード:LLM-Reverse-Curriculum-RL。

- ? [2023/09/20]このプロジェクトは、Githubのトレンディングにリストされています!それは大きな名誉です!

- ? [2023/09/15]調査が発表されました!大規模な言語モデルベースのエージェントの上昇と可能性をご覧ください:論文の調査!

- [2023/09/14]このリポジトリを作成して、LLMベースのエージェントに関するペーパーリストを維持します。その他の論文が近日公開されます!

?導入

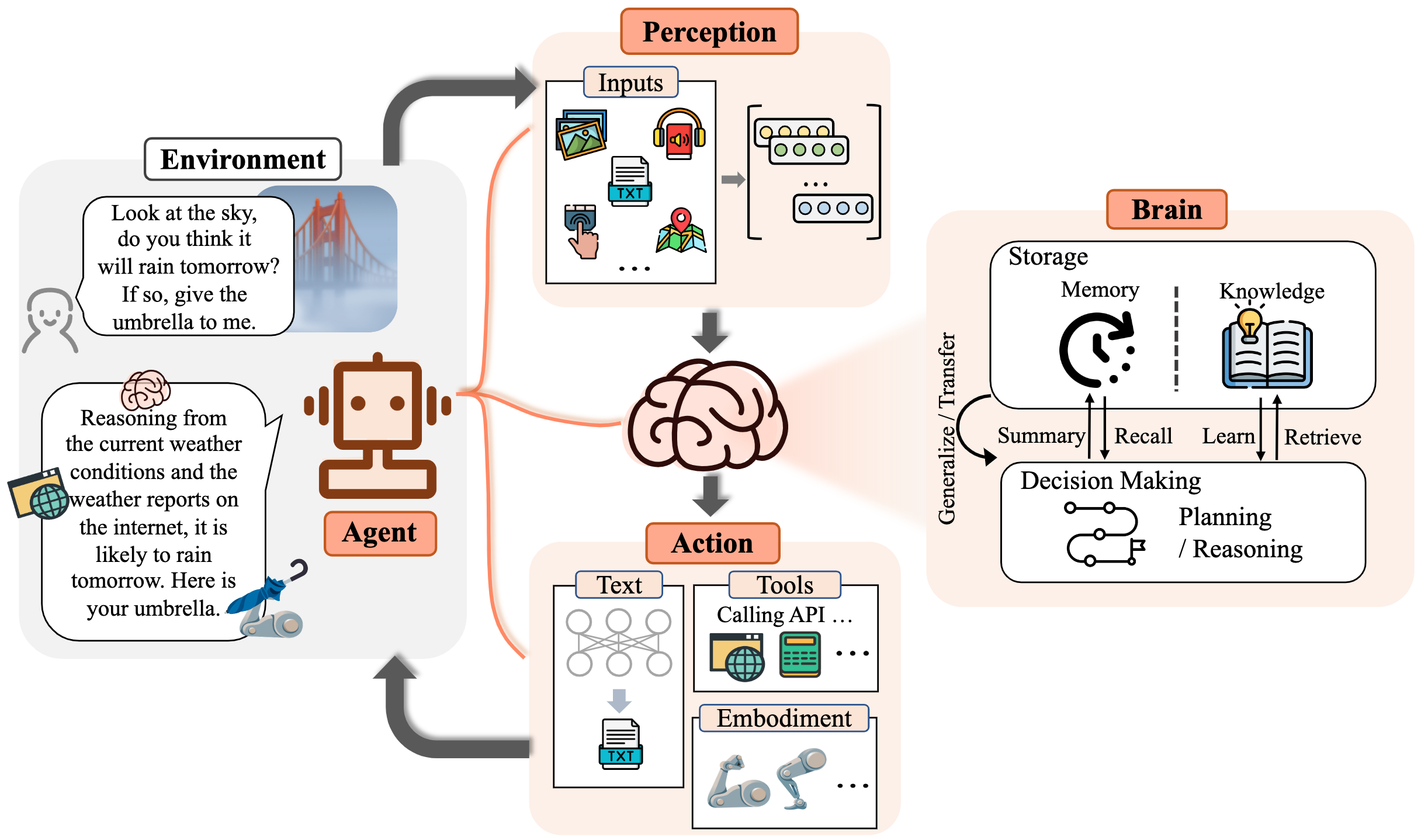

長い間、人類は人工知能(AI)と同等または人間のレベルを上回るか、この追求の有望な手段と見なされているため、人工知能(AI)を追いかけてきました。 AIエージェントは、環境を感知し、意思決定を行い、行動を起こす人工的なエンティティです。

彼らが実証している多目的で顕著な能力により、大規模な言語モデル(LLM)は、人工的な一般情報(AGI)の潜在的な火花と見なされており、一般的なAIエージェントの構築に希望を提供します。多くの研究努力により、LLMはAIエージェントを構築するための基盤として活用し、大きな進歩を遂げました。

このリポジトリでは、LLMベースのエージェントに関する体系的かつ包括的な調査を提供し、必見の論文をリストします。

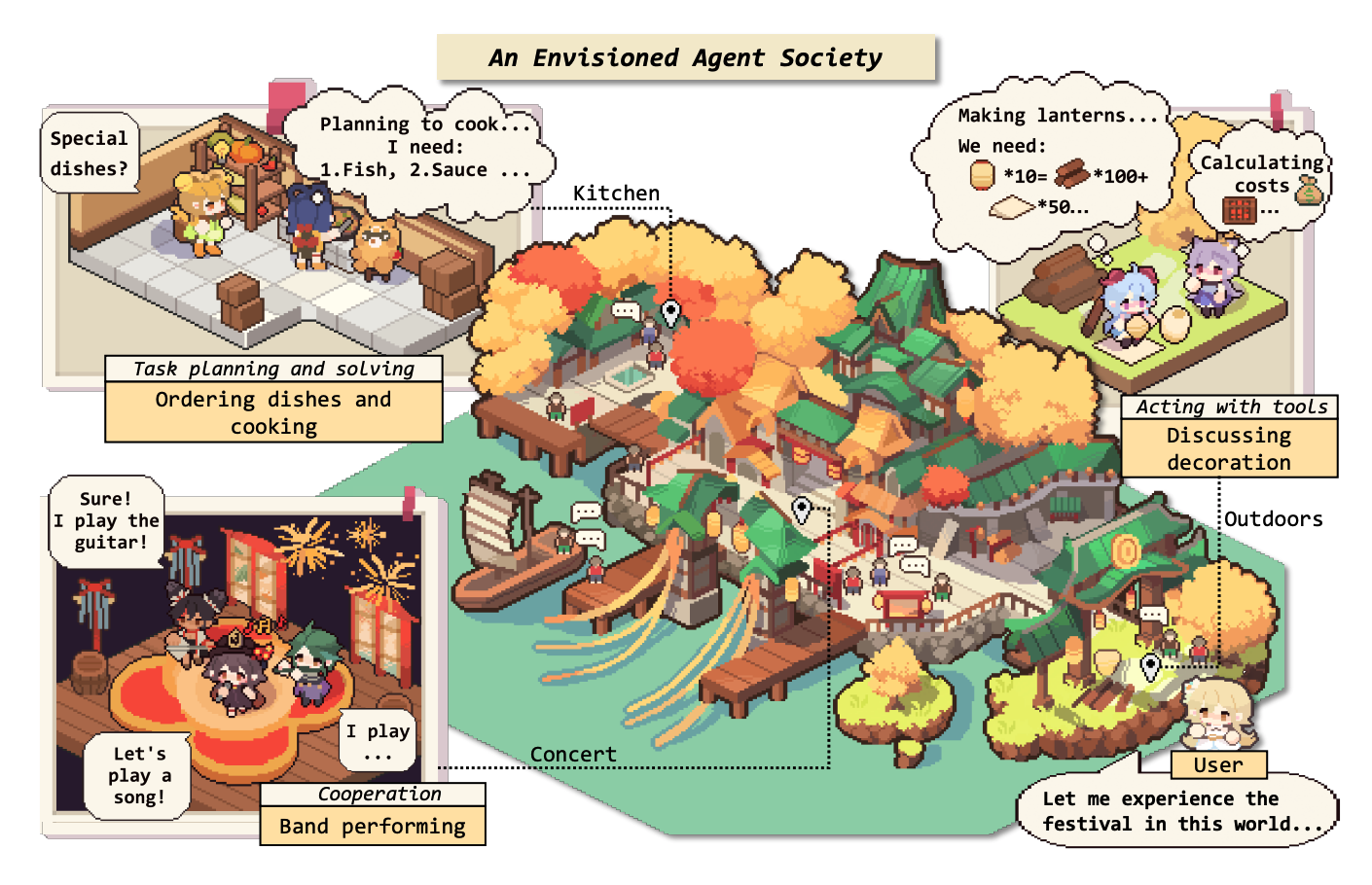

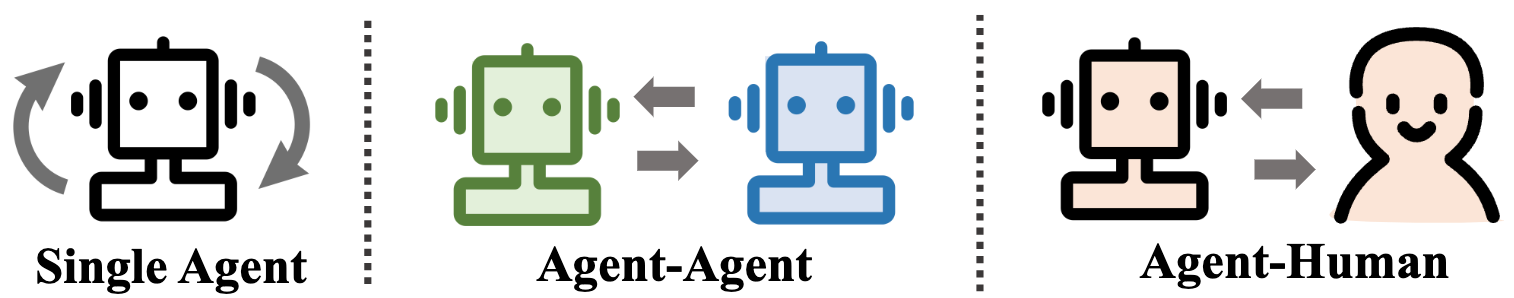

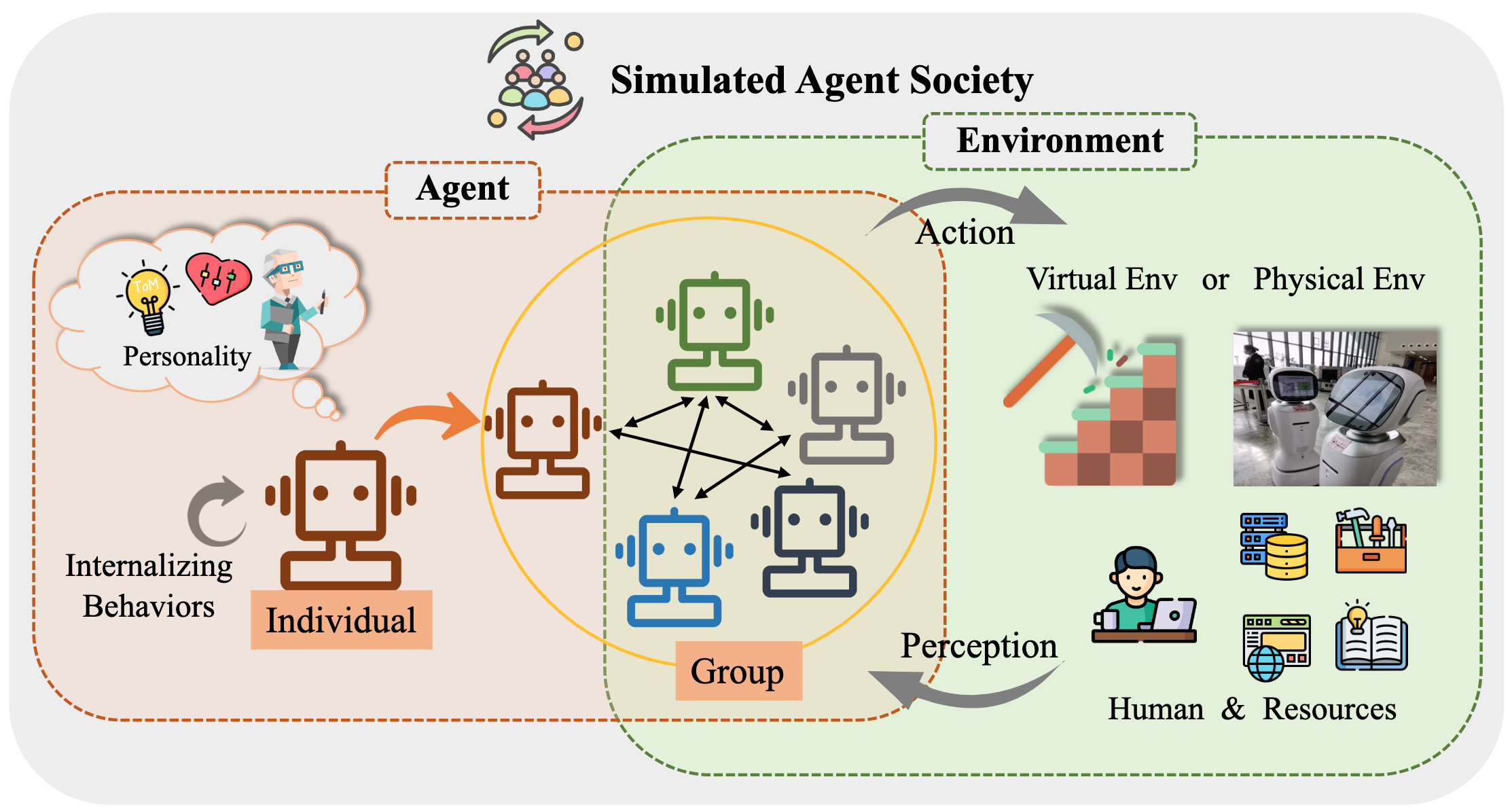

具体的には、LLMベースのエージェントの一般的な概念フレームワークから始めます。3つの主要なコンポーネントで構成されています:脳、知覚、およびアクション、およびフレームワークは、さまざまなアプリケーションに合わせて調整できます。その後、単一エージェントシナリオ、マルチエージェントシナリオ、およびヒューマンエージェント協力の3つの側面で、LLMベースのエージェントの広範なアプリケーションを調査します。これに続いて、私たちはエージェント社会を掘り下げ、LLMベースのエージェントの行動と人格、社会を形成するときに出現する社会現象、そして彼らが人間社会に提供する洞察を探求します。最後に、さまざまな主要なトピックとフィールド内のオープンな問題について説明します。

PR、問題、電子メール、またはその他の方法を介した貢献には、貢献を大いに評価しています。

コンテンツテーブル(TOC)

- 大規模な言語モデルベースのエージェントの上昇と可能性:調査

- ?ニュース

- ?導入

- コンテンツテーブル(TOC)

- 1。エージェントの誕生:LLMベースのエージェントの構築

- 1.1脳:主にLLMで構成されています

- 1.1.1自然言語の相互作用

- 1.1.2知識

- プレインモデル

- 言語知識

- 常識的な知識

- 実行可能な知識

- 知識の潜在的な問題

- 1.1.3メモリ

- メモリ機能

- トランスの長さの制限を上げる

- 記憶の要約

- ベクトルまたはデータ構造で記憶を圧縮します

- メモリ検索

- 1.1.4推論と計画

- 1.1.5転送可能性と一般化

- 目に見えないタスクの一般化

- コンテキスト学習

- 継続的な学習

- 1.2知覚:LLMベースのエージェントのマルチモーダル入力

- 1.3アクション:LLMベースのエージェントのアクション空間を拡張します

- 1.3.1使用したツール

- 1.3.2具体化されたアクション

- 2。実際のエージェント:LLMベースのエージェントのアプリケーション

- 2.1単一エージェントの一般的な能力

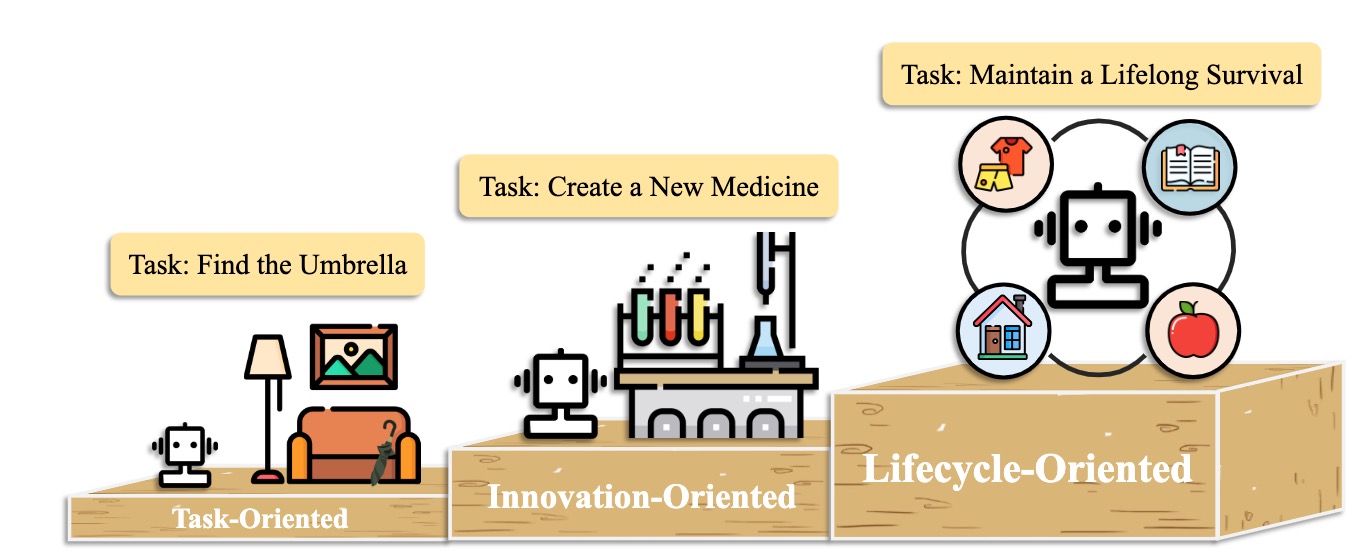

- 2.1.1タスク指向の展開

- 2.1.2イノベーション指向の展開

- 2.1.3ライフサイクル指向の展開

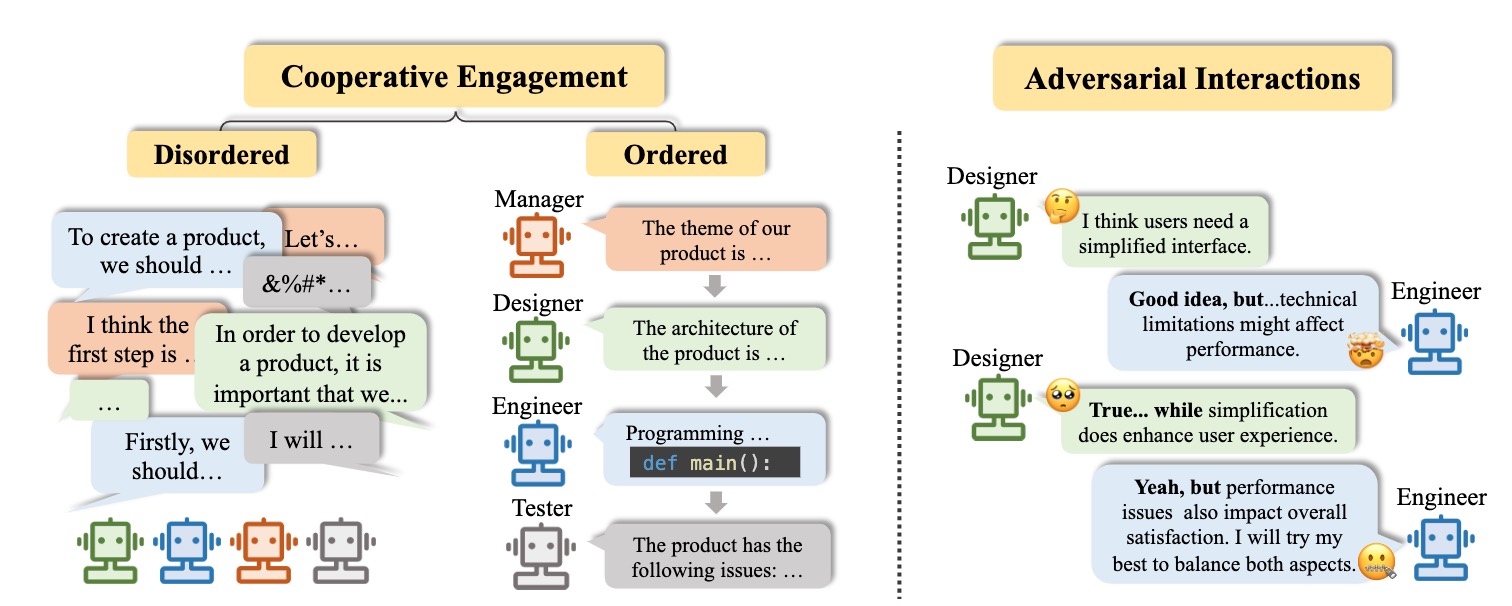

- 2.2複数のエージェントの調整可能性

- 2.2.1相補性のための協同組合の相互作用

- 2.2.2進歩のための敵対的な相互作用

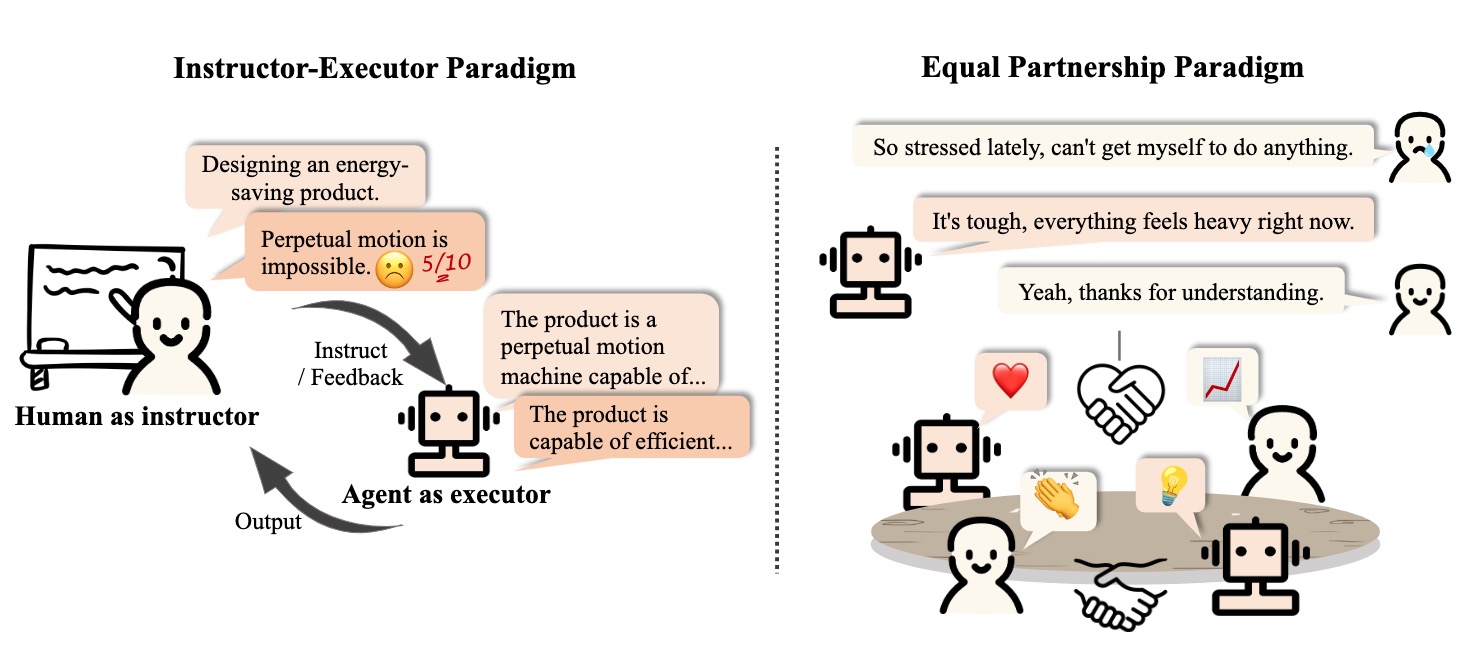

- 2.3人間とエージェントの間のインタラクティブなエンゲージメント

- 2.3.1インストラクターと執行者のパラダイム

- 2.3.2平等なパートナーシップパラダイム

- 3。エージェント社会:個性から社会性へ

- 3.1 LLMベースのエージェントの行動と性格

- 3.2エージェント社会の環境

- 3.2.1テキストベースの環境

- 3.2.2仮想サンドボックス環境

- 3.2.3物理的環境

- 3.3 LLMベースのエージェントによる社会シミュレーション

- 4。その他のトピック

- 4.1 LLMベースのエージェントのベンチマーク

- 4.2 LLMベースのエージェントのトレーニングと最適化

- 引用

- プロジェクトメンテナーと貢献者

- 接触

- 星の歴史

1。エージェントの誕生:LLMベースのエージェントの構築

1.1脳:主にLLMで構成されています

1.1.1自然言語の相互作用

高品質の世代

- [2023/10]マルチモーダルの大規模言語モデルを介したエンドツーエンドの具体化された意思決定に向けて:GPT4-VisionおよびBeyond Liang Chen et al。 arxiv。 [紙] [コード]

- この作業では、PCA-Evalを提案します。これは、MLLMベースのエンドツーエンド法と、知覚、認知、およびアクションレベルからのLLMベースのツール使用方法を介して意思決定を具体化しました。

- [2023/08]推論、幻覚、および相互作用に関するChatGPTのマルチタスク、多言語、マルチモーダル評価。 Yejin Bang et al。 arxiv。 [紙]

- この作業では、8つの異なる一般的なNLPアプリケーションタスクをカバーする21のデータセットを使用して、CHATGPTのマルチタスク、多言語、およびマルチモーダルの側面を評価します。

- [2023/06] LLM-EVAL:大規模な言語モデルを使用したオープンドメイン会話のための統一された多次元自動評価。イェン・ティン・リン等。 arxiv。 [紙]

- LLM-Eval法は、コンテンツ、文法、関連性、適切性など、評価の複数の次元を評価します。

- [2023/04] ChatGptは非常に流fluent的な文法エラー補正システムですか?包括的な評価。 Tao Fang et al。 arxiv。 [紙]

- 評価の結果は、CHATGPTが優れたエラー検出機能を持ち、修正された文を非常に流fluentにするためにエラーを自由に修正できることを示しています。さらに、非英語および低リソースの設定でのパフォーマンスは、多言語GECタスクの可能性を強調しています。

深い理解

- [2023/06]賢いハンスまたは心の神経理論?大規模な言語モデルの社会的推論のストレステスト。ナタリー・シャピラら。 arxiv。 [紙]

- LLMは特定の心の能力の理論を示しますが、この行動は堅牢ではありません。

- [2022/08]文脈で言語からの報酬を推測する。ジェシー・リン等。 ACL。 [紙]

- この作業は、言語から報酬を与え、目に見えない環境での最適なアクションを予測するモデルを提示します。

- [2021/10]複雑な人間のロボット協力における心に基づく支援コミュニケーションの理論。 Moritz C. Buehler et al。 arxiv。 [紙]

- この作品は、相互作用中に人間を理解してエージェント寿司を設計します。

1.1.2知識

プレインモデル

- [2023/04]無効なデータからの文の分散表現を学習する。フェリックスヒル(ケンブリッジ大学)等。 arxiv。 [紙]

- [2020/02]言語モデルのパラメーターにどのくらいの知識を詰め込むことができますか? Adam Roberts(Google)et al。 arxiv。 [紙]

- [2020/01]神経言語モデルのスケーリング法則。 Jared Kaplan(Johns Hopkins University)et al。 arxiv。 [紙]

- [2017/12]機械知能における常識的な知識。 Niket Tandon(Allen Institute for人工知能)et al。 Sigmod。 [紙]

- [2011/03]自然言語処理(ほぼ)ゼロから。ロナン・コロバート(プリンストン)等。 arxiv。 [紙]

言語知識

- [2023/02]推論、幻覚、および相互作用に関するChatGPTのマルチタスク、多言語、マルチモーダル評価。 Yejin Bang et al。 arxiv。 [紙]

- [2021/06]セマンティック属性とその価値の事前に訓練された言語モデルの調査。 Meriem Beloucif et al。 emnlp。 [紙]

- [2020/10]語彙セマンティクスの前提条件モデルの調査。イヴァン・ヴリッチ等。 arxiv。 [紙]

- [2019/04]単語表現の構文を見つけるための構造プローブ。ジョン・ヒューイット等。 ACL。 [紙]

- [2016/04]より多くの意味知識を考慮して、自動キーワード抽出を改善しました。 Hレオン。高度なアプリケーション用のシステム。 [紙]

常識的な知識

- [2022/10]コードの言語モデルは、少ないショットの常識学習者です。 Aman Madaan et al.arxiv。 [紙]

- [2021/04]コンテキスト言語モデルにおける関係の世界知識表現:レビュー。 Tara Safavi et al。 arxiv。 [紙]

- [2019/11]言語モデルが知っていることをどのように知ることができますか? Zhengbao Jiang et al.arxiv。 [紙]

実行可能な知識

- [2023/07]医学の大規模な言語モデル。 Arun James Thirunavukarasu et al。自然。 [紙]

- [2023/06] DS-1000:データサイエンスコード生成のための自然で信頼できるベンチマーク。 Yuhang Lai et al。 ICML。 [紙]

- [2022/10]コードの言語モデルは、少ないショットの常識学習者です。アマン・マダン等。 arxiv。 [紙]

- [2022/02]コードの大規模な言語モデルの体系的な評価。フランクF. Xu et al.arxiv。 [紙]

- [2021/10]数学の問題の問題を解決するための検証者のトレーニング。 Karl Cobbe et al。 arxiv。 [紙]

知識の潜在的な問題

- [2023/10] Freshllms:検索エンジンの増強で大規模な言語モデルをリフレッシュします。 Tu Vu(Google)et al。 arxiv [Paper] [code]

- [2023/05]大規模な言語モデルの編集:問題、方法、および機会。 Yunzhi Yao et al。 arxiv。 [紙]

- [2023/05]セルフチェッカー:大規模な言語モデルでファクトチェックするためのプラグアンドプレイモジュール。 Miaoran Li et al。 arxiv。 [紙]

- [2023/05]批評家:大規模な言語モデルは、ツールインタラクティブ批評で自己修正できます。 Zhibin Gou et al。 arxiv。 [紙]

- [2023/04]ファンデーションモデルを使用したツール学習。 Yujia Qin et al。 arxiv。 [紙]

- [2023/03] SelfCheckgpt:生成大規模な言語モデルのゼロリソースブラックボックスの幻覚検出。 Potsawee Manakul et al。 arxiv。 [紙]

- [2022/06]大規模なメモリベースのモデル編集。エリック・ミッチェル等。 arxiv。 [紙]

- [2022/04]知識ベースとしての言語モデルに関するレビュー。 Badr Alkhamissi et al.arxiv。 [紙]

- [2021/04]言語モデルの事実知識の編集。ニコラ・デ・カオ等al.arxiv。 [紙]

- [2017/08]ニューラルネットワークでの壊滅的な忘却の測定。 Ronald Kemker et al.arxiv。 [紙]

1.1.3メモリ

メモリ機能

トランスの長さの制限を上げる

- [2023/10] Memgpt:オペレーティングシステムとしてのLLMSに向けて。チャールズ・パッカー(UCバークレー)et al。 arxiv。 [紙] [プロジェクトページ] [コード] [データセット]

- [2023/05]ランダム化された位置エンコーディングは、変圧器の長さの一般化を強化します。 Anian Ruoss(Deepmind)et al。 arxiv。 [紙] [コード]

- [2023-03] COLT5:条件付き計算により、より高速な長距離変圧器。 Joshua Ainslie(Google Research)et al。 arxiv。 [紙]

- [2022/03]変圧器を使用した長い文書の効率的な分類。 Hyunji Hayley Park(イリノイ大学)et al。 arxiv。 [紙] [コード]

- [2021/12] Longt5:長いシーケンスのテキストからテキストへの効率的なトランス。 Mandy Guo(Google Research)et al。 arxiv。 [紙] [コード]

- [2019/10] BART:自然言語の生成、翻訳、および理解のためのシーケンスからシーケンス前のトレーニングを除去。マイケル・ルイス(Facebook AI)et al。 arxiv。 [紙] [コード]

記憶の要約

- [2023/10]メモリの迷路を歩く:インタラクティブな読書ハワード・チェン(プリンストン大学)et al。 arxiv。 [紙]

- [2023/09]大規模な言語モデルをチェックすることにより、プライベートチューターの力を強化するYulin Chen(Tsinghua University)et al。 arxiv。 [紙]

- [2023/08] Expel:LLMエージェントは体験学習者です。 Andrew Zhao(Tsinghua University)et al。 arxiv。 [紙] [コード]

- [2023/08] Chateval:Multi-Agent Debateを通じてLLMベースのより良い評価者に向けて。 Chi-Min Chan(Tsinghua University)et al。 arxiv。 [紙] [コード]

- [2023/05] MemoryBank:長期メモリで大規模な言語モデルの強化。 Wanjun Zhong(Harbin Institute of Technology)et al。 arxiv。 [紙] [コード]

- [2023/04]生成エージェント:人間の行動のインタラクティブなシミュレーション。ジュン・ソン・パーク(スタンフォード大学)et al。 arxiv。 [紙] [コード]

- [2023/04]自己制御メモリシステムを使用して、大規模な言語モデルの無限の長さの入力容量を解き放ちます。 Xinnian Liang(Beihang University)et al。 arxiv。 [紙] [コード]

- [2023/03]反射:言語補強学習を伴う言語エージェント。ノアシン(ノースイースタン大学)et al。 arxiv。 [紙] [コード]

- [2023/05] RecurrentGpt:(任意の)長いテキストのインタラクティブ生成。 Wangchunshu Zhou(Aiwaves)et al。 arxiv。 [紙] [コード]

ベクトルまたはデータ構造で記憶を圧縮します

- [2023/07]ソフトウェア開発のためのコミュニケーションエージェント。 Chen Qian(Tsinghua University)et al。 arxiv。 [紙] [コード]

- [2023/06] ChatDB:象徴的なメモリとしてデータベースを使用してLLMSを増強します。 Chenxu Hu(Tsinghua University)et al。 arxiv。 [紙] [コード]

- [2023/05] Minecraftの幽霊:テキストベースの知識と記憶を持つ大規模な言語モデルを介したオープンワールド環境の一般的な有能なエージェント。 Xizhou Zhu(Tsinghua University)et al。 arxiv。 [紙] [コード]

- [2023/05] ret-llm:大規模な言語モデルの一般的な読み取りワイトメモリに向けて。 Ali Modarressi(LMU Munich)et al。 arxiv。 [紙] [コード]

- [2023/05] RecurrentGpt:(任意の)長いテキストのインタラクティブ生成。 Wangchunshu Zhou(Aiwaves)et al。 arxiv。 [紙] [コード]

メモリ検索

- [2023/08]メモリサンドボックス:会話エージェント向けの透明でインタラクティブなメモリ管理。 Ziheng Huang(カリフォルニア大学 - サンディエゴ)et al。 arxiv。 [紙]

- [2023/08] Agentsims:大規模な言語モデル評価のためのオープンソースサンドボックス。 Jiaju Lin(PTA Studio)et al。 arxiv。 [紙] [プロジェクトページ] [コード]

- [2023/06] ChatDB:象徴的なメモリとしてデータベースを使用してLLMSを増強します。 Chenxu Hu(Tsinghua University)et al。 arxiv。 [紙] [コード]

- [2023/05] MemoryBank:長期メモリで大規模な言語モデルの強化。 Wanjun Zhong(Harbin Institute of Technology)et al。 arxiv。 [紙] [コード]

- [2023/04]生成エージェント:人間の行動のインタラクティブなシミュレーション。ジュン・ソン・パーク(スタンフォード)et al。 arxiv。 [紙] [コード]

- [2023/05] RecurrentGpt:(任意の)長いテキストのインタラクティブ生成。 Wangchunshu Zhou(Aiwaves)et al。 arxiv。 [紙] [コード]

1.1.4推論と計画

推論

[2024/02]逆カリキュラム補強学習を通じて推論するための大規模な言語モデルのトレーニング。 Zhiheng Xi(Fudan University)et al。 arxiv。 [紙] [コード]

[2023/09] Reconcile:ラウンドテーブル会議は、多様なLLMのコンセンサスを介して推論を改善します。ジャスティン・チハ・ヤオ・チェン(ノースカロライナ大学チャペル・ヒル校)et al。 arxiv。 [紙] [コード]

[2023/05]セルフポーリッシュ:問題の改良による大規模な言語モデルの推論を強化します。 Zhiheng Xi(Fudan University)et al。 arxiv。 [紙] [コード]

[2023-03]大規模な言語モデルはゼロショット推論です。コジマザウ(東京大学)et al。 arxiv。 [紙] [コード]

[2023/03] self refine:セルフフィードバックによる反復洗練。アマン・マダン(カーネギー・メロン大学)et al。 arxiv。 [紙] [コード]

[2022/05]選択推論:解釈可能な論理推論のために大規模な言語モデルを活用します。 Antonia Creswell(Deepmind)et al。 arxiv。 [紙]

[2022/03]自己整合性は、言語モデルの一連の思考推論を改善します。 Xuezhi Wang(Google Research)et al。 arxiv。 [紙] [コード]

[2023/02]言語モデルにおけるマルチモーダルチェーンの推論。 Zhuosheng Zhang(Shanghai Jiao Tong University)et al。 arxiv。 [紙] [コード]

[2022/01]チェーンオブ考えのプロンプトは、大規模な言語モデルで推論を引き出します。 Jason Wei(Google Research)et al。 arxiv。 [紙]

計画

計画の定式化

- [2023/11] Jarvis-1:メモリが熟成したマルチモーダル言語モデルを備えたオープンワールドマルチタスクエージェント。 Zihao Wang(Peking University)et al。 arxiv。 [紙] [コード]

- [2023/10]言語エージェントツリー検索は、言語モデルでの演技と計画の推論を統合します。 Andy Zhou(イリノイ大学Urbana-Champaign)et al。 arxiv。 [紙] [プロジェクトページ] [コード]

- [2023/05]思考のツリー:大規模な言語モデルでの意図的な問題解決。 Shunyu Yao(Princeton University)et al。 arxiv。 [紙] [コード]

- [2023/05]計画、排除、追跡 - 言語モデルは、具体化されたエージェントにとって優れた教師です。 Yue Wu(カーネギーメロン大学)et al。 arxiv。 [紙]

- [2023/05]言語モデルの推論は、世界モデルを計画しています。 Shibo Hao(UC San Diego)et al。 arxiv。 [紙] [コード]

- [2023/05] Swiftsage:複雑なインタラクティブなタスクに対して高速でゆっくりと思考を持つ生成エージェント。ビル・ユシェン・リン(アレン・インスティテュート・フォー・人工知能)et al。 arxiv。 [紙] [コード]

- [2023/04] LLM+P:最適な計画習熟度を持つ大規模な言語モデルの力を強化します。 Bo Liu(テキサス大学オースティン校)et al。 arxiv。 [紙] [コード]

- [2023/03] Hugginggpt:hugging faceのchatgptとその友人とのAIタスクを解決します。 Yongliang Shen(Microsoft Research Asia)et al。 arxiv。 [紙] [コード]

- [2023/02]説明、説明、計画、および選択:大規模な言語モデルを使用したインタラクティブな計画により、オープンワールドのマルチタスクエージェントが可能になります。 Zihao Wang(Peking University)et al。 arxiv。 [紙] [コード]

- [2022/05]最小のプロンプトは、大規模な言語モデルで複雑な推論を可能にします。 Denny Zhou(Google Research)et al。 arxiv。 [紙]

- [2022/05] MRKLシステム:大規模な言語モデル、外部知識ソース、離散推論を組み合わせたモジュール式の神経腫瘍アーキテクチャ。 Ehud Karpas(AI21 Labs)et al。 arxiv。 [紙]

- [2022/04]できる限り、私が言うように、ロボットアフォーダンスの基礎言語。 Michael Ahn(GoogleのRobotics)et al。 arxiv。 [紙]

- [2023/05]エージェント:自律言語エージェント向けのオープンソースフレームワーク。 Wangchunshu Zhou(Aiwaves)et al。 arxiv。 [紙] [コード]

- [2022/12]生成されない、差別:言語モデルを実際の環境に接地する提案。 Yu Gu(オハイオ州立大学)et al。 ACL。 [紙] [コード]

計画の反映

- [2024/02]エージェント-Pro:ポリシーレベルの反射と最適化を介して進化することを学ぶWenqi Zhang(Zhejiang University)et al。 arxiv。 [紙] [コード]

- [2024/01]自己支配:一貫性のない解決の視点によるより良い反射Wenqi Zhang(Zhejiang University)et al。 arxiv。 [紙]

- [2023/11] Jarvis-1:メモリが熟成したマルチモーダル言語モデルを備えたオープンワールドマルチタスクエージェント。 Zihao Wang(Peking University)et al。 arxiv。 [紙] [コード]

- [2023/10]チェーンオブバイフィッシュは、大規模な言語モデルの幻覚を減らします。 Shehzaad dhuliawala(Meta ai&Eth zürich)et al。 arxiv。 [紙]

- [2023/10] FireAct:言語エージェントの微調整に向けて。 Baian Chen(System2 Research)et al。 arxiv。 [紙] [プロジェクトページ] [コード] [データセット]

- [2023/08]セルフチェック:LLMSを使用してゼロショット自分の段階的な推論をチェックします。 Ning Miao(オックスフォード大学)et al。 arxiv。 [紙] [コード]

- [2023/05] ChatCot:チャットベースの大手言語モデルに関するツール編成の考え方の推論。 Zhipeng Chen(中国のRenmin大学)et al。 arxiv。 [紙] [コード]

- [2023/05] Voyager:大規模な言語モデルを備えたオープンエンドの具体化されたエージェント。グアンツィ・ワン(Nvidia)et al。 arxiv。 [紙] [プロジェクトページ] [コード]

- [2023/03]環境とのチャット:大規模な言語モデルを使用したインタラクティブなマルチモーダル認識。 Xufeng Zhao(University Hamburg)et al。 arxiv。 [紙] [コード]

- [2022/12] LLM-Planner:大規模な言語モデルを持つ具体化されたエージェントの少数の根拠のある計画。 Chan Hee Song(オハイオ州立大学)et al。 arxiv。 [紙] [コード]

- [2022/10] React:言語モデルでの推論と行動を相乗的にします。 Shunyu Yao(Princeton University)et al。 arxiv。 [紙] [コード]

- [2022/07]内側の独白:言語モデルとの計画を通じて推論を具体化。 Wenlong Huang(GoogleのRobotics)et al。 arxiv。 [紙] [コード]

- [2021/10] AIチェーン:大規模な言語モデルプロンプトをチェーンすることによる透明で制御可能な人間との相互作用。 Tongshuang Wu(ワシントン大学)他arxiv。 [紙]

1.1.5転送可能性と一般化

目に見えないタスクの一般化

- [2024/06] AgentGym:多様な環境での大規模な言語モデルベースのエージェントの進化。 Zhiheng Xi(Fudan University)et al。 arxiv。 [Paper] [Project Page] [コードとプラットフォーム] [データセット] [ベンチマーク] [モデル]。

- [2023/10] AgentTuning:LLMSの一般化されたエージェント能力の有効化。 Aohan Zeng(Tsinghua University)et al。 arxiv。 [紙] [プロジェクトページ] [コード] [データセット]

- [2023/10]レマー:言語エージェントの自然言語とコードを調和させるYiheng Xu(香港大学)et al。 arxiv。 [紙] [コード]

- [2023/05]人間のフィードバックで指示に従うための言語モデルのトレーニング。 Long Ouyang et al。ニューリップ。 [紙]

- instructgpt:人間のフィードバックを微調整することにより、幅広いタスクにユーザーの意図を持つ言語モデルを調整します。

- [2023/01]マルチタスクプロンプトトレーニングにより、ゼロショットタスクの一般化が可能になります。ビクター・サン等。 ICLR。 [紙] [コード]

- T0:T0は、テキスト入力を消費し、ターゲット応答を生成するエンコーダーデコーダーモデルです。これは、さまざまなタスクに分割されたNLPデータセットのマルチタスク混合物でトレーニングされています。

- [2022/10]命令finetuned言語モデルのスケーリング。ヒョンはチョン等に勝ちました。 arxiv。 [紙] [コード]

- この作業では、タスクの数とモデルサイズのスケーリングに特に焦点を当てた命令を探ります。これにより、さまざまなモデルクラスのパフォーマンスが向上し、セットアップの促進、評価ベンチマークが向上します。

- [2022/08] Finetuned Languageモデルはゼロショット学習者です。ジェイソン・ウェイ等。 ICLR。 [紙]

- FLAN:指導の調整により、目に見えないタスクのゼロショットパフォーマンスが大幅に向上します。

コンテキスト学習

- [2023/08]画像は画像で話す:文脈内の視覚学習のためのジェネラリストの画家。 Xinlong Wang et al。 IEEE。 [紙] [コード]

- 画家:この作品は、「画像」中心のソリューションを使用したコンテキスト内の視覚学習の一般主義モデルを提示します。

- [2023/08]ニューラルコーデック言語モデルは、音声シンセサイザーからゼロショットテキストです。 Chengyi Wang et al。 arxiv。 [紙] [コード]

- VALL-E:この作業は、コンテキストでの学習能力を登場するニューラルコーデック言語モデルを訓練します。

- [2023/07]コンテキスト学習のための調査。 Qingxiu Dong et al。 arxiv。 [紙]

- この調査では、コンテキスト学習(ICL)の進捗と課題を要約しています。

- [2023/05]言語モデルは少数の学習者です。トムB.ブラウン(Openai)et al。ニューリップ。 [紙]

- GPT-3:言語モデルをスケールアップすると、タスクに依存しない、少ないショットのパフォーマンスが大幅に向上し、時には最先端の微調整アプローチと競争力があります。

継続的な学習

- [2023/11] Jarvis-1:メモリが熟成したマルチモーダル言語モデルを備えたオープンワールドマルチタスクエージェント。 Zihao Wang(Peking University)et al。 arxiv。 [紙] [コード]

- [2023/07]プログレッシブプロンプト:言語モデルの継続的な学習。 Razdaibiedina et al。 arxiv。 [紙]

- この作業では、データリプレイや多数のタスク固有のパラメーターに依存することなく、前向きな転送を可能にし、壊滅的な忘却に抵抗するプログレッシブプロンプトを導入します。

- [2023/05] Voyager:大規模な言語モデルを備えたオープンエンドの具体化されたエージェント。グアンツィ・ワン(Nvidia)et al。 arxiv。 [紙] [プロジェクトページ] [コード]

- Voyager:これは、MinecraftのLLM駆動の具体化された生涯学習エージェントの例であり、世界を継続的に探求し、多様なスキルを習得し、人間の介入なしに斬新な発見をします。

- [2023/01]継続的な学習の包括的な調査:理論、方法、および応用。 Liyuan Wang et al。 arxiv。 [紙]

- この調査では、継続的な学習に関する包括的な調査を提示し、基本的な設定、理論的基礎、代表的な方法、および実用的なアプリケーションを橋渡ししようとしています。

- [2022/11]自然言語処理タスクの継続的な学習:調査。 Zixuan Ke et al。 arxiv。 [紙]

- この調査では、NLPにおけるCLの最近の進捗状況の包括的なレビューと分析を提示します。

1.2知覚:LLMベースのエージェントのマルチモーダル入力

1.2.1ビジュアル

- [2024/01]エージェントAI:マルチモーダル相互作用の視野を調査します。 Zane Durante et al。 arxiv。 [紙]

- [2023/10]マルチモーダルの大規模言語モデルを介したエンドツーエンドの具体化された意思決定に向けて:GPT4-VisionおよびBeyond Liang Chen et al。 arxiv。 [紙] [コード]

- [2023/05]言語はあなたが必要とするすべてではありません:言語モデルと知覚を調整します。 Shaohan Huang et al。 arxiv。 [紙]

- [2023/05] Instructblip:命令調整を伴う汎用ビジョン言語モデルに向けて。 Wenliang Dai et al。 arxiv。 [紙]

- [2023/05] Multimodal-GPT:人間との対話のためのビジョンと言語モデル。タオゴンら。 arxiv。 [紙]

- [2023/05] Pandagpt:1つのモデルを指示するすべてのモデル。 Yixuan Su et al。 arxiv。 [紙]

- [2023/04]視覚命令の調整。 Haotian Liu et al。 arxiv。 [紙]

- [2023/04] Minigpt-4:高度な大手言語モデルによる視覚言語の理解の向上。 Deyao Zhu。 arxiv。 [紙]

- [2023/01] BLIP-2:フローズン画像エンコーダーと大規模な言語モデルを使用した言語イメージのブートストラッププリトレーニング。 Junnan Li et al。 arxiv。 [紙]

- [2022/04]フラミンゴ:少数のショット学習の視覚言語モデル。 Jean-Baptiste Alayrac et al。 arxiv。 [紙]

- [2021/10] MobileVit:軽量、汎用、モバイルに優しいビジョントランス。 Sachin Mehta et al.arxiv。 [紙]

- [2021/05] MLP-Mixer:ビジョンのためのAll-MLPアーキテクチャ。 Ilya Tolstikhin et al.arxiv。 [紙]

- [2020/10]画像は16x16の価値があります:大規模な画像認識のための変圧器。 Alexey Dosovitskiy et al。 arxiv。 [紙]

- [2017/11]ニューラル離散表現学習。アーロン・ヴァン・デン・オード等arxiv。 [紙]

1.2.2オーディオ

- [2023/06] Video-llama:ビデオ理解のための命令調整されたオーディオ視聴覚言語モデル。ハングチャンら。 arxiv。 [紙]

- [2023/05] X-llm:マルチモダリティを外国語として扱うことにより、高度な大規模な言語モデルをブートストラップします。 Feilong Chen et al。 arxiv。 [紙]

- [2023/05] Interngpt:言語を超えてChatGptと対話することにより、ビジョン中心のタスクを解決します。 Zhaoyang Liu et al。 arxiv。 [紙]

- [2023/04] audiogpt:スピーチ、音楽、サウンド、トーキングヘッドの理解と生成。 Rongjie Huang et al。 arxiv。 [紙]

- [2023/03] Hugginggpt:hugging faceのchatgptとその友人とのAIタスクを解決します。 Yongliang Shen et al。 arxiv。 [紙]

- [2021/06] Hubert:隠されたユニットのマスクされた予測による学習学習。 Weining Hsu et al。 arxiv。 [紙]

- [2021/04] AST:オーディオスペクトログラムトランス。 Yuan Gong et al。 arxiv。 [紙]

1.3アクション:LLMベースのエージェントのアクション空間を拡張します

1.3.1使用したツール

- [2024/02]不確実性を認識する言語エージェントに向けて。柔術ハン(モナッシュ大学)et al。 arxiv。 [紙] [プロジェクトページ] [コード]

- [2023/10] Operagents:野生の言語エージェント向けのオープンプラットフォーム。 Xlang Lab(香港大学)Arxiv。 [紙] [プロジェクトページ] [コード] [デモ]

- [2023/10]レマー:言語エージェントの自然言語とコードを調和させるYiheng Xu(香港大学)et al。 arxiv。 [紙] [コード]

- [2023/10]マルチモーダルの大規模言語モデルを介したエンドツーエンドの具体化された意思決定に向けて:GPT4-VisionおよびBeyond Liang Chen(Peking University)et al。 arxiv。 [紙] [コード]

- Holmesは、LLMSがMLLMSとAPIを活用して、情報に基づいた意思決定のためにマルチモーダル情報を収集できるマルチエージェント協力フレームワークです。

- [2023/07] toolllm:16000以上の現実世界のAPIを習得するための大規模な言語モデルを促進します。 Yujia Qin(Tsinghua University)et al。 arxiv。 [紙] [コード] [データセット]

- TOOLLLMは、データ構築、モデルトレーニング、評価を含む一般的なツール使用フレームワークです。

- [2023/05]ツールメーカーとしての大規模な言語モデル。 Tianle Cai(Princeton University)et al。 arxiv。 [紙] [コード]

- LATMは、既存のツールの可用性への依存度を削除するための最初のステップを踏む閉ループフレームワークです。

- [2023/05]作成者:ツール作成による大規模な言語モデルの抽象的および具体的な推論を解き放つ。 Cheng Qian(Tsinghua University)et al。 arxiv。 [紙]

- Creatorは、ドキュメントとコードの実現を通じてLLMSを独自のツールを作成できるようにする新しいフレームワークです。

- [2023/04]ファンデーションモデルを使用したツール学習。 Yujia Qin(Tsinghua University)et al。 arxiv。 [紙] [コード]

- この調査では、主に「基礎モデルに基づいたツール学習」と呼ばれる新しいパラダイムを紹介します。これは、専門的なツールと基礎モデルの利点を組み合わせて、問題解決におけるより高い精度、効率、自動化を達成します。

- [2023/04] Chemcrow:化学ツールを使用した大規模モデルの増強。 Andres M Bran(人工化学知能研究所、ISIC、EPFL)et al。 arxiv。 [紙] [コード]

- Chemcrowは、13の専門家が設計したツールを統合し、化学のLLMパフォーマンスを統合し、新しい機能を出現するLLM化学エージェントです。

- [2023/04] Genegpt:生物医学情報へのアクセスを改善するために、ドメインツールを使用して大規模な言語モデルを増強します。 Qiao Jin(国立衛生研究所)、Yifan Yang、Qingyu Chen、Zhiyong Lu。 arxiv。 [紙] [コード]

- Genegptは、ゲノミクスの質問に答えるモデルです。 Web APIを使用するようにLLMを教えることにより、幻覚を伴う課題を処理するための新しい方法を導入します。

- [2023/04] Openagi:LLMがドメインの専門家に会ったとき。 Yingqiang GE(Rutgers University)et al。 arxiv。 [紙] [コード]

- Openagiは、オープンソースAGI研究プラットフォームです。複雑なタスク解決のためにさまざまな専門家モデルを動作させるLLMのパラダイムを導入し、LLMのタスク解決能力を改善するためのRLTFメカニズムを提案します。

- [2023/03] Hugginggpt:hugging faceのchatgptとその友人とのAIタスクを解決します。 Yongliang Shen(Zhejiang University)et al。 arxiv。 [紙] [コード]

- HuggingGptは、機械学習コミュニティのさまざまなマルチモーダルAIモデルを接続してAIタスクを解決するためにLLMを活用するシステムです。

- [2023/03] Visual ChatGPT:Visual Foundationモデルとの会話、描画、編集。 Chenfei Wu(Microsoft Research Asia)et al。 arxiv。 [紙] [コード]

- Visual ChatGptは、Visual Foundationモデルの助けを借りてChatGPTの視覚的な役割を調査するための扉を開くシステムです。

- [2023/02]拡張言語モデル:調査。 GrégoireMialon(Meta AI)et al。 TMLR。 [紙]

- この調査レビューでは、LMSがツールを使用する機能で補強されている作品があります。拡張LMSは、外部モジュールを使用してコンテキスト処理能力を拡大できます。

- [2023/02] Toolformer:言語モデルは、ツールを使用するように自分自身を教えることができます。 Timo Schick(Meta AI)et al。 arxiv。 [紙]

- Toolformerは、LLMSがAPIごとに少数のデモンストレーションで外部ツールを使用するように自分自身を教えることができることを示しています。

- [2022/05]タルム:ツール拡張言語モデル。アーロン・パリシ(Google)et al。 arxiv。 [紙]

- Talmは、非分化不可能なツールとLMSを組み合わせた方法を導入し、モデルがリアルタイムまたはプライベートデータにアクセスできるようにします。

- [2022/05] MRKLシステム:大規模な言語モデル、外部知識ソース、離散推論を組み合わせたモジュール式の神経腫瘍アーキテクチャ。 Ehud Karpas(AI21 Labs)et al。 arxiv。 [紙]

- MRKL Systemsは、外部の知識と推論モジュールのセットを簡単に拡張できるセットでLLMを増強します。

- [2022/04]できる限り、私が言うように、ロボットアフォーダンスの基礎言語。マイケル・アン(Google)et al。コール。 [紙]

- SayCanは、LLMSの高度なセマンティック知識と事前訓練を受けたスキルの価値関数を組み合わせることにより、実際のロボットタスクにLMSを適用します。

- [2021/12] WebGPT:人間のフィードバックを使用したブラウザ支援の質問。 reiichiro nakano(openai)et al。 arxiv。 [紙]

- WebGptは、ウェブブラウジング環境を使用して質問に答えます。トレーニング中に模倣学習を使用し、人間のフィードバックを通じて回答品質を最適化します。

- [2021/07]コードでトレーニングされた大規模な言語モデルの評価。マークチェン(Openai)et al。 arxiv。 [紙] [コード]

- Codexは、Docstringsのプログラムを合成できます。つまり、ドキュメントに基づいてツールを作成できます。

1.3.2具体化されたアクション

- [2023/12]具体化されたナビゲーションのためのジェネラリストモデルの学習に向けて。 Duo Zheng(香港の中国大学)et al。 arxiv。 [紙] [コード]

- [2023/11] 3D世界で具体化されたジェネラリストエージェント。 Jiangyong Huang(Bigai&Peking University)et al。 arxiv。 [紙] [プロジェクトページ]

- [2023/11] Jarvis-1:メモリが熟成したマルチモーダル言語モデルを備えたオープンワールドマルチタスクエージェント。 Zihao Wang(Peking University)et al。 arxiv。 [紙] [コード]

- [2023/10]レマー:言語エージェントの自然言語とコードを調和させるYiheng Xu(香港大学)et al。 arxiv。 [紙] [コード]

- [2023/10]マルチモーダルの大規模言語モデルを介したエンドツーエンドの具体化された意思決定に向けて:GPT4-VisionおよびBeyond Liang Chen et al。 arxiv。 [紙] [コード]

- [2023/07]インタラクティブな言語:リアルタイムでロボットと話す。 Corey Lynch et al。 IEEE(ral) [紙]

- [2023/05] Voyager:大規模な言語モデルを備えたオープンエンドの具体化されたエージェント。グアンツィ・ワン(Nvidia)et al。 arxiv。 [紙] [プロジェクトページ] [コード]

- [2023/05] Avlen:3D環境でのオーディオビジュアルと言語の具体化されたナビゲーション。 Sudipta Paul et al。ニューリップ。 [紙]

- [2023/05] Embodiedgpt:具体化された思考の連鎖を介したビジョン言語の事前トレーニング。 Yao Mu et al。 arxiv [Paper] [code]

- [2023/05] NAVGPT:大規模な言語モデルを使用したビジョンと言語のナビゲーションにおける明示的な推論。 Gengze Zhou et al。 arxiv [紙]

- [2023/05] Alphablock:ロボット操作におけるビジョン言語の推論のために具体化された微調整。 Chuhao Jin et al。 arxiv [紙]

- [2023/03] Palm-E:具体化されたマルチモーダル言語モデル。 Danny Driess et al。 arxiv。 [紙]

- [2023/03]反射:言語補強学習を伴う言語エージェント。ノア・シンらarxiv [Paper] [code]

- [2023/02]具体化された推論のために言語モデルと協力しています。石田dasgupta et al。 arxiv。 [紙]

- [2023/02]ポリシーとしてのコード:具体化された制御のための言語モデルプログラム。 Jacky Liang et al。 IEEE(ICRA)。 [紙]

- [2022/10] React:言語モデルでの推論と行動を相乗的にします。 Shunyu Yao et al。 arxiv [Paper] [code]

- [2022/10]マルチモーダルトランスを備えた命令に従うエージェント。 Hao Liu et al。 CVPR [Paper] [コード]

- [2022/07]内側の独白:言語モデルとの計画を通じて推論を具体化。 Wenlong Huang et al。 arxiv。 [紙]

- [2022/07] LM-NAV:言語、ビジョン、およびアクションの事前に訓練された大規模なモデルを備えたロボットナビゲーション。 Dhruv Shahet al。 corl [Paper] [code]

- [2022/04]できる限り、私が言うように、ロボットアフォーダンスの基礎言語。マイケル・アン等。 arxiv。 [紙]

- [2022/01]具体化されたAIの調査:シミュレータから研究タスクまで。 Jiafei Duan et al。 IEEE(tetci)。 [紙]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang et al. Arxiv. [紙] [コード]

- [2020/04] Experience Grounds Language. Yonatan Bisk et al. EMNLP [paper]

- [2019/03] Review of Deep Reinforcement Learning for Robot Manipulation. Hai Nguyen et al. IEEE (IRC). [紙]

- [2005/01] The Development of Embodied Cognition: Six Lessons from Babies. Linda Smith et al. Artificial Life. [紙]

2. Agents in Practice: Applications of LLM-based Agents

2.1 General Ability of Single Agent

2.1.1 Task-oriented Deployment

In web scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/07] WebArena: A Realistic Web Environment for Building Autonomous Agents. Shuyan Zhou (CMU) et al. arxiv。 [紙] [コード]

- [2023/07] A Real-World WebAgent with Planning, Long Context Understanding, and Program Synthesis. Izzeddin Gur (DeepMind) et al. arxiv。 [紙]

- [2023/06] SYNAPSE: Leveraging Few-Shot Exemplars for Human-Level Computer Control. Longtao Zheng (Nanyang Technological University) et al. arXiv. [紙] [コード]

- [2023/06] Mind2Web: Towards a Generalist Agent for the Web. Xiang Deng (The Ohio State University) et al. arxiv。 [紙] [コード]

- [2023/05] Multimodal Web Navigation with Instruction-Finetuned Foundation Models. Hiroki Furuta (The University of Tokyo) et al. arXiv. [紙]

- [2023/03] Language Models can Solve Computer Tasks. Geunwoo Kim (University of California) et al. arXiv. [紙] [コード]

- [2022/07] WebShop: Towards Scalable Real-World Web Interaction with Grounded Language Agents. Shunyu Yao (Princeton University) et al. arXiv. [紙] [コード]

- [2021/12] WebGPT: Browser-assisted question-answering with human feedback. Reiichiro Nakano (OpenAI) et al. arXiv. [紙]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [紙] [コード]

- [2024/04] OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

In life scenarios

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] InterAct: Exploring the Potentials of ChatGPT as a Cooperative Agent. Po-Lin Chen et al. arXiv. [紙]

- [2023/05] Plan, Eliminate, and Track -- Language Models are Good Teachers for Embodied Agents. Yue Wu (CMU) et al. arXiv. [紙]

- [2023/05] Augmenting Autotelic Agents with Large Language Models. Cédric Colas (MIT) et al. arXiv. [紙]

- [2023/03] Planning with Large Language Models via Corrective Re-prompting. Shreyas Sundara Raman (Brown University) et al. arXiv. [紙]

- [2022/10] Generating Executable Action Plans with Environmentally-Aware Language Models. Maitrey Gramopadhye (University of North Carolina at Chapel Hill) et al. arXiv. [紙] [コード]

- [2022/01] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents. Wenlong Huang (UC Berkeley) et al. arXiv. [紙] [コード]

2.1.2 Innovation-oriented Deployment

- [2023/10] OpenAgents: An Open Platform for Language Agents in the Wild. XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [demo]

- [2023/08] The Hitchhiker's Guide to Program Analysis: A Journey with Large Language Models. Haonan Li (UC Riverside) et al. arXiv. [紙]

- [2023/08] ChatMOF: An Autonomous AI System for Predicting and Generating Metal-Organic Frameworks. Yeonghun Kang (Korea Advanced Institute of Science and Technology) et al. arXiv. [紙]

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (University College London) et al. arXiv. [紙]

- [2023/06] Towards Autonomous Testing Agents via Conversational Large Language Models. Robert Feldt (Chalmers University of Technology) et al. arXiv. [紙]

- [2023/04] Emergent autonomous scientific research capabilities of large language models. Daniil A. Boiko (CMU) et al. arXiv. [紙]

- [2023/04] ChemCrow: Augmenting large-language models with chemistry tools. Andres M Bran (Laboratory of Artificial Chemical Intelligence, ISIC, EPFL) et al. arXiv. [紙] [コード]

- [2022/03] ScienceWorld: Is your Agent Smarter than a 5th Grader? Ruoyao Wang (University of Arizona) et al. arXiv. [紙] [コード]

2.1.3 Lifecycle-oriented Deployment

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [project page] [code]

- [2023/05] Ghost in the Minecraft: Generally Capable Agents for Open-World Environments via Large Language Models with Text-based Knowledge and Memory. Xizhou Zhu (Tsinghua University) et al. arXiv. [紙] [コード]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2023/02] Describe, Explain, Plan and Select: Interactive Planning with Large Language Models Enables Open-World Multi-Task Agents. Zihao Wang (PKU) et al. arXiv. [紙] [コード]

- [2023/01] Do Embodied Agents Dream of Pixelated Sheep: Embodied Decision Making using Language Guided World Modelling. Kolby Nottingham (University of California Irvine, Irvine) et al. arXiv. [紙] [コード]

2.2 Coordinating Potential of Multiple Agents

2.2.1 Cooperative Interaction for Complementarity

Disordered cooperation

- [2023/07] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration. Zhenhailong Wang (University of Illinois Urbana-Champaign) et al. arXiv. [紙] [コード]

- [2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [紙] [コード]

- [2023/04] ChatLLM Network: More brains, More intelligence. Rui Hao (Beijing University of Posts and Telecommunications) et al. arXiv. [紙]

- [2023/01] Blind Judgement: Agent-Based Supreme Court Modelling With GPT. Sil Hamilton (McGill University). arXiv. [紙]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [紙] [コード]

Ordered cooperation

- [2023/10] AutoAgents: A Framework for Automatic Agent Generation. Guangyao Chen (Peking University) et al. arxiv。 [紙] [コード]

- [2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [紙] [コード]

- [2023/08] CGMI: Configurable General Multi-Agent Interaction Framework. Shi Jinxin (East China Normal University) et al. arxiv。 [紙]

- [2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arXiv. [紙] [コード]

- [2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [紙] [コード]

- [2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University ) et al. arXiv. [紙] [コード]

- [2023/08] MetaGPT: Meta Programming for Multi-Agent Collaborative Framework. Sirui Hong (DeepWisdom) et al. arXiv. [紙] [コード]

- [2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [紙] [コード]

- [2023/06] Multi-Agent Collaboration: Harnessing the Power of Intelligent LLM Agents. Yashar Talebira (University of Alberta) et al. arXiv. [紙]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [紙] [コード]

- [2023/05] SwiftSage: A Generative Agent with Fast and Slow Thinking for Complex Interactive Tasks. Bill Yuchen Lin (Allen Institute for Artificial Intelligence) et al. arxiv。 [紙] [コード]

- [2023/05] ChatGPT as your Personal Data Scientist. Md Mahadi Hassan (Auburn University) et al. arXiv. [紙]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [紙] [コード]

- [2023/03] DERA: Enhancing Large Language Model Completions with Dialog-Enabled Resolving Agents. Varun Nair (Curai Health) et al. arXiv. [紙] [コード]

- [2023/04] Self-collaboration Code Generation via ChatGPT. Yihong Dong (Peking University) et al. arXiv. [紙]

2.2.2 Adversarial Interaction for Advancement

- [2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arxiv。 [紙] [コード]

- [2023/05] Improving Factuality and Reasoning in Language Models through Multiagent Debate. Yilun Du (MIT CSAIL) et al. arXiv. [紙] [コード]

- [2023/05] Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback. Yao Fu (University of Edinburgh) et al. arXiv. [紙] [コード]

- [2023/05] Examining the Inter-Consistency of Large Language Models: An In-depth Analysis via Debate. Kai Xiong (Harbin Institute of Technology) et al. arXiv. [紙]

- [2023/05] Encouraging Divergent Thinking in Large Language Models through Multi-Agent Debate. Tian Liang (Tsinghua University) et al. arXiv. [紙] [コード]

2.3 Interactive Engagement between Human and Agent

2.3.1 Instructor-Executor Paradigm

教育

- [2023/07] Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics. Melanie Swan (UCL) et al. arXiv. [紙]

- Communicate with humans to help them understand and use mathematics.

- [2023/03] Hey Dona! Can you help me with student course registration? Vishesh Kalvakurthi (MSU) et al. arXiv. [紙]

- This is a developed application called Dona that offers virtual voice assistance in student course registration, where humans provide instructions.

健康

- [2023/08] Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue. Songhua Yang (ZZU) et al. arXiv. [紙] [コード]

- [2023/05] HuatuoGPT, towards Taming Language Model to Be a Doctor. Hongbo Zhang (CUHK-SZ) et al. arXiv. [paper] [code] [demo]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [紙]

- [2020/10] A Virtual Conversational Agent for Teens with Autism Spectrum Disorder: Experimental Results and Design Lessons. Mohammad Rafayet Ali (U of R) et al. IVA '20. [紙]

Other Application

- [2023/08] RecMind: Large Language Model Powered Agent For Recommendation. Yancheng Wang (ASU, Amazon) et al. arXiv. [紙]

- [2023/08] Multi-Turn Dialogue Agent as Sales' Assistant in Telemarketing. Wanting Gao (JNU) et al. IEEE. [紙]

- [2023/07] PEER: A Collaborative Language Model. Timo Schick (Meta AI) et al. arxiv。 [紙]

- [2023/07] DIALGEN: Collaborative Human-LM Generated Dialogues for Improved Understanding of Human-Human Conversations. Bo-Ru Lu (UW) et al. arXiv. [紙]

- [2023/08] LLM As DBA [vision]. Xuanhe Zhou (Tsinghua) et al. arXiv. [紙]

- [2023/06] AssistGPT: A General Multi-modal Assistant that can Plan, Execute, Inspect, and Learn. Difei Gao (NUS) et al. arXiv. [紙]

- [2023/05] Agents: An Open-source Framework for Autonomous Language Agents. Wangchunshu Zhou (AIWaves) et al. arXiv. [紙] [コード]

- [2023/12] D-Bot: Database Diagnosis System using Large Language Models. Xuanhe Zhou (Tsinghua) et al. arXiv. [紙] [コード]

2.3.2 Equal Partnership Paradigm

Empathetic Communicator

- [2023/08] SAPIEN: Affective Virtual Agents Powered by Large Language Models. Masum Hasan et al. arXiv. [paper] [project page]

- [2023/05] Helping the Helper: Supporting Peer Counselors via AI-Empowered Practice and Feedback. Shang-Ling Hsu (Gatech) et al. arXiv. [紙]

- [2022/07] Artificial empathy in marketing interactions: Bridging the human-AI gap in affective and social customer experience. Yuping Liu‑Thompkins et al. [紙]

Human-Level Participant

- [2023/08] Quantifying the Impact of Large Language Models on Collective Opinion Dynamics. Chao Li et al. CoRR. [紙]

- [2023/06] Mastering the Game of No-Press Diplomacy via Human-Regularized Reinforcement Learning and Planning. Anton Bakhtin et al. ICLR. [紙]

- [2023/06] Decision-Oriented Dialogue for Human-AI Collaboration. Jessy Lin et al. CoRR. [紙]

- [2022/11] Human-level play in the game of Diplomacy by combining language models with strategic reasoning. FAIR et al.科学。 [紙]

3. Agent Society: From Individuality to Sociality

3.1 Behavior and Personality of LLM-based Agents

3.1.1 Social Behavior

Individual behaviors

- [2023/10] Lyfe Agents: Generative agents for low-cost real-time social interactions. Zhao Kaiya (MIT) et al. arXiv. [紙]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arXiv. [paper] [code] [project page]

- [2023/04] LLM+P: Empowering Large Language Models with Optimal Planning Proficiency. Bo Liu (University of Texas) et al. arXiv. [紙] [コード]

- [2023/03] Reflexion: Language Agents with Verbal Reinforcement Learning. Noah Shinn (Northeastern University) et al. arXiv. [紙] [コード]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2023/03] ReAct: Synergizing Reasoning and Acting in Language Models. Shunyu Yao (Princeton University) et al. ICLR. [paper] [project page]

- [2022/01] Chain-of-thought prompting elicits reasoning in large language models. Jason Wei (Google) et al. NeurIPS. [紙]

Group behaviors

[2023/10] Exploring Collaboration Mechanisms for LLM Agents: A Social Psychology View. Jintian Zhang (Zhejiang University) et al. arXiv. [紙] [コード]

[2023/09] MindAgent: Emerging Gaming Interaction. Ran Gong (UCLA) et al. arXiv. [紙] [コード]

[2023/09] Exploring Large Language Models for Communication Games: An Empirical Study on Werewolf. Yuzhuang Xu (Tsinghua University) et al. arXiv. [紙]

[2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [紙]

[2023/08] AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents. Weize Chen (Tsinghua University) et al. arXiv. [紙] [コード]

[2023/08] AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation Framework. Qingyun Wu (Pennsylvania State University) et al. arxiv。 [紙] [コード]

[2023/08] ChatEval: Towards Better LLM-based Evaluators through Multi-Agent Debate. Chi-Min Chan (Tsinghua University) et al. arXiv. [紙] [コード]

[2023/07] Communicative Agents for Software Development. Chen Qian (Tsinghua University) et al. arXiv. [紙] [コード]

[2023/07] RoCo: Dialectic Multi-Robot Collaboration with Large Language Models. Zhao Mandi, Shreeya Jain, Shuran Song (Columbia University) et al. arXiv. [紙] [コード]

[2023/08] ProAgent: Building Proactive Cooperative AI with Large Language Models. Ceyao Zhang (The Chinese University of Hong Kong, Shenzhen) et al. arxiv。 [紙] [コード]

[2023/06] Homophily in An Artificial Social Network of Agents Powered By Large Language Models. James K. He (University of Cambridge) et al. PsyArXiv. [紙]

3.1.2 Personality

認知

- [2023/09] Suspicion Agent: Playing Imperfect Information Games with Theory of Mind Aware GPT-4 Jiaxian Gu oet al. arXiv. [紙]

- [2023/03] Machine Psychology: Investigating Emergent Capabilities and Behavior in Large Language Models Using Psychological Methods. Thilo Hagendorff (University of Stuttgart) et al. arXiv. [紙]

- [2023/03] Mind meets machine: Unravelling GPT-4's cognitive psychology. Sifatkaur Dhingra (Nowrosjee Wadia College) et al. arXiv. [紙]

- [2022/07] Language models show human-like content effects on reasoning. Ishita Dasgupta (DeepMind) et al. arxiv。 [紙]

- [2022/06] Using cognitive psychology to understand GPT-3. Marcel Binz et al. arXiv. [紙]

感情

- [2023/07] Emotional Intelligence of Large Language Models. Xuena Wang (Tsinghua University) et al. arXiv. [紙]

- [2023/05] ChatGPT outperforms humans in emotional awareness evaluations. Zohar Elyoseph et al. Frontiers in Psychology. [紙]

- [2023/02] Empathetic AI for Empowering Resilience in Games. Reza Habibi (University of California) et al. arXiv. [紙]

- [2022/12] Computer says “No”: The Case Against Empathetic Conversational AI. Alba Curry (University of Leeds) et al. ACL. [紙]

キャラクター

- [2024/05] TimeChara: Evaluating Point-in-Time Character Hallucination of Role-Playing Large Language Models. Jaewoo Ahn (Seoul National University) et al. arXiv. [紙] [コード]

- [2023/10] Character-LLM: A Trainable Agent for Role-Playing. Yunfan Shao (Fudan University) et al. arxiv。 [紙] [コード]

- [2023/07] Do LLMs Possess a Personality? Making the MBTI Test an Amazing Evaluation for Large Language Models. Keyu Pan (ByteDance) et al. arXiv. [紙] [コード]

- [2023/07] Personality Traits in Large Language Models. Mustafa Safdari (DeepMind) et al. arXiv. [紙] [コード]

- [2022/12] Does GPT-3 Demonstrate Psychopathy? Evaluating Large Language Models from a Psychological Perspective. Xingxuan Li (Alibaba) et al. arXiv. [紙]

- [2022/12] Identifying and Manipulating the Personality Traits of Language Models. Graham Caron et al. arXiv. [紙]

3.2 Environment for Agent Society

3.2.1 Text-based Environment

- [2023/08] Hoodwinked: Deception and Cooperation in a Text-Based Game for Language Models. Aidan O'Gara (University of Southern California) et al. arXiv. [紙] [コード]

- [2023/03] CAMEL: Communicative Agents for "Mind" Exploration of Large Scale Language Model Society. Guohao Li (King Abdullah University of Science and Technology) et al. arXiv. [紙] [コード]

- [2020/12] Playing Text-Based Games with Common Sense. Sahith Dambekodi (Georgia Institute of Technology) et al. arXiv. [紙]

- [2019/09] Interactive Fiction Games: A Colossal Adventure. Matthew Hausknecht (Microsoft Research) et al. AAAI. [紙] [コード]

- [2019/03] Learning to Speak and Act in a Fantasy Text Adventure Game. Jack Urbanek (Facebook) et al. ACL. [紙] [コード]

- [2018/06] TextWorld: A Learning Environment for Text-based Games. Marc-Alexandre Côté (Microsoft Research) et al. IJCAI. [紙] [コード]

3.2.2 Virtual Sandbox Environment

- [2023/11] JARVIS-1: Open-world Multi-task Agents with Memory-Augmented Multimodal Language Models. ZiHao Wang (Peking University) et al. arXiv. [紙] [コード]

- [2023/10] Humanoid Agents: Platform for Simulating Human-like Generative Agents. Zhilin Wang (University of Washington and NVIDIA) et al. arXiv. [paper] [code] [demo]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arxiv。 [紙] [コード]

- [2023/05] Voyager: An Open-Ended Embodied Agent with Large Language Models. Guanzhi Wang (NVIDIA) et al. arxiv。 [paper] [project page] [code]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [紙] [コード]

- [2023/03] Plan4MC: Skill Reinforcement Learning and Planning for Open-World Minecraft Tasks. Haoqi Yuan (PKU) et al. arXiv. [paper] [project page]

- [2022/06] MineDojo: Building Open-Ended Embodied Agents with Internet-Scale Knowledge. Linxi Fan (NVIDIA) et al. NeurIPS. [paper] [project page]

3.2.3 Physical Environment

- [2023/11] An Embodied Generalist Agent in 3D World. Jiangyong Huang (BIGAI & Peking University) et al. arXiv. [paper] [project page]

- [2023/09] RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking. Homanga Bharadhwaj (Carnegie Mellon University) et al. arXiv. [paper] [project page]

- [2023/05] AVLEN: Audio-Visual-Language Embodied Navigation in 3D Environments. Sudipta Paul et al. NeurIPS. [紙]

- [2023/03] PaLM-E: An Embodied Multimodal Language Model. Danny Driess (Google) et al. ICML. [paper] [project page]

- [2022/10] Interactive Language: Talking to Robots in Real Time. Corey Lynch (Google) et al. arXiv. [紙] [コード]

3.3 Society Simulation with LLM-based Agents

- [2024/03] Emergence of Social Norms in Large Language Model-based Agent Societies. Siyue Ren et al. arXiv. [紙] [コード]

- [2023/08] AgentSims: An Open-Source Sandbox for Large Language Model Evaluation. Jiaju Lin (PTA Studio) et al. arXiv. [paper] [project page] [code]

- [2023/07] S 3 : Social-network Simulation System with Large Language Model-Empowered Agents. Chen Gao (Tsinghua University) et al. arXiv. [紙]

- [2023/07] Epidemic Modeling with Generative Agents. Ross Williams (Virginia Tech) et al. arXiv. [紙] [コード]

- [2023/06] RecAgent: A Novel Simulation Paradigm for Recommender Systems. Lei Wang (Renmin University of China) et al. arXiv. [紙]

- [2023/05] Training Socially Aligned Language Models in Simulated Human Society. Ruibo Liu (Dartmouth College) et al. arXiv. [紙] [コード]

- [2023/04] Generative Agents: Interactive Simulacra of Human Behavior. Joon Sung Park (Stanford University) et al. arXiv. [paper] [code]

- [2022/08] Social Simulacra: Creating Populated Prototypes for Social Computing Systems. Joon Sung Park (Stanford University) et al. UIST. [紙]

4. Other Topics

4.1 Benchmarks for LLM-based Agents

- [2023/11] "MAgIC: Investigation of Large Language Model Powered Multi-Agent in Cognition, Adaptability, Rationality and Collaboration." Lin Xu et al. (NUS, ByteDance, Stanford & UC Berkeley) arXiv. [paper] [Project Page] [Code]

- The work presents a benchmarking framework for evaluating LLMs in multi-agent settings, showing a 50% average improvement using Probabilistic Graphical Modeling.

- [2023/10] "Benchmarking Large Language Models As AI Research Agents." Qian Huang (Stanford) et al. arXiv. [paper] [code]

- [2023/08] "AgentBench: Evaluating LLMs as Agents." Xiao Liu (THU) et al. arXiv. [paper] [code] [project page]

- AGENTBENCH, a benchmark for assessing LLMs as agents, shows a performance gap between top commercial and open-source models.

- [2023/10] "SmartPlay : A Benchmark for LLMs as Intelligent Agents." Yue Wu (CMU & Microsoft) et al. arXiv. [paper] [code]

- SmartPlay is a benchmark and methodology for evaluating LLMs as intelligent agents, featuring six diverse games to assess key capabilities, providing a roadmap for identifying gaps in current methodologie

- [2024/04] "OSWorld: Benchmarking Multimodal Agents for Open-Ended Tasks in Real Computer Environments." XLang Lab (The University of Hong Kong) arXiv. [paper] [project page] [code] [data viewer]

- OSWorld is a unified, real computer environment for multimodal agents to benchmark open-ended computer tasks with arbitrary apps and interfaces on Ubuntu, Windows, & macOS.

4.2 Training and Optimizing LLM-based Agents

- [2024/06] AgentGym: Evolving Large Language Model-based Agents across Diverse Environments. Zhiheng Xi (Fudan University) et al. arXiv. [paper] [project page] [codes and platform] [dataset] [benchmark] [model].

- [2023/10] FireAct: Toward Language Agent Fine-tuning. Baian Chen (System2 Research) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] AgentTuning: Enabling Generalized Agent Abilities for LLMs. Aohan Zeng (Tsinghua University) et al. arXiv. [paper] [project page] [code] [dataset]

- [2023/10] Lemur: Harmonizing Natural Language and Code for Language Agents Yiheng Xu (University of Hong Kong) et al. arXiv. [paper] [code]

引用

If you find this repository useful, please cite our paper:

@misc{xi2023rise,

title={The Rise and Potential of Large Language Model Based Agents: A Survey},

author={Zhiheng Xi and Wenxiang Chen and Xin Guo and Wei He and Yiwen Ding and Boyang Hong and Ming Zhang and Junzhe Wang and Senjie Jin and Enyu Zhou and Rui Zheng and Xiaoran Fan and Xiao Wang and Limao Xiong and Yuhao Zhou and Weiran Wang and Changhao Jiang and Yicheng Zou and Xiangyang Liu and Zhangyue Yin and Shihan Dou and Rongxiang Weng and Wensen Cheng and Qi Zhang and Wenjuan Qin and Yongyan Zheng and Xipeng Qiu and Xuanjing Huang and Tao Gui},

year={2023},

eprint={2309.07864},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

Project Maintainers & Contributors

- Zhiheng Xi (奚志恒, @WooooDyy)

- Wenxiang Chen (陈文翔, @chenwxOggai)

- Xin Guo (郭昕, @XinGuo2002)

- Wei He(何为, @hewei2001)

- Yiwen Ding (丁怡文, @Yiwen-Ding)

- Boyang Hong(洪博杨, @HongBoYang)

- Ming Zhang (张明, @KongLongGeFDU)

- Junzhe Wang(王浚哲, @zsxmwjz)

- Senjie Jin(金森杰, @Leonnnnnn929)

接触

星の歴史