transformer pointer generator

1.0.0

当我想通过神经网络获得摘要时,我尝试了许多方法来生成摘要,但是结果不好。当我听到2018年字节杯时,我找到了一些有关它的信息,冠军的解决方案吸引了我,但是我找到了一些网站,例如Github Gitlab,我没有找到官方代码,因此我决定实施它。

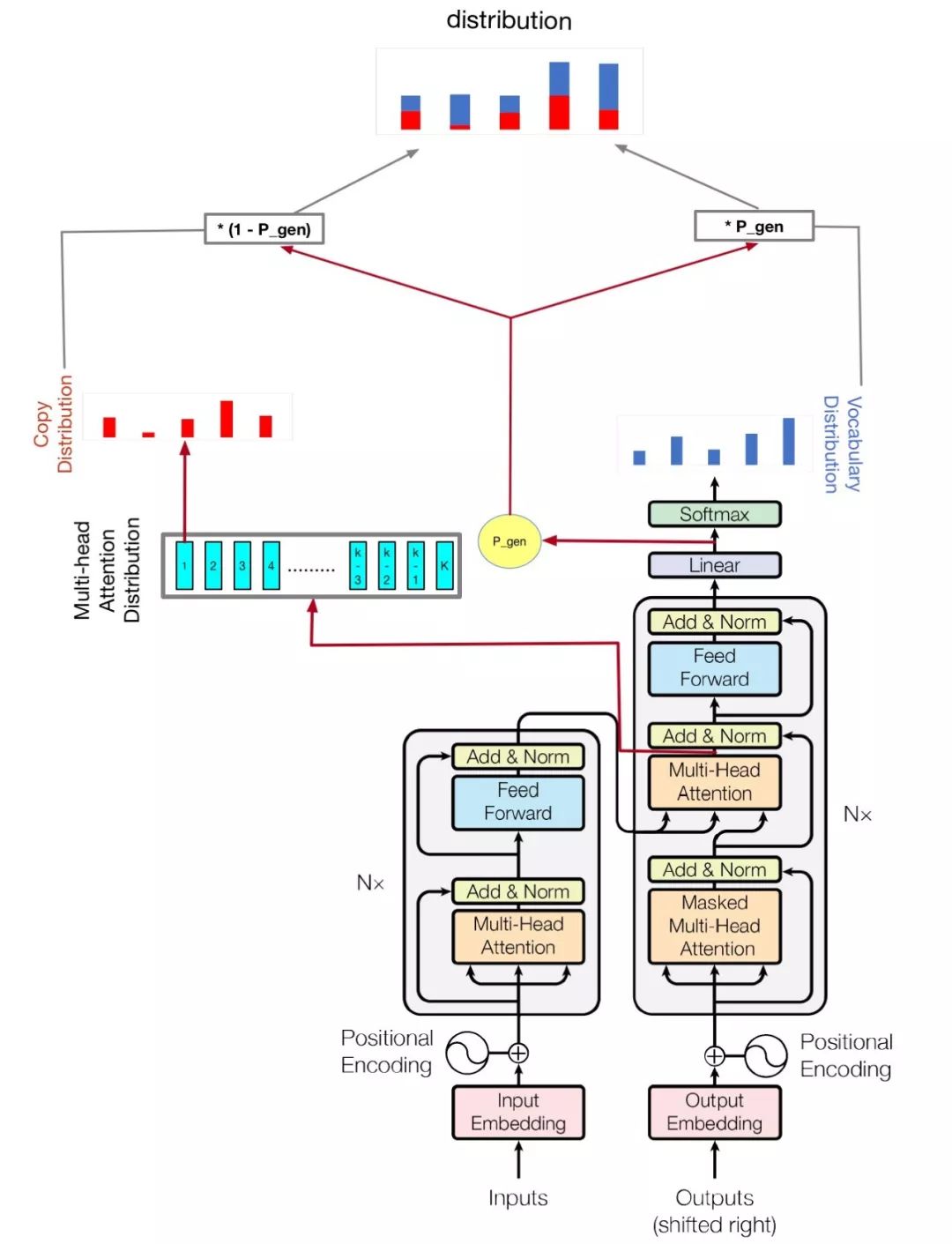

我的模型是基于注意的是您所需要的,并提到了:用指针生成网络汇总

python train.py

检查hparams.py以查看可能的参数。例如,

python train.py --logdir myLog --batch_size 32 --train myTrain --eval myEval

我的代码还可以改善多GPU来训练该模型,如果您有一个以上的GPU,就这样运行

python train.py --logdir myLog --batch_size 32 --train myTrain --eval myEval --gpu_nums=myGPUNums

| 姓名 | 类型 | 细节 |

|---|---|---|

| vocab_size | int | 词汇大小 |

| 火车 | str | 火车数据集DIR |

| 评估 | str | DEAD DATASET DIR |

| 测试 | str | 计算胭脂分数的数据 |

| 词汇 | str | 词汇文件路径 |

| batch_size | int | 火车批次尺寸 |

| eval_batch_size | int | 评估批处理大小 |

| LR | 漂浮 | 学习率 |

| 热身_STEPS | int | 通过学习率的热身步骤 |

| logdir | str | 日志目录 |

| num_epochs | int | 火车时代的数量 |

| 评估 | str | 评估dir |

| d_model | int | 编码器/解码器的隐藏尺寸 |

| D_FF | int | 馈电层的隐藏尺寸 |

| num_blocks | int | 编码器/解码器块的数量 |

| num_heads | int | 注意力头数 |

| maxlen1 | int | 源序列的最大长度 |

| maxlen2 | int | 目标序列的最大长度 |

| dropout_rate | 漂浮 | 辍学率 |

| beam_size | int | 梁尺寸的解码 |

| gpu_nums | int | GPU金额,可以允许多少GPU训练此模型,默认1 |

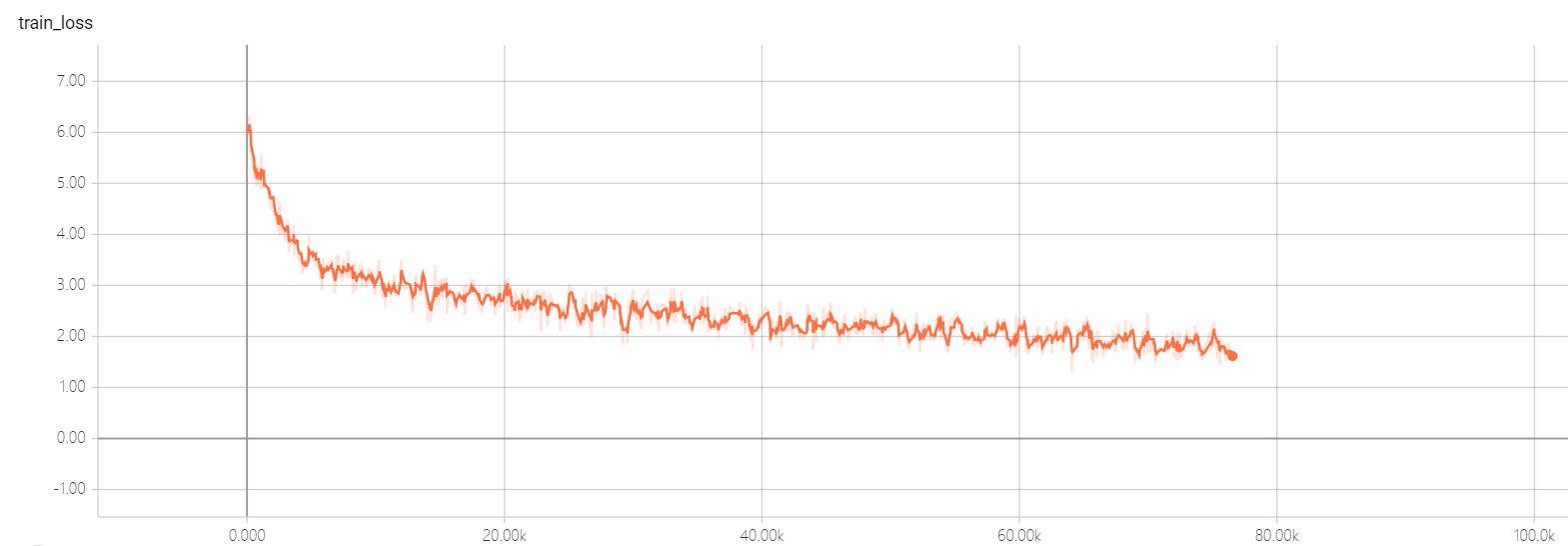

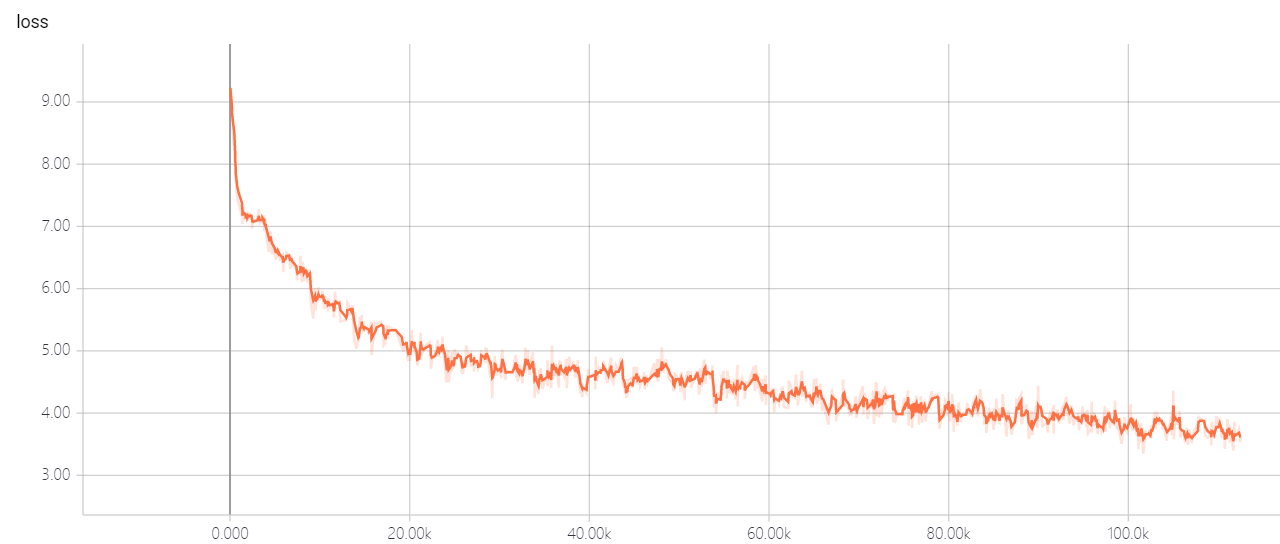

不要更改变压器的超参数,您有很好的解决方案,它会让损失无法消失!如果您有好的解决方案,希望您能告诉我。