Когда я хотел получить краткое изложение по нейронной сети, я попытался много способов генерировать абстрактное резюме, но результат был не очень хорошим. Когда я услышал кубок байта 2018 года, я нашел некоторую информацию об этом, и решение чемпиона привлекло меня, но я нашел несколько веб -сайтов, таких как Github Gitlab, я не нашел официальный код, поэтому я решил его реализовать.

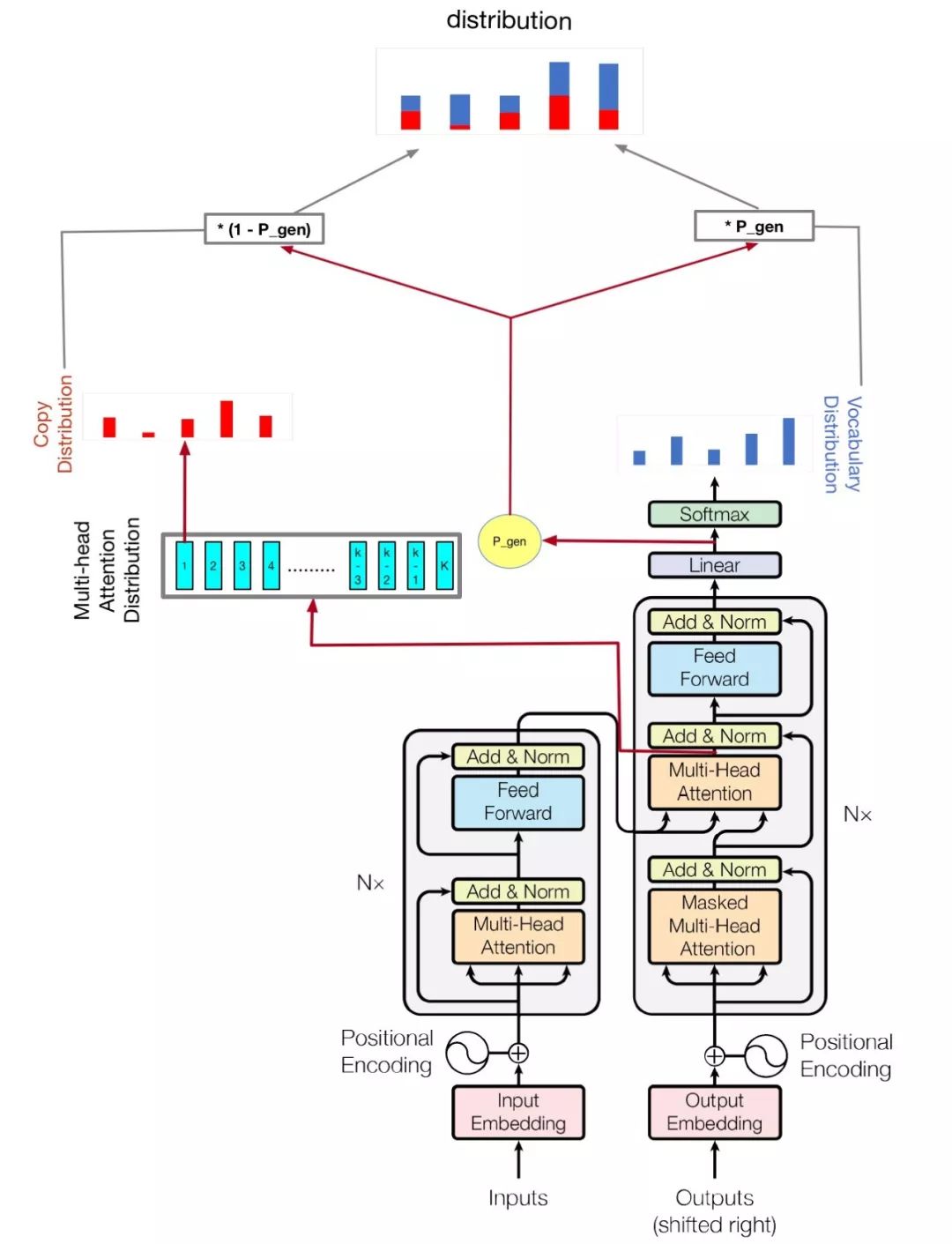

Моя модель основана на внимании-все, что вам нужно, и добраться до сути: суммирование с сети с указателями-генераторами

python train.py

Проверьте hparams.py , чтобы увидеть, какие параметры возможны. Например,

python train.py --logdir myLog --batch_size 32 --train myTrain --eval myEval

Мой код также улучшает многолетний графический процессор для обучения этой модели, если у вас более одного графического процессора, просто запустите так

python train.py --logdir myLog --batch_size 32 --train myTrain --eval myEval --gpu_nums=myGPUNums

| имя | тип | деталь |

|---|---|---|

| vocab_size | инт | размер слока |

| тренироваться | стр | Набор данных поезда |

| оценка | стр | Оценка набора данных Dir |

| тест | стр | Данные для расчета балла Rouge |

| слока | стр | Словарный файл путь |

| batch_size | инт | Размер партии поезда |

| eval_batch_size | инт | Оценка размера партии |

| лр | плавать | скорость обучения |

| Demplup_steps | инт | Шаги разминки путем обучения скорости |

| logdir | стр | Справочник журнала |

| num_epochs | инт | количество эпохи поезда |

| Евальдир | стр | Оценка реж |

| d_model | инт | Скрытое измерение энкодера/декодера |

| d_ff | инт | Скрытый размер питательного слоя |

| num_blocks | инт | Количество блоков энкодера/декодера |

| num_heads | инт | Количество головок внимания |

| maxlen1 | инт | максимальная длина исходной последовательности |

| maxlen2 | инт | максимальная длина целевой последовательности |

| DEPLOUT_RATE | плавать | Скорость отсева |

| beam_size | инт | размер луча для декодирования |

| GPU_NUMS | инт | Сумма графического процессора, которая может позволить, сколько графического процессора обучать эту модель , по умолчанию 1 |

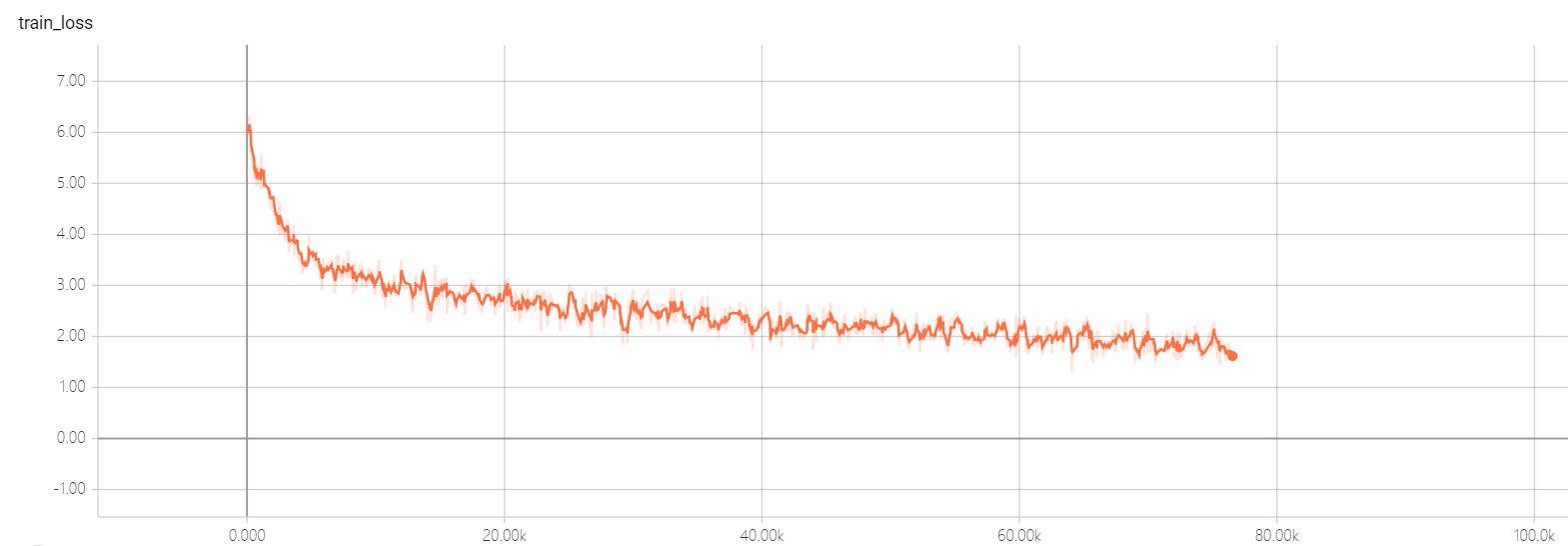

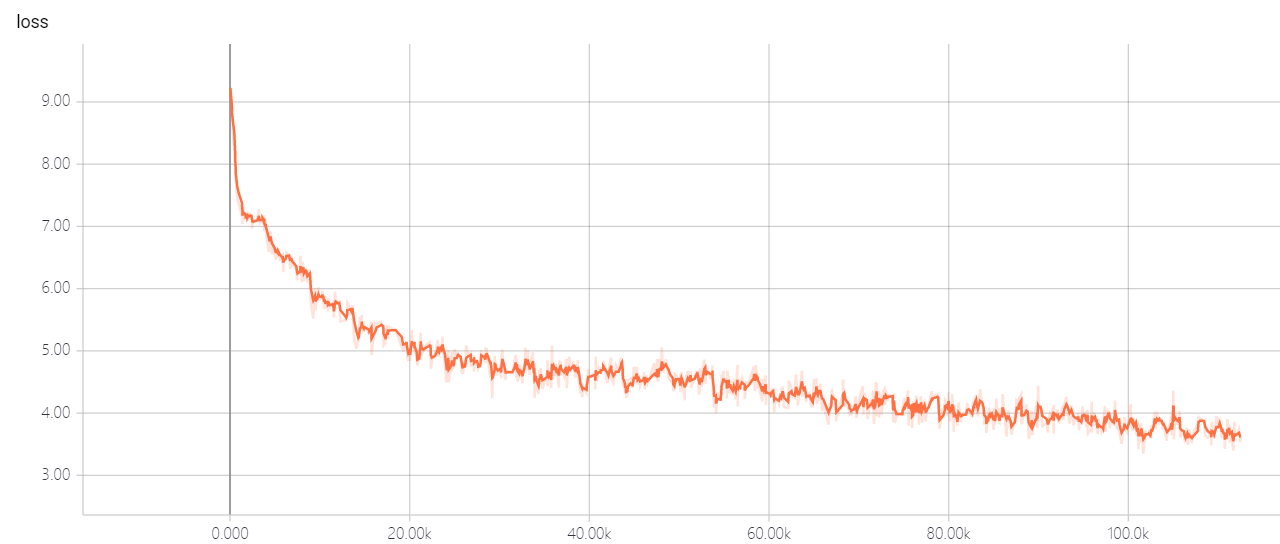

Не меняйте гиперпараметры утилита трансформатора, у вас есть хорошее решение, оно позволит потере не может выйти! Если у вас есть хорошее решение, я надеюсь, что вы можете мне сказать.