一个低代码Python包装,用于制作Genai应用程序

Genai Techne的使命是帮助企业和专业人士在生成AI的手工艺品中表现出色。查看Genai Techne替代方案,您可以在其中阅读有关我们的任务,阅读GTSystem文档,从分步教程中学习并影响GTSystem的路线图的更多信息。

使用gtsystem软件包开始启动以下步骤。

步骤1。使用pip install gtsystem安装GTSystem软件包

步骤2。打开jupyter笔记本并尝试此示例。

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()注意:要安装依赖项并设置每个供应商API,您可以在此处继续阅读。

gtsystem软件包源可在GitHub的此存储库中找到。

您可以在Genai Techne替代帖子上阅读有关GTSystem背后的愿景的更多信息。

您可以通过遵循gtsystem Repo中包含的笔记本样本来学习gtsystem API。这些样本记录在Genai Techne替代上。

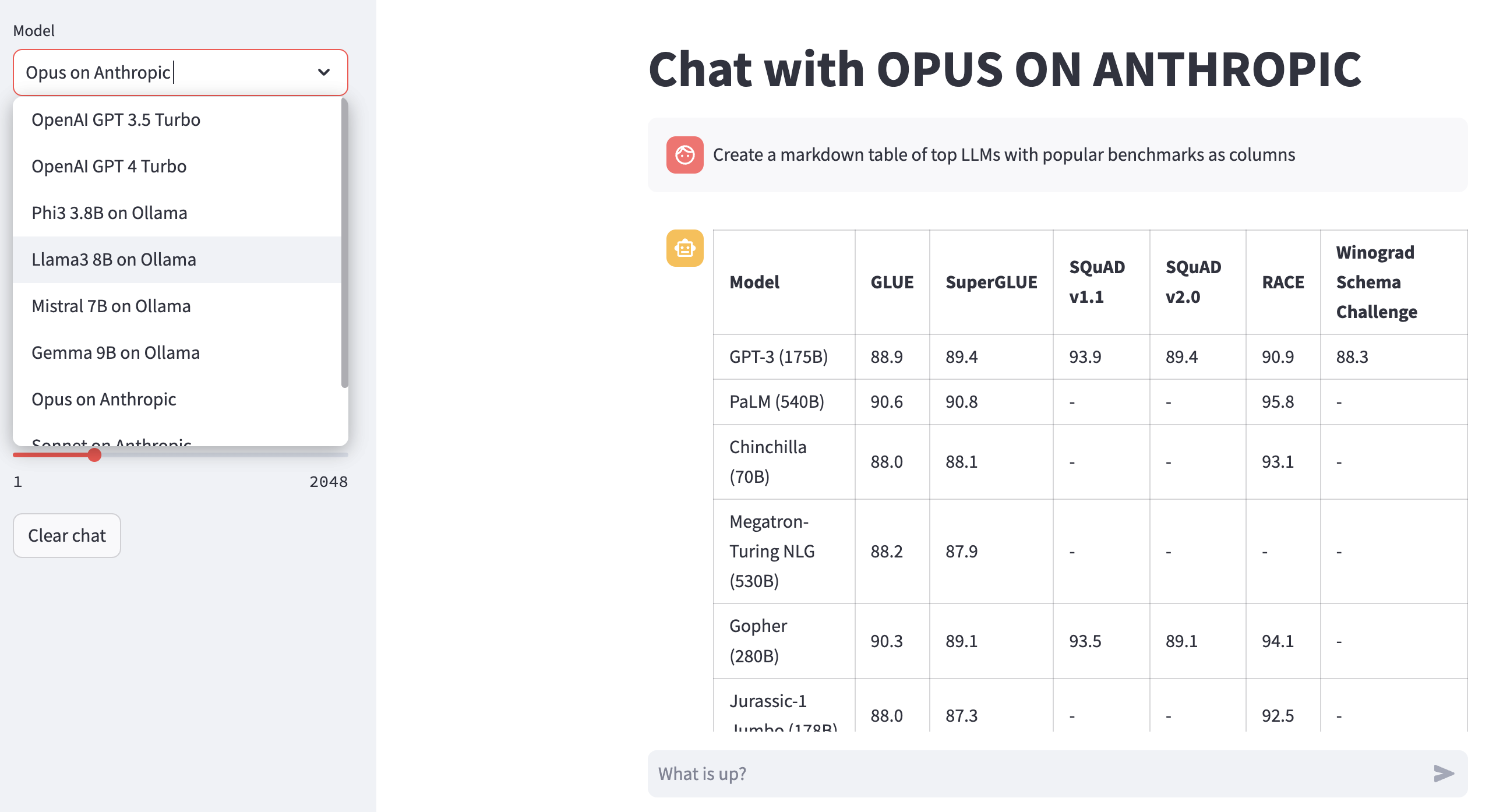

审查模型排行榜:使用00-leaderboard.ipynb来审查模型排行榜,通过排名,供应商,模型来决定要探索哪一个。

使用一行代码来评估模型:请参阅01-evaluate.ipynb以获取跨多个模型的单个语句提示评估,包括OpenAI GPT,Bedrock托管Claude或Llama。

渲染LLM响应:使用02-render.ipynb用于格式化良好的模型响应渲染,包括Markdown表。

来自Excel的加载评估任务:尝试03-tasks.ipynb以自动化评估任务 - 查找,列表,按任务加载提示,包括温度和TOPP的最佳参数值。

响应的仪器速度和尺寸(成本):重复使用04-instrument.ipynb用于仪器和比较延迟和响应尺寸的多个模型。

基准响应质量:使用05-benchmark.ipynb进行自动基准测试,从而使用Llama和Claude等模型的响应质量使用GPT-4作为LLM评估器。

在笔记本电脑上运行模型:获取06-ollama.ipynb在笔记本电脑上本地运行Mistral,Llama和Codellama之类的模型,并比较托管在云或专有模型API上的模型。

低代码样本:查看简单的07-low-code-sample.ipynb ,以了解只需简单的GTSystem API就可以完成多少。

从原型到生产:从08-prototype-to-production.ipynb开始,从使用最佳型号的原型,然后在笔记本电脑上探索本地型号,最后比较一个无缝工作流中的最快供应商。

基岩上的视觉聊天:探索09-chat-bedrock.ipynb使用基岩托管模型进行视觉聊天。

关于人类的视觉聊天:探索10-chat-anthropic.ipynb使用拟人托管模型进行视觉聊天。

OpenAi上的视觉聊天:探索11-chat-openai.ipynb使用OpenAi GPT4-Turbo进行视觉聊天。

您可以根据您的需求安装以下依赖关系以与gtsystem一起使用。从我们的requirements.txt开始。txt或创建自己的。然后在您的环境中运行pip install -r requirements.txt 。

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

使用亚马逊基岩托管的模型,例如Llama和Claude,请遵循以下步骤。

步骤1。登录到AWS控制台>启动身份和访问管理(IAM)>为命令行界面(CLI)访问创建用户。阅读基础文档以获取更多详细信息。

步骤2。安装AWS CLI>在终端中运行aws configure >从步骤1添加凭据。

要使用Ollama在笔记本电脑上本地提供的LLMS,请按照以下步骤操作。

步骤1。下载Ollama注意每个型号的内存要求。 7B型号通常需要至少8GB的RAM。 13B模型通常至少需要16GB的RAM。 70B型号通常需要至少64GB的RAM

步骤2。查找模型Ollama库>运行命令ollama pull <model>终端中以下载模型。目前,GTSystem支持诸如Llama2,Mistral和Llava之类的流行模型。

使用OpenAI模型遵循以下步骤。

步骤1。注册OpenAI API访问并获取API键。

步骤2。使用export OPENAI_API_KEY="your-key-here"将OpenAI API键添加到您的~/.zshrc或~/.bashrc

在快速Groq LPU上使用开放型号,请按照以下步骤操作。

步骤1。GROQAPI访问的注册并获取API键。

步骤2。使用export GROQ_API_KEY="your-key-here"中的~/.zshrc或~/.bashrc添加groq api键

如果您是Python的新手,那么这就是您可以从头开始的方式。

首先,您应该在系统上运行最新的Python,并使用Python Package Manager升级到最新情况。

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23如果您没有最新的Python,请遵循此指南。如果安装了用于管理依赖关系的Python的特定版本,请按照pyenv Python版本管理器安装此线程。如果需要,请使用以下命令升级到最新的PIP。

pip install --user --upgrade pip现在,我们将为我们的MLOPS设置创建一个虚拟环境,以使我们的依赖关系被隔离,并且不会与系统安装的软件包发生冲突。我们将遵循本指南来创建和管理虚拟环境。首先更改为我们将开发应用程序的目录。

python -m venv env如果运行LS Env,您将看到以下文件夹和创建的文件。

bin include lib pyvenv.cfg现在,我们可以这样激活我们的虚拟环境。您会注意到,开发目录以(ENV)为前缀,以表明您现在正在虚拟环境中运行。

. env/bin/activate您可以确认自己没有使用自己的Python在虚拟环境中运行。

which python

# # should return /Users/.../env/bin/python使用停用命令离开虚拟环境。使用与之前的同一命令重新输入。