Um pacote Python baixo para criar aplicativos Genai rapidamente

A Genai Techne está em uma missão para ajudar a empresas e os profissionais a se destacarem no ofício de IA generativa. Confira o Genai Techne Substack, onde você pode ler mais sobre nossa missão, ler a documentação do GTSystem, aprender com os tutoriais passo a passo e influenciar o roteiro do GTSYSTEM para seus casos de uso.

Comece a usar o pacote gtsystem segue estas etapas.

Etapa 1. Instale o pacote gtsystem usando pip install gtsystem

Etapa 2. Abra um notebook Jupyter e tente esta amostra.

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()Nota: Para instalar as dependências e configurar cada uma das APIs do fornecedor, você pode continuar lendo aqui.

A fonte do pacote gtsystem está disponível neste repositório no GitHub.

Você pode ler mais sobre a visão por trás do GTSystem na postagem do Genai Techne Substack.

Você pode aprender a API gtsystem , seguindo as amostras de notebook incluídas no repositório gtsystem . Essas amostras estão documentadas na subest de genai techne.

Revisão do modelo de líder do modelo: use 00-leaderboard.ipynb para revisar a tabela de classificação do modelo, filtrar por classificação, fornecedores, modelos para decidir qual deles explorar.

Avalie os modelos usando uma linha de código: consulte 01-evaluate.ipynb para avaliações de prompt de instrução única em vários modelos, incluindo o OpenAI GPT, o Bedrock hospedado em Claude ou Llama.

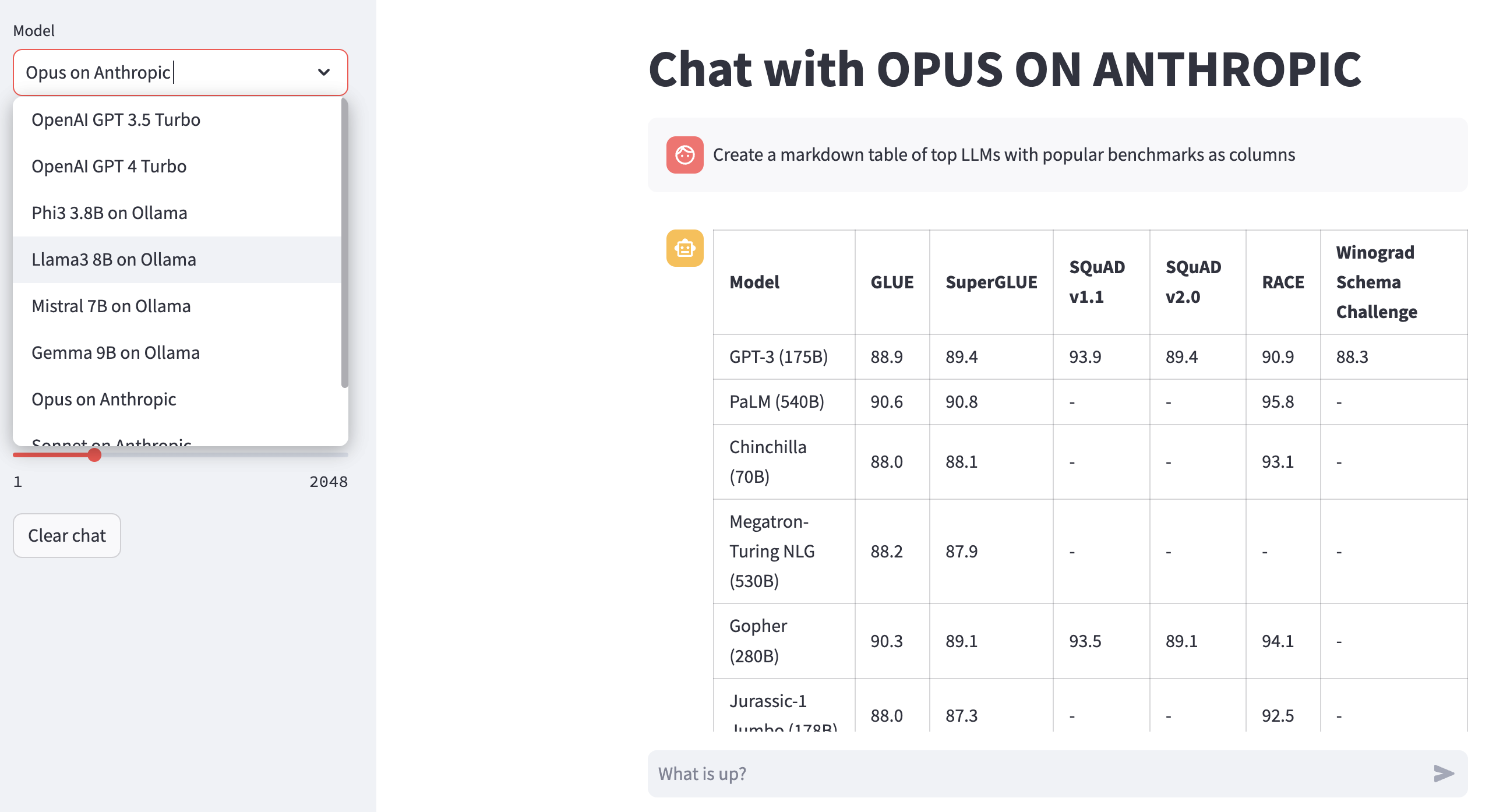

Respostas renderizadas LLM: use 02-render.ipynb para uma renderização bem formatada das respostas do modelo, incluindo tabelas de remarca.

Carregar tarefas de avaliação do Excel: tente 03-tasks.ipynb para automatizar tarefas de avaliação - Localizar, listar, carregar prompts por tarefa, incluindo valores ideais de parâmetros para temperatura e Topp.

Velocidade e tamanho do instrumento (custo) da resposta: Reutilize 04-instrument.ipynb para instrumentar e comparar vários modelos na latência e tamanho da resposta.

Qualidade da resposta de referência: use 05-benchmark.ipynb para obter a qualidade das respostas de benchmarking automatizada de modelos como llama e claude usando o GPT-4 como avaliador LLM.

Execute modelos no seu laptop: obtenha 06-ollama.ipynb para executar modelos como Mistral, Llama e Codellama localmente no seu laptop e comparar modelos hospedados em APIs de modelo ou modelo proprietário.

Amostra de código baixo: consulte o simples 07-low-code-sample.ipynb para apreciar quanto pode ser feito apenas com APIs simples do Gtsystem.

Vá do protótipo para a produção: comece com 08-prototype-to-production.ipynb para ir da prototipagem usando os melhores modelos e, em seguida, explorando modelos locais no laptop, finalmente comparando fornecedores mais rápidos como o GROQ em um fluxo de trabalho sem costura.

CHAP visual no Bedrock: Explore 09-chat-bedrock.ipynb para bate-papo visual usando modelos hospedados no Bedrock.

Bate-papo visual no Antrópico: Explore 10-chat-anthropic.ipynb para bate-papo visual usando modelos hospedados antropia.

Chat Visual no OpenAI: Explore 11-chat-openai.ipynb para bate-papo visual usando o OpenAI GPT4-TURBO.

Você pode instalar as seguintes dependências para trabalhar com gtsystem com base em suas necessidades. Comece com nossos requirements.txt ou crie o seu próprio. Em seguida, execute pip install -r requirements.txt em seu ambiente.

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

Para usar modelos hospedados na Amazon Bedrock, como Llama e Claude, siga estas etapas.

Etapa 1. Faça login no AWS Console> Lançar o gerenciamento de identidade e acesso (IAM)> Crie um usuário para acesso à interface da linha de comando (CLI). Leia a documentação do Bedrock para obter mais detalhes.

Etapa 2. Instale a AWS CLI> Execute aws configure no terminal> Adicionar credenciais da Etapa 1.

Para usar o Ollama, forneceu LLMs localmente no seu laptop, siga estas etapas.

Etapa 1. Baixe o ollama Nota os requisitos de memória para cada modelo. Os modelos 7b geralmente requerem pelo menos 8 GB de RAM. Os modelos 13b geralmente requerem pelo menos 16 GB de RAM. Os modelos 70b geralmente requerem pelo menos 64 GB de RAM

Etapa 2. Encontre o modelo Biblioteca Ollama> Execute o comando ollama pull <model> no terminal para baixar o modelo. Atualmente, o GTSystem suporta modelos populares como LLAMA2, Mistral e Llava.

Para usar os modelos OpenAI, siga estas etapas.

Etapa 1. Inscreva -se para acesso da API OpenAI e obtenha a chave da API.

Etapa 2. Adicione a chave da API OpenAI ao seu ~/.zshrc ou ~/.bashrc usando export OPENAI_API_KEY="your-key-here"

Para usar modelos abertos no Fast Groq LPUs, siga estas etapas.

Etapa 1. Inscreva -se para o acesso da API Groq e obtenha a chave da API.

Etapa 2. Adicione a tecla API GROQ ao seu ~/.zshrc ou ~/.bashrc usando export GROQ_API_KEY="your-key-here"

Se você é novo no Python, aqui está como você pode começar do zero.

Primeiro, você deve executar o mais recente Python no seu sistema com o Python Package Manager atualizado para o mais recente.

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23 Siga este guia para o Mac OS X se você não tiver o Python mais recente. Se instalar a versão específica do Python para gerenciar dependências, siga este thread para instalar usando pyenv Python Version Manager. Se necessário, atualize o PIP para o mais recente usando o seguinte comando.

pip install --user --upgrade pipAgora, criaremos um ambiente virtual para a configuração do MLOPS para que nossas dependências sejam isoladas e não entrem em conflito com os pacotes instalados do sistema. Seguiremos este guia para criar e gerenciar o ambiente virtual. Primeira alteração no diretório, onde desenvolveremos nosso aplicativo.

python -m venv envSe você executar o LS ENV, verá as seguintes pastas e arquivos criados.

bin include lib pyvenv.cfgAgora podemos ativar nosso ambiente virtual como assim. Você notará que o Diretório de Desenvolvimento prefixou com o (Env) para indicar que agora está em execução no ambiente virtual.

. env/bin/activateVocê pode confirmar que não está correndo dentro do ambiente virtual com seu próprio Python.

which python

# # should return /Users/.../env/bin/pythonPara deixar o ambiente virtual usando o comando DeActivate. Entre usando o mesmo comando do anterior.