genaiアプリケーションを迅速に作成するための低コードPythonパッケージ

Genai Techneは、企業や専門家が生成的AIの技術に優れているのを支援する使命にあります。 Genai Techne Substackをご覧ください。ここでは、ミッションの詳細をご覧ください。GTSystemドキュメントを読み、ステップバイステップのチュートリアルから学び、ユースケースのGTSystemのロードマップに影響を与えます。

gtsystemパッケージの使用を開始します。これらの手順に従います。

ステップ1。PIP pip install gtsystemを使用してGTSystemパッケージをインストールします

ステップ2。Jupyterノートを開いて、このサンプルを試してください。

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()注:依存関係をインストールし、各ベンダーAPIをセットアップするには、ここで読み続けることができます。

gtsystemパッケージソースは、GitHubのこのリポジトリで入手できます。

Genai Techne Substack PostのGTSystemの背後にあるVisionの詳細については、詳細をご覧ください。

gtsystem Repoに含まれるノートブックサンプルに沿ってフォローすることにより、 gtsystem APIを学習できます。このサンプルは、Genai Techne Substackに文書化されています。

モデルリーダーボードのレビュー: 00-leaderboard.ipynbを使用して、モデルリーダーボードをレビューし、ランキング、ベンダー、モデルでフィルターを使用して、どちらを探索するかを決定します。

1つのコードを使用してモデルを評価します。1 01-evaluate.ipynb参照してください。1つのステートメントについては、Openai GPT、Bedrock Hosted Claude、Llamaを含む複数のモデルで迅速な評価を促します。

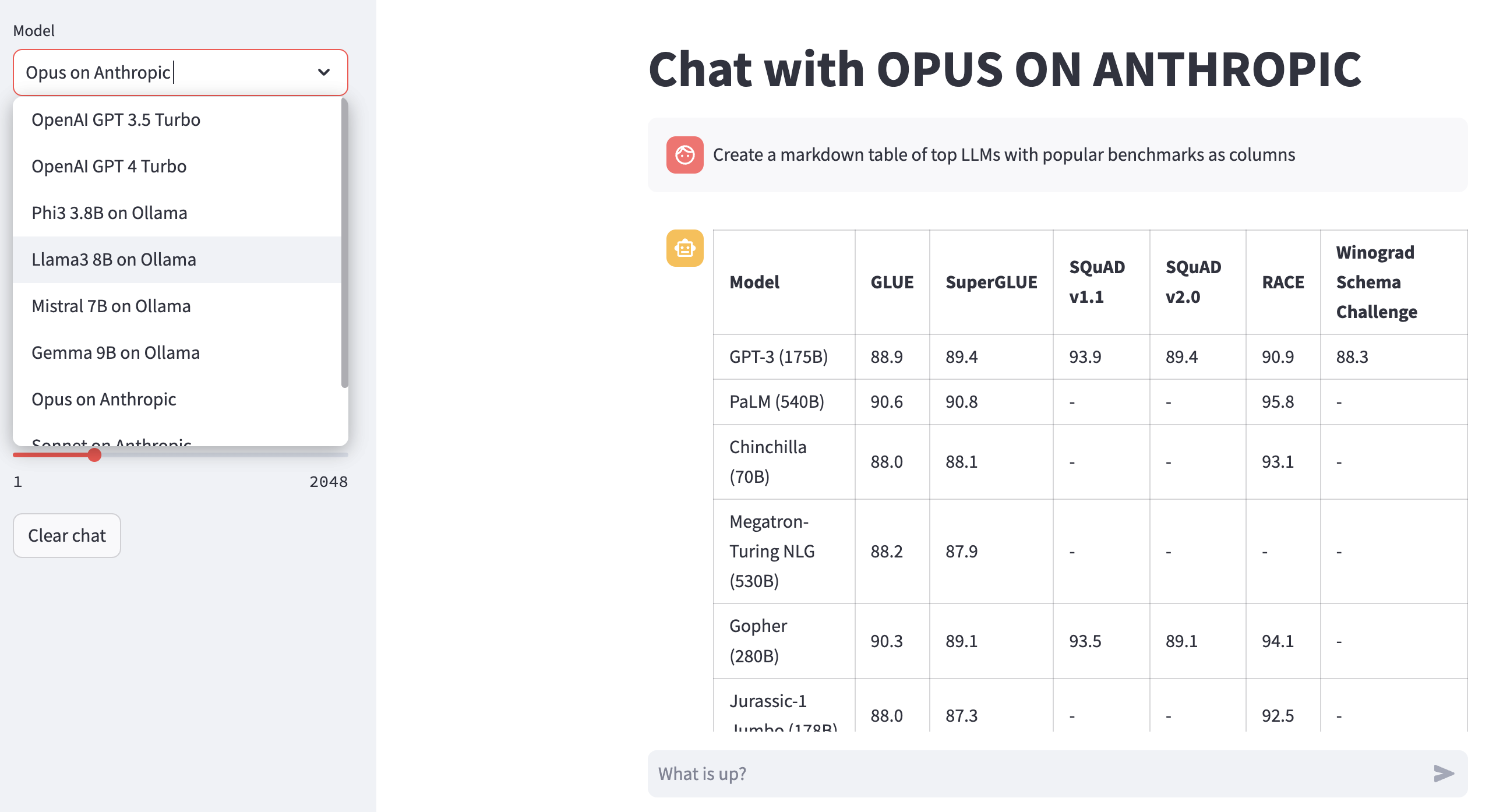

レンダリングLLM応答: 02-render.ipynbを使用して、マークダウンテーブルを含むモデル応答の適切にフォーマットされたレンダリングを行います。

Excelからのロード評価タスク: 03-tasks.ipynbを試してください

応答の機器速度とサイズ(コスト):再利用04-instrument.ipynbは、レイテンシと応答のサイズにわたって複数のモデルを計測および比較するための再利用。

ベンチマークの応答の品質: LLMAの評価者としてGPT-4を使用してLlamaやClaudeなどのモデルからの自動ベンチマークの品質の品質のために05-benchmark.ipynb使用します。

ラップトップでモデルを実行する: 06-ollama.ipynbを入手して、ラップトップでMistral、Llama、Codellamaなどのモデルを実行し、クラウドまたは独自のモデルAPIでホストされているモデルを比較します。

低コードサンプル: Simple 07-low-code-sample.ipynbをチェックして、単純なGTSystem APIだけでどれだけできるかを理解してください。

プロトタイプから制作に移行: 08-prototype-to-production.ipynb開始。ipynbは、ベストモデルを使用してプロトタイプから移動し、ラップトップのローカルモデルを探索し、最終的に1つのシームレスなワークフローでGROQのような最速ベンダーを比較します。

ベッドロックでのビジュアルチャット: Bedrockホストモデルを使用した視覚的なチャットのために09-chat-bedrock.ipynbを探索します。

人類に関するビジュアルチャット:人類ホストモデルを使用したビジュアルチャットについては10-chat-anthropic.ipynb探索します。

Openaiでのビジュアルチャット: Openai GPT4-Turboを使用したビジュアルチャットについては11-chat-openai.ipynb探索します。

ニーズに基づいてgtsystemを使用するために、次の依存関係をインストールできます。 requirements.txtから始めたり、独自に作成したりします。次に、環境内でpip install -r requirements.txt実行します。

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

Amazon Bedrockを使用するには、LlamaやClaudeなどのモデルをホストしています。これらの手順に従います。

ステップ1。AWSコンソールにログイン> IDおよびアクセス管理(IAM)の起動>コマンドラインインターフェイス(CLI)アクセスのユーザーを作成します。詳細については、岩盤のドキュメントをお読みください。

ステップ2。AWScli > run aws configure in terminal>ステップ1から資格情報を追加します。

Ollamaを使用するには、ラップトップでローカルにLLMSを提供しました。

ステップ1。オラマをダウンロードして、各モデルのメモリ要件に注意してください。 7bモデルには、通常、少なくとも8GBのRAMが必要です。 13Bモデルには、通常、少なくとも16GBのRAMが必要です。 70Bモデルでは、通常、少なくとも64GBのRAMが必要です

ステップ2。モデルOllama Library> Run Command ollama pull <model>ターミナルで見つけて、モデルをダウンロードします。現在、GTSystemはLlama2、Mistral、Llavaなどの人気モデルをサポートしています。

Openaiモデルを使用するには、これらの手順に従います。

ステップ1。OpenAIAPIアクセスのサインアップとAPIキーを取得します。

ステップ2。OpenAi_Api_Key export OPENAI_API_KEY="your-key-here"を使用して~/.zshrcまたは~/.bashrcにOpenAI APIキーを追加します "

高速GROQ LPUでオープンモデルを使用するには、次の手順に従います。

ステップ1。GROQAPIアクセスのサインアップとAPIキーを取得します。

ステップ2。GROQAPIキーを~/.zshrcまたは~/.bashrcをexport GROQ_API_KEY="your-key-here"

Pythonを初めて使用する場合は、ゼロから始める方法を次に示します。

まず、Pythonパッケージマネージャーが最新のものにアップグレードされた状態で、システム上の最新のPythonを実行する必要があります。

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23最新のPythonがない場合は、Mac OS Xのこのガイドに従ってください。依存関係を管理するために特定のバージョンのPythonをインストールする場合は、このスレッドに従ってpyenv Pythonバージョンマネージャーを使用してインストールします。必要な場合は、次のコマンドを使用してPIPを最新にアップグレードします。

pip install --user --upgrade pip依存関係が分離され、システムがインストールされたパッケージと競合しないように、MLOPSセットアップ用の仮想環境を作成します。仮想環境を作成および管理するためのこのガイドに従います。最初にアプリケーションを開発するディレクトリに変更します。

python -m venv envLS envを実行すると、次のフォルダーとファイルが作成されます。

bin include lib pyvenv.cfgこれで、仮想環境をアクティブにすることができます。 (env)が付いた開発ディレクトリが、仮想環境で実行されていることを示すことに気付くでしょう。

. env/bin/activate独自のPythonで仮想環境内で実行されていないことを確認できます。

which python

# # should return /Users/.../env/bin/python非アクティブ化コマンドを使用して仮想環境を離れる。以前と同じコマンドを使用して再入力します。