حزمة بيثون منخفض الرمز لصياغة تطبيقات Genai بسرعة

Genai Techne في مهمة لمساعدة المؤسسات والمهنيين على التفوق في حرفة الذكاء الاصطناعي. تحقق من Genai Techne Substack حيث يمكنك قراءة المزيد حول مهمتنا ، وقراءة وثائق نظام GTSYS ، والتعلم من البرامج التعليمية خطوة بخطوة ، والتأثير على خريطة الطريق لنظام GTSY في حالات الاستخدام الخاصة بك.

بدأ البدء باستخدام حزمة gtsystem اتبع هذه الخطوات.

الخطوة 1. قم بتثبيت حزمة GTSYstem باستخدام pip install gtsystem

الخطوة 2. افتح دفتر Jupyter وجرب هذه العينة.

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()ملاحظة: لتثبيت التبعيات وإعداد كل من واجهات برمجة تطبيقات البائع التي يمكنك متابعة القراءة هنا.

يتوفر مصدر حزمة gtsystem في هذا المستودع على GitHub.

يمكنك قراءة المزيد حول الرؤية وراء GTSYSTEM على منشور Genai Techne Substack.

يمكنك تعلم gtsystem API من خلال متابعة عينات دفتر الملاحظات المضمنة في نظام gtsystem . تم توثيق هذه العينات على Genai Techne Substack.

مراجعة نموذج المتصدرين: استخدم 00-leaderboard.ipynb لمراجعة المتصدرين النموذجين ، والتصفية عن طريق الترتيب ، والبائعين ، والنماذج لتحديد أي منها ستستكشف.

قم بتقييم النماذج باستخدام سطر واحد من التعليمات البرمجية: راجع 01-evaluate.ipynb لإجراء تقييمات موجبة بيان واحد عبر نماذج متعددة بما في ذلك Openai GPT أو Bedrock المستضافة Claude أو Llama.

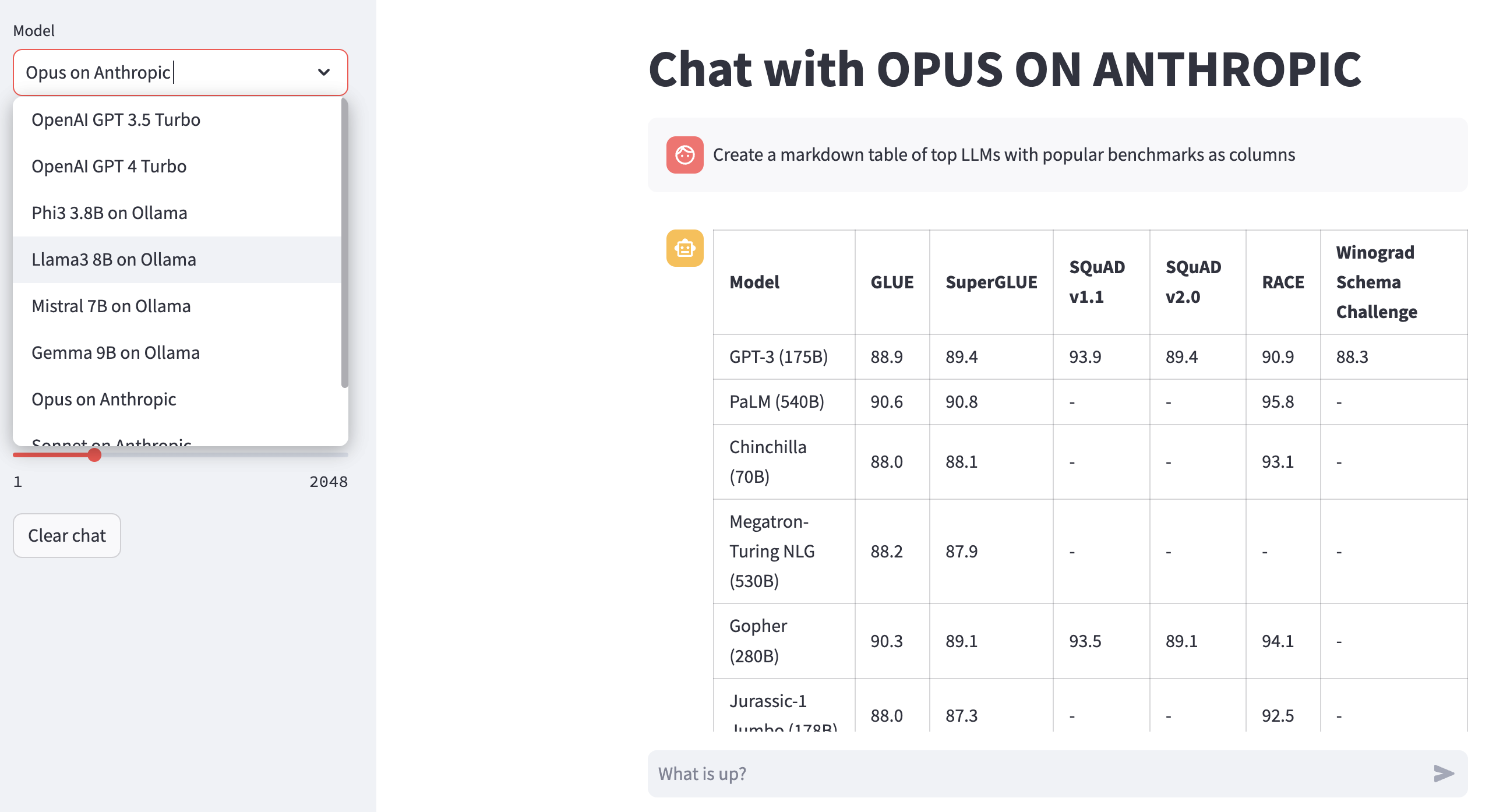

عرض ردود LLM: استخدم 02-render.ipynb لتقديم تنسيق جيد للاستجابات النموذجية بما في ذلك جداول تخفيض.

مهام تقييم التحميل من Excel: جرب 03-tasks.ipynb لأتمتة مهام التقييم - البحث ، القائمة ، مطالبات التحميل حسب المهمة ، بما في ذلك قيم المعلمات المثلى لدرجة الحرارة و TOPP.

سرعة الأداة وحجمها (التكلفة) للاستجابة: إعادة استخدام 04-instrument.ipynb للتكوين ومقارنة نماذج متعددة عبر الكمون وحجم الاستجابة.

جودة الاستجابة المعيارية: استخدم 05-benchmark.ipynb لجودة القياس الآلي لاستجابات من نماذج مثل LAMA و CLAUDE باستخدام GPT-4 كمقيِّم LLM.

قم بتشغيل النماذج على الكمبيوتر المحمول الخاص بك: احصل على 06-ollama.ipynb لتشغيل نماذج مثل Mistral و Llama و Codellama محليًا على الكمبيوتر المحمول ومقارنة النماذج المستضافة على واجهات برمجة تطبيقات النموذج السحابي أو الملكية.

عينة رمز منخفض: تحقق من Simple 07-low-code-sample.ipynb لتقدير مقدار ما يمكن القيام به من خلال واجهات برمجة تطبيقات نظام GTSY Simple.

انتقل من النموذج الأولي إلى الإنتاج: ابدأ بنمط 08-prototype-to-production.ipynb للانتقال من النماذج الأولية باستخدام أفضل النماذج ، ثم استكشاف النماذج المحلية على الكمبيوتر المحمول ، وأخيراً مقارنة بائعين أسرع مثل Groq في سير عمل سلس واحد.

الدردشة المرئية على الأساس: استكشف 09-chat-bedrock.ipynb للدردشة المرئية باستخدام النماذج المستضافة من Bedrock.

الدردشة المرئية على الأنثروبور: استكشف 10-chat-anthropic.ipynb للدردشة المرئية باستخدام النماذج المستضافة الأنثروب.

الدردشة المرئية على Openai: استكشف 11-chat-openai.ipynb للدردشة المرئية باستخدام Openai GPT4-Turbo.

يمكنك تثبيت التبعيات التالية للعمل مع gtsystem بناءً على احتياجاتك. ابدأ بمتطلباتنا requirements.txt أو إنشاء خاص بك. ثم قم بتشغيل pip install -r requirements.txt داخل بيئتك.

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

لاستخدام نماذج Amazon Bedrock المستضافة مثل Llama و Claude ، تتبع هذه الخطوات.

الخطوة 1. تسجيل الدخول إلى وحدة التحكم AWS> تشغيل الهوية وإدارة الوصول (IAM)> إنشاء مستخدم لواجهة خط الأوامر (CLI). قراءة وثائق Bedrock لمزيد من التفاصيل.

الخطوة 2. تثبيت AWS CLI> قم بتشغيل aws configure في Terminal> إضافة بيانات الاعتماد من الخطوة 1.

لاستخدام Ollama ، قدمت LLMS محليًا على جهاز الكمبيوتر المحمول ، اتبع هذه الخطوات.

الخطوة 1. قم بتنزيل Ollama لاحظ متطلبات الذاكرة لكل نموذج. تتطلب نماذج 7B عمومًا 8 جيجابايت على الأقل من ذاكرة الوصول العشوائي. تتطلب طرز 13B عمومًا ما لا يقل عن 16 جيجابايت من ذاكرة الوصول العشوائي. تتطلب طرز 70B عمومًا ما لا يقل عن 64 جيجابايت من ذاكرة الوصول العشوائي

الخطوة 2. ابحث عن طراز Ollama Library> Run Command ollama pull <model> في Terminal لتنزيل النموذج. يدعم GTSYSTEM حاليًا النماذج الشائعة مثل LLAMA2 و MISTRAL و LLAVA.

لاستخدام نماذج Openai اتبع هذه الخطوات.

الخطوة 1. الاشتراك في API API Openai والحصول على مفتاح API.

الخطوة 2. أضف مفتاح API Openai إلى ~/.zshrc أو ~/.bashrc باستخدام export OPENAI_API_KEY="your-key-here"

لاستخدام نماذج مفتوحة على Fast Groq LPUs اتبع هذه الخطوات.

الخطوة 1. التسجيل للوصول إلى GROQ API والحصول على مفتاح API.

الخطوة 2. أضف مفتاح Groq API إلى ~/.zshrc أو ~/.bashrc باستخدام export GROQ_API_KEY="your-key-here"

إذا كنت جديدًا على Python ، فإليك كيف يمكنك البدء من الصفر.

أولاً ، يجب أن تقوم بتشغيل أحدث Python على نظامك مع ترقية Python Package Manager إلى أحدث.

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23 اتبع هذا الدليل لنظام التشغيل Mac OS X إذا لم يكن لديك أحدث Python. في حالة تثبيت إصدار محدد من Python لإدارة التبعيات ، اتبع هذا الموضوع للتثبيت باستخدام Manager pyenv Python إصدار. إذا لزم الأمر "ترقية PIP" إلى أحدث استخدام الأمر التالي.

pip install --user --upgrade pipسنقوم الآن بإنشاء بيئة افتراضية لإعداد MLOPS لدينا بحيث تكون تبعياتنا معزولة ولا تتعارض مع الحزم المثبتة للنظام. سوف نتبع هذا الدليل لإنشاء وإدارة البيئة الافتراضية. أول تغيير إلى الدليل حيث سنقوم بتطوير تطبيقنا.

python -m venv envإذا قمت بتشغيل LS ENV ، فسترى المجلدات والملفات التالية.

bin include lib pyvenv.cfgالآن يمكننا تنشيط بيئتنا الافتراضية مثل ذلك. ستلاحظ أن دليل التطوير مسبوق بـ (ENV) للإشارة إلى أنك تعمل الآن في البيئة الافتراضية.

. env/bin/activateيمكنك تأكيد أنك لا تعمل داخل البيئة الافتراضية مع ثعبانها.

which python

# # should return /Users/.../env/bin/pythonلترك البيئة الافتراضية باستخدام الأمر deactivate. إعادة الدخول باستخدام نفس الأمر كما هو الحال في وقت سابق.