Paket Python Kode Rendah untuk Membuat Aplikasi Genai dengan Cepat

Genai Techne sedang dalam misi untuk membantu perusahaan dan profesional unggul dalam kerajinan AI generatif. Lihatlah Genai Techne Substack di mana Anda dapat membaca lebih lanjut tentang misi kami, membaca dokumentasi GTSystem, belajar dari tutorial langkah-demi-langkah, dan mempengaruhi peta jalan gtsystem untuk kasus penggunaan Anda.

Mulai menggunakan paket gtsystem mengikuti langkah -langkah ini.

Langkah 1. Instal Paket Gtsystem Menggunakan pip install gtsystem

Langkah 2. Buka buku catatan Jupyter dan coba sampel ini.

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()Catatan: Untuk menginstal dependensi dan mengatur masing -masing API vendor Anda dapat terus membaca di sini.

Sumber paket gtsystem tersedia di repositori ini di GitHub.

Anda dapat membaca lebih lanjut tentang visi di balik gtsystem di Genai Techne Substack Post.

Anda dapat mempelajari API gtsystem dengan mengikuti sampel notebook yang termasuk dalam repo gtsystem . Sampel ini didokumentasikan di Genai Techne Substack.

Ulasan Model Leaderboard: Gunakan 00-leaderboard.ipynb untuk meninjau model leaderboard, filter dengan peringkat, vendor, model untuk memutuskan mana yang akan dijelajahi.

Evaluasi model menggunakan satu baris kode: Rujuk 01-evaluate.ipynb untuk evaluasi prompt pernyataan tunggal di beberapa model termasuk OpenAi GPT, Bedrock Hosted Claude atau Llama.

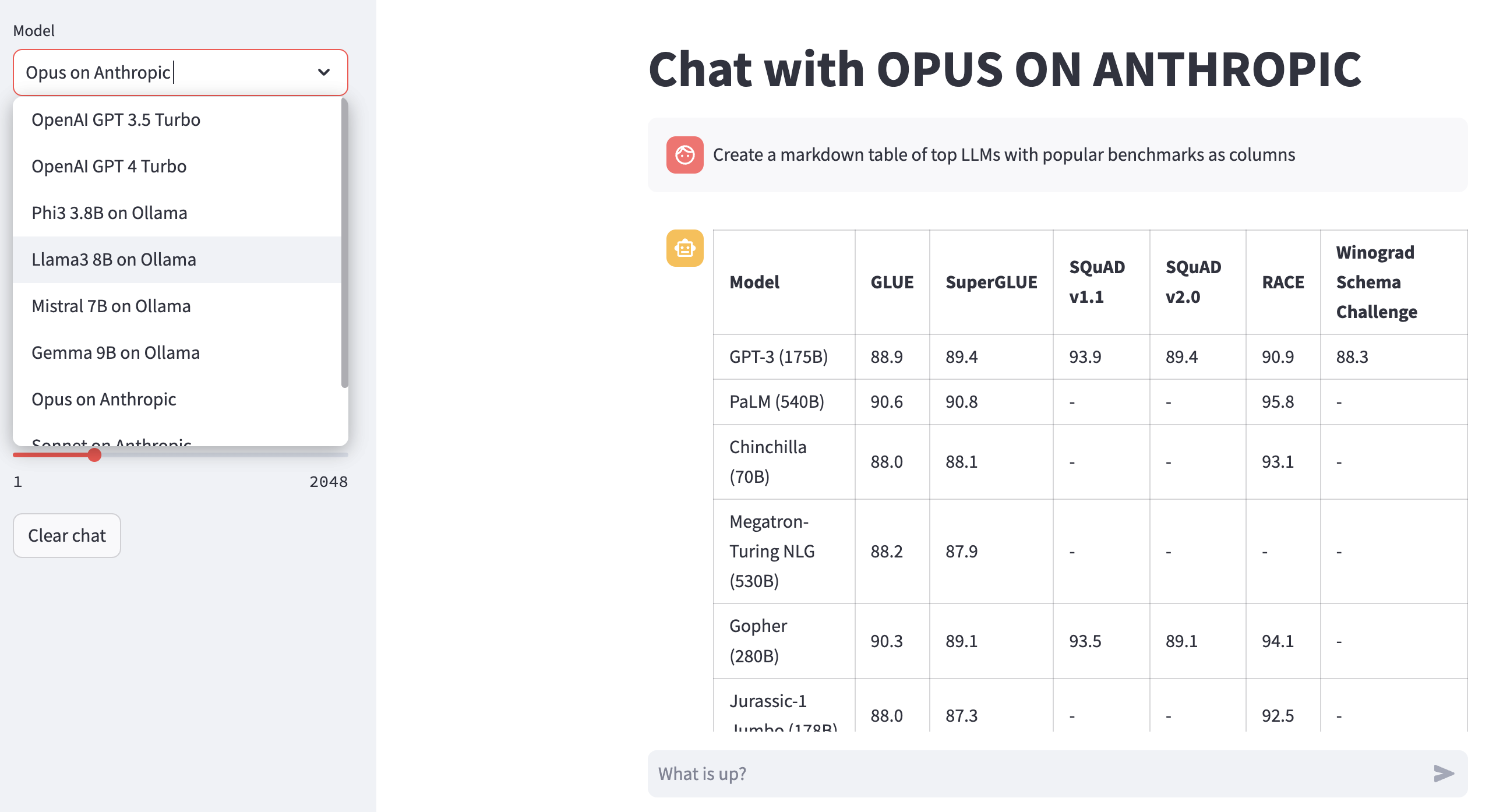

Render Respons LLM: Gunakan 02-render.ipynb untuk rendering respons model yang diformat dengan baik termasuk tabel penurunan harga.

Tugas Evaluasi Muat dari Excel: Coba 03-tasks.ipynb untuk mengotomatiskan tugas evaluasi - temukan, daftar, petunjuk beban berdasarkan tugas, termasuk nilai parameter optimal untuk suhu dan topp.

Kecepatan dan ukuran instrumen (biaya) respons: Reuse 04-instrument.ipynb untuk instrumen dan membandingkan banyak model di seluruh latensi dan ukuran respons.

Benchmark Quality of Response: Gunakan 05-benchmark.ipynb untuk kualitas tolok ukur kualitas respons dari model seperti Llama dan Claude menggunakan GPT-4 sebagai evaluator LLM.

Jalankan model di laptop Anda: Dapatkan 06-ollama.ipynb untuk menjalankan model seperti Mistral, Llama, dan Codellama secara lokal di laptop Anda dan membandingkan model yang di-host di API model cloud atau hak milik.

Sampel Kode Rendah: Lihat Simple 07-low-code-sample.ipynb untuk menghargai berapa banyak yang bisa dilakukan hanya dengan API GTSYSTEM sederhana.

GAIN DARI Prototipe ke Produksi: Mulailah dengan 08-prototype-to-production.ipynb untuk beralih dari prototipe menggunakan model terbaik, kemudian menjelajahi model lokal di laptop, akhirnya membandingkan vendor tercepat seperti GROQ dalam satu alur kerja yang mulus.

Obrolan Visual di Bedrock: Jelajahi 09-chat-bedrock.ipynb untuk obrolan visual menggunakan model yang di-host.

Obrolan Visual tentang Antropik: Jelajahi 10-chat-anthropic.ipynb untuk obrolan visual menggunakan model yang di-host antropik.

Obrolan Visual di OpenAi: Jelajahi 11-chat-openai.ipynb untuk obrolan visual menggunakan OpenAI GPT4-TURBO.

Anda dapat menginstal dependensi berikut untuk bekerja dengan gtsystem berdasarkan kebutuhan Anda. Mulailah dengan requirements.txt kami.txt atau buat sendiri. Kemudian jalankan pip install -r requirements.txt di lingkungan Anda.

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

Untuk menggunakan model Amazon Bedrock yang di -host seperti Llama dan Claude mengikuti langkah -langkah ini.

Langkah 1. Login ke AWS Console> Luncurkan Identity and Access Management (IAM)> Buat pengguna untuk akses antarmuka baris perintah (CLI). Baca dokumentasi Bedrock untuk detail lebih lanjut.

Langkah 2. Instal AWS CLI> Jalankan aws configure di Terminal> Tambahkan Kredensial dari Langkah 1.

Untuk menggunakan Ollama yang disediakan LLMS secara lokal di laptop Anda, ikuti langkah -langkah ini.

Langkah 1. Unduh Ollama Perhatikan persyaratan memori untuk setiap model. Model 7b umumnya membutuhkan setidaknya 8GB RAM. Model 13B umumnya membutuhkan setidaknya 16GB RAM. Model 70b umumnya membutuhkan setidaknya 64GB RAM

Langkah 2. Temukan Model Ollama Library> Jalankan Command ollama pull <model> di Terminal untuk mengunduh model. Saat ini GTSystem mendukung model populer seperti LLAMA2, Mistral, dan LLAVA.

Untuk menggunakan model OpenAI, ikuti langkah -langkah ini.

Langkah 1. Mendaftar untuk akses API OpenAI dan dapatkan kunci API.

Langkah 2. Tambahkan tombol API OpenAI ke ~/.zshrc atau ~/.bashrc Anda menggunakan export OPENAI_API_KEY="your-key-here"

Untuk menggunakan model terbuka pada LPU Fast Groq, ikuti langkah -langkah ini.

Langkah 1. Mendaftar untuk akses API GROQ dan dapatkan kunci API.

Langkah 2. Tambahkan tombol API GroQ ke ~/.zshrc atau ~/.bashrc Anda menggunakan export GROQ_API_KEY="your-key-here"

Jika Anda baru mengenal Python maka di sini adalah bagaimana Anda bisa memulai dari awal.

Pertama, Anda harus menjalankan python terbaru di sistem Anda dengan Python Package Manager yang ditingkatkan ke yang terbaru.

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23 Ikuti panduan ini untuk Mac OS X jika Anda tidak memiliki ular python terbaru. Jika menginstal versi spesifik Python untuk mengelola dependensi maka ikuti utas ini untuk menginstal menggunakan pyenv Python Version Manager. Jika diperlukan Pip Upgrade ke yang terbaru menggunakan perintah berikut.

pip install --user --upgrade pipKami sekarang akan menciptakan lingkungan virtual untuk pengaturan MLOPS kami sehingga ketergantungan kami terisolasi dan tidak bertentangan dengan paket yang dipasang sistem. Kami akan mengikuti panduan ini untuk membuat dan mengelola lingkungan virtual. Perubahan pertama ke direktori tempat kami akan mengembangkan aplikasi kami.

python -m venv envJika Anda menjalankan LS Env, Anda akan melihat folder dan file berikut yang dibuat.

bin include lib pyvenv.cfgSekarang kita dapat mengaktifkan lingkungan virtual kita seperti itu. Anda akan melihat bahwa direktori pengembangan diawali dengan (env) untuk menunjukkan bahwa Anda sekarang berjalan di lingkungan virtual.

. env/bin/activateAnda dapat mengonfirmasi bahwa Anda tidak berjalan di dalam lingkungan virtual dengan ular sanca.

which python

# # should return /Users/.../env/bin/pythonUntuk meninggalkan lingkungan virtual menggunakan perintah nonaktifkan. Masuk kembali menggunakan perintah yang sama seperti sebelumnya.