Низкий кодовый пакет Python для быстрого создания приложений Genai

Genai Techne выполняет миссию, чтобы помочь предприятию и профессионалам преуспеть в мастерстве генеративного ИИ. Проверьте Genai Techne Supack, где вы можете прочитать больше о нашей миссии, прочитать документацию GTSystem, учиться на пошаговых учебных пособиях и влиять на дорожную карту GTSystem для ваших вариантов использования.

Начало работы с использованием пакета gtsystem следуйте этим шагам.

Шаг 1. Установите пакет gtsystem с помощью pip install gtsystem

Шаг 2. Откройте ноутбук Jupyter и попробуйте этот образец.

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()ПРИМЕЧАНИЕ. Чтобы установить зависимости и настроить каждый из API -поставщиков, которые вы можете продолжить чтение здесь.

Источник пакета gtsystem доступен в этом репозитории на GitHub.

Вы можете прочитать больше о видении Gtsystem на посте Genai Techne Supack.

Вы можете выучить gtsystem API, следуя по образцам ноутбука, включенным в репо gtsystem . Эти образцы задокументированы на Genai Techne Supack.

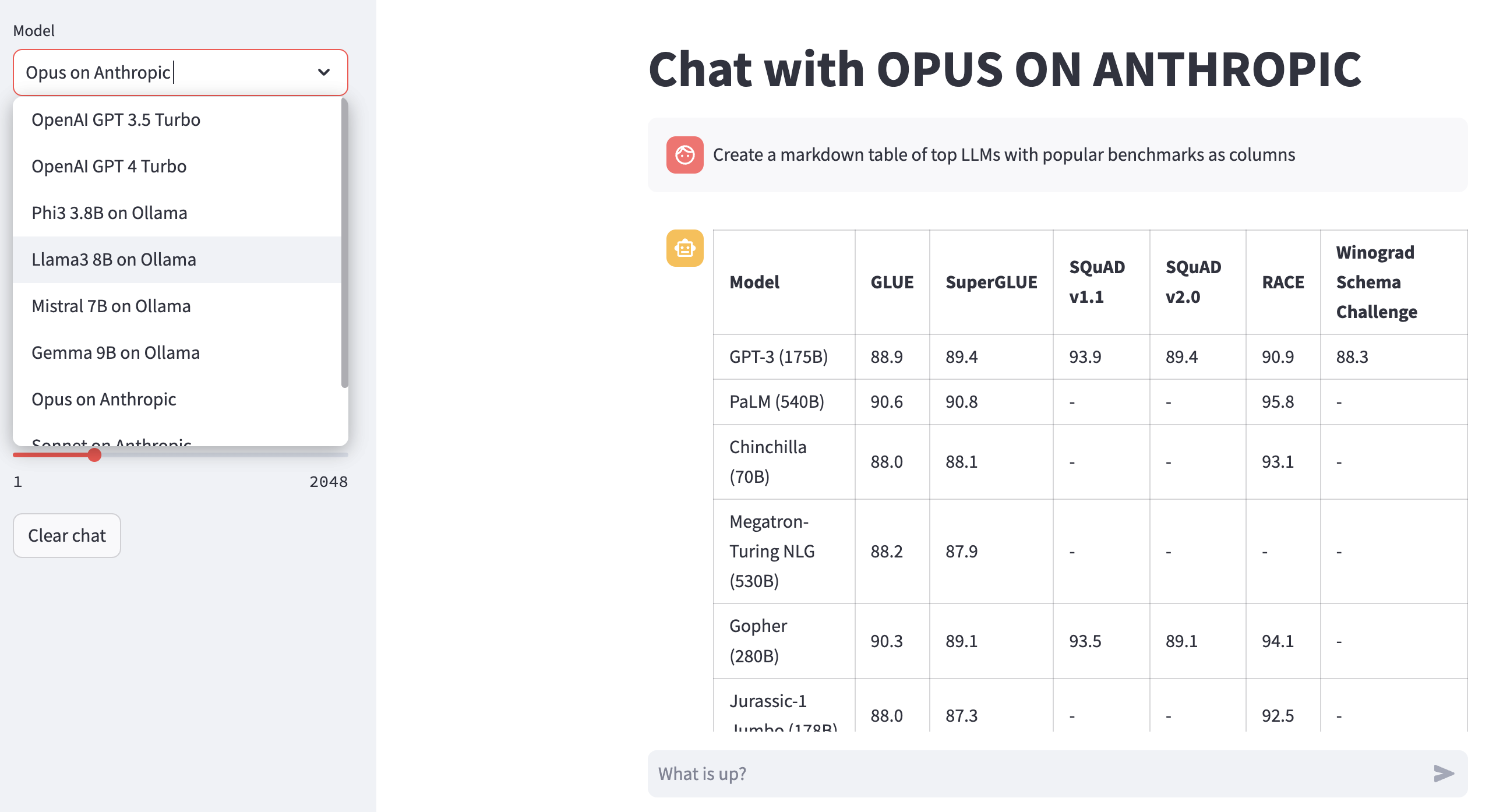

Обзор модели лидеров: используйте 00-leaderboard.ipynb

Оцените модели с использованием одной строки кода: см 01-evaluate.ipynb

Render LLM Ответы: используйте 02-render.ipynb для хорошо форматированного рендеринга модельных ответов, включая таблицы разметки.

Задачи оценки нагрузки из Excel: попробуйте 03-tasks.ipynb для автоматизации задач оценки - Найдите, перечислите, загружают подсказки по заданию, включая оптимальные значения параметров для температуры и Topp.

Скорость и размер инструмента (стоимость) ответа: повторное использование 04-instrument.ipynb для инструментальных инструментов и сравнения нескольких моделей по задержке и размеру отклика.

Конфликтное качество ответа: используйте 05-benchmark.ipynb для автоматического сравнительного качества ответов от таких моделей, как Llama и Claude, используя GPT-4 в качестве оценщика LLM.

Запустите модели на своем ноутбуке: Получите 06-ollama.ipynb , чтобы запустить такие модели, как Mistral, Llama и Codellama, на вашем ноутбуке, и сравните модели, размещенные в облачных или проприетарных модельных API.

Низкий код образец: Проверьте простой 07-low-code-sample.ipynb , чтобы оценить, сколько можно сделать с помощью простой API GTSystem.

Перейдите от прототипа к производству: начните с 08-prototype-to-production.ipynb

Визуальный чат на коренной породе: исследуйте 09-chat-bedrock.ipynb для визуального чата с использованием моделей, размещенных в розе.

Визуальный чат на антропическом: исследуйте 10-chat-anthropic.ipynb для визуального чата с использованием моделей Anpropic Hosted.

Визуальный чат на Openai: Исследуйте 11-chat-openai.ipynb для визуального чата с помощью Openai GPT4-Turbo.

Вы можете установить следующие зависимости для работы с gtsystem на основе ваших потребностей. Начните с наших requirements.txt или создайте свои собственные. Затем запустите pip install -r requirements.txt в вашей среде.

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

Для использования Amazon Bedrock размещенные модели, такие как Llama и Claude, следуют этим шагам.

Шаг 1. Войдите в консоль AWS> Запуск идентификатор и управление доступом (IAM)> Создайте пользователя для доступа к интерфейсу командной строки (CLI). Прочитайте документацию Bedrock для получения более подробной информации.

Шаг 2. Установите AWS CLI> Запустить aws configure в терминале> Добавить учетные данные с шага 1.

Чтобы использовать Ollama, предоставленные LLM на локальном уровне на вашем ноутбуке, выполните эти шаги.

Шаг 1. Загрузите Ollama. Обратите внимание на требования к памяти для каждой модели. Модели 7b обычно требуют не менее 8 ГБ оперативной памяти. 13b модели обычно требуют не менее 16 ГБ оперативной памяти. Модели 70b обычно требуют не менее 64 ГБ ОЗУ

Шаг 2. Найдите модель библиотеки Ollama> Запустите команду ollama pull <model> в терминале, чтобы загрузить модель. В настоящее время GTSystem поддерживает популярные модели, такие как Llama2, Mistral и Llava.

Чтобы использовать модели OpenAI, следуйте этим шагам.

Шаг 1. Зарегистрируйтесь для API API OpenAI и получите ключ API.

Шаг 2. Добавьте клавишу API Openai в ваш ~/.zshrc или ~/.bashrc с использованием export OPENAI_API_KEY="your-key-here"

Для использования открытых моделей на быстром GROQ LPU выполняют эти шаги.

Шаг 1. Зарегистрируйтесь для API API Groq и получите ключ API.

Шаг 2. Добавьте клавишу API Groq в ваш ~/.zshrc или ~/.bashrc с использованием export GROQ_API_KEY="your-key-here"

Если вы новичок в Python, то вот как вы можете начать с нуля.

Во -первых, вы должны запустить последний Python в вашей системе с Manager пакета Python, обновленным до последнего.

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23 Следуйте этому руководству для Mac OS X, если у вас нет последнего Python. При установке конкретной версии Python для управления зависимостями следуйте по этому потоку, чтобы установить с помощью Manager версий pyenv Python. При необходимости обновите PIP до последнего использования следующей команды.

pip install --user --upgrade pipТеперь мы создадим виртуальную среду для нашей установки MLOPS, чтобы наши зависимости изолированы и не конфликтуем с установленными пакетами системы. Мы будем следовать этому руководству для создания и управления виртуальной средой. Первое изменение в каталог, где мы разработаем наше приложение.

python -m venv envЕсли вы запустите LS Env, вы увидите следующие папки и созданные файлы.

bin include lib pyvenv.cfgТеперь мы можем активировать нашу виртуальную среду так. Вы заметите, что каталог разработки, префиксированный (ENV), чтобы указать, что вы сейчас работаете в виртуальной среде.

. env/bin/activateВы можете подтвердить, что вы не работаете в виртуальной среде с помощью собственного Python.

which python

# # should return /Users/.../env/bin/pythonОставить виртуальную среду, используя команду деактивирования. Повторно введите, используя ту же команду, что и раньше.