Genai 응용 프로그램을 신속하게 제작하기위한 낮은 코드 파이썬 패키지

Genai Techne은 Enterprise와 Professionals가 Generative AI의 공예에서 뛰어나도록 돕는 임무를 수행하고 있습니다. 우리의 미션에 대한 자세한 내용을 읽고, GTSYSTEM 문서를 읽고, 단계별 자습서에서 배우고, 사용 사례에 대한 GTSYSTEM의 로드맵에 영향을 줄 수있는 Genai Techne Subsack을 확인하십시오.

gtsystem 패키지를 사용하기 시작하면 다음 단계를 따릅니다.

1 단계. pip install gtsystem 사용하여 GTSYSTEM 패키지를 설치하십시오

2 단계. Jupyter 노트북을 열고이 샘플을 사용해보십시오.

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()참고 : 종속성을 설치하고 각 공급 업체 API를 설정하려면 여기에서 계속 읽을 수 있습니다.

gtsystem 패키지 소스는 GitHub 의이 저장소에서 사용할 수 있습니다.

Genai Techne Subsack Post의 GTSYSTEM의 비전에 대한 자세한 내용을 읽을 수 있습니다.

gtsystem Repo에 포함 된 노트북 샘플을 따라 gtsystem API를 배울 수 있습니다. 이 샘플은 Genai Techne Subsack에 문서화되어 있습니다.

모델 리더 보드 검토 : 00-leaderboard.ipynb 사용하여 모델 리더 보드, 순위에 따른 필터, 공급 업체, 모델을 탐색 할 모델을 결정하십시오.

OpenAi GPT, Bedrock 호스팅 Claude 또는 LLAMA를 포함한 여러 모델에서 단일 명령문 프롬프트 평가에 대해서는 01-evaluate.ipynb 줄의 코드를 사용하여 모델 평가 : 단일 명령문 프롬프트 평가를 참조하십시오.

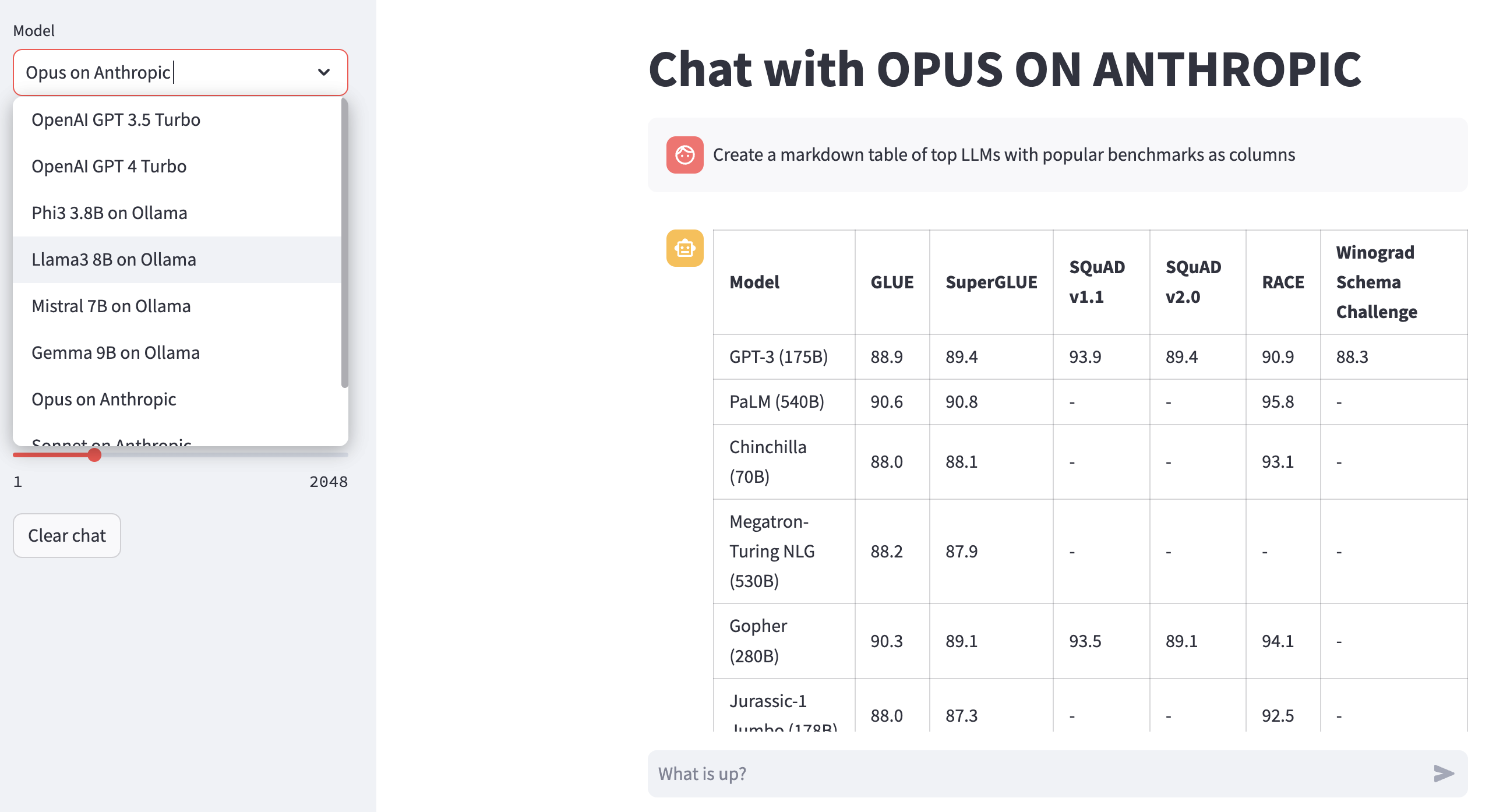

LLM 응답 렌더링 : Markdown 테이블을 포함한 모델 응답의 잘 형식화 된 렌더링을 위해 02-render.ipynb 사용하십시오.

Excel의로드 작업 : 평가 작업을 자동화하기위한 03-tasks.ipynb 시도 - 온도 및 TOPP에 대한 최적의 매개 변수 값을 포함하여 작업별로 찾기, 목록,로드 프롬프트.

기기 속도 및 크기 (비용) 응답 : 대기 시간 및 응답 크기에 걸쳐 여러 모델을 기기 및 비교할 수있는 재사용 04-instrument.ipynb .

벤치 마크 응답 품질 : LLAMA 및 Claude와 같은 모델의 자동화 된 벤치마킹 품질에 대해 05-benchmark.ipynb 사용하여 GPT-4를 LLM 평가자로 사용합니다.

노트북에서 모델을 실행하십시오 : 06-ollama.ipynb 얻으십시오. 랩톱에서 Mistral, Llama 및 Codellama와 같은 모델을 실행하고 클라우드 또는 독점 모델 API에서 호스팅되는 모델을 비교하십시오.

낮은 코드 샘플 : 간단한 07-low-code-sample.ipynb 확인하여 간단한 GTSYSTEM API로 수행 할 수있는 금액을 이해하십시오.

프로토 타입에서 프로덕션으로 이동 : 08-prototype-to-production.ipynb 로 시작하여 최고의 모델을 사용하여 프로토 타이핑에서 이동 한 다음 랩톱에서 로컬 모델을 탐색하고 마지막으로 한 원활한 워크 플로에서 Groq와 같은 가장 빠른 공급 업체를 비교하십시오.

기반암에서 시각적 채팅 : 기반암 호스팅 모델을 사용하여 시각적 채팅을위한 09-chat-bedrock.ipynb 탐색.

안트로에 대한 시각적 채팅 : 안트로 호스팅 모델을 사용한 시각적 채팅을위한 10-chat-anthropic.ipynb 탐색.

Openai에서 시각적 채팅 : OpenAI GPT4-Turbo를 사용하여 시각적 채팅을위한 11-chat-openai.ipynb 탐색.

귀하의 요구에 따라 gtsystem 과 함께 작업하기 위해 다음 종속성을 설치할 수 있습니다. requirements.txt 으로 시작하거나 직접 만들어냅니다. 그런 다음 환경 내에서 pip install -r requirements.txt 실행하십시오.

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

Llama 및 Claude와 같은 Amazon Bedrock 호스팅 모델을 사용하려면 다음 단계를 따르십시오.

1 단계. AWS 콘솔에 로그인> IAM (Ident and Access Management)> CLI (Command-Line Interface) 액세스 용 사용자 생성. 자세한 내용은 기반암 문서를 읽으십시오.

2 단계. aws cli> run aws configure 터미널에서 구성> 1 단계에서 자격 증명을 추가하십시오.

Ollama를 사용하려면 노트북에서 LLMS를 로컬로 제공하려면 다음 단계를 따르십시오.

1 단계. Ollama 다운로드 각 모델의 메모리 요구 사항에 유의하십시오. 7B 모델은 일반적으로 8GB 이상의 RAM이 필요합니다. 13B 모델은 일반적으로 16GB 이상의 RAM이 필요합니다. 70B 모델에는 일반적으로 64GB 이상의 RAM이 필요합니다

2 단계. Model Ollama Library> 실행 명령 ollama pull <model> 터미널에서 찾아 모델을 다운로드하십시오. 현재 GTSYSTEM은 LLAMA2, MISTRAL 및 LLAVA와 같은 인기있는 모델을 지원합니다.

OpenAI 모델을 사용하려면 다음 단계를 따릅니다.

1 단계. OpenAI API 액세스에 가입하고 API 키를 가져옵니다.

2 단계. OpenAI API 키를 ~/.zshrc 또는 ~/.bashrc 에 추가하여 export OPENAI_API_KEY="your-key-here"

빠른 Groq LPU에서 열린 모델을 사용하려면 다음 단계를 따르십시오.

1 단계. Groq API 액세스에 가입하고 API 키를 가져옵니다.

2 단계. export GROQ_API_KEY="your-key-here" 사용하여 ~/.zshrc 또는 ~/.bashrc 에 groq api 키를 추가하십시오.

Python을 처음 접한다면 여기에서 처음부터 시작하는 방법이 있습니다.

먼저 Python 패키지 관리자가 최신으로 업그레이드 된 시스템에서 최신 Python을 실행해야합니다.

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23 최신 파이썬이없는 경우 Mac OS X 의이 안내서를 따르십시오. 종속성을 관리하기 위해 특정 버전의 Python을 설치하는 경우이 스레드를 따라 pyenv Python 버전 관리자를 사용하여 설치하십시오. 필요한 경우 다음 명령을 사용하여 업그레이드 PIP를 최신로 제공합니다.

pip install --user --upgrade pip이제 MLOPS 설정을위한 가상 환경을 만들어 종속성이 분리되어 시스템 설치된 패키지와 충돌하지 않도록합니다. 우리는 가상 환경을 만들고 관리하기위한이 안내서를 따를 것입니다. 먼저 응용 프로그램을 개발할 디렉토리로 변경됩니다.

python -m venv envls env를 실행하면 다음 폴더와 파일이 생성됩니다.

bin include lib pyvenv.cfg이제 우리는와 같은 가상 환경을 활성화 할 수 있습니다. 개발 디렉토리가 (ENV)와 접두어를 접두어가 가상 환경에서 실행 중임을 나타냅니다.

. env/bin/activate자체 파이썬으로 가상 환경 내에서 실행되지 않음을 확인할 수 있습니다.

which python

# # should return /Users/.../env/bin/pythonDeactivate 명령을 사용하여 가상 환경을 떠나기 위해. 이전과 동일한 명령을 사용하여 다시 입력하십시오.