Un paquete Python de código bajo para elaborar aplicaciones Genai rápidamente

Genai Techne está en la misión de ayudar a las empresas y profesionales a sobresalir en el oficio de IA generativa. Echa un vistazo a Genai Techne Sushack, donde puedes leer más sobre nuestra misión, leer la documentación de GTSystem, aprender de los tutoriales paso a paso e influir en la hoja de ruta de GTSystem para tus casos de uso.

Comienza con el paquete gtsystem Sigue estos pasos.

Paso 1. Instale el paquete GTSystem usando pip install gtsystem

Paso 2. Abra un cuaderno de Jupyter e intente esta muestra.

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()Nota: para instalar las dependencias y configurar cada una de las API de proveedores que pueda continuar leyendo aquí.

La fuente del paquete gtsystem está disponible en este repositorio en GitHub.

Puede leer más sobre la visión detrás de GTSystem en la publicación de subsportación Genai Techne.

Puede aprender la API gtsystem siguiendo las muestras de cuaderno incluidas en el repositorio gtsystem . Estas muestras están documentadas en el sustituto de Genai Techne.

Revisión de la clasificación de modelos: use 00-leaderboard.ipynb para revisar la clasificación de modelos, filtrar la clasificación, los proveedores, los modelos para decidir cuál explorar.

Evalúe modelos con una línea de código: consulte 01-evaluate.ipynb para evaluar las evaluaciones de inmediato de la declaración única en múltiples modelos, incluidos OpenAI GPT, Bedrock alojado Claude o LLAMA.

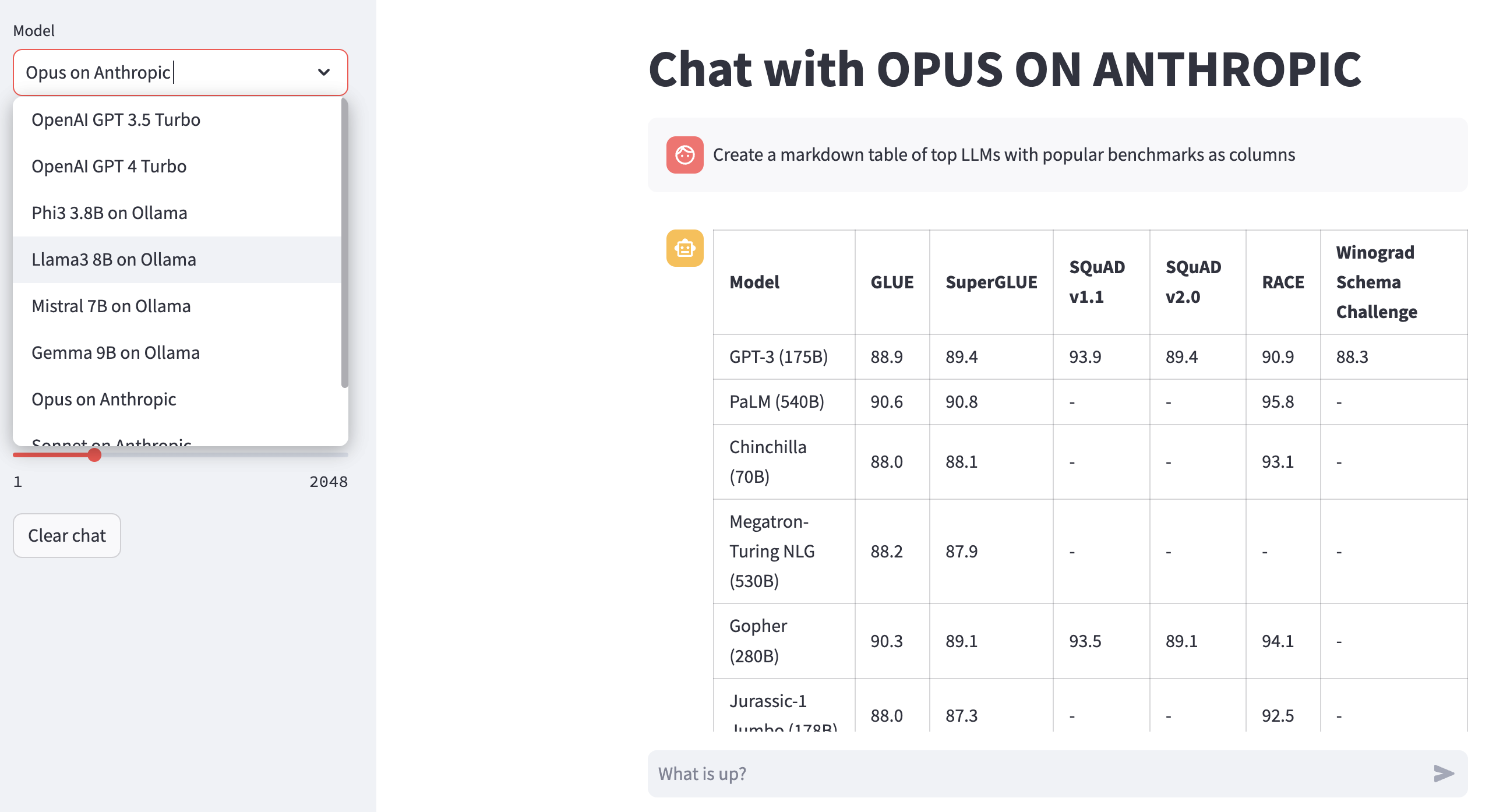

Respuestas de Render LLM: use 02-render.ipynb para la representación bien formateada de las respuestas del modelo, incluidas las tablas de Markdown.

Tareas de evaluación de carga desde Excel: intente 03-tasks.ipynb para automatizar tareas de evaluación: busque, enumere, cargue las indicaciones por tarea, incluidos los valores de parámetros óptimos para la temperatura y TOPP.

Velocidad y tamaño del instrumento (costo) de respuesta: reutilización 04-instrument.ipynb para instrumentar y comparar múltiples modelos a través de la latencia y el tamaño de la respuesta.

Calidad de la respuesta de referencia: use 05-benchmark.ipynb para la calidad de evaluación comparativa automatizada de respuestas de modelos como Llama y Claude usando GPT-4 como evaluador de LLM.

Ejecute modelos en su computadora portátil: obtenga 06-ollama.ipynb para ejecutar modelos como Mistral, Llama y Codellama localmente en su computadora portátil y compare modelos alojados en la nube o las API de modelos propietarias.

Muestra de código bajo: consulte 07-low-code-sample.ipynb para apreciar cuánto se puede hacer con solo simples API GTSYSTEM.

Vaya de prototipo a producción: comience con 08-prototype-to-production.ipynb para pasar de la creación de prototipos usando los mejores modelos, luego explorando modelos locales en la computadora portátil, finalmente comparando a los proveedores más rápidos como Groq en un flujo de trabajo sin costuras.

Chat visual en Bedrock: Explore 09-chat-bedrock.ipynb para chat visual con modelos alojados de rock.

Chat visual en antrópico: explore 10-chat-anthropic.ipynb para chat visual con modelos anhópicos alojados.

Chat visual en OpenAI: explore 11-chat-openai.ipynb para chat visual usando OpenAI GPT4-TURBO.

Puede instalar las siguientes dependencias para trabajar con gtsystem en función de sus necesidades. Comience con nuestros requirements.txt o cree el suyo. Luego ejecute pip install -r requirements.txt dentro de su entorno.

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

Para usar modelos alojados de Amazon Bedrock como Llama y Claude, siga estos pasos.

Paso 1. Inicie sesión en la consola AWS> Iniciar identidad y gestión de acceso (IAM)> Crear un usuario para el acceso de interfaz de línea de comandos (CLI). Lea la documentación de la roca madre para más detalles.

Paso 2. Instale AWS CLI> Ejecutar aws configure en Terminal> Agregar credenciales desde el paso 1.

Para usar Ollama proporcionados LLM localmente en su computadora portátil, siga estos pasos.

Paso 1. Descargue Ollama Note los requisitos de memoria para cada modelo. Los modelos 7b generalmente requieren al menos 8 GB de RAM. Los modelos 13b generalmente requieren al menos 16 GB de RAM. Los modelos 70b generalmente requieren al menos 64 GB de RAM

Paso 2. Encuentre la biblioteca Ollama Model> Ejecutar comando ollama pull <model> en Terminal para descargar el modelo. Actualmente, GTSystem admite modelos populares como LLAMA2, Mistral y Llava.

Para usar modelos OpenAI, siga estos pasos.

Paso 1. Regístrese para el acceso a la API de OpenAI y obtenga la clave API.

Paso 2. Agregue la tecla API OpenAI a su ~/.zshrc o ~/.bashrc usando export OPENAI_API_KEY="your-key-here"

Para usar modelos abiertos en LPU de Groq Fast, siga estos pasos.

Paso 1. Regístrese para el acceso a la API Groq y obtenga la clave API.

Paso 2. Agregue la tecla API Groq a su ~/.zshrc o ~/.bashrc usando export GROQ_API_KEY="your-key-here"

Si eres nuevo en Python, entonces así es cómo puedes comenzar desde cero.

Primero, debería ejecutar el último Python en su sistema con Python Package Manager actualizado a lo último.

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23 Siga esta guía para Mac OS X si no tiene la última Python. Si instala la versión específica de Python para administrar las dependencias, siga este hilo para instalar utilizando pyenv Python Version Manager. Si se requiere, actualice PIP a lo último con el siguiente comando.

pip install --user --upgrade pipAhora crearemos un entorno virtual para nuestra configuración de MLOPS para que nuestras dependencias estén aisladas y no entren en conflicto con los paquetes instalados del sistema. Seguiremos esta guía para crear y administrar el entorno virtual. Primero cambie al directorio donde desarrollaremos nuestra aplicación.

python -m venv envSi ejecuta LS ENV, verá las siguientes carpetas y archivos creados.

bin include lib pyvenv.cfgAhora podemos activar nuestro entorno virtual así. Notará que el directorio de desarrollo prefijo (Env) para indicar que ahora se está ejecutando en el entorno virtual.

. env/bin/activatePuede confirmar que no está ejecutando dentro del entorno virtual con su propio Python.

which python

# # should return /Users/.../env/bin/pythonPara dejar el entorno virtual utilizando el comando Desactivate. Vuelva a ingresar usando el mismo comando que antes.