Un package Python à faible code pour fabriquer rapidement des applications Genai

Genai Techne est en mission pour aider les entreprises et les professionnels à excellent exceller dans le métier d'une IA générative. Consultez le Genai Techne Baskled où vous pouvez en savoir plus sur notre mission, lire la documentation GTSYSTEM, apprendre des tutoriels étape par étape et influencer la feuille de route de GTSystem pour vos cas d'utilisation.

Le démarrage à l'aide du package gtsystem suit ces étapes.

Étape 1. Installez le package gtsystem à l'aide de pip install gtsystem

Étape 2. Ouvrez un cahier Jupyter et essayez cet échantillon.

from gtsystem import openai , bedrock , anthropic , ollama , instrument

prompt = 'How many faces does a tetrahedron have?'

openai . text ( prompt )

bedrock . text ( prompt )

anthropic . text ( prompt )

ollama . text ( prompt )

instrument . metrics . stats ()Remarque: Pour installer les dépendances et configurer chacune des API du fournisseur, vous pouvez continuer à lire ici.

La source du package gtsystem est disponible dans ce référentiel sur GitHub.

Vous pouvez en savoir plus sur la vision derrière Gtsystem sur le Genai Techne Sublack Post.

Vous pouvez apprendre l'API gtsystem en suivant les échantillons de ordinateur portable inclus dans le repo gtsystem . Ces échantillons sont documentés sur le Genai Techne Sbsack.

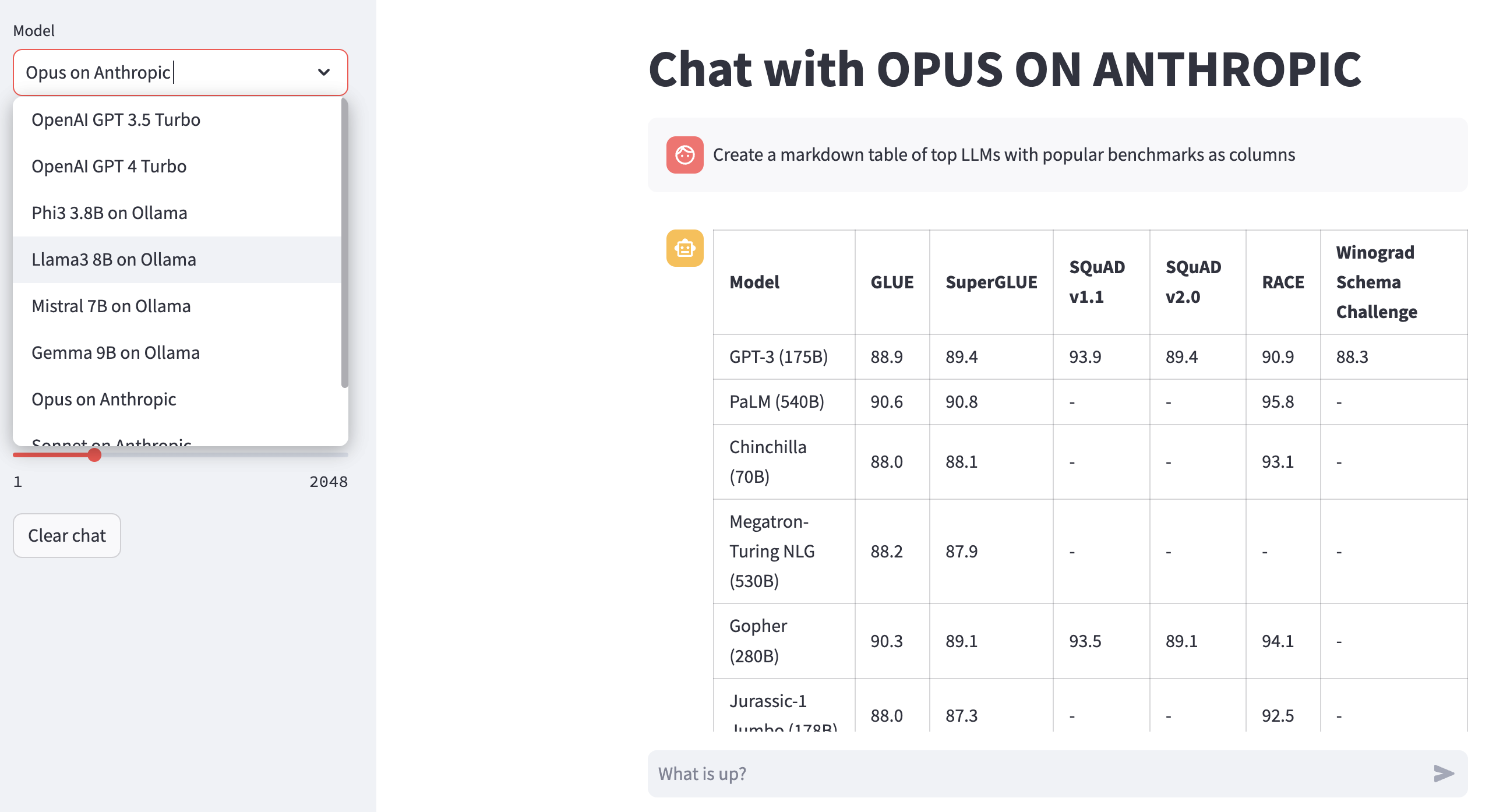

Revoir Modèle de classement: utilisez 00-leaderboard.ipynb pour examiner le classement du modèle, filtre par classement, vendeurs, modèles pour décider lequel explorer.

Évaluer les modèles à l'aide d'une ligne de code: Reportez-vous 01-evaluate.ipynb pour les évaluations d'invites à une seule instruction sur plusieurs modèles, notamment Openai GPT, Claude ou Llama hébergé par le fondement.

Render les réponses LLM: utilisez 02-render.ipynb pour le rendu formaté des réponses du modèle, y compris les tables de marque.

Tâches d'évaluation de chargement de Excel: essayez 03-tasks.ipynb pour automatiser les tâches d'évaluation - trouver, liste, charger les invites par tâche, y compris les valeurs optimales de paramètres pour la température et le TOPP.

Vitesse et taille de l'instrument (coût) de la réponse: Réutiliser 04-instrument.ipynb pour l'instrumentation et la comparaison de plusieurs modèles à travers la latence et la taille de la réponse.

Qualité de référence de réponse: utilisez 05-benchmark.ipynb pour la qualité d'analyse comparative automatisée des réponses de modèles comme Llama et Claude en utilisant GPT-4 comme évaluateur LLM.

Exécutez des modèles sur votre ordinateur portable: obtenez 06-ollama.ipynb pour exécuter des modèles comme Mistral, Llama et Codellama localement sur votre ordinateur portable et comparez des modèles hébergés sur des API de modèle cloud ou propriétaire.

Échantillon de code bas: consultez Simple 07-low-code-sample.ipynb pour apprécier le montant qui peut être fait avec des API gtsystem simples.

Passez du prototype à la production: commencez avec 08-prototype-to-production.ipynb pour passer du prototypage en utilisant les meilleurs modèles, puis explorer des modèles locaux sur l'ordinateur portable, en comparant enfin les fournisseurs les plus rapides comme le grêle dans un flux de travail sans couture.

Chat visuel sur le fondement: explorez 09-chat-bedrock.ipynb pour le chat visuel à l'aide de modèles hébergés de substratum rocheux.

Chat visuel sur anthropic: explorez 10-chat-anthropic.ipynb pour le chat visuel à l'aide de modèles hébergés anthropiques.

Chat visuel sur OpenAI: Explorez 11-chat-openai.ipynb pour le chat visuel à l'aide d'Openai GPT4-turbo.

Vous pouvez installer des dépendances suivantes pour travailler avec gtsystem en fonction de vos besoins. Commencez avec nos requirements.txt ou créez la vôtre. Ensuite, exécutez pip install -r requirements.txt dans votre environnement.

# Python capabilities

pandas

markdown

openpyxl

# Jupyter notebook

jupyterlab

ipywidgets

# AWS for Bedrock managed models

boto3

awscli

botocore

# OpenAI for GPT models

openai

# Anthropic models

anthropic

# Ollama for LLMs running on your laptop

ollama

# Groq for open models on fast Groq LPUs

groq

Pour utiliser des modèles hébergés d'Amazon comme Llama et Claude, suivez ces étapes.

Étape 1. Connectez-vous vers la console AWS> Lancement d'identité et d'accès à la gestion (IAM)> Créez un utilisateur pour l'accès à l'interface de ligne de commande (CLI). Lisez la documentation du substratum rocheux pour plus de détails.

Étape 2. Installez AWS CLI> Exécuter aws configure dans Terminal> Ajouter des informations d'identification à partir de l'étape 1.

Pour utiliser LLMS fourni localement Olllama sur votre ordinateur portable, suivez ces étapes.

Étape 1. Télécharger Olllama Remarquez les exigences de mémoire pour chaque modèle. Les modèles 7b nécessitent généralement au moins 8 Go de RAM. Les modèles 13B nécessitent généralement au moins 16 Go de RAM. Les modèles 70b nécessitent généralement au moins 64 Go de RAM

Étape 2. Trouver le modèle Olllama Library> Run Command ollama pull <model> dans le terminal pour télécharger le modèle. Actuellement, GTSystem prend en charge des modèles populaires comme Llama2, Mistral et Llava.

Pour utiliser les modèles OpenAI, suivez ces étapes.

Étape 1. Inscrivez-vous pour l'accès à l'API OpenAI et obtenez la clé API.

Étape 2. Ajoutez une touche API OpenAI à votre ~/.zshrc ou ~/.bashrc à l'aide de export OPENAI_API_KEY="your-key-here"

Pour utiliser des modèles ouverts sur des LPU à grooq rapides, suivez ces étapes.

Étape 1. Inscrivez-vous pour l'accès à l'API GROQ et obtenez la clé API.

Étape 2. Ajoutez une touche API GROQ à votre ~/.zshrc ou ~/.bashrc en utilisant export GROQ_API_KEY="your-key-here"

Si vous êtes nouveau sur Python, voici comment vous pouvez commencer à partir de zéro.

Tout d'abord, vous devriez exécuter le dernier Python de votre système avec Python Package Manager mis à niveau vers les dernières personnes.

python --version

# should return Python 3.10.x or higher as on Jan'23

pip --version

# should return pip 22.3.x or higher as on Jan'23 Suivez ce guide pour Mac OS X si vous n'avez pas le dernier Python. Si vous installez une version spécifique de Python pour gérer les dépendances, suivez ce fil pour installer à l'aide du gestionnaire de version pyenv Python. Si nécessaire, améliorez PIP vers le dernier en utilisant la commande suivante.

pip install --user --upgrade pipNous allons désormais créer un environnement virtuel pour notre configuration MOPLOP afin que nos dépendances soient isolées et ne sont pas en conflit avec les packages installés par le système. Nous suivrons ce guide pour créer et gérer l'environnement virtuel. Premièrement passer au répertoire où nous développerons notre application.

python -m venv envSi vous exécutez LS env, vous verrez des dossiers et des fichiers suivants créés.

bin include lib pyvenv.cfgNous pouvons maintenant activer notre environnement virtuel comme ainsi. Vous remarquerez que le répertoire de développement préfixé avec le (Env) indique que vous exécutez maintenant dans l'environnement virtuel.

. env/bin/activateVous pouvez confirmer que vous ne courez pas dans l'environnement virtuel avec son propre Python.

which python

# # should return /Users/.../env/bin/pythonPour quitter l'environnement virtuel en utilisant la commande désactivée. Réintégrez en utilisant la même commande que plus tôt.