模型|排行榜|方法论|评估|鲁棒性分析|限制|引用| Outlook |

Ethan Chern*,Haoyang Zou*,Xuefeng Li*,Jiewen Hu*,Kehua Feng,Junlong Li,Pengfei Liu+

[2023/12/12]我们发布了ABEL-7B-002 ,导致更强(GSM8K的增长35%,数学提高了126%)和更广泛的模型,在所有7B型号中达到了最佳性能(GSM8K上的80.44,MATH上的80.44,MATH上的29.46)

| 模型名称 | HF检查点 | GSM8K | 数学 | 执照 |

|---|---|---|---|---|

| Abel-7b-002 | ? 7b | 80.44 | 29.46 | Apache许可证2.0 |

| Abel-7b-001 | ? 7b | 59.74 | 13.00 | 美洲驼2 |

| Abel-13b-001 | ? 13b | 66.41 | 17.34 | 美洲驼2 |

| Abel-70B-001 | ? 70B | 83.62 | 28.26 | 美洲驼2 |

| 模型 | GSM8K | 数学 | Mathqa | svamp | SCQ5K-en | 弧 | 弧 | Hellaswag | mmlu |

|---|---|---|---|---|---|---|---|---|---|

| Abel-7b-002 | 80.44 | 29.46 | 69.78 | 77.67 | 55.95 | 77.67 | 55.05 | 77.72 | 61.19 |

| Abel-7b-001 | 59.74 | 13 | 1.21 | 57.67 | 9.3 | 53.32 | 38.97 | 63.51 | 40.59 |

| Metamath-Mistral-7b | 77.7 | 28.2 | 33.94 | 79.33 | 37.6 | 78.48 | 51.93 | 76.44 | 61.93 |

| QWEN-7B | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74.97 | 53.05 | 86.85 | 57.98 |

| Mistral-7b | 37.83 | 9.06 | 25.73 | 63 | 39.6 | 76.83 | 53.22 | 76.31 | 64.05 |

| Yi-6b | 32.6 | 5.78 | 26.98 | 55.67 | 35.5 | 73.66 | 49.53 | 68.97 | 64.02 |

| Llama2-7b | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

可以发现:

评估详细信息:

Abel是为尼尔斯·亨里克(Niels Henrik)亚伯(Niels Henrik Abel)致敬的代数和分析的开创性工作的致敬,我们的模型也相对更好。不过,我们还有很长的路要走吗?♂️?♀️ ?? ♂️?♀️?♀️?

我们表明:

我们已经在GSM8K( 83.62 )和Math( 28.26 )基准上建立了开源LLM(不使用外部工具)的新的最先进的性能。具体来说:

GAIRMath-Abel在排名前10位的排名中获得了3个职位,并成为榜单中唯一由大学主导的项目(其他是Star Startups或大型科技公司)。我们证明了这一点:

?代表开源模型?表明模型开发是由学术大学(而不是公司)领导的| 排行 | 模型 | 参数。 | 领导组织 | GSM8K | 数学 |

|---|---|---|---|---|---|

| 1 | GPT-4 | 未知 | Openai | 92.0 | 42.5 |

| 2 | 克劳德-2 | 未知 | 人类 | 88.0 | - |

| 3 | Palm-2-Flan | 未知 | 谷歌 | 84.7 | 33.2 |

| ? 4 | Gairmath-亚伯 | 70B | ?上海Jiotong大学的Gair Lab | 83.6 | 28.3 |

| ? 5 | 巫师 | 70B | 微软 | 81.6 | 22.7 |

| 6 | 克劳德·纳斯特 | 未知 | 人类 | 80.9 | - |

| 7 | chatgpt | 未知 | Openai | 80.8 | 34.1 |

| ? 4 | 亚伯-002 | 7b | ?上海Jiotong大学的Gair Lab | 80.4 | 29.5 |

| 8 | CHATGPT-0301 | 未知 | Openai | 74.9 | - |

| ? 9 | Gairmath-亚伯 | 13b | ?上海Jiotong大学的Gair Lab | 66.4 | 17.3 |

| ? 10 | Gairmath-亚伯 | 7b | ?上海Jiotong大学的Gair Lab | 59.7 | 13.0 |

| 11 | 密涅瓦 | 540b | 谷歌 | 58.8 | 33.6 |

| 12 | 棕榈 | 540b | 谷歌 | 56.9 | 8.8 |

| ? 13 | Llama-2 | 70B | 元 | 56.8 | 13.5 |

| ? 14 | rft | 33b | Ofa | 56.5 | 7.4 |

| ? 15 | Baichuan2-13b | 13b | Baichuan | 52.8 | 10.1 |

| 16 | 密涅瓦 | 62B | 谷歌 | 52.4 | 27.6 |

| 17 | 棕榈 | 64B | 谷歌 | 52.4 | 4.4 |

| ? 18 | rft | 13b | Ofa | 52.1 | 5.1 |

| ? 19 | 骆驼 | 65B | 元 | 50.9 | 10.6 |

| ? 20 | QWEN | 7b | 阿里巴巴 | 44.9 | 8.5 |

| 21 | 龙猫 | 70B | 深态 | 43.7 | - |

| ? 22 | Llama-2 | 34B | 元 | 42.2 | 6.24 |

| 23 | 银河系 | 30b | 元 | 41.7 | 12.7 |

| ? 24 | chatglm2 | 12b | Zhipu | 40.9 | - |

| 25 | text-davinci-002 | 175b | Openai | 40.7 | 19.1 |

| ? 26 | 骆驼 | 33b | 元 | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| ? 28 | Internlm | 7b | 上海AI实验室 | 31.2 | - |

| ? 29 | Llama-2 | 13b | 元 | 28.7 | 3.9 |

| ? 30 | Vicuna v1.3 | 13b | lmsys | 27.6 | - |

| ? 31 | 鹘 | 40b | 技术创新研究所 | 19.6 | 2.5 |

| ? 32 | 骆驼 | 13b | 元 | 17.8 | 3.9 |

| ? 33 | MPT | 30b | Mosaicml | 15.2 | 3.1 |

| 34 | 银河系 | 6.7b | 元 | 10.2 | 2.2 |

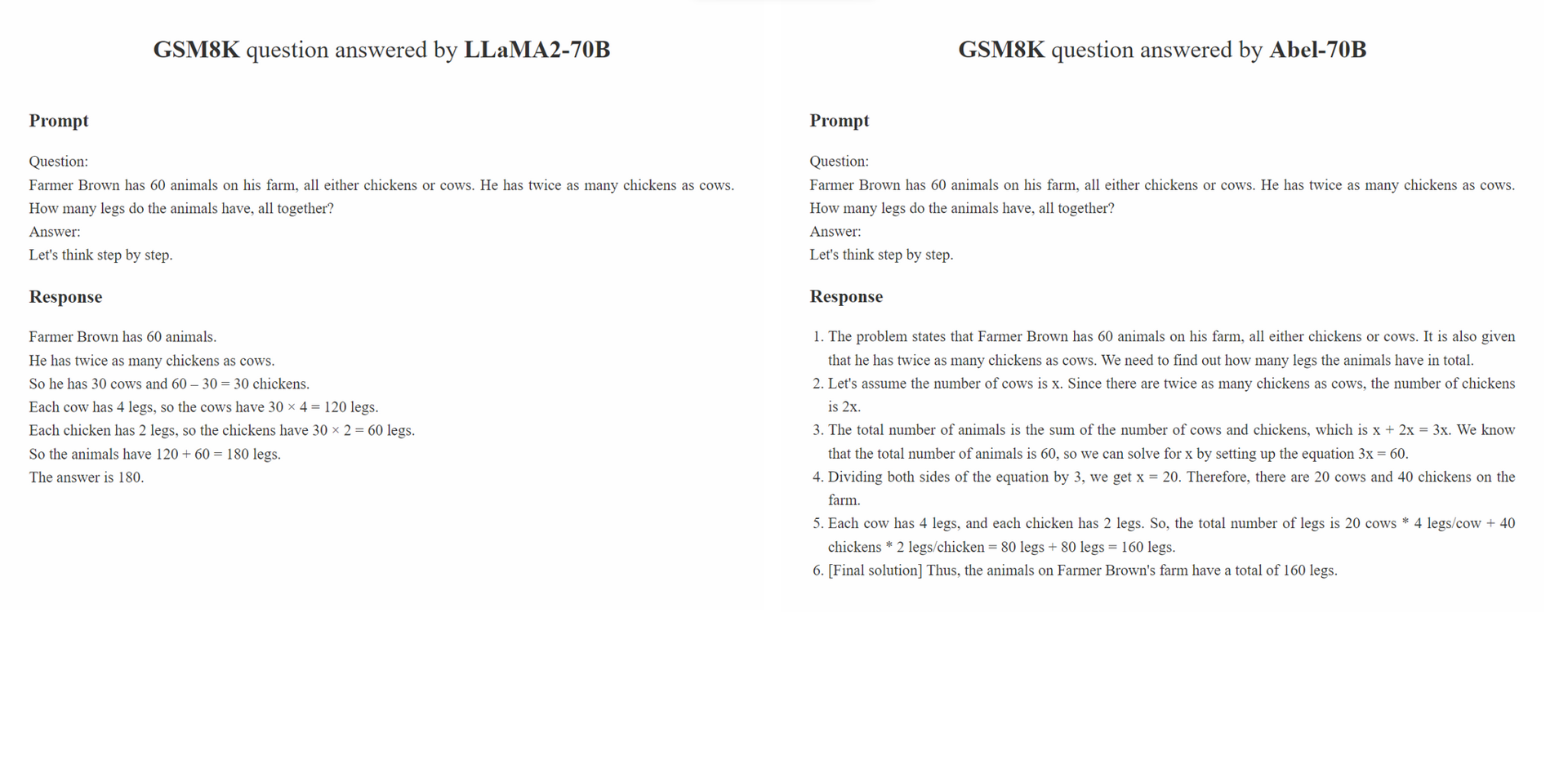

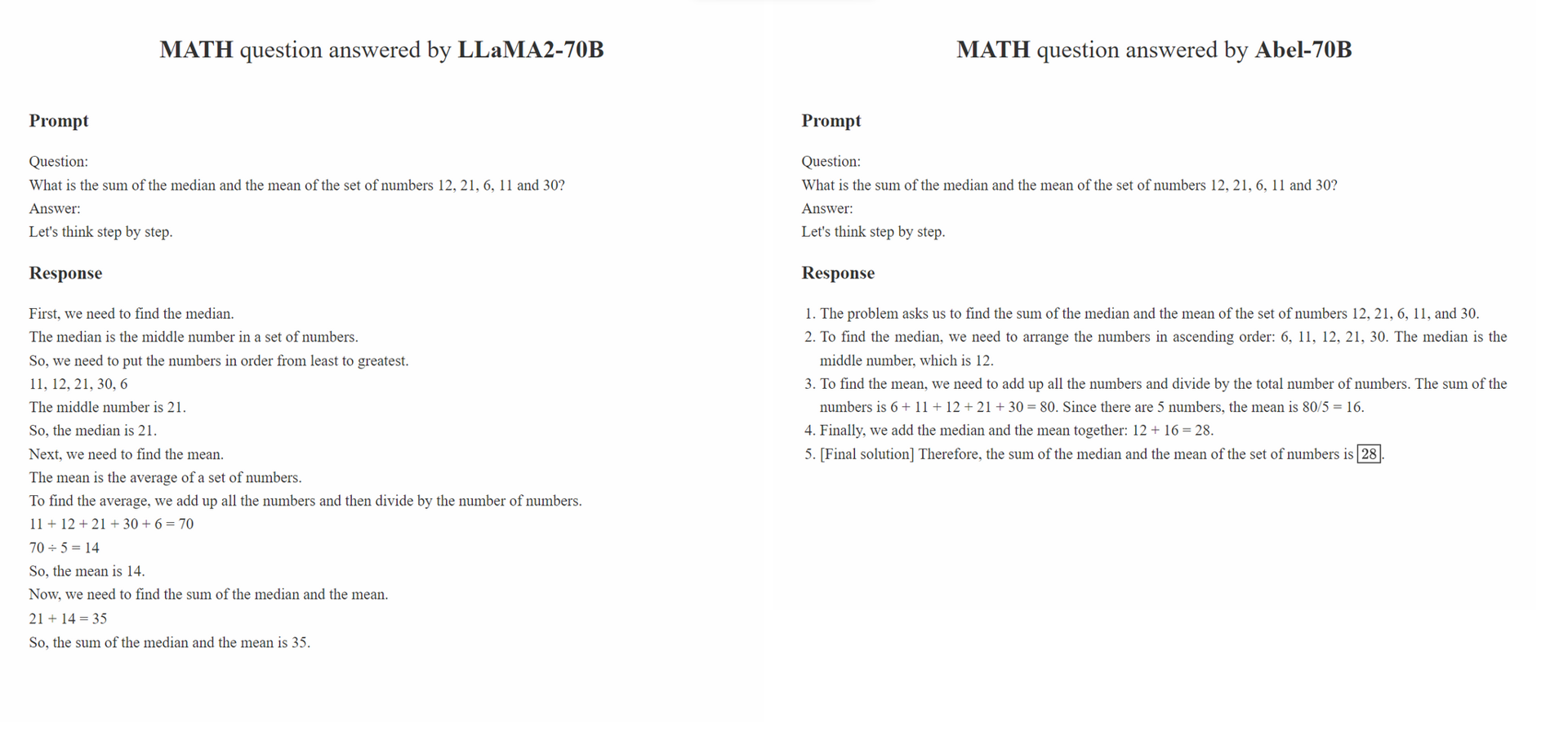

我们提出了父母监督,这是一种监督微调的保姆策略,

Parental Oversight不仅限于任何特定的数据处理方法。相反,它定义了数据处理理念,该理念应指导生成AI(GAI)时代的监督微调。我们认为,在GAI时代,数据结构工程已成为新的范式。在此范式中,处理微调数据的方式显着影响训练有素的GAI的性能。我们希望社区中越来越多的研究专注于这种数据处理理念。

Parental Oversight的原则强调以谨慎和审慎的态度对待受监督的微调。这类似于鼓励父母教育孩子的方式。不同类型的数据及其演示格式(例如,分步推理,迭代精致)可以比喻为各种教育方法。正如父母谨慎选择指导孩子的最有效方法一样,GAI从业者应谨慎选择最有效的数据处理方法,以更好地指导其LLM。

此外,“越多的数据,越好”的理念并不总是成立。带注释的样本的质量和相关性通常会超过其数量。 SFT中使用的培训样本不仅应提供正确的答案,而且还应根据LLM的知识来指导模型如何得出正确的答案。此外,如果LLM的知识不足以回答问题, Parental Oversight应介入以迅速解决知识差距。

conda create -n abel python=3.10conda activate abelpip install -r requirements.txt 。bash evaluation/eval.sh 。评估脚本的一部分是从密涅瓦修改的。./outputs目录中检查我们的评估输出。 我们的稳健性分析包括两个部分:对GSM8K_ROBUST数据集的对抗评估,并在TAL-SCQ5K-EN数据集中进行了监督的转移学习。我们执行初步分析以了解(1)ABEL是否过度拟合训练数据集,因此对于分布式测试样本而言是脆弱的,以及(2)我们的SFT方法是否可以快速转移并从不同分布中转移ABEL到数据集。

GSM8K_ROBUST数据集是我们基于GSM8K数据集建立的数据集。我们使用GPT-4随机修改了GSM8K数据集问题中的数字,而无需更改问题中的任何其他信息。我们还要求GPT-4为修改后的问题生成“金色答案”。在手动审查了这些样品的子集后,我们发现所有改变的问题的生成答案都是准确的。我们利用GSM8K_ROBUST数据集来评估模型是否拟合训练数据,使模型容易受到分布外测试样本的影响。我们的分析表明,与其他模型相比,ABEL对分布式测试样品更强大。

| 模型 | GSM8K | gsm8k_robust | 三角洲 |

|---|---|---|---|

| 亚伯-7b | 59.74 | 58.23 | -1.51 |

| 亚伯-13b | 66.41 | 66.57 | +0.16 |

| 亚伯-70B | 83.62 | 81.80 | -1.82 |

| Wizardmath-70B | 81.60 | 74.91 | -6.70 |

| Wizardmath-13b | 63.90 | 59.51 | -4.39 |

| RFT-7B | 41.7 | 37.98 | -3.72 |

我们证明,ABEL-70B不仅可以在GSM8K和数学数据集上实现SOTA,而且还可以很好地推广到TAL-SCQ5K-EN 2K,这是Math LLM提供商TAL(tal)新发布的数据集(tal)。我们的分析表明,我们的SFT方法可以成功地将ABEL概括为来自不同分布的数据集。我们将进行进一步的分析和实验,以探索和改善亚伯的泛化能力。

| 模型 | TAL-SCQ5K-EN 2K测试基准测试 |

|---|---|

| 亚伯-70B | 59.7 |

| Mathgpt | 59.0 |

| GPT-4 | 51.0 |

| Llama-70B | 43.8 |

我们创建了一系列问题,以维持这些局限性和潜在的解决方案。总是欢迎您的意见和评论。

如果此存储库中的型号/代码/结论对您有所帮助,请引用回购。

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

我们正在不断完善我们的模型,并将发布更新。敬请关注!