Modell | Rangliste | Methodik | Bewertung | Robustheitsanalyse | Einschränkung | Zitat | Outlook |

Ethan Chern*, Haoyang Zou*, Xuefeng li*, Jiewen Hu*, Kehua Feng, Junlong Li, Pengfei Liu+

[2023/12/12] Wir haben ABEL-7B-002 veröffentlicht, was zu einer stärkeren (35% igen Verbesserung der GSM8K, 126% Verbesserung der Mathematik) und einem allgemeineren Modell, das die beste Leistung unter allen 7B-Modellen erzielt (80,44 auf GSM8K, 29,46 auf Mathe) erzielt, 29,46 auf Mathe).

| Modellname | HF -Kontrollpunkte | GSM8K | MATHE | Lizenz |

|---|---|---|---|---|

| ABEL-7B-002 | ? 7b | 80.44 | 29.46 | Apache -Lizenz 2.0 |

| ABEL-7B-001 | ? 7b | 59.74 | 13.00 | Lama 2 |

| ABEL-13B-001 | ? 13b | 66.41 | 17.34 | Lama 2 |

| ABEL-70B-001 | ? 70b | 83.62 | 28.26 | Lama 2 |

| Modell | GSM8K | MATHE | Mathqa | Svamp | SCQ5K-EN | Bogen-e | ARC-C | Hellaswag | MMLU |

|---|---|---|---|---|---|---|---|---|---|

| ABEL-7B-002 | 80.44 | 29.46 | 69.78 | 77,67 | 55,95 | 77,67 | 55.05 | 77,72 | 61.19 |

| ABEL-7B-001 | 59.74 | 13 | 1.21 | 57.67 | 9.3 | 53.32 | 38,97 | 63,51 | 40.59 |

| Metamath-MISTRAL-7B | 77,7 | 28.2 | 33.94 | 79,33 | 37.6 | 78,48 | 51.93 | 76,44 | 61.93 |

| Qwen-7b | 47,84 | 9.34 | 27.44 | 53 | 40.05 | 74,97 | 53.05 | 86,85 | 57.98 |

| Mistral-7b | 37.83 | 9.06 | 25.73 | 63 | 39.6 | 76,83 | 53.22 | 76,31 | 64.05 |

| Yi-6b | 32.6 | 5.78 | 26.98 | 55.67 | 35.5 | 73,66 | 49,53 | 68,97 | 64.02 |

| LAMA2-7B | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46,7 |

Es kann festgestellt werden, dass:

Bewertungsdetails:

Abel wurde als Hommage an Niels Henrik Abel für seine bahnbrechende Arbeit in Algebra und Analyse geschaffen, bei denen auch unser Modell relativ besser ist. Es gibt jedoch noch einen langen Weg für uns zu gehen?

Wir zeigen das:

Wir haben eine neue hochmoderne Leistung in Open-Source-LLMs (die keine externen Werkzeuge verwenden) auf den Benchmarks GSM8K ( 83,62 ) und Math (28.26) auf den GSM8K (83.62) und in den Benchmarks GSM8K ( 83,62 ) eingerichtet. Speziell:

GAIRMath-Abel sichert 3 Positionen in den Top 10 Ranglisten und ist das einzige von Universität geführte Projekt in der Liste (andere sind entweder Star-Startups oder große Technologieunternehmen).Wir zeigen das:

? repräsentiert das Open-Source-Modell? legt nahe, dass die Modellentwicklung von der akademischen Universität (anstelle von Unternehmen) geleitet wird| Rang | Modell | Param. | Führende Organisation | GSM8K | MATHE |

|---|---|---|---|---|---|

| 1 | GPT-4 | unbekannt | Openai | 92.0 | 42,5 |

| 2 | Claude-2 | unbekannt | Anthropisch | 88.0 | - - |

| 3 | Palm-2-Flan | unbekannt | 84.7 | 33.2 | |

| ? 4 | Gairmathabel | 70b | ? Gair Labor an der Shanghai Jiaotong University | 83.6 | 28.3 |

| ? 5 | Wizardmath | 70b | Microsoft | 81.6 | 22.7 |

| 6 | Claude-Instant | unbekannt | Anthropisch | 80.9 | - - |

| 7 | Chatgpt | unbekannt | Openai | 80.8 | 34.1 |

| ? 4 | Abel -002 | 7b | ? Gair Labor an der Shanghai Jiaotong University | 80.4 | 29,5 |

| 8 | CHATGPT-0301 | unbekannt | Openai | 74,9 | - - |

| ? 9 | Gairmathabel | 13b | ? Gair Labor an der Shanghai Jiaotong University | 66,4 | 17.3 |

| ? 10 | Gairmathabel | 7b | ? Gair Labor an der Shanghai Jiaotong University | 59.7 | 13.0 |

| 11 | Minerva | 540b | 58,8 | 33.6 | |

| 12 | Palme | 540b | 56,9 | 8.8 | |

| ? 13 | LAMA-2 | 70b | Meta | 56,8 | 13.5 |

| ? 14 | Rft | 33b | OFA | 56,5 | 7.4 |

| ? 15 | Baichuan2-13b | 13b | Baichuan | 52,8 | 10.1 |

| 16 | Minerva | 62b | 52.4 | 27.6 | |

| 17 | Palme | 64b | 52.4 | 4.4 | |

| ? 18 | Rft | 13b | OFA | 52.1 | 5.1 |

| ? 19 | Lama | 65b | Meta | 50.9 | 10.6 |

| ? 20 | Qwen | 7b | Alibaba | 44,9 | 8.5 |

| 21 | Chinchilla | 70b | Deepmind | 43.7 | - - |

| ? 22 | LAMA-2 | 34b | Meta | 42.2 | 6.24 |

| 23 | Galactica | 30b | Meta | 41.7 | 12.7 |

| ? 24 | Chatglm2 | 12b | Zhipu | 40.9 | - - |

| 25 | Text-Davinci-002 | 175b | Openai | 40.7 | 19.1 |

| ? 26 | Lama | 33b | Meta | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| ? 28 | Internlm | 7b | Shanghai AI Lab | 31.2 | - - |

| ? 29 | LAMA-2 | 13b | Meta | 28.7 | 3.9 |

| ? 30 | Vicuna v1.3 | 13b | LMSYS | 27.6 | - - |

| ? 31 | Falke | 40b | Technology Innovation Institute | 19.6 | 2.5 |

| ? 32 | Lama | 13b | Meta | 17.8 | 3.9 |

| ? 33 | Mpt | 30b | Mosaicml | 15.2 | 3.1 |

| 34 | Galactica | 6.7b | Meta | 10.2 | 2.2 |

Wir schlagen die Aufsicht der Eltern vor, eine Babysitter-Strategie für die Überwachung der Feinabstimmung,

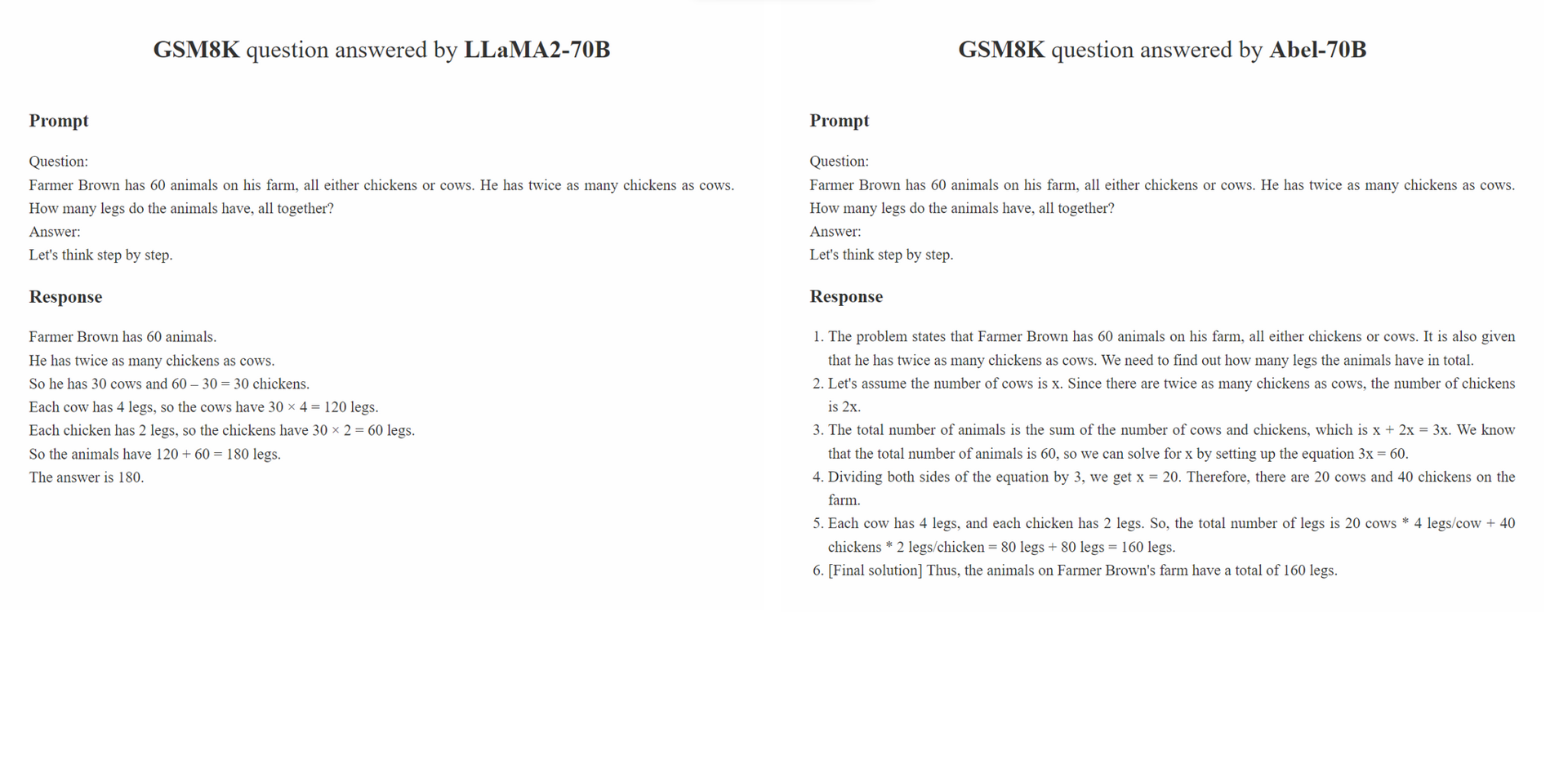

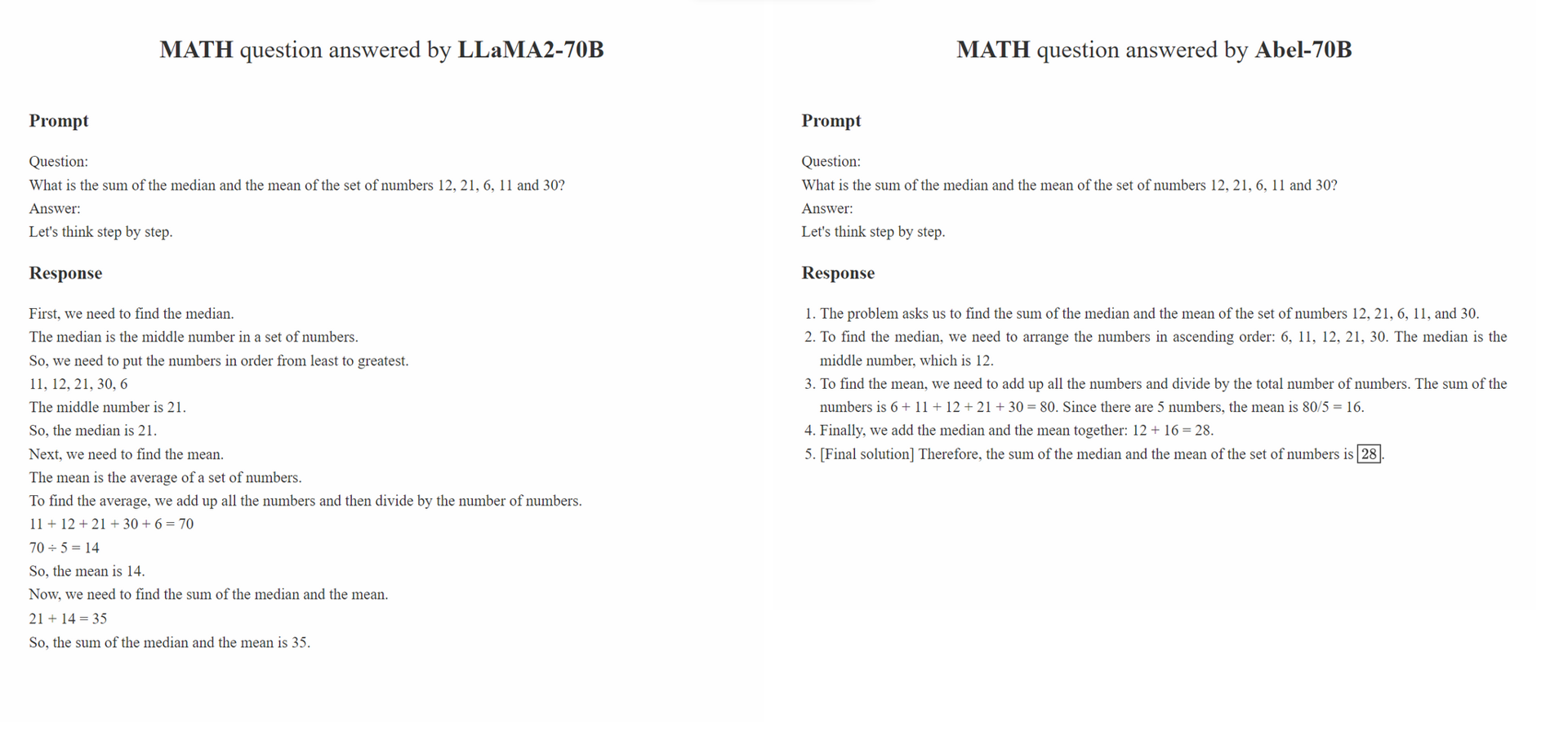

Parental Oversight ist nicht auf eine bestimmte Datenverarbeitungsmethode beschränkt. Stattdessen definiert es die Datenverarbeitungsphilosophie, die die beaufsichtigte Feinabstimmung im Zeitalter der generativen KI (GAI) leiten sollte. Wir glauben, dass die Datenstruktur Engineering in der Ära von GAI zu einem neuen Paradigma entstanden ist. In diesem Paradigma wird die Art und Weise, wie die Feinabstimmungsdaten verarbeitet werden, die Leistung des geschulten GAI erheblich beeinflusst. Wir erwarten, dass eine wachsende Anzahl von Studien in der Community sich auf diese Datenverarbeitungsphilosophie konzentriert.

Das Prinzip der Parental Oversight betont die Behandlung von beaufsichtigter Feinabstimmung mit Sorgfalt und Klugheit. Dies ist analog zu der Art und Weise, wie Eltern ermutigt werden, ihre Kinder zu erziehen. Verschiedene Arten von Daten sowie ihre Präsentationsformate (z. B. schrittweise Argumentation, iterative Verfeinerung) können mit unterschiedlichen Bildungsmethoden verglichen werden. So wie die Eltern vorsichtig den effektivsten Ansatz für ihre Kinder auswählen, sollten GAI -Praktiker vorsichtig die effektivsten Datenverarbeitungsansätze auswählen, um ihre LLMs besser zu unterweisen.

Darüber hinaus gilt die Philosophie "Je mehr Daten, desto besser". Die Qualität und Relevanz von kommentierten Proben kann häufig ihre Menge überwiegen. In SFT verwendete Trainingsproben sollten nicht nur die richtige Antwort präsentieren, sondern auch das Modell darüber anweisen, wie die richtige Antwort basierend auf dem Wissen der LLM abgeleitet wurde. Wenn das Wissen des LLM nicht ausreicht, um eine Frage zu beantworten, sollte Parental Oversight eingehen, um die Wissenslücken umgehend zu beheben.

conda create -n abel python=3.10conda activate abelpip install -r requirements.txt ausführen.txt.bash evaluation/eval.sh . Ein Teil des Evaluierungsskripts wird von Minerva geändert../outputs überprüfen. Unsere Robustheitsanalyse besteht aus zwei Teilen: einer kontroversen Bewertung des Datensatzes GSM8K_ROBUST und dem Überwachung von Transferlernen auf dem TAL-SCQ5K-EN-Datensatz . Wir führen eine vorläufige Analyse durch, um zu verstehen (1), ob Abel den Trainingsdatensatz übertroffen hat und somit spröde für Proben außerhalb des Verteilungsverteilungstests ist, und (2), ob unser SFT-Ansatz Abel schnell übertragen und auf Datensätze aus verschiedenen Verteilungen verallgemeinern kann.

Der GSM8K_ROBUST -Datensatz ist ein Datensatz, den wir basierend auf dem GSM8K -Datensatz erstellt haben. Wir haben die Zahlen innerhalb der Fragen des GSM8K-Datensatzes zufällig geändert, ohne andere Informationen in den Fragen mit GPT-4 zu ändern. Wir haben GPT-4 auch gebeten, die "goldenen Antworten" für die geänderten Fragen zu generieren. Nachdem wir eine Untergruppe dieser Proben manuell überprüft hatten, stellten wir fest, dass alle generierten Antworten auf die veränderten Fragen korrekt waren. Wir haben den Datensatz von GSM8K_ROBUST verwendet, um zu bewerten, ob die Modelle die Trainingsdaten überwinden und die Modelle für Außenverteilungsproben anfällig machen. Unsere Analyse zeigt, dass Abel im Vergleich zu anderen Modellen robuster für Proben außerhalb des Verteilungsverteilungen ist.

| Modell | GSM8K | Gsm8k_robust | Delta |

|---|---|---|---|

| Abel-7b | 59.74 | 58.23 | -1.51 |

| Abel-13b | 66.41 | 66,57 | +0.16 |

| Abel-70b | 83.62 | 81.80 | -1.82 |

| Wizardmath-70b | 81.60 | 74,91 | -6.70 |

| Wizardmath-13b | 63,90 | 59,51 | -4.39 |

| Rft-7b | 41.7 | 37,98 | -3.72 |

Wir zeigen, dass ABEL-70B nicht nur SOTA auf den GSM8K- und Mathematikdatensätzen erreicht, sondern auch gut auf tal-scq5k-en 2k verallgemeinert, einem neu veröffentlichten Datensatz von Math LLM Anbieter Tal (好未來). Unsere Analyse zeigt, dass unser SFT -Ansatz Abel erfolgreich auf Datensätze aus verschiedenen Verteilungen verallgemeinern kann. Wir werden weitere Analysen und Experimente durchführen, um die Verallgemeinerungsfähigkeiten von Abel zu untersuchen und zu verbessern.

| Modell | Tal-scq5k-en 2k Test Benchmark |

|---|---|

| Abel-70b | 59.7 |

| Mathgpt | 59.0 |

| GPT-4 | 51.0 |

| Lama-70b | 43,8 |

Wir haben eine Liste von Problemen erstellt, um diese Einschränkungen und potenziellen Lösungen aufrechtzuerhalten. Ihre Meinungen und Kommentare sind immer willkommen.

Bitte zitieren Sie das Repo, wenn das Modell/Code/die Schlussfolgerung in diesem Repo für Sie hilfreich ist.

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

Wir verfeinern unsere Modelle kontinuierlich und werden Aktualisierungen veröffentlichen. Bleiben Sie dran!