모델 | 리더 보드 | 방법론 | 평가 | 견고성 분석 | 제한 | 인용 | 전망 |

Ethan Chern*, Haoyang Zou*, Xuefeng Li*, Jiewen Hu*, Kehua Feng, Junlong Li, Pengfei Liu+

[2023/12/12] 우리는 ABEL-7B-002를 릴리스하여 GSM8K의 35% 개선, 수학에 대한 126% 개선) 및보다 일반화 된 모델 (GSM8K의 80.44, 수학 29.46) 중 최상의 성능을 달성했습니다.

| 모델 이름 | HF 체크 포인트 | GSM8K | 수학 | 특허 |

|---|---|---|---|---|

| ABEL-7B-002 | ? 7b | 80.44 | 29.46 | 아파치 라이센스 2.0 |

| ABEL-7B-001 | ? 7b | 59.74 | 13.00 | 라마 2 |

| ABEL-13B-001 | ? 13b | 66.41 | 17.34 | 라마 2 |

| ABEL-70B-001 | ? 70b | 83.62 | 28.26 | 라마 2 |

| 모델 | GSM8K | 수학 | Mathqa | svamp | scq5k-en | 아크 -E | 아크 -C | Hellaswag | MMLU |

|---|---|---|---|---|---|---|---|---|---|

| ABEL-7B-002 | 80.44 | 29.46 | 69.78 | 77.67 | 55.95 | 77.67 | 55.05 | 77.72 | 61.19 |

| ABEL-7B-001 | 59.74 | 13 | 1.21 | 57.67 | 9.3 | 53.32 | 38.97 | 63.51 | 40.59 |

| Metamath-Mistral-7b | 77.7 | 28.2 | 33.94 | 79.33 | 37.6 | 78.48 | 51.93 | 76.44 | 61.93 |

| Qwen-7b | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74.97 | 53.05 | 86.85 | 57.98 |

| Mistral-7b | 37.83 | 9.06 | 25.73 | 63 | 39.6 | 76.83 | 53.22 | 76.31 | 64.05 |

| Yi-6B | 32.6 | 5.78 | 26.98 | 55.67 | 35.5 | 73.66 | 49.53 | 68.97 | 64.02 |

| llama2-7b | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

다음을 찾을 수 있습니다.

평가 세부 사항 :

Abel Niels Henrik Abel에게 대수학 및 분석 분야의 획기적인 작업을 위해 공물로 만들어졌으며, 여기서 우리 모델도 비교적 더 좋습니다. 그래도 우리가 갈 수있는 먼 길이 여전히 있습니까? ♂️? ♀️?

우리는 그것을 보여줍니다 :

우리는 GSM8K ( 83.62 ) 및 Math ( 28.26 ) 벤치 마크에서 오픈 소스 LLM (외부 도구를 사용하지 않는)에서 새로운 최첨단 성능을 설정했습니다. 구체적으로:

GAIRMath-Abel 상위 10 위 순위에서 3 개의 포지션을 확보하고 목록에서 유일한 대학 주도 프로젝트 (다른 스타트 업 또는 대기업 회사)입니다.우리는 다음을 보여줍니다.

? 오픈 소스 모델을 나타냅니다? 모델 개발은 (회사 대신) 학술 대학에서 주도한다고 제안합니다.| 순위 | 모델 | 파라. | 주요 조직 | GSM8K | 수학 |

|---|---|---|---|---|---|

| 1 | GPT-4 | 알려지지 않은 | Openai | 92.0 | 42.5 |

| 2 | 클로드 -2 | 알려지지 않은 | 인류 | 88.0 | - |

| 3 | 손바닥 -2- 플랜 | 알려지지 않은 | 84.7 | 33.2 | |

| ? 4 | Gairmath- Abel | 70b | ? 상하이 Jiaotong University의 Gair Lab | 83.6 | 28.3 |

| ? 5 | 마법사 | 70b | 마이크로 소프트 | 81.6 | 22.7 |

| 6 | 클로드에 영향을 미칩니다 | 알려지지 않은 | 인류 | 80.9 | - |

| 7 | chatgpt | 알려지지 않은 | Openai | 80.8 | 34.1 |

| ? 4 | 아벨 -002 | 7b | ? 상하이 Jiaotong University의 Gair Lab | 80.4 | 29.5 |

| 8 | chatgpt-0301 | 알려지지 않은 | Openai | 74.9 | - |

| ? 9 | Gairmath- Abel | 13b | ? 상하이 Jiaotong University의 Gair Lab | 66.4 | 17.3 |

| ? 10 | Gairmath- Abel | 7b | ? 상하이 Jiaotong University의 Gair Lab | 59.7 | 13.0 |

| 11 | 미네르바 | 540b | 58.8 | 33.6 | |

| 12 | 손바닥 안에 감추다 | 540b | 56.9 | 8.8 | |

| ? 13 | llama-2 | 70b | 메타 | 56.8 | 13.5 |

| ? 14 | RFT | 33b | OFA | 56.5 | 7.4 |

| ? 15 | Baichuan2-13b | 13b | Baichuan | 52.8 | 10.1 |

| 16 | 미네르바 | 62b | 52.4 | 27.6 | |

| 17 | 손바닥 안에 감추다 | 64b | 52.4 | 4.4 | |

| ? 18 | RFT | 13b | OFA | 52.1 | 5.1 |

| ? 19 | 야마 | 65b | 메타 | 50.9 | 10.6 |

| ? 20 | Qwen | 7b | 알리바바 | 44.9 | 8.5 |

| 21 | 친칠라 | 70b | 심해 | 43.7 | - |

| ? 22 | llama-2 | 34b | 메타 | 42.2 | 6.24 |

| 23 | galactica | 30b | 메타 | 41.7 | 12.7 |

| ? 24 | chatglm2 | 12b | Zhipu | 40.9 | - |

| 25 | Text-Davinci-002 | 175b | Openai | 40.7 | 19.1 |

| ? 26 | 야마 | 33b | 메타 | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| ? 28 | internlm | 7b | 상하이 AI 실험실 | 31.2 | - |

| ? 29 | llama-2 | 13b | 메타 | 28.7 | 3.9 |

| ? 30 | 비쿠나 v1.3 | 13b | lmsys | 27.6 | - |

| ? 31 | 매 | 40b | 기술 혁신 연구소 | 19.6 | 2.5 |

| ? 32 | 야마 | 13b | 메타 | 17.8 | 3.9 |

| ? 33 | MPT | 30b | 모자이크 | 15.2 | 3.1 |

| 34 | galactica | 6.7b | 메타 | 10.2 | 2.2 |

우리는 부모의 감독 , 감독 된 미세 조정을위한 탁아 전략 ,

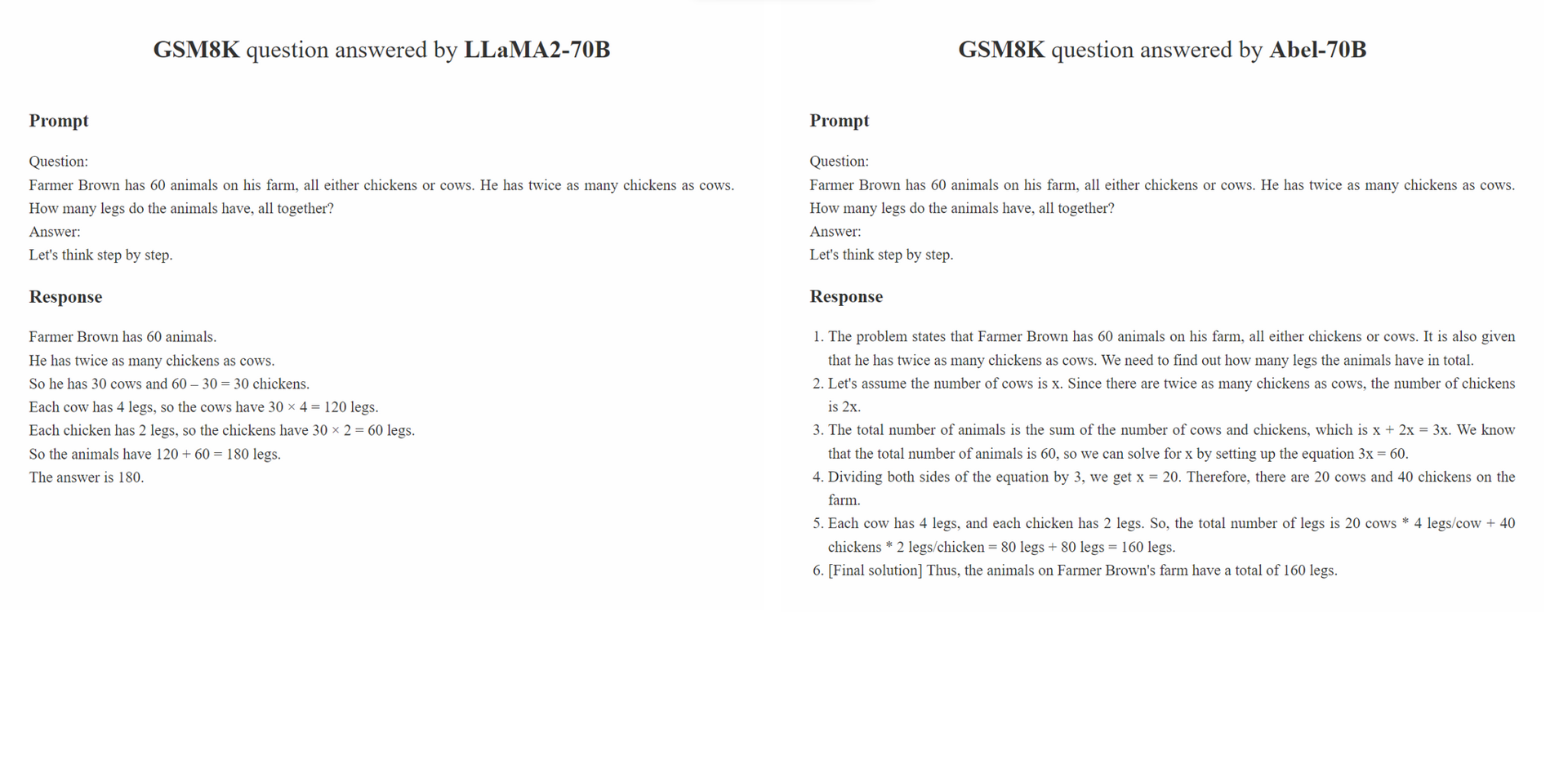

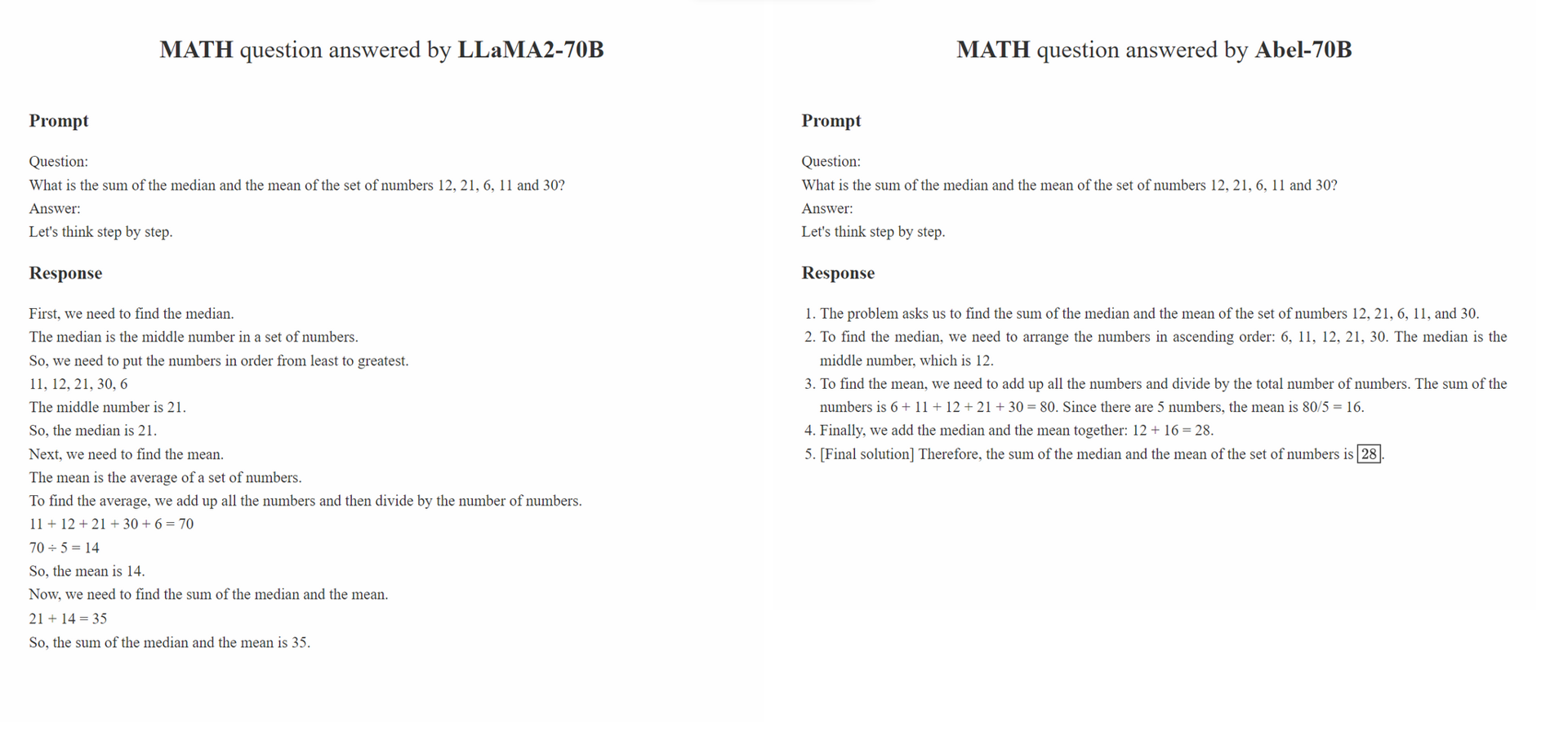

Parental Oversight 특정 데이터 처리 방법에만 국한되지 않습니다. 대신, 생성 AI (GAI) 시대에 감독 된 미세 조정을 안내하는 데이터 처리 철학을 정의합니다. 우리는 GAI 시대에 데이터 구조 공학이 새로운 패러다임으로 등장했다고 믿습니다. 이 패러다임 내에서 미세 조정 데이터가 처리되는 방식은 훈련 된 GAI의 성능에 크게 영향을 미칩니다. 우리는 지역 사회에서 점점 더 많은 연구 가이 데이터 처리 철학에 중점을두기를 기대합니다.

Parental Oversight 원칙은 감독 된 미세 조정을주의와 신중하게 대우하는 것을 강조합니다. 이것은 부모가 자녀를 교육하도록 장려되는 방식과 유사합니다. 다른 유형의 데이터와 프리젠 테이션 형식 (예 : 단계별 추론, 반복 정제)과 함께 다양한 교육 방법에 비유 될 수 있습니다. 부모가 자녀에게 가장 효과적인 접근 방식을 조심스럽게 선택하는 것처럼 GAI 실무자들은 LLM을 더 잘 지시하기 위해 가장 효과적인 데이터 처리 방법을 조심스럽게 선택해야합니다.

또한 "데이터가 많을수록 더 나은"철학이 항상 사실이 아닙니다. 주석이 달린 샘플의 품질과 관련성은 종종 양을 능가 할 수 있습니다. SFT에 사용 된 훈련 샘플은 정답을 제시해야 할뿐만 아니라 LLM에 대한 지식에 따라 정답이 어떻게 도출되었는지에 대한 모델을 지시해야합니다. 또한 LLM의 지식이 질문에 답하기에 충분하지 않은 경우, Parental Oversight 지식 격차를 신속하게 해결하기 위해 발전해야합니다.

conda create -n abel python=3.10 만듭니다conda activate abelpip install -r requirements.txt 실행합니다 .txt.bash evaluation/eval.sh 실행하십시오. 평가 스크립트의 일부는 Minerva에서 수정되었습니다../outputs 디렉토리에서 평가 출력을 확인할 수도 있습니다. 우리의 견고성 분석은 GSM8K_ROBUST 데이터 세트에 대한 대적 평가 및 TAL-SCQ5K-EN 데이터 세트의 감독 전송 학습의 두 부분으로 구성됩니다. 우리는 (1) Abel이 훈련 데이터 세트를 과도하게 유지하고 분포되지 않은 테스트 샘플에 부서지기 쉬우 며 (2) SFT 접근 방식이 다른 분포에서 데이터 세트로 Abel을 빠르게 전송하고 일반화 할 수 있는지 여부를 이해하기 위해 예비 분석을 수행합니다.

GSM8K_ROBUST 데이터 세트는 GSM8K 데이터 세트를 기반으로 설정 한 데이터 세트입니다. GPT-4를 사용하여 질문의 다른 정보를 변경하지 않고 GSM8K 데이터 세트의 질문 내에서 숫자를 무작위로 수정했습니다. 우리는 또한 GPT-4에게 수정 된 질문에 대한 '골든 답변'을 생성하도록 요청했습니다. 이 샘플의 서브 세트를 수동으로 검토 한 후 변경된 질문에 대한 모든 생성 된 답변이 정확하다는 것을 발견했습니다. 우리는 GSM8K_ROBUST 데이터 세트를 사용하여 모델이 교육 데이터에 과잉 맞는 지 여부를 평가하여 모델이 분포되지 않은 테스트 샘플에 취약하게 만들었습니다. 우리의 분석에 따르면 Abel은 다른 모델에 비해 분포되지 않은 테스트 샘플에 더 강력하다는 것을 나타냅니다.

| 모델 | GSM8K | gsm8k_robust | 델타 |

|---|---|---|---|

| ABEL-7B | 59.74 | 58.23 | -1.51 |

| Abel-13b | 66.41 | 66.57 | +0.16 |

| ABEL-70B | 83.62 | 81.80 | -1.82 |

| 마법사 -70b | 81.60 | 74.91 | -6.70 |

| 마법사 -13B | 63.90 | 59.51 | -4.39 |

| RFT-7B | 41.7 | 37.98 | -3.72 |

우리는 ABEL-70B가 GSM8K 및 수학 데이터 세트에서 SOTA를 달성 할뿐만 아니라 Math LLM 제공 업체 Tal (好未來)에 의해 새로 출시 된 데이터 세트 인 Tal-SCQ5K-EN 2K에 대해 잘 일반화한다는 것을 보여줍니다. 우리의 분석에 따르면 SFT 접근 방식은 Abel을 다른 분포의 데이터 세트로 성공적으로 일반화 할 수 있습니다. 우리는 Abel의 일반화 기능을 탐색하고 개선하기 위해 추가 분석 및 실험을 수행 할 것입니다.

| 모델 | tal-scq5k-en 2k 테스트 벤치 마크 |

|---|---|

| ABEL-70B | 59.7 |

| 수학 | 59.0 |

| GPT-4 | 51.0 |

| llama-70b | 43.8 |

우리는 이러한 제한 사항과 잠재적 솔루션을 유지하기위한 문제 목록을 만들었습니다. 귀하의 의견과 의견은 항상 환영합니다.

이 repo의 모델/코드/결론이 도움이된다면 저장소를 인용하십시오.

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

우리는 모델을 지속적으로 정제하고 있으며 업데이트를 발표 할 것입니다. 계속 지켜봐!