Model | Papan peringkat | Metodologi | Evaluasi | Analisis ketahanan | Batasan | Kutipan | Outlook |

Ethan Chern*, Haoyang Zou*, Xuefeng Li*, Jiewen Hu*, Kehua Feng, Junlong Li, Pengfei Liu+

[2023/12/12] Kami merilis ABEL-7B-002 , menghasilkan peningkatan yang lebih kuat (35% pada GSM8K, peningkatan 126% pada matematika) dan model yang lebih umum, mencapai kinerja terbaik di antara semua model 7B (80,44 pada GSM8K, 29,46 tentang matematika)

| Nama model | HF pos pemeriksaan | GSM8K | Matematika | Lisensi |

|---|---|---|---|---|

| Abel-7b-002 | ? 7b | 80.44 | 29.46 | Lisensi Apache 2.0 |

| Abel-7b-001 | ? 7b | 59.74 | 13.00 | Llama 2 |

| Abel-13b-001 | ? 13b | 66.41 | 17.34 | Llama 2 |

| ABEL-70B-001 | ? 70b | 83.62 | 28.26 | Llama 2 |

| Model | GSM8K | Matematika | Mathqa | Svamp | Scq5k-en | Arc-e | Arc-C | Hellaswag | Mmlu |

|---|---|---|---|---|---|---|---|---|---|

| Abel-7b-002 | 80.44 | 29.46 | 69.78 | 77.67 | 55.95 | 77.67 | 55.05 | 77.72 | 61.19 |

| Abel-7b-001 | 59.74 | 13 | 1.21 | 57.67 | 9.3 | 53.32 | 38.97 | 63.51 | 40.59 |

| Metamath-mistral-7b | 77.7 | 28.2 | 33.94 | 79.33 | 37.6 | 78.48 | 51.93 | 76.44 | 61.93 |

| Qwen-7b | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74.97 | 53.05 | 86.85 | 57.98 |

| Mistral-7b | 37.83 | 9.06 | 25.73 | 63 | 39.6 | 76.83 | 53.22 | 76.31 | 64.05 |

| Yi-6b | 32.6 | 5.78 | 26.98 | 55.67 | 35.5 | 73.66 | 49.53 | 68.97 | 64.02 |

| Llama2-7b | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

Dapat ditemukan bahwa:

Detail Evaluasi:

Abel diciptakan sebagai penghormatan kepada Niels Henrik Abel atas pekerjaannya yang inovatif dalam aljabar dan analisis, di mana model kami relatif lebih baik juga. Namun, masih ada jalan panjang bagi kita untuk pergi?

Kami menunjukkan itu:

Kami telah membangun kinerja canggih baru di seluruh LLMS open-source (yang tidak menggunakan alat eksternal) pada tolok ukur GSM8K ( 83.62 ) dan matematika ( 28.26 ). Secara khusus:

GAIRMath-Abel mengamankan 3 posisi di peringkat 10 teratas dan berdiri sebagai satu-satunya proyek yang dipimpin universitas dalam daftar (yang lain adalah startup bintang atau perusahaan teknologi besar).Kami menunjukkan itu:

? mewakili model open-source? menyarankan bahwa pengembangan model dipimpin oleh universitas akademik (bukan perusahaan)| Peringkat | Model | Param. | Organisasi terkemuka | GSM8K | Matematika |

|---|---|---|---|---|---|

| 1 | GPT-4 | tidak dikenal | Openai | 92.0 | 42.5 |

| 2 | Claude-2 | tidak dikenal | Antropik | 88.0 | - |

| 3 | Palm-2-flan | tidak dikenal | 84.7 | 33.2 | |

| ? 4 | Gairmath- Abel | 70b | ? Lab Gair di Universitas Shanghai Jiaotong | 83.6 | 28.3 |

| ? 5 | Wizardmath | 70b | Microsoft | 81.6 | 22.7 |

| 6 | Claude-Instant | tidak dikenal | Antropik | 80.9 | - |

| 7 | Chatgpt | tidak dikenal | Openai | 80.8 | 34.1 |

| ? 4 | Abel -002 | 7b | ? Lab Gair di Universitas Shanghai Jiaotong | 80.4 | 29.5 |

| 8 | Chatgpt-0301 | tidak dikenal | Openai | 74.9 | - |

| ? 9 | Gairmath- Abel | 13b | ? Lab Gair di Universitas Shanghai Jiaotong | 66.4 | 17.3 |

| ? 10 | Gairmath- Abel | 7b | ? Lab Gair di Universitas Shanghai Jiaotong | 59.7 | 13.0 |

| 11 | Minerva | 540b | 58.8 | 33.6 | |

| 12 | Telapak | 540b | 56.9 | 8.8 | |

| ? 13 | Llama-2 | 70b | Meta | 56.8 | 13.5 |

| ? 14 | Rft | 33b | OFA | 56.5 | 7.4 |

| ? 15 | Baichuan2-13b | 13b | Baichuan | 52.8 | 10.1 |

| 16 | Minerva | 62b | 52.4 | 27.6 | |

| 17 | Telapak | 64b | 52.4 | 4.4 | |

| ? 18 | Rft | 13b | OFA | 52.1 | 5.1 |

| ? 19 | Llama | 65b | Meta | 50.9 | 10.6 |

| ? 20 | Qwen | 7b | Alibaba | 44.9 | 8.5 |

| 21 | Chinchilla | 70b | DeepMind | 43.7 | - |

| ? 22 | Llama-2 | 34b | Meta | 42.2 | 6.24 |

| 23 | Galactica | 30b | Meta | 41.7 | 12.7 |

| ? 24 | Chatglm2 | 12b | Zhipu | 40.9 | - |

| 25 | Text-Davi-002 | 175b | Openai | 40.7 | 19.1 |

| ? 26 | Llama | 33b | Meta | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| ? 28 | Internlm | 7b | Shanghai Ai Lab | 31.2 | - |

| ? 29 | Llama-2 | 13b | Meta | 28.7 | 3.9 |

| ? 30 | Vicuna v1.3 | 13b | Lmsys | 27.6 | - |

| ? 31 | Elang | 40b | Lembaga Inovasi Teknologi | 19.6 | 2.5 |

| ? 32 | Llama | 13b | Meta | 17.8 | 3.9 |

| ? 33 | MPT | 30b | Mosaicml | 15.2 | 3.1 |

| 34 | Galactica | 6.7b | Meta | 10.2 | 2.2 |

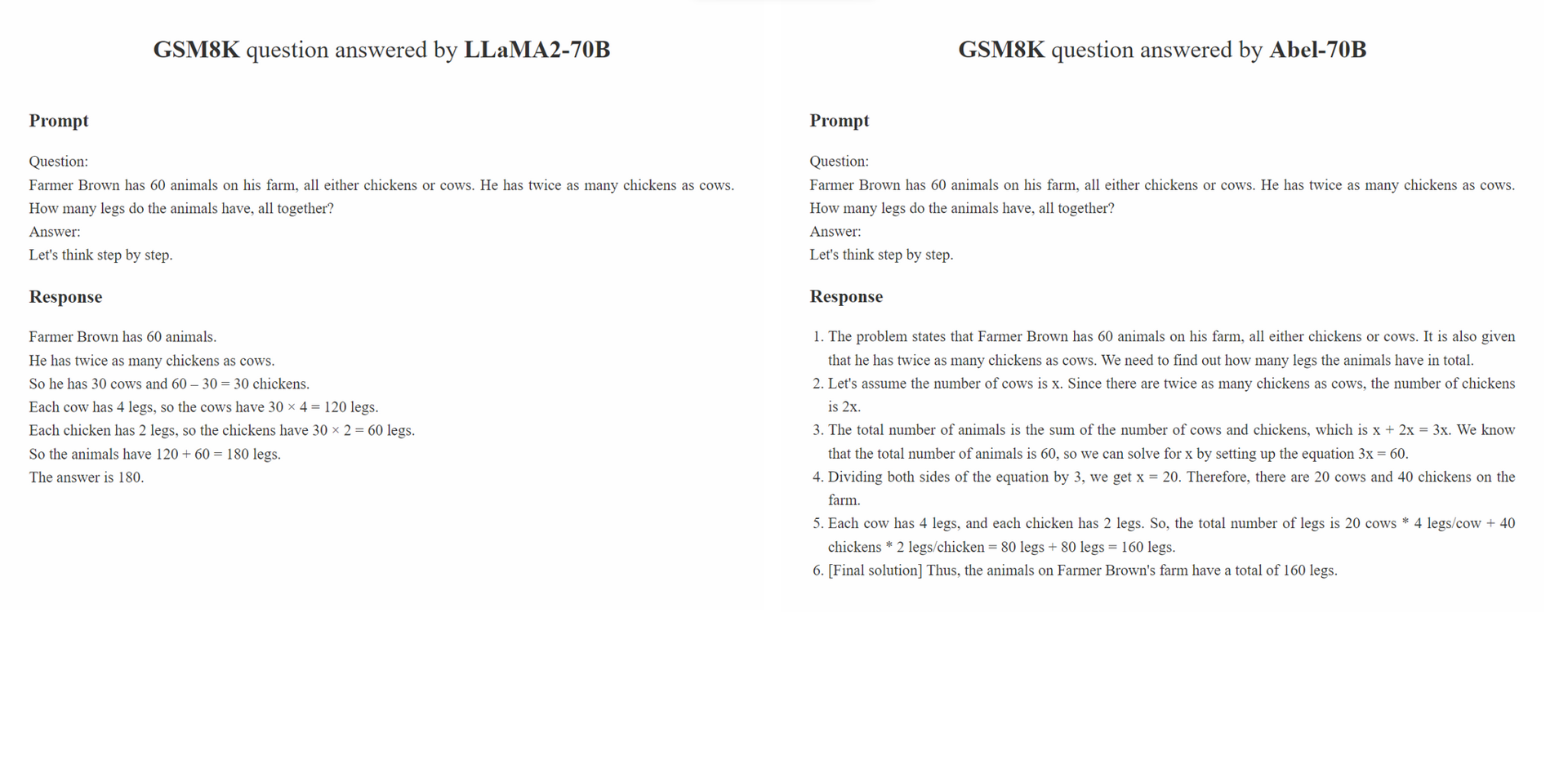

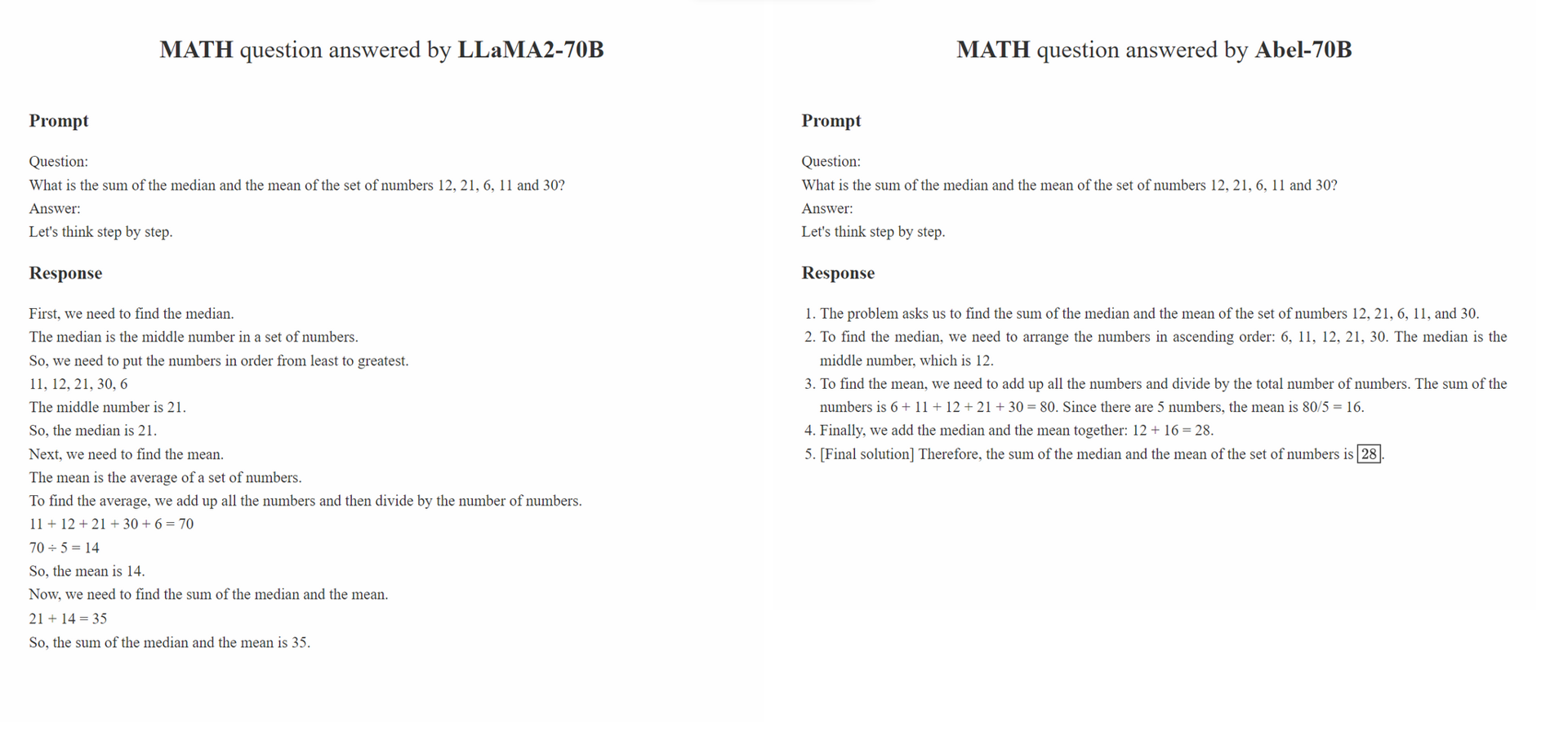

Kami mengusulkan pengawasan orang tua , strategi pengasuhan anak untuk menyempurnakan yang diawasi,

Parental Oversight tidak terbatas pada metode pemrosesan data tertentu. Sebaliknya, ia mendefinisikan filosofi pemrosesan data yang harus memandu fine-tuning yang diawasi di era AI generatif (GAI). Kami percaya bahwa di era GAI, rekayasa struktur data telah muncul sebagai paradigma baru. Dalam paradigma ini, cara di mana data penyempurnaan diproses secara signifikan berdampak pada kinerja GAI yang terlatih. Kami mengharapkan semakin banyak studi di masyarakat untuk fokus pada filosofi pemrosesan data ini.

Prinsip Parental Oversight menekankan memperlakukan penyesuaian yang diawasi dengan hati-hati dan kehati-hatian. Ini analog dengan cara orang tua didorong untuk mendidik anak -anak mereka. Berbagai jenis data, bersama dengan format presentasinya (misalnya, penalaran langkah demi langkah, penyempurnaan berulang), dapat disamakan dengan berbagai metode pendidikan. Sama seperti orang tua dengan hati -hati memilih pendekatan yang paling efektif untuk menginstruksikan anak -anak mereka, praktisi GAI harus dengan hati -hati memilih pendekatan pemrosesan data yang paling efektif untuk menginstruksikan LLM mereka dengan lebih baik.

Selain itu, filosofi "semakin banyak data, semakin baik" tidak selalu benar. Kualitas dan relevansi sampel beranotasi seringkali dapat melebihi kuantitasnya. Sampel pelatihan yang digunakan dalam SFT seharusnya tidak hanya menyajikan jawaban yang tepat, tetapi juga menginstruksikan model tentang bagaimana jawaban yang benar diturunkan berdasarkan pengetahuan LLM. Selain itu, jika pengetahuan LLM tidak cukup untuk menjawab pertanyaan, Parental Oversight harus segera membahas kesenjangan pengetahuan.

conda create -n abel python=3.10conda activate abelpip install -r requirements.txt .bash evaluation/eval.sh . Bagian dari skrip evaluasi dimodifikasi dari Minerva../outputs . Analisis ketahanan kami terdiri dari dua bagian: evaluasi permusuhan pada dataset GSM8K_ROBUST dan belajar transfer yang diawasi pada dataset Tal-SCQ5K-EN . Kami melakukan analisis pendahuluan untuk memahami (1) apakah Abel mengatasi dataset pelatihan dan dengan demikian rapuh untuk sampel pengujian di luar distribusi dan (2) apakah pendekatan SFT kami dapat dengan cepat mentransfer dan menggeneralisasi Abel ke kumpulan data dari distribusi yang berbeda.

Dataset GSM8K_ROBUST adalah dataset yang kami buat berdasarkan dataset GSM8K. Kami secara acak memodifikasi angka-angka dalam pertanyaan dari dataset GSM8K, tanpa mengubah informasi lain dalam pertanyaan, menggunakan GPT-4. Kami juga meminta GPT-4 untuk menghasilkan 'jawaban emas' untuk pertanyaan yang dimodifikasi. Setelah secara manual meninjau sebagian dari sampel ini, kami menemukan bahwa semua jawaban yang dihasilkan untuk pertanyaan yang diubah akurat. Kami menggunakan dataset GSM8K_ROBUST untuk mengevaluasi apakah model-model tersebut menguasai data pelatihan, membuat model rentan terhadap sampel pengujian di luar distribusi. Analisis kami menunjukkan bahwa Habel lebih kuat untuk sampel pengujian di luar distribusi dibandingkan dengan model lain.

| Model | GSM8K | Gsm8k_robust | delta |

|---|---|---|---|

| Abel-7b | 59.74 | 58.23 | -1.51 |

| Abel-13b | 66.41 | 66.57 | +0.16 |

| Abel-70b | 83.62 | 81.80 | -1.82 |

| Wizardmath-70b | 81.60 | 74.91 | -6.70 |

| Wizardmath-13b | 63.90 | 59.51 | -4.39 |

| RFT-7B | 41.7 | 37.98 | -3.72 |

Kami menunjukkan bahwa ABEL-70B tidak hanya mencapai SOTA pada dataset GSM8K dan matematika tetapi juga menggeneralisasi dengan baik untuk Tal-SCQ5K-EN 2K, dataset yang baru dirilis oleh penyedia LLM Math Tal (好未來). Analisis kami menunjukkan bahwa pendekatan SFT kami dapat berhasil menggeneralisasi Abel ke set data dari distribusi yang berbeda. Kami akan melakukan analisis dan percobaan lebih lanjut untuk mengeksplorasi dan meningkatkan kemampuan generalisasi Abel.

| Model | Talchmark tes 2K tal-scq5k-en |

|---|---|

| Abel-70b | 59.7 |

| Mathgpt | 59.0 |

| GPT-4 | 51.0 |

| Llama-70b | 43.8 |

Kami telah membuat daftar masalah untuk mempertahankan keterbatasan dan solusi potensial ini. Pendapat dan komentar Anda selalu diterima.

Harap kutip repo jika model/kode/kesimpulan dalam repo ini bermanfaat bagi Anda.

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

Kami terus menyempurnakan model kami dan akan merilis pembaruan. Pantau terus!