モデル|リーダーボード|方法論|評価|堅牢性分析|制限|引用| Outlook |

Ethan Chern*、Haoyang Zou*、Xuefeng Li*、Jiewen Hu*、Kehua Feng、Junlong Li、Pengfei Liu+

[2023/12/12] ABEL-7B-002をリリースし、その結果、より強力な(GSM8Kの35%改善、数学の126%の改善)、より一般化されたモデルをもたらし、すべての7Bモデルで最高のパフォーマンスを達成しました(GSM8Kで80.44、MATで29.46)

| モデル名 | HFチェックポイント | GSM8K | 数学 | ライセンス |

|---|---|---|---|---|

| Abel-7B-002 | ? 7b | 80.44 | 29.46 | Apacheライセンス2.0 |

| Abel-7B-001 | ? 7b | 59.74 | 13.00 | ラマ2 |

| ABEL-13B-001 | ? 13b | 66.41 | 17.34 | ラマ2 |

| Abel-70b-001 | ? 70b | 83.62 | 28.26 | ラマ2 |

| モデル | GSM8K | 数学 | Mathqa | svamp | scq5k-en | arc-e | ARC-C | Hellaswag | mmlu |

|---|---|---|---|---|---|---|---|---|---|

| Abel-7B-002 | 80.44 | 29.46 | 69.78 | 77.67 | 55.95 | 77.67 | 55.05 | 77.72 | 61.19 |

| Abel-7B-001 | 59.74 | 13 | 1.21 | 57.67 | 9.3 | 53.32 | 38.97 | 63.51 | 40.59 |

| メタマスミストラル-7b | 77.7 | 28.2 | 33.94 | 79.33 | 37.6 | 78.48 | 51.93 | 76.44 | 61.93 |

| Qwen-7b | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74.97 | 53.05 | 86.85 | 57.98 |

| ミストラル-7B | 37.83 | 9.06 | 25.73 | 63 | 39.6 | 76.83 | 53.22 | 76.31 | 64.05 |

| YI-6B | 32.6 | 5.78 | 26.98 | 55.67 | 35.5 | 73.66 | 49.53 | 68.97 | 64.02 |

| llama2-7b | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

それは次のことを見つけることができます

評価の詳細:

Abel 、代数と分析での画期的な仕事のためにニールス・ヘンリック・アベルへのオマージュとして作成されており、私たちのモデルも比較的優れています。しかし、私たちが行くのに長い道のりがありますか?

私たちはそれを示します:

GSM8K( 83.62 )および数学( 28.26 )のベンチマークに、オープンソースLLM(外部ツールを使用しない)で新しい最先端のパフォーマンスを確立しました。具体的には:

GAIRMath-Abelトップ10のランキングで3つのポジションを確保し、リスト内で唯一の大学主導のプロジェクトとして立っています(その他はスタースタートアップまたは大手ハイテク企業のいずれかです)。私たちはそれを示します:

?オープンソースモデルを表します?モデル開発は(企業の代わりに)アカデミック大学が主導することを示唆しています| ランキング | モデル | パラメーション。 | 主要な組織 | GSM8K | 数学 |

|---|---|---|---|---|---|

| 1 | GPT-4 | 未知 | Openai | 92.0 | 42.5 |

| 2 | クロード-2 | 未知 | 人類 | 88.0 | - |

| 3 | パルム-2-フラン | 未知 | グーグル | 84.7 | 33.2 |

| ? 4 | Gairmath- Abel | 70b | ?上海ジョートン大学のゲアラボ | 83.6 | 28.3 |

| ? 5 | ウィザードマス | 70b | マイクロソフト | 81.6 | 22.7 |

| 6 | claude-instant | 未知 | 人類 | 80.9 | - |

| 7 | chatgpt | 未知 | Openai | 80.8 | 34.1 |

| ? 4 | アベル-002 | 7b | ?上海ジョートン大学のゲアラボ | 80.4 | 29.5 |

| 8 | chatgpt-0301 | 未知 | Openai | 74.9 | - |

| ? 9 | Gairmath- Abel | 13b | ?上海ジョートン大学のゲアラボ | 66.4 | 17.3 |

| ? 10 | Gairmath- Abel | 7b | ?上海ジョートン大学のゲアラボ | 59.7 | 13.0 |

| 11 | ミネルバ | 540b | グーグル | 58.8 | 33.6 |

| 12 | 手のひら | 540b | グーグル | 56.9 | 8.8 |

| ? 13 | llama-2 | 70b | メタ | 56.8 | 13.5 |

| ? 14 | rft | 33b | ofa | 56.5 | 7.4 |

| ? 15 | Baichuan2-13b | 13b | バイチュアン | 52.8 | 10.1 |

| 16 | ミネルバ | 62b | グーグル | 52.4 | 27.6 |

| 17 | 手のひら | 64b | グーグル | 52.4 | 4.4 |

| ? 18 | rft | 13b | ofa | 52.1 | 5.1 |

| ? 19 | ラマ | 65b | メタ | 50.9 | 10.6 |

| ? 20 | Qwen | 7b | アリババ | 44.9 | 8.5 |

| 21 | チンチラ | 70b | deepmind | 43.7 | - |

| ? 22 | llama-2 | 34b | メタ | 42.2 | 6.24 |

| 23 | ギャラクティカ | 30b | メタ | 41.7 | 12.7 |

| ? 24 | chatglm2 | 12b | Zhipu | 40.9 | - |

| 25 | Text-Davinci-002 | 175b | Openai | 40.7 | 19.1 |

| ? 26 | ラマ | 33b | メタ | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| ? 28 | internlm | 7b | 上海AIラボ | 31.2 | - |

| ? 29 | llama-2 | 13b | メタ | 28.7 | 3.9 |

| ? 30 | Vicuna v1.3 | 13b | lmsys | 27.6 | - |

| ? 31 | ファルコン | 40b | Technology Innovation Institute | 19.6 | 2.5 |

| ? 32 | ラマ | 13b | メタ | 17.8 | 3.9 |

| ? 33 | MPT | 30b | MOSAICML | 15.2 | 3.1 |

| 34 | ギャラクティカ | 6.7b | メタ | 10.2 | 2.2 |

私たちは、親の監視、監視された微調整のためのベビーシッター戦略を提案します。

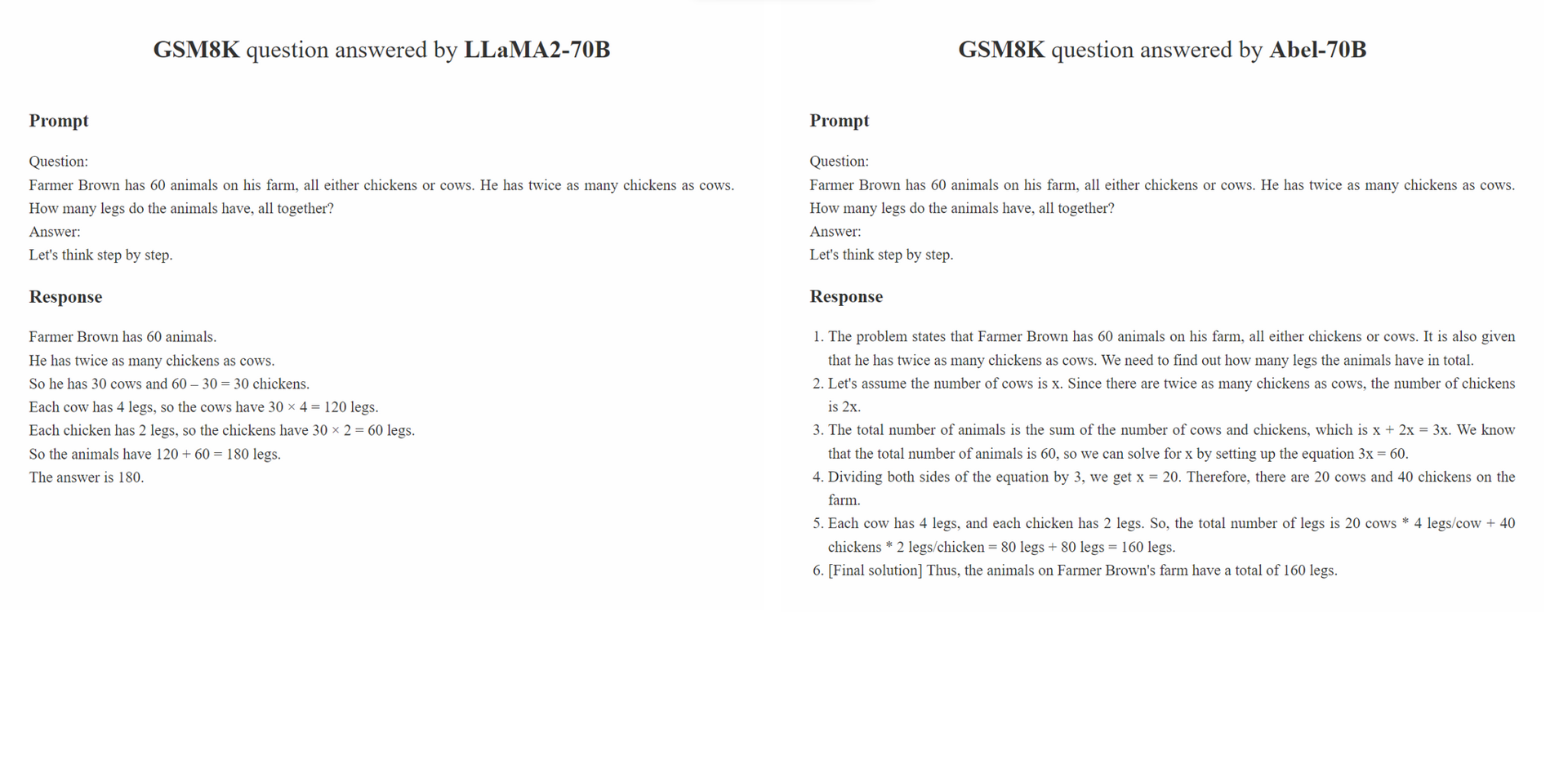

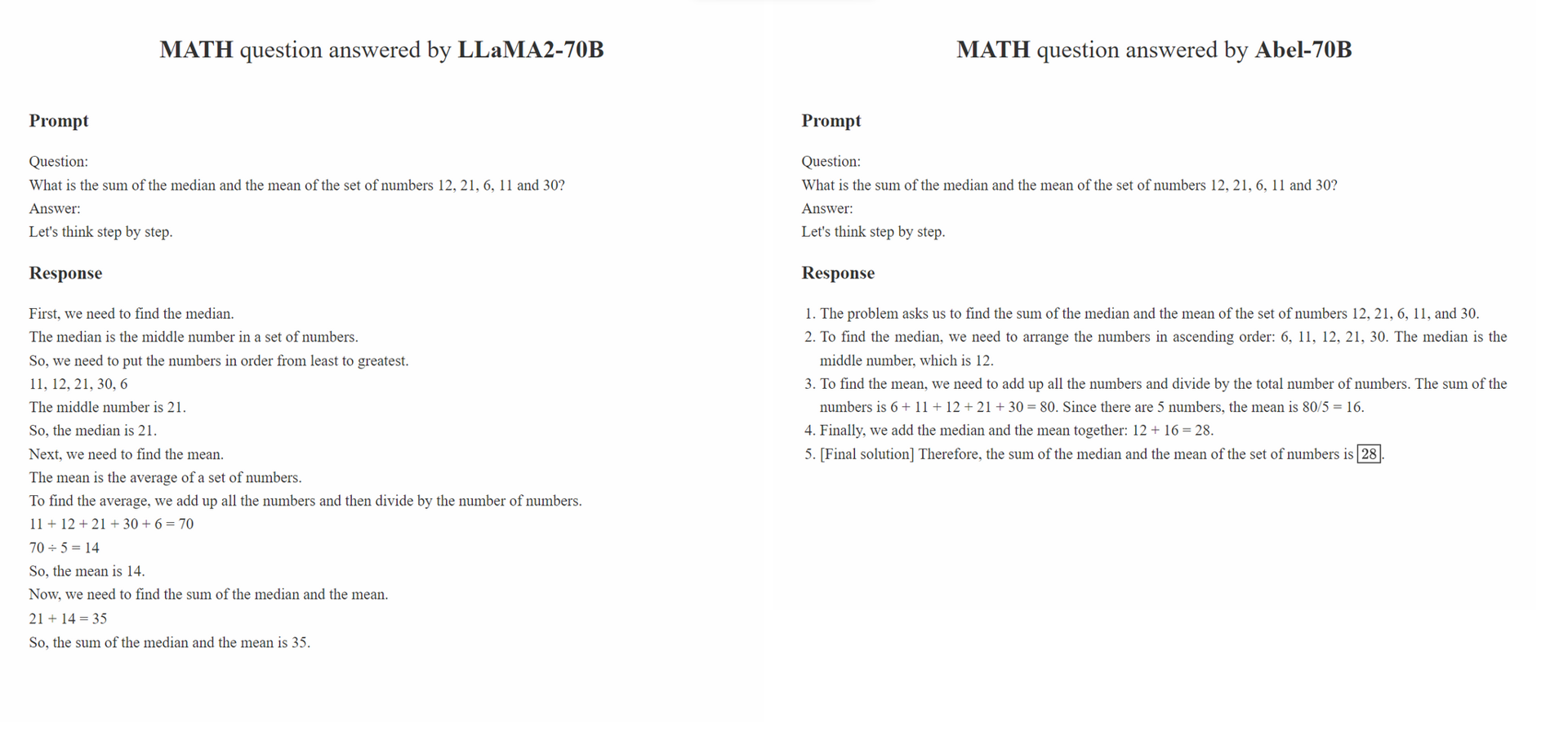

Parental Oversight 、特定のデータ処理方法に限定されません。代わりに、生成AI(GAI)の時代に監督された微調整を導くべきデータ処理哲学を定義します。 GAIの時代には、データ構造エンジニアリングが新しいパラダイムとして浮上したと考えています。このパラダイム内で、微調整データが処理される方法は、訓練されたGAIのパフォーマンスに大きく影響します。コミュニティでの研究がますますこのデータ処理哲学に焦点を当てることを期待しています。

Parental Oversightの原則は、監督された微調整を注意と慎重に扱うことを強調しています。これは、親が子供を教育することを奨励される方法に類似しています。さまざまな種類のデータと、プレゼンテーション形式(段階的な推論、反復改良など)とともに、さまざまな教育方法に例えることができます。親が子供を指導するための最も効果的なアプローチを慎重に選択するように、GAIの実践者は、LLMSをよりよく指導するために最も効果的なデータ処理アプローチを慎重に選択する必要があります。

さらに、「データが多いほど、より良い」哲学は必ずしも当てはまるとは限りません。注釈付きサンプルの品質と関連性は、多くの場合、その量を上回ることができます。 SFTで使用されるトレーニングサンプルは、正しい答えを提示するだけでなく、LLMの知識に基づいて正解がどのように導き出されたかについてモデルに指示する必要があります。さらに、LLMの知識が質問に答えるのに十分でない場合、 Parental Oversight即座に知識のギャップに対処するために介入する必要があります。

conda create -n abel python=3.10conda activate abelpip install -r requirements.txtを実行します。txt。bash evaluation/eval.shを実行します。評価スクリプトの一部は、Minervaから変更されています。./outputsディレクトリの評価出力を確認することもできます。 当社の堅牢性分析は、 GSM8K_ROBUSTデータセットの敵対的評価とTAL-SCQ5K-ENデータセットの監視された転送学習の2つの部分で構成されています。 (1)Abelがトレーニングデータセットを覆い、したがって分散除外テストサンプルに脆弱か、(2)SFTアプローチが異なる分布からAbelをデータセットに迅速に転送および一般化できるかどうかを理解するための予備分析を実行します。

GSM8K_ROBUSTデータセットは、GSM8Kデータセットに基づいて確立したデータセットです。 GPT-4を使用して、質問の他の情報を変更することなく、GSM8Kデータセットの質問内の数値をランダムに変更しました。また、GPT-4に、修正された質問の「黄金の答え」を生成するように依頼しました。これらのサンプルのサブセットを手動でレビューした後、変更された質問に対する生成されたすべての回答が正確であることがわかりました。 GSM8K_ROBUSTデータセットを使用して、モデルがトレーニングデータに過剰にフィットするかどうかを評価し、モデルを分散していないテストサンプルの影響を受けやすくしました。私たちの分析は、Abelが他のモデルと比較して分散型テストサンプルに対してより堅牢であることを示しています。

| モデル | GSM8K | GSM8K_OBUST | デルタ |

|---|---|---|---|

| アベル-7b | 59.74 | 58.23 | -1.51 |

| ABEL-13B | 66.41 | 66.57 | +0.16 |

| Abel-70b | 83.62 | 81.80 | -1.82 |

| wizardmath-70b | 81.60 | 74.91 | -6.70 |

| wizardmath-13b | 63.90 | 59.51 | -4.39 |

| RFT-7B | 41.7 | 37.98 | -3.72 |

Abel-70Bは、GSM8Kおよび数学データセットでSOTAを達成するだけでなく、Math LLM Provider Tal(好未來)によって新しくリリースされたデータセットであるTal-Scq5k-en 2kにもよく一般化することを実証します。分析は、SFTアプローチがさまざまな分布のデータセットにAbelを正常に一般化できることを示しています。 Abelの一般化能力を調査および改善するために、さらに分析と実験を実施します。

| モデル | TAL-SCQ5K-EN 2Kテストベンチマーク |

|---|---|

| Abel-70b | 59.7 |

| Mathgpt | 59.0 |

| GPT-4 | 51.0 |

| llama-70b | 43.8 |

これらの制限と潜在的なソリューションを維持するための問題のリストを作成しました。あなたの意見やコメントはいつでも大歓迎です。

このレポのモデル/コード/結論が役立つ場合は、リポジトリを引用してください。

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

モデルを継続的に改良しており、更新をリリースします。乞うご期待!