Модель | Таблица лидеров | Методология | Оценка | Анализ надежности | Ограничение | Цитата | Outlook |

Итан Черн*, Хаоян Зу*, Сюфенг Ли*, Джевен Ху*, Кехуа Фэн, Джунлонг Ли, Пенгфей Лю+

[2023/12/12] Мы выпустили ABEL-7B-002 , что приводит к более сильному (35% улучшению GSM8K, 126% улучшения по математике) и более обобщенной модели, достигнув наилучшей производительности среди всех моделей 7B (80,44 на GSM8K, 29,46 по математике).

| Название модели | Контрольные точки HF | GSM8K | Математика | Лицензия |

|---|---|---|---|---|

| Абель-7B-002 | ? 7b | 80.44 | 29,46 | Apache License 2.0 |

| Абель-7B-001 | ? 7b | 59,74 | 13.00 | Лама 2 |

| Абель-13B-001 | ? 13b | 66.41 | 17.34 | Лама 2 |

| Абель-70B-001 | ? 70b | 83,62 | 28.26 | Лама 2 |

| Модель | GSM8K | Математика | Матка | Свамп | SCQ5K-EN | Арк-э | Дуговой | Hellaswag | MMLU |

|---|---|---|---|---|---|---|---|---|---|

| Абель-7B-002 | 80.44 | 29,46 | 69,78 | 77.67 | 55,95 | 77.67 | 55,05 | 77.72 | 61.19 |

| Абель-7B-001 | 59,74 | 13 | 1.21 | 57.67 | 9.3 | 53,32 | 38.97 | 63,51 | 40.59 |

| Metamath-Mistral-7b | 77.7 | 28.2 | 33,94 | 79,33 | 37.6 | 78.48 | 51.93 | 76.44 | 61.93 |

| Qwen-7b | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74,97 | 53,05 | 86.85 | 57.98 |

| Миштраль-7B | 37.83 | 9.06 | 25,73 | 63 | 39,6 | 76.83 | 53,22 | 76.31 | 64,05 |

| Yi-6b | 32,6 | 5.78 | 26.98 | 55,67 | 35,5 | 73,66 | 49,53 | 68,97 | 64.02 |

| Llama2-7B | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

Можно найти, что:

Детали оценки:

Abel создается как дань уважения Нильсу Хенрику Абелю за его новаторскую работу по алгебре и анализу, при которой наша модель также относительно лучше. У нас все еще долгий путь, хотя?

Мы показываем, что:

Мы создали новую современную производительность в LLMS с открытым исходным кодом (которые не используют внешние инструменты) на тестах GSM8K ( 83.62 ) и математике ( 28,26 ). Конкретно:

GAIRMath-Abel занимает 3 позиции в топ-10 рейтингах и является единственным университетским проектом в списке (другие-либо звездные стартапы, либо крупные технологические компании).Мы демонстрируем, что:

? представляет модель с открытым исходным кодом? предполагает, что развитие модели возглавляет академический университет (вместо компаний)| Рейтинг | Модель | Парамет | Ведущая организация | GSM8K | Математика |

|---|---|---|---|---|---|

| 1 | GPT-4 | неизвестный | Openai | 92.0 | 42,5 |

| 2 | Клод-2 | неизвестный | Антроп | 88.0 | - |

| 3 | Палм-2-Флан | неизвестный | 84,7 | 33,2 | |

| ? 4 | Гайрмат- Абель | 70b | ? Лаборатория Gair в Университете Шанхай Цзяотонг | 83,6 | 28.3 |

| ? 5 | Wizardmath | 70b | Microsoft | 81.6 | 22.7 |

| 6 | Клод-Инстанция | неизвестный | Антроп | 80.9 | - |

| 7 | Чатгпт | неизвестный | Openai | 80.8 | 34.1 |

| ? 4 | Абель -002 | 7b | ? Лаборатория Gair в Университете Шанхай Цзяотонг | 80.4 | 29,5 |

| 8 | CHATGPT-0301 | неизвестный | Openai | 74,9 | - |

| ? 9 | Гайрмат- Абель | 13b | ? Лаборатория Gair в Университете Шанхай Цзяотонг | 66.4 | 17.3 |

| ? 10 | Гайрмат- Абель | 7b | ? Лаборатория Gair в Университете Шанхай Цзяотонг | 59,7 | 13.0 |

| 11 | Минерва | 540b | 58.8 | 33,6 | |

| 12 | Ладонь | 540b | 56.9 | 8.8 | |

| ? 13 | Лама-2 | 70b | Мета | 56.8 | 13.5 |

| ? 14 | Резок | 33b | Оф | 56.5 | 7.4 |

| ? 15 | Baichuan2-13b | 13b | Бачуань | 52,8 | 10.1 |

| 16 | Минерва | 62b | 52,4 | 27.6 | |

| 17 | Ладонь | 64b | 52,4 | 4.4 | |

| ? 18 | Резок | 13b | Оф | 52,1 | 5.1 |

| ? 19 | Лама | 65b | Мета | 50,9 | 10.6 |

| ? 20 | Qwen | 7b | Алибаба | 44,9 | 8.5 |

| 21 | Чиншилла | 70b | Глубокий | 43,7 | - |

| ? 22 | Лама-2 | 34b | Мета | 42.2 | 6.24 |

| 23 | Галактика | 30b | Мета | 41.7 | 12.7 |

| ? 24 | Чатглм2 | 12B | Зипу | 40,9 | - |

| 25 | Текст-давинка-002 | 175b | Openai | 40,7 | 19.1 |

| ? 26 | Лама | 33b | Мета | 35,6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| ? 28 | Internlm | 7b | Шанхайская лаборатория | 31.2 | - |

| ? 29 | Лама-2 | 13b | Мета | 28,7 | 3.9 |

| ? 30 | Vicuna v1.3 | 13b | Lmsys | 27.6 | - |

| ? 31 | Сокол | 40b | Институт технологий инноваций | 19.6 | 2.5 |

| ? 32 | Лама | 13b | Мета | 17.8 | 3.9 |

| ? 33 | Мпт | 30b | Mosaicml | 15.2 | 3.1 |

| 34 | Галактика | 6,7B | Мета | 10.2 | 2.2 |

Мы предлагаем родительский надзор , стратегию присмотра за присмотром под контролем точной настройки,

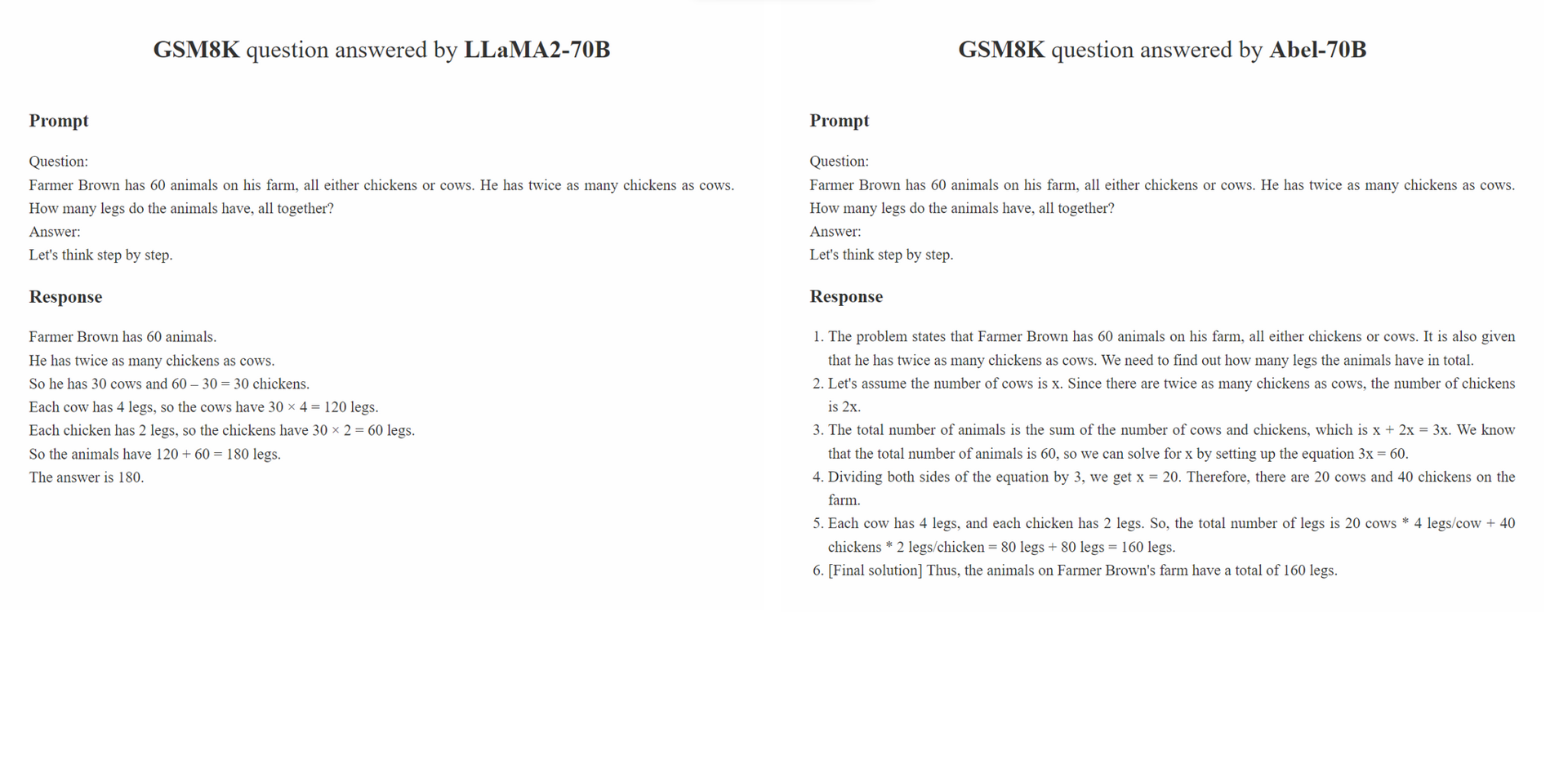

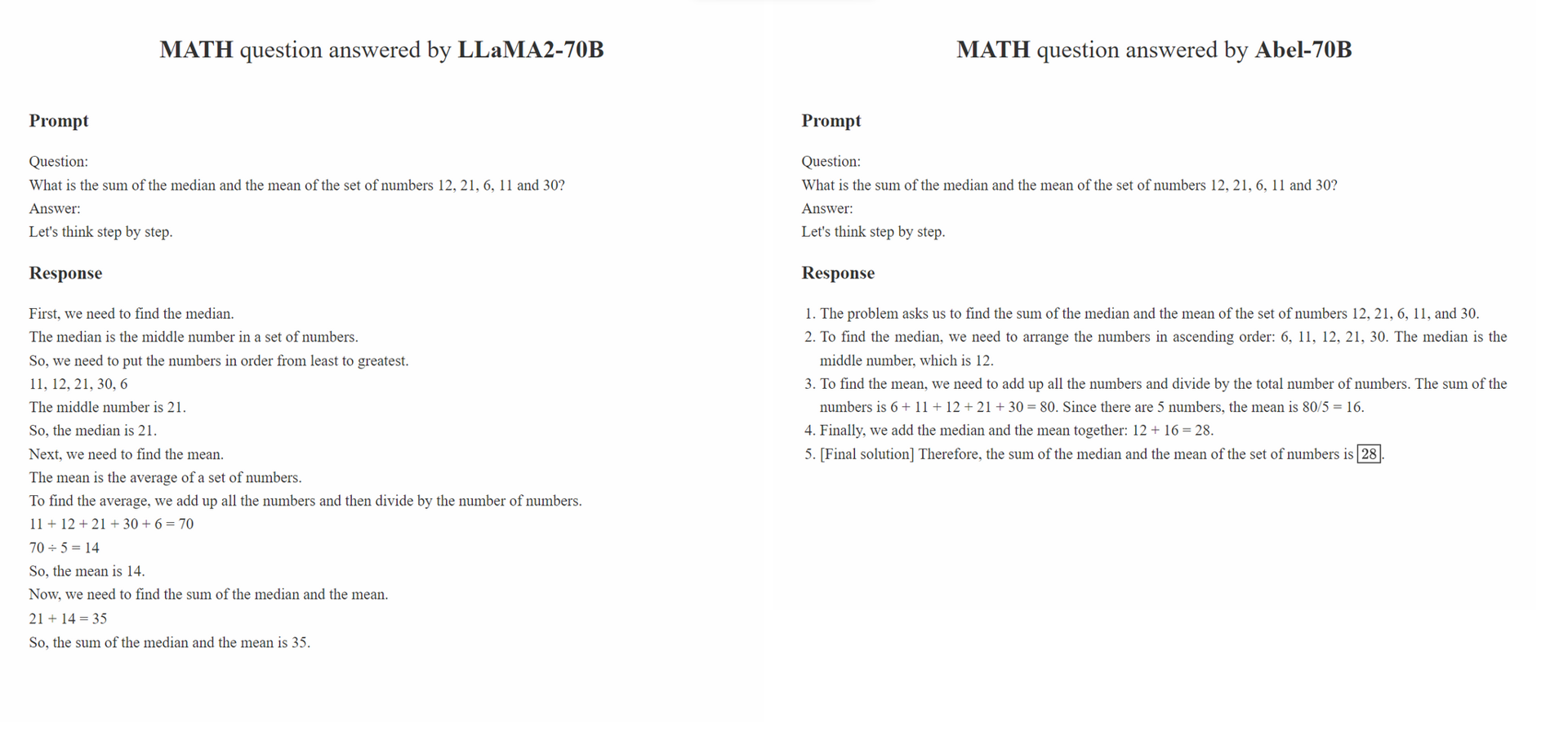

Parental Oversight не ограничивается каким -либо конкретным методом обработки данных. Вместо этого он определяет философию обработки данных, которая должна направлять контролируемую тонкую настройку в эпоху генеративного ИИ (GAI). Мы считаем, что в эпоху GAI инженерия структуры данных стала новой парадигмой. В рамках этой парадигмы способ обработки точной настройки значительно влияет на производительность обученного GAI. Мы ожидаем, что растущее число исследований в сообществе сосредоточится на этой философии обработки данных.

Принцип Parental Oversight подчеркивает лечение контролируемой точной настройки с осторожностью и осторожностью. Это аналогично тому, как родителям рекомендуется обучать своих детей. Различные типы данных, наряду с их форматами презентаций (например, пошаговые рассуждения, итеративная уточнение) могут быть сравнены с различными методами образования. Подобно тому, как родители осторожно выбирают наиболее эффективный подход к обучению своим детям, практикующие Gai должны осторожно выбрать наиболее эффективные подходы к обработке данных, чтобы лучше инструктировать свои LLMS.

Кроме того, чем больше данных, тем лучше »философия не всегда верна. Качество и актуальность аннотированных образцов часто могут перевесить их количество. Обучающие образцы, используемые в SFT, должны не просто представлять правильный ответ, но и инструктировать модель о том, как был получен правильный ответ на основе знаний LLM. Кроме того, если знания LLM недостаточно для ответа на вопрос, Parental Oversight должен вмешаться, чтобы быстро рассмотреть разрывы в знаниях.

conda create -n abel python=3.10conda activate abelpip install -r requirements.txt .bash evaluation/eval.sh . Часть сценария оценки модифицирована из Minerva../outputs . Наш анализ надежности состоит из двух частей: состязательной оценки набора данных GSM8K_ROBUST и контролируемого обучения передачи на набор данных TAL-SCQ5K-EN . Мы выполняем предварительный анализ, чтобы понять (1), преодолевает ли Абель учебный набор данных и, таким образом, хрупкий в выборочных образцах тестирования и (2) может ли наш подход SFT быстро передавать и обобщать ABEL на наборы данных из разных распределений.

Набор данных GSM8K_ROBUST - это набор данных, который мы установили на основе набора данных GSM8K. Мы случайным образом изменили числа в вопросах набора данных GSM8K, не изменяя какую-либо другую информацию в вопросах, используя GPT-4. Мы также попросили GPT-4 сгенерировать «золотые ответы» по измененным вопросам. После вручного просмотра подмножества этих образцов мы обнаружили, что все сгенерированные ответы для измененных вопросов были точными. Мы использовали набор данных GSM8K_ROBUST, чтобы оценить, переполняют ли модели данные обучения, что делает модели восприимчивыми к выборочным испытаниям. Наш анализ показывает, что Abel более устойчив к выстраивающимся образцам тестирования по сравнению с другими моделями.

| Модель | GSM8K | GSM8K_ROBUST | дельта |

|---|---|---|---|

| Абель-7B | 59,74 | 58.23 | -1,51 |

| Абель-13b | 66.41 | 66.57 | +0.16 |

| Абель-70b | 83,62 | 81.80 | -1,82 |

| Wizardmath-70b | 81.60 | 74,91 | -6.70 |

| Wizardmath-13b | 63,90 | 59,51 | -4.39 |

| RFT-7B | 41.7 | 37.98 | -3,72 |

Мы демонстрируем, что ABEL-70B не только достигает SOTA на наборах данных GSM8K и Math, но и хорошо обобщает TAL-SCQ5K-EN 2K, недавно выпущенный набор данных по провайдеру Math LLM TAL (好未來). Наш анализ показывает, что наш подход SFT может успешно обобщать ABEL для наборов данных из разных распределений. Мы проведем дальнейшие анализы и эксперименты для изучения и улучшения возможностей обобщения Абеля.

| Модель | Tal-SCQ5K-EN 2K. |

|---|---|

| Абель-70b | 59,7 |

| Mathgpt | 59,0 |

| GPT-4 | 51.0 |

| Llama-70b | 43,8 |

Мы создали список проблем для поддержания этих ограничений и потенциальных решений. Ваше мнение и комментарии всегда приветствуются.

Пожалуйста, цитируйте репо, если вам полезна модель/код/заключение в этом репо.

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

Мы постоянно совершенствуем наши модели и будем выпускать обновления. Следите за обновлениями!