รุ่น | ลีดเดอร์บอร์ด วิธีการ การประเมินผล การวิเคราะห์ความทนทาน ข้อ จำกัด | การอ้างอิง Outlook

Ethan Chern*, Haoyang Zou*, Xuefeng Li*, Jiewen Hu*, Kehua Feng, Junlong Li, Pengfei Liu+

[2023/12/12] เราเปิด ตัว ABEL-7B-002 ส่งผลให้มีการปรับปรุงที่แข็งแกร่งขึ้น (35% สำหรับ GSM8K, การปรับปรุง 126% ในวิชาคณิตศาสตร์) และโมเดลทั่วไปมากขึ้นบรรลุประสิทธิภาพที่ดีที่สุดในทุกรุ่น 7B (80.44 ใน GSM8K, 29.46 ในวิชาคณิตศาสตร์)

| ชื่อนางแบบ | จุดตรวจ HF | GSM8K | คณิตศาสตร์ | ใบอนุญาต |

|---|---|---|---|---|

| Abel-7b-002 | - 7b | 80.44 | 29.46 | ใบอนุญาต Apache 2.0 |

| Abel-7b-001 | - 7b | 59.74 | 13.00 น | ลามะ 2 |

| Abel-13b-001 | - 13B | 66.41 | 17.34 | ลามะ 2 |

| ABEL-70B-001 | - 70b | 83.62 | 28.26 | ลามะ 2 |

| แบบอย่าง | GSM8K | คณิตศาสตร์ | Mathqa | SVAMP | scq5k-en | ส่วนโค้ง | ARC-C | Hellaswag | mmlu |

|---|---|---|---|---|---|---|---|---|---|

| Abel-7b-002 | 80.44 | 29.46 | 69.78 | 77.67 | 55.95 | 77.67 | 55.05 | 77.72 | 61.19 |

| Abel-7b-001 | 59.74 | 13 | 1.21 | 57.67 | 9.3 | 53.32 | 38.97 | 63.51 | 40.59 |

| Metamath-Mistral-7b | 77.7 | 28.2 | 33.94 | 79.33 | 37.6 | 78.48 | 51.93 | 76.44 | 61.93 |

| Qwen-7b | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74.97 | 53.05 | 86.85 | 57.98 |

| Mistral-7b | 37.83 | 9.06 | 25.73 | 63 | 39.6 | 76.83 | 53.22 | 76.31 | 64.05 |

| Yi-6b | 32.6 | 5.78 | 26.98 | 55.67 | 35.5 | 73.66 | 49.53 | 68.97 | 64.02 |

| LLAMA2-7B | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

พบว่า:

รายละเอียดการประเมิน:

Abel ถูกสร้างขึ้นเพื่อเป็นเครื่องบรรณาการให้กับ Niels Henrik Abel สำหรับงานที่ก้าวล้ำของเขาในพีชคณิตและการวิเคราะห์ซึ่งแบบจำลองของเราค่อนข้างดีขึ้นเช่นกัน ยังมีทางยาวที่เราจะไปได้หรือไม่ ♂? ♀ ?? ♂? ♀

เราแสดงให้เห็นว่า:

เราได้สร้างประสิทธิภาพ ที่ล้ำสมัยใหม่ ใน LLMS โอเพนซอร์ซ (ซึ่งไม่ได้ใช้เครื่องมือภายนอก) บน GSM8K ( 83.62 ) และเกณฑ์มาตรฐานคณิตศาสตร์ ( 28.26 ) โดยเฉพาะ:

GAIRMath-Abel ได้รับ ตำแหน่ง 3 ตำแหน่งใน 10 อันดับแรก และเป็น โครงการที่นำโดยมหาวิทยาลัยเพียงแห่งเดียว ในรายการ (อื่น ๆ เป็น Star Startups หรือ บริษัท เทคโนโลยีขนาดใหญ่)เราแสดงให้เห็นว่า:

? แสดงถึงโมเดลโอเพนซอร์ซ? แสดงให้เห็นว่าการพัฒนาแบบจำลองนำโดยมหาวิทยาลัยวิชาการ (แทนที่จะเป็น บริษัท )| การจัดอันดับ | แบบอย่าง | พารามิเตอร์ | องค์กรชั้นนำ | GSM8K | คณิตศาสตร์ |

|---|---|---|---|---|---|

| 1 | GPT-4 | ไม่รู้จัก | Openai | 92.0 | 42.5 |

| 2 | Claude-2 | ไม่รู้จัก | มานุษยวิทยา | 88.0 | - |

| 3 | ปาล์ม -2-flan | ไม่รู้จัก | 84.7 | 33.2 | |

| - 4 | Gairmath- Abel | 70b | - Gair Lab ที่มหาวิทยาลัยเซี่ยงไฮ้ Jiaotong | 83.6 | 28.3 |

| - 5 | พ่อมด | 70b | Microsoft | 81.6 | 22.7 |

| 6 | Claude-instant | ไม่รู้จัก | มานุษยวิทยา | 80.9 | - |

| 7 | CHATGPT | ไม่รู้จัก | Openai | 80.8 | 34.1 |

| - 4 | อาเบล -002 | 7b | - Gair Lab ที่มหาวิทยาลัยเซี่ยงไฮ้ Jiaotong | 80.4 | 29.5 |

| 8 | chatgpt-0301 | ไม่รู้จัก | Openai | 74.9 | - |

| - 9 | Gairmath- Abel | 13B | - Gair Lab ที่มหาวิทยาลัยเซี่ยงไฮ้ Jiaotong | 66.4 | 17.3 |

| - 10 | Gairmath- Abel | 7b | - Gair Lab ที่มหาวิทยาลัยเซี่ยงไฮ้ Jiaotong | 59.7 | 13.0 |

| 11 | Minerva | 540B | 58.8 | 33.6 | |

| 12 | ปาล์ม | 540B | 56.9 | 8.8 | |

| - 13 | Llama-2 | 70b | เมตา | 56.8 | 13.5 |

| - 14 | rft | 33B | OFA | 56.5 | 7.4 |

| - 15 | Baichuan2-13b | 13B | ชาวไชน่า | 52.8 | 10.1 |

| 16 | Minerva | 62b | 52.4 | 27.6 | |

| 17 | ปาล์ม | 64B | 52.4 | 4.4 | |

| - 18 | rft | 13B | OFA | 52.1 | 5.1 |

| - 19 | ลาม่า | 65B | เมตา | 50.9 | 10.6 |

| - 20 | Qwen | 7b | อาลีบาบา | 44.9 | 8.5 |

| 21 | ชินชิลล่า | 70b | ใจลึก | 43.7 | - |

| - 22 | Llama-2 | 34B | เมตา | 42.2 | 6.24 |

| 23 | กาแล็กซี่ | 30B | เมตา | 41.7 | 12.7 |

| - 24 | chatglm2 | 12b | zhipu | 40.9 | - |

| 25 | Text-Davinci-002 | 175b | Openai | 40.7 | 19.1 |

| - 26 | ลาม่า | 33B | เมตา | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| - 28 | ผู้ฝึกงาน | 7b | ห้องแล็บเซี่ยงไฮ้ | 31.2 | - |

| - 29 | Llama-2 | 13B | เมตา | 28.7 | 3.9 |

| - 30 | Vicuna v1.3 | 13B | LMSYS | 27.6 | - |

| - 31 | เหยี่ยว | 40b | สถาบันนวัตกรรมเทคโนโลยี | 19.6 | 2.5 |

| - 32 | ลาม่า | 13B | เมตา | 17.8 | 3.9 |

| - 33 | MPT | 30B | กระเบื้องโมเสค | 15.2 | 3.1 |

| 34 | กาแล็กซี่ | 6.7b | เมตา | 10.2 | 2.2 |

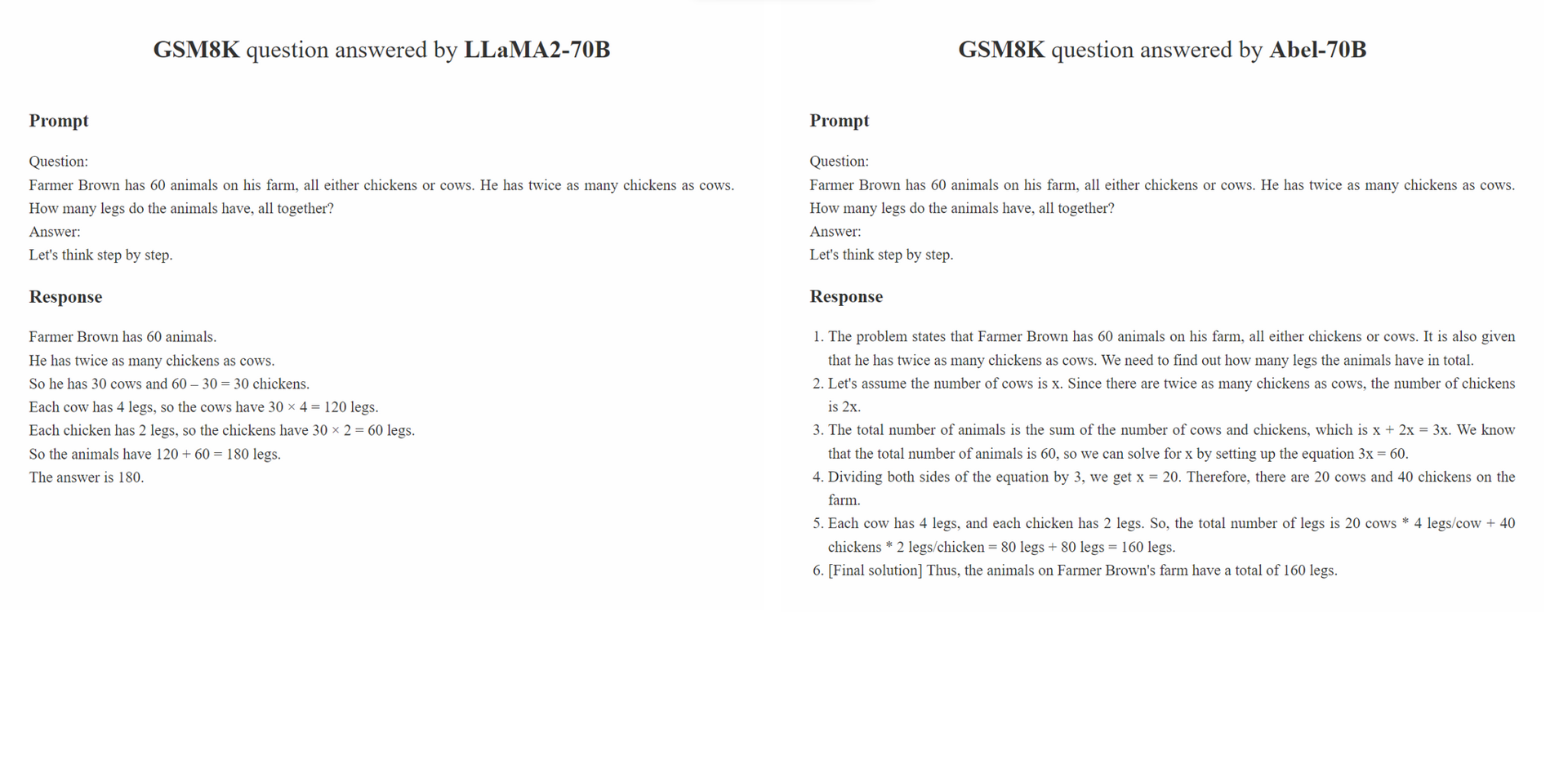

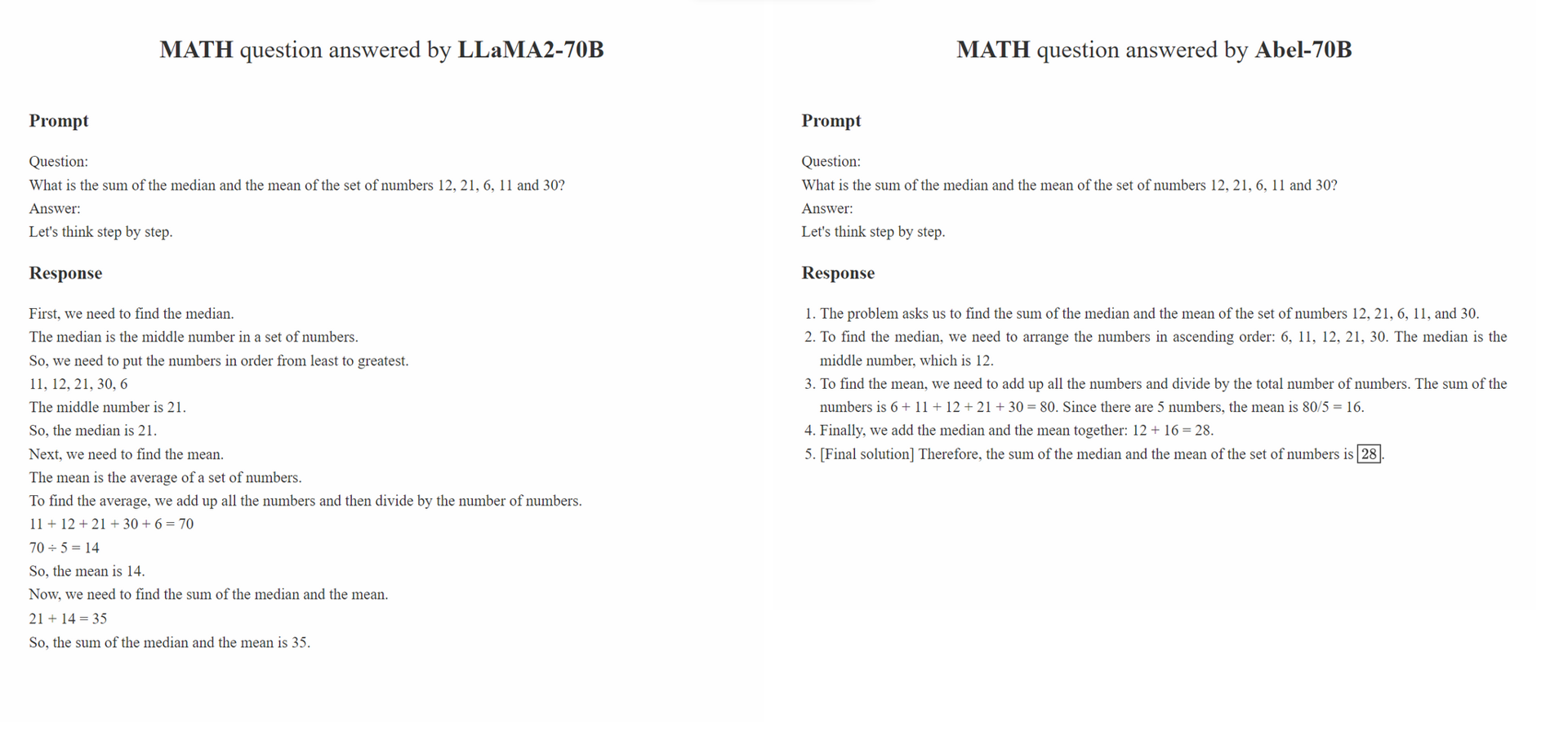

เราเสนอ การกำกับดูแลของผู้ปกครอง กลยุทธ์การรับเลี้ยงเด็ก สำหรับการปรับแต่งภายใต้การดูแล

Parental Oversight ไม่ จำกัด เฉพาะวิธีการประมวลผลข้อมูลเฉพาะ แต่จะกำหนดปรัชญาการประมวลผลข้อมูลที่ควรเป็นแนวทางในการควบคุมการปรับแต่งในยุคของ Generative AI (GAI) เราเชื่อว่าในยุคของ GAI วิศวกรรมโครงสร้างข้อมูล ได้กลายเป็นกระบวนทัศน์ใหม่ ภายในกระบวนทัศน์นี้ลักษณะที่ข้อมูลการปรับจูนได้รับการประมวลผลอย่างมีนัยสำคัญส่งผลกระทบต่อประสิทธิภาพของ GAI ที่ผ่านการฝึกอบรมอย่างมีนัยสำคัญ เราคาดว่าการศึกษาจำนวนมากขึ้นในชุมชนจะมุ่งเน้นไปที่ปรัชญาการประมวลผลข้อมูลนี้

หลักการของ Parental Oversight เน้นการรักษาผู้ควบคุมการปรับแต่งด้วยความระมัดระวังและรอบคอบ สิ่งนี้คล้ายคลึงกับวิธีที่ผู้ปกครองได้รับการสนับสนุนให้ให้ความรู้แก่ลูก ๆ ของพวกเขา ข้อมูลประเภทต่าง ๆ พร้อมกับรูปแบบการนำเสนอ (เช่นการใช้เหตุผลทีละขั้นตอนการปรับแต่งซ้ำ ๆ ) สามารถเปรียบได้กับวิธีการศึกษาที่หลากหลาย เช่นเดียวกับที่ผู้ปกครองเลือกวิธีการที่มีประสิทธิภาพมากที่สุดอย่างระมัดระวังในการสอนลูกของพวกเขาผู้ปฏิบัติงาน GAI ควรเลือกวิธีการประมวลผลข้อมูลที่มีประสิทธิภาพมากที่สุดอย่างระมัดระวังเพื่อแนะนำ LLM ของพวกเขาให้ดีขึ้น

ยิ่งไปกว่านั้น "ยิ่งมีข้อมูลมากขึ้นเท่าไหร่ปรัชญาที่ดีกว่า" ก็ไม่ได้เป็นจริงเสมอไป คุณภาพและความเกี่ยวข้องของตัวอย่างที่มีคำอธิบายประกอบมักจะมีค่ามากกว่าปริมาณของพวกเขา ตัวอย่างการฝึกอบรมที่ใช้ใน SFT ไม่เพียง แต่นำเสนอคำตอบที่ถูกต้อง แต่ยังแนะนำรูปแบบเกี่ยวกับวิธีการตอบที่ถูกต้องตามความรู้ของ LLM นอกจากนี้หากความรู้ของ LLM ไม่เพียงพอที่จะตอบคำถาม Parental Oversight ควรก้าวเข้ามาเพื่อจัดการกับช่องว่างความรู้ทันที

conda create -n abel python=3.10conda activate abelpip install -r requirements.txtbash evaluation/eval.sh ส่วนหนึ่งของสคริปต์การประเมินผลได้รับการแก้ไขจาก Minerva./outputs การวิเคราะห์ความทนทานของเราประกอบด้วยสองส่วน: การประเมินผลของฝ่ายตรงข้ามในชุดข้อมูล GSM8K_Robust และ การเรียนรู้การถ่ายโอนภายใต้การดูแลในชุดข้อมูล TAL-SCQ5K-EN เราทำการวิเคราะห์เบื้องต้นเพื่อทำความเข้าใจ (1) ว่าอาเบลเกินชุดข้อมูลการฝึกอบรมหรือไม่และมีความเปราะบางในการทดสอบตัวอย่างและ (2) ว่าวิธีการ SFT ของเราสามารถถ่ายโอนและสรุป Abel ไปยังชุดข้อมูลจากการแจกแจงที่แตกต่างกันได้หรือไม่

ชุดข้อมูล GSM8K_Robust เป็นชุดข้อมูลที่เราสร้างขึ้นตามชุดข้อมูล GSM8K เราสุ่มแก้ไขตัวเลขภายในคำถามของชุดข้อมูล GSM8K โดยไม่ต้องเปลี่ยนข้อมูลอื่น ๆ ในคำถามโดยใช้ GPT-4 นอกจากนี้เรายังขอให้ GPT-4 สร้าง 'คำตอบทองคำ' สำหรับคำถามที่แก้ไข หลังจากตรวจสอบชุดย่อยของตัวอย่างเหล่านี้ด้วยตนเองเราพบว่าคำตอบที่สร้างขึ้นทั้งหมดสำหรับคำถามที่เปลี่ยนแปลงนั้นถูกต้อง เราใช้ชุดข้อมูล GSM8K_Robust เพื่อประเมินว่าแบบจำลองนั้นมีข้อมูลการฝึกอบรมมากเกินไปหรือไม่ การวิเคราะห์ของเราบ่งชี้ว่าอาเบลมีความแข็งแกร่งมากกว่าตัวอย่างการทดสอบที่ไม่สามารถแจกจ่ายเมื่อเทียบกับรุ่นอื่น ๆ

| แบบอย่าง | GSM8K | gsm8k_robust | เดลต้า |

|---|---|---|---|

| Abel-7b | 59.74 | 58.23 | -1.51 |

| Abel-13b | 66.41 | 66.57 | +0.16 |

| Abel-70b | 83.62 | 81.80 | -1.82 |

| WizardMath-70B | 81.60 | 74.91 | -6.70 |

| WizardMath-13b | 63.90 | 59.51 | -4.39 |

| RFT-7B | 41.7 | 37.98 | -3.72 |

เราแสดงให้เห็นว่า Abel-70b ไม่เพียง แต่ประสบความสำเร็จใน SOTA ในชุดข้อมูล GSM8K และคณิตศาสตร์เท่านั้น การวิเคราะห์ของเราบ่งชี้ว่าวิธีการ SFT ของเราสามารถสรุป Abel ไปยังชุดข้อมูลจากการแจกแจงที่แตกต่างกันได้สำเร็จ เราจะทำการวิเคราะห์และการทดลองเพิ่มเติมเพื่อสำรวจและปรับปรุงความสามารถทั่วไปของ Abel

| แบบอย่าง | มาตรฐานการทดสอบ TAL-SCQ5K-EN 2K |

|---|---|

| Abel-70b | 59.7 |

| คณิตศาสตร์ | 59.0 |

| GPT-4 | 51.0 |

| LLAMA-70B | 43.8 |

เราได้สร้างรายการปัญหาเพื่อรักษาข้อ จำกัด และวิธีแก้ปัญหาที่อาจเกิดขึ้นเหล่านี้ ความคิดเห็นและความคิดเห็นของคุณยินดีต้อนรับเสมอ

โปรดอ้างอิง repo หากโมเดล/รหัส/ข้อสรุปใน repo นี้มีประโยชน์สำหรับคุณ

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

เรากำลังปรับปรุงแบบจำลองของเราอย่างต่อเนื่องและจะเปิดตัวการอัปเดต คอยติดตาม!