Modèle | Classement | Méthodologie | Évaluation | Analyse de la robustesse | Limitation | Citation | Perspectives |

Ethan Chern *, Haoyang Zou *, Xuefeng Li *, Jiewen Hu *, Kehua Feng, Junlong Li, Pengfei Liu +

[2023/12/12] Nous avons publié ABEL-7B-002 , entraînant une amélioration plus forte (35% de GSM8K, une amélioration de 126% des mathématiques) et un modèle plus généralisé, réalisant les meilleures performances parmi tous les modèles 7B (80,44 sur GSM8K, 29,46 sur les mathématiques)

| Nom du modèle | Points de contrôle HF | GSM8K | MATHÉMATIQUES | Licence |

|---|---|---|---|---|

| Abel-7b-002 | ? 7b | 80.44 | 29.46 | Licence Apache 2.0 |

| Abel-7b-001 | ? 7b | 59,74 | 13h00 | Lama 2 |

| Abel-13b-001 | ? 13B | 66.41 | 17.34 | Lama 2 |

| Abel-70b-001 | ? 70b | 83.62 | 28.26 | Lama 2 |

| Modèle | GSM8K | MATHÉMATIQUES | Mathqa | Svamp | SCQ5K-en | Arc-e | Arc-c | Hellaswag | MMLU |

|---|---|---|---|---|---|---|---|---|---|

| Abel-7b-002 | 80.44 | 29.46 | 69.78 | 77.67 | 55,95 | 77.67 | 55.05 | 77.72 | 61.19 |

| Abel-7b-001 | 59,74 | 13 | 1.21 | 57,67 | 9.3 | 53.32 | 38,97 | 63.51 | 40.59 |

| Metamath-Mistral-7b | 77.7 | 28.2 | 33.94 | 79.33 | 37.6 | 78,48 | 51,93 | 76.44 | 61.93 |

| Qwen-7b | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74.97 | 53.05 | 86.85 | 57,98 |

| Mistral-7b | 37,83 | 9.06 | 25.73 | 63 | 39.6 | 76.83 | 53.22 | 76.31 | 64.05 |

| YI-6B | 32.6 | 5.78 | 26.98 | 55.67 | 35,5 | 73.66 | 49,53 | 68,97 | 64.02 |

| Llama2-7b | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

On peut constater que:

Détails de l'évaluation:

Abel est créé en hommage à Niels Henrik Abel pour son travail révolutionnaire en algèbre et analyse, au cours de laquelle notre modèle est également relativement meilleur. Cependant, il y a encore un long chemin à parcourir, cependant? ️? ♀️ ?? ️? ♀️.

Nous montrons que:

Nous avons établi une nouvelle performance de pointe dans les LLM open source (qui n'utilisent pas d'outils externes) sur les repères GSM8K ( 83,62 ) et mathématiques ( 28.26 ). Spécifiquement:

GAIRMath-Abel assure 3 postes dans le top 10 et est le seul projet dirigé par l'université de la liste (d'autres sont soit des startups vedettes ou des grandes entreprises technologiques).Nous démontrons que:

? représente le modèle open source? suggère que le développement de modèles est dirigé par une université universitaire (au lieu des entreprises)| Classement | Modèle | Param. | Organisation de premier plan | GSM8K | MATHÉMATIQUES |

|---|---|---|---|---|---|

| 1 | Gpt-4 | inconnu | Openai | 92.0 | 42.5 |

| 2 | Claude-2 | inconnu | Anthropique | 88.0 | - |

| 3 | Palm-2-flan | inconnu | 84.7 | 33.2 | |

| ? 4 | Gairmath- abel | 70b | ? Gair Lab à l'Université de Shanghai Jiaotong | 83.6 | 28.3 |

| ? 5 | Wizardmath | 70b | Microsoft | 81.6 | 22.7 |

| 6 | Claude | inconnu | Anthropique | 80.9 | - |

| 7 | Chatte | inconnu | Openai | 80.8 | 34.1 |

| ? 4 | Abel -002 | 7b | ? Gair Lab à l'Université de Shanghai Jiaotong | 80.4 | 29.5 |

| 8 | Chatppt-0301 | inconnu | Openai | 74.9 | - |

| ? 9 | Gairmath- abel | 13B | ? Gair Lab à l'Université de Shanghai Jiaotong | 66.4 | 17.3 |

| ? 10 | Gairmath- abel | 7b | ? Gair Lab à l'Université de Shanghai Jiaotong | 59.7 | 13.0 |

| 11 | Mineroir | 540b | 58.8 | 33.6 | |

| 12 | Palmier | 540b | 56.9 | 8.8 | |

| ? 13 | Lama-2 | 70b | Méta | 56.8 | 13.5 |

| ? 14 | RFT | 33b | De | 56.5 | 7.4 |

| ? 15 | Baichuan2-13b | 13B | Baichuan | 52.8 | 10.1 |

| 16 | Mineroir | 62b | 52.4 | 27.6 | |

| 17 | Palmier | 64b | 52.4 | 4.4 | |

| ? 18 | RFT | 13B | De | 52.1 | 5.1 |

| ? 19 | Lama | 65b | Méta | 50.9 | 10.6 |

| ? 20 | Qwen | 7b | Alibaba | 44.9 | 8.5 |

| 21 | Chinchilla | 70b | Profondeur | 43.7 | - |

| ? 22 | Lama-2 | 34b | Méta | 42.2 | 6.24 |

| 23 | Galactica | 30b | Méta | 41.7 | 12.7 |

| ? 24 | Chatglm2 | 12b | Zhipu | 40.9 | - |

| 25 | Text-davinci-002 | 175b | Openai | 40.7 | 19.1 |

| ? 26 | Lama | 33b | Méta | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| ? 28 | Interne | 7b | Shanghai Ai Lab | 31.2 | - |

| ? 29 | Lama-2 | 13B | Méta | 28.7 | 3.9 |

| ? 30 | Vicuna v1.3 | 13B | LMSYS | 27.6 | - |

| ? 31 | Faucon | 40B | Institut de l'innovation technologique | 19.6 | 2.5 |

| ? 32 | Lama | 13B | Méta | 17.8 | 3.9 |

| ? 33 | Mpte | 30b | Mosaïque | 15.2 | 3.1 |

| 34 | Galactica | 6.7b | Méta | 10.2 | 2.2 |

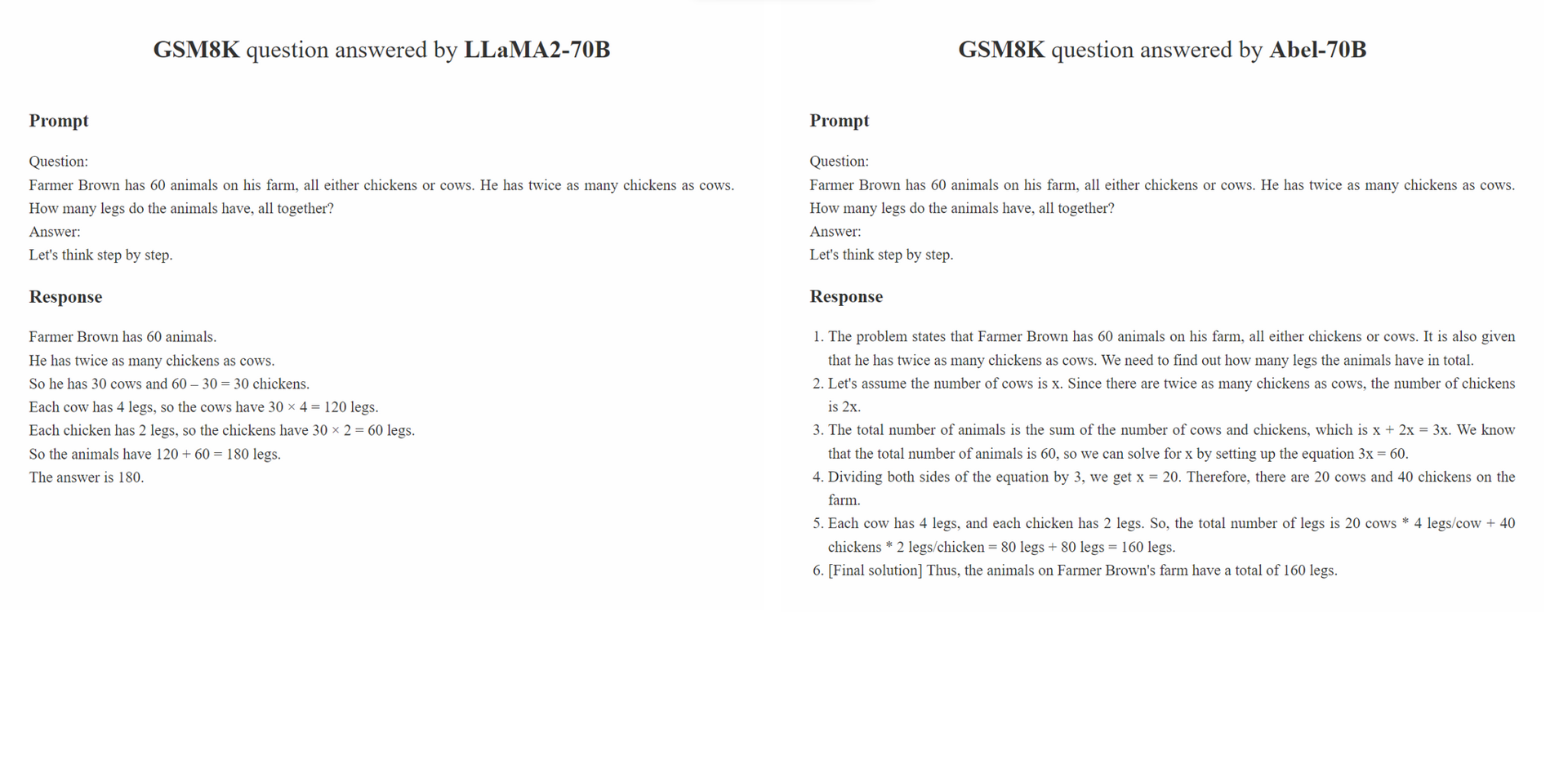

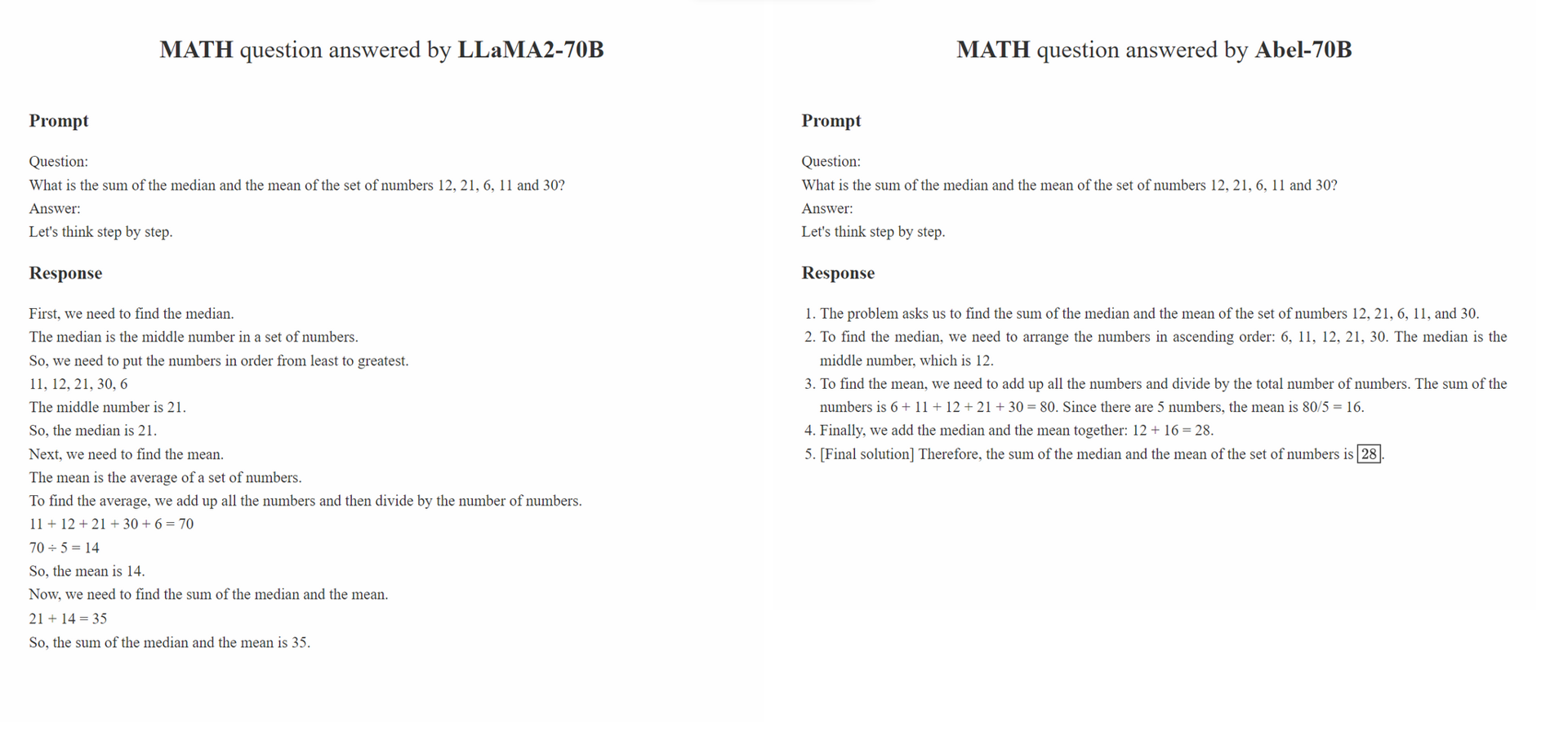

Nous proposons une surveillance parentale , une stratégie de babysitting pour le réglage fin supervisé,

Parental Oversight ne se limite à aucune méthode de traitement des données spécifique. Au lieu de cela, il définit la philosophie de traitement des données qui devrait guider le réglage fin supervisé à l'ère de l'IA générative (GAI). Nous pensons qu'à l'ère de GAI, l'ingénierie de la structure des données est devenue un nouveau paradigme. Dans ce paradigme, la manière dont les données de réglage fin est traitée affecte considérablement les performances du GAI formé. Nous nous attendons à ce qu'un nombre croissant d'études dans la communauté se concentrent sur cette philosophie de traitement des données.

Le principe de Parental Oversight met l'accent sur le traitement du réglage fin supervisé avec soin et prudence. Ceci est analogue à la façon dont les parents sont encouragés à éduquer leurs enfants. Différents types de données, ainsi que leurs formats de présentation (par exemple, le raisonnement étape par étape, le raffinement itératif), peuvent être comparés à des méthodes éducatives variées. Tout comme les parents sélectionnent avec prudence l'approche la plus efficace pour instruire leurs enfants, les praticiens du GAI devraient sélectionner avec prudence les approches de traitement des données les plus efficaces pour mieux instruire leur LLMS.

De plus, plus la philosophie "plus", la meilleure "ne tient pas toujours. La qualité et la pertinence des échantillons annotés peuvent souvent l'emporter sur leur quantité. Les échantillons de formation utilisés dans SFT ne doivent pas seulement présenter la bonne réponse, mais également instruire le modèle sur la façon dont la bonne réponse a été dérivée en fonction de la connaissance du LLM. De plus, si les connaissances du LLM ne sont pas suffisantes pour répondre à une question, Parental Oversight doit intervenir pour combler les lacunes des connaissances rapidement.

conda create -n abel python=3.10conda activate abelpip install -r requirements.txt .bash evaluation/eval.sh Une partie du script d'évaluation est modifiée à partir de Minerva../outputs . Notre analyse de robustesse se compose de deux parties: une évaluation contradictoire sur l'ensemble de données GSM8K_ROBUST et un apprentissage de transfert supervisé sur l'ensemble de données TAL-SCQ5K-en . Nous effectuons une analyse préliminaire pour comprendre (1) si ABEL suraligne l'ensemble de données de formation et est donc fragile des échantillons de tests hors distribution et (2) si notre approche SFT peut rapidement transférer et généraliser ABEL aux ensembles de données à partir de différentes distributions.

L'ensemble de données GSM8K_ROBUST est un ensemble de données que nous avons établi sur la base de l'ensemble de données GSM8K. Nous avons modifié au hasard les nombres dans les questions de l'ensemble de données GSM8K, sans modifier d'autres informations dans les questions, en utilisant GPT-4. Nous avons également demandé à GPT-4 de générer les «réponses dorées» pour les questions modifiées. Après avoir examiné manuellement un sous-ensemble de ces échantillons, nous avons constaté que toutes les réponses générées pour les questions modifiées étaient exactes. Nous avons utilisé l'ensemble de données GSM8K_ROBUST pour évaluer si les modèles surfigmentent les données de formation, ce qui rend les modèles sensibles à des échantillons de tests hors distribution. Notre analyse indique qu'Abel est plus robuste aux échantillons de tests hors distribution par rapport à d'autres modèles.

| Modèle | GSM8K | Gsm8k_robust | delta |

|---|---|---|---|

| Abel-7b | 59,74 | 58.23 | -1,51 |

| Abel-13b | 66.41 | 66.57 | +0.16 |

| Abel-70b | 83.62 | 81.80 | -1,82 |

| Wizardmath-70b | 81,60 | 74.91 | -6,70 |

| Wizardmath-13b | 63.90 | 59.51 | -4.39 |

| RFT-7B | 41.7 | 37,98 | -3,72 |

Nous démontrons qu'ABEL-70B atteint non seulement SOTA sur les ensembles de données GSM8K et mathématiques, mais se généralise également bien à TAL-SCQ5K-EN 2K, un ensemble de données nouvellement publié par le fournisseur de mathématiques LLM TAL (好未來). Notre analyse indique que notre approche SFT peut généraliser avec succès Abel aux ensembles de données à partir de différentes distributions. Nous effectuerons d'autres analyses et expériences pour explorer et améliorer les capacités de généralisation d'Abel.

| Modèle | TAL-SCQ5K-en 2k Test Benchmark |

|---|---|

| Abel-70b | 59.7 |

| Mathgpt | 59.0 |

| Gpt-4 | 51.0 |

| Lama-70b | 43.8 |

Nous avons créé une liste de problèmes pour maintenir ces limitations et solutions potentielles. Vos opinions et commentaires sont toujours les bienvenus.

Veuillez citer le dépôt si le modèle / code / conclusion dans ce dépôt vous est utile.

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

Nous affinons continuellement nos modèles et publions des mises à jour. Restez à l'écoute!