Modelo | Tabela de classificação | Metodologia | Avaliação | Análise de robustez | Limitação | Citação | Outlook |

Ethan Chern*, Haoyang Zou*, Xuefeng Li*, Jiewen Hu*, Kehua Feng, Junlong Li, Pengfei Liu+

[2023/12/12] Lançamos o ABEL-7B-002 , resultando em uma melhoria mais forte (35% no GSM8K, melhoria de 126% em matemática) e modelo mais generalizado, alcançando o melhor desempenho entre todos os modelos 7B (80,44 no GSM8K, 29,46 na matemática)

| Nome do modelo | Ponto de verificação HF | GSM8K | MATEMÁTICA | Licença |

|---|---|---|---|---|

| Abel-7b-002 | ? 7b | 80.44 | 29.46 | Licença Apache 2.0 |

| Abel-7b-001 | ? 7b | 59.74 | 13.00 | LLAMA 2 |

| Abel-13b-001 | ? 13b | 66.41 | 17.34 | LLAMA 2 |

| Abel-70B-001 | ? 70B | 83.62 | 28.26 | LLAMA 2 |

| Modelo | GSM8K | MATEMÁTICA | Mathqa | Svamp | SCQ5K-en | Arc-e | Arc-c | Hellaswag | Mmlu |

|---|---|---|---|---|---|---|---|---|---|

| Abel-7b-002 | 80.44 | 29.46 | 69.78 | 77.67 | 55.95 | 77.67 | 55.05 | 77.72 | 61.19 |

| Abel-7b-001 | 59.74 | 13 | 1.21 | 57.67 | 9.3 | 53.32 | 38.97 | 63.51 | 40.59 |

| Metamath-Mistral-7b | 77.7 | 28.2 | 33.94 | 79.33 | 37.6 | 78.48 | 51.93 | 76.44 | 61.93 |

| QWEN-7B | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74.97 | 53.05 | 86,85 | 57.98 |

| Mistral-7b | 37.83 | 9.06 | 25.73 | 63 | 39.6 | 76.83 | 53.22 | 76.31 | 64.05 |

| Yi-6b | 32.6 | 5.78 | 26.98 | 55.67 | 35.5 | 73.66 | 49.53 | 68.97 | 64.02 |

| Llama2-7b | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

Pode -se descobrir que:

Detalhes da avaliação:

Abel é criado como uma homenagem a Niels Henrik Abel por seu trabalho inovador em álgebra e análise, na qual nosso modelo também é relativamente melhor. Ainda há um longo caminho para nós irmos?

Nós mostramos isso:

Estabelecemos um novo desempenho de ponta nos LLMs de código aberto (que não usam ferramentas externas) nos benchmarks GSM8K ( 83,62 ) e Math ( 28.26 ). Especificamente:

GAIRMath-Abel protege 3 posições nos 10 principais rankings e permanece como o único projeto liderado pela universidade na lista (outros são startups em estrelas ou grandes empresas de tecnologia).Nós demonstramos que:

? representa o modelo de código aberto? sugere que o desenvolvimento do modelo é liderado pela Universidade Acadêmica (em vez de empresas)| Ranking | Modelo | Param. | Organização líder | GSM8K | MATEMÁTICA |

|---|---|---|---|---|---|

| 1 | GPT-4 | desconhecido | Openai | 92.0 | 42.5 |

| 2 | Claude-2 | desconhecido | Antrópico | 88.0 | - |

| 3 | Palm-2-flan | desconhecido | 84.7 | 33.2 | |

| ? 4 | Gairmath- Abel | 70B | ? Laboratório Gair na Universidade de Xangai Jiaotong | 83.6 | 28.3 |

| ? 5 | Wizardmath | 70B | Microsoft | 81.6 | 22.7 |

| 6 | Claude-Instant | desconhecido | Antrópico | 80.9 | - |

| 7 | Chatgpt | desconhecido | Openai | 80.8 | 34.1 |

| ? 4 | Abel -002 | 7b | ? Laboratório Gair na Universidade de Xangai Jiaotong | 80.4 | 29.5 |

| 8 | ChatGPT-0301 | desconhecido | Openai | 74.9 | - |

| ? 9 | Gairmath- Abel | 13b | ? Laboratório Gair na Universidade de Xangai Jiaotong | 66.4 | 17.3 |

| ? 10 | Gairmath- Abel | 7b | ? Laboratório Gair na Universidade de Xangai Jiaotong | 59.7 | 13.0 |

| 11 | Minerva | 540b | 58.8 | 33.6 | |

| 12 | Palma | 540b | 56.9 | 8.8 | |

| ? 13 | Lhama-2 | 70B | Meta | 56.8 | 13.5 |

| ? 14 | Rft | 33b | OFA | 56.5 | 7.4 |

| ? 15 | Baichuan2-13b | 13b | Baichuan | 52.8 | 10.1 |

| 16 | Minerva | 62b | 52.4 | 27.6 | |

| 17 | Palma | 64b | 52.4 | 4.4 | |

| ? 18 | Rft | 13b | OFA | 52.1 | 5.1 |

| ? 19 | Lhama | 65b | Meta | 50.9 | 10.6 |

| ? 20 | Qwen | 7b | Alibaba | 44.9 | 8.5 |

| 21 | Chinchila | 70B | DeepMind | 43.7 | - |

| ? 22 | Lhama-2 | 34b | Meta | 42.2 | 6.24 |

| 23 | Galactica | 30b | Meta | 41.7 | 12.7 |

| ? 24 | Chatglm2 | 12b | Zhipu | 40.9 | - |

| 25 | Text-Davinci-002 | 175b | Openai | 40.7 | 19.1 |

| ? 26 | Lhama | 33b | Meta | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Openai | 34 | 5.2 |

| ? 28 | Internlm | 7b | Shanghai Ai Lab | 31.2 | - |

| ? 29 | Lhama-2 | 13b | Meta | 28.7 | 3.9 |

| ? 30 | Vicuna v1.3 | 13b | Lmsys | 27.6 | - |

| ? 31 | Falcão | 40b | Instituto de Inovação em Tecnologia | 19.6 | 2.5 |

| ? 32 | Lhama | 13b | Meta | 17.8 | 3.9 |

| ? 33 | Mpt | 30b | Mosaicml | 15.2 | 3.1 |

| 34 | Galactica | 6.7b | Meta | 10.2 | 2.2 |

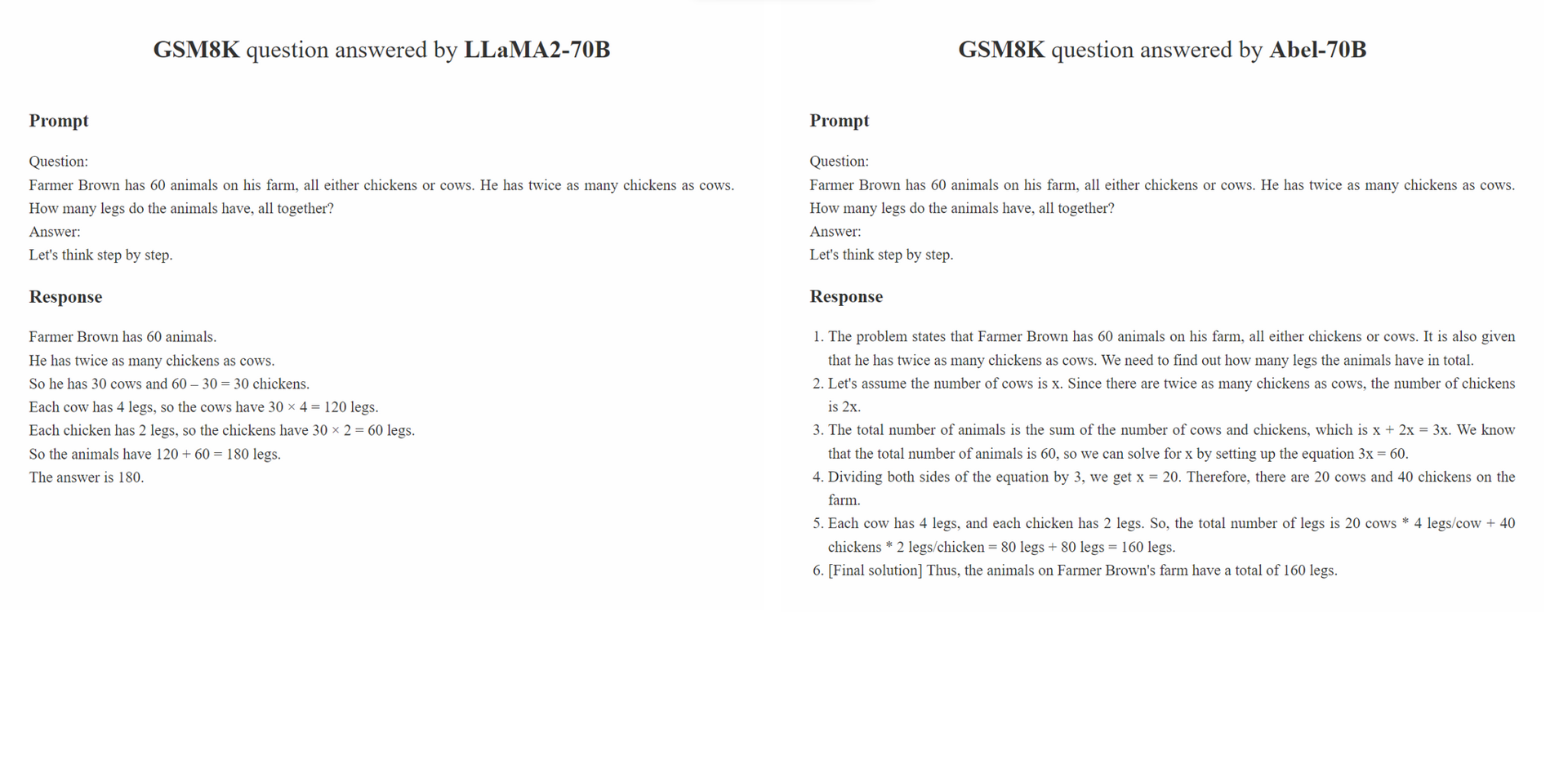

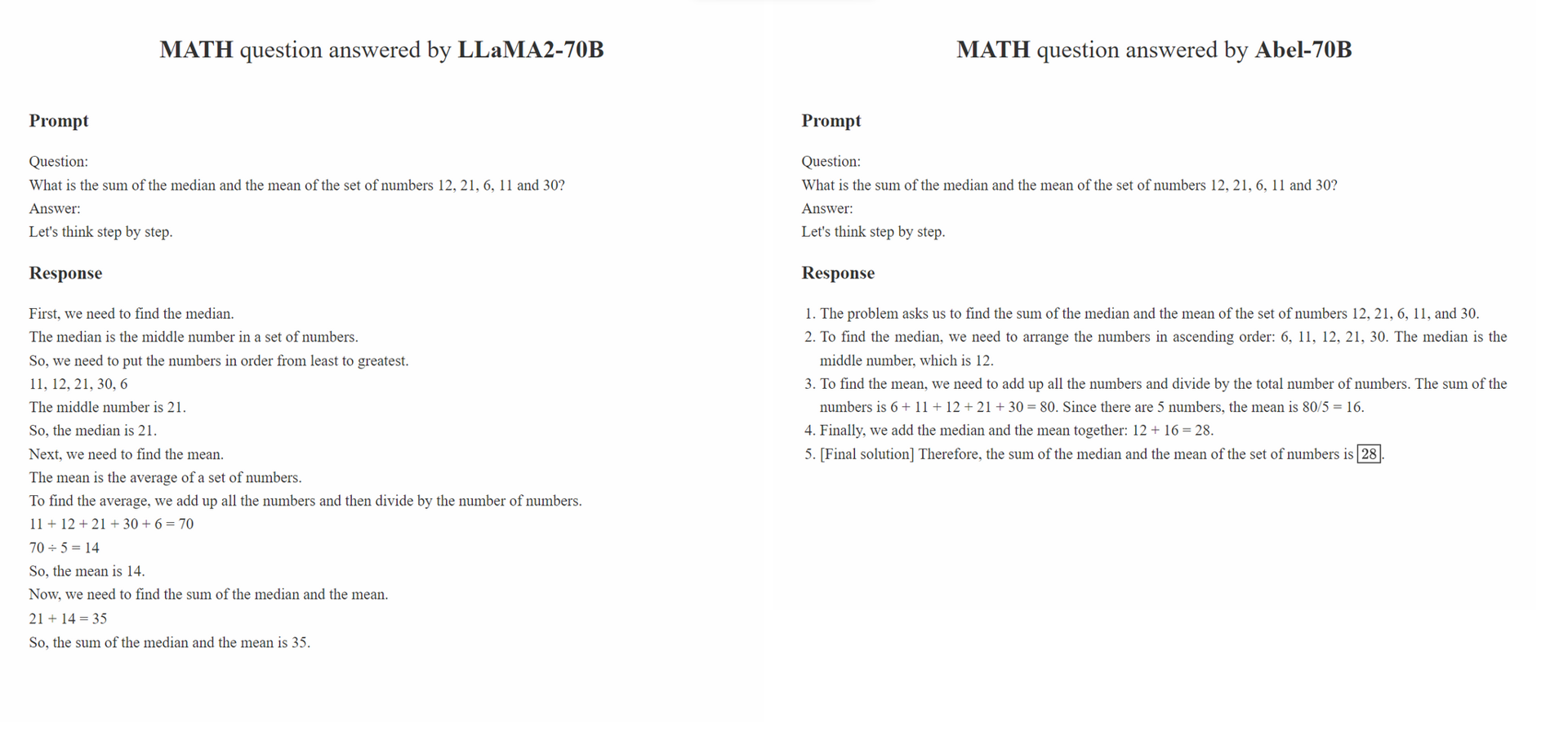

Propomos a supervisão dos pais , uma estratégia de babá para o ajuste fino supervisionado,

Parental Oversight não se limita a nenhum método específico de processamento de dados. Em vez disso, define a filosofia de processamento de dados que deve orientar o ajuste fino supervisionado na era da IA generativa (GAI). Acreditamos que, na era do GAI, a engenharia da estrutura de dados emergiu como um novo paradigma. Dentro desse paradigma, a maneira pela qual os dados de ajuste fino são processados afeta significativamente o desempenho do GAI treinado. Esperamos que um número crescente de estudos na comunidade se concentre nessa filosofia de processamento de dados.

O princípio da Parental Oversight enfatiza o tratamento de ajustes finos supervisionados com cuidado e prudência. Isso é análogo à maneira como os pais são incentivados a educar seus filhos. Diferentes tipos de dados, juntamente com seus formatos de apresentação (por exemplo, raciocínio passo a passo, refinamento iterativo), podem ser comparados a métodos educacionais variados. Assim como os pais selecionam cautelosamente a abordagem mais eficaz para instruir seus filhos, os profissionais da GAI devem selecionar cautelosamente as abordagens de processamento de dados mais eficazes para instruir melhor seus LLMs.

Além disso, quanto mais a filosofia "mais dados, melhor" nem sempre é verdadeira. A qualidade e a relevância das amostras anotadas geralmente superavam sua quantidade. As amostras de treinamento usadas na SFT não devem apenas apresentar a resposta certa, mas também instruir o modelo sobre como a resposta correta foi derivada com base no conhecimento do LLM. Além disso, se o conhecimento do LLM não for suficiente para responder a uma pergunta, Parental Oversight deve intervir para abordar prontamente as lacunas de conhecimento.

conda create -n abel python=3.10conda activate abelpip install -r requirements.txt .bash evaluation/eval.sh . Parte do script de avaliação é modificada no Minerva../outputs . Nossa análise de robustez consiste em duas partes: avaliação adversária no conjunto de dados GSM8K_ROBUST e aprendizado de transferência supervisionado no conjunto de dados tal-scq5k-en . Realizamos uma análise preliminar para entender (1) se abels sobrecarregar o conjunto de dados de treinamento e, portanto, é quebradiço para amostras de testes fora da distribuição e (2) se nossa abordagem SFT pode transferir e generalizar rapidamente a Abel para conjuntos de dados de diferentes distribuições.

O conjunto de dados GSM8K_ROBUST é um conjunto de dados que estabelecemos com base no conjunto de dados GSM8K. Modificamos aleatoriamente os números dentro das questões do conjunto de dados GSM8K, sem alterar nenhuma outra informação nas perguntas, usando o GPT-4. Também pedimos ao GPT-4 que gerasse as 'respostas douradas' para as perguntas modificadas. Depois de revisar manualmente um subconjunto dessas amostras, descobrimos que todas as respostas geradas para as perguntas alteradas eram precisas. Utilizamos o conjunto de dados GSM8K_ROBUST para avaliar se os modelos superam os dados de treinamento, tornando os modelos suscetíveis a amostras de testes fora da distribuição. Nossa análise indica que a ABEL é mais robusta para amostras de testes fora da distribuição em comparação com outros modelos.

| Modelo | GSM8K | Gsm8k_robust | delta |

|---|---|---|---|

| Abel-7b | 59.74 | 58.23 | -1,51 |

| Abel-13b | 66.41 | 66.57 | +0.16 |

| Abel-70B | 83.62 | 81,80 | -1,82 |

| Wizardmath-70b | 81.60 | 74.91 | -6,70 |

| WizardMath-13b | 63.90 | 59.51 | -4,39 |

| RFT-7B | 41.7 | 37.98 | -3.72 |

Demonstramos que o ABEL-70B não apenas atinge o SOTA nos conjuntos de dados GSM8K e Math, mas também generaliza bem para o tal-scq5k-en 2k, um conjunto de dados recém-lançado do fornecedor Math LLM Tal (好未來). Nossa análise indica que nossa abordagem SFT pode generalizar com sucesso a Abel para conjuntos de dados de diferentes distribuições. Realizaremos análises e experimentos adicionais para explorar e melhorar as capacidades de generalização de Abel.

| Modelo | Referência de teste tal-scq5k-en 2k |

|---|---|

| Abel-70B | 59.7 |

| Mathgpt | 59.0 |

| GPT-4 | 51.0 |

| LLAMA-70B | 43.8 |

Criamos uma lista de problemas para manter essas limitações e possíveis soluções. Suas opiniões e comentários são sempre bem -vindos.

Cite o repositório se o modelo/código/conclusão neste repositório for útil para você.

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

Estamos refinando continuamente nossos modelos e lançaremos atualizações. Fique atento!