Modelo | Tabla de clasificación | Metodología | Evaluación | Análisis de robustez | Limitación | Cita | Perspectiva |

Ethan Chern*, Haoyang Zou*, Xuefeng Li*, Jiewen Hu*, Kehua Feng, Junlong Li, Pengfei Liu+

[2023/12/12] Lanzamos ABEL-7B-002 , lo que resultó en una mejora más fuerte (35% en GSM8K, 126% de mejora en matemáticas) y más generalizado, logrando el mejor rendimiento entre los modelos 7B (80.44 en GSM8K, 29.46 en matemáticas)

| Nombre del modelo | Puntos de control HF | GSM8K | MATEMÁTICAS | Licencia |

|---|---|---|---|---|

| Abel-7b-002 | ? 7b | 80.44 | 29.46 | Licencia de Apache 2.0 |

| Abel-7b-001 | ? 7b | 59.74 | 13.00 | Llama 2 |

| Abel-13b-001 | ? 13B | 66.41 | 17.34 | Llama 2 |

| Abel-70b-001 | ? 70b | 83.62 | 28.26 | Llama 2 |

| Modelo | GSM8K | MATEMÁTICAS | Mathqa | Svamp | Scq5k-en | Arc-E | Arc-c | Helaswag | MMLU |

|---|---|---|---|---|---|---|---|---|---|

| Abel-7b-002 | 80.44 | 29.46 | 69.78 | 77.67 | 55.95 | 77.67 | 55.05 | 77.72 | 61.19 |

| Abel-7b-001 | 59.74 | 13 | 1.21 | 57.67 | 9.3 | 53.32 | 38.97 | 63.51 | 40.59 |

| Metamath-Mistral-7b | 77.7 | 28.2 | 33.94 | 79.33 | 37.6 | 78.48 | 51.93 | 76.44 | 61.93 |

| Qwen-7b | 47.84 | 9.34 | 27.44 | 53 | 40.05 | 74.97 | 53.05 | 86.85 | 57.98 |

| Mistral-7b | 37.83 | 9.06 | 25.73 | 63 | 39.6 | 76.83 | 53.22 | 76.31 | 64.05 |

| Yi-6b | 32.6 | 5.78 | 26.98 | 55.67 | 35.5 | 73.66 | 49.53 | 68.97 | 64.02 |

| Llama2-7b | 12.96 | 2.78 | 11.52 | 44 | 28.24 | 71.12 | 46.61 | 71.32 | 46.7 |

Se puede encontrar que:

Detalles de evaluación:

Abel es creado como un homenaje a Niels Henrik Abel por su innovador trabajo en álgebra y análisis, en el que nuestro modelo también es relativamente mejor. ¿Todavía hay un largo camino para que nos vayamos?

Mostramos que:

Hemos establecido un nuevo rendimiento de última generación en LLM de código abierto (que no usan herramientas externas) en los puntos de referencia GSM8K ( 83.62 ) y matemáticas ( 28.26 ). Específicamente:

GAIRMath-Abel asegura 3 puestos en las 10 mejores clasificaciones y se encuentra como el único proyecto dirigido por la universidad en la lista (otros son nuevas empresas estelares o grandes compañías tecnológicas).Demostramos que:

? representa el modelo de código abierto? sugiere que el desarrollo del modelo está dirigido por la Universidad Académica (en lugar de las empresas)| Categoría | Modelo | Param. | Organización líder | GSM8K | MATEMÁTICAS |

|---|---|---|---|---|---|

| 1 | GPT-4 | desconocido | Opadai | 92.0 | 42.5 |

| 2 | Claude-2 | desconocido | Antrópico | 88.0 | - |

| 3 | Palma-2-flan | desconocido | 84.7 | 33.2 | |

| ? 4 | Gairmath- abel | 70b | ? Gair Lab en la Universidad de Shanghai Jiaotong | 83.6 | 28.3 |

| ? 5 | Mago | 70b | Microsoft | 81.6 | 22.7 |

| 6 | Instante | desconocido | Antrópico | 80.9 | - |

| 7 | Chatgpt | desconocido | Opadai | 80.8 | 34.1 |

| ? 4 | Abel -002 | 7b | ? Gair Lab en la Universidad de Shanghai Jiaotong | 80.4 | 29.5 |

| 8 | Chatgpt-0301 | desconocido | Opadai | 74.9 | - |

| ? 9 | Gairmath- abel | 13B | ? Gair Lab en la Universidad de Shanghai Jiaotong | 66.4 | 17.3 |

| ? 10 | Gairmath- abel | 7b | ? Gair Lab en la Universidad de Shanghai Jiaotong | 59.7 | 13.0 |

| 11 | Minerva | 540b | 58.8 | 33.6 | |

| 12 | Palmera | 540b | 56.9 | 8.8 | |

| ? 13 | Llama-2 | 70b | Meta | 56.8 | 13.5 |

| ? 14 | RFT | 33b | Ofa | 56.5 | 7.4 |

| ? 15 | Baichuan2-13b | 13B | Baichuan | 52.8 | 10.1 |

| 16 | Minerva | 62B | 52.4 | 27.6 | |

| 17 | Palmera | 64b | 52.4 | 4.4 | |

| ? 18 | RFT | 13B | Ofa | 52.1 | 5.1 |

| ? 19 | Llama | 65b | Meta | 50.9 | 10.6 |

| ? 20 | Qwen | 7b | Alibaba | 44.9 | 8.5 |

| 21 | Chinchilla | 70b | Profundo | 43.7 | - |

| ? 22 | Llama-2 | 34b | Meta | 42.2 | 6.24 |

| 23 | Galáctica | 30b | Meta | 41.7 | 12.7 |

| ? 24 | Chatglm2 | 12b | Zhipu | 40.9 | - |

| 25 | Texto-Davinci-002 | 175b | Opadai | 40.7 | 19.1 |

| ? 26 | Llama | 33b | Meta | 35.6 | 7.1 |

| 27 | GPT-3 | 175b | Opadai | 34 | 5.2 |

| ? 28 | Prostituta | 7b | Shanghai AI Labor | 31.2 | - |

| ? 29 | Llama-2 | 13B | Meta | 28.7 | 3.9 |

| ? 30 | Vicuna V1.3 | 13B | LMSYS | 27.6 | - |

| ? 31 | Halcón | 40b | Instituto de innovación tecnológica | 19.6 | 2.5 |

| ? 32 | Llama | 13B | Meta | 17.8 | 3.9 |

| ? 33 | MPT | 30b | Mosaico | 15.2 | 3.1 |

| 34 | Galáctica | 6.7b | Meta | 10.2 | 2.2 |

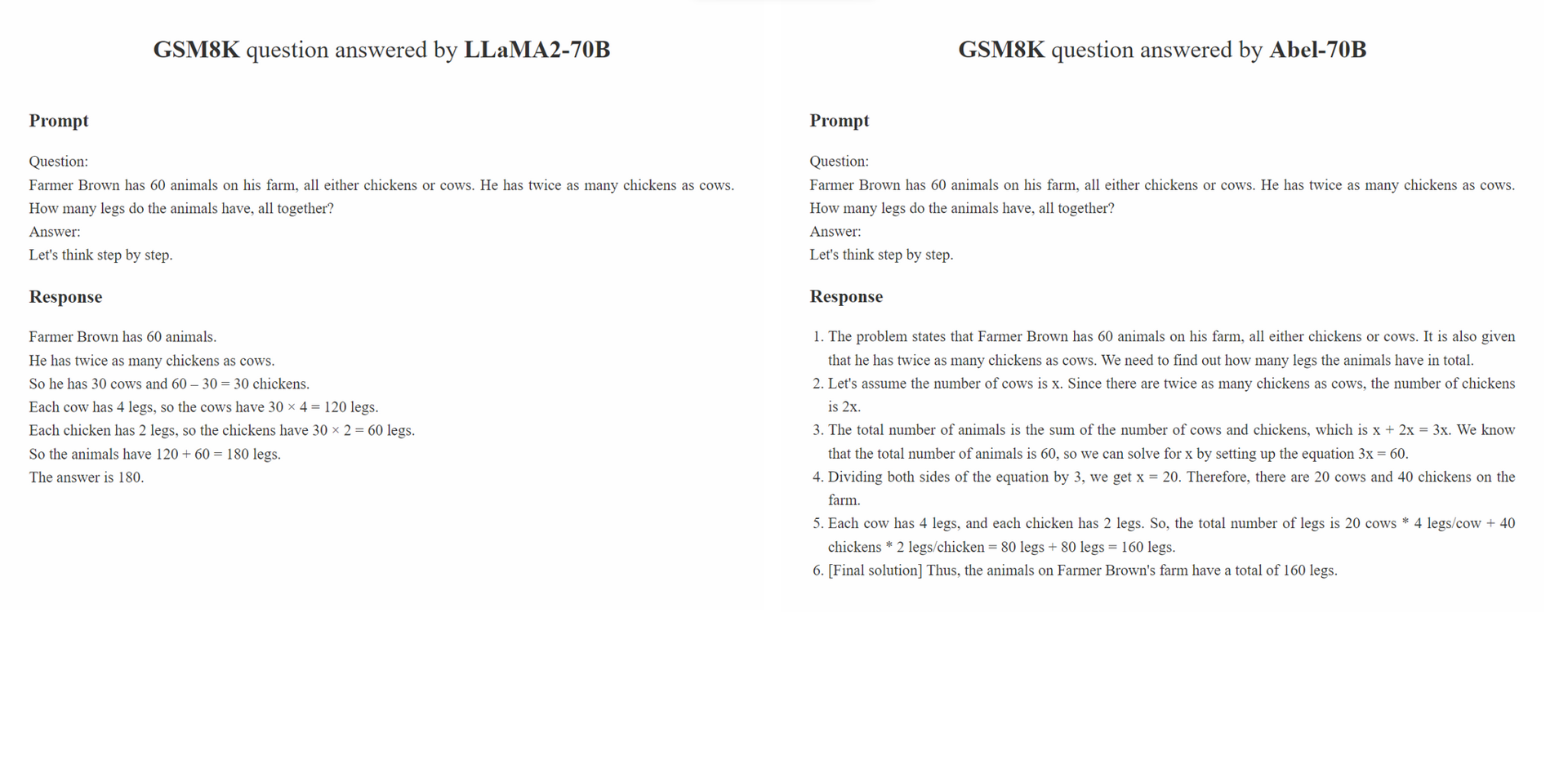

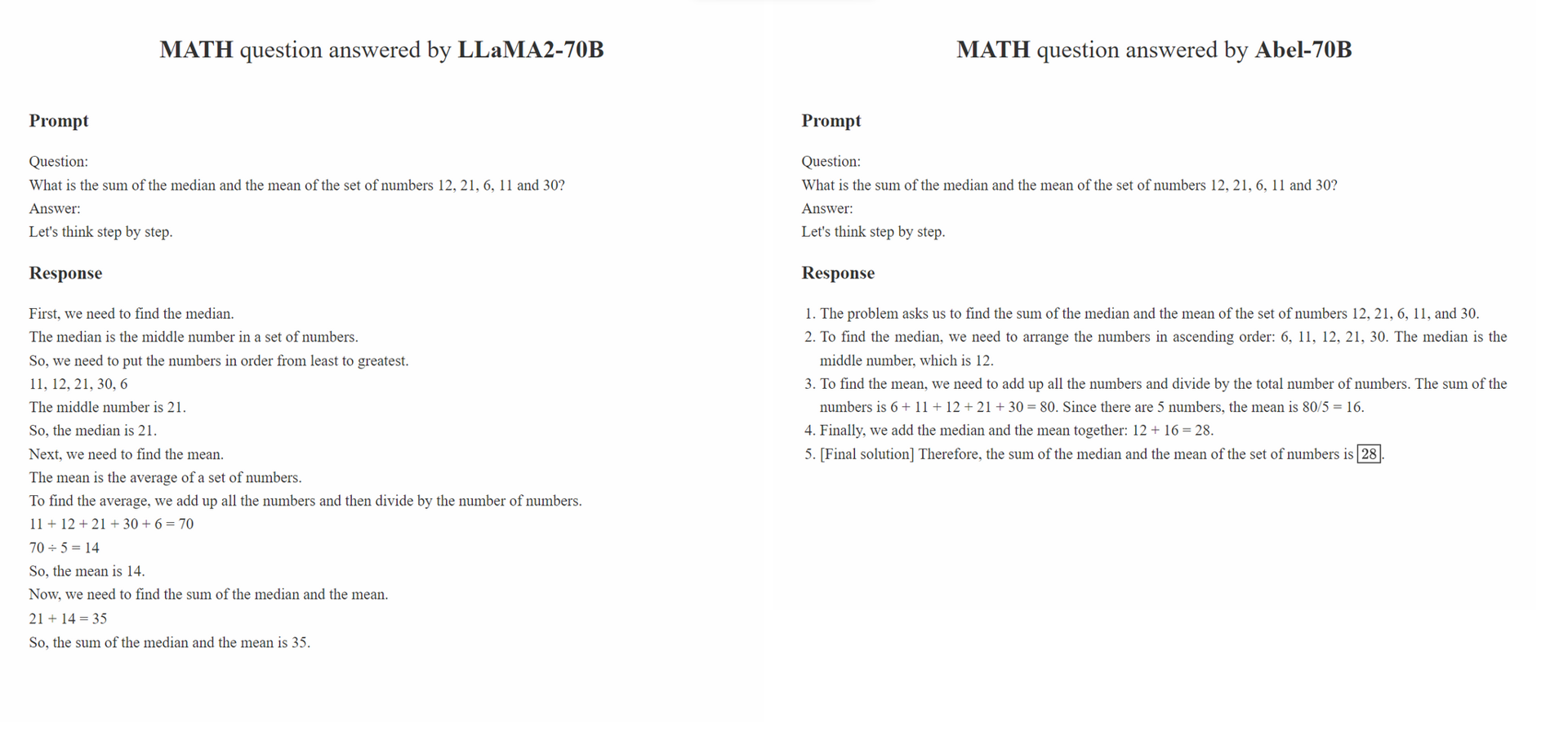

Proponemos la supervisión de los padres , una estrategia de cuidado de niños para el ajuste de fino supervisado,

Parental Oversight no se limita a ningún método de procesamiento de datos específico. En cambio, define la filosofía de procesamiento de datos que debería guiar el ajuste fino supervisado en la era de la IA generativa (GAI). Creemos que en la era de GAI, la ingeniería de estructura de datos ha surgido como un nuevo paradigma. Dentro de este paradigma, la forma en que se procesan los datos de ajuste fino afectan significativamente el rendimiento del GAI capacitado. Esperamos que un número creciente de estudios en la comunidad se concentre en esta filosofía de procesamiento de datos.

El principio de Parental Oversight enfatiza el tratamiento de ajuste fino supervisado con cuidado y prudencia. Esto es análogo a la forma en que se alienta a los padres a educar a sus hijos. Los diferentes tipos de datos, junto con sus formatos de presentación (por ejemplo, razonamiento paso a paso, refinamiento iterativo), pueden compararse con los métodos educativos variados. Así como los padres seleccionan con cautela el enfoque más efectivo para instruir a sus hijos, los practicantes de GAI deben seleccionar con cautela los enfoques de procesamiento de datos más efectivos para instruir mejor a sus LLM.

Además, la filosofía "más datos, más mejor" no siempre es cierta. La calidad y relevancia de las muestras anotadas a menudo pueden superar su cantidad. Las muestras de entrenamiento utilizadas en SFT no solo deben presentar la respuesta correcta, sino que también instruir al modelo sobre cómo se derivó la respuesta correcta en función del conocimiento de la LLM. Además, si el conocimiento de la LLM no es suficiente para responder una pregunta, Parental Oversight debe intervenir para abordar las brechas de conocimiento con prontitud.

conda create -n abel python=3.10conda activate abelpip install -r requirements.txt .bash evaluation/eval.sh . Parte del script de evaluación se modifica de Minerva../outputs . Nuestro análisis de robustez consta de dos partes: evaluación adversaria en el conjunto de datos GSM8K_ROBUST y el aprendizaje de transferencia supervisada en el conjunto de datos TAL-SCQ5K-EN . Realizamos un análisis preliminar para comprender (1) si ABEL sobrefiña el conjunto de datos de capacitación y, por lo tanto, es frágil para las muestras de prueba fuera de distribución y (2) si nuestro enfoque SFT puede transferir rápidamente y generalizar ABEL a conjuntos de datos de diferentes distribuciones.

El conjunto de datos GSM8K_ROBUST es un conjunto de datos que establecimos en base al conjunto de datos GSM8K. Modificamos aleatoriamente los números dentro de las preguntas del conjunto de datos GSM8K, sin alterar ninguna otra información en las preguntas, utilizando GPT-4. También le pedimos a GPT-4 que generara las 'respuestas doradas' para las preguntas modificadas. Después de revisar manualmente un subconjunto de estas muestras, encontramos que todas las respuestas generadas para las preguntas alteradas eran precisas. Utilizamos el conjunto de datos GSM8K_ROBUST para evaluar si los modelos sobrepiten los datos de capacitación, lo que hace que los modelos sean susceptibles a las muestras de prueba fuera de distribución. Nuestro análisis indica que ABEL es más sólido para las muestras de pruebas fuera de distribución en comparación con otros modelos.

| Modelo | GSM8K | Gsm8k_robust | delta |

|---|---|---|---|

| Abel-7b | 59.74 | 58.23 | -1.51 |

| Abel-13b | 66.41 | 66.57 | +0.16 |

| Abel-70b | 83.62 | 81.80 | -1.82 |

| Wizardmath-70b | 81.60 | 74.91 | -6.70 |

| Wizardmath-13b | 63.90 | 59.51 | -4.39 |

| RFT-7B | 41.7 | 37.98 | -3.72 |

Demostramos que ABEL-70B no solo logra SOTA en los conjuntos de datos GSM8K y Matemáticas, sino que también generaliza bien a TALSCQ5K-EN 2K, un conjunto de datos recientemente publicado por el proveedor de Math LLM Tal (好未來). Nuestro análisis indica que nuestro enfoque SFT puede generalizar con éxito ABEL a los conjuntos de datos de diferentes distribuciones. Realizaremos más análisis y experimentos para explorar y mejorar las capacidades de generalización de ABEL.

| Modelo | Tal-SCQ5K-EN 2K Testing Benchmark |

|---|---|

| Abel-70b | 59.7 |

| Mathgpt | 59.0 |

| GPT-4 | 51.0 |

| Llama-70b | 43.8 |

Hemos creado una lista de problemas para mantener estas limitaciones y posibles soluciones. Sus opiniones y comentarios siempre son bienvenidos.

Cite el repositorio si el modelo/código/conclusión en este repositorio es útil para usted.

@misc{abel,

author = {Chern, Ethan and Zou, Haoyang and Li, Xuefeng and Hu, Jiewen and Feng, Kehua and Li, Junlong and Liu, Pengfei},

title = {Generative AI for Math: Abel},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/GAIR-NLP/abel}},

}

Estamos continuamente refinando nuestros modelos y lanzaremos actualizaciones. ¡Manténganse al tanto!